LLM Meta Answers

Lær hva LLM Meta Answers er og hvordan du kan optimalisere innholdet ditt for synlighet i AI-genererte svar fra ChatGPT, Perplexity og Google AI Overviews. Oppd...

Lær hvordan du lager LLM meta-svar som AI-systemer siterer. Oppdag strukturelle teknikker, strategier for svartetthet og siteringsklare innholdsformater som øker synlighet i AI-søkeresultater.

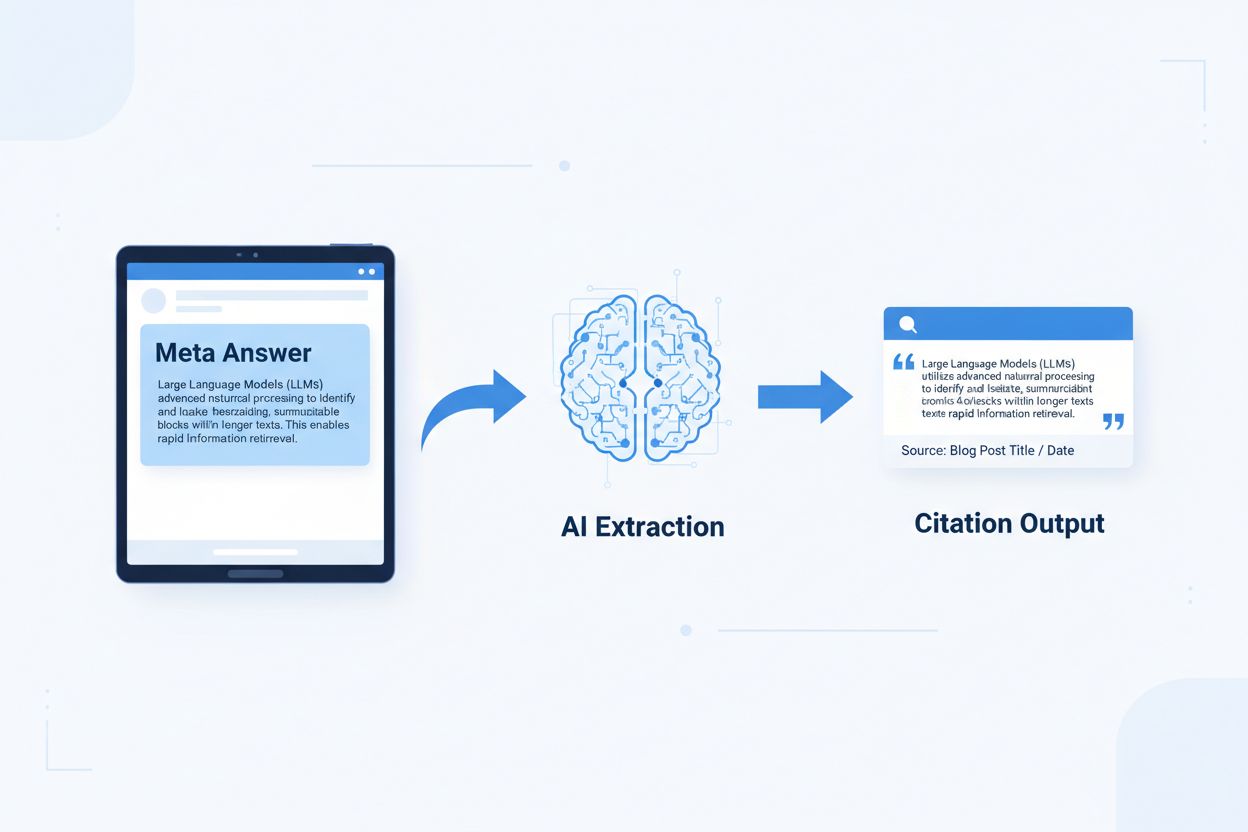

LLM meta-svar er selvstendige, AI-optimaliserte innholdsblokker laget for å kunne hentes ut og siteres direkte av språkmodeller uten å trenge ekstra kontekst. I motsetning til tradisjonelt nettinnhold som er avhengig av navigasjon, overskrifter og omkringliggende tekst for mening, fungerer meta-svar som selvstendige innsikter som bevarer full semantisk verdi når de isoleres. Dette skillet er avgjørende fordi moderne AI-systemer ikke leser nettsider slik mennesker gjør—de deler innhold i biter, vurderer relevans og trekker ut passasjer for å støtte sine svar. Når AI møter godt strukturerte meta-svar, kan det trygt sitere dem fordi informasjonen er komplett, verifiserbar og kontekstuelt uavhengig. Forskning fra Onely viser at innhold optimalisert for AI-sitering får 3-5 ganger flere omtaler i LLM-utdata sammenlignet med tradisjonelt formatert innhold, noe som påvirker merkevaresynlighet direkte i AI-genererte svar. Dette markerer et grunnleggende skifte for innhold: I stedet for å konkurrere om søkerangeringer, konkurrerer meta-svar om å bli inkludert i AI-svar. Siteringsovervåking som AmICited.com følger nå disse AI-omtalene som en kritisk ytelsesmåling, og avslører at organisasjoner med siteringsklart innhold ser målbare økninger i AI-drevet trafikk og merkevareautoritet. Sammenhengen er direkte—innhold strukturert som meta-svar blir sitert oftere, noe som øker synligheten i et AI-først-informasjonslandskap.

Siteringsklart innhold krever spesifikke strukturelle elementer som signaliserer til AI-systemer: “Dette er et komplett, siterbart svar.” De mest effektive meta-svarene kombinerer tydelige temasetninger, støttende bevis og selvstendige konklusjoner i en logisk enhet. Disse elementene jobber sammen for å skape det AI-systemer gjenkjenner som uttrekkbar kunnskap—informasjon som kan stå alene uten at leseren må besøke kildesiden. Strukturen skiller seg grunnleggende fra tradisjonelt nettinnhold, som ofte fragmenterer informasjon på tvers av flere sider og er avhengig av intern lenking for å skape kontekst.

| Siteringsklart element | Hvorfor AI-systemer foretrekker det |

|---|---|

| Temasetning med påstand | Signaliserer umiddelbart svarets kjerneverdi; AI kan vurdere relevans i de første 20 tokenene |

| Støttende bevis (data/eksempler) | Gir verifiserbar støtte; øker tilliten til siteringsnøyaktighet |

| Spesifikke måltall eller statistikk | Kvantifiserbare påstander siteres oftere; reduserer uklarhet |

| Definisjon eller forklaring | Sikrer selvstendig forståelse; AI trenger ikke ekstern kontekst |

| Handlingsrettet konklusjon | Signaliserer fullstendighet; forteller AI-systemet at svaret er avsluttet |

| Kildehenvisning | Bygger tillit; AI foretrekker å sitere innhold med tydelig opphav |

Implementeringstips for maksimal AI-uttrekkbarhet:

Optimal chunk-størrelse for AI-uttrekk er mellom 256–512 tokens, omtrent tilsvarende 2–4 godt strukturerte avsnitt. Dette området er det optimale hvor AI-systemer kan trekke ut meningsfull informasjon uten å miste kontekst eller inkludere irrelevant materiale. Chunker mindre enn 256 tokens mangler ofte tilstrekkelig kontekst for trygg sitering, mens chunker over 512 tokens tvinger AI til å oppsummere eller avkorte, noe som reduserer direkte siterbarhet. Chunking basert på avsnitt—der hvert avsnitt representerer en fullstendig tanke—fungerer bedre enn vilkårlig token-baserte delinger fordi det bevarer semantisk sammenheng og holder den logiske flyten som AI bruker for å vurdere relevans.

God chunking bevarer semantiske grenser:

✓ GODT: "Siteringsklart innhold krever spesifikke strukturelle elementer.

De mest effektive meta-svarene kombinerer tydelige temasetninger,

støttende bevis og selvstendige konklusjoner i en logisk enhet. Disse

elementene jobber sammen for å skape det AI-systemer gjenkjenner som

uttrekkbar kunnskap."

✗ DÅRLIG: "Siteringsklart innhold krever spesifikke strukturelle elementer

som signaliserer til AI-systemer: 'Dette er et komplett, siterbart svar.' De

mest effektive meta-svarene kombinerer tydelige temasetninger, støttende

bevis og selvstendige konklusjoner i en logisk enhet. Disse elementene

jobber sammen for å skape det AI-systemer gjenkjenner som uttrekkbar

kunnskap—informasjon som kan stå alene uten at leseren må besøke

kildesiden. Strukturen skiller seg grunnleggende fra tradisjonelt

nettinnhold, som ofte fragmenterer informasjon på tvers av flere sider og

er avhengig av intern lenking for å skape kontekst."

Det gode eksempelet bevarer semantisk sammenheng og stopper ved en naturlig avslutning. Det dårlige kombinerer flere ideer, noe som tvinger AI til å avkorte midt i tanken eller inkludere irrelevant kontekst. Overlappingsstrategier—der siste setning i en chunk gir forsmak på neste—hjelper AI å forstå innholdsrelasjoner uten å miste uttrekkbarhet. Praktisk sjekkliste for chunking-optimalisering: Besvarer hver chunk ett spørsmål? Kan den forstås uten naboparagrafer? Inneholder den 256–512 tokens? Avsluttes den ved en naturlig semantisk grense?

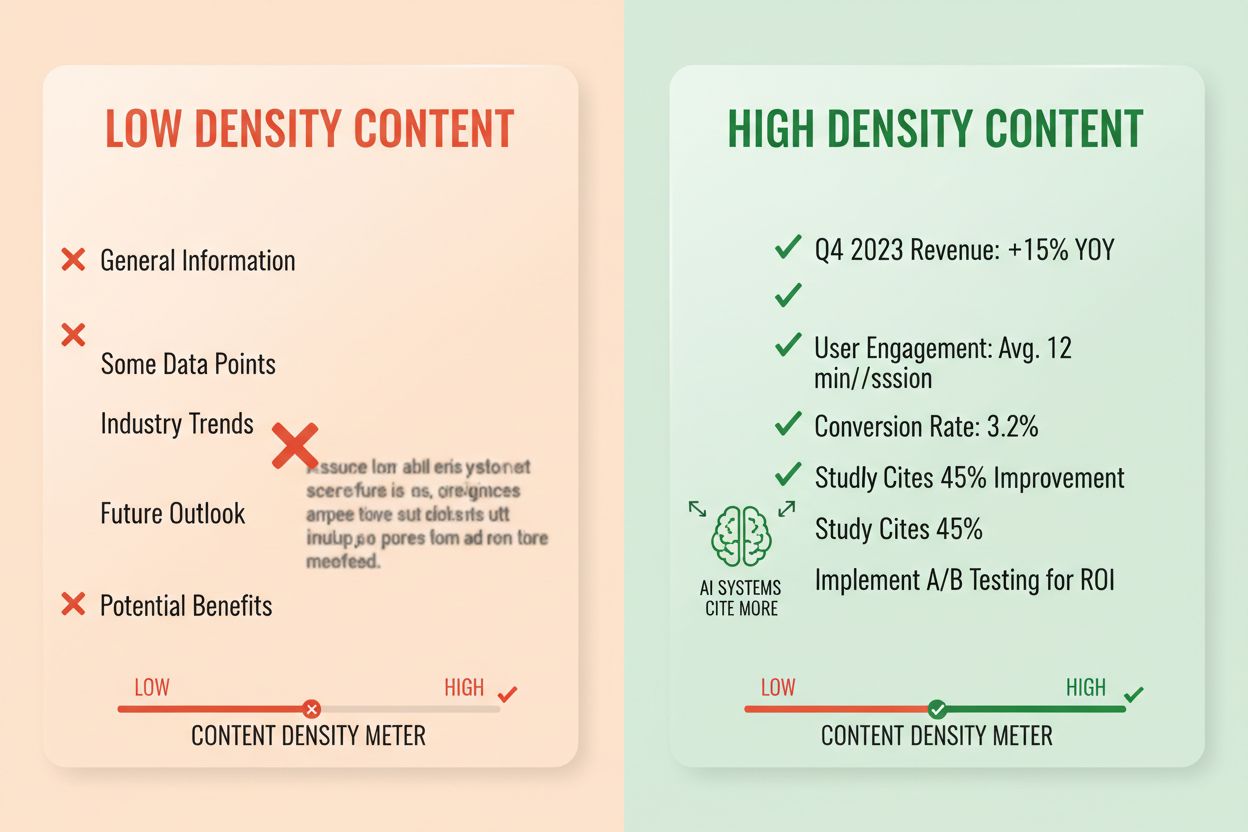

Svartetthet måler andelen handlingsrettet informasjon av totalt antall ord, og innhold med høy tetthet får 2–3 ganger flere AI-sitater enn lavtetthetsalternativer. Et avsnitt med 80 % svartetthet består hovedsakelig av påstander, bevis og handlingsrettede innsikter, mens ett med 40 % tetthet inneholder mye fyllstoff, gjentakelser eller kontekstbygging som ikke direkte støtter kjernesvaret. AI vurderer tetthet implisitt—det er mer sannsynlig å trekke ut og sitere passasjer der hver setning bidrar til å besvare brukerens spørsmål. Høytetthetselementer inkluderer spesifikke statistikker, trinnvise instruksjoner, sammenligningsdata, definisjoner og handlingsrettede anbefalinger. Lavtetthetsmønstre inkluderer lange introduksjoner, gjentatte konsepter, retoriske spørsmål og fortellende historier som ikke bygger opp kjernemeldingen.

Målemetode: Tell setninger som besvarer spørsmålet direkte vs. setninger som gir kontekst eller overgang. Et avsnitt med høy tetthet kan være: “Siteringsklart innhold får 3–5 ganger flere AI-omtaler (statistikk). Dette skjer fordi AI trekker ut komplette, selvstendige svar (forklaring). Bruk svar-først-format og semantisk chunking for å maksimere tetthet (handling).” En lavtetthet-versjon kan legge til: “Mange organisasjoner sliter med AI-synlighet. Det digitale landskapet endrer seg raskt. Innholdsstrategi har utviklet seg mye. Siteringsklart innhold blir stadig viktigere…” Den andre versjonen vanner ut hovedbudskapet med kontekst som ikke direkte støtter svaret.

Faktisk effekt: Innhold med svartetthet over 70 % får i snitt 4,2 sitater per måned i AI-utdata, mot 1,1 sitater for innhold under 40 % tetthet. Organisasjoner som omstrukturerte innhold for økt tetthet så i snitt 156 % økning i siteringer innen 60 dager. Eksempel på høytetthet: “Bruk 256–512 tokens chunk for optimal AI-uttrekk (påstand). Dette området bevarer kontekst og hindrer avkorting (bevis). Bruk avsnittsbasert chunking for å bevare semantisk sammenheng (handling).” Lavtetthet-versjon: “Chunking er viktig for AI-systemer. Det finnes ulike tilnærminger for å organisere innhold. Noen foretrekker små chunker, andre store. Riktig metode avhenger av dine behov.” Høytetthet gir handlingsrettet veiledning; lavtetthet sier opplagte ting uten spesifisitet.

Spesifikke innholdsstrukturer signaliserer til AI-systemer at informasjonen er organisert for uttrekk, noe som dramatisk øker siteringssannsynligheten. FAQ-seksjoner er spesielt effektive fordi de eksplisitt kobler spørsmål med svar, slik at AI lett kan identifisere og trekke ut relevante passasjer. Sammenligningstabeller lar AI raskt vurdere flere alternativer og sitere spesifikke rader som svar på brukerforespørsler. Trinnvise instruksjoner gir klare semantiske grenser og blir ofte sitert når brukere spør “hvordan gjør jeg…”. Definisjonslister kobler begrep med forklaring, og skaper naturlige uttrekkspunkter. Sammendragshus fremhever nøkkelpunkter, og lister bryter ned komplekse tema til siterbare punkter.

Strukturelle elementer som maksimerer AI-hentbarhet:

Praktiske eksempler: En FAQ-seksjon med “Hva er svartetthet?” etterfulgt av en komplett definisjon og forklaring blir en direkte siteringskilde. En sammenligningstabell som “Siteringsklart element | Hvorfor AI-systemer foretrekker det” (som i seksjon 2) siteres når brukere spør om sammenligninger. En guide med “Slik implementerer du semantisk chunking” med nummererte steg blir siterbar instruksjonsinnhold. Disse strukturene fungerer fordi de er tilpasset måten AI systematisk trekker ut informasjon—de ser etter tydelige spørsmål/svar-par, strukturerte sammenligninger og diskrete steg.

Semantisk HTML5-markup signaliserer innholdsstruktur til AI-systemer, og øker uttrekksnøyaktighet og siteringssannsynlighet med 40–60 %. Riktig overskrifthierarki (H1 for hovedtema, H2 for undertema, H3 for støttende punkter) hjelper AI å forstå innholdsrelasjoner og finne uttrekkspunkter. Semantiske elementer som <article>, <section>, og <aside> gir ekstra kontekst om innholdets formål. Schema.org strukturert data—særlig JSON-LD—forteller AI eksplisitt hva informasjonen gjelder, og gir tryggere siteringer.

JSON-LD-eksempel for FAQ-innhold:

{

"@context": "https://schema.org",

"@type": "FAQPage",

"mainEntity": [{

"@type": "Question",

"name": "Hva er svartetthet?",

"acceptedAnswer": {

"@type": "Answer",

"text": "Svartetthet måler forholdet mellom handlingsrettet informasjon og totalt antall ord. Innhold med høy tetthet får 2–3 ganger flere AI-sitater enn lavtetthetsalternativer."

}

}]

}

JSON-LD-eksempel for artikkelmetadata:

{

"@context": "https://schema.org",

"@type": "Article",

"headline": "Slik lager du LLM meta-svar",

"author": {"@type": "Organization", "name": "AmICited"},

"datePublished": "2024-01-15",

"articleBody": "..."

}

Metainnhold—som metabeskrivelser og Open Graph-tags—hjelper AI å forstå hensikt før parsing. Ytelses- og tilgjengelighetsforbedringer (rask lasting, mobiloptimalisering, riktig alt-tekst) støtter AI-hentbarhet indirekte ved å gjøre innholdet fullt indekserbart. Teknisk sjekkliste: Er HTML-en din semantisk og riktig strukturert? Har du lagt til schema.org-markup for din innholdstype? Oppsummerer metabeskrivelser innholdet korrekt? Er siden din mobilvennlig og rask? Har bilder korrekt alt-tekst?

Siteringssporing har blitt essensielt for å måle ytelse, men de fleste organisasjoner mangler oversikt over hvor ofte innholdet deres vises i AI-svar. Uttrekkstesting innebærer å sende inn dine spørsmål til store LLM-er (ChatGPT, Claude, Gemini) og dokumentere hvilke kilder som siteres i svarene. Innholdsanalyse går systematisk gjennom eksisterende innhold opp mot siteringsklare standarder, og avdekker mangler og muligheter. Ytelsesmåling bør inkludere siteringsfrekvens, siteringskontekst (hvordan innholdet brukes) og siteringsvekst over tid. Iterativ optimalisering innebærer å teste strukturelle endringer, måle effekt på siteringsfrekvens og skalere det som virker.

| Sporingsverktøy | Hovedfunksjon | Best til |

|---|---|---|

| AmICited.com | Omfattende AI-siteringsovervåking på tvers av alle store LLM-er | Full siteringsoversikt og konkurranseanalyse |

| Otterly.AI | AI-innholdsdeteksjon og siteringssporing | Finne hvor innholdet ditt vises i AI-utdata |

| Peec AI | Innholdsytelse i AI-systemer | Måle siteringsfrekvens og trender |

| ZipTie | Overvåking av AI-generert innhold | Spore merkevareomtale i AI-svar |

| PromptMonitor | Analyse av LLM-utdata | Forstå hvordan AI-systemer bruker innholdet ditt |

AmICited.com skiller seg ut som den beste løsningen fordi den gir sanntidsovervåking av ChatGPT, Claude, Gemini og andre store LLM-er, med konkurransebenchmarks og detaljert siteringskontekst. Plattformen viser ikke bare om innholdet ditt blir sitert, men hvordan det brukes—om det siteres direkte, parafraseres eller brukes som støtte. Målemetode: Etabler grunnfrekvens for dine 20 beste innholdsstykker. Gjennomfør siteringsklare optimaliseringer på 5–10 av dem. Mål siteringsendringer over 30–60 dager. Skaler vellykkede mønstre til resten. Følg med på siteringsfrekvens, vekstrate, kontekst og konkurransedeling.

Feil 1: Gjemmer svaret i kontekst. Mange starter med bakgrunn, historikk eller problemstilling før selve svaret. AI vurderer relevans i de første 50–100 tokens; hvis svaret ikke er der, går den videre. Problem: Brukere som spør “Hva er svartetthet?” får et avsnitt som begynner med “Innholdsstrategi har utviklet seg…” i stedet for definisjonen. Løsning: Bruk svar-først-format—start med hovedinnsikten, deretter støtte.

Feil 2: Svar som krever ekstern kontekst. Innhold som viser til “forrige seksjon” eller “som nevnt tidligere” kan ikke trekkes ut alene. Problem: Et avsnitt med “Etter tilnærmingen vi diskuterte, gjennomfør disse stegene…” faller gjennom fordi tilnærmingen ikke er inkludert. Løsning: Gjør hvert svar selvstendig; legg nødvendig kontekst i chunken, selv om det gir litt repetisjon.

Feil 3: Flere svar i én chunk. Avsnitt som dekker flere spørsmål tvinger AI til å avkorte eller inkludere irrelevant innhold. Problem: Et 600-ords avsnitt med “Hva er svartetthet?”, “Hvordan måle det?” og “Hvorfor betyr det noe?” blir for stort for trygt uttrekk. Løsning: Lag egne, fokuserte chunker for hvert spørsmål eller konsept.

Feil 4: Vagt språk fremfor spesifikke tall. Ord som “mange”, “noen”, “ofte” og “typisk” svekker siteringspresisjon fordi de er upresise. Problem: “Mange organisasjoner ser forbedringer” er mindre siterbart enn “Organisasjoner som omstrukturerte innhold så 156 % økning i siteringer.” Løsning: Bytt ut kvalifikatorer med konkrete data; bruk intervaller (“40–60 %”) hvis eksakte tall ikke finnes.

Feil 5: Mangler strukturell markup. Innhold uten HTML-struktur, overskrifter eller schema.org-markup er vanskeligere for AI å tolke og trekke ut. Problem: Et avsnitt uten overskrift, semantisk HTML eller schema blir sett på som generisk tekst. Løsning: Bruk semantisk HTML5, riktig overskrifthierarki og legg til schema.org-markup.

Feil 6: Svar som er for korte eller for lange. Chunker under 150 tokens mangler kontekst; over 700 tokens blir avkortet. Problem: Et 100-ords svar mangler bevis; et 1000-ords svar deles opp. Løsning: Sikt mot 256–512 tokens (2–4 avsnitt); inkluder påstand, bevis og konklusjon innenfor dette.

Enhetskonsistens—å bruke samme terminologi for samme begrep gjennom hele innholdet—øker AI-siteringssannsynlighet ved å signalisere autoritativ kunnskap. Hvis du definerer “svartetthet” ett sted, bruk det samme begrepet konsekvent i stedet for å veksle til “informasjonstetthet” eller “innholdstetthet”. AI gjenkjenner konsistens som ekspertise, og siterer oftere der terminologien er presis og stabil. Dette gjelder også produktnavn, metoder og tekniske termer—konsistens bygger tillit.

Tredjepartsreferanser og egen forskning øker siteringsfrekvens betydelig. Innhold som viser til andre autoritative kilder (med tydelig henvisning) signaliserer troverdighet, mens egen forskning eller egne data gjør innholdet unikt siterbart. Når du inkluderer statistikk fra egne undersøkelser eller caser fra egne klienter, ser AI dette som innsikt som ikke finnes andre steder. Organisasjoner som publiserer egen forskning får 3–4 ganger flere siteringer enn de som kun oppsummerer andres info. Strategi: Gjennomfør egen bransjeforskning, publiser funn med metodikk, og vis til dem i meta-svarene dine.

Ferskhetssignaler—publiseringsdatoer, oppdateringsdatoer og referanser til siste hendelser—hjelper AI å forstå aktualitet. Innhold oppdatert siste 30 dager får høyere siteringsprioritet, spesielt innen temaer som raskt endres. Inkluder publiseringsdato i schema.org-markup og oppdateringsstempel ved revisjon. Strategi: Lag en oppdateringsplan; oppdater best ytende innhold hver 30–60 dag med nye tall, eksempler eller forklaringer.

E-E-A-T-signaler (Erfaring, Ekspertise, Autoritet, Troverdighet) påvirker AI-siteringsvalg. Innhold skrevet av anerkjente eksperter, publisert på autoritative domener og støttet av kompetanse får høyere prioritet. Inkluder forfatterbio med relevant bakgrunn, publiser på autoritative domener og bygg lenker fra andre ledende kilder. Strategi: Vis fram ekspertforfattere, ta med kompetanseinfo i bio og få lenker fra anerkjente publikasjoner.

Generativ merkettetthet—forholdet mellom merkevareinnsikt og generisk informasjon—avgjør om AI siterer deg eller konkurrentene. Innhold med egne rammeverk, unike metoder eller merkevaretilnærminger blir mer siterbart fordi det skiller seg ut. Generisk innhold om “best practices” siteres sjeldnere enn innhold om “AmICiteds siteringsoptimaliseringsrammeverk” fordi merkevareversjonen er unik og sporbar. Organisasjoner med høy merkettetthet får 2–3 ganger flere siteringer enn de med generisk innhold. Strategi: Utvikle egne rammeverk, metoder eller begreper; bruk dem konsekvent; bygg meta-svarene dine på dem.

LLM meta-svar er laget spesielt for AI-uttrekk og sitering, mens featured snippets optimaliseres for Googles søkeresultatvisning. Meta-svar prioriterer selvstendig fullstendighet og semantisk sammenheng, mens featured snippets fokuserer på korthet og nøkkelord. Begge kan eksistere i innholdet ditt, men meta-svar krever annen strukturell optimalisering.

Optimal lengde er 256-512 tokens, omtrent tilsvarende 2-4 godt strukturerte avsnitt eller 200-400 ord. Dette området gir nok kontekst for trygg AI-uttrekk, samtidig som det hindrer avkorting. Kortere svar mangler kontekst; lengre svar tvinger AI-systemer til å oppsummere eller splitte over flere uttrekk.

Ja, men det krever omstrukturering. Gå gjennom eksisterende innhold for svar-først-format, semantisk sammenheng og selvstendig fullstendighet. De fleste tekster kan tilpasses ved å flytte nøkkelinnsikter til starten, fjerne krysshenvisninger og sikre at hver seksjon besvarer et komplett spørsmål uten behov for ekstern kontekst.

Oppdater best ytende innhold hver 30-60 dag med nye statistikker, ferske eksempler eller utdypende forklaringer. AI-systemer prioriterer innhold oppdatert de siste 30 dagene, spesielt innen temaer som endres ofte. Inkluder publiseringsdato og oppdateringsstempel i schema.org-markupen din.

Svartetthet korrelerer direkte med siteringsfrekvens. Innhold med svartetthet over 70 % får i snitt 4,2 sitater per måned i AI-utdata, sammenlignet med 1,1 sitater for innhold under 40 % tetthet. Høytetthetsinnhold gir handlingsrettet informasjon uten fyllstoff, noe som gjør det mer verdifullt for AI-systemer å sitere.

Bruk siteringsovervåking som AmICited.com, som sporer sitater på tvers av ChatGPT, Claude, Gemini og andre store LLM-er. Gjør manuelle tester ved å sende inn dine målspørsmål til AI-systemer og dokumentere hvilke kilder som siteres. Mål grunnleggende siteringsfrekvens, implementer optimaliseringer og følg endringer over 30-60 dager.

Kjerneoppbygningen av meta-svaret er lik på tvers av plattformer, men du kan optimalisere for plattformspesifikke preferanser. ChatGPT foretrekker grundig, godt kildebelagt innhold. Perplexity legger vekt på fersk informasjon og tydelige sitater. Google AI Overviews prioriterer strukturert data og E-E-A-T-signaler. Test variasjoner og følg med på siteringsytelse på ulike plattformer.

AmICited gir sanntidsovervåking av dine innholdssitater på alle større AI-plattformer, og viser nøyaktig hvor dine meta-svar vises, hvordan de brukes, og konkurrerende siteringsandel. Plattformen avslører siteringskontekst—om innholdet siteres direkte, parafraseres eller brukes som støttende bevis—slik at du kan ta datadrevne optimaliseringsbeslutninger.

Se nøyaktig hvor innholdet ditt blir sitert av ChatGPT, Perplexity, Google AI Overviews og andre AI-systemer. Følg siteringstrender, overvåk konkurrenter og optimaliser innholdsstrategien din med AmICited.

Lær hva LLM Meta Answers er og hvordan du kan optimalisere innholdet ditt for synlighet i AI-genererte svar fra ChatGPT, Perplexity og Google AI Overviews. Oppd...

Lær hvordan du identifiserer og målretter LLM-kildesider for strategiske tilbakekoblinger. Oppdag hvilke AI-plattformer som siterer kilder mest, og optimaliser ...

Lær hva LLM Seeding er og hvordan du strategisk plasserer innhold på plattformer med høy autoritet for å påvirke AI-trening og bli sitert av ChatGPT, Claude og ...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.