E-E-A-T og AI-søk: Hvorfor merkevarens autoritet betyr mer enn noen gang

Forstå E-E-A-T (Erfaring, Ekspertise, Autoritet, Troverdighet) og dens avgjørende betydning for synlighet i AI-søkemotorer som ChatGPT, Perplexity og Google AI ...

Oppdag hvordan E-E-A-T-signaler påvirker LLM-sitater og AI-synlighet. Lær hvordan erfaring, ekspertise, autoritet og tillit former innholdsoppdagelse i AI-drevne søk.

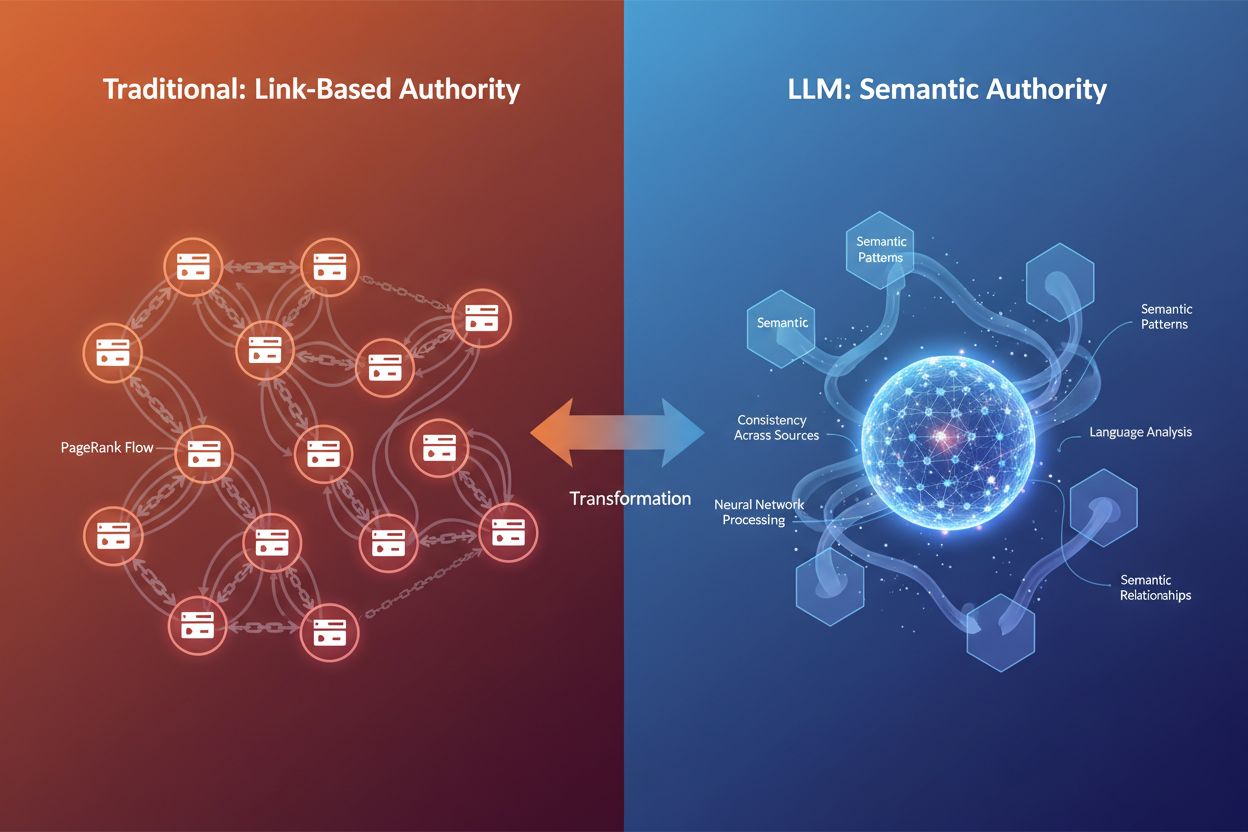

Det digitale landskapet er i endring. I tiår har tilbakekoblinger vært det primære autoritetsmerket—jo flere kvalitetslenker som peker til nettstedet ditt, jo mer autoritativt ble du ansett av søkemotorene. Men når store språkmodeller (LLM-er) som ChatGPT, Claude og Gemini former hvordan informasjon oppdages og vurderes, utvikler selve definisjonen av autoritet seg. E-E-A-T—Erfaring, Ekspertise, Autoritet og Tillit—har gått fra å være en sekundær SEO-betraktning til å bli et grunnleggende rammeverk som avgjør synlighet på både tradisjonelle søk og AI-drevne plattformer. Det viktige poenget her er at tilbakekoblinger ikke lenger er det eneste autoritetsmerket som avgjør om innholdet ditt blir sitert av AI-systemer. I stedet vurderer LLM-er autoritet gjennom semantisk rikdom, konsistens på tvers av kilder og dybden av kunnskap som demonstreres i innholdet ditt. Dette skiftet er avgjørende for merkevarer som ønsker synlighet i AI-siteringssystemer som Google AI Overviews, Perplexity og ChatGPT. Når AmICited overvåker hvordan AI refererer til merkevaren din på disse plattformene, sporer vi signaler som går langt utover tradisjonelle lenkeprofiler. Spørsmålet er ikke lenger bare “hvem lenker til deg?”, men “viser innholdet ditt ekte ekspertise, og kan AI-systemer stole nok på det til å sitere det?” Å forstå denne forskjellen er avgjørende for alle som ønsker å bygge autoritet i det AI-drevne søkelandskapet.

E-E-A-T representerer fire sammenkoblede dimensjoner av innholdstroverdighet, hver med en distinkt rolle i hvordan både Google og LLM-er vurderer om innholdet ditt fortjener synlighet. La oss bryte ned hver pilar og forstå hvordan de fungerer i konteksten av AI-sitater:

Erfaring betyr at du faktisk har gjort det du skriver om. En produktanmeldelse skrevet av noen som har brukt produktet i seks måneder, veier mer enn en generell gjennomgang. I AI-æraen gjenkjenner LLM-er erfaringsbasert innhold gjennom språk som signaliserer førstehåndserfaring—spesifikke detaljer, observasjoner fra virkeligheten og kontekstuelle nyanser som bare noen med direkte erfaring vil inkludere.

Ekspertise er dokumentert kunnskap støttet av meritter, utdanning eller en bevist merittliste. En finansrådgiver med CFA-sertifisering som skriver om investeringsstrategier, har mer autoritet enn en livsstilsblogger som prøver seg på finans. For LLM-er gjenkjennes ekspertise gjennom konsekvent bruk av teknisk terminologi, logisk dybde i forklaringer og evne til å dekke komplekse undertemaer presist.

Autoritet kommer fra ekstern anerkjennelse—andre troverdige kilder siterer deg, lenker til deg eller omtaler deg som ressurs. Tradisjonelt ble dette målt med tilbakekoblinger. I LLM-kontekst måles autoritet stadig mer gjennom semantisk fotavtrykk—hvor konsekvent merkevaren eller navnet ditt vises i tilknytning til din nisje på tvers av flere kilder og plattformer.

Tillit er paraplyen som holder alt sammen. Uten tillit faller de andre tre pilarene sammen. Tillit bygges gjennom åpenhet (klar forfatterskap, kontaktinformasjon), nøyaktighet (faktabasert innhold med riktige referanser) og sikkerhet (HTTPS, profesjonell nettstruktur). Google sier eksplisitt at tillit er det viktigste medlemmet i E-E-A-T-familien, og LLM-er vektlegger også konsistens og pålitelighet tungt når de velger kilder å sitere.

| Signal | Tradisjonell SEO-vurdering | LLM-siteringsvurdering |

|---|---|---|

| Erfaring | Forfatterbio, personlige historier | Språkmønstre som indikerer førstehåndserfaring |

| Ekspertise | Meritter, lenker fra autoritetssider | Semantisk dybde, teknisk terminologi, tematisk dekning |

| Autoritet | Lenkeprofil, domeneautoritet | Enhetsgjenkjenning, omtaler på tvers av plattformer, semantisk autoritet |

| Tillit | HTTPS, nettsideoppsett, brukeranmeldelser | Konsistens på tvers av kilder, nøyaktighetsverifisering, tydelighet |

Den viktigste forskjellen er at mens tradisjonell SEO er avhengig av strukturelle signaler (lenker, domenemålinger), vurderer LLM-er E-E-A-T gjennom semantisk og kontekstuell analyse. Det betyr at innholdet ditt kan bygge autoritet uten store lenkebyggingskampanjer—så lenge det viser ekte ekspertise og konsistens.

Store språkmodeller tenker ikke som tradisjonelle søkemotorer. De gjennomsøker ikke nettet etter lenker eller sjekker domeneautoritetspoeng. I stedet fungerer de som sannsynlighetsmaskiner som gjenkjenner mønstre i språk, kontekst og informasjonskonsistens. Når en LLM vurderer om den skal sitere innholdet ditt, stiller den fundamentalt andre spørsmål enn Googles rangeringsalgoritme.

Mønster-gjenkjenning vs. strukturelle signaler: Tradisjonelle søkemotorer verifiserer autoritet gjennom ekstern validering—hvem lenker til deg? LLM-er derimot, gjenkjenner autoritet språklig. De analyserer om teksten din viser ekspertise gjennom korrekt bruk av tekniske begreper, logisk flyt, selvsikker tone og evne til å ta for seg nyanserte aspekter av et tema. En side om hjertesykdom som naturlig inkluderer begreper som “kolesterol”, “arterieplakk” og “kardiovaskulære risikofaktorer”, signaliserer semantisk autoritet til en LLM, selv uten én eneste lenke.

Semantisk relevans og tematisk dybde: LLM-er prioriterer innhold som grundig dekker et tema fra flere vinkler. Når du spør en AI-assistent et spørsmål, bryter systemet ned prompten din i flere søk (kalt “query fan-out”), og henter innhold som matcher de utvidede søkene. Innhold som belyser et tema omfattende—med undertemaer, svar på oppfølgingsspørsmål og kontekst—blir oftere valgt for sitering. Derfor har semantisk rikdom blitt en ny form for autoritet.

Konsistens på tvers av kilder: LLM-er kryssjekker informasjon på tvers av millioner av dokumenter. Hvis innholdet ditt stemmer overens med etablerte fakta og gir unike innspill, vurderes det som mer autoritativt. Hvis innholdet derimot motsier etablerte fakta uten støtte, kan AI-systemene rangere det som upålitelig. Dette skaper en interessant dynamikk: du kan introdusere nye ideer, men de må være forankret i verifiserbar informasjon.

Viktige forskjeller i autoritetsvurdering:

Konklusjon: LLM-er gjenkjenner autoritet gjennom mening, ikke målinger. Dette endrer fundamentalt hvordan du bør optimalisere innholdet ditt for AI-synlighet.

En av de mest slående funnene fra nyere forskning på LLM-siteringsatferd er sterk aktualitetsbias på alle store plattformer. Ved å analysere 90 000 sitater fra ChatGPT, Gemini og Perplexity med nettsøk aktivert, viser dataene et tydelig mønster: De fleste siterte URL-er var publisert innen noen hundre dager før LLM-responsen. Dette er ikke tilfeldig—det er bygd inn. LLM-er trenes til å gjenkjenne at ferskt innhold ofte korrelerer med relevans og kvalitet, særlig for tidsaktuelle temaer.

Hvorfor ferskhet betyr noe i RAG-henting: Når LLM-er bruker Retrieval-Augmented Generation (RAG)—søker på nettet i sanntid for å forankre svarene sine—spør de i praksis: “Hva er den mest oppdaterte, relevante informasjonen som finnes?” Ferskhet blir et signal for pålitelighet. Hvis du spør om nyheter, markedstrender eller fersk forskning, er en artikkel publisert forrige måned iboende mer troverdig enn en fra fem år siden. Dette gir en stor fordel til innholdsskapere som jevnlig oppdaterer sidene sine.

Plattformspesifikke ferskhetsmønstre: Forskning viser at Gemini foretrekker ferskt innhold sterkest, med høyest andel sitater fra sider publisert innen null til 300 dager. Perplexity ligger midt imellom, og siterer en god blanding av nytt og moderat gammelt innhold. OpenAI henter fram det bredeste aldersspennet, inkludert eldre kilder, men viser fortsatt sterk evne til å finne aktuelt materiale. Dette betyr at optimaliseringsstrategien din bør ta hensyn til hvilke AI-plattformer publikumet ditt bruker mest.

Tidsaktuelle temaer krever aktive oppdateringer: For YMYL-temaer (Your Money or Your Life)—helse, økonomi, juridisk rådgivning—og bransjer i rask utvikling, er ferskhet ufravikelig. En artikkel om kryptoregler fra 2021 vil sjelden bli sitert i 2025-svar. Løsningen er systematisk innholdspleie: oppdater statistikk årlig (kvartalsvis for raske bransjer), legg inn “sist oppdatert”-datoer synlig, og forny viktige datapunkter etter hvert som ny informasjon kommer. Dette signaliserer både til AI-systemer og lesere at innholdet ditt er oppdatert og pålitelig.

Data om aktualitetsbias: Analyse av 21 412 URL-er med tilgjengelige publiseringsdatoer viste at på tvers av alle tre store LLM-plattformer, topper siteringsaktiviteten seg mellom null og 300 dager, for så å avta over tid. Dette betyr at det første året av et innholds liv er kritisk for AI-synlighet. Innhold eldre enn tre år får betydelig lavere siteringsrate med mindre det dreier seg om tidløse temaer eller nylig er oppdatert.

Selv om LLM-er ikke vurderer domeneautoritet direkte, er det en klar sammenheng mellom domener med høy autoritet og hvor ofte de siteres. Analyse av de 1 000 nettstedene ChatGPT siterer mest, viser et tydelig mønster: AI foretrekker nettsteder med Domain Rating (DR) over 60, og flertallet av sitater kommer fra domener med DR 80–100. Men denne sammenhengen er trolig indirekte—domener med høy DR rangerer bedre i søk, og siden LLM-er henter innhold gjennom søk, møter de disse autoritative nettstedene oftere.

Den indirekte autoritetseffekten: Forholdet mellom domeneautoritet og LLM-sitater fungerer slik: LLM-er bruker søkemotorer (eller søkelignende systemer) for å finne innhold. Nettsteder med høy autoritet rangerer bedre i disse søkene. Derfor dukker de oftere opp i LLM-resultatene. Det er altså ikke slik at LLM-er leser domeneautoritetspoeng; det er at autoritet korrelerer med søkesynlighet, som igjen gir flere siteringsmuligheter. Det betyr at tradisjonell SEO-autoritet gjennom kvalitetslenker fortsatt er verdifullt, selv i et AI-drevet landskap.

Semantisk rikdom som nytt autoritetssignal: Utover domenemålinger gjenkjenner LLM-er autoritet gjennom semantisk rikdom—dybden og bredden i tematisk dekning. En side som grundig utforsker et emne, bruker relevante nøkkelord naturlig, tar for seg undertemaer og gir kontekst, signaliserer ekspertise til AI-systemer. For eksempel vil en artikkel om “fordeler med middelhavsdietten” som dekker kulturelle aspekter, spesifikke helseeffekter, sammenligninger med andre dietter og vanlige spørsmål, vise mer semantisk autoritet enn en generell listeartikkel.

Enhetsrelasjoner og tematisk autoritet: LLM-er bruker enhetsgjenkjenning for å se hvordan innholdet ditt kobles til større kunnskapsgrafer. Hvis artikkelen din om “Steve Jobs” jevnlig nevner Apple, innovasjon, ledelse og produktdesign, kobler AI sammen disse entitetene og bygger et mer helhetlig bilde av autoriteten din. Derfor har strukturert data og schema markup blitt stadig viktigere—de hjelper AI-systemer å forstå relasjoner og temakoblinger tydeligere.

Innhold må dekke utvidede spørsmål: Når en LLM får et brukerspørsmål, utvider den ofte søket til flere relaterte spørsmål. Innholdet ditt må dekke ikke bare hovedspørsmålet, men også variasjoner. Hvis noen spør “hvordan vet jeg om en avokado er moden”, vil LLM-en også søke etter “modenhetsindikatorer avokado”, “hvor lenge modnes avokado” og “lagring av moden avokado”. Innhold som dekker disse vinklene grundig, blir oftere valgt som sitatkilde på tvers av mange søkevarianter.

Å optimalisere for E-E-A-T i LLM-siteringskontekst krever en strategisk, flerlags tilnærming. Målet er å lage innhold som viser ekte ekspertise samtidig som det gjøres lett for AI-systemer å gjenkjenne og trekke ut denne ekspertisen. Her er en praktisk ramme:

1. Vis frem meritter og ekspertise tydelig Forfatterbioen din bør være omfattende og etterprøvbar. Ta med spesifikke meritter (sertifiseringer, grader, profesjonelle titler), antall år erfaring og direkte engasjement med temaet. Ikke bare skriv “markedsføringsekspert”—skriv “CMO med 15 års erfaring innen B2B SaaS-markedsføring, inkludert roller i HubSpot og Salesforce.” Denne presisjonen hjelper LLM-er å gjenkjenne ekte ekspertise. Ta med forfatterbios på alt innhold, og vurder å legge til schema markup (Author schema) for å gjøre merittene maskinlesbare.

2. Lag original forskning og data Original forskning er et av de sterkeste autoritetssignalene. Når du publiserer data som ikke finnes andre steder—undersøkelser, egne målinger, casestudier—blir du primærkilden. LLM-er siterer primærkilder oftere fordi de gir unik verdi. Ahrefs sin “How Much Does SEO Cost?"-side, basert på en undersøkelse av 439 personer, er en av deres mest siterte artikler nettopp fordi det er original forskning. Nøkkelen er å gjøre metoden transparent og vise utvalgstørrelse.

3. Oppretthold konsekvent autoritet på tvers av plattformer Autoriteten din måles ikke bare på eget nettsted. LLM-er analyserer tilstedeværelsen din på LinkedIn, bransjepublikasjoner, foredrag, medieomtaler og andre kanaler. Oppretthold konsekvent profesjonell informasjon, ekspertposisjonering og budskap overalt. Når AI-systemer ser navnet ditt konsekvent i tilknytning til din nisje på flere kilder, styrker det autoriteten din.

4. Bruk riktig schema markup Schema markup gjør ekspertisesignalene dine maskinlesbare. Bruk Article schema for publiseringsdato og forfatterinfo, FAQ schema for spørsmål- og svarinnhold, og Author schema for å koble meritter til innholdet. Forskning viser at 36,6 % av søkeord utløser featured snippets fra schema markup, og denne strukturerte dataen hjelper også LLM-er å tolke innholdet mer presist.

5. Bygg tematisk autoritet med innholdsklynger I stedet for å publisere isolerte blogginnlegg, lag innholdshuber som viser omfattende kunnskap om et tema. Interlenk relaterte artikler, dekk undertemaer grundig og bygg et semantisk nettverk som viser at du har dekket temaet fra mange vinkler. Denne klyngetilnærmingen signaliserer tematisk autoritet til både søkemotorer og LLM-er.

6. Oppdater innhold systematisk Ferskhet er en rangeringsfaktor for både Google og LLM-er. Lag en vedlikeholdsplan: gjennomgå og oppdater viktige sider kvartalsvis, forny statistikk årlig og legg til “sist oppdatert”-datoer synlig. Denne investeringen signaliserer at innholdet ditt er oppdatert og pålitelig.

7. Siter autoritative kilder Når du refererer til andre troverdige kilder, bygger du et tillitsnettverk. Siter fagfellevurdert forskning, bransjerapporter og anerkjente eksperter. Dette styrker ikke bare din egen troverdighet, men hjelper LLM-er å forstå konteksten og påliteligheten i påstandene dine.

8. Vær åpen om begrensninger Ekte ekspertise handler også om å kjenne sine begrensninger. Hvis et tema er utenfor ditt fagfelt, si det. Hvis dine data har svakheter, erkjenn dem. Denne åpenheten bygger tillit både hos mennesker og AI-systemer, som er trent til å verdsette ærlig, nyansert kommunikasjon.

Å forstå E-E-A-T i teorien er én ting; å se det fungere i praksis er noe annet. La oss se på hva som gjør visst innhold svært siterbart, og hvordan disse prinsippene viser seg i virkeligheten.

Anatomi av svært siterbart innhold: Ahrefs sin “How Much Does SEO Cost?"-side er et eksempel på optimalisering for E-E-A-T og LLM-sitater. Siden svarer direkte på et vanlig spørsmål med stor søkevolum. Den bygger på original forskning (439 spurte), har tydelig tidsstempel og bryter ned priser langs flere dimensjoner (frilansere vs. byråer, timepris vs. fast, geografiske forskjeller). Innholdet er lett å skanne med tydelige overskrifter, visualiseringer med forklarende tekst og belyser temaet fra flere vinkler for å dekke relaterte spørsmål. Forfatterlinjen viser relevante meritter, og innholdet er fagfellevurdert, noe som gir et ekstra lag av tillit.

Hva gjør innhold siterbart: Svært siterbart innhold deler ofte disse trekkene: det svarer spesifikt og uten fyllstoff, baserer seg på verifiserbare data eller original forskning, har struktur og format som gjør det lett å trekke ut, belyser temaet fra flere vinkler og viser ekte ekspertise gjennom dybde og nyanser. Når LLM-er vurderer om de skal sitere en side, spør de i praksis: “Kan jeg trekke ut et klart og korrekt svar herfra? Er kilden pålitelig? Gir denne siden unik verdi?”

Strukturert formatering som siteringssignal: Innhold som bruker tydelige overskrifter, punktlister, tabeller og korte avsnitt, blir oftere sitert. Dette handler ikke bare om lesbarhet for mennesker—det handler om ekstraksjon for AI. Når en LLM raskt kan finne nøkkelinformasjonen gjennom strukturelle signaler, er det større sjanse for at den bruker innholdet ditt i sitt svar. Sammenlign en tekstvegg med en godt strukturert artikkel med H2, H3 og punktlister: den strukturerte versjonen er langt mer siterbar.

Flere perspektiver på temaer: Innhold som tar for seg et tema fra ulike vinkler øker siteringsmulighetene. For eksempel kan en artikkel om “produktivitet for hjemmekontor” dekke ulike roller (utviklere, ledere, kundeservice), tidssoner, hjemmemiljøer og personlighetstyper. Denne flerperspektivtilnærmingen gir svar på mange relaterte spørsmål fra én kilde, noe som dramatisk øker siteringspotensialet.

Sitater i virkeligheten: Forskning fra SearchAtlas på 90 000 sitater på tvers av store LLM-er viser at svært siterte sider ofte har sterk domeneautoritet, men også at nisjeeksperter med dyp tematisk kunnskap ofte blir sitert. Reddit-svar og Substack-artikler dukker ofte opp i AI-sitater til tross for svake lenkeprofiler, fordi de viser autentisk ekspertise og klarhet. Dette beviser at autoritet i økende grad handler om dokumentert kunnskap, ikke bare lenkemålinger.

Å bygge E-E-A-T er én ting; å måle effekten er noe annet. Tradisjonelle SEO-målinger som søkeordsrangeringer og antall tilbakekoblinger gir ikke hele bildet av AI-synligheten din. Du trenger nye verktøy og målinger tilpasset AI-æraen.

Manuell testing på tvers av AI-plattformer: Start med direkte testing. Lag en liste på 10–20 spørsmål innholdet ditt bør svare på, og test dem månedlig i ChatGPT, Perplexity, Claude og Gemini. Noter hvilke kilder som blir sitert (dine og konkurrenters), følg endringer over tid og identifiser mønstre. Dette tar tid, men gir innsikt i hva publikum faktisk ser. Bruk et enkelt Google-ark for å spore resultater og finne trender.

Analysetracking for AI-henvisningstrafikk: De fleste analyseverktøy sporer nå AI-søk som egen kanal. I Ahrefs Web Analytics (gratis i Ahrefs Webmaster Tools) er AI-søk allerede segmentert, slik at du kan se hvilke sider som får AI-henvisningstrafikk og hvordan denne trafikken oppfører seg. Følg med på målinger som tid brukt, fluktfrekvens, rullingsdybde og konverteringsrate. Selv om AI-trafikk foreløpig utgjør under 1 % av totalen, viser de som klikker gjennom ofte høyere kjøpsintensjon enn tradisjonell søketrafikk.

Måling av E-E-A-T-effektivitet: I stedet for å se etter direkte E-E-A-T-poeng, følg disse substituttmålingene: AI Overview-sitater (bruk verktøy som BrightEdge eller Authoritas), søkevolum på merkevare, bransjeomtaler på tvers av plattformer og rangeringstabilitet under algoritmeoppdateringer. Innhold med sterke E-E-A-T-signaler har ofte lavere volatilitet under kjerneoppdateringer. Du kan også bruke verktøy som LLM SEO E-E-A-T Score Checker for direkte kategorisk oversikt over E-E-A-T-prestasjon.

Betalt overvåking i stor skala: For omfattende overvåking uten manuelt arbeid, bruk verktøy som Ahrefs Brand Radar, som sporer sitater i 150 millioner forespørsler på seks store AI-plattformer. Brand Radar viser hvor og når du blir sitert, lar deg filtrere på AI-plattform og tema, sporer trender over tid og gir konkurrentdata. Dette gir deg full oversikt over AI-synligheten din og hjelper deg å finne muligheter og hull.

Viktige målinger å følge: Følg AI-siteringsfrekvens (hvor ofte du siteres), siteringsmangfold (hvilke temaer og plattformer), semantisk relevans (hvor godt sitert innhold matcher spørsmålene), ferskhetsmålinger (gjennomsnittsalder på sitert innhold) og domeneoverlapp (hvilke konkurrenter siteres sammen med deg). Disse målingene gir samlet et bilde av E-E-A-T-effekten din i AI-kontekst.

Etter hvert som E-E-A-T og LLM-optimalisering har fått oppmerksomhet, har flere misforståelser dukket opp. La oss avlive de vanligste:

Myte: “Lenker er døde” Virkelighet: Lenker er fortsatt viktige autoritetssignaler, spesielt for Googles algoritme. Det som har endret seg, er vektingen. De er ikke lenger eneste valuta i SEO. Nettsteder med høy autoritet blir fortsatt oftere sitert av LLM-er, men dette er hovedsakelig fordi de rangerer bedre i søk (som LLM-er bruker for innhenting). Hovedpoenget: Lenker betyr fortsatt noe, men de er én brikke i et større puslespill som nå også inkluderer semantisk autoritet, ferskhet og demonstrert ekspertise.

Myte: “E-E-A-T er en direkte rangeringsfaktor” Virkelighet: E-E-A-T er ikke en direkte rangeringsfaktor som søkeord eller sidehastighet. Det er et rammeverk Google bruker via kvalitetsevaluatører for å forbedre og trene algoritmene sine. Å optimalisere for E-E-A-T handler egentlig om å optimalisere for mennesker først—skape genuint autoritativt, pålitelig innhold. Rangeringsfordelene kommer indirekte, gjennom økt brukertilfredshet og lavere fluktfrekvens.

Myte: “AI kan avsløre falsk autoritet på sikt” Virkelighet: Dette er delvis sant, men nyansert. LLM-er kan bli lurt av innhold som “høres” autoritativt ut på kort sikt. Innholdsfabrikker kan lage ekspertaktig materiale gjennom bevisst ordvalg og struktur. Men falsk autoritet overlever sjelden menneskelig gransking, og ettersom AI-systemene blir mer sofistikerte og får mer variert treningsdata, blir de stadig bedre til å skille ekte ekspertise fra etterligninger. Det sikreste er å bygge ekte autoritet, ikke prøve å lure systemet.

Myte: “Du må ha masse lenker for å bli sitert av LLM-er” Virkelighet: Selv om nettsteder med høy autoritet oftere blir sitert, dukker nisjeeksperter med mindre lenkeprofiler jevnlig opp i LLM-sitater. Det viktigste er å vise ekte ekspertise i ditt domene. En spesialisert blogg med dyp tematisk kunnskap kan overgå en generalistside med flere lenker, spesielt på nisjesøk. N

E-E-A-T står for Erfaring, Ekspertise, Autoritet og Tillit. Det er et rammeverk som bestemmer innholdets troverdighet for både tradisjonelle søk og AI-systemer. LLM-er bruker E-E-A-T-signaler for å avgjøre hvilke kilder de skal sitere i sine svar, noe som gjør det kritisk for AI-synlighet.

LLM-er vurderer autoritet gjennom semantiske mønstre, konsistens på tvers av kilder og demonstrert ekspertise, ikke gjennom lenker. De gjenkjenner autoritet språklig via teknisk terminologi, logisk dybde og tematisk dekning. Dette betyr at nettsteder med høy autoritet fortsatt blir ofte sitert, men hovedsakelig fordi de rangerer bedre i søkeresultatene som LLM-er bruker for innhenting.

Ja. Selv om større nettsteder har fordeler, dukker nisjeeksperter med mindre lenkeprofiler regelmessig opp i LLM-sitater. Det viktige er å demonstrere ekte ekspertise i ditt spesifikke domene gjennom semantisk rikdom, tematisk dybde og konsekvent posisjonering. En spesialisert blogg med dyp kunnskap kan overgå generalistsider med flere lenker.

E-E-A-T er en langsiktig strategi. Å bygge ekte autoritet og tillitssignaler tar vanligvis måneder, ikke uker. Imidlertid kan riktig bruk av schema markup og forfatterskapsattributt gi mer umiddelbare effekter. Det første året av innholdets levetid er kritisk for AI-synlighet, og siteringsraten synker betydelig etter tre år med mindre innholdet oppdateres.

Lenker er fortsatt verdifulle autoritetssignaler, men de er ikke lenger eneste valuta. Nettsteder med høy autoritet blir oftere sitert av LLM-er, men dette skyldes hovedsakelig at de rangerer bedre i søkeresultatene. Hovedpoenget: Lenker har fortsatt betydning som en del av et større puslespill som nå også inkluderer semantisk autoritet, ferskhet og demonstrert ekspertise.

Følg AI-siteringsfrekvens, siteringsmangfold på tvers av temaer og plattformer, semantiske relevansscore, ferskhetsmetrikker og domeneoverlapp med konkurrenter. Bruk verktøy som Ahrefs Brand Radar for omfattende overvåking av 150 millioner forespørsler, eller test manuelt målrettede søk månedlig i ChatGPT, Perplexity, Claude og Gemini.

Nei, E-E-A-T er ikke en direkte rangeringsfaktor. Det er et rammeverk som påvirker hvordan AI-systemer vurderer innholdskvalitet. Å optimalisere for E-E-A-T handler egentlig om å lage genuint autoritativt, pålitelig innhold som først og fremst tjener menneskelige lesere. Fordelene kommer indirekte gjennom økt brukertilfredshet og høyere siteringsrate.

Ferskhet vektlegges tungt i LLM-siteringsvalg. Forskning viser at LLM-er siterer innhold publisert innen 300 dager i betydelig høyere grad. For tidsaktuelle temaer er en artikkel fra forrige måned iboende mer pålitelig enn en fra fem år tilbake. Systematiske innholdsoppdateringer og synlige 'sist oppdatert'-datoer er avgjørende for å opprettholde AI-synlighet.

Følg med på hvordan merkevaren din blir sitert av ChatGPT, Perplexity, Google AI Overviews og andre LLM-er. Forstå dine E-E-A-T-signaler og optimaliser for AI-synlighet med AmICited.

Forstå E-E-A-T (Erfaring, Ekspertise, Autoritet, Troverdighet) og dens avgjørende betydning for synlighet i AI-søkemotorer som ChatGPT, Perplexity og Google AI ...

E-E-A-T (Erfaring, Ekspertise, Autoritet, Pålitelighet) er Googles rammeverk for å vurdere innholdskvalitet. Lær hvordan det påvirker SEO, AI-sitater og merkeva...

Lær hvordan du kan demonstrere førstehånds kunnskap og erfaringssignaler for AI-systemer som ChatGPT, Perplexity og Google AI Overviews. Optimaliser innholdet d...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.