YMYL (Your Money Your Life)

YMYL-innhold krever høye E-E-A-T-standarder. Lær hva som kvalifiserer som Your Money Your Life-innhold, hvorfor det er viktig for SEO og AI-synlighet, og hvorda...

Lær hvordan helseorganisasjoner kan optimalisere medisinsk innhold for LLM-synlighet, navigere YMYL-krav, og overvåke AI-siteringer med AmICited.coms AI-overvåkingsplattform.

Your Money or Your Life (YMYL)-innhold omfatter temaer som direkte påvirker brukernes velvære, inkludert helse, økonomi, sikkerhet og samfunnsinformasjon—og helsesektoren ligger øverst i Googles granskningshierarki. Etter Googles kjerneoppdatering i mars 2024 reduserte søkegiganten synligheten til innhold av lav kvalitet med 40 %, noe som signaliserer et enestående oppgjør med upålitelig medisinsk informasjon. Utfordringen for helseorganisasjoner har imidlertid endret seg grunnleggende: innhold må nå være synlig ikke bare for søkemotorer, men også for store språkmodeller (LLM-er) som i økende grad er første stopp for de som søker helseinformasjon. Med 5 % av alle Google-søk relatert til helse og 58 % av pasientene som nå bruker AI-verktøy for helseinformasjon, står helseaktører overfor et kritisk synlighetshull—innholdet deres kan rangere høyt i tradisjonelle søk, men forbli usynlig for AI-systemene pasientene faktisk konsulterer. Dette doble synlighetskravet representerer en helt ny grense i strategi for helseinnhold.

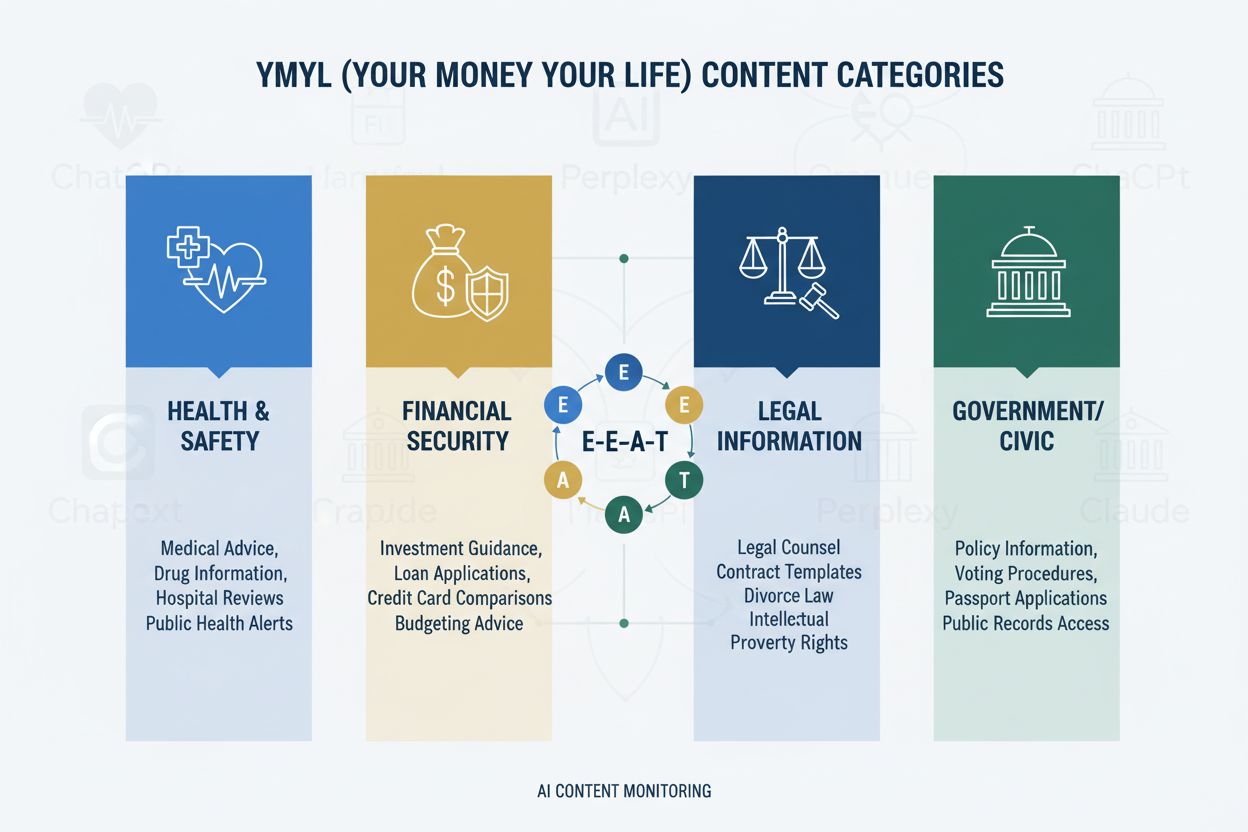

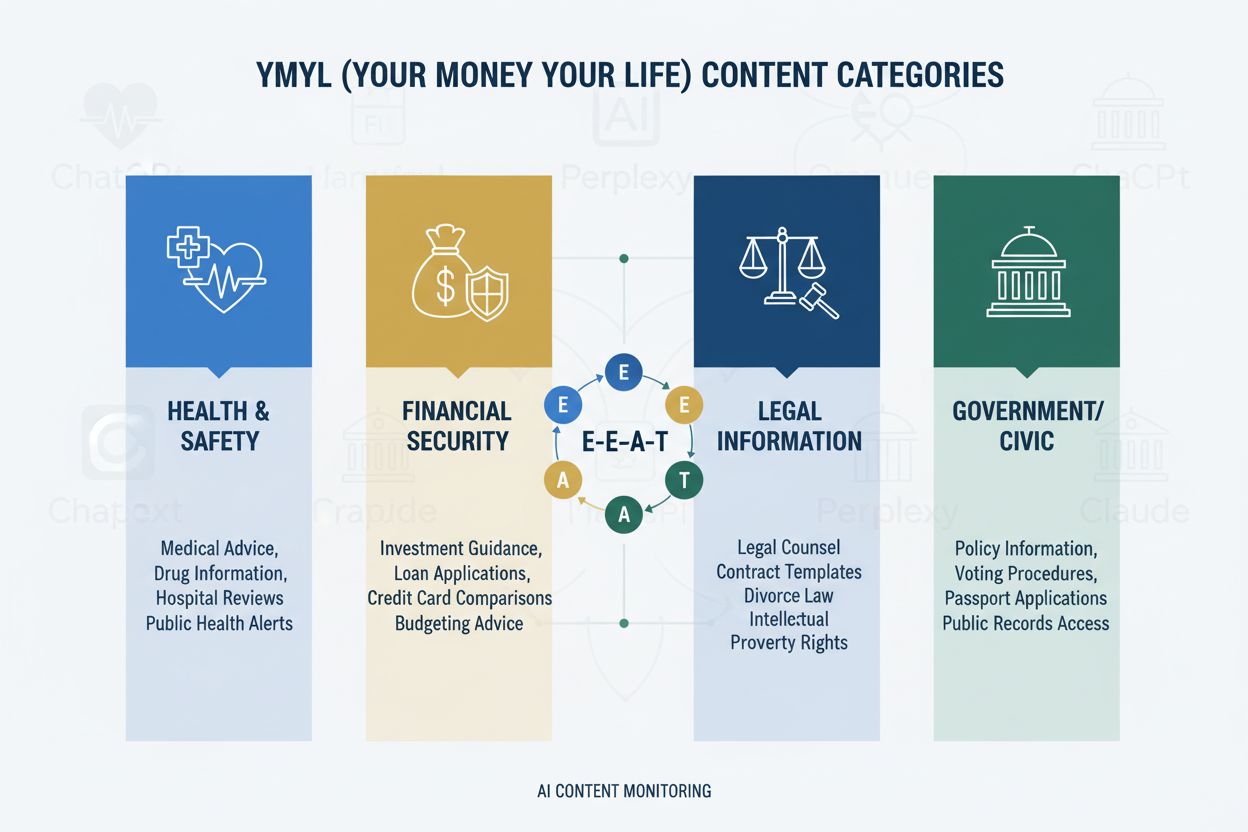

YMYL-rammeverket kategoriserer innhold i fire kritiske domener: Helse (medisinske tilstander, behandlinger, velvære), Økonomi (investeringsråd, økonomisk planlegging), Sikkerhet (beredskapsprosedyrer, trygghet), og Samfunn (valg, juridiske forhold)—der helse har høyeste granskningsnivå grunnet direkte påvirkning på menneskers velvære. Googles E-E-A-T-rammeverk (Experience, Expertise, Authoritativeness, Trustworthiness) er evalueringsstandarden som krever at helseinnhold dokumenterer reell medisinsk kunnskap, profesjonell kompetanse og etterprøvbar nøyaktighet. Quality Rater Guidelines understreker eksplisitt at helseinnhold må utarbeides eller gjennomgås av kvalifiserte medisinske fagpersoner, med tydelige forfatteropplysninger og institusjonell støtte. Helseorganisasjoner må forstå at E-E-A-T ikke er valgfritt—det er grunnleggende krav for synlighet både i søk og for inkludering i LLM-er. Under er påvirkningshierarkiet for YMYL-kategorier:

| YMYL-kategori | Påvirkningsnivå | Granskningsintensitet | Helserelevans |

|---|---|---|---|

| Helse | Kritisk | Høyest | Direkte pasientsikkerhet |

| Økonomi | Høy | Høy | Forsikring, kostnader |

| Sikkerhet | Høy | Høy | Beredskapsprotokoller |

| Samfunn | Middels | Middels | Helsepolitikk |

Til tross for avansert teknologi viser LLM-er alarmerende feilrater ved behandling av medisinsk informasjon, og Stanford HAI-forskning dokumenterer 30-50 % ubegrunnede påstander i helseresponser. GPT-4 med Retrieval-Augmented Generation (RAG) produserer fortsatt svar der 50 % inneholder ubegrunnede påstander, selv når de trenes på autoritative kilder—et fenomen kjent som hallusinasjoner som kan arte seg som anbefaling om ikke-eksisterende medisinsk utstyr, feil behandlingsprotokoller eller oppdiktede legemiddelinteraksjoner. Et bemerkelsesverdig tilfelle var Men’s Journal som publiserte en AI-generert artikkel med 18 konkrete medisinske feil, inkludert farlige behandlingsanbefalinger som kunne skade leserne. Hovedproblemet er at AI mangler “Experience”—den førstehånds kliniske kunnskapen som skiller eksperter fra statistiske mønstergjenkjenningssystemer. Dette gapet betyr at uten riktig strukturert, autoritativt innhold fra verifiserte medisinske fagfolk, vil LLM-er selvsikkert generere plausibelt, men potensielt farlig medisinsk veiledning.

AI Overviews og lignende LLM-drevne svarsystemer endrer fundamentalt hvordan pasienter oppdager helseinformasjon ved å gi direkte svar uten å kreve besøk på nettsteder, og fjerner effektivt den tradisjonelle klikkstrømmen som har drevet trafikken til helsesider i flere tiår. Synlighet avhenger nå av sitering i AI-responser fremfor rangeringsposisjon, noe som betyr at en helseaktørs artikkel kan bli syntetisert inn i et AI-svar uten å motta trafikk eller anerkjennelse. LLM-er syntetiserer informasjon fra flere kilder samtidig, og skaper en ny informasjonsarkitektur der enkeltstående nettsteder konkurrerer om å bli inkludert i AI-genererte sammendrag snarere enn om topplasseringer i søk. Helseaktører må erkjenne at Share of Model (SOM)—andelen AI-svar som siterer deres innhold—har blitt det kritiske synlighetsmålet, og erstatter tradisjonelle klikkrater. Dette krever en grunnleggende omlegging av innholdsstrategien: i stedet for å optimalisere for klikk må helseorganisasjoner optimalisere for siteringskvalitet, nøyaktighet og strukturell klarhet som gjør innholdet til den foretrukne kilden for LLM-syntese.

LLM-er prosesserer medisinsk innhold mest effektivt når det er organisert med tydelig hierarkisk struktur som speiler klinisk beslutningstaking: tilstandsdefinisjon → symptombilde → diagnosekriterier → behandlingsalternativer → prognose. Progressiv avsløring av arkitektur—å presentere enkle konsepter før de komplekse—gjør det mulig for LLM-er å bygge nøyaktige mentale modeller i stedet for å blande sammen relaterte, men distinkte tilstander. Spørsmålsbasert innholdsdesign (besvare “Hva er tilstand X?” før “Hvordan behandles den?”) samsvarer med hvordan LLM-er henter og syntetiserer informasjon på tvers av dokumenter. Semantisk rikdom og sammenkoblede konsepter—å koble eksplisitt relaterte tilstander, behandlinger og risikofaktorer—hjelper LLM-er å forstå relasjoner som ellers kan forbli implisitte. Implementering av Schema.org medisinsk oppmerking (MedicalCondition, MedicalProcedure, MedicalTreatment) gir strukturert data som LLM-er kan tolke og sitere pålitelig. Naturlig språk som etterligner ekspertforklaring—med terminologi leger ville brukt, men fortsatt tilgjengelig—signalerer autentisitet både til LLM-er og mennesker. Helseorganisasjoner bør revidere eksisterende innhold mot disse strukturelle kravene, da tradisjonelt SEO-optimalisert innhold ofte mangler hierarkisk klarhet og semantisk rikdom som LLM-er trenger for nøyaktig syntese.

Tilstedeværelse på flere plattformer forsterker autoritetssignaler på måter som enkeltstående nettsteder ikke kan, da LLM-er gjenkjenner konsistent ekspertise vist på flere autoritative kanaler. Medisinske Q&A-plattformer som HealthTap og Figure 1 gir direkte lege-til-pasient-interaksjon som LLM-er ser som ekte ekspertise, med verifiserte kvalifikasjoner og sanntidsengasjement. Profesjonelle nettverk som Doximity og medisinske LinkedIn-fellesskap etablerer anerkjennelse fra kolleger og profesjonell status som LLM-er vektlegger tungt i autoritetsvurdering. Bidrag til medisinsk Wikipedia og lignende samarbeidsbaser vises som vilje til å bidra til offentlig medisinsk kunnskap uten kommersiell motivasjon, et tillitssignal LLM-er gjenkjenner. Omfattende forfatterprofilsider—med spesialistgodkjenninger, publikasjoner, klinisk erfaring og institusjonelle tilknytninger—må finnes på hovednettstedet og lenkes konsekvent på tvers av plattformer. Konsistens på tvers av plattformer i kvalifikasjoner, spesialiteter og kliniske perspektiver forsterker autentisitet; motsetninger mellom plattformer utløser LLM-skepsis. Helseorganisasjoner bør utvikle en autoritetstrategi på tvers av plattformer som ser hver plattform som et forsterkende signal fremfor en separat kanal, slik at legenes ekspertise er synlig og etterprøvbar i hele det digitale økosystemet.

Tradisjonell helseanalyse—måling av organisk trafikk, klikkrater og søkerangeringer—overser hele AI-synlighetshistorien, og skaper et farlig blindsone der innholdet ser vellykket ut etter gamle mål, men forblir usynlig for LLM-er. Share of Model (SOM) blir det avgjørende nye målet, og måler hvor stor andel av AI-genererte svar om en gitt tilstand som siterer din organisasjons innhold. Effektiv overvåking krever systematisk testing på tvers av flere LLM-plattformer (ChatGPT, Claude, Perplexity og nye konkurrenter) med konsistente spørsmål om dine spesialfelt, dokumentering av siteringsfrekvens og posisjonering i svarene. Siteringskvalitet er like viktig som siteringsfrekvens—å bli sitert som hovedkilde veier tyngre enn å være med i en liste over sekundære referanser, og LLM-er gjenkjenner når innhold siteres for spesifikk ekspertise versus generell informasjon. Overvåkingsverktøy spenner fra manuell testing (kjøre spørsmål og dokumentere resultater) til automatiseringsplattformer som sporer SOM-endringer over tid og varsler om synlighetsendringer. Indirekte indikatorer som merkevaresøkvolum, pasienttilbakemeldinger som nevner AI-anbefalinger, og henvisningsmønstre fra AI-plattformer gir supplerende data som bekrefter SOM-trender. Helseorganisasjoner bør etablere grunnlinjemålinger for SOM umiddelbart, da konkurransebildet endrer seg raskt og tidlig synlighetsfordel forsterkes over tid.

Helseorganisasjoner bør starte med ett spesialfelt fremfor å forsøke en total omlegging samtidig, slik at teamene kan utvikle kompetanse og finjustere prosesser før skalering. Innholdsrevisjon med LLM-briller innebærer å vurdere eksisterende artikler for hierarkisk klarhet, semantisk rikdom, spørsmålsbasert arkitektur og forfattertroverdighet—ofte avsløres det at innhold som rangerer godt mangler strukturen LLM-er trenger. Synlighetstesting på AI-plattformer med spesialitetsspesifikke spørsmål gir grunnlinje for SOM og avdekker hvilke tilstander og behandlinger som er synlige versus usynlige. Gjennomføring av spørsmålsbasert arkitektur innebærer å omstrukturere eksisterende innhold eller lage nytt innhold som starter med pasientspørsmål (“Hvorfor har jeg dette symptomet?”) før kliniske forklaringer. Forfatterprofilsider bør opprettes for hver legebidragsyter, med spesialistgodkjenninger, spesialiteter, publikasjoner og klinisk erfaring, og konsekvent lenkes fra alt innhold de har skrevet. Innholdsklynger rundt tilstander—å lage sammenkoblet innhold som dekker symptomer, diagnostikk, behandlingsalternativer og prognose—hjelper LLM-er å forstå helhetlig tilstandsinformasjon fremfor isolerte artikler. Denne trinnvise tilnærmingen lar helseorganisasjoner måle effekt, finjustere strategi og bygge intern kompetanse før utvidelse til flere fagfelt.

HIPAA-overholdelse er fremdeles avgjørende selv om innhold blir synlig for LLM-er; pasientvern gjelder uansett om informasjonen nås via søkemotorer eller AI-systemer, og krever nøye anonymisering og de-identifikasjon av alle kasus. Medisinske ansvarsfraskrivelser og nøyaktighetskrav må være eksplisitte og godt synlige, med klare uttalelser om at AI-syntetisert informasjon ikke skal erstatte profesjonell medisinsk konsultasjon, og at individuelle forhold kan avvike fra generelle råd. Faktasjekk og kildehenvisning blir kritiske samsvarselementer, da helseorganisasjoner er ansvarlige for nøyaktigheten av det de publiserer, og LLM-er vil forsterke feil gjennom tusenvis av brukerinteraksjoner. Regulatorisk gransking av AI-generert medisinsk innhold tiltar, med FDA og FTC som i økende grad undersøker hvordan AI-systemer presenterer medisinsk informasjon; helseorganisasjoner må sikre at alt innhold—uansett om det er skrevet av mennesker eller AI-assistert—oppfyller regulatoriske standarder. Menneskelig medisinsk gjennomgang av kvalifiserte leger må fortsatt være obligatorisk for alt helseinnhold, med dokumenterte prosesser som viser forpliktelse til nøyaktighet og sikkerhet. Ansvarshensyn strekker seg utover tradisjonell feilbehandling til å inkludere potensielt ansvar for informasjon som LLM-er syntetiserer og presenterer til pasienter; helseorganisasjoner bør rådføre seg med juridiske eksperter om sitt ansvar for hvordan innholdet brukes i AI-systemer. Samsvar og sikkerhet kan ikke behandles som sekundære hensyn i jakten på AI-synlighet.

AI vil fortsette å endre hvordan pasienter finner helseinformasjon i økende tempo, med LLM-er som blir stadig mer avanserte i medisinsk resonnement og stadig mer sentrale i pasientenes informasjonsinnhenting. Helseorganisasjoner som tilpasser innholdsstrategien nå posisjonerer seg som pålitelige kilder i dette nye økosystemet, mens de som venter risikerer å bli usynlige for AI-systemene pasientene faktisk bruker. Tidlige brukere får konkurransefordel gjennom etablerte autoritetssignaler, høyere Share of Model-målinger og pasienttillit bygget gjennom konsistent synlighet i AI-svar—fordeler som forsterkes etter hvert som LLM-er lærer å prioritere pålitelige kilder. Integrering av tradisjonell SEO og LLM-optimalisering er ikke et enten-eller-valg, men en komplementær strategi, da søkemotorer i økende grad innlemmer LLM-teknologi og pasienter fortsetter å bruke flere informasjonskilder. Langsiktig bærekraft avhenger av reell ekspertise snarere enn optimaliseringstriks; helseorganisasjoner som investerer i autentisk medisinsk kunnskap, åpne kvalifikasjoner og nøyaktig informasjon vil lykkes uavhengig av hvordan informasjonsinnhenting utvikler seg. Landskapet for helseinnhold har endret seg grunnleggende, og organisasjoner som ser denne overgangen som en mulighet heller enn en trussel vil definere fremtidens pasientinformasjon.

YMYL (Your Money Your Life) refererer til innhold som kan ha betydelig innvirkning på folks helse, økonomiske stabilitet eller sikkerhet. Helse er den kategorien med høyest gransking fordi medisinsk feilinformasjon kan forårsake alvorlig skade eller død. Google bruker strengere algoritmiske standarder for YMYL-innhold, og LLM-er brukes i økende grad av pasienter for å finne helseinformasjon, noe som gjør YMYL-overholdelse avgjørende for synlighet.

LLM-er syntetiserer informasjon fra flere kilder for å gi direkte svar, mens søkemotorer rangerer individuelle sider. Helseinnhold må nå struktureres for sitering av AI-systemer, ikke bare for Google-rangering. Det betyr at ditt innhold kan undervise tusenvis gjennom AI-svar uten å motta direkte trafikk til nettstedet, og krever en grunnleggende annerledes optimaliseringstilnærming.

E-E-A-T står for Experience, Expertise, Authoritativeness og Trustworthiness. Helseinnhold krever de høyeste E-E-A-T-standardene, med vekt på førstehånds medisinsk erfaring og verifiserte kvalifikasjoner. Googles Quality Rater Guidelines nevner E-E-A-T 137 ganger, noe som gjenspeiler den kritiske betydningen for synlighet av helseinnhold i både søk og LLM-systemer.

Studier viser at AI produserer ubegrunnede medisinske påstander 30-50 % av tiden og hallusinerer medisinsk informasjon. AI mangler reell medisinsk erfaring og kan ikke verifisere informasjon mot gjeldende medisinske standarder. Derfor er menneskelig medisinsk gjennomgang og ekspertforfatterskap fortsatt essensielt—AI skal bistå helsepersonell, ikke erstatte dem.

Test innholdet ditt i ChatGPT, Claude og Perplexity med vanlige pasientspørsmål innen ditt fagfelt. Følg med på Share of Model (SOM)-målinger—prosentandelen AI-svar som siterer ditt innhold. AmICited.com automatiserer denne overvåkingen og gir sanntidsinnsikt i hvordan ditt helsemerke vises på flere LLM-plattformer.

Tradisjonell SEO fokuserer på å rangere individuelle sider for nøkkelord. LLM-optimalisering legger vekt på omfattende dekning, semantisk rikhet og strukturert innhold som AI-systemer kan forstå og sitere. Begge tilnærmingene er komplementære—helseorganisasjoner trenger integrerte strategier som optimaliserer for både søkemotorer og LLM-er.

AI skal kun brukes som et verktøy for å støtte menneskelige medisinske eksperter, ikke for å erstatte dem. Alt helseinnhold må gjennomgås og godkjennes av kvalifiserte medisinske fagpersoner før publisering. Risikoen er for høy til å stole på AI-generering uten ekspertkontroll og verifisering.

AmICited.com overvåker hvordan helsemerker og medisinsk innhold vises i AI-svar på tvers av ChatGPT, Perplexity, Google AI Overviews og andre LLM-plattformer. Den gir synlighetsmålinger, sporer Share of Model (SOM), og tilbyr optimaliseringsanbefalinger for å hjelpe helseorganisasjoner med å sikre at deres ekspertise er søkbar gjennom AI-drevet pasientforskning.

Følg med på hvordan ditt medisinske innhold vises i ChatGPT, Perplexity, Google AI Overviews og andre LLM-plattformer. Få sanntidsinnsikt i din Share of Model (SOM) og optimaliser for AI-drevet pasientoppdagelse.

YMYL-innhold krever høye E-E-A-T-standarder. Lær hva som kvalifiserer som Your Money Your Life-innhold, hvorfor det er viktig for SEO og AI-synlighet, og hvorda...

Diskusjon i fellesskapet om hvordan AI-systemer håndterer YMYL (Your Money or Your Life)-emner. Ekte innsikt om synlighet for helse-, finans- og juridisk innhol...

Lær hva YMYL-emner er i AI-søk, hvordan de påvirker merkevarens synlighet i ChatGPT, Perplexity og Google AI Overviews, og hvorfor overvåkning av dem er viktig ...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.