7 %-overlappingsproblemet: Hvorfor synlighet på Google ikke betyr AI-synlighet

Kun 7 % av URL-ene som nevnes av AI-søkemotorer samsvarer med Googles toppresultater. Oppdag hvorfor rangering på Google ikke garanterer AI-synlighet og hvordan...

Lær hvorfor KI-crawlere som ChatGPT ikke kan se JavaScript-gjengitt innhold, og hvordan du gjør nettstedet ditt synlig for KI-systemer. Oppdag gjengivelsesstrategier for KI-synlighet.

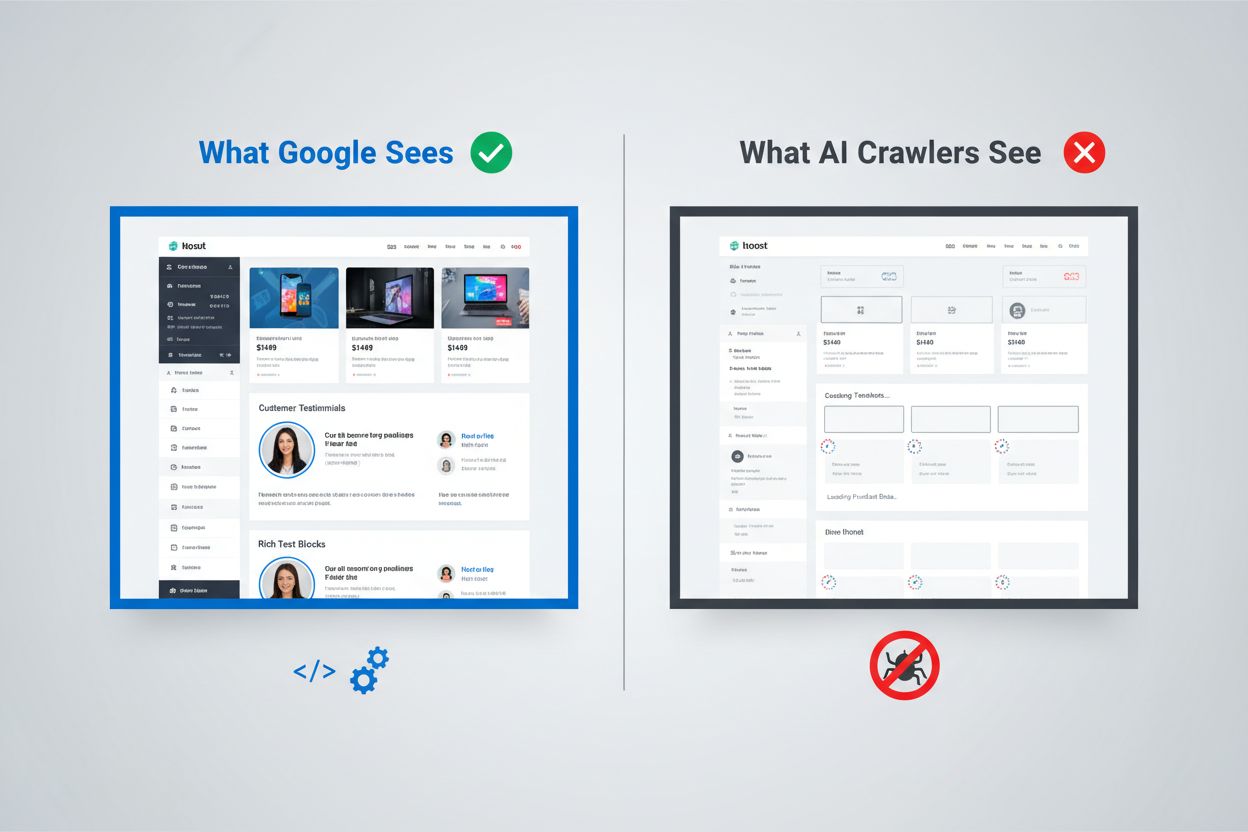

Det digitale landskapet har fundamentalt endret seg, men de fleste organisasjoner har ikke fulgt etter. Mens Googles sofistikerte gjengivelsespipeline kan kjøre JavaScript og indeksere dynamisk generert innhold, opererer KI-crawlere som ChatGPT, Perplexity og Claude under helt andre begrensninger. Dette skaper et kritisk synlighetsgap: Innhold som fremstår perfekt for menneskelige brukere og til og med for Googles søkemotor, kan være fullstendig usynlig for KI-systemene som i økende grad driver trafikk og påvirker kjøpsbeslutninger. Å forstå dette skillet er ikke lenger bare av teknisk interesse—det blir avgjørende for å opprettholde synlighet på tvers av hele det digitale økosystemet. Innsatsen er høy, og løsningene er mer nyanserte enn de fleste organisasjoner er klar over.

Googles tilnærming til JavaScript-gjengivelse representerer et av de mest sofistikerte systemene som noensinne er bygget for nettindeksering. Søkemotorgiganten bruker et to-bølge gjengivelsessystem hvor sider først crawles for statisk HTML-innhold, og deretter gjengis på nytt ved hjelp av en headless Chrome-nettleser gjennom sin Web Rendering Service (WRS). I denne andre bølgen kjører Google JavaScript, bygger opp hele DOM (Document Object Model), og fanger tilstanden til den fullt gjengitte siden. Prosessen inkluderer gjengivelsescaching, slik at Google kan gjenbruke tidligere gjengitte versjoner for å spare ressurser. Hele systemet er designet for å håndtere kompleksiteten til moderne webapplikasjoner samtidig som det kan crawle milliarder av sider. Google investerer enorme datakraftressurser i denne evnen, med tusenvis av headless Chrome-installasjoner for å prosessere nettets JavaScript-tunge innhold. For organisasjoner som er avhengige av Google-søk, betyr dette at klientbasert gjengitt innhold har en sjanse til å bli synlig—men bare fordi Google har bygget en ekstremt kostbar infrastruktur for å støtte det.

KI-crawlere opererer under fundamentalt annerledes økonomiske og arkitektoniske begrensninger som gjør JavaScript-kjøring upraktisk. Ressursbegrensninger er den viktigste faktoren: Å kjøre JavaScript krever oppstart av nettlesermotorer, minnehåndtering og tilstandshåndtering på tvers av forespørsler—alt dette er dyre operasjoner i stor skala. De fleste KI-crawlere arbeider med tidsvinduer på 1–5 sekunder, noe som betyr at de må hente og prosessere innhold ekstremt raskt eller droppe forespørselen helt. Kost-nytte-analysen taler ikke for JavaScript-kjøring for KI-systemer; de kan trene på langt mer innhold ved kun å prosessere statisk HTML enn ved å gjengi hver side de møter. I tillegg stripper prosesseringspipen for treningsdata til store språkmodeller vanligvis bort CSS og JavaScript under innlasting, og fokuserer kun på det semantiske HTML-innholdet. Den arkitektoniske filosofien er grunnleggende forskjellig: Google bygde gjengivelse inn i sin kjerneindeksering fordi søkeresultater er avhengig av å forstå gjengitt innhold, mens KI-systemer prioriterer bredde fremfor dybde. Dette er ikke en begrensning som enkelt kan overvinnes—det er innebygd i den grunnleggende økonomien bak hvordan disse systemene opererer.

Når KI-crawlere henter en side, mottar de rå HTML-filen uten noen JavaScript-kjøring, noe som ofte betyr at de ser en dramatisk annerledes versjon av innholdet enn det menneskelige brukere gjør. Single Page Applications (SPA) bygget med React, Vue eller Angular er spesielt problematiske, fordi de som oftest leverer minimal HTML og er helt avhengige av JavaScript for å fylle innholdet på siden. En KI-crawler som henter et React-basert e-handelsside, kan motta HTML som kun inneholder tomme <div id="root"></div>-tagger uten faktisk produktinformasjon, priser eller beskrivelser. Crawleren ser skjelettet av siden, men ikke innholdet. For innholdstunge nettsteder betyr dette at produktkataloger, blogginnlegg, pristabeller og dynamiske innholdsseksjoner rett og slett ikke eksisterer i KI-crawlerens synsfelt. Det finnes mange eksempler fra virkeligheten: En SaaS-plattforms funksjonstabell kan være helt usynlig, et e-handelsnetts anbefalte produkter blir ikke indeksert, og en nyhetssides dynamisk innlastede artikler kan fremstå som blanke sider. HTML-en KI-crawlere mottar er ofte bare applikasjonsskallet—det faktiske innholdet ligger i JavaScript-bunter som aldri kjøres. Dette skaper en situasjon hvor siden ser perfekt ut i en nettleser, men nærmest tom ut for KI-systemer.

Forretningspåvirkningen av dette gjengivelsesgapet går langt utover tekniske bekymringer og påvirker direkte inntekter, synlighet og konkurranseposisjon. Når KI-crawlere ikke ser innholdet ditt, lider flere viktige forretningsfunksjoner:

Den kumulative effekten er at organisasjoner som investerer tungt i innhold og brukeropplevelse, kan oppleve å bli usynlige for en stadig viktigere bruker- og systemgruppe. Dette er ikke et problem som løser seg selv—det krever bevisste tiltak.

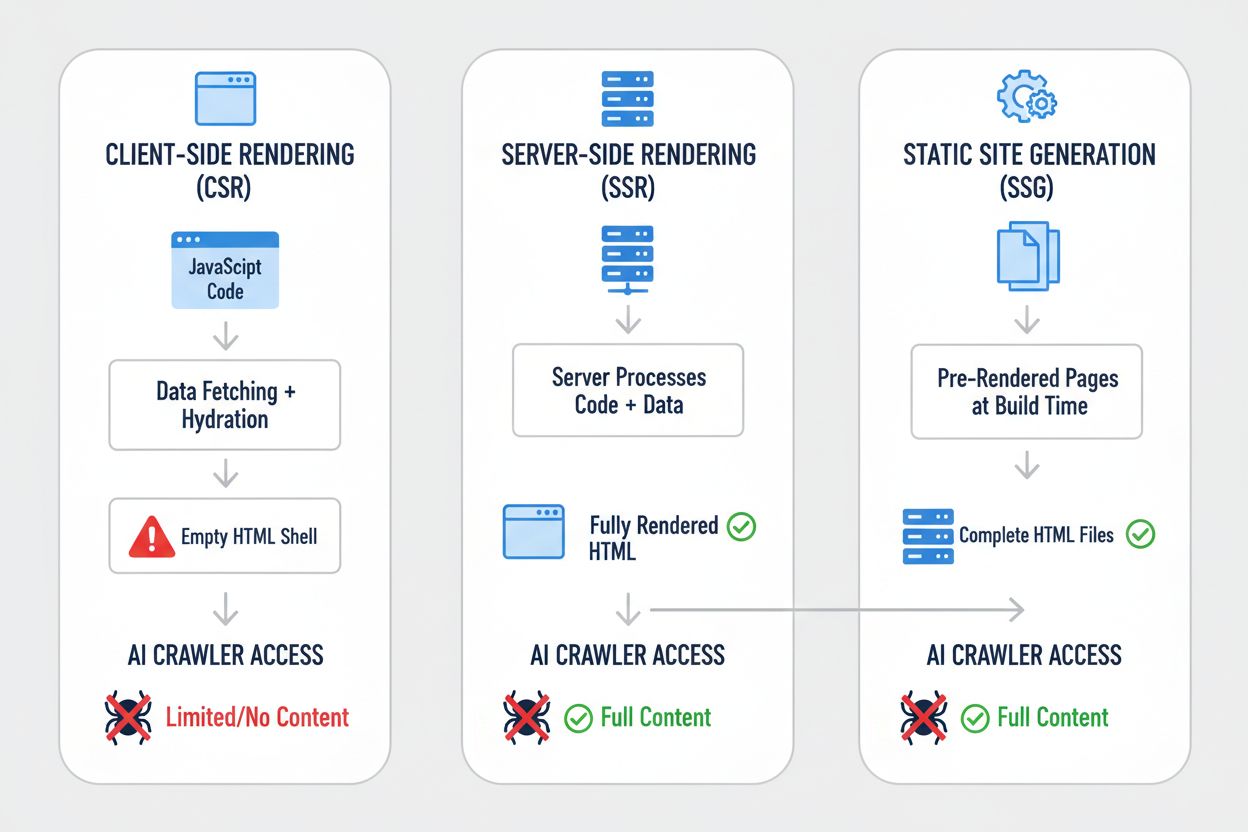

Ulike gjengivelsesstrategier gir dramatisk forskjellige resultater når man ser dem gjennom KI-crawlerens linse. Valget av gjengivelsesstrategi avgjør fundamentalt hva KI-systemer kan se og indeksere. Slik sammenlignes de viktigste strategiene:

| Strategi | Hva KI ser | Innvirkning på KI-synlighet | Kompleksitet | Best for |

|---|---|---|---|---|

| Server-side rendering (SSR) | Fullstendig HTML med alt innhold gjengitt | Full synlighet—KI ser alt | Høy | Innholdstunge nettsteder, SEO-kritiske applikasjoner |

| Statisk nettsteds-generering (SSG) | Forhåndsgjengitte HTML-filer | Utmerket synlighet—innholdet er statisk HTML | Middels | Blogger, dokumentasjon, markedsføringssider |

| Klientbasert gjengivelse (CSR) | Tomt HTML-skall, minimalt innhold | Dårlig synlighet—KI ser kun skjelettet | Lav | Sanntidsdashbord, interaktive verktøy |

| Hybrid (SSR + CSR) | Initielt HTML + klientbaserte forbedringer | God synlighet—kjerneinnhold synlig | Svært høy | Komplekse applikasjoner med dynamiske funksjoner |

| Forhåndsgjengivelsestjeneste | Bufret gjengitt HTML | God synlighet—avhenger av tjenestekvalitet | Middels | Eksisterende CSR-nettsteder med behov for raske tiltak |

| API-først + markup | Strukturert data + HTML-innhold | Utmerket synlighet—om korrekt implementert | Høy | Moderne webapplikasjoner, headless CMS |

Hver strategi innebærer ulike avveininger mellom utviklingskompleksitet, ytelse, brukeropplevelse og KI-synlighet. Den avgjørende innsikten er at synlighet for KI-systemer henger sterkt sammen med at innholdet finnes i statisk HTML-form—uavhengig av om HTML-en lages ved bygging, ved forespørsel eller serveres fra cache. Organisasjoner må vurdere sin gjengivelsesstrategi ikke bare for brukeropplevelse og ytelse, men eksplisitt for KI-crawler-synlighet.

Server-side rendering (SSR) regnes som gullstandarden for KI-synlighet fordi det leverer fullstendig gjengitt HTML til hver forespørsel—både for menneskelige nettlesere og KI-crawlere. Med SSR kjøres applikasjonskoden på serveren, og hele HTML-svaret genereres før det sendes til klienten, slik at KI-crawlere mottar en fullstendig gjengitt side på første forsøk. Moderne rammeverk som Next.js, Nuxt.js og SvelteKit har gjort SSR mye mer praktisk enn i tidligere generasjoner, og håndterer komplekse aspekter som hydrering (der klientbasert JavaScript tar over for servergjengitt HTML) automatisk. Fordelene strekker seg utover KI-synlighet: SSR forbedrer gjerne Core Web Vitals, reduserer Time to First Contentful Paint, og gir bedre ytelse for brukere med treg tilkobling. Ulempen er økt serverbelastning og kompleksitet ved tilstandshåndtering mellom server og klient. For organisasjoner hvor KI-synlighet er kritisk—særlig innholdstunge sider, e-handel og SaaS-applikasjoner—er SSR ofte det mest forsvarlige valget. Investeringen i SSR-infrastruktur gir uttelling på flere områder: bedre synlighet i søkemotorer, bedre KI-crawler-synlighet, bedre brukeropplevelse og bedre ytelsesstatistikk.

Statisk nettsteds-generering (SSG) tar en annen tilnærming ved å gjengi sidene på forhånd under bygging, og generere statiske HTML-filer som kan leveres umiddelbart til alle forespørsler. Verktøy som Hugo, Gatsby og Astro har gjort SSG stadig kraftigere og mer fleksibelt, med støtte for dynamisk innhold via API-er og inkrementell statisk regenerering. Når en KI-crawler henter en side som er laget med SSG, mottar den fullstendig, statisk HTML med alt innhold gjengitt—perfekt synlighet. Ytelsesfordelene er eksepsjonelle: statiske filer leveres raskere enn noen dynamisk gjengivelse, og infrastrukturen er minimal. Begrensningen er at SSG passer best for innhold som ikke endres ofte; sider må bygges på nytt og distribueres ved innholdsoppdatering. For blogger, dokumentasjon, markedsføringssider og innholdstunge applikasjoner er SSG ofte det optimale valget. Kombinasjonen av utmerket KI-synlighet, fremragende ytelse og minimalt behov for infrastruktur gjør SSG attraktivt for mange formål. Men for applikasjoner som krever sanntids-personalisering eller hyppig oppdatert innhold, blir SSG mindre praktisk uten ekstra kompleksitet som inkrementell statisk regenerering.

Klientbasert gjengivelse (CSR) er fortsatt populært til tross for betydelige ulemper for KI-synlighet, først og fremst fordi det gir best utvikleropplevelse og mest fleksibel brukeropplevelse for svært interaktive applikasjoner. Med CSR sendes minimal HTML fra serveren, og JavaScript bygger opp hele siden i nettleseren—noe som betyr at KI-crawlere ser nesten ingenting. React-, Vue- og Angular-applikasjoner leveres vanligvis med CSR som standard, og mange organisasjoner har bygget hele sin teknologistack rundt dette mønsteret. Appellen er forståelig: CSR muliggjør rike, interaktive opplevelser, sanntidsoppdateringer og smidig klientnavigasjon. Problemet er at denne fleksibiliteten går på bekostning av KI-synligheten. For applikasjoner som absolutt krever CSR—sanntidsdashbord, samarbeidsverktøy, komplekse interaktive apper—finnes det omveier. Forhåndsgjengivelsestjenester som Prerender.io kan lage statiske HTML-øyeblikksbilder av CSR-sider og servere disse til crawlere, mens den interaktive versjonen leveres til nettlesere. Alternativt kan man bruke hybride løsninger der kritisk innhold gjengis på serveren, mens interaktive funksjoner fortsatt kjøres på klienten. Hovedpoenget er at CSR bør være et bevisst valg med full forståelse av synlighetskonsekvensene, ikke et standardvalg.

Å implementere praktiske løsninger krever en systematisk tilnærming som starter med å forstå dagens tilstand og fortsetter med implementering og løpende overvåking. Start med en revisjon: bruk verktøy som Screaming Frog, Semrush eller egendefinerte skript for å crawle nettstedet ditt slik en KI-crawler ville gjort, og undersøk hvilket innhold som faktisk er synlig i rå HTML. Gjennomfør gjengivelsesforbedringer basert på funnene—dette kan bety å migrere til SSR, innføre SSG for relevante seksjoner, eller bruke forhåndsgjengivelse for kritiske sider. Test grundig ved å sammenligne hva KI-crawlere ser mot hva nettlesere ser; bruk curl-kommandoer for å hente rå HTML og sammenlign med den gjengitte versjonen. Overvåk kontinuerlig for å sikre at gjengivelsesendringer ikke ødelegger synligheten over tid. For organisasjoner med store og komplekse nettsteder kan det være lurt å prioritere de mest verdifulle sidene først—produktsider, prissider og viktige innholdsseksjoner—før man tar for seg hele nettstedet. Verktøy som Lighthouse, PageSpeed Insights og egendefinerte overvåkingsløsninger kan hjelpe med å spore gjengivelsesytelse og synlighetsmetrikker. Investeringen i å få dette riktig gir avkastning i form av både bedre søkesynlighet, KI-synlighet og generell nettstedsytelse.

Testing og overvåking av gjengivelsesstrategien din krever spesifikke teknikker som avslører hva KI-crawlere faktisk ser. Den enkleste testen er å bruke curl for å hente rå HTML uten JavaScript-kjøring:

curl -s https://example.com | grep -i "product\|price\|description"

Dette viser deg nøyaktig hva en KI-crawler mottar—hvis kritisk innhold ikke vises i dette utdataet, vil det heller ikke være synlig for KI-systemer. Nettleserbasert testing med Chrome DevTools kan vise deg forskjellen mellom den initiale HTML-en og det fullt gjengitte DOM-et; åpne DevTools, gå til Nettverk-fanen og undersøk HTML-responsen og den endelige gjengitte tilstanden. For løpende overvåking bør du implementere syntetisk overvåking som jevnlig henter sidene dine slik en KI-crawler ville gjort, og varsler hvis innholdssynligheten forverres. Spor metrikker som “prosent av innhold synlig i initial HTML” og “tid til innholdssynlighet” for å forstå gjengivelsesytelsen. Noen organisasjoner lager egne overvåkingsdashbord som sammenligner KI-crawler-synlighet mot konkurrenter, og gir innsikt i hvem som optimaliserer for KI-synlighet og hvem som ikke gjør det. Nøkkelen er å gjøre denne overvåkingen kontinuerlig og handlingsrettet—synlighetsproblemer bør fanges opp og fikses raskt, ikke oppdages måneder senere når trafikken plutselig faller.

Fremtiden for KI-crawleres evner er usikker, men nåværende begrensninger vil sannsynligvis ikke endres dramatisk med det første. OpenAI har eksperimentert med mer avanserte crawlere som Comet og Atlas-nettlesere som kan kjøre JavaScript, men disse er fortsatt eksperimentelle og er ikke tatt i bruk i stor skala for treningsdatainnsamling. De grunnleggende økonomiske forholdene er uendret: Å kjøre JavaScript i stor skala er fortsatt dyrt, og treningsdataprosessen har mer å tjene på bredde enn dybde. Selv om KI-crawlere etter hvert skulle få JavaScript-støtte, vil optimaliseringen du gjør nå ikke skade—servergjengitt innhold gir bedre ytelse for brukerne, raskere lasting og bedre SEO uansett. Det fornuftige er å optimalisere for KI-synlighet nå i stedet for å vente på at crawlerkapasiteten skal bli bedre. Det innebærer å behandle KI-synlighet som en førsteklasses bekymring i gjengivelsesstrategien, ikke som en ettertanke. Organisasjoner som gjør dette nå, vil ha et konkurransefortrinn etter hvert som KI-systemer blir stadig viktigere for trafikk og synlighet.

Å overvåke din KI-synlighet og spore forbedringer over tid krever riktige verktøy og metrikker. AmICited.com tilbyr en praktisk løsning for å følge med på hvordan innholdet ditt vises i KI-genererte svar og overvåke synligheten din på tvers av ulike KI-systemer. Ved å spore hvilke sider som blir sitert, gjengitt eller referert i KI-generert innhold, får du innsikt i den faktiske effekten av dine gjengivelsesoptimaliseringer. Plattformen hjelper deg med å identifisere hvilket innhold som er synlig for KI-systemene og hvilket som forblir usynlig, slik at du får konkrete data om hvor godt gjengivelsesstrategien din fungerer. Etter hvert som du implementerer SSR, SSG eller forhåndsgjengivelsesløsninger, lar AmICited.com deg måle den faktiske forbedringen i KI-synlighet—og se om optimaliseringen faktisk gir flere sitater og referanser. Denne tilbakemeldingssløyfen er avgjørende for å rettferdiggjøre investeringen i gjengivelsesforbedringer og finne ut hvilke sider som trenger ytterligere optimalisering. Ved å kombinere teknisk overvåking av hva KI-crawlere ser med forretningsmetrikker på hvor ofte innholdet ditt faktisk vises i KI-svar, får du et komplett bilde av KI-synlighetens ytelse.

Nei, ChatGPT og de fleste KI-crawlere kan ikke kjøre JavaScript. De ser kun rå HTML fra den første sideinnlastingen. Alt innhold som injiseres via JavaScript etter at siden er lastet, forblir fullstendig usynlig for KI-systemene, i motsetning til Google som bruker headless Chrome-nettlesere til å gjengi JavaScript.

Google bruker headless Chrome-nettlesere til å gjengi JavaScript, på samme måte som en ekte nettleser. Dette er ressurskrevende, men Google har infrastrukturen til å gjøre det i stor skala. Googles to-bølge gjengivelsessystem crawler først statisk HTML, og gjengir deretter sidene med JavaScript-eksekvering for å fange hele DOM-et.

Deaktiver JavaScript i nettleseren din og last inn nettstedet, eller bruk curl-kommandoen for å se rå HTML. Hvis viktig innhold mangler, vil ikke KI-crawlere se det heller. Du kan også bruke verktøy som Screaming Frog i “Text Only”-modus for å crawle nettstedet ditt slik en KI-crawler ville gjort.

Nei. Du kan også bruke statisk nettsteds-generering, forhåndsgjengivelsestjenester eller hybride tilnærminger. Den beste løsningen avhenger av innholdstype og hvor ofte det oppdateres. SSR fungerer godt for dynamisk innhold, SSG for stabilt innhold, og forhåndsgjengivelsestjenester for eksisterende CSR-nettsteder.

Google kan håndtere JavaScript, så dine Google-rangeringer bør ikke påvirkes direkte. Likevel vil optimalisering for KI-crawlere ofte forbedre nettstedets generelle kvalitet, ytelse og brukeropplevelse, noe som indirekte kan gi bedre rangeringer på Google.

Det avhenger av hvor ofte KI-plattformen crawler. ChatGPT-User crawler på forespørsel når brukere ber om innhold, mens GPTBot crawler sjeldent med lange intervaller mellom besøk. Endringer kan ta uker før de vises i KI-svar, men du kan overvåke fremdriften med verktøy som AmICited.com.

Forhåndsgjengivelsestjenester er enklere å implementere og vedlikeholde med minimale kodeendringer, mens SSR gir mer kontroll og bedre ytelse for dynamisk innhold. Velg basert på tekniske ressurser, hvor ofte innholdet oppdateres og applikasjonens kompleksitet.

Ja, du kan bruke robots.txt til å blokkere spesifikke KI-crawlere som GPTBot. Dette betyr imidlertid at innholdet ditt ikke vil vises i KI-genererte svar, og kan redusere synlighet og trafikk fra KI-drevne søkeverktøy og assistenter.

Følg med på hvordan KI-systemer refererer til merkevaren din på tvers av ChatGPT, Perplexity og Google KI-oversikter. Identifiser synlighetshull og mål effekten av dine gjengivelsesoptimaliseringer.

Kun 7 % av URL-ene som nevnes av AI-søkemotorer samsvarer med Googles toppresultater. Oppdag hvorfor rangering på Google ikke garanterer AI-synlighet og hvordan...

Oppdag de viktigste tekniske SEO-faktorene som påvirker synligheten din i AI-søkemotorer som ChatGPT, Perplexity og Google AI-modus. Lær hvordan sidehastighet, ...

Finn ut hvorfor konkurrentene dominerer AI-genererte svar, og lær dokumenterte strategier for å øke merkevarens synlighet i ChatGPT, Perplexity og Google AI Ove...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.