Multimodal AI-søk

Lær hvordan multimodale AI-søkesystemer behandler tekst, bilder, lyd og video sammen for å levere mer nøyaktige og kontekstuelt relevante resultater enn AI-løsn...

Lær hvordan du optimaliserer tekst, bilder og video for multimodale AI-systemer. Oppdag strategier for å forbedre AI-sitater og synlighet på tvers av ChatGPT, Gemini og Perplexity.

Multimodal AI representerer et grunnleggende skifte i hvordan kunstige intelligenssystemer behandler og forstår informasjon. I motsetning til unimodale systemer som håndterer bare tekst, bilder eller video uavhengig av hverandre, integrerer multimodal AI flere datatyper samtidig for å gi en mer helhetlig forståelse av kompleks informasjon. Denne tilnærmingen speiler hvordan mennesker naturlig opplever verden – vi skiller ikke mellom det vi ser, hører eller leser, men syntetiserer alle inntrykk sammen. Markedet for multimodal AI, verdsatt til 1,6 milliarder dollar i 2024, opplever eksplosiv vekst med en årlig vekst på 32,7 % (CAGR), noe som understreker teknologiens kritiske betydning for bedriftsstrategier rundt AI. Bransjeanalytikere anslår at 40 % av alle generative AI-løsninger vil være multimodale innen 2027, ifølge forskning fra Gartner. Denne overgangen er ikke bare inkrementell, men representerer et paradigmeskifte i hvordan organisasjoner utnytter AI for konkurransefortrinn. Sammenkoblingen av tekst-, bilde- og videobehandling gjør det mulig for AI-systemer å levere innsikt og kapasiteter som tidligere var umulig med enkeltmodalitetstilnærminger.

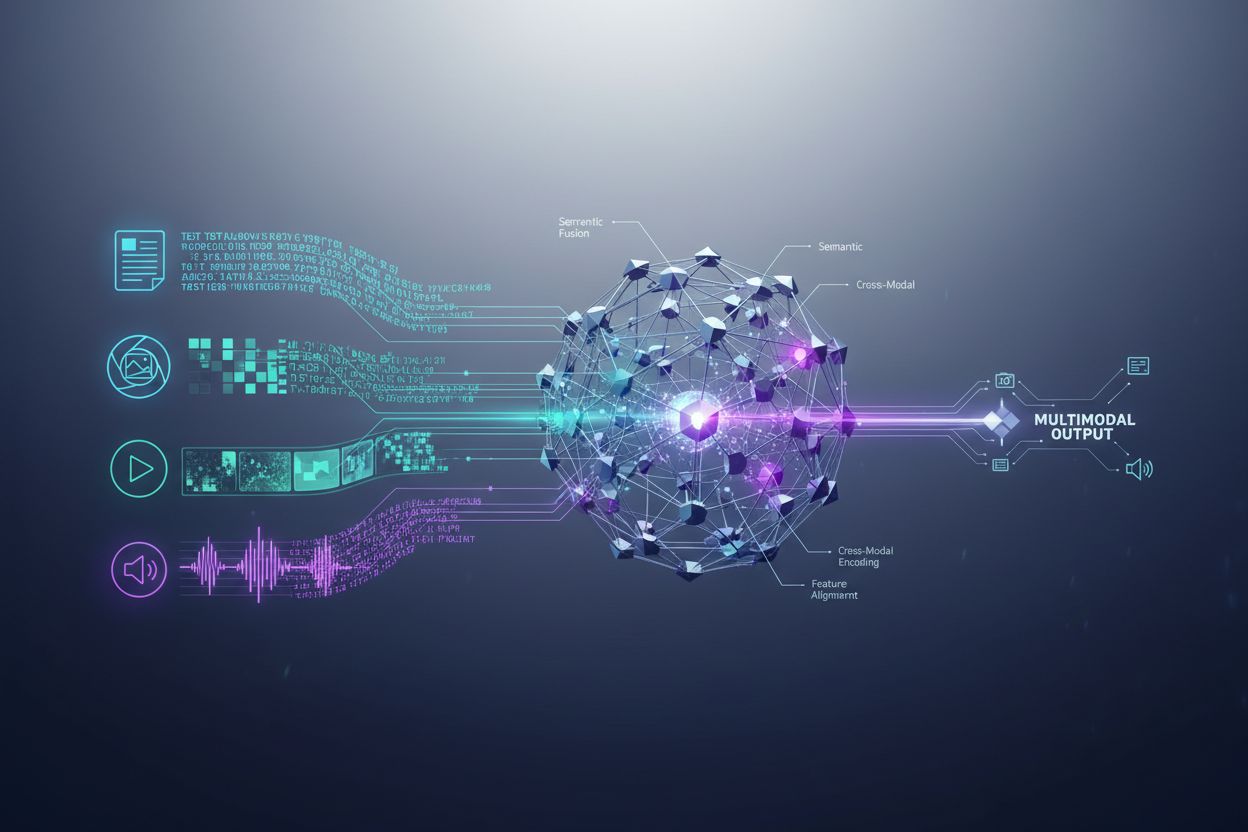

Multimodale AI-systemer bruker sofistikerte arkitekturkomponenter for å håndtere ulike datainnganger sømløst. Encodere er spesialiserte nevrale nettverk som konverterer hver datatype – tekst, bilder og video – til en samlet numerisk representasjon kalt embeddings. Disse embeddingene fanger opp den semantiske meningen i hver modalitet i et delt matematisk rom, slik at systemet kan sammenligne og relatere informasjon på tvers av ulike innholdstyper. Fusjonsmekanismen kombinerer deretter embeddingene, enten ved sammenkobling, addisjon eller mer avanserte lærte fusjonsteknikker som avgjør hvor mye vekt hver modalitet skal ha i sluttresultatet. Kryssoppmerksomhetsmekanismer gjør det mulig for modellen å dynamisk fokusere på relevant informasjon på tvers av modaliteter; for eksempel, når den analyserer et produktbilde med tilhørende tekst, kan systemet fokusere på spesifikke visuelle trekk som samsvarer med tekstbeskrivelser. Denne flertrinnsprosessen gjør det mulig for multimodale systemer å oppnå kontekstuell forståelse som enkeltmodale systemer ikke kan reprodusere. Tabellen under viser forskjellen i evner:

| Evne | Unimodal AI | Multimodal AI |

|---|---|---|

| Tekstanalyse | Utmerket | Utmerket |

| Bildeforståelse | Begrenset/Ingen | Utmerket |

| Videobehandling | Begrenset/Ingen | Utmerket |

| Kryssmodal resonnering | Ikke mulig | Utmerket |

| Kontekstintegrasjon | Én kilde | Flere kilder |

| Nøyaktighet i virkelighet | 60–75 % | 85–95 % |

| Behandlingshastighet | Rask | Optimalisert rask |

Landskapet for multimodal AI domineres av flere kraftige plattformer som har satt nye standarder for integrert prosessering. GPT-4o fra OpenAI er et flaggskip innen multimodellering, og håndterer tekst, bilder og video sømløst med innebygd integrasjon. Google Gemini tilbyr multimodale bedriftsfunksjoner med særlig styrke innen forståelse av komplekse visuelle dokumenter og lange videoer. Claude fra Anthropic leverer sofistikert multimodal resonnering med vekt på nøyaktighet og nyansert forståelse av tekst- og bildeinnhold. Metas ImageBind-teknologi demonstrerer en annen arkitektonisk tilnærming, og skaper et samlet embedding-rom på tvers av seks modaliteter inkludert tekst, bilde, lyd, dybde, termisk og IMU-data. Disse plattformene representerer frontlinjen innen multimodal teknologi, alle med sine særegne arkitektoniske innovasjoner og optimaliseringsstrategier. Organisasjoner som skal velge multimodale plattformer må vurdere ikke bare bredde, men også ytelsesoptimalisering, kostnadseffektivitet og integrasjon med eksisterende arbeidsflyt.

Multimodal AI transformerer driften på tvers av nesten alle bransjer, og gir målbare forbedringer i effektivitet, nøyaktighet og kundeopplevelse. Organisasjoner som implementerer disse teknologiene rapporterer bemerkelsesverdige resultater:

Helsevesen: Radiologer bruker multimodal AI for å analysere medisinske bilder sammen med pasientjournaler og kliniske notater, noe som forbedrer diagnostisk nøyaktighet og reduserer analysetid med opptil 40 %. AI-systemer kan korrelere visuelle funn med tekstlig sykehistorie for å identifisere mønstre mennesker kan overse.

Detaljhandel: Mote- og netthandelsbedrifter utnytter multimodal AI for å matche kundebeskrivelser med visuelle varelagre, slik at “søk med beskrivelse” øker konverteringsraten. Produktanbefalinger forbedres betydelig når AI forstår både visuelle preferanser og tekstlig tilbakemelding.

Produksjon: Kvalitetskontrollprosesser akselereres dramatisk med multimodale inspeksjonssystemer som kombinerer visuell feildeteksjon med sensordata og vedlikeholdslogger, og oppnår 100x raskere katalogisering av produksjonsfeil sammenlignet med manuelle prosesser.

Innholdsproduksjon: Medieselskaper bruker multimodal AI til automatisk å generere bildetekster, transkripsjoner og metadata for videoinnhold, og 72 % av medieledere med generativ AI rapporterer positiv avkastning på investeringene.

Kundeservice: Chatboter med multimodale evner kan prosessere kundebilder av problemer sammen med tekstbeskrivelser, og gi mer presise og kontekstuelle supportsvar.

Landbruk: Bønder bruker multimodale systemer som analyserer bilder av avlinger, værdata og sensordata fra jord for å optimalisere vanning, gjødsling og skadedyrkontroll.

Robotikk: Autonome systemer bruker multimodal persepsjon for å navigere i komplekse miljøer, og kombinerer visuelle inntrykk med lydsignaler og taktil tilbakemelding for sikrere og smartere drift.

For å maksimere effekten av multimodale AI-systemer må tekstinnhold optimaliseres målrettet for å forbedre maskinlesbarhet og kontekstforståelse. Strukturert dataoppmerking med schema.org-standarder hjelper AI-systemer å forstå semantiske relasjoner i innholdet, slik at de kan lage mer presise koblinger på tvers av modaliteter. Å bruke samtalevennlig språk fremfor kun formell prosa gjør det lettere for multimodale systemer å forstå hensikt og kontekst, særlig når tekst prosesseres sammen med visuelle eller videobaserte elementer. Beskrivende overskrifter og underoverskrifter hjelper både mennesker og gir strukturelle signaler som hjelper AI-systemer å organisere og prioritere informasjon. Å inkludere relevante nøkkelord i naturlig sammenheng – ikke kunstig stappet – sørger for at teksten stemmer overens med hvordan multimodale systemer identifiserer tematiske relasjoner. Metadataoptimalisering, inkludert titler, metabeskrivelser og strukturerte data-attributter, gir eksplisitte signaler om innholdets betydning som multimodale systemer kan bruke. Organisasjoner bør også vurdere hvordan tekst utfyller visuelle elementer; bildetekster og alt-tekst er ikke bare for tilgjengelighet – de er kritiske optimaliseringselementer som gjør det mulig for multimodal AI å forstå forholdet mellom tekst og visuell informasjon.

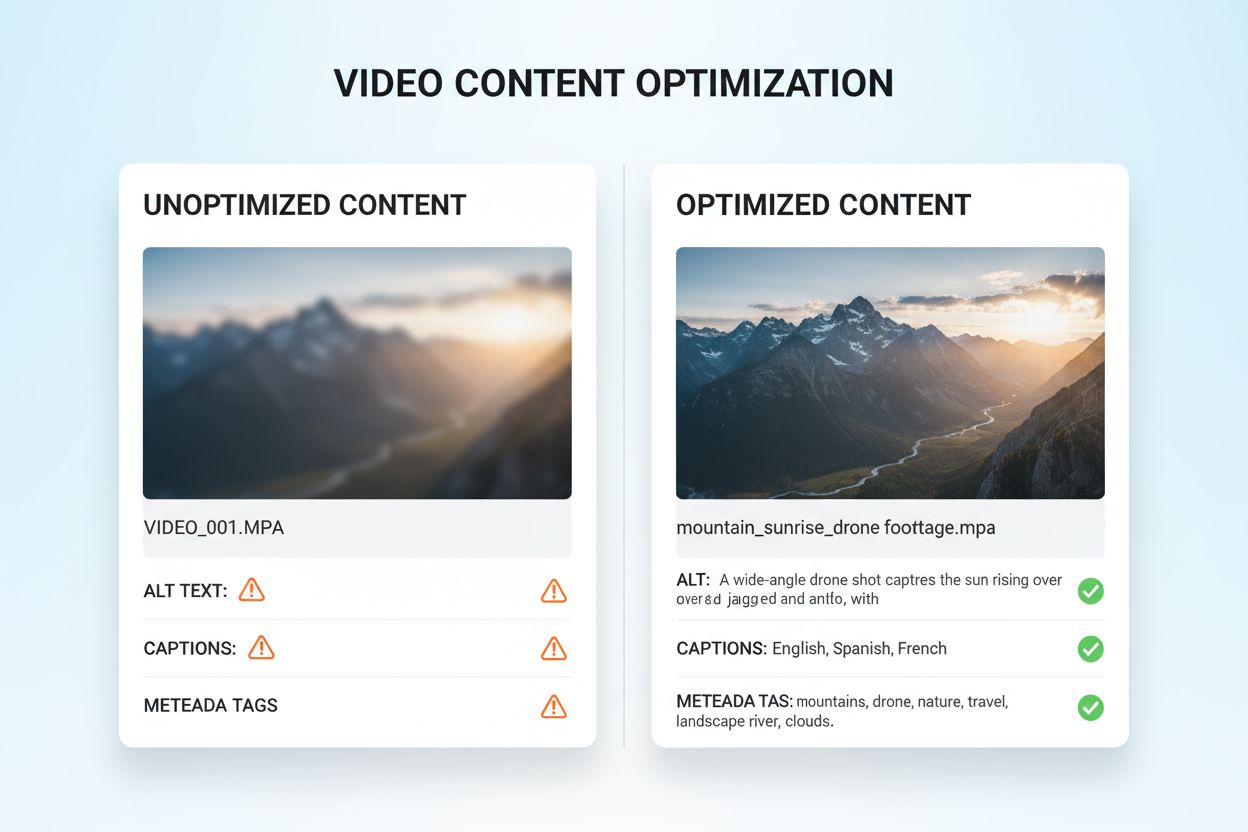

Optimalisering av visuelle og videobaserte medier for multimodal AI krever en helhetlig tilnærming som går langt utover tradisjonell SEO. Beskrivende alt-tekst er grunnleggende; istedenfor generiske beskrivelser bør alt-teksten fange opp semantisk mening, kontekst og relevante detaljer for å hjelpe AI-systemer til å forstå bildet. Filnavnskonvensjoner er viktige – beskrivende filnavn som “produkt-sammenligning-diagram-2024.jpg” gir avgjørende kontekst som AI-systemer bruker for å forstå formålet. Videotekster og transkripsjoner er essensielle; de gjør det mulig for multimodale systemer å koble taleinnhold med visuelle elementer, og forbedrer forståelsen av komplekse videoer betydelig. Metadatafelter som tittel, beskrivelse og tagger bør fylles ut med presisjon, da disse direkte påvirker hvordan AI-systemer kategoriserer og relaterer visuelt innhold til andre modaliteter. Bildekomprimering og teknisk optimalisering sikrer at visuell kvalitet er høy nok for AI-analyse, samtidig som lastetiden holdes lav. Strukturert data for visuelle medier, inkludert oppmerking av bilder, videoer og mediegallerier, gir eksplisitte signaler om innholdsrelasjoner. Organisasjoner bør også vurdere tidsmessig metadata for videoinnhold – markering av nøkkelmomenter, sceneskift og tematiske overganger hjelper multimodale systemer å forstå narrativ struktur og ekstrahere relevante segmenter.

Multimodale AI-systemer benytter to hovedtyper arkitektur, hver med sine fordeler og kompromisser. Forente arkitekturer behandler alle modaliteter i ett integrert nevralt nettverk som lærer felles representasjoner fra starten av. Denne tilnærmingen gir ofte overlegen kryssmodal resonnering fordi systemet får dyp forståelse av hvordan modalitetene henger sammen, men krever mer datakraft og lengre treningstid. Modulære arkitekturer bruker separate spesialiserte nettverk for hver modalitet, og kombinerer deretter utdataene gjennom fusjonsmekanismer. Dette gir større fleksibilitet, slik at organisasjoner kan bytte ut individuelle modalitetsprosessorer uten å måtte trene om hele systemet, og krever som regel færre ressurser. Mixture of Experts (MoE)-modeller er en fremvoksende hybridløsning, hvor ulike ekspertnettverk spesialiserer seg på ulike modaliteter eller oppgaver, og en styringsmekanisme sender innganger til riktig ekspert. Denne arkitekturen gir 30–50 % forbedret effektivitet sammenlignet med tette forente modeller, samtidig som nøyaktigheten opprettholdes. Valg av arkitektur avhenger av bruksområde: forente arkitekturer er best på komplekse resonneringsoppgaver som krever dyp forståelse på tvers av modaliteter, mens modulære løsninger passer der fleksibilitet og ressursbruk er viktigst.

Effektiv implementering av multimodal AI krever solide rammeverk for å måle både teknisk ytelse og forretningsmessig effekt. Nøkkelindikatorer (KPIer) bør inkludere nøyaktighetsmålinger for hver modalitet, kvalitet på kryssmodal resonnering, behandlingstid og kostnad per inferens. Analyseplattformer bør fange opp hvordan multimodal AI påvirker virksomhetsmål: konverteringsrater i detaljhandel, diagnostisk presisjon i helsevesenet, produksjonseffektivitet i industrien. Organisasjoner må også implementere attribusjonssporing for å forstå hvilken modalitet som gir størst bidrag til ulike resultater – denne innsikten styrer optimalisering og ressursbruk. ROI-måling bør ta høyde for både direkte besparelser (som 100x raskere katalogisering rapportert fra produksjon) og indirekte fordeler som økt kundetilfredshet eller færre feil. Overvåkingsverktøy bør følge med på ytelsesforringelse over tid, da virkelige data kan føre til at systemet blir mindre nøyaktig hvis det ikke følges opp. For organisasjoner som drar nytte av AI-generert innhold og innsikt, blir siterings- og attribusjonssporing stadig viktigere; verktøy som AmICited.com hjelper med å overvåke hvordan AI-systemer siterer og tillegger informasjon, gir innsyn i AI-beslutninger og sikrer samsvar med krav til innholdsproveniens. Regelmessige ytelsesrevisjoner og optimaliseringssykluser sørger for at multimodale systemer fortsetter å gi verdi etter hvert som virksomhetsbehov og datamønstre endres.

Det multimodale AI-landskapet utvikler seg raskt, med flere transformative trender som omformer hvordan organisasjoner drar nytte av slike teknologier. Integrasjon av stemme er neste store skritt, ettersom systemer i økende grad kombinerer lyd med visuelle og tekstlige data, og gir en virkelig helhetlig forståelse av menneskelig kommunikasjon og kontekst. Agentisk AI – AI-agenter som selvstendig kan planlegge og utføre flerstegsoppgaver – vil bruke multimodal persepsjon for å navigere i komplekse virkeligverdensscenarioer, fra autonome kjøretøy til robotisert prosessautomasjon i bedrifter. Sanntidsprosessering forbedres dramatisk, slik at multimodal analyse av direkte videostrømmer, lyd og sensordata åpner for umiddelbare beslutninger i tidskritiske situasjoner. Effektiviseringsteknikker som distillasjon og kvantisering gjør avanserte multimodale funksjoner tilgjengelig for organisasjoner med begrensede ressurser, og demokratiserer tilgangen til avansert AI. Spesialiserte bransjemodeller vil dukke opp, med multimodale systemer finjustert for bransjer som helse, juss eller finans, og levere bedre ytelse enn generelle modeller. Samspillet mellom disse trendene tyder på at multimodal AI vil gå fra å være et konkurransefortrinn til et grunnleggende krav for organisasjoner som vil forbli relevante i en stadig mer AI-drevet verden. Organisasjoner som begynner å optimalisere sitt innhold og sine prosesser for multimodal AI i dag, vil være best posisjonert for å utnytte morgendagens muligheter.

Multimodal AI prosesserer flere datatyper (tekst, bilder, lyd, video) samtidig, mens tradisjonell unimodal AI bare håndterer én type. Dette gir rikere kontekstforståelse og mer presise resultater. Multimodale systemer kan forstå relasjoner mellom ulike modaliteter og levere innsikt som enkeltmodale systemer ikke kan replikere.

Etter hvert som multimodal AI blir standard for generative AI-løsninger (anslått til 40 % innen 2027), sikrer optimalisering av innholdet ditt bedre synlighet i AI-genererte svar. Organisasjoner som optimaliserer på tvers av tekst, bilde og video oppnår bedre AI-sitater, høyere synlighet på plattformer som ChatGPT og Gemini, og generelt bedre innholdsprestasjoner.

Spor nøkkelindikatorer som nøyaktighet på tvers av modaliteter, kvalitet på kryssmodal resonnering, behandlingstid og forretningsmessig effekt (konverteringsrater, engasjement osv.). Bruk verktøy som AmICited.com for å overvåke hvordan AI-systemer siterer innholdet ditt, og implementer analyseverktøy for å forstå hvilke modaliteter som bidrar mest til virksomhetsresultatene dine.

Viktige utfordringer inkluderer å sikre konsistent metadata på tvers av modaliteter, opprettholde høy kvalitet på alt-tekst og bildetekster, synkronisere tidsdata i videoer og håndtere de datakraftressursene som kreves for behandling. Organisasjoner bør også planlegge for datatilrettelegging (10–20 % av prosjektbudsjettet) og endringsledelse når teamene tilpasser seg nye optimaliseringspraksiser.

Helsevesen, detaljhandel, produksjon, innholdsproduksjon, kundeservice, landbruk og robotikk har alle betydelige fordeler. Helsevesenet bruker det for diagnostisk nøyaktighet, detaljhandel for produktoppdagelse, produksjon for kvalitetskontroll (100x raskere katalogisering), og medieselskaper rapporterer 72 % ROI på generativ AI-investering.

AmICited.com overvåker hvordan AI-systemer som ChatGPT, Perplexity og Google AI Overviews siterer innholdet ditt på tvers av ulike modaliteter. Det gir sanntidsinnsikt i din AI-søkeposisjon, og hjelper deg å forstå hvordan ditt tekst-, bilde- og videoinnhold blir referert i AI-genererte svar.

Forente arkitekturer behandler alle modaliteter gjennom ett integrert nettverk, og gir overlegen kryssmodal resonnering, men krever mer datakraft. Modulære arkitekturer har separate nettverk for hver modalitet, noe som gir større fleksibilitet og effektivitet. Mixture of Experts (MoE)-modeller gir en hybrid tilnærming med 30–50 % effektivitetsforbedring.

Optimaliser tekst med strukturert data og samtalevennlig språk, legg til beskrivende alt-tekst og metadata på bilder, inkluder bildetekster og transkripsjoner for video, og bruk konsistente filnavn. Sørg for at alle modaliteter fungerer sammen for å gi fullstendig kontekst, og implementer skjemaoppmerking slik at AI-systemer forstår semantiske relasjoner.

Følg med på hvordan multimodale AI-systemer siterer innholdet ditt på ChatGPT, Perplexity, Google AI Overviews og andre plattformer. Få sanntidsinnsikt i din AI-søkeposisjon.

Lær hvordan multimodale AI-søkesystemer behandler tekst, bilder, lyd og video sammen for å levere mer nøyaktige og kontekstuelt relevante resultater enn AI-løsn...

Bli ekspert på multimodal AI-søkeoptimalisering. Lær hvordan du optimaliserer bilder og stemmespørringer for AI-drevne søkeresultater, med strategier for GPT-4o...

Lær hva multimodalt innhold for KI er, hvordan det fungerer, og hvorfor det er viktig. Utforsk eksempler på multimodale KI-systemer og deres bruksområder på tve...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.