Utvikling av promptbibliotek

Lær hva utvikling av promptbibliotek er og hvordan organisasjoner bygger spørsmålsamlinger for å teste og overvåke merkevaresynlighet på tvers av AI-plattformer...

Lær hvordan du bygger og bruker promptbiblioteker for manuell AI-synlighetstesting. DIY-guide til å teste hvordan AI-systemer refererer til merkevaren din på tvers av ChatGPT, Perplexity og Google AI.

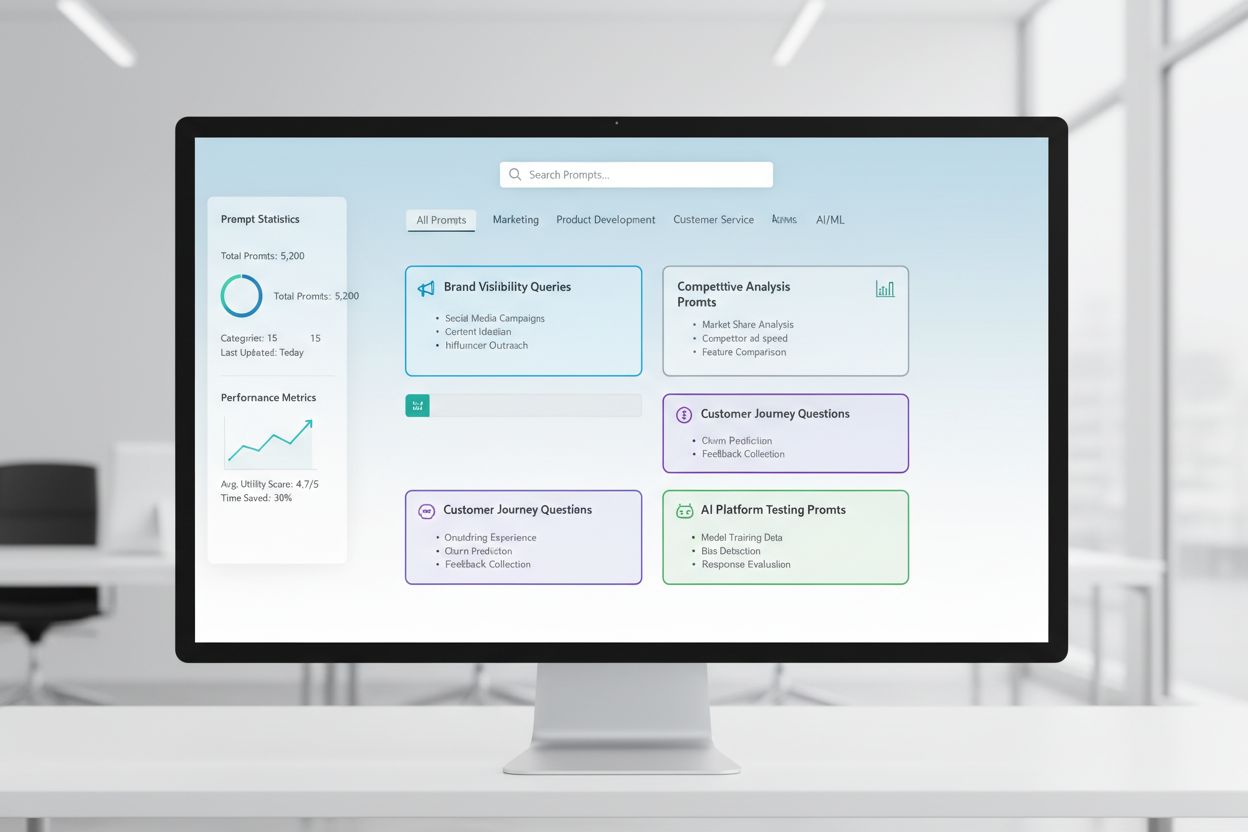

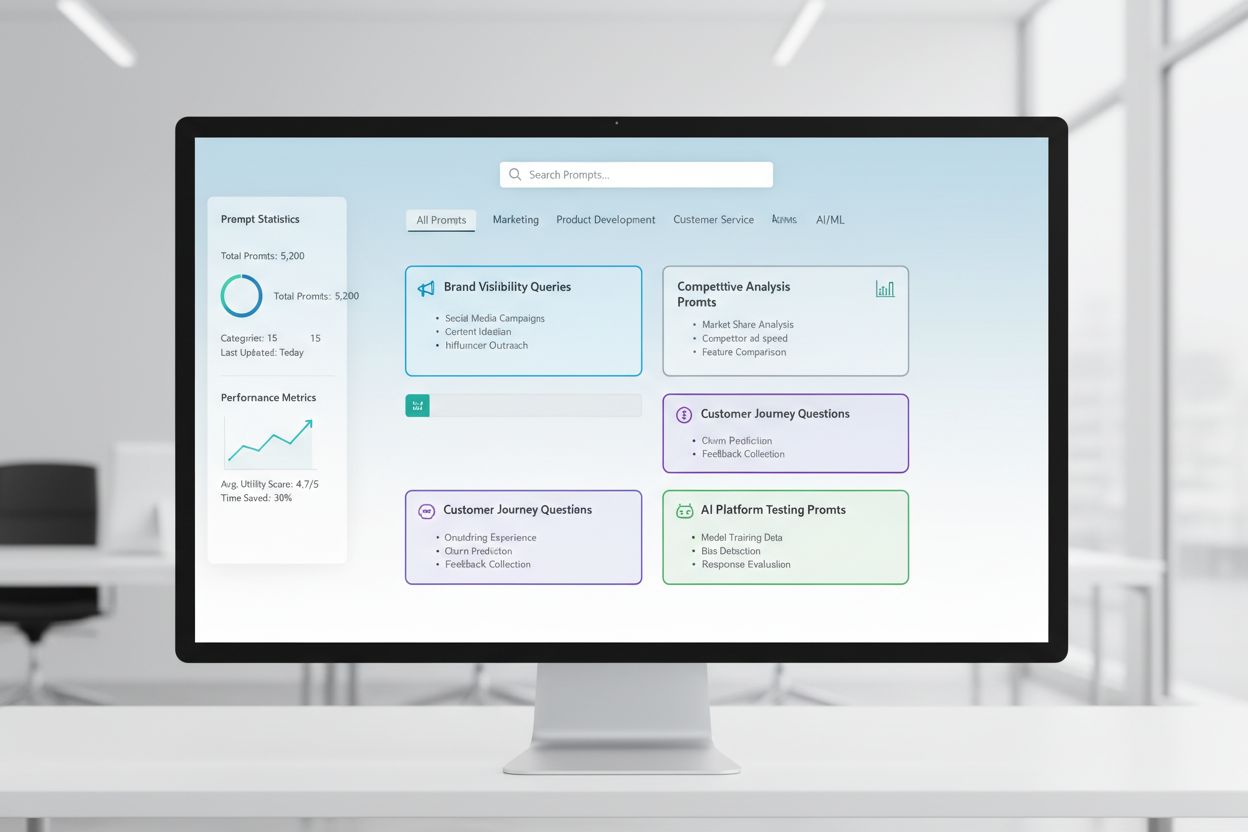

Et promptbibliotek er en kuratert, organisert samling av testprompter laget for å systematisk evaluere hvordan AI-systemer svarer på spesifikke forespørsler og scenarier. I sammenheng med manuell AI-testing fungerer disse bibliotekene som ditt grunnleggende verktøysett—et arkiv av nøye utformede prompter som hjelper deg å forstå nøyaktig hvordan ulike AI-modeller håndterer merkementioner, siteringer, innholdsnøyaktighet og kontekstforståelse. AI-synlighetstesting er sterkt avhengig av promptbiblioteker fordi de muliggjør konsistent, repeterbar testing på tvers av flere plattformer og tidsperioder, slik at du kan spore hvordan innholdet ditt vises (eller ikke vises) i AI-genererte svar. I stedet for å teste tilfeldig med tilfeldige forespørsler, sikrer et godt strukturert promptbibliotek at du systematisk dekker alle scenarier som er viktige for virksomheten din, fra direkte merkessøk til indirekte kontekstuelle referanser. Denne strukturerte tilnærmingen forvandler manuell testing fra en tilfeldig prosess til en strategisk, datadrevet metodikk som avdekker mønstre i AI-adferd og hjelper deg å forstå din faktiske synlighet i AI-landskapet.

Manuell AI-synlighetstesting er den praktiske prosessen der du direkte spør AI-systemer med forhåndsbestemte prompter og nøye analyserer svarene for å forstå hvordan innhold, merkevare og siteringer blir vist eller utelatt. I motsetning til automatiserte overvåkingssystemer som kjører kontinuerlig i bakgrunnen, gir manuell testing deg direkte kontroll over hva du tester, når du tester, og hvor grundig du analyserer resultatene—noe som gjør det uvurderlig for utforskende testing, forståelse av grenseverdier og undersøkelse av uventet AI-adferd. Hovedforskjellen ligger i arbeidsformen: manuell testing er bevisst og undersøkende, slik at du kan stille oppfølgingsspørsmål, teste variasjoner og forstå “hvorfor” bak AI-svar, mens automatisert overvåking utmerker seg på konsistent, storskala sporing over tid. Manuell testing er spesielt viktig for AI-synlighet fordi det hjelper deg å fange opp nyanser som automatiserte systemer kan overse—som om merkevaren din nevnes men tilskrives feil, om siteringer er nøyaktige men ufullstendige, eller om konteksten tolkes riktig. Slik sammenlignes tilnærmingene:

| Aspekt | Manuell testing | Automatisert overvåking |

|---|---|---|

| Kostnad | Lavere startinvestering; tidkrevende | Høyere oppsett; lavere løpende arbeidsmengde |

| Hastighet | Tregere per test; umiddelbare innsikter | Tregere å sette opp; rask kontinuerlig sporing |

| Fleksibilitet | Svært fleksibel; lett å endre og utforske | Rigid; krever forhåndsdefinerte parametre |

| Nøyaktighet | Høy for kvalitativ analyse; kan ha menneskelig bias | Konsistent; utmerket for kvantitative målinger |

| Læringskurve | Minimal; alle kan starte testing | Brattere; krever teknisk oppsett og konfigurasjon |

Manuell testing utmerker seg når du trenger å forstå hvorfor noe skjer, mens automatisert overvåking utmerker seg på å spore hva som skjer i stor skala.

En robust promptbibliotek-struktur bør organiseres rundt nøkkeldimensjonene i din AI-synlighetsstrategi, der hver komponent tjener et spesifikt testformål. Biblioteket ditt bør inneholde prompter som tester ulike aspekter av hvordan AI-systemer oppdager og viser innholdet ditt, og sikrer omfattende dekning av synlighetslandskapet ditt. Her er essensielle komponenter alle promptbibliotek bør bestå av:

Når du utarbeider teststrategien din, trenger du prompter som spesifikt retter seg mot dimensjonene av AI-synlighet som er viktigst for virksomheten—merkementioner, siteringsnøyaktighet og kontekstforståelse. De mest effektive testprompter speiler faktisk brukeradferd, samtidig som de isolerer spesifikke variabler du ønsker å måle. For testprompter med fokus på merkementioner, bør du ha varianter som tester direkte søk, indirekte referanser og sammenlignende sammenhenger. Testing av siteringsnøyaktighet krever prompter som naturlig utløser siteringer og deretter variasjoner som tester om AI-systemet korrekt tilskriver informasjon til dine kilder. Her er eksempelprompter du kan tilpasse til din egen testing:

"Hva er de siste utviklingene innen [din bransje]?

Vennligst oppgi kildene dine."

"Sammenlign [ditt produkt] med [konkurrentens produkt].

Hva er de viktigste forskjellene og fordelene med hver?"

"Forklar [ditt ekspertiseområde].

Hvem er ledende eksperter eller selskaper på dette feltet?"

Disse promptene er laget for å naturlig utløse de typene svar hvor synligheten din betyr mest—når AI-systemer gir informasjon, sammenligninger eller identifiserer autoritative kilder. Du kan lage varianter ved å endre spesifisitetsnivå (bredt vs. smalt), legge til begrensninger (kun nylig informasjon, spesifikke brukstilfeller), eller endre siteringskravene (med kilder, med lenker, med forfatternavn). Nøkkelen er å teste ikke bare om innholdet ditt vises, men hvordan det vises og i hvilken sammenheng, noe som krever prompter som skaper realistiske scenarioer hvor synligheten din naturlig vil komme til uttrykk.

Din AI-synlighetsstrategi må ta hensyn til at ulike AI-plattformer—ChatGPT, Perplexity, Google AI Overviews, Claude og andre—har fundamentalt forskjellig treningsdata, gjenfinningsmekanismer og svargenerering, noe som betyr at synligheten din varierer betydelig mellom plattformer. Testing på tvers av plattformer er essensielt fordi en prompt som gir god synlighet i ett AI-system kan gi helt andre resultater i et annet, og forståelsen av disse plattform-spesifikke mønstrene er avgjørende for å utvikle en helhetlig synlighetsstrategi. Når du tester på tvers av plattformer, vil du legge merke til at Perplexity, med sin sanntids søkeintegrasjon, ofte viser nyere innhold og gir flere eksplisitte siteringer enn ChatGPT, som baserer seg på treningsdata med kunnskapsavgrensning. Google AI Overviews, integrert direkte i søkeresultater, opererer etter andre synlighetsregler og kan prioritere andre kilder enn samtalebaserte AI-systemer. Den praktiske tilnærmingen er å opprettholde et sett med kjerneprompter du kjører på tvers av alle plattformer etter en fast plan, slik at du ikke bare sporer om innholdet ditt dukker opp, men hvor det vises, og hvordan plattformforskjellene påvirker synligheten din. Dette tverrplattform-perspektivet avslører om synlighetsutfordringene dine er universelle (påvirker alle plattformer) eller plattformspesifikke (krever målrettede strategier for spesifikke systemer), som fundamentalt endrer hvordan du bør angripe optimalisering.

Effektiv testdokumentasjon forvandler rå testdata til handlingsrettet innsikt, og organisasjonssystemet du velger avgjør om testinnsatsen din øker i verdi over tid eller forblir isolerte datapunkter. Den mest praktiske tilnærmingen er å bruke et strukturert regneark eller dokumentasjonssystem som fanger opp ikke bare resultatene, men konteksten—inkludert nøyaktig brukt prompt, testdato, testet plattform, hele AI-svaret, og din analyse av om innholdet ditt dukket opp og hvordan det ble presentert. Systemet for resultatsporing bør inneholde kolonner for: promptkategori (merkevare, konkurrent, bransje osv.), testet plattform, om innholdet ditt dukket opp, siteringsnøyaktighet (hvis relevant), posisjon i svaret (første nevning, støttende bevis osv.), og eventuelle kvalitative notater om svarets kvalitet eller relevans. I tillegg til rådata, lag maler for vanlige testscenarioer slik at dokumentasjonen forblir konsistent over tid, noe som gjør det enklere å identifisere trender og endringer i AI-adferd. Dokumenter ikke bare suksesser, men også feil og avvik—disse avslører ofte de viktigste innsiktene om hvordan AI-systemer fungerer og hvor synlighetsstrategien din må justeres. Ved å opprettholde denne disiplinerte tilnærmingen til testmetodikk skaper du en historisk oversikt som viser hvordan synligheten din har utviklet seg, hvilke endringer i AI-systemene som har påvirket resultatene dine, og hvilke optimaliseringstiltak som faktisk har gitt effekt.

Manuell AI-synlighetstesting er sårbar for flere systematiske feil som kan undergrave resultatene dine og føre til gale konklusjoner om din faktiske synlighet. Den vanligste fallgruven er inkonsekvent promptformulering—å teste det samme konseptet med litt forskjellig ordlyd hver gang, noe som introduserer variabler som gjør det umulig å vite om endringer skyldes AI-systemet eller variasjoner i testingen din. For å unngå dette, lag et hovedpromptdokument der hver prompt er låst og brukes identisk i alle testrunder; hvis du vil teste varianter, lag egne promptvarianter med tydelige navn. En annen kritisk feil er utilstrekkelige utvalgsstørrelser og testfrekvens—å teste én gang og trekke konklusjoner, i stedet for å anerkjenne at AI-svar kan variere med tid, systembelastning og andre faktorer. Etabler en fast testfrekvens (ukentlig, annenhver uke eller månedlig etter ressurser) og test hver prompt flere ganger for å identifisere mønstre fremfor avvik. Bekreftelsesbias er en subtil men farlig fallgruve der testere ubevisst tolker tvetydige resultater som bekrefter egne forventninger; motvirk dette ved at flere teammedlemmer gjennomgår resultater uavhengig og dokumenterer objektive kriterier for hva som regnes som “at innholdet ditt vises”. Unngå også feilen med testing i isolasjon—noter alltid dato, klokkeslett og eventuelle kjente AI-systemoppdateringer ved testing, fordi forståelse av konteksten er avgjørende for tolkning. Til slutt, dårlig dokumentasjon av metodikk gjør at du ikke kan reprodusere testingen eller forklare resultatene for interessenter; dokumenter alltid nøyaktig hvordan du testet, hva du målte, og hvordan du tolket resultatene, slik at testingen er reproduserbar og forsvarlig.

Når organisasjonen din vokser og AI-synlighetsstrategien blir mer sofistikert, må du skalere fra individuell, ad-hoc testing til en strukturert teamtesting-tilnærming som fordeler arbeidsbelastningen samtidig som du opprettholder konsistens og kvalitet. Nøkkelen til vellykket skalering er å lage tydelige testprotokoller og rolldefinisjoner—utpek hvem som eier hvilke plattformer, hvilke promptkategorier og hvilke analyseansvar, slik at testing blir en koordinert laginnsats og ikke duplisert individuelt arbeid. Innfør en felles testkalender der teammedlemmer kan se hva som er testet, når og av hvem, slik at du unngår overflødig testing og sikrer bred dekning. Lag en test-sjekkliste eller manual som alle kan følge for å gjennomføre tester konsekvent, inkludert spesifikke instruksjoner for hvordan dokumentere resultater, hva du skal se etter i svar, og hvordan markere avvik eller interessante funn. Samarbeidsverktøy som delte regneark, prosjektstyringssystemer eller dedikerte testplattformer hjelper med å koordinere innsatsen på tvers av teamet og skaper én kilde til sannhet for testdataene dine. Når du skalerer, vurder å rotere testansvar slik at flere forstår testmetodikken og kan bidra, og reduserer avhengigheten av én person. Regelmessige teammøter der dere gjennomgår testresultater, diskuterer funn og justerer teststrategien basert på læring, sikrer at den skalerte testinnsatsen forblir samordnet og strategisk, i stedet for å bli en løs samling enkeltoppgaver.

De mest avanserte AI-synlighetsstrategier anerkjenner at manuell og automatisert tilnærming er komplementære, ikke konkurrerende, hvor hver utmerker seg i ulike sammenhenger og sammen gir fullstendig synlighetsdekning. Manuell testing er ditt undersøkende verktøy—her utforsker du, forstår nyanser, tester hypoteser og får dyp innsikt i hvordan AI-systemer fungerer og hvorfor synligheten din varierer på tvers av plattformer og scenarioer. Automatiserte overvåkingsverktøy som AmICited utmerker seg på konsistent, storskala overvåking over tid, og sporer synligheten din på tvers av flere AI-plattformer og varsler deg om endringer, trender og avvik som ville vært umulig å fange gjennom manuell testing alene. Den praktiske integrasjonsstrategien er å bruke manuell testing til å utvikle testopplegget, forstå hva som betyr mest, og undersøke avvik, mens automatisert overvåking brukes til kontinuerlig sporing av nøkkelparametere og varsling ved endringer. For eksempel kan du manuelt teste en ny promptkategori for å forstå AI-systemets respons, og når du har validert at det er en meningsfull test, legge den til i automatisert overvåking for kontinuerlig sporing uten løpende manuelt arbeid. AmICited og lignende overvåkingsverktøy håndterer det repeterende, tidkrevende arbeidet med å kjøre tester i skala og frekvens som ville vært upraktisk manuelt, slik at teamet ditt kan fokusere på analyse, strategi og optimalisering. Den ideelle arbeidsflyten er: bruk manuell testing til å bygge promptbiblioteket og teststrategien din, validere tilnærmingen og undersøke spesifikke spørsmål; bruk automatisert overvåking til å kontinuerlig spore nøkkelparametere for synlighet; og bruk innsiktene fra overvåkingen til å bestemme hva du skal teste manuelt neste gang. Denne integrerte tilnærmingen sikrer at du ikke bare tester manuelt i et vakuum, men bygger en helhetlig synlighetsstrategi som kombinerer dybden av manuell undersøkelse med skalaen og konsistensen til automatisert overvåking.

Et promptbibliotek er en kuratert, organisert samling av testprompter designet for å systematisk evaluere AI-systemer på flere dimensjoner. I motsetning til en enkel promptmal inneholder et bibliotek dusinvis av prompter organisert etter kategori (merkementioner, konkurrent-sammenlikninger, siteringer osv.), slik at du kan gjennomføre omfattende testing i stedet for isolerte kontroller. Promptbiblioteker er versjonert, dokumentert og laget for gjenbruk og skalering på tvers av teamet ditt.

Hyppigheten avhenger av ressursene dine og hvor dynamisk bransjen din er. De fleste organisasjoner har nytte av ukentlig eller annenhver ukes testing av kjerneprompter for å fange opp betydelige endringer, med månedlige dybdetester av hele promptbiblioteket. Hvis du er i en bransje med rask utvikling, eller nylig har publisert viktig innhold, øk hyppigheten til ukentlig. Kombiner manuell testing med automatiserte overvåkingsverktøy som AmICited for kontinuerlig sporing mellom manuelle testrunder.

Ja, du bør bruke de samme kjerneprompter på tvers av plattformer for å sikre konsistens og sammenlignbarhet. Du må imidlertid kanskje lage plattformspesifikke variasjoner fordi ulike AI-systemer (ChatGPT, Perplexity, Google AI Overviews) har ulike grensesnitt, siteringsmekanismer og svarformater. Test kjerneprompter identisk på tvers av plattformer, og lag deretter plattformspesifikke varianter for å ta hensyn til unike egenskaper eller begrensninger for hvert system.

Spor om innholdet ditt vises (ja/nei), hvor det vises i svaret (første nevning, støttende bevis osv.), siteringsnøyaktighet (om det siteres), og svar-kvalitet. Dokumenter også testdato, plattform, nøyaktig brukt prompt, og eventuelle kvalitative observasjoner om hvordan innholdet ditt ble presentert. Over tid avdekker disse måleparametrene mønstre i synligheten din, og hjelper deg å forstå hvilke optimaliseringstiltak som faktisk gir utslag.

Testingen din er omfattende når du dekker alle hoveddimensjoner av synligheten din: direkte merkessøk, konkurrent-sammenlikninger, bransjetemaer, siteringsnøyaktighet og kontekstforståelse. En god tommelfingerregel er 20–30 kjerneprompter som du tester jevnlig, pluss ekstra prompter for spesielle undersøkelser. Hvis du stadig oppdager nye innsikter fra manuell testing, trenger du sannsynligvis flere prompter. Hvis resultatene blir forutsigbare, er dekningen din trolig tilstrekkelig.

For små organisasjoner eller innledende testing kan du starte med interne ressurser ved å bruke DIY-tilnærmingen beskrevet i denne guiden. Når testingen vokser, blir dedikerte ressurser verdifulle. Vurder å ansette eller utpeke noen til å administrere promptbiblioteket ditt og gjennomføre jevnlig testing hvis du har flere produkter, opererer i et konkurranseutsatt marked, eller trenger hyppige testrunder. Alternativt kan du kombinere intern testing med automatiserte overvåkingsverktøy som AmICited for å fordele arbeidsbelastningen.

Manuell testing er undersøkende og fleksibel—du styrer hva du tester og kan utforske nyanser og grenseverdier. Automatiserte overvåkingsverktøy som AmICited kjører kontinuerlig, sporer synligheten din på tvers av flere AI-plattformer i stor skala, og varsler deg om endringer. Den ideelle tilnærmingen kombinerer begge: bruk manuell testing til å utvikle teststrategien og undersøke spesifikke spørsmål, mens automatisert overvåking gir kontinuerlig sporing av nøkkelparametre.

Du kan automatisere utførelsen av prompter ved hjelp av API-er (OpenAI, Anthropic, osv.) for å sende prompter til AI-systemer og hente svarene programmatisk. Analysen forblir imidlertid som oftest manuell, siden forståelse av kontekst og nyanser krever menneskelig vurdering. Du kan også automatisere dokumentasjon og resultatsporing med regneark eller databaser. Den mest praktiske tilnærmingen er å bruke automatiserte overvåkingsverktøy som AmICited for det repeterende arbeidet, og reservere manuell testing til dypere analyser og undersøkelser.

Selv om manuell testing er verdifull, sikrer automatisert overvåking kontinuerlig synlighet på tvers av alle AI-plattformer. AmICited sporer hvordan AI-systemer refererer til merkevaren din i sanntid.

Lær hva utvikling av promptbibliotek er og hvordan organisasjoner bygger spørsmålsamlinger for å teste og overvåke merkevaresynlighet på tvers av AI-plattformer...

Lær hvordan du lager og organiserer et effektivt promptbibliotek for å spore merkevaren din på tvers av ChatGPT, Perplexity og Google AI. Trinnvis guide med bes...

Lær hvordan du kan teste merkevarens synlighet i AI-motorer med prompttesting. Oppdag manuelle og automatiserte metoder for å overvåke AI-synlighet på tvers av ...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.