AI Crawler Referansekort: Alle Bots på et Blikk

Fullstendig referanseguide for AI-crawlere og roboter. Identifiser GPTBot, ClaudeBot, Google-Extended og 20+ andre AI-crawlere med brukeragenter, crawl-frekvens...

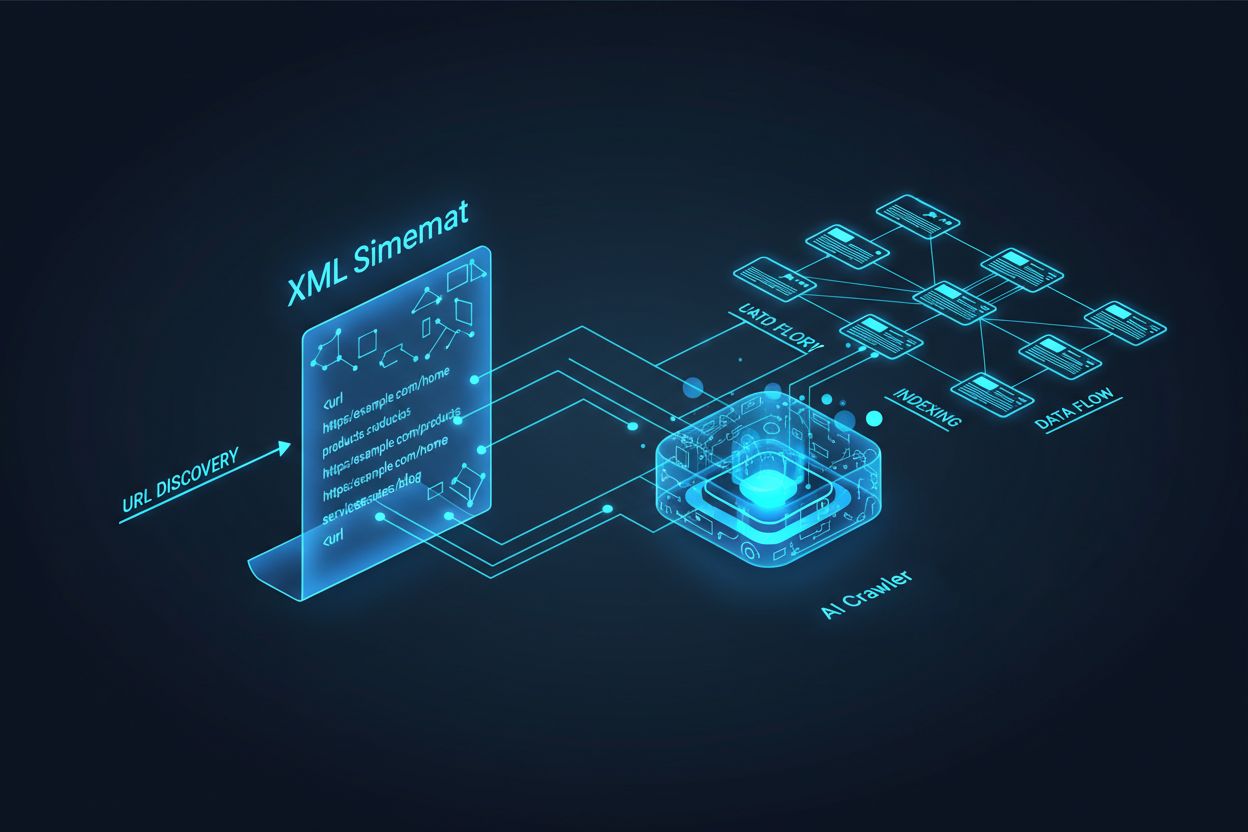

AI-crawlere som GPTBot, ClaudeBot og PerplexityBot opererer fundamentalt annerledes enn tradisjonelle søkemotorroboter. Mens Googlebot indekserer sider for rangering i søkeresultater, henter AI-crawlere kunnskap for å trene og informere store språkmodeller som driver konversasjonssøk og AI-genererte svar. Uten en riktig optimalisert XML-sitemap forblir innholdet ditt usynlig for disse kritiske systemene, uansett hvor godt skrevet eller autoritativt det måtte være. Tenk på sitemap-en din som et veikart som forteller AI-systemer nøyaktig hvor ditt mest verdifulle innhold finnes og hvordan det er organisert.

Distinksjonen mellom tradisjonelle søkecrawlere og AI-crawlere er avgjørende for å forstå hvorfor sitemap-optimalisering er viktigere enn noen gang. Tradisjonelle søkemotorer som Google fokuserer på å rangere individuelle sider for spesifikke søkeord, mens AI-crawlere prioriterer kunnskapsinnhenting og semantisk forståelse. Slik skiller de seg fra hverandre:

| Aspekt | Tradisjonelle crawlere (Googlebot) | AI-crawlere (GPTBot, ClaudeBot) |

|---|---|---|

| Hovedformål | Rangere sider i søkeresultater | Hente kunnskap til LLM-trening og sanntidssvar |

| Fokus | Metadata, interne lenker, rangeringssignaler | Innholdsstruktur, semantisk mening, faktatetthet |

| Crawl-prioritet | Basert på PageRank og aktualitet | Basert på autoritet, tematisk relevans og kunnskapsverdi |

| Sitatpåvirkning | Gir trafikk via blå lenker | Avgjør om innholdet ditt vises i AI-genererte svar |

| JavaScript-håndtering | Utfører og gjengir JavaScript | Hopper ofte over JavaScript; prioriterer server-renderet HTML |

Denne grunnleggende forskjellen betyr at det ikke lenger er tilstrekkelig å bare optimalisere for tradisjonell SEO. Sitemap-en din må nå ha dobbelt funksjon: hjelpe tradisjonelle søkemotorer å forstå nettstedets struktur, samtidig som den leder AI-systemer til dine mest verdifulle kunnskapsressurser.

En XML-sitemap fungerer som nettstedets blåkopi og forteller eksplisitt crawlere hvilke sider som finnes og hvordan de henger sammen med den overordnede innholdsstrategien. For AI-systemer har sitemaps en enda viktigere funksjon enn for tradisjonelt søk. AI-crawlere bruker sitemaps for å forstå nettstedets tematiske arkitektur, identifisere høyt prioriterte sider og avgjøre hvilke sider som fortjener dypere analyse. Når sitemap-en din er omfattende og godt organisert, kan AI-systemer mer effektivt oppdage og vurdere innholdet ditt for inkludering i generative svar. Omvendt skaper en ufullstendig eller utdatert sitemap blindsone der AI-systemene aldri møter dine viktigste sider. Effekten er direkte: sider som ikke er i sitemap-en din har betydelig mindre sannsynlighet for å bli sitert av AI-systemer, uansett kvalitet eller relevans.

Å lage en effektiv sitemap for AI-crawlere krever mer enn å bare liste opp hver URL på nettstedet ditt. Sitemap-en bør være strategisk kuratert og kun inkludere sider som gir reell verdi for brukere og AI-systemer. Her er de viktigste beste praksisene:

En godt strukturert sitemap fungerer som et kvalitetsfilter og forteller AI-systemer at du har kuratert innholdet ditt nøye, og at hver inkludert URL fortjener oppmerksomhet. Denne strategiske tilnærmingen øker sjansene dine betydelig for å bli valgt ut til sitat i AI-genererte svar.

Aktualitet er en av de sterkeste rangeringsfaktorene i AI-drevne søkesystemer. Når AI-crawlere vurderer hvilke kilder de skal sitere i genererte svar, vektlegger de innholdsfriskhet tungt. Lastmod-tidsstempelet i XML-sitemap-en din er det primære signalet som forteller AI-systemer når innholdet ditt sist ble oppdatert. Utdaterte eller manglende tidsstempler kan føre til at selv autoritativt innhold blir nedprioritert til fordel for ferskere kilder. Hvis sitemap-en din viser at en side ikke er oppdatert på flere år, kan AI-systemer anta at informasjonen er utdatert og heller velge konkurrenters innhold. Omvendt signaliserer nøyaktige lastmod-tidsstempler som reflekterer reelle innholdsoppdateringer til AI-crawlere at informasjonen er aktuell og pålitelig. For tidskritiske emner som priser, regelverk eller bransjetrender blir nøyaktige tidsstempler enda viktigere. Automatiserte tidsstempeloppdateringer via CMS-et ditt sikrer at hver innholdsforandring umiddelbart reflekteres i sitemap-en, og maksimerer synligheten din i AI-genererte svar.

Mens sitemaps inviterer crawlere til å indeksere innholdet ditt, styrer robots.txt-filer hvilke deler av nettstedet crawlere kan få tilgang til. Disse to filene må fungere sammen for å maksimere AI-synligheten din. En vanlig feil er å lage en omfattende sitemap samtidig som du blokkerer AI-crawlere i robots.txt-filen din, noe som skaper en motsetning som forvirrer crawlere og reduserer synligheten. Robots.txt-filen din bør eksplisitt tillate store AI-crawlere som GPTBot, ClaudeBot og PerplexityBot å få tilgang til innholdet ditt. Du kan bruke robots.txt strategisk for kun å blokkere sider som ikke skal indekseres, for eksempel admin-paneler, påloggingssider eller dupliserte innholdsversjoner. Nøkkelen er å sikre at robots.txt-reglene dine er i tråd med sitemap-strategien—hvis en side er i sitemap-en, bør den være tilgjengelig i henhold til robots.txt-reglene dine. Regelmessige revisjoner av begge filene hjelper deg å oppdage feilkonfigurasjoner som stille kan begrense AI-synligheten din.

De mest effektive AI-optimaliseringsstrategiene behandler sitemaps og strukturert data som komplementære systemer som forsterker hverandre. Når sitemap-en din fremhever en side som viktig, og den siden inneholder relevant schema-markering, sender du konsistente signaler til AI-crawlere om sidens hensikt og verdi. For eksempel, hvis sitemap-en din prioriterer en guide, bør den siden inkludere HowTo-schema som gir strukturert informasjon om trinnene. Tilsvarende bør produktsider i sitemap-en inkludere Product-schema med pris, tilgjengelighet og vurderingsinformasjon. Denne tilpasningen skaper et sammenhengende dataprospekt som AI-systemer lett kan tolke og stole på. Når sitemaps og strukturert data er i konflikt eller ikke samsvarer, blir AI-crawlere usikre på sidens egentlige hensikt, noe som reduserer sannsynligheten for sitat. Ved å sørge for at sitemap-strategien din er i samsvar med schema-implementeringen, skaper du et samlet signal som dramatisk øker sjansene dine for å bli valgt ut i AI-genererte svar.

Ulike innholdstyper krever ulike sitemap-strategier for å maksimere AI-synlighet. Blogginnlegg, produktsider, tjenestebeskrivelser og FAQ-innhold har ulike formål og bør optimaliseres deretter:

| Innholdstype | Sitemap-strategi | Anbefalt schema-markering | Prioriteringshensyn |

|---|---|---|---|

| Blogginnlegg & artikler | Inkluder med nøyaktige publiserings- og oppdateringsdatoer | Article, NewsArticle, BlogPosting | Prioriter nylig, tidløst innhold; oppdater lastmod jevnlig |

| Produktsider | Inkluder med lageroppdateringer; vurder eget produktsitemap | Product, Offer, AggregateRating | Fremhev bestselgere og nyheter; oppdater priser ofte |

| Tjenestesider | Inkluder med tjenesteoppdateringsdatoer | Service, LocalBusiness, ProfessionalService | Prioriter kjerneprodukter; oppdater tilgjengelighet og priser |

| FAQ-sider | Inkluder med oppdateringsdatoer for innhold | FAQPage, Question, Answer | Prioriter omfattende FAQ-er; oppdater svar når informasjon endres |

| Videoinnhold | Inkluder i video-sitemap med miniatyr og varighet | VideoObject, Video | Inkluder transkripsjoner; oppdater visningstall og engasjement |

| Bildeinnhold | Inkluder i bilde-sitemap med bildetekster | ImageObject, Product (for produktbilder) | Optimaliser alt-tekst; inkludér beskrivende bildetekster |

Denne differensierte tilnærmingen sikrer at hver innholdstype får optimalisering tilpasset AI-oppdagelse. Ved å tilpasse sitemap-strategien til innholdsmiksen din maksimerer du sjansen for at AI-systemer finner og siterer dine mest verdifulle ressurser.

llms.txt-standarden, foreslått sent i 2024, representerer en eksperimentell tilnærming for å hjelpe AI-systemer å forstå nettstedstruktur. I motsetning til XML-sitemaps er llms.txt en Markdown-basert fil som gir et menneskelesbart innholdsfortegnelse for nettstedet ditt. Den lister opp de viktigste sidene og ressursene dine i et format som er enklere for språkmodeller å tolke og forstå. Selv om konseptet er lovende, tyder nåværende bevis på at llms.txt har minimal innvirkning på AI-synlighet sammenlignet med tradisjonelle XML-sitemaps. Store AI-crawlere som GPTBot og ClaudeBot fortsetter å basere seg hovedsakelig på XML-sitemaps for URL-oppdagelse og aktualitetssignaler. I stedet for å erstatte XML-sitemap-en din, bør llms.txt ses på som et supplement som kan gi ekstra kontekst til AI-systemer. Hvis du implementerer llms.txt, sørg for at den utfyller og ikke erstatter kjerne-sitemap-strategien din, og fokuser først på å perfeksjonere XML-sitemap-en med nøyaktige tidsstempler og strategisk innholdskuratering.

Selv velmenende nettsteder begår ofte kritiske sitemap-feil som stille begrenser AI-synligheten deres. Å forstå og unngå disse feilene er avgjørende for å maksimere synligheten i AI-genererte svar:

Å rette opp disse vanlige feilene kan umiddelbart forbedre AI-synligheten din. Start med å revidere den nåværende sitemap-en din etter denne sjekklisten og utbedre eventuelle problemer du finner.

Å opprettholde en optimalisert sitemap krever løpende overvåking og validering. Flere verktøy kan hjelpe deg å sikre at sitemap-en forblir effektiv for AI-crawlere. Google Search Console har innebygd sitemap-validering og viser hvor mange URL-er Google har indeksert fra sitemap-en din. Screaming Frog SEO Spider lar deg crawle hele nettstedet og sammenligne resultatene med sitemap-en, slik at du finner manglende eller brutte URL-er. XML-sitemap-validatorer sjekker syntaksen og sikrer at sitemap-en overholder XML-sitemap-protokollen. For større virksomheter inkluderer dedikerte SEO-plattformer som Semrush og Ahrefs sitemap-analysefunksjoner som sporer endringer over tid. Regelmessige revisjoner—ideelt månedlig—hjelper deg å oppdage problemer før de påvirker AI-synligheten. Sett kalendervarsler for å gjennomgå sitemap-en hver gang du gjør vesentlige innholdsforandringer, lanserer nye seksjoner eller oppdaterer nettstedets arkitektur.

For å forstå hvordan AI-crawlere samhandler med sitemap-en din må du overvåke og analysere aktiviteten aktivt. Serverloggene dine inneholder verdifulle data om hvilke AI-crawlere som besøker nettstedet ditt, hvor ofte de crawler, og hvilke sider de prioriterer. Ved å analysere disse loggene kan du identifisere mønstre og optimalisere sitemap-en deretter. Verktøy som AmICited.com lar deg overvåke hvor ofte innholdet ditt blir sitert av AI-systemer som ChatGPT, Claude, Perplexity og Googles AI Overviews, og gir deg direkte tilbakemelding på sitemap-ens effektivitet. Google Analytics kan konfigureres til å spore henvisningstrafikk fra AI-systemer og vise hvilke sider som gir mest AI-drevet synlighet. Ved å korrelere disse dataene med sitemap-strukturen kan du identifisere hvilke innholdstyper og temaer som resonerer best med AI-systemer. Denne datadrevne tilnærmingen gjør det mulig å kontinuerlig forbedre sitemap-strategien din, og prioritere innholdet som gir flest AI-sitater og synlighet.

I tillegg til grunnleggende sitemap-optimalisering kan avanserte strategier forbedre AI-synligheten din betydelig. Å lage separate sitemaps for ulike innholdstyper—som dedikerte bloggsitemaps, produktsitemaps og videositemaps—gir deg mulighet til å bruke type-spesifikke optimaliseringsstrategier. Dynamisk sitemap-generering, hvor sitemap-en oppdateres i sanntid når innholdet endres, sikrer at AI-crawlere alltid ser det mest oppdaterte innholdet ditt. For store foretakssider med tusenvis av sider, hjelper implementering av sitemap-hierarkier og strategisk prioritering AI-crawlere å fokusere på ditt mest verdifulle innhold. Noen organisasjoner lager egne AI-sitemaps som kun fremhever sider med høyest autoritet og størst sitatpotensial, og signaliserer til AI-systemer hvilke sider som fortjener prioritet. Integrering av sitemap-strategien med innholdsstyringssystemet sikrer at optimaliseringen skjer automatisk og ikke krever manuelle oppdateringer. Disse avanserte tilnærmingene krever mer teknisk kompetanse, men kan gi betydelige forbedringer i AI-synlighet for organisasjoner med komplekse innholdsøkosystemer.

AI-crawlerlandskapet utvikler seg raskt, med nye crawlere som stadig dukker opp og standarder som llms.txt som vinner frem. Fremtidssikring av sitemap-strategien betyr å bygge fleksibilitet inn i systemene dine og holde deg oppdatert på bransjeutviklingen. Implementer systemer for sitemap-generering som enkelt kan tilpasses nye crawler-krav uten manuell konfigurasjon. Følg med på kunngjøringer fra store AI-selskaper om nye crawlere og oppdater robots.txt- og sitemap-strategiene dine deretter. Vurder den langsiktige verdien av AI-synlighet versus innholdskontroll—mens noen organisasjoner velger å blokkere AI-crawlere, tyder trenden på at AI-sitater vil bli stadig viktigere for merkevaresynlighet. Utarbeid klare retningslinjer for hvordan organisasjonen din skal håndtere AI-crawler-tilgang og innholdsbruk. Ved å behandle sitemap-en din som et levende dokument som utvikler seg med AI-landskapet, sikrer du at innholdet ditt forblir oppdagbart og siterbart etter hvert som søk- og oppdagelsesmekanismer fortsetter å forandre seg.

Du bør oppdatere sitemap-en din hver gang du publiserer nytt innhold eller gjør vesentlige endringer på eksisterende sider. Ideelt sett bør du implementere automatisert sitemap-generering slik at oppdateringer skjer umiddelbart. For nettsteder med hyppige innholdsoppdateringer anbefales daglige oppdateringer. For statiske nettsider holder det med månedlige gjennomganger.

De fleste store AI-crawlere som GPTBot og ClaudeBot respekterer robots.txt-direktiver, men ikke alle gjør det. Beste praksis er å eksplisitt tillate AI-crawlere i robots.txt-filen din i stedet for å stole på standardoppførsel. Overvåk serverloggene dine for å bekrefte at crawlere oppfører seg som forventet.

XML-sitemaps er maskinlesbare filer som lister opp alle URL-ene dine med metadata som lastmod-tidsstempler. llms.txt er en nyere Markdown-basert standard utviklet for å gi AI-systemer et menneskelesbart innholdsfortegnelse. XML-sitemaps er per i dag viktigst for AI-synlighet, mens llms.txt bør sees på som et supplement.

Sjekk serverloggene dine for brukeragenter som 'GPTBot', 'ClaudeBot', 'PerplexityBot' og 'Google-Extended'. Du kan også bruke verktøy som AmICited.com for å overvåke hvor ofte innholdet ditt blir sitert av AI-systemer, noe som indikerer vellykket crawling og indeksering.

Ja, ved å lage egne sitemaps for blogg, produkter, videoer og bilder kan du bruke type-spesifikke optimaliseringsstrategier. Dette hjelper også AI-crawlere å forstå innholdsstrukturen din bedre og kan forbedre crawl-effektiviteten på store nettsteder.

XML-sitemaps bør ikke inneholde mer enn 50 000 URL-er per fil. For større nettsteder, bruk sitemap-indekser for å organisere flere sitemap-filer. AI-crawlere kan håndtere store sitemaps, men å dele dem opp i logiske seksjoner forbedrer crawl-effektiviteten og gjør administrasjonen enklere.

Lastmod-tidsstempler signaliserer innholdsaktualitet til AI-crawlere. Aktualitet er en sterk rangeringsfaktor i AI-systemer, så nøyaktige tidsstempler hjelper innholdet ditt å konkurrere om sitater. Bruk alltid automatiserte systemer for å oppdatere tidsstempler kun når innholdet faktisk endres—aldri sett falske tidsstempler manuelt.

Ja, en dårlig vedlikeholdt sitemap kan skade AI-synligheten din betydelig. Brutte lenker, utdaterte URL-er, unøyaktige tidsstempler og mangelfull dekning reduserer sjansene dine for å bli sitert av AI-systemer. Regelmessige revisjoner og vedlikehold er avgjørende for å beskytte AI-synligheten din.

Følg med på hvor ofte innholdet ditt blir sitert av ChatGPT, Claude, Perplexity og Google AI Overviews. Optimaliser din sitemap-strategi basert på reelle AI-sitatdata.

Fullstendig referanseguide for AI-crawlere og roboter. Identifiser GPTBot, ClaudeBot, Google-Extended og 20+ andre AI-crawlere med brukeragenter, crawl-frekvens...

Lær hvordan du lar AI-boter som GPTBot, PerplexityBot og ClaudeBot crawle nettstedet ditt. Konfigurer robots.txt, sett opp llms.txt, og optimaliser for AI-synli...

Lær hvilke AI-crawlere du bør tillate eller blokkere i robots.txt-filen din. Omfattende guide som dekker GPTBot, ClaudeBot, PerplexityBot og 25+ AI-crawlere med...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.