Prerendering for AI-søkeboter: Gjør JavaScript-innhold tilgjengelig

Lær hvordan prerendering gjør JavaScript-innhold synlig for AI-søkeboter som ChatGPT, Claude og Perplexity. Oppdag de beste tekniske løsningene for AI-søkeoptim...

Oppdag hvordan SSR- og CSR-renderingsstrategier påvirker AI-crawler-synlighet, merkevaresiteringer i ChatGPT og Perplexity, og din totale AI-søkepresentasjon.

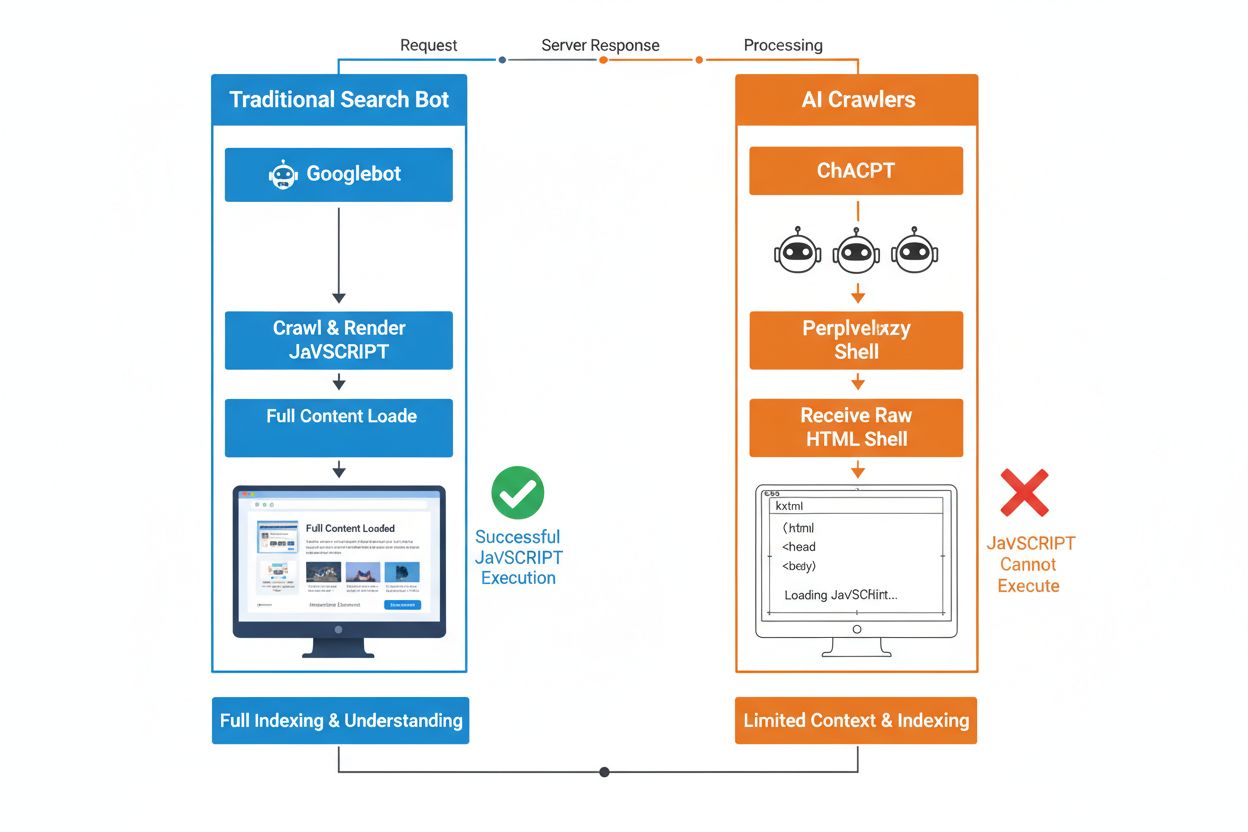

Den grunnleggende forskjellen mellom tradisjonelle søkemotorroboter og AI-crawlere ligger i hvordan de håndterer JavaScript. Mens Googlebot og andre tradisjonelle søkemotorer kan rendre JavaScript (dog med ressursbegrensninger), kjører ikke AI-crawlere som GPTBot, ChatGPT-User og OAI-SearchBot JavaScript i det hele tatt—de ser kun rå HTML levert ved første sidelast. Dette er avgjørende, for hvis nettstedets innhold avhenger av klientbasert JavaScript for å vises, vil AI-systemer motta et ufullstendig eller tomt bilde av sidene dine—uten produktdetaljer, prisinformasjon, anmeldelser og annet dynamisk innhold brukerne ser i nettleseren. Å forstå dette gapet er essensielt fordi AI-drevne søkeresultater raskt blir en primær kanal for informasjonsinnhenting.

Server-Side Rendering (SSR) forbedrer AI-synlighet fundamentalt ved å levere fullt rendret HTML direkte fra serveren ved første forespørsel, og eliminerer behovet for at AI-crawlere kjører JavaScript. Med SSR er alt kritisk innhold—overskrifter, brødtekst, produktinformasjon, metadata og strukturert data—tilstede i HTML-en botene mottar, og dermed umiddelbart tilgjengelig for AI-treningskorpuser og søkeindekser. Dette sikrer konsistent innholdsleveranse for alle crawlere, raskere indeksering og full synlighet av metadata som AI-systemer er avhengig av for å forstå og sitere innholdet ditt korrekt. Tabellen nedenfor viser hvordan ulike renderingsstrategier påvirker AI-crawlers synlighet:

| Renderingsmåte | Hva AI-crawlere ser | Indekseringshastighet | Innholdsfullstendighet | Metadata-synlighet |

|---|---|---|---|---|

| Server-Side Rendering (SSR) | Fullt rendret HTML med alt innhold | Rask (umiddelbar) | Fullstendig | Utmerket |

| Client-Side Rendering (CSR) | Minimal HTML-ramme, mangler dynamisk innhold | Treg (hvis i det hele tatt) | Ufullstendig | Dårlig |

| Static Site Generation (SSG) | Forhåndsbygget, cachet HTML | Svært rask | Fullstendig | Utmerket |

| Hybrid/Inkremetell | Blanding av statiske og dynamiske ruter | Moderat til rask | God (hvis kritiske sider forhåndsrendres) | God |

Client-Side Rendering (CSR) byr på store utfordringer for AI-synlighet fordi det tvinger crawlere til å vente på JavaScript-kjøring—noe AI-boter rett og slett ikke gjør på grunn av ressursbegrensninger og korte tidsfrister. Når et CSR-basert nettsted lastes, inneholder den første HTML-responsen bare en minimal ramme med lasteindikatorer og plassholdere, mens selve innholdet lastes inn asynkront via JavaScript. AI-crawlere har strenge tidsfrister på 1–5 sekunder og kjører ikke script, noe som betyr at de fanger et tomt eller nesten tomt bilde av siden, uten produktbeskrivelser, priser, anmeldelser og annen kritisk informasjon. Dette skaper en kjedereaksjon: ufullstendige innholdsbilder gir dårlig chunking- og embeddingkvalitet, noe som reduserer sannsynligheten for at sidene dine velges for AI-genererte svar. For nettbutikker, SaaS-plattformer og innholdstunge applikasjoner som er avhengige av CSR, betyr dette tapt synlighet i AI Overviews, ChatGPT-svar og Perplexity-resultater—de kanalene som driver synlighet i AI-æraen.

Den tekniske årsaken til at AI-boter ikke kan kjøre JavaScript, skyldes grunnleggende skalerbarhets- og ressursbegrensninger. AI-crawlere prioriterer hastighet og effektivitet over fullstendighet, og opererer under stramme tidsfrister fordi de må prosessere milliarder av sider for å trene og oppdatere språkmodeller. Å kjøre JavaScript krever oppstart av headless-browsere, allokering av minne og venting på asynkrone operasjoner—luksuser som ikke lar seg skalere til volumet som kreves for LLM-trening. Derfor fokuserer AI-systemer på å trekke ut ren, semantisk strukturert HTML som er umiddelbart tilgjengelig, og behandler statisk innhold som den kanoniske versjonen av nettstedet. Dette valget reflekterer en grunnleggende sannhet: AI-systemer er optimalisert for statisk HTML-leveranse, ikke for rendering av komplekse JavaScript-rammeverk som React, Vue eller Angular.

Innvirkningen på AI-genererte svar og merkevaresynlighet er betydelig og påvirker forretningsresultatene direkte. Når AI-crawlere ikke får tilgang til innholdet ditt på grunn av JavaScript-rendering, blir merkevaren din usynlig i AI Overviews, mangler i siteringer, og er fraværende i LLM-drevne søkeresultater—selv om du rangerer høyt i tradisjonelt Google-søk. For nettbutikker betyr dette at produktdetaljer, priser og tilgjengelighetsinformasjon aldri når AI-systemene, noe som resulterer i ufullstendige eller feilaktige produktanbefalinger og tapte salgsmuligheter. SaaS-selskaper mister synlighet for funksjonssammenligninger og prissider som ellers ville tiltrukket kvalifiserte leads gjennom AI-drevne forskningstjenester. Nyhets- og innholdssider får artiklene sine utelatt fra AI-sammendrag, noe som reduserer henvisningstrafikk fra plattformer som ChatGPT og Perplexity. Forskjellen mellom hva mennesker ser og hva AI-systemer ser, skaper et to-nivå-synlighetsproblem: nettstedet ditt kan fremstå bra i tradisjonelle SEO-målinger, men samtidig være usynlig for den raskest voksende kanalen for innhold.

Pre-rendering og hybride løsninger gir praktiske måter å kombinere fordelene fra begge renderingstilnærmingene uten å måtte gjøre en total arkitektonisk omlegging. I stedet for å velge mellom CSR sin interaktivitet og SSR sin crawlbarhet, benytter moderne team strategiske kombinasjoner for ulike formål:

Disse tilnærmingene lar deg beholde rike, interaktive brukeropplevelser samtidig som AI-crawlere mottar komplett, ferdig rendret HTML. Rammeverk som Next.js, Nuxt og SvelteKit gjør hybrid rendering tilgjengelig uten omfattende spesialutvikling. Nøkkelen er å identifisere hvilke sider som driver anskaffelse, inntekt eller support—de kritiske sidene bør alltid forhåndsrendres eller serverrendres for å garantere AI-synlighet.

Renderingsstrategi påvirker direkte hvordan AI-systemer refererer og siterer merkevaren din, derfor er det avgjørende å overvåke synligheten på tvers av AI-plattformer. Verktøy som AmICited.com sporer hvordan AI-systemer siterer merkevaren din i ChatGPT, Perplexity, Google AI Overviews og andre LLM-drevne plattformer, og viser om innholdet ditt faktisk når frem. Når nettstedet ditt bruker CSR uten pre-rendering, viser AmICited-data ofte et tydelig gap: du kan rangere godt i tradisjonelt søk, men motta null siteringer i AI-genererte svar. Denne overvåkingen viser den reelle kostnaden ved JavaScript-rendering—ikke bare for crawl-effektivitet, men også for tapt merkevaresynlighet og siteringsmuligheter. Ved å implementere SSR eller pre-rendering og så spore resultater via AmICited, kan du måle den direkte effekten renderingsbeslutningene har på AI-synlighet, noe som gjør det enklere å rettferdiggjøre tekniske investeringer for interessenter opptatt av trafikk og konverteringer.

Revisjon og optimalisering av renderingsstrategien for AI-synlighet krever en systematisk tilnærming. Start med å identifisere hvilke sider som gir størst verdi: produktsider, prissider, kjerne-dokumentasjon og blogginnlegg med mye trafikk bør prioriteres. Bruk verktøy som Screaming Frog (i “Tekstmodus”) eller Chrome DevTools for å sammenligne hva roboter ser med hva brukerne ser—hvis kritisk innhold mangler i kilden, er det JavaScript-avhengig og usynlig for AI-crawlere. Deretter velg renderingsstrategi basert på behov for innholdsoppdatering: statiske sider kan bruke SSG, ofte oppdatert innhold har fordeler av SSR eller ISR, og interaktive funksjoner kan legges på toppen av serverrendret HTML med JavaScript. Test med faktiske AI-boter ved å sende inn sidene dine til ChatGPT, Perplexity og Claude for å bekrefte at de får tilgang til innholdet. Til slutt overvåk crawl-logger for AI-user-agenter (GPTBot, ChatGPT-User, OAI-SearchBot) for å bekrefte at disse botene faktisk crawler de forhåndsrendrede eller serverrendrende sidene. Denne iterative tilnærmingen gjør rendering til et målbart synlighetsgrep, ikke bare en teknisk detalj.

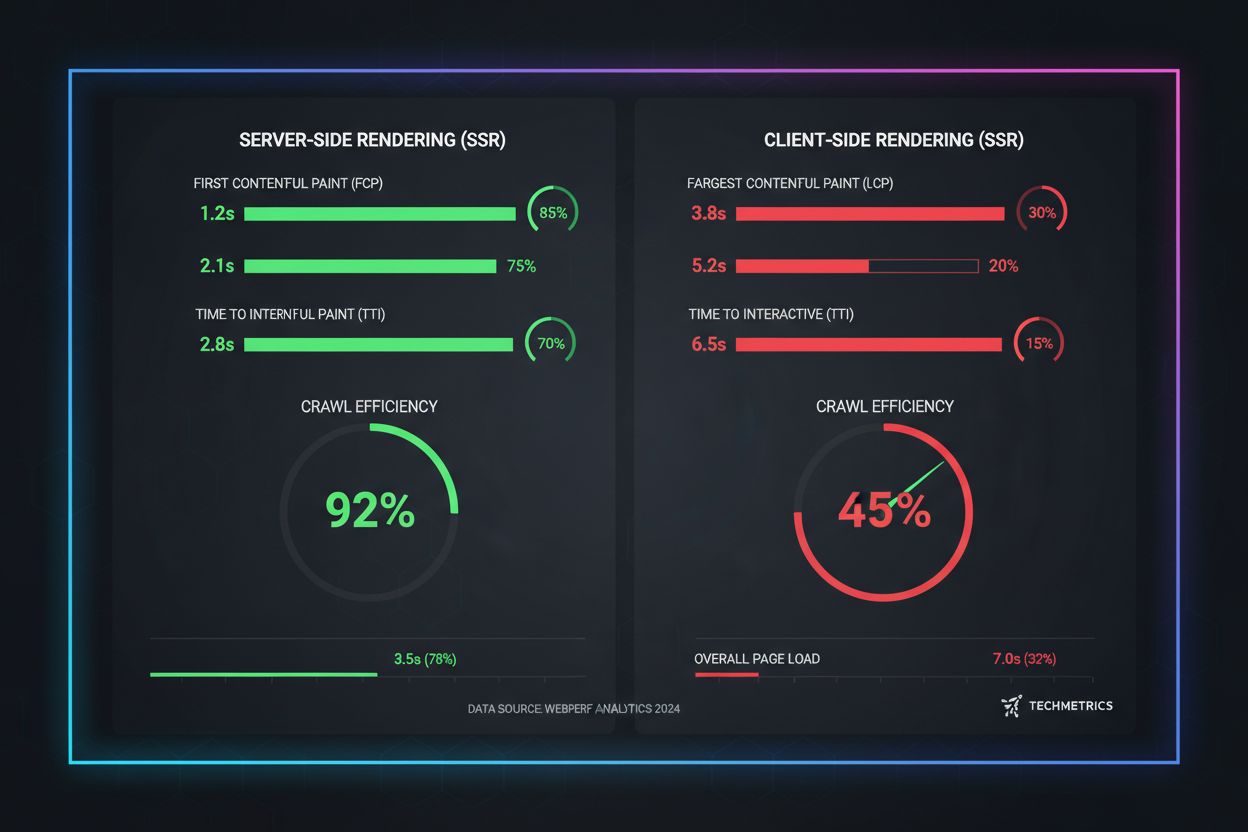

Ytelsesmålinger fra virkeligheten viser store forskjeller mellom renderingstilnærminger når det gjelder AI-crawlbarhet. SSR og forhåndsrendrede sider oppnår First Contentful Paint (FCP) på 0,5–1,5 sekunder, mens CSR-sider ofte trenger 2–4 sekunder eller mer mens JavaScript lastes og kjøres. For AI-crawlere med 1–5 sekunders tidsfrister er dette forskjellen på full synlighet og total usynlighet. Crawlingseffektiviteten øker dramatisk med SSR: en forhåndsrendret nettbutikk kan bli fullstendig crawlet og indeksert i løpet av timer, mens et CSR-basert nettsted kan bruke uker fordi crawlere sliter med JavaScript-overhead. Indekseringshastigheten forbedres også—SSR-sider får nytt innhold indeksert innen 24–48 timer, mens CSR-sider ofte opplever 7–14 dagers forsinkelser. For tidskritisk innhold som nyhetsartikler, produktlanseringer eller tidsbegrensede tilbud, betyr denne forsinkelsen tapt synlighet i det avgjørende vinduet når brukere faktisk søker.

Fremtiden for SEO er uløselig knyttet til AI-synlighet, og renderingsstrategien din er en kritisk, langsiktig investering, ikke bare en teknisk detalj. AI-drevet søk vokser eksponentielt—13,14 % av alle Google-søk utløser nå AI Overviews, og plattformer som ChatGPT får over fire milliarder besøk hver måned, med Perplexity og Claude i rask vekst. Etter hvert som AI-systemer blir primær kanal for flere brukere, vil rendering-valgene du tar i dag, avgjøre synligheten din i morgen. Kontinuerlig overvåking er avgjørende fordi AI-crawleradferd, tidsfrister og JavaScript-støtte endrer seg etter hvert som systemene utvikler seg. Team som behandler rendering som et engangsløft, oppdager ofte at de er usynlige igjen i løpet av måneder når AI-plattformene endrer crawlerstrategi. Bygg i stedet renderingsoptimalisering inn i kvartalsplanen, inkludér AI-synlighet i regresjonstester, og bruk verktøy som AmICited for å følge med på om merkevaren opprettholder synligheten etter hvert som AI-landskapet endres. Vinnerne i AI-søk er de som ser på renderingsstrategi som et kjernefortrinn—ikke en teknisk gjeld som kan skyves på.

AI-crawlere som GPTBot og ChatGPT-User opererer under strenge ressursbegrensninger og korte tidsfrister (1-5 sekunder) fordi de må prosessere milliarder av sider for å trene språkmodeller. Å kjøre JavaScript krever oppstart av headless-browsere og venting på asynkrone operasjoner—luksuser som ikke kan skalere til volumet som kreves for LLM-trening. I stedet fokuserer AI-systemer på å trekke ut ren, statisk HTML som er umiddelbart tilgjengelig.

Server-Side Rendering leverer fullt rendret HTML på første forespørsel, noe som gjør alt innhold umiddelbart tilgjengelig for AI-crawlere uten JavaScript-kjøring. Dette sikrer at produktdetaljer, priser, anmeldelser og metadata når AI-systemer pålitelig, og øker sjansen for at merkevaren din blir sitert i AI-genererte svar og vises i AI Overviews.

Server-Side Rendering (SSR) rendrer sider på forespørsel når en forespørsel kommer, mens pre-rendering genererer statiske HTML-filer under bygging. Pre-rendering fungerer best for innhold som ikke endres ofte, mens SSR er bedre for dynamisk innhold som oppdateres jevnlig. Begge tilnærminger sikrer at AI-crawlere mottar komplett HTML uten behov for JavaScript-kjøring.

Ja, men med betydelige begrensninger. Du kan bruke pre-rendering-verktøy for å generere statiske HTML-snapshots av CSR-sidene dine, eller implementere hybrid rendering der kritiske sider rendres på serveren mens mindre viktige sider forblir klientrendret. Uten disse optimaliseringene er CSR-nettsteder stort sett usynlige for AI-crawlere.

Bruk verktøy som Screaming Frog (tekstmodus), Chrome DevTools eller Google Search Console for å sammenligne hva roboter ser versus hva brukere ser. Hvis kritisk innhold mangler fra sidens kilde, er det JavaScript-avhengig og usynlig for AI-crawlere. Du kan også teste direkte med ChatGPT, Perplexity og Claude for å bekrefte at de kan få tilgang til innholdet ditt.

SSR og forhåndsrendrede sider oppnår vanligvis First Contentful Paint (FCP) på 0,5–1,5 sekunder, mens CSR-sider ofte krever 2–4+ sekunder. Siden AI-crawlere opererer under 1–5 sekunders tidsfrister, betyr raskere rendering direkte bedre AI-crawlbarhet. Forbedrede Core Web Vitals gir også bedre brukeropplevelse og tradisjonelle SEO-rangeringer.

AmICited overvåker hvordan AI-systemer siterer merkevaren din på tvers av ChatGPT, Perplexity og Google AI Overviews. Ved å spore AI-synligheten før og etter implementering av SSR eller pre-rendering, kan du måle den direkte effekten renderingsbeslutninger har på merkevaresiteringer og AI-søkepresentasjon.

Det avhenger av kravene til innholdsoppdatering og forretningsprioriteringer. Statisk innhold har fordeler av SSG, ofte oppdatert innhold av SSR, og interaktive funksjoner kan legges oppå serverrendret HTML med JavaScript. Start med å identifisere sider med høy verdi (produktsider, pris, dokumentasjon) og prioriter disse for SSR eller pre-rendering først.

Overvåk hvordan ChatGPT, Perplexity og Google AI Overviews refererer til din merkevare. Forstå den reelle effekten renderingsstrategien har på AI-siteringer.

Lær hvordan prerendering gjør JavaScript-innhold synlig for AI-søkeboter som ChatGPT, Claude og Perplexity. Oppdag de beste tekniske løsningene for AI-søkeoptim...

Lær hvordan du gjør innholdet ditt synlig for AI-crawlere som ChatGPT, Perplexity og Googles AI. Oppdag tekniske krav, beste praksis og overvåkningsstrategier f...

Lær hvordan JavaScript påvirker AI-crawleres synlighet. Oppdag hvorfor AI-boter ikke kan gjengi JavaScript, hvilket innhold som skjules, og hvordan du optimalis...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.