Data-drevet PR: Skap forskning som AI ønsker å sitere

Lær hvordan du lager original forskning og datadrevet PR-innhold som AI-systemer aktivt siterer. Oppdag de 5 egenskapene til innhold verdt å sitere og strategie...

Lær hvordan proprietære undersøkelsesdata og originale statistikker blir siteringsmagneter for LLM-er. Oppdag strategier for å forbedre AI-synlighet og få flere siteringer fra ChatGPT, Perplexity og Google AI Overviews.

Large Language Models finner ikke opp data – de henter det fra verifiserbare kilder. Når teamet ditt publiserer unike statistikker eller originale metoder, eier du midlertidig denne kunnskapen, noe som gir LLM-er en grunn til å sitere deg for å validere sine svar. Dette er grunnlaget for det IDX kaller “Autoritetshjulet”, et system der proprietær forskning blir din kraftigste siteringsmagnet.

Mekanismene er enkle: AI-modeller vurderer kilder basert på om de kan verifisere påstander gjennom flere kanaler. Når du publiserer original forskning, skaper du en kunnskapsressurs som ikke finnes andre steder på nettet. Denne unikheten tvinger LLM-er til å sitere din kilde hvis de vil inkludere disse dataene i svarene sine. En kampanje for The Zebra, en forsikringsplattform, demonstrerer dette prinsippet perfekt—kombinasjonen av proprietær forskning og Digital PR førte til over 1 580 høykvalitets medielenker og ga en økning på 354 % i organisk trafikk.

Ifølge fersk forskning identifiserte 48,6 % av SEO-ekspertene Digital PR som den mest effektive lenkebyggingstaktikken for 2025. Men den virkelige kraften ligger i det som skjer etterpå: Når dine proprietære data distribueres på tvers av ulike, høyt rangerte domener gjennom Digital PR, bekrefter det din autoritet i flere kunnskapsnettverk samtidig. Denne valideringen på flere kanaler er akkurat det LLM-er ser etter når de bestemmer seg for om de skal sitere din merkevare.

Den viktigste innsikten: Proprietære data skaper det forskere kaller “midlertidig kunnskapseierskap”. I motsetning til generisk innhold som konkurrerer med tusenvis av lignende artikler, er din originale forskning den eneste kilden for disse spesifikke dataene. Dette knapphetsprinsippet gjør det mer sannsynlig at LLM-er siterer deg, fordi å sitere deg er eneste vei til å inkludere denne informasjonen i sine svar.

Å forstå hvordan LLM-er faktisk henter og velger kilder er avgjørende for å optimalisere for siteringer. Disse systemene fungerer ikke som tradisjonelle søkemotorer. I stedet opererer de gjennom to distinkte kunnskapsbaner: parametrisk minne (kunnskap lagret under trening) og hentet kunnskap (sanntidsinformasjon hentet via Retrieval-Augmented Generation, eller RAG).

Parametrisk kunnskap representerer alt en LLM “vet” fra forhåndstreningen. Denne kunnskapen er statisk og fastlåst ved modellens treningskutt. Omtrent 60 % av ChatGPT-spørsmål besvares rent fra parametrisk kunnskap uten å utløse nettsøk. Entiteter som nevnes ofte i autoritative kilder under trening får sterkere nevrale representasjoner, og er mer sannsynlig å bli gjenkalt. Wikipedia-innhold utgjør ca. 22 % av treningsdataene til de største LLM-ene, noe som forklarer hvorfor Wikipedia-siteringer er så vanlige i AI-genererte svar.

Hentet kunnskap fungerer annerledes. Når en LLM trenger oppdatert informasjon, bruker den RAG-systemer som kombinerer semantisk søk (tette vektorer) med nøkkelordsmatching (BM25) ved bruk av Reciprocal Rank Fusion. Forskning viser at hybrid henting gir 48 % forbedring sammenlignet med enkeltmetoder. Systemet rangerer så resultatene på nytt med kryss-enkodermodeller før de øverste 5–10 bitene injiseres i LLM-ens prompt som kontekst.

| Signal | Prioritet tradisjonell SEO | Prioritet LLM-sitering | Hvorfor det er viktig |

|---|---|---|---|

| Domeneautoritet | Høy (kjernefaktor) | Svak/nøytral | LLM-er prioriterer innholdsstruktur fremfor domeneautoritet |

| Antall lenker | Høy (primærsignal) | Svak/nøytral | LLM-er vurderer kilde-troverdighet annerledes |

| Innholdsstruktur | Medium | Kritisk | Klare overskrifter og svarblokker er essensielle for uttrekk |

| Proprietære data | Lav | Svært høy | Unik informasjon tvinger frem sitering |

| Merkesøkevolum | Lav | Høyest (0,334 korrelasjon) | Indikerer reell autoritet og etterspørsel |

| Aktualitet | Medium | Høy | LLM-er foretrekker nylig oppdatert innhold |

| E-E-A-T-signaler | Medium | Høy | Forfatterkreditering og åpenhet betyr mye |

Den avgjørende forskjellen: LLM-er rangerer ikke sider – de trekker ut semantiske biter. En side med svake SEO-målinger men krystallklar struktur og proprietære data kan overgå en autoritativ side med vage beskrivelser. Dette grunnleggende skiftet gjør at din siteringsstrategi må prioritere maskinlesbarhet og innholdsklarhet fremfor tradisjonelle lenkebyggingsmålinger.

Målingene som betyr noe for AI-synlighet har fundamentalt endret seg fra tradisjonelle SEO-signaler. I to tiår var domenemyndighet, lenker og nøkkelordrangeringer suksesskriterier. I 2025 er disse faktorene nesten irrelevante for LLM-siteringer. I stedet har et nytt hierarki oppstått basert på hvordan AI-systemer faktisk vurderer og velger kilder.

Merkevaresøkevolum er nå den sterkeste prediktoren for LLM-siteringer, med en korrelasjonskoeffisient på 0,334 – betydelig høyere enn noen SEO-metrikk. Dette gir mening: Om millioner søker etter ditt merkenavn, signaliserer det reell autoritet og etterspørsel. LLM-er kjenner igjen dette signalet og gir det stor vekt når de bestemmer om de skal sitere deg. Samtidig viser lenker svak eller nøytral sammenheng med AI-siteringer, i strid med tiår med SEO-visdom.

Skiftet gjelder også innholdsevaluering. Å legge til statistikk i innholdet ditt øker AI-synligheten med 22 %. Å inkludere sitater gir 37 % økning. Original forskning blir sitert tre ganger oftere enn generisk innhold. Dette er ikke marginale forbedringer – de representerer et grunnleggende skifte i hvordan LLM-er vurderer kildekvalitet.

| Metrikk | Gammelt fokus (før 2024) | Nytt fokus (2025+) | Effekt på LLM-siteringer |

|---|---|---|---|

| Lenke-kvalitetsindikator | Domenemyndighet (DA/DR) | Faglig relevans & redaksjonell kontekst | Bakkeforankring og kildevariasjon |

| Ankertekststrategi | Eksakte nøkkelord | Merke-/entitetsomtale | Entitetsgjenkjenning og konsistens |

| Innholdstype | Gjesteposter (volum) | Original forskning/datajournalistikk | 3x høyere siteringssannsynlighet |

| Målemetode | Økt rangering | Siteringsrate i AI Overviews | Tillit og autoritetsvalidering |

| Outreach-strategi | Skaffe lenker | Bygge relasjoner/gi verdi | Høyere redaksjonell kvalitet |

Denne matrisen avslører en kritisk innsikt: Merkene som vinner AI-synlighet er ikke nødvendigvis de med flest lenker eller høyeste domenemyndighet. Det er de som skaper original forskning, opprettholder konsistente merkevaresignaler og publiserer innhold strukturert for maskinlesing. Fordelen har flyttet seg fra lenkemengde til innholdskvalitet og unikhet.

Proprietære undersøkelsesdata har en unik rolle i AI-synlighetsstrategi. I motsetning til generiske bransjerapporter som LLM-er kan finne mange steder, kan dine originale undersøkelsesdata kun siteres fra ditt nettsted. Dette gir en siteringsfordel konkurrentene ikke kan kopiere, uansett hvor sterke deres lenkeprofiler er.

Undersøkelsesdata fungerer fordi de gir det LLM-er kaller “bakkeforankring” – verifiserbare bevis som validerer påstander. Når du sier at “78 % av markedsføringsledere prioriterer AI-synlighet”, kan LLM-er sitere din undersøkelse som bevis. Uten disse proprietære dataene ville påstanden vært spekulativ, og LLM-er ville enten hoppet over den eller sitert en konkurrents forskning.

De mest effektive undersøkelsesdataene svarer på konkrete spørsmål målgruppen din stiller:

Effekten er målbar. Forskning viser at å legge til statistikk øker AI-synlighet med 22 %, mens sitater gir 37 % økning. Original forskning blir sitert tre ganger oftere enn generisk innhold. Disse multiplikatorene forsterkes når du kombinerer flere typer proprietære data i ett innholdsprodukt.

Nøkkelen er åpenhet. LLM-er vurderer metode like nøye som funn. Hvis undersøkelsesmetodikken er solid, utvalget godt og funnene presenteres ærlig (inkludert begrensninger), vil LLM-er sitere deg trygt. Hvis metodikken er vag eller funnene virker selekterte, nedprioriterer LLM-er kilden til fordel for mer åpne konkurrenter.

Å publisere proprietære data er bare halve jobben. Den andre halvdelen er å strukturere dataene slik at LLM-er lett kan trekke dem ut og sitere dem. Innholdsarkitektur er like viktig som selve dataene.

Start med direkte svar. LLM-er foretrekker innhold som begynner med svaret, ikke reisen. I stedet for “Vi gjennomførte en undersøkelse for å forstå markedsføringsprioriteringer, og her er funnene”, skriv “78 % av markedsføringsledere prioriterer nå AI-synlighet i sin 2025-strategi.” Denne direkte strukturen gjør uttrekk enklere og øker sannsynligheten for sitering.

Optimal avsnittslengde for LLM-uttrekk er 40–60 ord. Denne lengden gjør at LLM-er kan trekke ut en komplett tanke uten avkorting. Lengre avsnitt blir delt opp, noe som kan føre til tap av sammenheng. Kortere kan mangle tilstrekkelig informasjon.

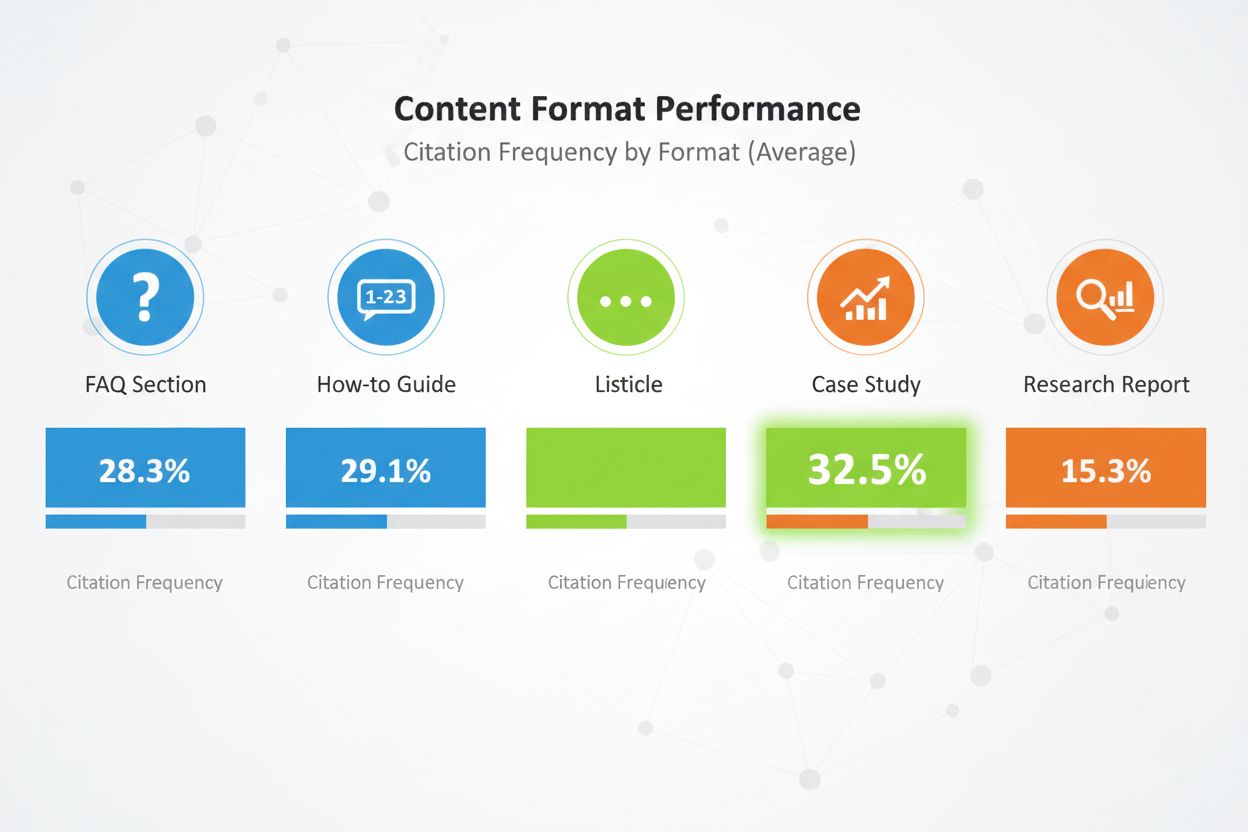

Innholdsformater er svært viktige. Sammenlignende lister får 32,5 % av alle AI-siteringer – høyest av alle formater. FAQ-seksjoner fungerer svært godt fordi de speiler hvordan brukere stiller spørsmål til AI-systemer. Hvordan-guides, casestudier og forskningsrapporter gjør det også bra, men lister er jevnt over best.

Strukturer innholdet med klar overskrifthierarki. Bruk H2-overskrifter som speiler sannsynlige søk. Under hver H2, bruk H3 for undertema. Dette gjør det lettere for LLM-er å forstå strukturen og trekke ut relevante deler.

Implementer E-E-A-T-signaler overalt. Ta med forfatterbios med kreditering og reell erfaring. Lenke til tredjeparts validering av dine påstander. Vær åpen om metode. Siter dine egne kilder. Disse signalene forteller LLM-er at innholdet er troverdig og verdt å sitere.

Bruk semantisk HTML overalt. Strukturer data med riktige <table>, <ul> og <ol>-tagger fremfor CSS-stylet divs. Dette gjør innholdet lettere for AI å tolke og oppsummere. Ta med schema markup (Article, FAQPage, HowTo) for å gi ekstra kontekst om innholdstypen.

Til slutt: Oppdater innholdet regelmessig. LLM-er foretrekker ferskt innhold, særlig på tidssensitive data. Hvis undersøkelsen din er fra 2024, oppdater den i 2025. Legg til “Sist oppdatert”-tidsstempel for å vise at du aktivt vedlikeholder innholdet. Dette signaliserer for LLM-er at dataene dine fortsatt er aktuelle og pålitelige.

Å publisere proprietære data på nettsiden din er nødvendig, men ikke tilstrekkelig. LLM-er oppdager innhold gjennom flere kanaler, og din distribusjonsstrategi avgjør hvor mange av disse kanalene som fanger opp dataene.

Digital PR er den mest effektive distribusjonskanalen for proprietære data. Når forskningen din vises i bransjepublikasjoner, nyhetsmedier og autoritative blogger, skaper det mange siteringsmuligheter. LLM-er indekserer disse tredjepartsomtaler og bruker dem til å validere din opprinnelige kilde. En merkevare som vises på 4+ plattformer er 2,8x mer sannsynlig å bli sitert i ChatGPT-svar enn merkevarer med begrenset tilstedeværelse.

Effektive distribusjonskanaler inkluderer:

Hver kanal har sin rolle. Pressemeldinger gir oppmerksomhet og mediedekning. Bransjepublikasjoner gir troverdighet og når beslutningstakere. LinkedIn når profesjonelle i stor skala. Reddit bygger fellesskapstillit. Anmeldelsesplattformer gir strukturert data LLM-er enkelt kan lese.

Multiplikatoreffekten er betydelig. Når dine proprietære data vises i flere autoritative kilder, ser LLM-er konsistente signaler på tvers av nettet. Denne konsistensen øker tilliten til dataene og gjør sitering mer sannsynlig. Ett enkelt nettsted kan bli oversett. De samme dataene på nettstedet ditt, i en pressemelding, i en bransjepublikasjon og på en anmeldelsesplattform blir umulig å ignorere.

Timing er viktig. Distribuer dine proprietære data strategisk. Slipp dem først på nettsiden din med en pressemelding. Følg opp med publikasjoner i bransjen. Forsterk deretter gjennom sosiale kanaler og fellesskapsengasjement. Denne trinnvise tilnærmingen skaper en bølge av synlighet heller enn en enkelt topp.

Å publisere proprietære data uten å måle effekten er som å annonsere uten å spore konverteringer. Du må ha innsikt i om dataene faktisk gir siteringer og forbedrer din AI-synlighet.

Start med å spore siteringsfrekvens. Identifiser 20–50 høyt verdsatte kjøperspørsmål som dine proprietære data svarer på. Søk på store AI-plattformer (ChatGPT, Perplexity, Claude, Google AI Overviews) månedlig med disse spørsmålene. Dokumenter om merkevaren din nevnes, på hvilken plassering, og om siteringen inneholder lenke til ditt nettsted.

Beregn siteringsfrekvensen som prosent: (Antall ganger du nevnes) / (Totalt antall spørsmål) × 100. Sikt mot 30 % siteringsfrekvens for dine viktigste kategorispørsmål. Toppmerker i konkurranseutsatte kategorier oppnår over 50 % siteringsfrekvens.

Spor AI Share of Voice (AI SOV) ved å kjøre identiske spørsmål og beregne din andel av totale merkenavn. Om merkevaren din nevnes i 3 av 10 AI-svar, mens konkurrenter nevnes i 2 hver, har du 30 % AI SOV. I konkurransekategorier, sikt mot AI SOV som overstiger din tradisjonelle markedsandel med 10–20 %.

Overvåk sentimentanalyse. I tillegg til å bli nevnt, spor om AI-systemene beskriver merkevaren din positivt, nøytralt eller negativt. Bruk verktøy som Profound AI som spesialiserer seg på hallusinasjonsdeteksjon – å oppdage når AI gir feil eller foreldet informasjon om merkevaren. Sikt mot 70 % eller høyere positivt sentiment på tvers av AI-plattformer.

Sett opp et Knowledge-Based Indicator (KBI)-dashbord som sporer:

Oppdater disse målingene månedlig. Se etter trender fremfor enkeltmålinger. En måned med få siteringer kan være tilfeldigheter. Tre måneder med fallende siteringsrate indikerer et problem som krever tiltak.

Å spore proprietære datasiteringer manuelt er tidkrevende og feilutsatt. AmICited.com gir infrastrukturen for å overvåke din AI-synlighet i stor skala, spesielt for merkevarer som bruker proprietære data som siteringsstrategi.

Plattformen overvåker hvordan AI-systemer siterer din proprietære forskning i ChatGPT, Perplexity, Google AI Overviews, Claude, Gemini og nye AI-plattformer. I stedet for å manuelt søke hver plattform månedlig, automatiserer AmICited prosessen, kjører dine utvalgte spørsmål kontinuerlig og sporer siteringsmønstre i sanntid.

Nøkkelfunksjoner inkluderer:

Plattformen integreres med din eksisterende analyseteknologi, og gir AI-siteringsdata inn i dine markedsføringsdashbord sammen med tradisjonelle SEO-målinger. Denne samlede oversikten hjelper deg å forstå den fulle effekten av din proprietære datastrategi på merkevaresynlighet og pipeline-generering.

For merkevarer som satser seriøst på AI-synlighet gir AmICited måleinfrastrukturen som gjør optimalisering mulig. Du kan ikke forbedre det du ikke måler, og tradisjonelle analyserverktøy var aldri laget for å spore LLM-siteringer. AmICited fyller dette gapet, og gir deg innsikten du trenger for å maksimere ROI på dine proprietære datainvesteringer.

Selv velmente strategier for proprietære data mislykkes ofte grunnet unngåelige feil. Å kjenne fellene hjelper deg å unngå dem.

Den vanligste feilen er å gjemme data bak “Kontakt salg”-skjemaer. LLM-er kan ikke få tilgang til innhold bak betalingsmur, så de bruker i stedet ufullstendig eller spekulativ informasjon fra forumer. Hvis undersøkelsesfunnene dine er skjult, vil LLM-er sitere en Reddit-diskusjon om produktet ditt i stedet for din offisielle forskning. Publiser nøkkelfunn offentlig med transparent metode. Du kan beskytte detaljerte rapporter, men hold sammendrag og innsikt åpent tilgjengelig.

Ukonsekvent terminologi på tvers av plattformer skaper forvirring. Hvis nettsiden din kaller produktet “markedsføringsautomatiseringsplattform” mens LinkedIn omtaler det som “CRM-programvare”, får LLM-er problemer med å bygge en helhetlig forståelse. Bruk konsistent kategorispråk overalt. Definer ditt terminologikart, og bruk det på nettsiden, LinkedIn, Crunchbase og andre plattformer.

Manglende forfatterkreditering svekker tilliten. LLM-er vurderer E-E-A-T-signaler nøye. Mangler undersøkelsen forfatterbios med reelle kvalifikasjoner, nedprioriterer LLM-er den. Ta med detaljerte forfatterbios med relevant erfaring, sertifiseringer og tidligere publikasjoner. Lenke til forfatterprofiler på LinkedIn og andre steder.

Utdaterte statistikker skader troverdigheten. Hvis undersøkelsen din er fra 2023, men du fortsatt siterer den i 2025, legger LLM-er merke til det. Oppdater forskningen regelmessig. Legg til “Sist oppdatert”-tidsstempel. Gjennomfør nye undersøkelser årlig for å holde innholdet aktuelt. LLM-er foretrekker ferske data, spesielt for tidsavhengige temaer.

Vag metodikk reduserer siteringssannsynlighet. Hvis undersøkelsesmetoden ikke er transparent, stiller LLM-er spørsmål ved funnene. Publiser metode åpent. Forklar utvalgsstørrelse, utvalgsmåte, periode og begrensninger. Åpenhet bygger tillit.

Nøkkelordfylling i innholdet gir dårligere resultater i AI-systemer enn i tradisjonell søk. LLM-er oppdager og straffer kunstig språk. Skriv naturlig. Fokuser på klarhet og presisjon heller enn nøkkelordstetthet. Dine proprietære data bør fremstå som ekte forskning, ikke markedsføringstekst.

Tynt innhold rundt dine proprietære data blir aktivt straffet. Ett avsnitt som nevner undersøkelsesfunn er ikke nok. Lag omfattende innhold som utforsker implikasjoner, gir kontekst og svarer på oppfølgingsspørsmål. Sikt mot minst 2 000 ord substansielt innhold rundt hver større datakilde.

Virkelige eksempler viser kraften i proprietære data for AI-synlighet. Disse merkevarene investerte i original forskning og så målbare resultater.

The Zebra sin Digital PR-suksess: The Zebra, en forsikringssammenligningstjeneste, kombinerte proprietær forskning med Digital PR for å generere over 1 580 høykvalitets medielenker og øke organisk trafikk med 354 %. Ved å publisere original forskning om forsikringsbransjen og spre den gjennom fortjent media, ble The Zebra den foretrukne kilden til forsikringsdata. LLM-er siterer nå The Zebras forskning når de svarer på spørsmål om forsikringstrender og priser.

Tallys strategi for fellesskapsengasjement: Tally, en online skjemabygger, forbedret sin AI-synlighet ved å aktivt engasjere seg i fellesskapsfora og dele produktplaner. I stedet for kun å publisere forskning, ble Tally en betrodd stemme i fellesskap der brukerne holder til. Dette autentiske engasjementet gjorde ChatGPT til en av de viktigste henvisningskildene, med betydelig økning i ukentlige påmeldinger. Ved å gi GPT-4 kuraterte, kontekstsensitive bevis, økte Tally faktisk nøyaktighet fra 56 % til 89 %.

HubSpots kontinuerlige forskningsprogram: HubSpot publiserer jevnlig forskningsrapporter om markedsføringstrender, salgsresultater og kundeservice. Disse rapportene har blitt bransjestandarder som LLM-er ofte siterer. HubSpots satsing på kontinuerlig forskning har gjort merkevaren synonymt med markedsføringsdata og innsikt. Når LLM-er svarer på spørsmål om markedsføringstrender, dukker HubSpots forskning opp jevnlig.

Disse casene har felles: original forskning, åpen metode, konsistent distribusjon og løpende oppdateringer. Ingen av merkevarene satset på ett enkelt forskningsprosjekt. I stedet bygget de programmer som kontinuerlig genererer nye proprietære data, og sikrer varig siteringsfordel.

Lærdommen er klar: Proprietære data er ingen engangstaktikk. Det er en strategisk investering i å bli den autoritative kilden i din kategori. Merker som satser på jevnlig forskning, åpen metode og strategisk distribusjon får jevnlig siteringer fra LLM-er og bygger varige konkurransefortrinn i AI-synlighet.

Du trenger ikke enorme datasett. Selv en fokusert undersøkelse med 100-500 respondenter kan gi verdifulle proprietære innsikter som LLM-er vil sitere. Nøkkelen er at dataene er originale, metodikken er transparent, og funnene er handlingsorienterte. Kvalitet og unikhet er viktigere enn kvantitet.

Kundetilfredshetsundersøkelser, bransjetrender, konkurranseanalyser, brukeradferdsstudier og markedsstørrelsesundersøkelser fungerer godt. De beste dataene svarer på konkrete spørsmål målgruppen din stiller, og gir innsikt konkurrentene ikke har.

Sanntidsplattformer som Perplexity kan sitere ferske data innen noen uker. ChatGPT og andre modeller med sjeldnere oppdateringer kan ta 2-3 måneder. Konsistente, høyverdige proprietære data gir vanligvis målbare økninger i siteringer innen 3-6 måneder.

Nei. LLM-er kan ikke få tilgang til innhold bak betalingsmur, så de vil i stedet bruke ufullstendig eller spekulativ informasjon fra forum. Publiser hovedfunnene offentlig med transparent metodikk. Du kan beskytte detaljerte rapporter, men hold sammendrag og innsikt offentlig tilgjengelig.

Bruk klar og konsekvent terminologi på alle plattformer. Inkluder transparent metodikk i forskningen din. Legg til forfatterkrediteringer og sertifiseringer. Lenke til tredjeparts validering. Bruk schema markup for å strukturere dataene dine. Overvåk siteringer månedlig og rett feil raskt.

Ja. Original forskning gir vanligvis tilbakekoblinger og medieomtale, som forbedrer tradisjonelle rangeringer. I tillegg skaper proprietære data innhold som er mer omfattende og autoritativt, noe som hjelper både med tradisjonell SEO og AI-synlighet.

Proprietære data er original forskning du selv utfører. Generiske rapporter er allment tilgjengelige. LLM-er foretrekker proprietære data fordi de er unike og kun kan siteres fra din kilde. Dette gir en siteringsfordel konkurrentene ikke enkelt kan kopiere.

Spor siteringsfrekvens, AI Share of Voice, søkevolum på merkevaren og trafikk fra AI-plattformer. Sammenlign disse målingene før og etter publisering av proprietære data. Beregn verdien av AI-henvist trafikk (vanligvis 4,4x høyere konverteringsrate enn tradisjonell organisk) for å bestemme ROI.

Overvåk hvordan AI-systemer siterer dine proprietære data på tvers av ChatGPT, Perplexity, Google AI Overviews og flere. Få innsikt i sanntid om din AI-synlighet og konkurranseposisjonering.

Lær hvordan du lager original forskning og datadrevet PR-innhold som AI-systemer aktivt siterer. Oppdag de 5 egenskapene til innhold verdt å sitere og strategie...

Diskusjon i fellesskapet om hvorvidt sitering av myndighetskilder forbedrer AI-synlighet. Ekte erfaringer fra innholdsskapere som tester autoritative siteringer...

Lær hvordan ekspertuttalelser øker merkevarens synlighet i AI-søkemotorer som ChatGPT og Perplexity. Oppdag strategier for å oppnå siteringer og bygge autoritet...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.