Søkeintensjon

Søkeintensjon er hensikten bak en brukers søk. Lær de fire typene søkeintensjon, hvordan du identifiserer dem, og optimaliserer innholdet for bedre rangeringer ...

Lær hvordan store språkmodeller tolker brukerintensjon utover nøkkelord. Oppdag forespørselsutvidelse, semantisk forståelse og hvordan AI-systemer avgjør hvilket innhold som skal siteres i svar.

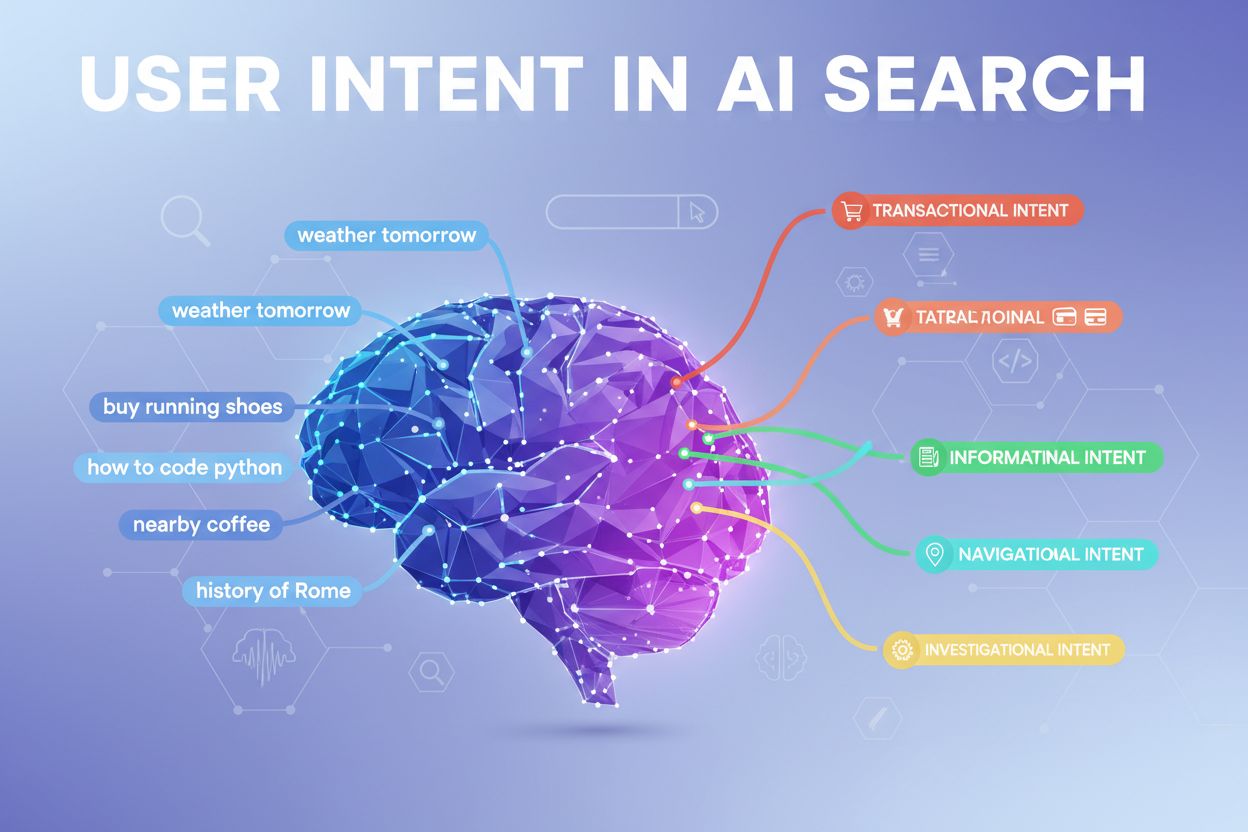

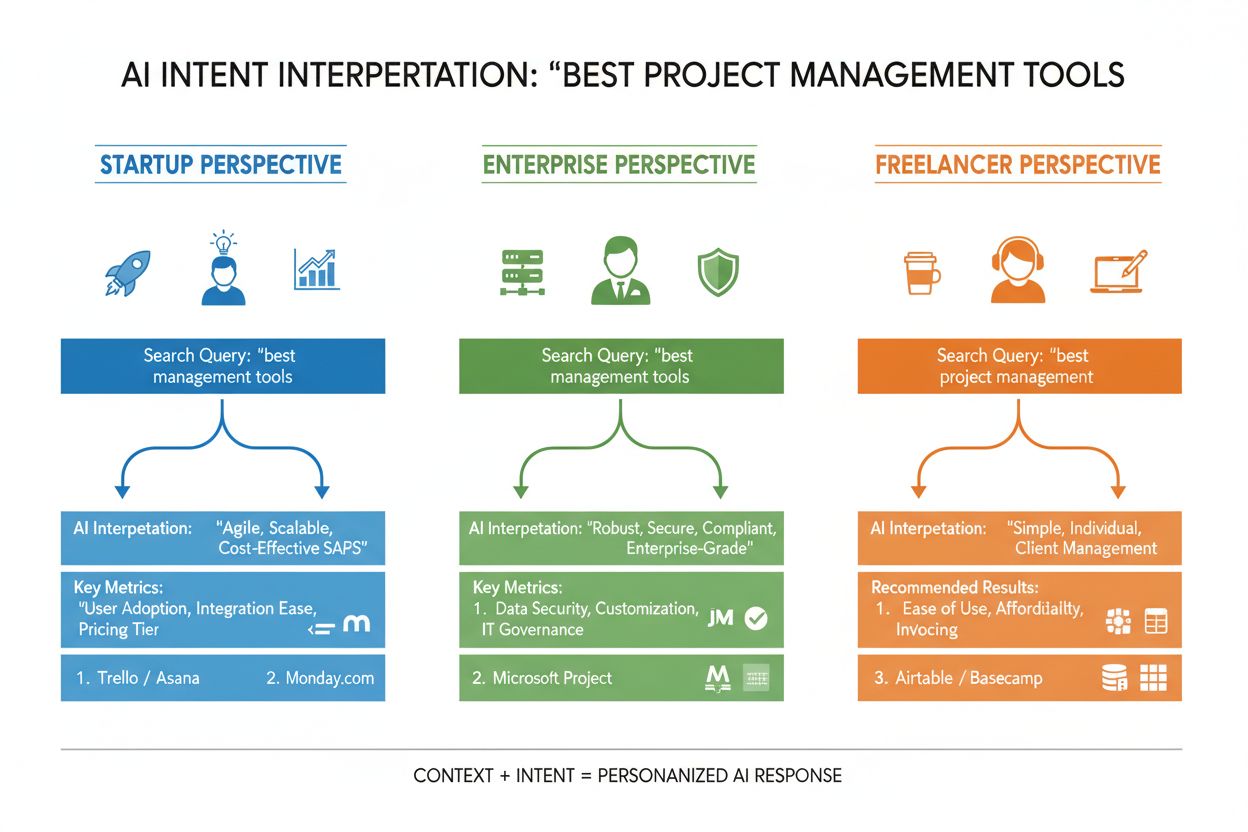

Brukerintensjon i AI-søk refererer til det underliggende målet eller hensikten bak en forespørsel, ikke bare nøkkelordene noen skriver inn. Når du søker etter “beste prosjektstyringsverktøy”, kan du være ute etter en rask sammenligning, prisinformasjon eller integrasjonsmuligheter—og store språkmodeller (LLM-er) som ChatGPT, Perplexity og Googles Gemini prøver å forstå hvilket av disse målene du faktisk forfølger. I motsetning til tradisjonelle søkemotorer som matcher nøkkelord med sider, tolker LLM-er den semantiske meningen i forespørselen din ved å analysere kontekst, formulering og relaterte signaler for å forutsi hva du egentlig ønsker å oppnå. Dette skiftet fra nøkkelordmatching til intensjonsforståelse er grunnleggende for hvordan moderne AI-søkesystemer fungerer, og det avgjør direkte hvilke kilder som blir sitert i AI-genererte svar. Å forstå brukerintensjon har blitt kritisk for merkevarer som ønsker synlighet i AI-søkeresultater, ettersom verktøy som AmICited nå overvåker hvordan AI-systemer refererer til innholdet ditt basert på intensjonssamsvar.

Når du skriver inn én enkelt forespørsel i et AI-søkesystem, skjer det noe bemerkelsesverdig i bakgrunnen: modellen svarer ikke bare direkte på spørsmålet ditt. I stedet utvider den forespørselen til dusinvis av relaterte mikrospørsmål, en prosess forskere kaller “query fan-out”. For eksempel kan et enkelt søk som “Notion vs Trello” utløse underforespørsler som “Hvilket er best for teamarbeid?”, “Hva er prisforskjellene?”, “Hvilket integreres best med Slack?” og “Hva er enklest for nybegynnere?” Denne utvidelsen lar LLM-er utforske ulike sider av intensjonen din og samle mer helhetlig informasjon før det genereres et svar. Systemet evaluerer så avsnitt fra ulike kilder på et detaljert nivå, i stedet for å rangere hele sider—det betyr at ett enkelt avsnitt fra innholdet ditt kan bli valgt, mens resten av siden ignoreres. Denne avsnitt-baserte analysen gjør at klarhet og spesifisitet i hver seksjon er viktigere enn noen gang—et godt strukturert svar på en spesifikk underintensjon kan være grunnen til at innholdet ditt blir trukket inn i et AI-generert svar.

| Original forespørsel | Underintensjon 1 | Underintensjon 2 | Underintensjon 3 | Underintensjon 4 |

|---|---|---|---|---|

| “Beste prosjektstyringsverktøy” | “Hvilket er best for fjernteam?” | “Hva er prisen?” | “Hvilket integreres med Slack?” | “Hva er enklest for nybegynnere?” |

| “Hvordan forbedre produktivitet” | “Hvilke verktøy hjelper med tidsstyring?” | “Hva er dokumenterte produktivitetsmetoder?” | “Hvordan redusere distraksjoner?” | “Hvilke vaner øker fokus?” |

| “AI-søkemotorer forklart” | “Hvordan skiller de seg fra Google?” | “Hvilket AI-søk er mest nøyaktig?” | “Hvordan håndterer de personvern?” | “Hva er fremtiden for AI-søk?” |

LLM-er vurderer ikke forespørselen din isolert—de bygger det forskere kaller en “brukerembedding”, en vektorbasert profil som fanger opp din utviklende intensjon basert på søkehistorikk, lokasjon, enhetstype, tidspunkt på døgnet og til og med tidligere samtaler. Denne kontekstuelle forståelsen gjør det mulig for systemet å tilpasse resultatene dramatisk: to brukere som søker etter “beste CRM-verktøy” kan få helt ulike anbefalinger hvis den ene er gründer og den andre er en bedriftsleder. Re-rangering i sanntid forbedrer resultatene ytterligere basert på hvordan du interagerer med dem—hvis du klikker på bestemte resultater, bruker tid på å lese spesifikke seksjoner eller stiller oppfølgingsspørsmål, justerer systemet forståelsen av intensjonen din og oppdaterer fremtidige anbefalinger deretter. Denne atferdsbaserte tilbakemeldingssløyfen gjør at AI-systemer stadig lærer hva brukerne faktisk vil ha, ikke bare hva de først skrev inn. For innholdsprodusenter og markedsførere understreker dette viktigheten av å lage innhold som tilfredsstiller intensjon på tvers av ulike brukerkontekster og beslutningsfaser.

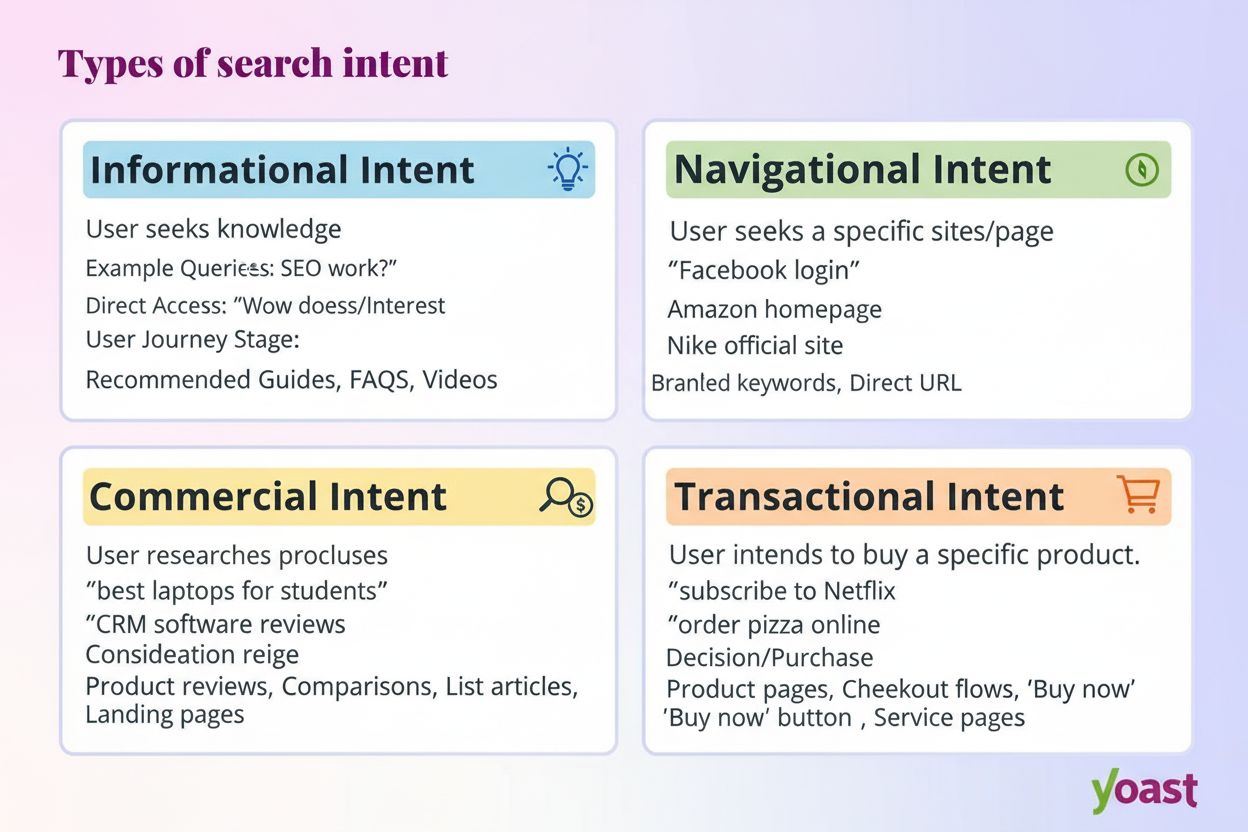

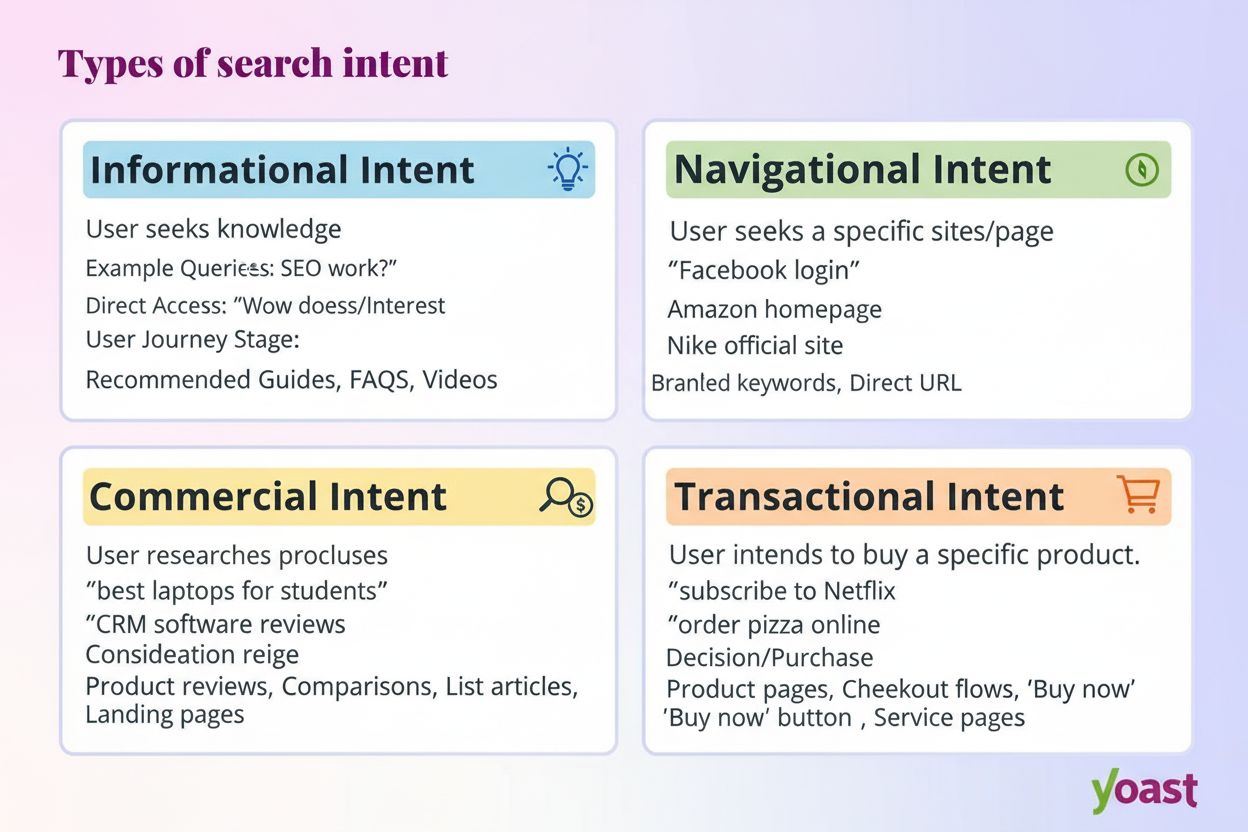

Moderne AI-systemer klassifiserer brukerintensjon i flere distinkte kategorier, som hver krever ulike typer innhold og svar:

LLM-er klassifiserer disse intensjonene automatisk ved å analysere forespørselsstruktur, nøkkelord og kontekstuelle signaler, og velger deretter innhold som best samsvarer med den oppdagede intensjonstypen. Å forstå disse kategoriene hjelper innholdsprodusenter å strukturere sidene sine for å møte den spesifikke intensjonen brukerne har med søkene sine.

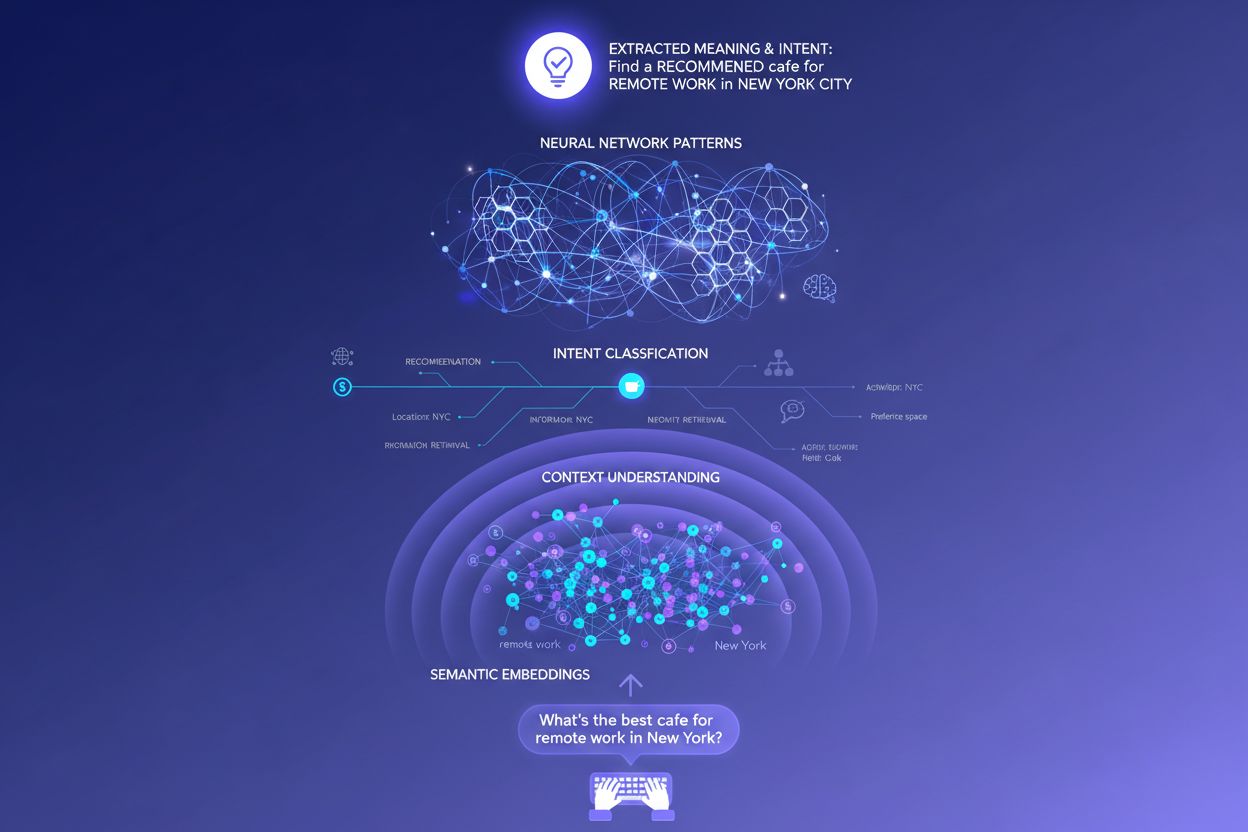

Tradisjonelle søkemotorer basert på nøkkelord opererer med enkel strengmatching—hvis siden din inneholder akkurat de ordene noen søker etter, kan den rangere. Denne tilnærmingen feiler spektakulært med synonymer, omformuleringer og kontekst. Hvis noen søker etter “rimelig prosjektstyringsprogramvare” og siden din bruker uttrykket “budsjettvennlig plattform for oppgavekoordinering”, kan tradisjonelt søk overse sammenhengen fullstendig. Semantiske embeddinger løser dette problemet ved å konvertere ord og uttrykk til matematiske vektorer som fanger betydning, ikke bare overflatetekst. Disse vektorene eksisterer i et høydimensjonalt rom der semantisk like konsepter grupperes, slik at LLM-er kan gjenkjenne at “rimelig”, “budsjettvennlig”, “billig” og “lavpris” alle uttrykker samme intensjon. Denne semantiske tilnærmingen håndterer også langhale- og samtalebaserte forespørsler langt bedre enn nøkkelordmatching—en forespørsel som “Jeg er frilanser og trenger noe enkelt men kraftig” kan matches med relevant innhold selv om det ikke inneholder tradisjonelle nøkkelord. Det praktiske resultatet er at AI-systemer kan finne relevante svar på vage, komplekse eller uvanlige forespørsler, noe som gjør dem langt mer nyttige enn sine forgjengere basert på nøkkelord.

I det tekniske hjertet av intensjonstolkning ligger transformer-arkitekturen, et nevralt nettverksdesign som prosesserer språk ved å analysere forholdet mellom ord gjennom en mekanisme kalt “attention”. I stedet for å lese tekst sekvensielt som et menneske, vurderer transformere hvordan hvert ord relaterer seg til alle andre ord i en forespørsel, slik at de kan fange nyansert mening og kontekst. Semantiske embeddinger er de numeriske representasjonene som oppstår fra denne prosessen—hvert ord, uttrykk eller konsept blir konvertert til en vektor av tall som koder for dets betydning. Modeller som BERT (Bidirectional Encoder Representations from Transformers) og RankBrain bruker disse embeddingene til å forstå at “beste CRM for oppstartsbedrifter” og “topp kundebehandlingsplattform for nye selskaper” uttrykker lignende intensjon, selv om de bruker helt forskjellige ord. Attention-mekanismen er spesielt kraftig fordi den lar modellen fokusere på de mest relevante delene av en forespørsel—i “beste prosjektstyringsverktøy for fjernteam med begrenset budsjett” lærer systemet å vekte “fjernteam” og “begrenset budsjett” som kritiske intensjonssignaler. Denne tekniske sofistikasjonen er grunnen til at moderne AI-søk føles langt mer intelligent enn tradisjonelle nøkkelordbaserte systemer.

Å forstå hvordan LLM-er tolker intensjon endrer innholdsstrategien fundamentalt. I stedet for å skrive én omfattende guide som prøver å rangere for ett nøkkelord, bør vellykket innhold nå adressere flere underintensjoner i modulære seksjoner som kan stå alene. Hvis du skriver om prosjektstyringsverktøy, lag egne seksjoner som svarer på “Hvilket er best for fjernteam?”, “Hva er det rimeligste alternativet?” og “Hvilket integreres med Slack?"—hver seksjon blir et potensielt svar-kort som LLM-er kan trekke ut og sitere. Siteringsklar formatering er svært viktig: bruk fakta framfor vage utsagn, inkluder spesifikke tall og datoer, og strukturer informasjonen slik at det er lett for AI-systemer å sitere eller oppsummere. Punktlister, tydelige overskrifter og korte avsnitt hjelper LLM-er å tolke innholdet ditt mer effektivt enn tettpakket tekst. Verktøy som AmICited gir nå markedsførere mulighet til å overvåke hvordan AI-systemer refererer til innholdet deres på tvers av ChatGPT, Perplexity og Google AI, og viser hvilke intensjonssamsvar som fungerer og hvor det finnes innholdshull. Denne datadrevne tilnærmingen til innholdsstrategi—å optimalisere for hvordan AI-systemer faktisk tolker og siterer arbeidet ditt—representerer et grunnleggende skifte fra tradisjonell SEO.

Tenk på et e-handelseksempel: når noen søker etter “vanntett jakke under 2000 kroner”, uttrykker de flere intensjoner samtidig—de ønsker informasjon om holdbarhet, prisbekreftelse og produktanbefalinger. Et AI-system kan utvide dette til underforespørsler om vanntette teknologier, prissammenligninger, merkevareomtaler og garantiinformasjon. En merkevare som adresserer alle disse vinklene i modulært, godt strukturert innhold har langt større sannsynlighet for å bli sitert i AI-genererte svar enn en konkurrent med en generell produktside. I SaaS-verdenen kan samme forespørsel “Hvordan inviterer jeg teamet mitt til dette arbeidsområdet?” dukke opp hundrevis av ganger i supportsystemer, noe som signaliserer et kritisk innholdshull. En AI-assistent trent på dokumentasjonen din kan slite med å svare klart på dette spørsmålet, noe som gir dårlig brukeropplevelse og redusert synlighet i AI-genererte supportsvar. I nyhets- og informasjonskontekster vil en forespørsel som “Hva skjer med AI-regulering?” tolkes forskjellig ut fra brukerkonteksten—en politiker trenger lovgivningsdetaljer, en bedriftsleder trenger konkurranseimplikasjoner, og en teknolog vil ha tekniske standarder. Vellykket innhold adresserer disse ulike intensjonskontekstene eksplisitt.

Til tross for sin sofistikasjon, møter LLM-er reelle utfordringer i intensjonstolkning. Tvetydige forespørsler som “Java” kan referere til programmeringsspråket, øya eller kaffen—selv med kontekst kan systemet feiltolke intensjonen. Blandede eller lagdelte intensjoner gjør det enda mer komplisert: “Er denne CRM-en bedre enn Salesforce og hvor kan jeg prøve den gratis?” kombinerer sammenligning, evaluering og transaksjonsintensjon i én forespørsel. Kontekstvindubegrensninger gjør at LLM-er bare kan vurdere en begrenset mengde samtalehistorikk, så i lange samtaler kan tidligere intensjonssignaler glemmes. Hallusinasjoner og faktafeil er fortsatt en bekymring, spesielt i områder som krever høy presisjon som helse, finans eller juridisk rådgivning. Personvernshensyn er også viktig—etter hvert som systemene samler mer atferdsdata for å forbedre personalisering, må de balansere intensjonspresisjon mot brukernes personvern. Å forstå disse begrensningene hjelper innholdsprodusenter og markedsførere å sette realistiske forventninger til AI-synlighet i søk og erkjenne at ikke alle forespørsler tolkes perfekt.

Intensjonsbasert søk utvikler seg raskt mot mer sofistikert forståelse og interaksjon. Samtalebasert AI vil bli stadig mer naturlig, med systemer som beholder kontekst gjennom lengre, mer komplekse flersamtaler der intensjonen kan skifte og utvikle seg. Multimodal intensjonsforståelse vil kombinere tekst, bilder, lyd og til og med video for å tolke brukerens mål mer helhetlig—tenk deg å be en AI-assistent “finn noe lignende som dette” mens du viser et bilde. Søk uten forespørsel (“zero-query search”) er en ny grense der AI-systemer forutser brukerens behov før de eksplisitt er uttalt, ved å bruke atferdssignaler og kontekst til å proaktivt vise relevant informasjon. Forbedret personalisering vil gjøre resultatene stadig mer tilpasset individuelle brukerprofiler, beslutningsfaser og kontekstuelle situasjoner. Integrasjon med anbefalingssystemer vil viske ut grensen mellom søk og oppdagelse, med AI-systemer som foreslår relevant innhold brukeren ikke visste at de skulle søke etter. Etter hvert som disse mulighetene modnes, vil konkurransefortrinnet i økende grad tilhøre merkevarer og innholdsprodusenter som forstår intensjon dypt og strukturerer innholdet sitt for å møte den omfattende på tvers av ulike kontekster og brukertyper.

Brukerintensjon refererer til det underliggende målet eller hensikten bak en forespørsel, ikke bare nøkkelordene som er skrevet inn. LLM-er tolker semantisk mening ved å analysere kontekst, formulering og relaterte signaler for å forutsi hva brukeren faktisk ønsker å oppnå. Derfor kan samme forespørsel gi ulike resultater avhengig av brukerens kontekst og hvor i beslutningsprosessen de er.

LLM-er bruker en prosess kalt 'query fan-out' for å bryte ned én forespørsel til dusinvis av relaterte mikrospørsmål. For eksempel kan 'Notion vs Trello' utvides til underforespørsler om teamarbeid, priser, integrasjoner og brukervennlighet. Dette lar AI-systemer utforske ulike sider av intensjonen og samle helhetlig informasjon.

Å forstå intensjon hjelper innholdsprodusenter å optimalisere for hvordan AI-systemer faktisk tolker og siterer arbeidet deres. Innhold som adresserer flere underintensjoner i modulære seksjoner blir oftere valgt av LLM-er. Dette påvirker direkte synlighet i AI-genererte svar på tvers av ChatGPT, Perplexity og Google AI.

Semantiske embeddinger konverterer ord og uttrykk til matematiske vektorer som fanger betydning, ikke bare overflatetekst. Dette lar LLM-er gjenkjenne at 'rimelig', 'budsjettvennlig' og 'billig' uttrykker samme intensjon, selv om ordene er forskjellige. Denne semantiske tilnærmingen håndterer synonymer, omformuleringer og kontekst langt bedre enn tradisjonell nøkkelordmatching.

Ja, LLM-er møter utfordringer med tvetydige forespørsler, blandede intensjoner og kontekstbegrensninger. Forespørsler som 'Java' kan referere til programmeringsspråk, geografi eller kaffe. Lange samtaler kan overstige kontekstvinduet, noe som gjør at tidligere intensjonssignaler blir glemt. Å forstå disse begrensningene hjelper med å sette realistiske forventninger til AI-synlighet i søk.

Merkevarer bør lage modulært innhold som adresserer flere underintensjoner i egne seksjoner. Bruk siteringsklar formatering med fakta, spesifikke tall og tydelig struktur. Overvåk hvordan AI-systemer refererer til innholdet ditt med verktøy som AmICited for å identifisere hull i intensjonssamsvar og optimalisere deretter.

Intensjon er oppgavefokusert—hva brukeren vil oppnå akkurat nå. Interesse er bredere nysgjerrighet. AI-systemer prioriterer intensjon fordi det direkte avgjør hvilket innhold som velges til svar. En bruker kan være interessert i produktivitetsverktøy generelt, men intensjonen kan være å finne noe spesifikt for fjernarbeid.

AI-systemer siterer kilder som best matcher den oppdagede intensjonen. Dersom innholdet ditt tydelig adresserer en spesifikk underintensjon med velstrukturert, faktabasert informasjon, er det mer sannsynlig å bli valgt. Verktøy som AmICited sporer disse siteringsmønstrene og viser hvilke intensjonssamsvar som gir synlighet i AI-genererte svar.

Forstå hvordan LLM-er refererer til innholdet ditt på tvers av ChatGPT, Perplexity og Google AI. Spor intensjonssamsvar og optimaliser for AI-synlighet med AmICited.

Søkeintensjon er hensikten bak en brukers søk. Lær de fire typene søkeintensjon, hvordan du identifiserer dem, og optimaliserer innholdet for bedre rangeringer ...

Lær hvordan du identifiserer og optimaliserer for søkeintensjon i AI-søkemotorer. Oppdag metoder for å klassifisere brukerforespørsler, analysere AI SERP-er og ...

Lær hvordan du kan tilpasse innholdet ditt til AI-søkeintensjon for å øke siteringer i ChatGPT, Perplexity og Google AI. Bli ekspert på strategier for matching ...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.