AI-spesifikk Robots.txt

Lær hvordan du konfigurerer robots.txt for AI-crawlere som GPTBot, ClaudeBot og PerplexityBot. Forstå AI-crawlerkategorier, blokkeringsstrategier og beste praks...

Lær hvordan Web Application Firewall gir avansert kontroll over AI-roboter utover robots.txt. Implementer WAF-regler for å beskytte innholdet ditt mot uautorisert AI-skraping og overvåk AI-sitater med AmICited.

Utilstrekkeligheten til robots.txt som et selvstendig forsvarsmiddel har blitt stadig tydeligere i en tid hvor AI-drevet innholdsforbruk øker. Mens tradisjonelle søkemotorer vanligvis respekterer robots.txt-retningslinjer, opererer moderne AI-roboter med helt andre insentiver og håndhevingsmekanismer, noe som gjør enkle tekstbaserte retningslinjer utilstrekkelige for innholdsbeskyttelse. Ifølge Cloudflares analyse utgjør AI-roboter nå nesten 80 % av all bottrafikk til nettsteder, der treningsroboter konsumerer store mengder innhold uten å gi noe særlig henvisningstrafikk tilbake—OpenAIs roboter har et forhold på 400:1 mellom crawling og henvisninger, mens Anthropics når så høyt som 38 000:1. For utgivere og innholdseiere representerer dette asymmetriske forholdet en kritisk forretningstrussel, da AI-modeller trent på deres innhold kan direkte redusere organisk trafikk og svekke verdien av deres immaterielle rettigheter.

En Web Application Firewall (WAF) fungerer som en omvendt proxy plassert mellom brukere og webservere, og inspiserer hver HTTP-forespørsel i sanntid for å filtrere uønsket trafikk basert på konfigurerbare regler. I motsetning til robots.txt, som er avhengig av frivillig etterlevelse fra roboter, håndhever WAF-er beskyttelse på infrastrukturnivå og er derfor langt mer effektive for å kontrollere tilgang fra AI-roboter. Følgende sammenligning illustrerer hvordan WAF-er skiller seg fra tradisjonelle sikkerhetstilnærminger:

| Funksjon | Robots.txt | Tradisjonell brannmur | Moderne WAF |

|---|---|---|---|

| Håndhevingsnivå | Veiledende/Frivillig | IP-basert blokkering | Applikasjonsbevisst inspeksjon |

| AI-robotdeteksjon | Kun user-agent-samsvar | Begrenset botgjenkjenning | Atferdsanalyse + fingeravtrykk |

| Sanntids tilpasning | Statisk fil | Krever manuelle oppdateringer | Kontinuerlig trusselintelligens |

| Granulær kontroll | Kun på sti-nivå | Bredt IP-område | Forespørselsnivå-poliser |

| Maskinlæring | Ingen | Ingen | Avansert botklassifisering |

WAF-er gir granulær botklassifisering ved å bruke enhetsfingeravtrykk, atferdsanalyse og maskinlæring for å profilere roboter etter hensikt og raffinement, noe som muliggjør langt mer nyansert kontroll enn enkle tillat/avvis-regler.

AI-roboter faller inn i tre distinkte kategorier, som hver presenterer ulike trusler og krever ulike mottiltak. Treningsroboter som GPTBot, ClaudeBot og Google-Extended samler systematisk inn webinnhold for å bygge datasett til store språkmodeller, utgjør omtrent 80 % av all AI-robottrafikk, og gir ingen henvisningsverdi til utgivere. Søke- og siteringsroboter som OAI-SearchBot og PerplexityBot indekserer innhold for AI-drevne søkeopplevelser og kan gi noe henvisningstrafikk gjennom sitater, men i betydelig lavere volum enn tradisjonelle søkemotorer. Brukerutløste henteroboter aktiveres kun når brukere spesifikt ber om innhold gjennom AI-assistenter, og opererer med minimalt volum og enkeltforespørsler snarere enn systematisk crawling. Trusselbildet inkluderer:

Moderne WAF-er benytter avanserte tekniske deteksjonsmetoder som går langt utover enkel matching av user-agent-strenger for å identifisere og klassifisere AI-roboter med høy presisjon. Disse systemene bruker atferdsanalyse til å undersøke forespørselsmønstre, inkludert crawl-hastighet, rekkefølge på forespørsler og egenskaper ved responsbehandling som skiller roboter fra menneskelige brukere. Enhetsfingeravtrykk analyserer HTTP-overskrifter, TLS-signaturer og nettleseregenskaper for å fange opp forfalskede user-agenter som prøver å omgå tradisjonelle forsvar. Maskinlæringsmodeller trent på millioner av forespørsler kan oppdage nye robotsignaturer og bot-taktikker i sanntid, og tilpasser seg nye trusler uten behov for manuelle regeloppdateringer. I tillegg kan WAF-er verifisere roboters legitimitet ved å krysssjekke forespørsels-IP-adresser mot offisielle IP-områder vedlikeholdt av store AI-selskaper—OpenAI publiserer verifiserte IP-er på https://openai.com/gptbot.json, mens Amazon gir sine på https://developer.amazon.com/amazonbot/ip-addresses/—og sikrer at kun autentiserte roboter fra legitime kilder slipper gjennom.

Effektiv implementering av WAF-regler for AI-roboter krever en lagdelt tilnærming som kombinerer blokkering av user-agent, IP-verifisering og atferdspolicyer. Følgende kodeeksempel viser en grunnleggende WAF-regelkonfigurasjon som blokkerer kjente treningsroboter, men tillater legitime søkefunksjoner:

# WAF-regel: Blokker AI-treningsroboter

Regelnavn: Block-AI-Training-Crawlers

Betingelse 1: HTTP User-Agent matcher (GPTBot|ClaudeBot|anthropic-ai|Google-Extended|Meta-ExternalAgent|Amazonbot|CCBot|Bytespider)

Handling: Blokker (returner 403 Forbidden)

# WAF-regel: Tillat verifiserte søkeroboter

Regelnavn: Allow-Verified-Search-Crawlers

Betingelse 1: HTTP User-Agent matcher (OAI-SearchBot|PerplexityBot)

Betingelse 2: Kilde-IP i verifisert IP-område

Handling: Tillat

# WAF-regel: Begrens mistenkelig bottrafikk

Regelnavn: Rate-Limit-Suspicious-Bots

Betingelse 1: Forespørselsrate overstiger 100 forespørsler/minutt

Betingelse 2: User-Agent inneholder bot-indikatorer

Betingelse 3: Ingen verifisert IP-treff

Handling: Utfordring (CAPTCHA) eller Blokker

Organisasjoner bør implementere regelrekkefølge med omhu, slik at mer spesifikke regler (som IP-verifisering for legitime roboter) kjøres før bredere blokkeringsregler. Regelmessig testing og overvåking av reglenes effektivitet er essensielt, da robots user-agent-strenger og IP-områder endres ofte. Mange WAF-leverandører tilbyr ferdige regelsett spesielt utviklet for AI-robot-håndtering, noe som reduserer implementeringskompleksiteten samtidig som du opprettholder omfattende beskyttelse.

IP-verifisering og hvitelisting er den mest pålitelige metoden for å skille legitime AI-roboter fra forfalskede forespørsler, ettersom user-agent-strenger lett kan forfalskes, mens IP-adresser er langt vanskeligere å forfalske i stor skala. Store AI-selskaper publiserer offisielle IP-områder i JSON-format, noe som muliggjør automatisert verifisering uten manuell vedlikehold—OpenAI tilbyr egne IP-lister for GPTBot, OAI-SearchBot og ChatGPT-User, mens Amazon har en samlet liste for Amazonbot. WAF-regler kan konfigureres slik at kun forespørsler fra disse verifiserte IP-områdene hvitelistes, og hindrer effektivt at aktører omgår begrensninger kun ved å endre user-agent-headeren. For organisasjoner som bruker servernivå-blokkering via .htaccess eller brannmurregler, gir kombinasjonen av IP-verifisering og user-agent-matching forsvar-i-dybden som fungerer uavhengig av WAF-konfigurasjon. I tillegg respekterer noen roboter HTML-meta-taggen som <meta name="robots" content="noarchive">, som signaliserer til kompatible roboter at innholdet ikke skal brukes til modelltrening og gir utgivere et ekstra kontrollnivå for sidebasert beskyttelse.

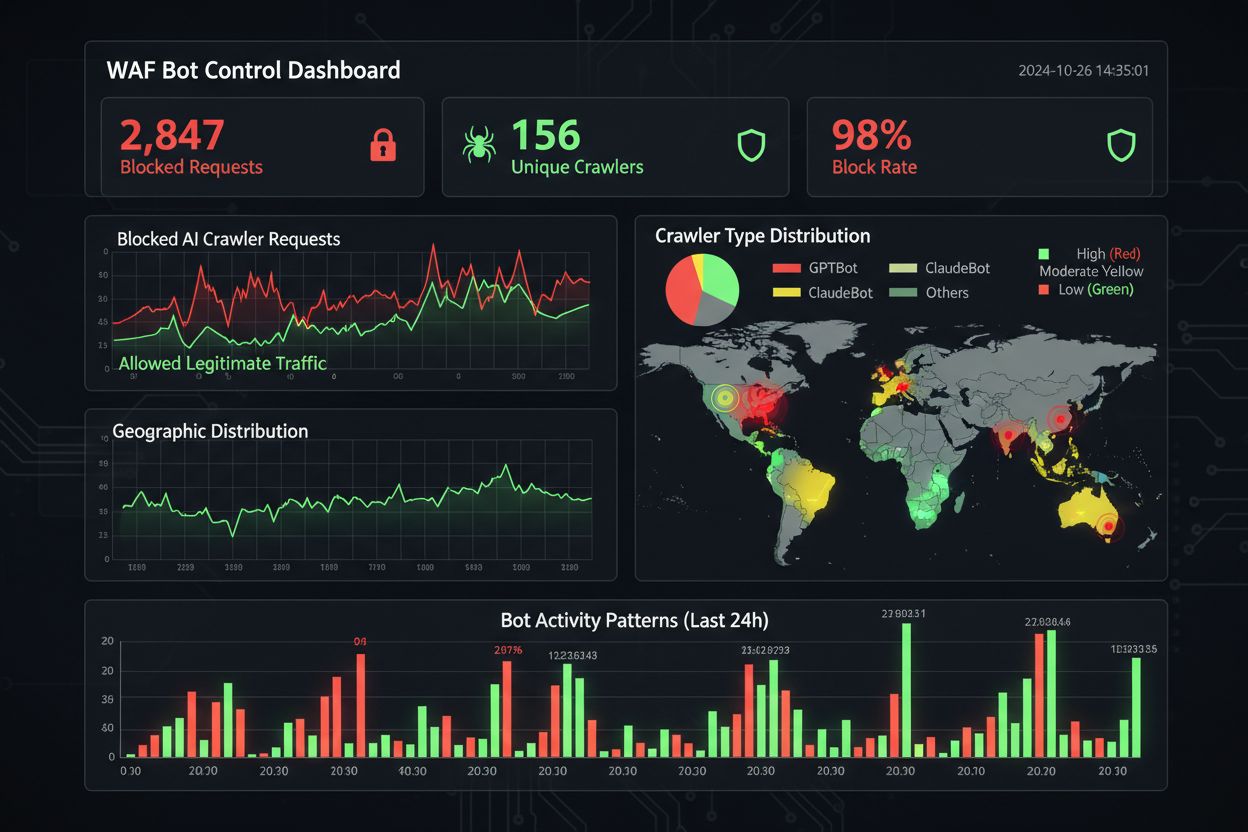

Effektiv overvåking og etterlevelse krever kontinuerlig oversikt over robotaktivitet og verifisering av at blokkeringsregler fungerer som tiltenkt. Organisasjoner bør regelmessig analysere servertilgangslogger for å identifisere hvilke roboter som får tilgang til nettstedene deres og om blokkerte roboter fortsatt prøver å gjøre forespørsler—Apache-logger ligger vanligvis i /var/log/apache2/access.log, mens Nginx har sine i /var/log/nginx/access.log, og grep-filter kan raskt finne mistenkelige mønstre. Analyseplattformer skiller i økende grad bottrafikk fra menneskelige besøkende, slik at team kan måle effekten av robotblokkering på legitime målinger som fluktfrekvens, konverteringssporing og SEO-ytelse. Verktøy som Cloudflare Radar gir global oversikt over AI-bottrafikk og kan identifisere nye roboter som ennå ikke er på blokkeringslisten din. Fra et etterlevelsesperspektiv genererer WAF-logger revisjonsspor som viser at organisasjoner har implementert rimelige sikkerhetstiltak for å beskytte kundedata og immaterielle rettigheter, noe som blir stadig viktigere for GDPR, CCPA og andre datavernregler. Kvartalsvise gjennomganger av robot-blokkeringslisten din er essensielt, da nye AI-roboter stadig dukker opp og eksisterende roboter oppdaterer sine user-agent-strenger—det fellesskapsdrevne ai.robots.txt-prosjektet på GitHub

er en verdifull ressurs for å følge med på nye trusler.

Å balansere innholdsbeskyttelse med forretningsmål krever nøye analyse av hvilke roboter som skal blokkeres versus tillates, ettersom for aggressiv blokkering kan redusere synlighet i nye AI-drevne oppdagelseskanaler. Blokkering av treningsroboter som GPTBot og ClaudeBot beskytter immaterielle rettigheter, men har ingen direkte trafikkpåvirkning, siden disse robotene aldri sender henvisningstrafikk. Derimot kan blokkering av søkeroboter som OAI-SearchBot og PerplexityBot redusere synlighet i AI-drevne søkeresultater hvor brukere aktivt søker etter sitater og kilder—et kompromiss som avhenger av innholdsstrategi og publikum. Noen utgivere utforsker alternative tilnærminger, for eksempel å tillate søkeroboter, men blokkere treningsroboter, eller å implementere betaling per crawl der AI-selskaper kompenserer utgivere for innholdstilgang. Verktøy som AmICited.com hjelper utgivere å spore om innholdet deres siteres i AI-genererte svar, og gir data som grunnlag for blokkeringsbeslutninger. Den optimale WAF-konfigurasjonen avhenger av forretningsmodellen: nyhetsutgivere kan prioritere å blokkere treningsroboter for å beskytte innhold, men tillate søkeroboter for synlighet, mens SaaS-selskaper kanskje vil blokkere alle AI-roboter for å hindre at konkurrenter analyserer priser og funksjoner. Regelmessig overvåking av trafikkmønstre og inntektsmålinger etter implementering av WAF-regler sikrer at beskyttelsesstrategien samsvarer med faktiske forretningsresultater.

Når du sammenligner WAF-løsninger for AI-robotkontroll, bør organisasjoner vurdere flere nøkkelfunksjoner som skiller plattformer i bedriftsklassen fra grunnleggende tilbud. Cloudflares AI Crawl Control integreres med WAF-en for å gi ferdige regler for kjente AI-roboter, med mulighet til å blokkere, tillate eller implementere betaling per crawl for utvalgte roboter—plattformens rekkefølge for regelutførelse sikrer at WAF-regler kjører før andre sikkerhetslag. AWS WAF Bot Control tilbyr både grunnleggende og målrettede beskyttelsesnivåer, hvor det målrettede bruker nettleserinterrogasjon, fingeravtrykk og atferdsheuristikk for å oppdage sofistikerte roboter som ikke selv-identifiserer seg, samt valgfri maskinlæringsanalyse av trafikkstatistikk. Azure WAF tilbyr lignende funksjoner gjennom sine administrerte regelsett, men med mindre AI-spesialisering enn Cloudflare eller AWS. I tillegg tilbyr spesialiserte bot-håndteringsløsninger fra leverandører som DataDome avanserte maskinlæringsmodeller trent spesifikt på AI-robotatferd, men til høyere pris. Valget mellom løsningene avhenger av eksisterende infrastruktur, budsjett og ønsket sofistikasjonsnivå—organisasjoner som allerede bruker Cloudflare får sømløs integrasjon, mens AWS-kunder kan utnytte Bot Control i sin eksisterende WAF-infrastruktur.

Beste praksis for AI-robotkontroll vektlegger en forsvar-i-dybden-tilnærming som kombinerer flere kontrollmekanismer, i stedet for å basere seg på én enkelt løsning. Organisasjoner bør gjennomføre kvartalsvise gjennomganger av blokkeringslisten for å fange opp nye roboter og oppdaterte user-agent-strenger, opprettholde serverlogganalyse for å verifisere at blokkerte roboter ikke omgår reglene, og regelmessig teste WAF-konfigurasjoner for å sikre at reglene kjøres i riktig rekkefølge. Fremtiden for WAF-teknologi vil i økende grad inkorporere AI-drevet trusseldeteksjon som tilpasser seg i sanntid til nye robot-taktikker, med integrasjon i bredere sikkerhetsøkosystemer for kontekstbevisst beskyttelse. Etter hvert som regelverkene strammes inn rundt datascraping og AI-treningsdatas innhenting, vil WAF-er bli essensielle etterlevelsesverktøy snarere enn valgfrie sikkerhetsfunksjoner. Organisasjoner bør begynne å implementere omfattende WAF-regler for AI-roboter nå, før nye trusler som nettleserbaserte AI-agenter og headless nettleserroboter blir utbredt—kostnaden ved å ikke handle, målt i tapt trafikk, ødelagte analyser og potensiell rettslig risiko, er langt høyere enn investeringen som kreves for robust beskyttelsesinfrastruktur.

Robots.txt er en veiledende fil som er avhengig av at roboter frivillig respekterer dine retningslinjer, mens WAF-regler håndheves på infrastrukturnivå og gjelder for alle forespørsler uavhengig av robotens etterlevelse. WAF-er gir sanntidsdeteksjon og blokkering, mens robots.txt er statisk og lett kan omgås av ikke-kompatible roboter.

Ja, mange AI-roboter ignorerer robots.txt-retningslinjer fordi de er designet for å maksimere innsamling av treningsdata. Selv om veloppdragne roboter fra store selskaper vanligvis respekterer robots.txt, gjør ikke alle aktører og noen nye roboter det. Derfor gir WAF-regler mer pålitelig beskyttelse.

Sjekk serverens tilgangslogger (vanligvis i /var/log/apache2/access.log eller /var/log/nginx/access.log) for user-agent-strenger som inneholder bot-identifikatorer. Verktøy som Cloudflare Radar gir global oversikt over trafikkmønstre fra AI-roboter, og analyseplattformer skiller i økende grad bottrafikk fra menneskelige besøkende.

Blokkering av treningsroboter som GPTBot har ingen direkte SEO-effekt siden de ikke sender henvisningstrafikk. Men blokkering av søkeroboter som OAI-SearchBot kan redusere synlighet i AI-drevne søkeresultater. Googles AI Overviews følger vanlige Googlebot-regler, så blokkering av Google-Extended påvirker ikke vanlig søkeindeksering.

Cloudflares AI Crawl Control, AWS WAF Bot Control og Azure WAF tilbyr alle effektive løsninger. Cloudflare gir flest AI-spesifikke funksjoner med ferdige regler og betaling per crawl. AWS tilbyr avansert maskinlæringsdeteksjon, mens Azure har solide administrerte regelsett. Velg ut fra din eksisterende infrastruktur og budsjett.

Gå gjennom og oppdater WAF-reglene dine minst kvartalsvis, ettersom nye AI-roboter dukker opp regelmessig og eksisterende roboter oppdaterer sine user-agent-strenger. Følg med på det fellesskapsdrevne ai.robots.txt-prosjektet på GitHub for nye trusler, og sjekk serverlogger månedlig for å identifisere nye roboter som besøker nettstedet ditt.

Ja, dette er en vanlig strategi. Du kan konfigurere WAF-regler til å blokkere treningsroboter som GPTBot og ClaudeBot, samtidig som du tillater søkeroboter som OAI-SearchBot og PerplexityBot. Dette beskytter innholdet ditt mot bruk i modelltrening, samtidig som du opprettholder synlighet i AI-drevne søkeresultater.

WAF-priser varierer etter leverandør. Cloudflare tilbyr WAF fra $20/måned med AI Crawl Control-funksjoner. AWS WAF tar betalt per web-ACL og regel, vanligvis $5-10/måned for grunnleggende beskyttelse. Azure WAF er inkludert med Application Gateway. Implementeringskostnadene er minimale sammenlignet med verdien av å beskytte innholdet ditt og opprettholde nøyaktige analyser.

AmICited sporer AI-robotaktivitet og overvåker hvordan innholdet ditt siteres i ChatGPT, Perplexity, Google AI Overviews og andre AI-plattformer. Få oversikt over AI-tilstedeværelsen din og forstå hvilke roboter som får tilgang til innholdet ditt.

Lær hvordan du konfigurerer robots.txt for AI-crawlere som GPTBot, ClaudeBot og PerplexityBot. Forstå AI-crawlerkategorier, blokkeringsstrategier og beste praks...

Lær hvordan du bruker robots.txt for å kontrollere hvilke AI-roboter som får tilgang til innholdet ditt. Komplett guide til blokkering av GPTBot, ClaudeBot og a...

Diskusjon i fellesskapet om hvilke AI-crawlere man bør tillate eller blokkere. Virkelige avgjørelser fra nettredaktører om GPTBot, PerplexityBot og andre AI-cra...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.