Bli sitert i Wikipedia-artikler: En ikke-manipulerende tilnærming

Lær etiske strategier for å få merkevaren din sitert på Wikipedia. Forstå Wikipedias innholdspolicyer, pålitelige kilder, og hvordan du kan utnytte siteringer f...

Finn ut hvordan Wikipedia-sitater former KI-treningsdata og skaper ringvirkninger på tvers av LLM-er. Lær hvorfor Wikipedia-tilstedeværelsen din er viktig for KI-omtale og merkevareoppfatning.

Wikipedia har blitt det grunnleggende treningsdatasettet for praktisk talt alle store språkmodeller som finnes i dag – fra OpenAI sin ChatGPT og Google sin Gemini til Anthropic sin Claude og Perplexity sin søkemotor. I mange tilfeller utgjør Wikipedia den største kilden til strukturert, høykvalitets tekst i treningsdatasett for disse KI-systemene, og utgjør ofte 5–15 % av hele treningskorpuset avhengig av modell. Denne dominansen skyldes Wikipedias unike egenskaper: dens nøytralitetspolicy, grundige fellesskapsbaserte faktasjekk, strukturerte format og fri lisensiering gjør den til en enestående ressurs for å lære KI-systemer hvordan de skal resonnere, sitere kilder og kommunisere presist. Dette forholdet har likevel fundamentalt endret Wikipedias rolle i det digitale økosystemet – det er ikke lenger bare et mål for mennesker som søker informasjon, men heller den usynlige ryggraden som driver den samtalebaserte KI-en millioner samhandler med daglig. Å forstå denne forbindelsen avslører en kritisk ringvirkning: kvaliteten, skjevhetene og hullene i Wikipedia former direkte evnene og begrensningene til KI-systemene som nå medierer hvordan milliarder av mennesker får tilgang til og forstår informasjon.

Når store språkmodeller prosesserer informasjon under trening, blir ikke alle kilder behandlet likt – Wikipedia har en unikt privilegert posisjon i beslutningshierarkiet deres. Under entitetsgjenkjenning identifiserer LLM-er viktige fakta og konsepter, og kryssjekker disse mot flere kilder for å etablere troverdighetspoeng. Wikipedia fungerer som en «primær autoritetssjekk» i denne prosessen på grunn av sin åpne redigeringshistorikk, fellesskapsbaserte verifiseringsmekanismer og nøytralitetspolicy, som samlet signaliserer pålitelighet til KI-systemene. Troverdighets-multiplikatoreffekten forsterker denne fordelen: når informasjon forekommer konsekvent på Wikipedia, i strukturerte kunnskapsgrafer som Google Knowledge Graph og Wikidata, og i akademiske kilder, gir LLM-er eksponentielt høyere tillit til den informasjonen. Dette vektingssystemet forklarer hvorfor Wikipedia får spesiell behandling i treningen – det fungerer både som en direkte kunnskapskilde og et valideringslag for fakta hentet fra andre kilder. Resultatet er at LLM-er har lært å behandle Wikipedia ikke bare som ett av mange datapunkter, men som en grunnleggende referanse som enten bekrefter eller setter spørsmålstegn ved informasjon fra mindre kvalitetssikrede kilder.

| Kildetype | Troverdighetsvekt | Årsak | KI-behandling |

|---|---|---|---|

| Wikipedia | Svært høy | Nøytral, fellesskapsredigert, verifisert | Primærreferanse |

| Firmaside | Middels | Selvpromoterende | Sekundærkilde |

| Nyhetsartikler | Høy | Tredjepart, men potensielt partisk | Sammenlignende kilde |

| Kunnskapsgrafer | Svært høy | Strukturert, aggregert | Autoritetsmultiplikator |

| Sosiale medier | Lav | Ikke verifisert, promotering | Minimal vekt |

| Akademiske kilder | Svært høy | Fagfellevurdert, autoritativ | Høy tillit |

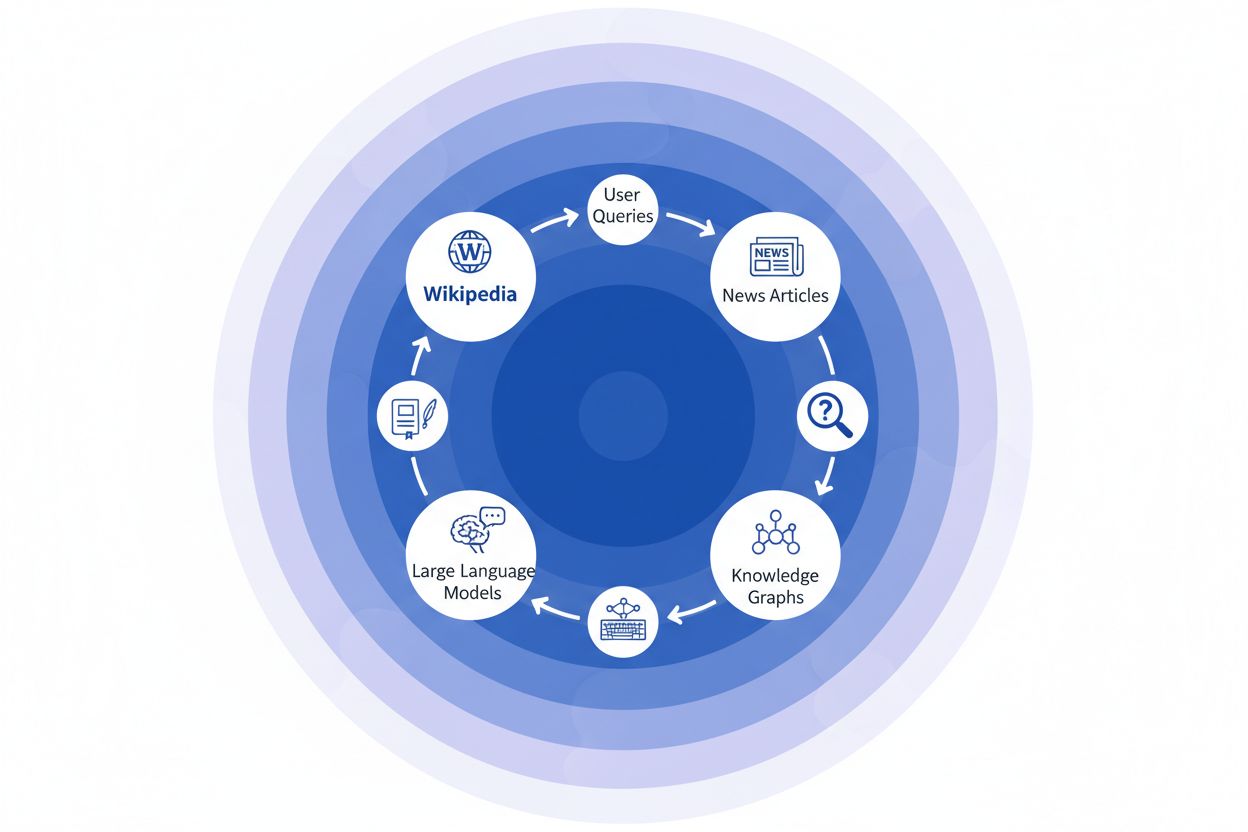

Når en nyhetsorganisasjon siterer Wikipedia som kilde, skaper det vi kaller en «siteringskjede» – en kaskade hvor troverdighet forsterkes gjennom flere lag av informasjonsinfrastruktur. En journalist som skriver om klimavitenskap, kan referere til en Wikipedia-artikkel om global oppvarming, som igjen siterer fagfellevurderte studier; denne nyhetsartikkelen blir så indeksert av søkemotorer og inkorporert i kunnskapsgrafer, som til slutt trener store språkmodeller som millioner av brukere spør daglig. Dette gir en kraftig feedback-loop: Wikipedia → Kunnskapsgraf → LLM → Bruker, hvor den opprinnelige Wikipedia-artikkelens vinkling og vektlegging kan forme hvordan KI-systemer presenterer informasjon for sluttbrukere – ofte uten at brukerne er klar over at informasjonen stammer fra et folkebasert leksikon. Ta et konkret eksempel: Hvis Wikipedia-artikkelen om en farmasøytisk behandling vektlegger visse kliniske studier og nedtoner andre, vil det redaksjonelle valget forplante seg gjennom nyhetsdekning, lagres i kunnskapsgrafer og til slutt påvirke hvordan ChatGPT eller lignende modeller svarer på pasientspørsmål om behandlingsalternativer. Denne «ringvirkningen» betyr at Wikipedias redaksjonelle avgjørelser ikke bare påvirker de som besøker nettstedet direkte – de former i bunn og grunn informasjonslandskapet som KI-systemene lærer fra og speiler tilbake til milliarder av brukere. Siteringskjeden gjør Wikipedia fra å være et oppslagsverk til å bli et usynlig, men innflytelsesrikt lag i KI-treningslinjen, hvor nøyaktighet og skjevhet i kilden kan forsterkes gjennom hele økosystemet.

Ringvirkningene i Wikipedia-til-KI-økosystemet er kanskje det mest avgjørende å forstå for merkevarer og organisasjoner. Én enkelt Wikipedia-redigering endrer ikke bare én kilde – den forplanter seg gjennom et sammenkoblet nettverk av KI-systemer, hvor hvert system henter og forsterker informasjonen på måter som mangedobler effekten. Når en unøyaktighet oppstår på en Wikipedia-side, blir den ikke isolert; istedenfor sprer den seg gjennom hele KI-landskapet og former hvordan merkevaren din beskrives, forstås og presenteres til millioner av brukere daglig. Denne multiplikatoreffekten gjør at investering i nøyaktighet på Wikipedia ikke bare handler om én plattform – det handler om å kontrollere narrativet ditt på tvers av hele den generative KI-økosystemet. For digital PR og merkevareansvarlige endrer denne virkeligheten fundamentalt hvor det lønner seg å bruke ressurser og oppmerksomhet.

Viktige ringvirkninger å følge med på:

Ny forskning fra IUP-studiet til Vetter m.fl. har belyst en kritisk sårbarhet i KI-infrastrukturen vår: Wikipedias bærekraft som treningsressurs trues i økende grad av nettopp den teknologien den hjelper å drive. Etter hvert som store språkmodeller blir flere og trenes på stadig voksende datasett av LLM-generert innhold, får vi en «modellkollaps» hvor kunstige tekster begynner å forurense treningsdatabasen og forringe kvaliteten på modellene i etterfølgende generasjoner. Fenomenet er særlig akutt fordi Wikipedia – et folkebasert leksikon bygget på menneskelig ekspertise og frivillig arbeid – har blitt en bærebjelke i treningen av avanserte KI-systemer, ofte uten eksplisitt kreditering eller kompensasjon til bidragsyterne. De etiske implikasjonene er betydelige: Når KI-selskaper henter verdi fra Wikipedias fritt bidragsyte kunnskap og samtidig oversvømmer informasjonsøkosystemet med syntetisk innhold, utfordres insentivene som har opprettholdt Wikipedias frivillige fellesskap i over tjue år. Uten bevisste tiltak for å bevare menneskeskapt innhold som en egen og beskyttet ressurs, risikerer vi en feedback-loop der KI-generert tekst gradvis fortrenger ekte menneskekunnskap, og til slutt undergraver selve fundamentet dagens språkmodeller er avhengige av. Wikipedias bærekraft er dermed ikke bare et anliggende for leksikonet selv, men en kritisk faktor for hele informasjonsøkosystemet og den fremtidige levedyktigheten til KI-systemene som er avhengige av ekte menneskekunnskap.

Etter hvert som KI-systemer i økende grad baserer seg på Wikipedia som kunnskapskilde, har det blitt essensielt for moderne organisasjoner å overvåke hvordan merkevaren fremstår i KI-genererte svar. AmICited.com spesialiserer seg på å spore Wikipedia-sitater etter hvert som de får ringvirkninger i KI-systemer, og gir merkevarer innsikt i hvordan Wikipedia-tilstedeværelsen deres oversettes til KI-omtale og anbefalinger. Selv om alternative verktøy som FlowHunt.io tilbyr generell webovervåking, fokuserer AmICited spesielt på siteringslinjen fra Wikipedia til KI, og fanger opp det spesifikke øyeblikket hvor KI-systemer refererer til Wikipedia-artikkelen din og hvordan det påvirker svarene deres. Å forstå denne koblingen er kritisk fordi Wikipedia-sitater har stor vekt i KI-treningsdata og responsgenerering – en godt vedlikeholdt Wikipedia-tilstedeværelse informerer ikke bare menneskelige lesere, men former hvordan KI-systemer oppfatter og presenterer merkevaren din for millioner av brukere. Ved å overvåke Wikipedia-omtaler gjennom AmICited får du handlingsrettet innsikt i ditt KI-avtrykk og kan optimalisere Wikipedia-tilstedeværelsen din med full bevissthet om dens ringvirkninger på KI-drevet synlighet og merkevareoppfatning.

Ja, alle store LLM-er inkludert ChatGPT, Gemini, Claude og Perplexity har Wikipedia i treningsdataene sine. Wikipedia er ofte den største kilden til strukturert, verifisert informasjon i LLM-treningsdatasett, og utgjør vanligvis 5-15 % av hele treningskorpuset.

Wikipedia fungerer som en troverdighetskontroll for KI-systemer. Når en LLM genererer informasjon om merkevaren din, vektes Wikipedia-beskrivelsen tyngre enn andre kilder, noe som gjør Wikipedia-siden din til en kritisk faktor for hvordan KI-systemer representerer deg på tvers av ChatGPT, Gemini, Claude og andre plattformer.

Ringvirkningene viser til hvordan et enkelt Wikipedia-sitat eller en redigering skaper konsekvenser nedstrøms i hele KI-økosystemet. Én Wikipedia-endring kan påvirke kunnskapsgrafer, som igjen påvirker KI-oversikter og hvordan flere KI-systemer omtaler merkevaren din til millioner av brukere.

Ja. Fordi LLM-er anser Wikipedia som svært troverdig, vil unøyaktig informasjon på Wikipedia-siden din spre seg gjennom KI-systemer. Dette kan påvirke hvordan ChatGPT, Gemini og andre KI-plattformer omtaler organisasjonen din, og potensielt skade merkevareoppfatningen din.

Verktøy som AmICited.com følger med på hvordan merkevaren din blir sitert og omtalt i KI-systemer, inkludert ChatGPT, Perplexity og Google AI Overviews. Dette hjelper deg å forstå ringvirkningene av Wikipedia-tilstedeværelsen din og optimalisere deretter.

Wikipedia har strenge retningslinjer mot selvpromotering. Alle redigeringer bør følge Wikipedias retningslinjer og være basert på pålitelige, tredjepartskilder. Mange organisasjoner samarbeider med Wikipedia-spesialister for å sikre samsvar og en korrekt tilstedeværelse.

LLM-er trenes på øyeblikksbilder av data, så endringer tar tid å slå gjennom. Kunnskapsgrafer oppdateres imidlertid oftere, så ringvirkningene kan begynne innen uker til måneder, avhengig av KI-systemet og når det trenes på nytt.

Wikipedia er en primærkilde som brukes direkte i LLM-trening. Kunnskapsgrafer som Googles Knowledge Graph samler informasjon fra flere kilder, inkludert Wikipedia, og mater dette inn i KI-systemer, noe som skaper et ekstra lag av påvirkning på hvordan KI-systemene forstår og presenterer informasjon.

Følg hvordan Wikipedia-sitater gir ringvirkninger gjennom ChatGPT, Gemini, Claude og andre KI-systemer. Forstå ditt KI-avtrykk og optimaliser Wikipedia-tilstedeværelsen din med AmICited.

Lær etiske strategier for å få merkevaren din sitert på Wikipedia. Forstå Wikipedias innholdspolicyer, pålitelige kilder, og hvordan du kan utnytte siteringer f...

Oppdag hvordan Wikipedia fungerer som et kritisk AI-treningsdatasett, hvilken betydning den har for modellnøyaktighet, lisensavtaler og hvorfor AI-selskaper er ...

Oppdag hvordan Wikipedia påvirker AI-sitater i ChatGPT, Perplexity og Google AI. Lær hvorfor Wikipedia er den mest pålitelige kilden for AI-trening og hvordan d...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.