Flerspråklig AI-synlighet: Optimalisering for globale markeder

Lær hvordan du kan optimalisere merkevarens synlighet på tvers av AI-systemer på flere språk. Oppdag hvorfor oversatt innhold får 327 % flere siteringer og hvor...

Forvirrende situasjon med vår AI-synlighet:

Vi har 500 sider. Omtrent 200 ser ut til å få AI-siteringer jevnlig. De andre 300 er helt usynlige – aldri sitert selv om de er det beste svaret på et spørsmål.

Dette har jeg sjekket:

Dette er jeg usikker på:

Det må være en grunn til at halve nettstedet vårt er usynlig for AI. Hjelp meg å feilsøke dette.

La meg hjelpe deg å feilsøke systematisk.

Steg 1: Logganalyse

Sjekk serverloggene dine for AI-crawler-besøk på de “usynlige” sidene:

# Sjekk om GPTBot besøker spesifikke sider

grep "GPTBot" access.log | grep "/invisible-page-path/"

Ingen crawler-besøk: De oppdager ikke disse sidene. Besøk, men ikke sitert: Innholdsproblem, ikke tilgang.

Steg 2: Direkte tilgangstest

Test hva crawlerne ser når de besøker siden:

curl -A "GPTBot" -s https://yoursite.com/page-path/ | head -200

Sjekk:

Steg 3: Rendering-test

AI-crawlere varierer i JS-renderingskapasitet. Test med JS deaktivert:

Hvis innholdet forsvinner uten JS, er det problemet ditt.

Steg 4: Rate limiting-sjekk

Har du aggressiv rate limiting for roboter? Sjekk om WAF eller CDN blokkerer etter X forespørsler. AI-crawlere kan bli blokkert midt i crawling.

De vanligste problemene jeg finner:

Oppdagelse vs blokkering – veldig forskjellige problemer.

Hvis GPTBot ikke besøker visse sider, sjekk:

1. Sitemap-dekning Er alle 500 sider i sitemapet ditt? Sjekk sitemap.xml.

2. Intern lenking Hvordan er de usynlige sidene lenket fra resten av nettstedet?

AI-crawlere prioriterer godt lenkede sider. Foreldreløse sider blir crawlet sjeldnere.

3. Crawl-budsjett AI-crawlere har begrensninger. Hvis nettstedet ditt er stort, crawler de kanskje ikke alt.

4. Lenkedybde Hvor mange klikk fra forsiden for å nå de usynlige sidene?

Tiltak:

Intern lenking er sannsynligvis problemet ditt hvis 300 sider ikke blir oppdaget.

Gjennomgå din interne lenkestruktur:

Verktøy som Screaming Frog kan vise:

Vanlige mønstre jeg ser:

Blogginnlegg kun lenket fra arkivsider Bloggarkiv side 15 lenker til gamle innlegg. Crawlere går ikke så dypt.

Produktsider kun lenket fra kategorilister Kategori side 8 lenker til produkter. For dypt.

Ressurssider uten krysslenking Flott innhold, men ingenting lenker til det.

Løsninger:

Nav-sider (hub pages) Lag “Ressurser”- eller “Guider”-sider som lenker til flere relaterte artikler.

Lenker til relaterte innlegg I slutten av hvert innlegg, lenk til 3–5 relaterte artikler.

Brødsmulestier Hjelper crawlere å forstå hierarkiet og finne sider.

Navigasjonsoppdateringer Kan du legge populære dype sider i hovedmenyen eller footeren?

Intern lenking er ikke bare god SEO-praksis – det er slik crawlere oppdager innholdet ditt.

La meg gå i dybden på problemer med JavaScript-rendering:

Hva AI-crawlere klarer:

| Crawler | JS-rendering |

|---|---|

| GPTBot | Begrenset |

| PerplexityBot | Begrenset |

| ClaudeBot | Begrenset |

| Google-Extended | Ja (via Googlebot) |

Trygg antakelse: De fleste AI-crawlere ser det du ser med JS deaktivert.

Vanlige JS-problemer:

Klientside-rendret innhold React/Vue/Angular-apper som kun rendrer innhold i nettleseren. Crawlere ser tomme containere.

Lazy loading uten fallback Bilder og innhold under folden lastes aldri for crawlere.

Interaktive komponenter som skjuler innhold Faner, akordioner, karuseller – innhold i inaktive tilstander er kanskje ikke i initial HTML.

JS-injisert schema Schema lagt til via JavaScript kan bli oversett.

Testing:

# Se rå HTML (det crawlere ser)

curl -s https://yoursite.com/page/

# Sammenlign med rendret HTML (nettleser > Vis kilde)

Hvis viktig innhold mangler i curl-utdataene, har du et JS-problem.

Tiltak:

Botbeskyttelse kan stille blokkere AI-crawlere.

Vanlig botbeskyttelse som gir problemer:

Cloudflare Bot Fight Mode Kan utfordre eller blokkere AI-crawlere. Sjekk: Sikkerhet > Bots > Bot Fight Mode

Rate limiting Hvis du begrenser forespørsler/IP/minutt, kan AI-crawlere treffe grenser.

JavaScript-utfordringer Leverer du JS-utfordringer til roboter, kan AI-crawlere feile dem.

User agent-blokkering Noen WAF-er blokkerer ukjente eller mistenkelige user agents.

Slik verifiserer du:

Anbefalte innstillinger for AI-crawlere:

De fleste CDN/WAF-plattformer lar deg hviteliste user agents:

Du vil beskytte deg mot ondsinnede roboter, ikke mot AI-crawlere som ønsker å indeksere innholdet ditt.

Sitemap-optimalisering for AI-crawler-oppdagelse:

Beste praksis for sitemap:

Inkluder ALLE viktige sider Ikke bare nytt innhold. Alle sider du vil skal oppdages.

Oppdateringsfrekvens-signaler

Bruk <lastmod> for å vise når innholdet ble oppdatert.

Nylige oppdateringer kan bli prioritert for crawling.

Sitemap i robots.txt

Sitemap: https://yoursite.com/sitemap.xml

Dette sørger for at alle crawlere finner det.

Verifisering:

# Sjekk tilgjengelighet for sitemap

curl -I https://yoursite.com/sitemap.xml

# Skal returnere 200

# Sjekk sidetall i sitemap

curl -s https://yoursite.com/sitemap.xml | grep -c "<url>"

Hvis de usynlige sidene ikke er i sitemapet – legg dem til.

Prioritetstips:

Du kan bruke <priority>-tag, men de fleste crawlere ignorerer den. Bedre å satse på intern lenking og ferskhetssignaler.

Fant problemene! Her er hva feilsøkingen avdekket:

Problem 1: Oppdagelse (primær)

Problem 2: Botbeskyttelse (sekundær)

Problem 3: JS-innhold (mindre)

Tiltak utført:

Overhaling av intern lenking

Konsolidering av sitemap

Justerte botbeskyttelse

SSR-implementering

Viktig innsikt:

Sidene var ikke blokkert – de ble bare ikke oppdaget. Intern lenking og sitemap-dekning er avgjørende for tilgang fra AI-crawlere.

Takk til alle for feilsøkingsrammeverket!

Get personalized help from our team. We'll respond within 24 hours.

Følg med på hvilke AI-crawlere som besøker nettstedet ditt, og sørg for at innholdet ditt er synlig for AI-systemer.

Lær hvordan du kan optimalisere merkevarens synlighet på tvers av AI-systemer på flere språk. Oppdag hvorfor oversatt innhold får 327 % flere siteringer og hvor...

Lær hvordan du kommer i gang med AI-synlighet på bare 30 dager. En praktisk guide for nybegynnere som dekker oppdagelse, optimalisering, innholdsstrategi og ove...

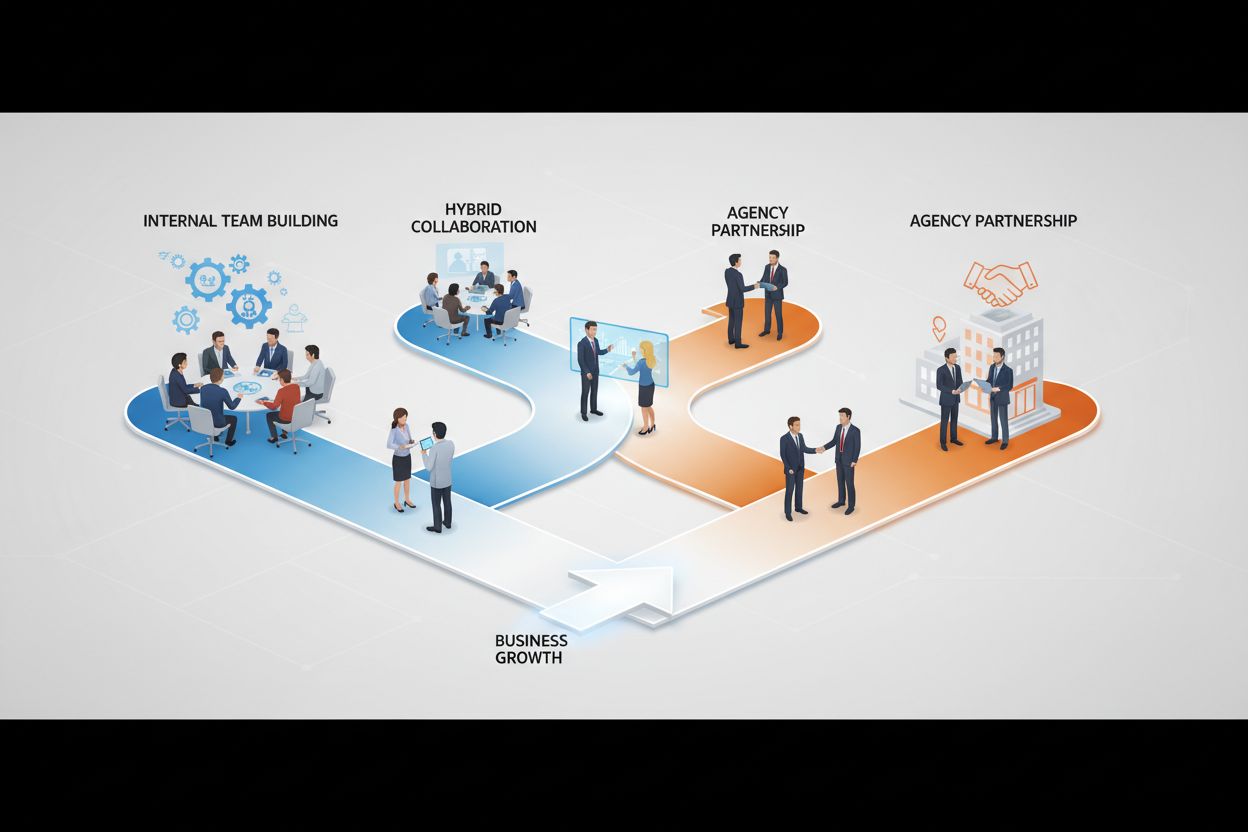

Omfattende beslutningsguide som sammenligner gjør-det-selv og byråtilnærminger for AI-synlighetsmåling. Lær om kostnader, tidslinjer og når du bør hente inn pro...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.