Forstå terskler for AI-innholdskvalitet

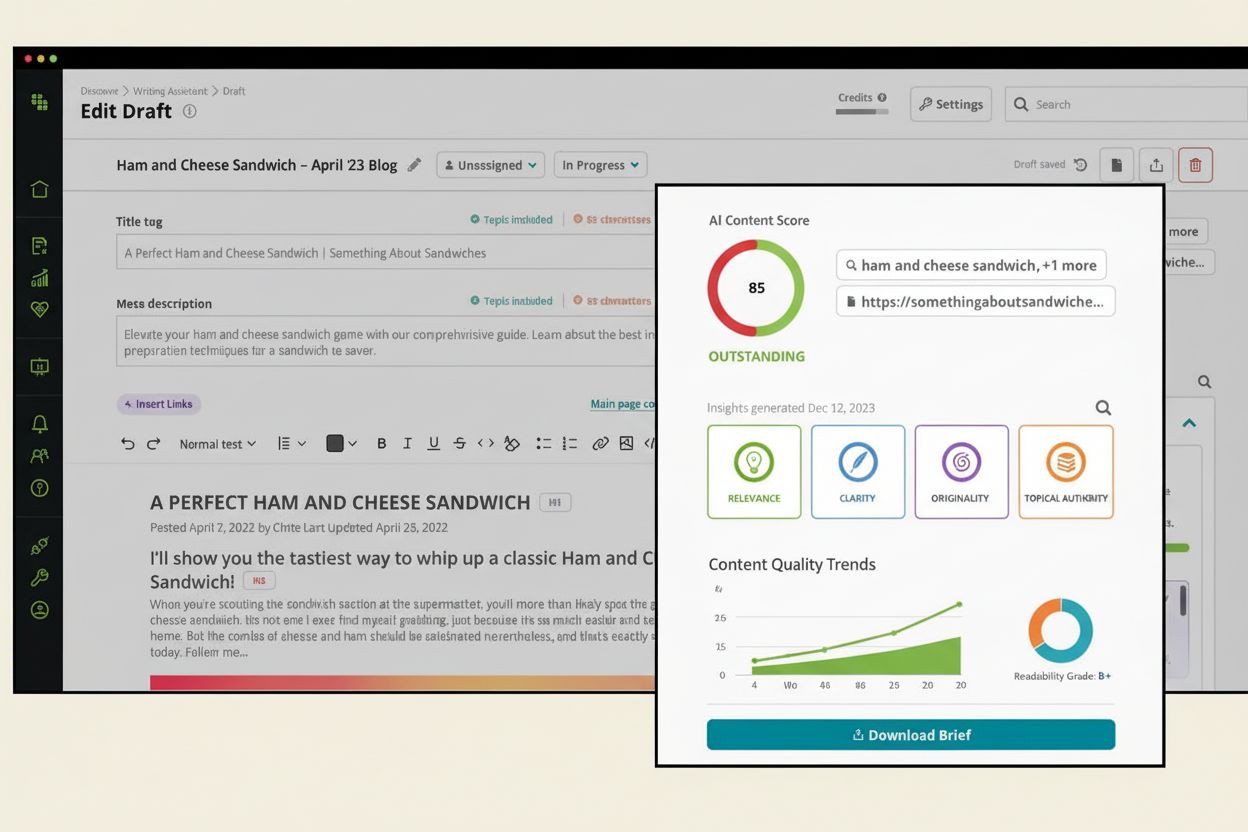

En terskel for AI-innholdskvalitet er en forhåndsdefinert standard som avgjør om AI-generert innhold oppfyller minimumskrav for publisering, distribusjon eller bruk i spesifikke applikasjoner. Disse tersklene fungerer som viktige kontrollmekanismer i generativ AI-tid, der organisasjoner må balansere hastigheten og effektiviteten til automatisert innholdsproduksjon mot behovet for å opprettholde merkevarens integritet, nøyaktighet og brukertillit. Terskelen fungerer som en kvalitetsport, og sikrer at bare innhold som oppfyller etablerte standarder, når ut til publikum, enten det er via AI-svarmotorer som ChatGPT, Perplexity eller andre AI-drevne plattformer.

Kvalitetsterskler er ikke vilkårlige tall, men vitenskapelig funderte referansepunkter utviklet gjennom evalueringsrammeverk som vurderer flere dimensjoner av innholdsytelse. De representerer skjæringspunktet mellom tekniske målinger, menneskelig vurdering og forretningsmessige mål, og skaper et helhetlig system for kvalitetssikring i AI-drevne innholdsøkosystemer.

Kjernedimensjoner ved AI-innholdskvalitet

Nøyaktighet og faktuell korrekthet

Nøyaktighet er grunnlaget for ethvert kvalitetsterskelsystem. Denne dimensjonen måler om informasjonen i AI-generert innhold er faktisk korrekt og kan verifiseres mot pålitelige kilder. I høyrisikoområder som helse, økonomi og journalistikk, er kravene til nøyaktighet spesielt strenge, ofte med krav om 95–99 % korrekthetsgrad. Utfordringen med AI-systemer er at de kan produsere hallusinasjoner – plausible, men fullstendig oppdiktede opplysninger – noe som gjør nøyaktighetsvurdering avgjørende.

Nøyaktighetsvurdering innebærer vanligvis å sammenligne AI-svar mot fasitdata, ekspertverifisering eller etablerte kunnskapsbaser. Når man for eksempel overvåker hvordan merkevaren vises i AI-svar, sikrer nøyaktighetsterskler at enhver henvisning til ditt innhold er faktisk korrekt og riktig kreditert. Organisasjoner som innfører kvalitetsterskler setter ofte minimumsnivå for nøyaktighet på 85–90 % for generelt innhold og 95 % eller høyere for spesialiserte fagområder.

Relevans og intensjonstilpasning

Relevans måler hvor godt AI-generert innhold svarer på brukerens faktiske hensikt og spørsmål. Et svar kan være grammatisk korrekt og faktuelt riktig, men likevel feile hvis det ikke adresserer det brukeren faktisk spør om. Kvalitetsterskler for relevans vurderer om innholdets struktur, tone og informasjonshierarki samsvarer med den underliggende søkeintensjonen.

Moderne systemer for innholdsscore analyserer relevans fra flere vinkler: tematisk dekning (dekker det alle aspekter av spørsmålet?), målgruppetilpasning (er det tilpasset riktig nivå?), og hvor i brukerreisen mottakeren befinner seg (forskning, sammenligning, beslutning). Relevansterskler ligger ofte mellom 70–85 %, da noe periferiinformasjon kan aksepteres avhengig av kontekst.

Sammenheng og lesbarhet

Sammenheng viser til den strukturelle kvaliteten og den logiske flyten i innholdet. AI-systemer må generere tekst som flyter naturlig, med tydelig setningskonstruksjon, konsistent tone og logisk progresjon i ideene. Lesbarhetsmålinger vurderer hvor lett et menneske forstår innholdet, ofte ved hjelp av skårer som Flesch-Kincaid eller Gunning Fog Index.

Kvalitetsterskler for sammenheng spesifiserer gjerne minimumskrav til lesbarhet, tilpasset målgruppen. For et bredt publikum er en Flesch Reading Ease-score på 60–70 vanlig, mens teknisk publikum kan akseptere lavere skårer (40–50) dersom innholdet er spesialisert. Sammenhengsterskler vurderer også avsnittsstruktur, overgangskvalitet og bruk av tydelige overskrifter og formatering.

Originalitet og plagiatkontroll

Originalitet sikrer at AI-generert innhold ikke bare kopierer eller omformulerer eksisterende materiale uten kildeangivelse. Denne dimensjonen er viktig for å opprettholde merkevarens stemme og unngå opphavsrettsproblemer. Kvalitetsterskler krever som regel originalitetsskårer på 85–95 %, altså at 85–95 % av innholdet skal være unikt eller betydelig omskrevet.

Plagiatverktøy måler andelen innhold som samsvarer med eksisterende kilder. Terskler må likevel ta høyde for legitim bruk av faste uttrykk, bransjeterminologi og faktaopplysninger som ikke kan uttrykkes annerledes. Det viktigste er å skille mellom akseptabel omformulering og problematisk kopiering.

Merkevarens stemmekonsistens

Konsistent merkevarestemme måler om AI-generert innhold følger organisasjonens unike tone, stil og budskapsretningslinjer. Denne dimensjonen er avgjørende for å opprettholde gjenkjennelse og tillit på tvers av alle kontaktpunkter, inkludert AI-genererte svar i søkemotorer og svarplattformer.

Kvalitetsterskler for merkevarestemme er ofte kvalitative, men kan operasjonaliseres med kriterier som ordvalg, setningsstruktur, emosjonell tone og samsvar med merkevarens budskapsprinsipper. Organisasjoner setter vanligvis terskler på 80–90 % samsvar med etablerte retningslinjer, med noe fleksibilitet for å bevare kjerneidentitet.

Etisk sikkerhet og bias-detektering

Etisk sikkerhet omfatter flere hensyn: fravær av skadelige stereotypier, støtende språk, forutinntatte antagelser og innhold som kan misbrukes eller forårsake skade. Denne dimensjonen har fått økende betydning etter hvert som organisasjoner erkjenner sitt ansvar for å forhindre at AI-systemer forsterker samfunnsbias eller produserer skadelig innhold.

Kvalitetsterskler for etisk sikkerhet er ofte binære eller nært opp til 100 % (95–100 % påkrevd), siden selv små mengder bias eller skadelig innhold kan skade omdømme og bryte med etiske prinsipper. Evalueringsmetoder inkluderer automatiserte bias-verktøy, manuell vurdering av mangfoldige grupper og testing i ulike demografiske kontekster.

Ready to Monitor Your AI Visibility?

Track how AI chatbots mention your brand across ChatGPT, Perplexity, and other platforms.

Målemetoder og scoringssystemer

Automatiserte metrikker og scoring

Moderne kvalitetsterskelsystemer benytter flere automatiserte målinger for å evaluere AI-innhold i stor skala. Disse inkluderer:

| Metrikk | Hva måles | Terskelområde | Bruksområde |

|---|

| BLEU/ROUGE-skårer | N-gram-overlapp med referansetekst | 0,3–0,7 | Maskinoversettelse, sammendrag |

| BERTScore | Semantisk likhet via embedding | 0,7–0,9 | Generell innholdskvalitet |

| Perpleksitet | Hvor sikre språkmodellen er | Lavere er bedre | Flytvurdering |

| Lesbarhetsskårer | Hvor lett teksten forstås | 60–70 (generelt) | Tilgjengelighetsvurdering |

| Plagiatkontroll | Andel originalitet | 85–95 % unikt | Opphavsrettssikring |

| Toksisitetsskårer | Skadelig språkgjenkjenning | <0,1 (0–1 skala) | Sikkerhetssikring |

| Bias-detektering | Stereotypi- og rettferdighetsvurdering | >0,9 rettferdighet | Etisk samsvar |

Disse automatiserte målingene gir kvantitativ, skalerbar vurdering, men har begrensninger. Tradisjonelle målinger som BLEU og ROUGE fanger ikke alltid semantiske nyanser i LLM-utdata, mens nyere som BERTScore fanger mening bedre, men kan overse domenespesifikke kvalitetsaspekter.

LLM-as-a-Judge-evaluering

En mer avansert tilnærming bruker store språkmodeller som evaluatorer, og utnytter deres overlegne resonnementsevner. Denne metoden, kjent som LLM-as-a-Judge, benytter rammeverk som G-Eval og DAG (Deep Acyclic Graph) for å vurdere innholdskvalitet etter naturlige språkrubrikker.

G-Eval genererer evalueringstrinn via tankerekker før det tildeles skår. For eksempel, vurdering av sammenheng innebærer: (1) definere kriterier, (2) lage evalueringstrinn, (3) bruke disse på innholdet, og (4) gi skår fra 1–5. Denne metoden gir høyere samsvar med menneskelig vurdering (ofte 0,8–0,95 Spearman-korrelasjon) sammenlignet med tradisjonelle metrikker.

DAG-basert evaluering bruker beslutningstrær drevet av LLM-vurdering, hvor hvert node representerer et evalueringskriterium, og kantene representerer valg. Denne metoden er spesielt nyttig når kvalitetsterskler har klare, bestemte krav (f.eks. “innhold må inneholde spesifikke seksjoner i riktig rekkefølge”).

Menneskelig vurdering og ekspertgjennomgang

Til tross for automatisering er menneskelig vurdering avgjørende for å vurdere nyanserte kvaliteter som kreativitet, emosjonell respons og kontekstuelt hensiktsmessig innhold. Kvalitetsterskelsystemer innlemmer vanligvis menneskelig vurdering på flere nivåer:

- Ekspertgjennomgang for spesialisert innhold (medisinsk, juridisk, finans)

- Crowdsource-vurdering for generell kvalitetskontroll

- Stikkprøvekontroll av automatiske skårer for å validere pålitelighet

- Grensesak-analyse for innhold nær terskelverdiene

Menneskelige evaluatorer vurderer innhold etter rubrikker med spesifikke kriterier og scoringsveiledninger for å sikre konsistens. Interrater-pålitelighet (målt med Cohens Kappa eller Fleiss’ Kappa) bør overstige 0,70 for at kvalitetsterskler skal være pålitelige.

Å sette riktige terskler

Kontekstavhengige standarder

Kvalitetsterskler er ikke én standard for alle. De må tilpasses spesifikke kontekster, bransjer og bruksområder. Et raskt FAQ-svar vil naturlig score lavere enn en omfattende guide, og dette er akseptabelt hvis tersklene er riktig satt.

Ulike domener har ulike krav:

- Helse/medisinsk innhold: 95–99 % nøyaktighet kreves; etisk sikkerhet 99 %+

- Finans/juridisk innhold: 90–95 % nøyaktighet; krav om etterlevelse

- Nyheter/journalistikk: 90–95 % nøyaktighet; kildehenvisning påkrevd

- Markedsføring/kreativt innhold: 75–85 % nøyaktighet akseptert; merkevarestemme 85 %+

- Teknisk dokumentasjon: 95 %+ nøyaktighet; klarhet og struktur kritisk

- Generell informasjon: 80–85 % nøyaktighet; relevans 75–80 %

5-metrikk-regelen

I stedet for å følge opp dusinvis av målinger, fokuserer effektive kvalitetsterskelsystemer ofte på 5 kjernemetrikker: 1–2 tilpassede målinger spesifikt for din bruk, og 3–4 generiske målinger tilpasset innholdsarkitekturen. Dette gir balanse mellom helhet og håndterbarhet.

Eksempel – et merkevareovervåkingssystem som sporer AI-svar kan bruke:

- Nøyaktighet (tilpasset): Faktisk korrekthet for merkevareomtaler (terskel: 90 %)

- Kvalitet på attribusjon (tilpasset): Riktig kildehenvisning (terskel: 95 %)

- Relevans (generisk): Innhold svarer på brukerens intensjon (terskel: 80 %)

- Sammenheng (generisk): Teksten har logisk flyt (terskel: 75 %)

- Etisk sikkerhet (generisk): Ingen skadelige stereotypier (terskel: 99 %)

Terskelområder og fleksibilitet

Kvalitetsterskler opererer vanligvis på en skala fra 0–100, men tolkning krever nyanser. En skår på 78 er ikke nødvendigvis “dårlig” – det avhenger av dine standarder og kontekst. Mange organisasjoner etablerer terskelområder i stedet for faste grenser:

- Publiser umiddelbart: 85–100 (oppfyller alle kvalitetskrav)

- Vurder og eventuelt publiser: 70–84 (akseptabelt med mindre justeringer)

- Krever betydelig revisjon: 50–69 (grunnleggende feil)

- Avvis og generer på nytt: 0–49 (oppfyller ikke minimumskrav)

Disse områdene gir fleksibel kvalitetsstyring med opprettholdte standarder. Noen setter minimumsterskel på 80 før publisering, mens andre bruker 70 som grunnlag for vurdering, avhengig av risikonivå og innholdstype.

Stay Updated on AI Visibility Trends

Get the latest insights on AI mentions, brand monitoring, and optimization strategies.

Overvåking av AI-innholdskvalitet i svarmotorer

Hvorfor terskler er viktige for merkevareovervåking

Når merkevaren, domenet eller dine URL-er dukker opp i AI-genererte svar fra ChatGPT, Perplexity eller lignende plattformer, blir kvalitetsterskler avgjørende for merkevarebeskyttelse. Dårlige henvisninger, feilaktig fremstilling eller uriktig attribuert innhold kan skade omdømmet og villede brukere.

Kvalitetsterskler for merkevareovervåking fokuserer gjerne på:

- Siteringsnøyaktighet: Er merkevare/URL riktig sitert? (terskel: 95 %+)

- Kontekstegnethet: Brukes innholdet ditt i relevante sammenhenger? (terskel: 85 %+)

- Attribusjonsklarhet: Er kilden tydelig identifisert? (terskel: 90 %+)

- Informasjonsnøyaktighet: Er fakta om merkevaren din riktige? (terskel: 90 %+)

- Tonesamsvar: Matcher AI-presentasjonen merkevarens stemme? (terskel: 80 %+)

Implementering av kvalitetsterskler for AI-overvåking

Organisasjoner som implementerer kvalitetsterskelsystemer for AI-svarovervåking bør:

- Definere grunnmetrikker spesifikt for din bransje og merkevare

- Etablere tydelige terskelverdier med dokumentert begrunnelse

- Innføre automatisert overvåking for kontinuerlig måling

- Gjennomføre regelmessige revisjoner for å validere tersklene

- Juster terskler basert på resultater og forretningsmål

- Dokumenter alle endringer for å sikre konsistens og ansvarlighet

Denne systematiske tilnærmingen sikrer at merkevaren din opprettholder kvalitetsstandarder på alle AI-plattformer der den vises, beskytter omdømme og sikrer korrekt representasjon overfor brukere som stoler på AI-genererte svar.

Konklusjon

En AI-innholdskvalitetsterskel er langt mer enn bare en enkel kvalitetsskår – det er et omfattende rammeverk for å sikre at AI-generert innhold møter organisasjonens krav til nøyaktighet, relevans, sammenheng, originalitet, merkevaretilpasning og etisk sikkerhet. Ved å kombinere automatiserte målinger, LLM-basert evaluering og menneskelig vurdering kan organisasjoner etablere pålitelige terskler som skalerer med innholdsproduksjonen, samtidig som kvalitetsintegriteten ivaretas. Enten du lager innhold selv eller overvåker hvordan merkevaren vises i AI-svarmotorer, er forståelse og innføring av riktige kvalitetsterskler avgjørende for å opprettholde tillit, beskytte omdømme og sikre at AI-generert innhold tjener publikumet ditt effektivt.