Nylighetsbias i KI

Lær om nylighetsbias i KI-systemer, hvordan det påvirker innholdssynlighet, anbefalingsalgoritmer og forretningsbeslutninger. Oppdag strategier for å motvirke o...

Lær om kildeseleksjonsbias i KI, hvordan det påvirker maskinlæringsmodeller, eksempler fra virkeligheten, og strategier for å oppdage og redusere dette kritiske rettferdighetsproblemet.

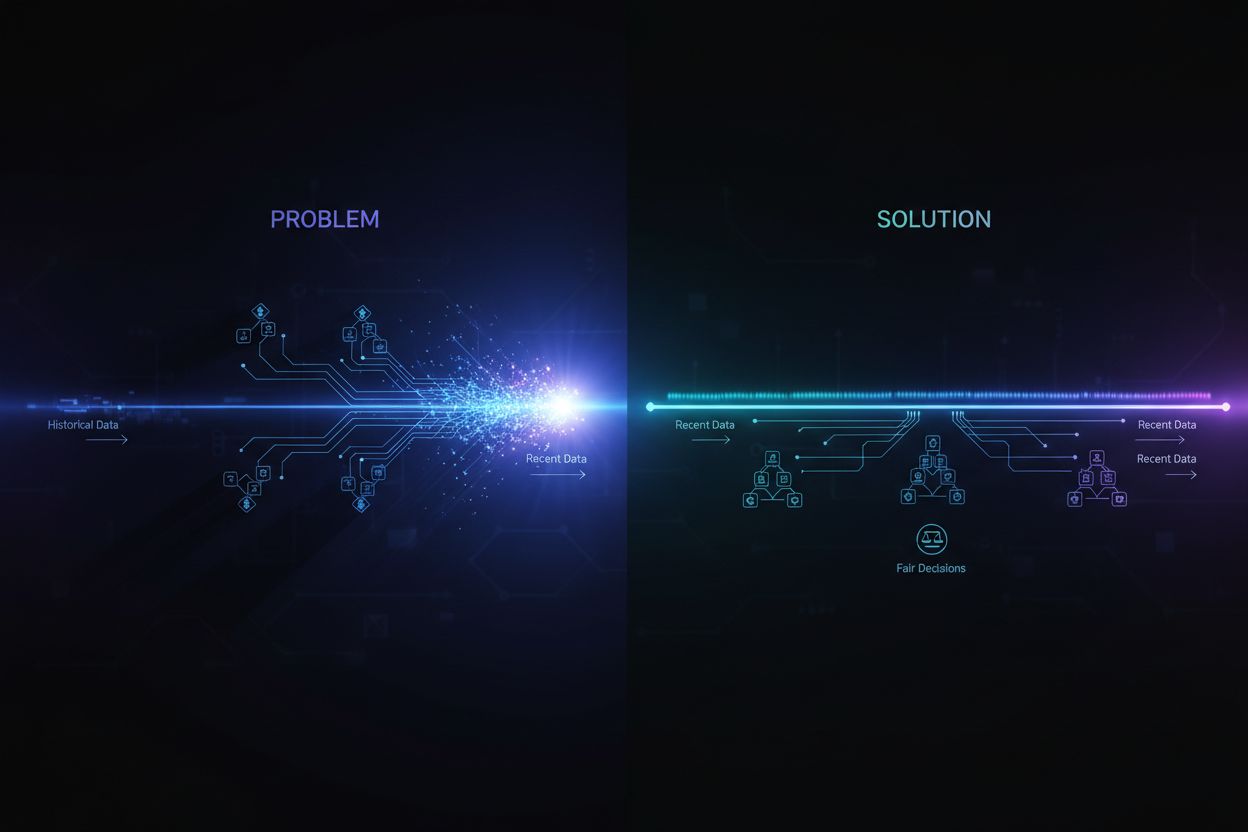

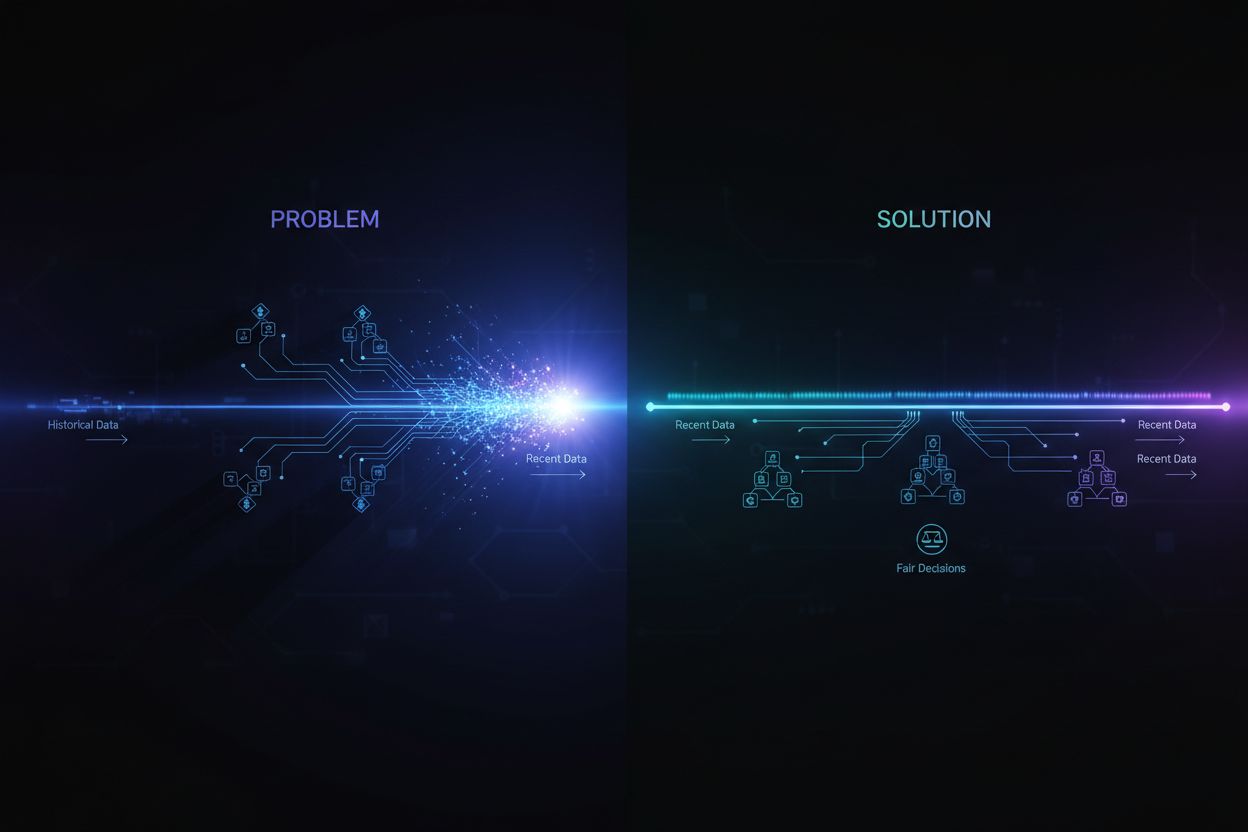

Kildeseleksjonsbias oppstår når treningsdataene ikke er representative for den totale populasjonen eller den virkelige fordelingen, noe som fører til at KI-modeller gir unøyaktige prediksjoner for underrepresenterte grupper eller scenarioer.

Kildeseleksjonsbias er et grunnleggende problem i kunstig intelligens som oppstår når dataene som brukes til å trene maskinlæringsmodeller ikke nøyaktig representerer den virkelige populasjonen eller fordelingen de skal betjene. Denne typen bias oppstår når datasett velges på måter som systematisk ekskluderer eller underrepresenterer visse grupper, scenarioer eller egenskaper. Konsekvensen er at KI-modeller lærer mønstre fra ufullstendige eller skjeve data, noe som fører til prediksjoner som er unøyaktige, urettferdige eller diskriminerende overfor underrepresenterte populasjoner. Forståelse av denne biasen er avgjørende for alle som utvikler, implementerer eller stoler på KI-systemer, fordi det direkte påvirker rettferdigheten, nøyaktigheten og påliteligheten til automatisert beslutningstaking på tvers av bransjer.

Kildeseleksjonsbias skiller seg fra andre former for bias fordi den oppstår allerede i datainnsamlingsfasen. I stedet for å komme fra algoritmiske valg eller menneskelige antakelser under modellutvikling, ligger kildeseleksjonsbias i selve grunnlaget for treningsdatasettet. Dette gjør den spesielt insidious, fordi modeller som trenes på skjeve kildedata vil videreføre og forsterke disse biasene i sine prediksjoner, uavhengig av hvor sofistikert algoritmen er. Problemet blir enda mer kritisk når KI-systemer brukes i områder med høy risiko som helsevesen, finans, strafferett og rekruttering, hvor skjeve prediksjoner kan få alvorlige konsekvenser for enkeltpersoner og samfunn.

Kildeseleksjonsbias utvikles gjennom flere ulike mekanismer i prosessen med innsamling og utvelgelse av data. Den vanligste veien skjer gjennom dekningsoverbias, hvor visse populasjoner eller scenarioer systematisk ekskluderes fra treningsdatasettet. For eksempel, hvis et ansiktsgjenkjenningssystem hovedsakelig trenes på bilder av personer med lys hud, vil det ha dårlig dekning av mørkhudede ansikter, noe som fører til høyere feilrate for disse gruppene. Dette skjer fordi datainnsamlere kanskje har begrenset tilgang til mangfoldige populasjoner, eller de kan ubevisst prioritere visse grupper når de samler inn data.

En annen viktig mekanisme er ikke-respons-bias, også kalt deltakelsesbias, som oppstår når enkelte grupper er mindre tilbøyelige til å delta i datainnsamlingsprosesser. Tenk på et undersøkelsesbasert datasett for å forutsi forbrukerpreferanser: hvis visse demografiske grupper er betydelig mindre tilbøyelige til å svare på undersøkelser, vil deres preferanser bli underrepresentert i treningsdataene. Dette skaper et datasett som tilsynelatende virker balansert, men som egentlig reflekterer deltakelsesmønstre fremfor de egentlige populasjonsegenskapene. I helsevesenet, for eksempel, hvis kliniske studiedata hovedsakelig kommer fra urbane populasjoner med tilgang til avanserte medisinske fasiliteter, vil de resulterende KI-modellene kanskje ikke generalisere godt til rurale eller dårligere stilte samfunn.

Utvalgsbias representerer en tredje mekanisme hvor korrekt randomisering ikke brukes under datainnsamlingen. I stedet for å velge datapunkter tilfeldig, kan innsamlerne velge de første tilgjengelige prøvene eller bruke bekvemmelighetsutvalg. Dette introduserer systematiske feil fordi utvalgte prøver ikke er representative for den bredere populasjonen. For eksempel, hvis en KI-modell for å forutsi mislighold av lån trenes på data samlet fra en bestemt geografisk region eller tidsperiode, kan den ikke forutsi mislighold nøyaktig i andre regioner eller under forskjellige økonomiske forhold.

| Bias-type | Mekanisme | Eksempel fra virkeligheten |

|---|---|---|

| Dekningsbias | Systematisk ekskludering av populasjoner | Ansiktsgjenkjenning trent kun på lyshudede ansikter |

| Ikke-respons-bias | Deltakelsesgap i datainnsamling | Helsesystemer trent kun på urbane populasjoner |

| Utvalgsbias | Feil randomisering i utvalg | Lånemodeller trent på én geografisk region |

| Tidsbias | Data fra bestemte tidsperioder | Modeller trent på pre-pandemi-data brukt etter pandemi |

| Kildemangfold-bias | Begrensede datakilder | Medisinske bildedatasett fra ett sykehus |

Konsekvensene av kildeseleksjonsbias i KI-systemer er dype og vidtrekkende, og påvirker både enkeltpersoner og organisasjoner. I helsevesenet har kildeseleksjonsbias ført til diagnostiske systemer som presterer betydelig dårligere for visse pasientgrupper. Forskning har dokumentert at KI-algoritmer for å diagnostisere hudkreft gir betydelig lavere nøyaktighet for pasienter med mørkere hudtoner, med noen studier som viser bare omtrent halvparten så god diagnostisk nøyaktighet sammenlignet med lyshudede pasienter. Denne forskjellen fører direkte til forsinkede diagnoser, feilbehandlinger og dårligere helseutfall for underrepresenterte populasjoner. Når treningsdata hovedsakelig kommer fra én demografisk gruppe, lærer modellene mønstre som er spesifikke for denne gruppen og klarer ikke å generalisere til andre.

I finanssektoren har kildeseleksjonsbias i kredittvurderings- og utlånsalgoritmer videreført historisk diskriminering. Modeller trent på historiske lånegodkjenninger som reflekterer tidligere diskriminering, vil reprodusere de samme biasene i nye utlånsbeslutninger. Hvis visse grupper historisk har blitt nektet kreditt på grunn av systemisk diskriminering, og disse dataene brukes til å trene KI-modeller, vil modellene lære å nekte kreditt til lignende grupper i fremtiden. Dette skaper en ond sirkel hvor historiske ulikheter blir innebygd i algoritmiske beslutninger, og påvirker enkeltpersoners tilgang til kapital og økonomiske muligheter.

Ansettelser og rekruttering er et annet kritisk område hvor kildeseleksjonsbias fører til betydelig skade. KI-verktøy brukt i CV-screening har vist seg å ha bias basert på antatt rase og kjønn, med studier som viser at navn assosiert med hvite kandidater ble foretrukket 85% av gangene i noen systemer. Når treningsdataene kommer fra historiske ansettelsesregistre som reflekterer tidligere diskriminering eller ensartede ansettelsesmønstre, lærer de resulterende KI-modellene å reprodusere disse mønstrene. Dette betyr at kildeseleksjonsbias i ansettelsesdata viderefører diskriminering i arbeidslivet i stor skala, begrenser muligheter for underrepresenterte grupper og reduserer mangfoldet i arbeidsstyrken.

I strafferettspleien har kildeseleksjonsbias i prediktive politisystemer ført til uforholdsmessig overvåking av visse samfunn. Når treningsdataene kommer fra historiske arrestasjonsregistre som allerede er skjeve mot marginaliserte grupper, forsterker modellene denne biasen ved å forutsi høyere kriminalitetsrater i disse samfunnene. Dette skaper en tilbakekoblingssløyfe hvor skjeve prediksjoner fører til økt politiaktivitet i visse områder, noe som igjen genererer flere arrestasjoner i disse områdene og ytterligere forsterker biasen i modellen.

Å oppdage kildeseleksjonsbias krever en systematisk tilnærming som kombinerer kvantitativ analyse, kvalitativ evaluering og kontinuerlig overvåking gjennom hele modellens livssyklus. Første steg er å gjennomføre en omfattende datarevisjon som undersøker kildene, innsamlingsmetodene og representativiteten til treningsdataene dine. Dette innebærer å dokumentere hvor dataene kommer fra, hvordan de ble samlet inn, og om prosessen kan ha ekskludert visse populasjoner eller scenarioer. Still kritiske spørsmål: Var alle relevante demografiske grupper representert i datainnsamlingen? Var det barrierer som kunne ha hindret visse grupper fra å delta? Begrenset datainnsamlingsperioden eller det geografiske omfanget representasjonen?

Demografisk paritetsanalyse gir en kvantitativ tilnærming til å oppdage kildeseleksjonsbias. Dette innebærer å sammenligne fordelingen av nøkkelkarakteristikker i treningsdataene mot fordelingen i den virkelige populasjonen modellen skal betjene. Hvis treningsdataene dine betydelig underrepresenterer visse demografiske grupper, aldersgrupper, geografiske regioner eller andre relevante egenskaper, har du bevis på kildeseleksjonsbias. For eksempel, hvis treningsdataene dine kun har 5% kvinnelig representasjon, men målgruppen er 50% kvinner, indikerer dette en alvorlig dekningsbias som sannsynligvis vil føre til dårlig modellprestasjon for kvinner.

Resultatanalyse på tvers av grupper er en annen viktig teknikk hvor du evaluerer modellens ytelse separat for ulike demografiske grupper og subpopulasjoner. Selv om den totale nøyaktigheten virker akseptabel, kan ytelsen variere dramatisk mellom gruppene. Hvis modellen din oppnår 95% nøyaktighet totalt, men bare 70% for en bestemt demografisk gruppe, tyder dette på at kildeseleksjonsbias i treningsdataene har ført til at modellen har lært mønstre spesifikke for majoritetsgruppen, men ikke for minoritetsgruppen. Denne analysen bør ikke bare gjøres på total nøyaktighet, men også på rettferdighetsmål som lik odds og ulik påvirkning.

Adversarial testing innebærer å bevisst lage testtilfeller for å avdekke mulige bias. Dette kan inkludere å teste modellen på data fra underrepresenterte grupper, ytterpunkter eller scenarioer som ikke er godt representert i treningsdataene. Ved å stressteste modellen mot mangfoldige input, kan du avdekke hvor kildeseleksjonsbias har skapt blindsoner. For eksempel, hvis modellen er trent hovedsakelig på data fra urbane områder, bør den testes grundig på rurale data for å se om ytelsen forverres. Hvis treningsdataene kom fra en bestemt tidsperiode, bør modellen testes på data fra ulike perioder for å avdekke tidsbias.

Å redusere kildeseleksjonsbias krever tiltak på flere trinn i KI-utviklingsprosessen, fra datainnsamling til modellvurdering og implementering. Den mest effektive tilnærmingen er datadrevet biasreduksjon, hvor man forbedrer kvaliteten og representativiteten til treningsdataene. Dette starter med mangfoldig datainnsamling hvor man aktivt jobber for å inkludere underrepresenterte grupper og scenarioer i treningsdatasettet. I stedet for å stole på bekvemmelighetsutvalg eller eksisterende datasett, bør organisasjoner gjennomføre målrettede datainnsamlinger for å sikre tilstrekkelig representasjon av alle relevante demografiske grupper og bruksområder.

Resampling- og omvektingsmetoder gir praktiske verktøy for å håndtere ubalanserte datasett. Tilfeldig oversampling dupliserer eksempler fra underrepresenterte grupper, mens tilfeldig undersampling reduserer eksempler fra overrepresenterte grupper. Mer sofistikerte tilnærminger som stratifikasjonsutvalg sikrer proporsjonal representasjon på flere dimensjoner samtidig. Omvekting gir høyere betydning til underrepresenterte prøver under modelltrening, og forteller algoritmen at den skal vie mer oppmerksomhet til mønstre i minoritetsgrupper. Disse teknikkene fungerer best i kombinasjon med innsamling av mer mangfoldige data, ikke kun ved resampling av begrenset data.

Syntetisk datagenerering gir en annen mulighet for å adressere kildeseleksjonsbias, spesielt når det er vanskelig eller dyrt å samle inn reelle data fra underrepresenterte grupper. Metoder som generative adversarielle nettverk (GANs) og variational autoencoders (VAEs) kan skape realistiske syntetiske eksempler for disse gruppene. Mer målrettede teknikker som SMOTE (Synthetic Minority Over-sampling Technique) lager syntetiske eksempler ved å interpolere mellom eksisterende minoritetseksempler. Syntetisk data må imidlertid brukes med forsiktighet og valideres grundig, da det kan introdusere egne bias om det ikke genereres riktig.

Rettferdighetsbevisste algoritmer gir en annen strategi på modelltreningsstadiet. Disse algoritmene inkorporerer eksplisitt rettferdighetsbegrensninger i læringsprosessen, slik at modellen oppnår akseptabel ytelse på tvers av alle demografiske grupper, ikke bare majoriteten. Adversarial debiasing bruker for eksempel et motstående nettverk for å sikre at modellens prediksjoner ikke kan brukes til å utlede beskyttede egenskaper som rase eller kjønn. Rettferdighetsregulering legger til straff i tapsfunksjonen for å motvirke diskriminerende atferd. Disse tilnærmingene gjør det mulig å balansere mellom total nøyaktighet og rettferdighet, og velge det som samsvarer med dine etiske prioriteringer.

Kontinuerlig overvåking og retrening sikrer at kildeseleksjonsbias ikke oppstår eller forverres over tid. Selv om de opprinnelige treningsdataene er representative, kan fordelingen i den virkelige verden endre seg på grunn av demografiske endringer, økonomiske forhold eller andre faktorer. Implementering av overvåkingssystemer som sporer modellens ytelse separat for ulike demografiske grupper, gjør det mulig å oppdage når bias oppstår. Når ytelsesforverring oppdages, kan retrening med oppdaterte data som reflekterer dagens populasjon gjenopprette rettferdigheten. Denne prosessen understreker at biasreduksjon ikke er en engangsinnsats, men et kontinuerlig ansvar.

Forståelsen av kildeseleksjonsbias blir stadig viktigere i sammenheng med overvåking av KI-svar og merkevaresynlighet. Når KI-systemer som ChatGPT, Perplexity og andre KI-baserte svarmotorer blir primære informasjonskilder for brukere, blir kildene disse systemene siterer og informasjonen de presenterer formet av treningsdataene. Hvis treningsdataene som brukes til å bygge disse systemene har kildeseleksjonsbias, vil svarene de genererer reflektere denne biasen. For eksempel, hvis et KI-systems treningsdata overrepresenterer visse nettsteder, publikasjoner eller perspektiver og underrepresenterer andre, vil systemet være mer tilbøyelig til å sitere og forsterke informasjon fra de overrepresenterte kildene.

Dette har direkte konsekvenser for merkevareovervåkning og innholdssynlighet. Hvis din merkevare, ditt domene eller dine URL-er er underrepresentert i treningsdataene til store KI-systemer, kan innholdet ditt systematisk bli ekskludert eller underrepresentert i KI-genererte svar. Omvendt, om konkurrenters merkevarer eller feilinformasjon er overrepresentert i treningsdataene, får de uforholdsmessig stor synlighet i KI-svar. Ved å overvåke hvordan din merkevare fremkommer i KI-genererte svar på ulike plattformer, kan du forstå om kildeseleksjonsbias i disse systemene påvirker din synlighet og omdømme. Ved å spore hvilke kilder som siteres, hvor ofte innholdet ditt vises, og om informasjonen er korrekt, kan du identifisere mulige bias i hvordan KI-systemer representerer din merkevare og bransje.

Kildeseleksjonsbias i KI er et kritisk rettferdighetsproblem som oppstår i datainnsamlingsfasen og forplanter seg gjennom alle videre bruksområder for maskinlæringsmodeller. Den oppstår når treningsdata systematisk ekskluderer eller underrepresenterer visse populasjoner, scenarioer eller egenskaper, noe som fører til at modeller gir unøyaktige eller urettferdige prediksjoner for underrepresenterte grupper. Konsekvensene er alvorlige og vidtrekkende, og påvirker helseutfall, finansiell tilgang, jobbmuligheter og strafferettslige avgjørelser. Å oppdage kildeseleksjonsbias krever omfattende datarevisjoner, analyser av demografisk paritet, resultatmålinger på tvers av grupper og adversarial testing. Å redusere denne biasen krever en flerfasettert tilnærming inkludert mangfoldig datainnsamling, resampling og omvekting, syntetisk datagenerering, rettferdighetstilpassede algoritmer og kontinuerlig overvåking. Organisasjoner må erkjenne at håndtering av kildeseleksjonsbias ikke er valgfritt, men avgjørende for å bygge KI-systemer som er rettferdige, nøyaktige og pålitelige på tvers av alle populasjoner og bruksområder.

Sørg for at merkevaren din vises riktig i KI-genererte svar på tvers av ChatGPT, Perplexity og andre KI-plattformer. Følg med på hvordan KI-systemer siterer innholdet ditt og identifiser mulige bias i KI-responsene.

Lær om nylighetsbias i KI-systemer, hvordan det påvirker innholdssynlighet, anbefalingsalgoritmer og forretningsbeslutninger. Oppdag strategier for å motvirke o...

Diskusjon i fellesskapet om hvordan KI-motorer håndterer motstridende informasjon. Ekte erfaringer fra SEO-eksperter og innholdsskapere som analyserer KIs konfl...

Lær effektive metoder for å identifisere, verifisere og korrigere unøyaktig informasjon i AI-genererte svar fra ChatGPT, Perplexity og andre AI-systemer.

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.