Hvordan gjennomføre en AI-synlighetsrevisjon: Komplett metodikk

Lær den komplette steg-for-steg-metodikken for å gjennomføre en AI-synlighetsrevisjon. Oppdag hvordan du måler merkevareomtaler, siteringer og synlighet på tver...

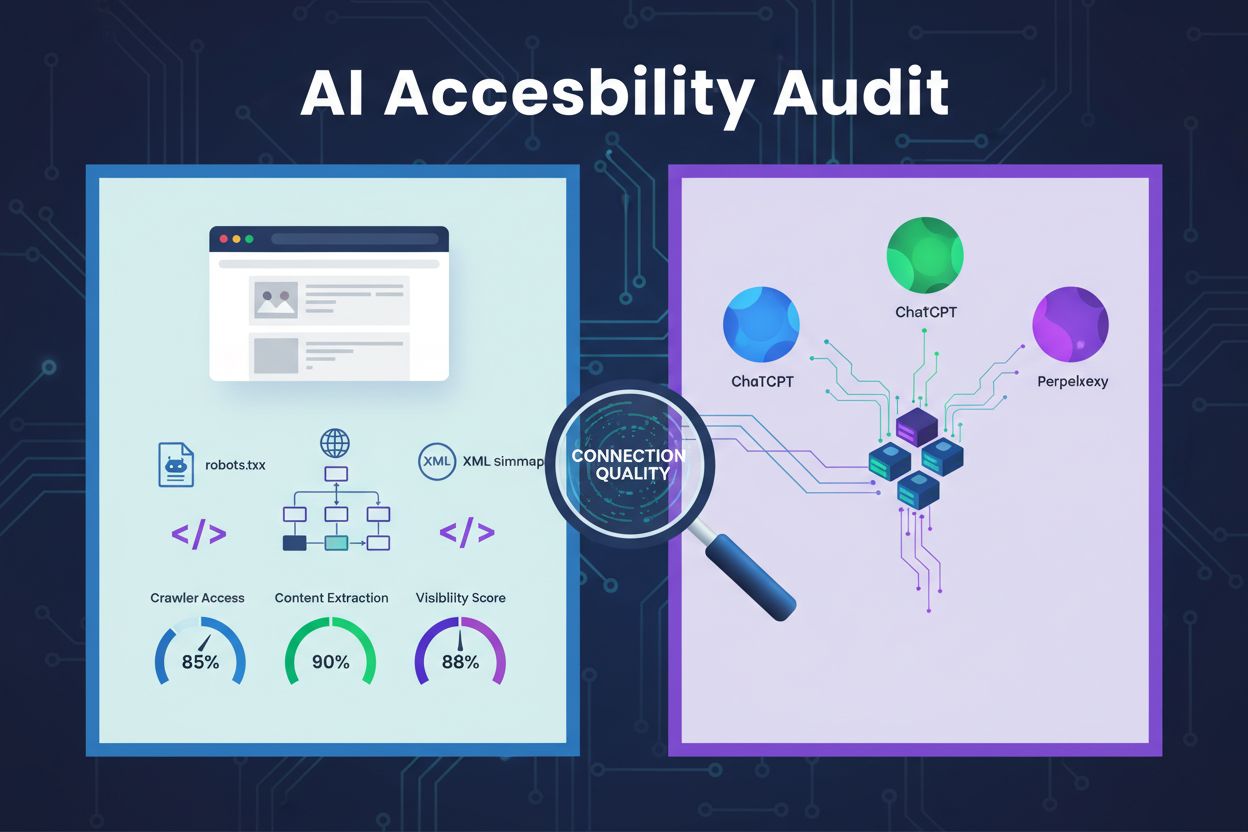

En teknisk gjennomgang av nettstedets arkitektur, konfigurasjon og innholdsstruktur for å avgjøre om AI-crawlere effektivt kan få tilgang til, forstå og hente ut innhold. Evaluerer robots.txt-konfigurasjon, XML-sitemaps, sidens kråleevne, JavaScript-rendering og evne til innholdsekstraksjon for å sikre synlighet på AI-drevne søkeplattformer som ChatGPT, Claude og Perplexity.

En teknisk gjennomgang av nettstedets arkitektur, konfigurasjon og innholdsstruktur for å avgjøre om AI-crawlere effektivt kan få tilgang til, forstå og hente ut innhold. Evaluerer robots.txt-konfigurasjon, XML-sitemaps, sidens kråleevne, JavaScript-rendering og evne til innholdsekstraksjon for å sikre synlighet på AI-drevne søkeplattformer som ChatGPT, Claude og Perplexity.

En AI tilgjengelighetsrevisjon er en teknisk gjennomgang av nettstedets arkitektur, konfigurasjon og innholdsstruktur for å finne ut om AI-crawlere effektivt kan få tilgang til, forstå og hente ut innholdet ditt. I motsetning til tradisjonelle SEO-revisjoner som fokuserer på nøkkelordrangeringer og lenker, undersøker AI tilgjengelighetsrevisjoner de tekniske fundamentene som gjør det mulig for AI-systemer som ChatGPT, Claude og Perplexity å oppdage og sitere innholdet ditt. Revisjonen vurderer kritiske komponenter som robots.txt-konfigurasjon, XML-sitemaps, sidens kråleevne, JavaScript-rendering og evne til innholdsekstraksjon for å sikre at nettstedet ditt er fullt synlig for det AI-drevne søkeøkosystemet.

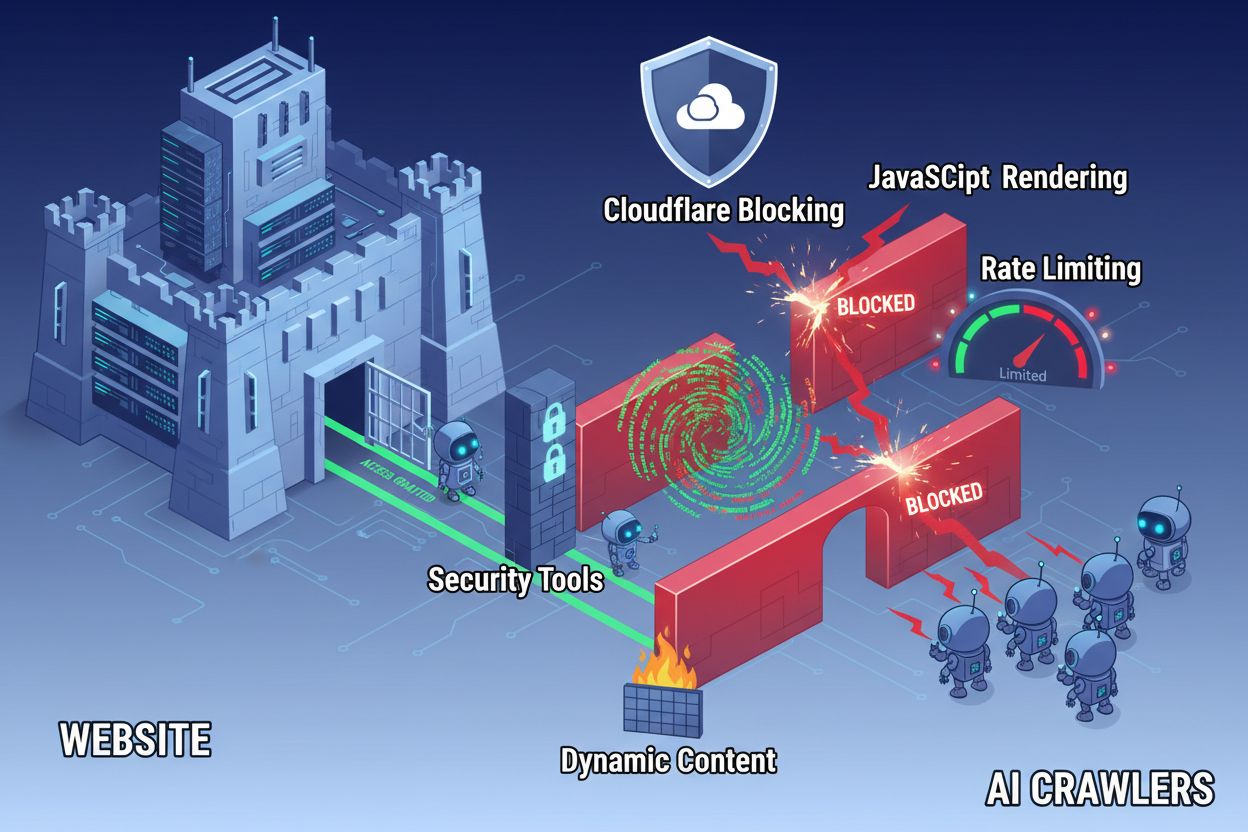

Til tross for fremskritt innen webteknologi møter AI-crawlere betydelige barrierer når de prøver å få tilgang til moderne nettsteder. Den største utfordringen er at mange moderne nettsteder er avhengige av JavaScript-rendering for å vise innhold dynamisk, men de fleste AI-crawlere kan ikke kjøre JavaScript-kode. Dette betyr at omtrent 60–90 % av moderne nettstedsinnhold er usynlig for AI-systemer, selv om det vises perfekt i brukernes nettlesere. I tillegg blokkerer sikkerhetsverktøy som Cloudflare AI-crawlere som standard, og behandler dem som potensielle trusler i stedet for legitime indekseringsroboter. Forskning viser at 35 % av bedriftssider utilsiktet blokkerer AI-crawlere, noe som hindrer verdifullt innhold fra å bli oppdaget og sitert av AI-systemer.

Vanlige barrierer som hindrer AI-crawlertilgang inkluderer:

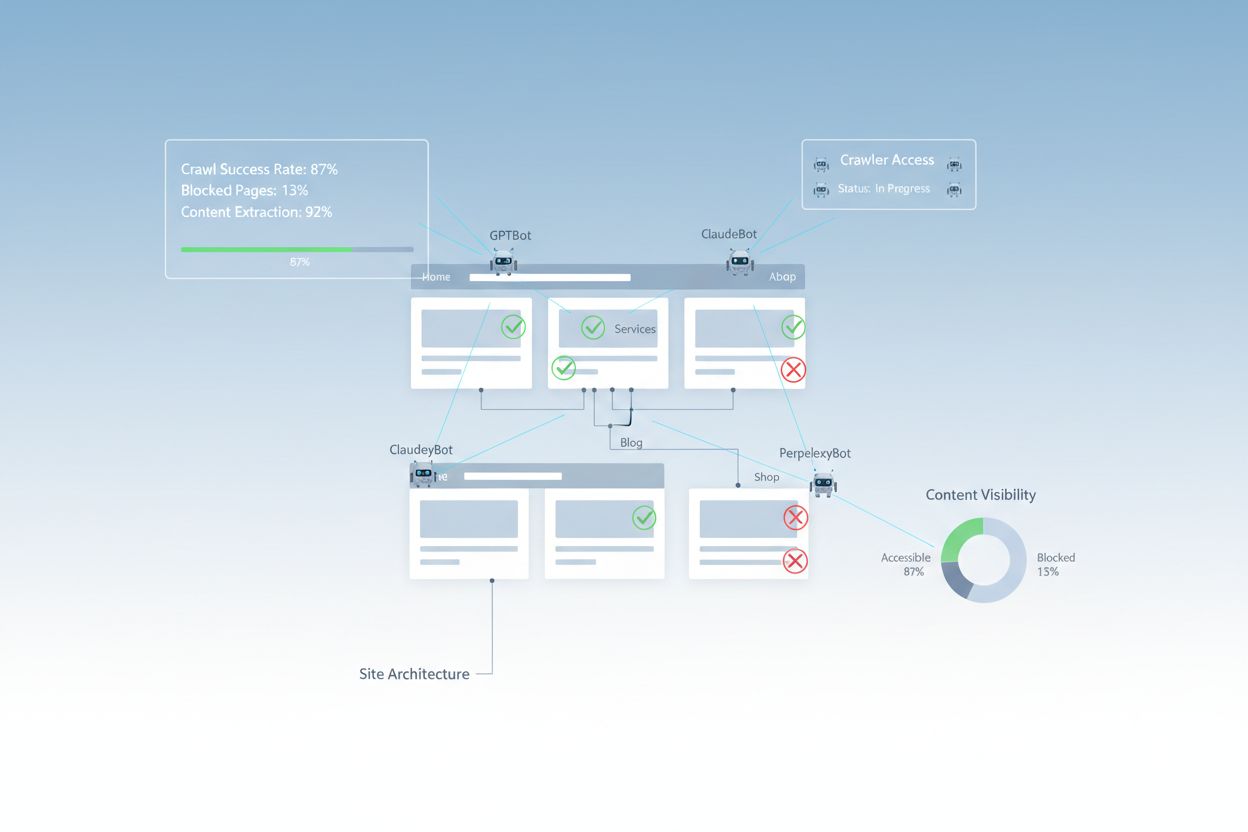

En grundig AI tilgjengelighetsrevisjon gjennomgår flere tekniske og strukturelle elementer som påvirker hvordan AI-systemer samhandler med nettstedet ditt. Hver komponent spiller en unik rolle for om innholdet ditt blir synlig for AI-drevne søkeplattformer. Revisjonsprosessen innebærer testing av kråleevne, verifisering av konfigurasjonsfiler, vurdering av innholdsstruktur og overvåking av faktisk crawler-adferd. Ved å systematisk vurdere disse komponentene kan du identifisere spesifikke barrierer og iverksette målrettede tiltak for å forbedre din AI-synlighet.

| Komponent | Formål | Betydning for AI-synlighet |

|---|---|---|

| Robots.txt-konfigurasjon | Kontrollerer hvilke crawlere som får tilgang til bestemte deler av nettstedet | Kritisk – Feilkonfigurasjon blokkerer AI-crawlere fullstendig |

| XML-sitemaps | Veileder crawlere til viktige sider og innholdsstruktur | Høy – Hjelper AI-systemer å prioritere og oppdage innhold |

| Sidens kråleevne | Sikrer at sider er tilgjengelige uten innlogging eller komplisert navigasjon | Kritisk – Blokkerte sider er usynlige for AI-systemer |

| JavaScript-rendering | Avgjør om dynamisk innhold er synlig for crawlere | Kritisk – 60–90 % av innholdet kan gå tapt uten forhåndsgenerering |

| Innholdsekstraksjon | Vurderer hvor lett AI-systemer kan analysere og forstå innholdet | Høy – Dårlig struktur reduserer sannsynlighet for sitering |

| Sikkerhetsverktøy-konfigurasjon | Håndterer brannmur og beskyttelsesregler som påvirker crawler-tilgang | Kritisk – For strenge regler blokkerer legitime AI-boter |

| Schema markup-implementering | Gir maskinlesbar kontekst om innhold | Middels – Forbedrer AI-forståelse og sjanse for sitering |

| Internlenkestruktur | Etablerer semantiske relasjoner mellom sider | Middels – Hjelper AI å forstå temaautoritet og relevans |

Din robots.txt-fil er det primære verktøyet for å kontrollere hvilke crawlere som får tilgang til nettstedet ditt. Plassert i roten av domenet, inneholder denne enkle tekstfilen direktiver som forteller crawlere om de har lov til å besøke bestemte deler av nettstedet. For AI-tilgjengelighet er korrekt robots.txt-konfigurasjon avgjørende, fordi feilregler kan blokkere viktige AI-crawlere som GPTBot (OpenAI), ClaudeBot (Anthropic) og PerplexityBot (Perplexity) fullstendig. Nøkkelen er å eksplisitt tillate disse crawlerne samtidig som du opprettholder sikkerhet ved å blokkere ondsinnede roboter og beskytte sensitive områder.

Eksempel på robots.txt-konfigurasjon for AI-crawlere:

# Tillat alle AI-crawlere

User-agent: GPTBot

User-agent: ChatGPT-User

User-agent: ClaudeBot

User-agent: Claude-Web

User-agent: PerplexityBot

User-agent: Google-Extended

Allow: /

# Blokker sensitive områder

Disallow: /admin/

Disallow: /private/

Disallow: /api/

# Sitemaps

Sitemap: https://dittnettsted.no/sitemap.xml

Sitemap: https://dittnettsted.no/ai-sitemap.xml

Denne konfigurasjonen gir eksplisitt tillatelse til de viktigste AI-crawlerne til å få tilgang til ditt offentlige innhold, samtidig som administrative og private områder beskyttes. Sitemap-direktivene hjelper crawlere å effektivt oppdage de viktigste sidene dine.

Et XML-sitemap fungerer som et veikart for crawlere, viser hvilke URL-er du vil ha indeksert og gir metadata om hver side. For AI-systemer er sitemaps spesielt verdifulle fordi de hjelper crawlere å forstå nettstedets struktur, prioritere viktig innhold og oppdage sider som ellers kunne blitt oversett ved vanlig crawling. I motsetning til tradisjonelle søkemotorer som kan slutte seg til sidens struktur via lenker, har AI-crawlere stor nytte av eksplisitt veiledning om hvilke sider som er viktigst. Et velstrukturert sitemap med riktige metadata øker sannsynligheten for at innholdet ditt blir oppdaget, forstått og sitert av AI-systemer.

Eksempel på XML-sitemapstruktur for AI-optimalisering:

<?xml version="1.0" encoding="UTF-8"?>

<urlset xmlns="http://www.sitemaps.org/schemas/sitemap/0.9">

<!-- Høyt prioritert innhold for AI-crawlere -->

<url>

<loc>https://dittnettsted.no/om-oss</loc>

<lastmod>2025-01-03</lastmod>

<priority>1.0</priority>

</url>

<url>

<loc>https://dittnettsted.no/produkter</loc>

<lastmod>2025-01-03</lastmod>

<priority>0.9</priority>

</url>

<url>

<loc>https://dittnettsted.no/blogg/ai-guide</loc>

<lastmod>2025-01-02</lastmod>

<priority>0.8</priority>

</url>

<url>

<loc>https://dittnettsted.no/faq</loc>

<lastmod>2025-01-01</lastmod>

<priority>0.7</priority>

</url>

</urlset>

Priority-attributtet signaliserer til AI-crawlere hvilke sider som er viktigst, mens lastmod viser ferskheten på innholdet. Dette hjelper AI-systemer å fordele kråleressurser effektivt og forstå innholdshierarkiet ditt.

Utover konfigurasjonsfiler finnes det flere tekniske barrierer som kan hindre AI-crawlere i å få tilgang til innholdet ditt. JavaScript-rendering er fortsatt den største utfordringen, ettersom moderne web-rammeverk som React, Vue og Angular gjengir innhold dynamisk i nettleseren og etterlater AI-crawlere med tom HTML. Cloudflare og lignende sikkerhetsverktøy blokkerer ofte AI-crawlere som standard, og ser på deres høye forespørselsvolum som potensielle angrep. Rate-limiting kan hindre fullstendig indeksering, mens kompleks nettstedarkitektur og dynamisk innlastet innhold gjør crawler-tilgang enda vanskeligere. Heldigvis finnes det flere løsninger for å overvinne disse barrierene.

Løsninger for å forbedre AI-crawlertilgang:

AI-systemer må ikke bare få tilgang til innholdet ditt–de må også forstå det. Innholdsekstraksjon handler om hvor effektivt AI-crawlere kan analysere, forstå og hente ut meningsfull informasjon fra sidene dine. Denne prosessen er avhengig av semantisk HTML-struktur, som bruker riktige overskriftshierarkier, beskrivende tekst og logisk organisering for å formidle mening. Når innholdet ditt er godt strukturert med tydelige overskrifter (H1, H2, H3), beskrivende avsnitt og logisk flyt, kan AI-systemer lettere identifisere nøkkelinformasjon og forstå kontekst. I tillegg gir schema markup maskinlesbare metadata som eksplisitt forteller AI-systemer hva innholdet ditt handler om, noe som dramatisk forbedrer forståelse og sannsynlighet for å bli sitert.

Riktig semantisk struktur innebærer også å bruke semantiske HTML-elementer som <article>, <section>, <nav> og <aside> i stedet for generiske <div>-tagger. Dette hjelper AI-systemer å forstå formålet og viktigheten av ulike innholdsseksjoner. Når det kombineres med strukturert data som FAQ-schema, Product-schema eller Organization-schema, blir innholdet ditt betraktelig mer tilgjengelig for AI-systemer, og øker sjansen for å bli vist i AI-genererte svar.

Etter at du har gjort forbedringer, må du verifisere at AI-crawlere faktisk får tilgang til innholdet ditt og overvåke løpende ytelse. Serverlogger gir direkte bevis på crawleraktivitet, viser hvilke roboter som har besøkt nettstedet ditt, hvilke sider de har vært innom, og om de har støtt på feil. Google Search Console gir innsikt i hvordan Googles crawlere samhandler med nettstedet ditt, mens spesialiserte AI-synlighetsovervåkingsverktøy sporer hvordan innholdet ditt vises på ulike AI-plattformer. AmICited.com overvåker spesielt hvordan AI-systemer refererer til merkevaren din på ChatGPT, Perplexity og Google AI Overviews, og gir oversikt over hvilke sider som blir sitert og hvor ofte.

Verktøy og metoder for å overvåke AI-crawlertilgang:

Å optimalisere nettstedet ditt for AI-crawlertilgang krever en strategisk, kontinuerlig tilnærming. I stedet for å behandle AI-tilgjengelighet som et engangsprosjekt, implementerer de mest vellykkede organisasjonene kontinuerlig overvåking og forbedring. Den mest effektive strategien kombinerer korrekt teknisk konfigurasjon med innholdsoptimalisering, og sikrer at både infrastrukturen og innholdet ditt er AI-klart.

Dette bør du gjøre for AI-tilgjengelighet:

Dette bør du unngå for AI-tilgjengelighet:

Den mest vellykkede AI-tilgjengelighetsstrategien behandler crawlere som partnere i innholdsdistribusjon, og ikke som trusler som bør blokkeres. Ved å sørge for at nettstedet ditt er teknisk solid, riktig konfigurert og semantisk tydelig, maksimerer du sannsynligheten for at AI-systemer oppdager, forstår og siterer innholdet ditt i sine svar til brukere.

AI-tilgjengelighetsrevisjoner fokuserer på semantisk struktur, maskinlesbart innhold og siterbarhet for AI-systemer, mens tradisjonelle SEO-revisjoner vektlegger nøkkelord, lenker og søkerangeringer. AI-revisjoner undersøker om crawlere kan få tilgang til og forstå innholdet ditt, mens SEO-revisjoner fokuserer på rangeringsfaktorer for Googles søkeresultater.

Sjekk serverloggene dine for AI-crawler user agents som GPTBot, ClaudeBot og PerplexityBot. Bruk Google Search Console for å overvåke kråleaktivitet, test robots.txt-filen din med valideringsverktøy, og bruk spesialiserte plattformer som AmICited for å spore hvordan AI-systemer refererer til innholdet ditt på ulike plattformer.

De vanligste barrierene inkluderer JavaScript-renderingsbegrensninger (AI-crawlere kan ikke kjøre JavaScript), blokkering fra Cloudflare og sikkerhetsverktøy (35 % av bedriftssider blokkerer AI-crawlere), rate-limiting som hindrer fullstendig indeksering, kompleks nettstedarkitektur og dynamisk innlastet innhold. Hver barriere krever ulike løsninger.

De fleste virksomheter har fordel av å tillate AI-crawlere, ettersom de øker merkevarens synlighet i AI-drevne søkeresultater og samtalegrensesnitt. Beslutningen avhenger imidlertid av innholdsstrategi, konkurransesituasjon og forretningsmål. Du kan bruke robots.txt til selektivt å tillate enkelte crawlere og blokkere andre basert på dine behov.

Gjennomfør en fullstendig revisjon kvartalsvis eller når du gjør vesentlige endringer i nettstedets arkitektur, innholdsstrategi eller sikkerhetskonfigurasjon. Overvåk crawleraktivitet kontinuerlig ved hjelp av serverlogger og spesialverktøy. Oppdater robots.txt og sitemaps når du lanserer nye innholdsseksjoner eller endrer URL-strukturer.

Robots.txt er ditt viktigste verktøy for å kontrollere AI-crawlertilgang. Korrekt konfigurasjon tillater eksplisitt de viktigste AI-crawlerne (GPTBot, ClaudeBot, PerplexityBot) samtidig som sensitive områder beskyttes. Feilkonfigurert robots.txt kan fullstendig blokkere AI-crawlere, slik at innholdet ditt blir usynlig for AI-systemer uavhengig av kvaliteten.

Selv om teknisk optimalisering er viktig, kan du også forbedre AI-synlighet gjennom innholdsoptimalisering—ved å bruke semantisk HTML-struktur, implementere schema markup, forbedre internlenking og sikre komplett innhold. Men tekniske barrierer som JavaScript-rendering og blokkering fra sikkerhetsverktøy krever vanligvis tekniske løsninger for full AI-tilgjengelighet.

Bruk serverlogganalyse for å spore crawleraktivitet, Google Search Console for krålestatistikk, robots.txt-valideringsverktøy for å sjekke konfigurasjon, schema markup-valideringsverktøy for strukturert data, og spesialiserte plattformer som AmICited for å overvåke AI-sitater. Mange SEO-verktøy, som Screaming Frog, tilbyr også crawler-simuleringsfunksjoner for å teste AI-tilgjengelighet.

Følg med på hvordan ChatGPT, Perplexity, Google AI Overviews og andre AI-systemer refererer til merkevaren din med AmICited. Få sanntidsinnsikt i din AI-søkesynlighet og optimaliser innholdsstrategien din.

Lær den komplette steg-for-steg-metodikken for å gjennomføre en AI-synlighetsrevisjon. Oppdag hvordan du måler merkevareomtaler, siteringer og synlighet på tver...

Lær hvordan du reviderer AI-crawlertilgang til nettstedet ditt. Oppdag hvilke boter som kan se innholdet ditt og løs blokkeringer som hindrer AI-synlighet i Cha...

Diskusjon i fellesskapet om hvordan man sikrer at AI-crawlere kan få tilgang til og se alt innhold på nettsiden. Ekte erfaringer fra utviklere om verifiseringsm...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.