Hva er AI-synlighetsattribusjon, og hvordan påvirker det merkevaren din?

Lær hva AI-synlighetsattribusjon er, hvordan det skiller seg fra tradisjonell SEO, og hvorfor det er avgjørende for moderne markedsførings-suksess å overvåke hv...

En oppmerksomhetsmekanisme er en komponent i nevrale nettverk som dynamisk vekter viktigheten av ulike inndataelementer, slik at modellene kan fokusere på de mest relevante delene av dataene når de gjør prediksjoner. Den beregner oppmerksomhetsvekter gjennom lærte transformasjoner av forespørsler (queries), nøkler (keys) og verdier (values), noe som gjør det mulig for dype læringsmodeller å fange opp langtrekkende avhengigheter og kontekstbevisste relasjoner i sekvensielle data.

En oppmerksomhetsmekanisme er en komponent i nevrale nettverk som dynamisk vekter viktigheten av ulike inndataelementer, slik at modellene kan fokusere på de mest relevante delene av dataene når de gjør prediksjoner. Den beregner oppmerksomhetsvekter gjennom lærte transformasjoner av forespørsler (queries), nøkler (keys) og verdier (values), noe som gjør det mulig for dype læringsmodeller å fange opp langtrekkende avhengigheter og kontekstbevisste relasjoner i sekvensielle data.

Oppmerksomhetsmekanisme er en maskinlæringsteknikk som styrer dype læringsmodeller til å prioritere (eller “fokusere på”) de mest relevante delene av inndata når de gjør prediksjoner. I stedet for å behandle alle inndataelementer likt, beregner oppmerksomhetsmekanismer oppmerksomhetsvekter som reflekterer den relative viktigheten av hvert element for oppgaven, og bruker så disse vektene til dynamisk å fremheve eller nedtone spesifikke inndata. Denne grunnleggende innovasjonen har blitt hjørnesteinen i moderne transformer-arkitekturer og store språkmodeller (LLMs) som ChatGPT, Claude og Perplexity, og gjør det mulig å behandle sekvensielle data med enestående effektivitet og nøyaktighet. Mekanismen er inspirert av menneskelig kognitiv oppmerksomhet—evnen til selektivt å fokusere på viktige detaljer samtidig som irrelevant informasjon filtreres bort—og oversetter dette biologiske prinsippet til en matematisk streng og lærbar komponent i nevrale nettverk.

Konseptet oppmerksomhetsmekanismer ble først introdusert av Bahdanau og kolleger i 2014 for å løse kritiske begrensninger i rekurrente nevrale nettverk (RNNs) brukt til maskinoversettelse. Før oppmerksomhet ble introdusert, var Seq2Seq-modeller avhengig av en enkelt kontekstvektor for å kode hele kildesetninger, noe som skapte en informasjonsflaskehals som reduserte ytelsen betydelig på lengre sekvenser. Den originale oppmerksomhetsmekanismen lot dekoderen få tilgang til alle skjulte tilstander fra enkoderen, ikke bare den siste, og kunne dermed dynamisk velge hvilke deler av inndata som var mest relevante ved hvert dekodetrinn. Dette gjennombruddet forbedret oversettelseskvaliteten dramatisk, spesielt for lengre setninger. I 2015 introduserte Luong og kolleger dot-produkt oppmerksomhet, som erstattet den datamessig dyre additiv oppmerksomheten med effektiv matrise-multiplikasjon. Det avgjørende øyeblikket kom i 2017 med publiseringen av “Attention is All You Need”, som introduserte transformer-arkitekturen som forkastet rekurrens til fordel for ren oppmerksomhet. Denne artikkelen revolusjonerte dyp læring og la grunnlaget for BERT, GPT-modeller og hele det moderne generative AI-økosystemet. I dag er oppmerksomhetsmekanismer allestedsnærværende innen naturlig språkbehandling, datamaskinsyn og multimodale AI-systemer, med over 85% av toppmoderne modeller som inkluderer en eller annen form for oppmerksomhetsbasert arkitektur.

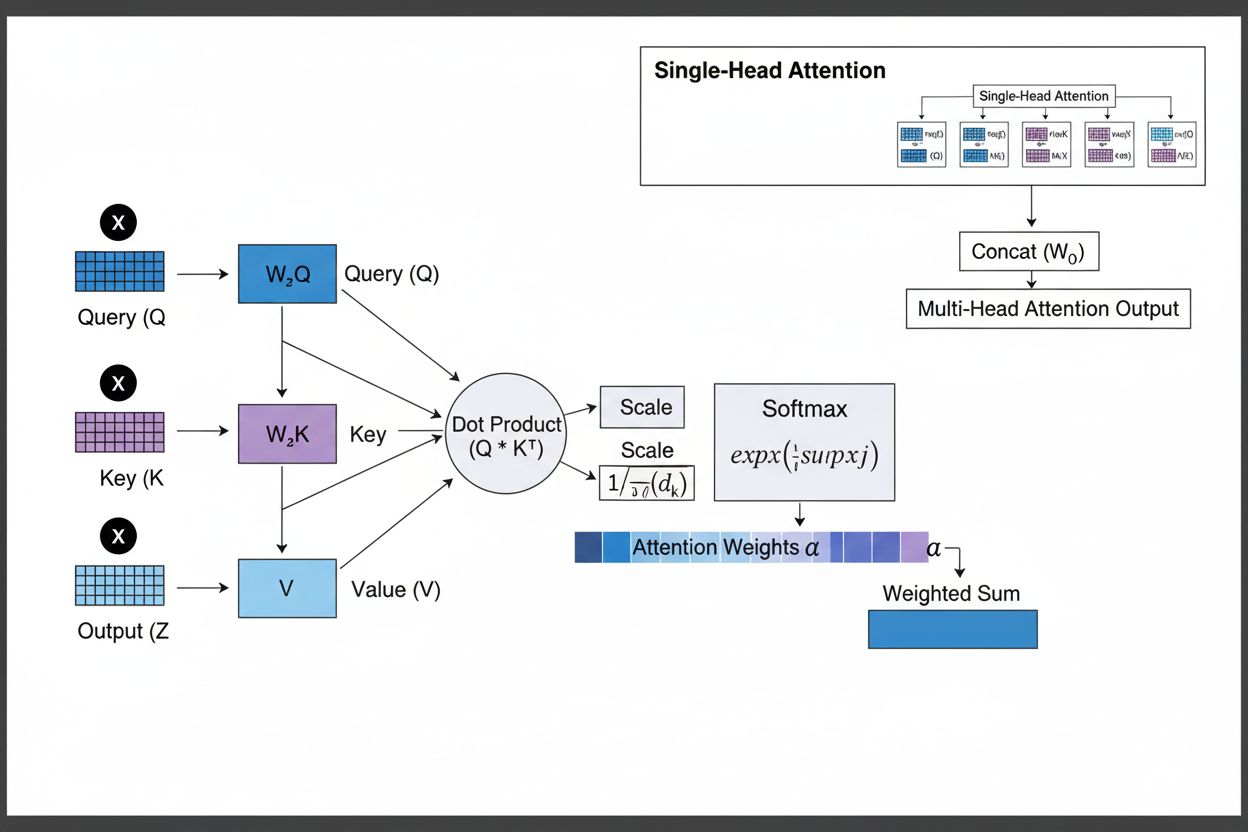

Oppmerksomhetsmekanismen fungerer gjennom et sofistikert samspill mellom tre kjernekomponenter: forespørsler (Q), nøkler (K) og verdier (V). Hvert inndataelement transformeres til disse tre representasjonene gjennom lærte lineære projeksjoner, og skaper en database-lignende struktur hvor nøkler fungerer som identifikatorer og verdier inneholder selve informasjonen. Mekanismen beregner justeringspoeng ved å måle likheten mellom en forespørsel og alle nøkler, vanligvis ved bruk av skalert dot-produkt oppmerksomhet hvor poenget beregnes som QK^T/√d_k. Disse rå poengene normaliseres med softmax-funksjonen, som gjør dem til en sannsynlighetsfordeling hvor alle vekter summerer til 1, slik at hvert element får en verdi mellom 0 og 1. Til slutt beregnes en vektet sum av verdi-vektorene basert på disse oppmerksomhetsvektene, og danner en kontekstvektor som representerer den mest relevante informasjonen fra hele inndatasekvensen. Denne kontekstvektoren kombineres så med den opprinnelige inndataen gjennom residualforbindelser og sendes gjennom feedforward-lag, slik at modellen gradvis kan forbedre forståelsen av inndata. Den matematiske elegansen i dette designet—kombinasjonen av lærbare transformasjoner, likhetsberegninger og sannsynlighetsvekting—gjør at oppmerksomhetsmekanismer kan fange opp komplekse avhengigheter og samtidig være fullt differensierbare for gradientbasert optimalisering.

| Oppmerksomhetstype | Beregning | Beregningstid | Beste brukstilfelle | Nøkkelfordel |

|---|---|---|---|---|

| Additiv oppmerksomhet | Feed-forward nettverk + tanh aktivering | O(n·d) per forespørsel | Kortere sekvenser, variable dimensjoner | Håndterer ulike query/key-dimensjoner |

| Dot-produkt oppmerksomhet | Enkel matrise-multiplikasjon | O(n·d) per forespørsel | Standardsekvenser | Regnemessig effektiv |

| Skalert dot-produkt | QK^T/√d_k + softmax | O(n·d) per forespørsel | Moderne transformere | Forhindrer gradientforvitring |

| Multi-head oppmerksomhet | Flere parallelle oppmerksomhetshoder | O(h·n·d) hvor h=hoder | Komplekse relasjoner | Fanger opp ulike semantiske aspekter |

| Selvoppmerksomhet | Forespørsler, nøkler, verdier fra samme sekvens | O(n²·d) | Intra-sekvensrelasjoner | Muliggjør parallell behandling |

| Kryssoppmerksomhet | Forespørsler fra én sekvens, nøkler/verdier fra en annen | O(n·m·d) | Encoder-decoder, multimodal | Tilpasser ulike modaliteter |

| Grouped Query Attention | Deler nøkler/verdier på tvers av query-hoder | O(n·d) | Effektiv inferens | Reduserer minne og beregning |

| Sparsom oppmerksomhet | Begrenset oppmerksomhet til lokale/stride posisjoner | O(n·√n·d) | Svært lange sekvenser | Håndterer ekstreme sekvenslengder |

Oppmerksomhetsmekanismen fungerer gjennom en nøye orkestrert sekvens av matematiske transformasjoner som gjør det mulig for nevrale nettverk å fokusere dynamisk på relevant informasjon. Når en inndatasekvens behandles, blir hvert element først kodet inn i et høy-dimensjonalt vektorrom som fanger semantisk og syntaktisk informasjon. Disse embeddingene projiseres så inn i tre separate rom gjennom lærte vektmatriser: forespørselsrommet (hva som søkes etter), nøkkelrommet (hva hvert element inneholder av informasjon) og verdirrommet (hvilken informasjon som skal aggregeres). For hver forespørsel beregnes et likhetspoeng med hver nøkkel gjennom dot-produkt, og gir en vektor med rå justeringspoeng. Disse poengene skaleres ved å dele på kvadratroten av nøkkeldimensjonen (√d_k)—et kritisk steg for å forhindre at dot-produktene blir for store ved høye dimensjoner, noe som ellers ville ført til at gradientene forsvinner under tilbakepropagering. De skalerte poengene sendes gjennom en softmax-funksjon som eksponentierer og normaliserer poengene slik at de summerer til 1, og danner en sannsynlighetsfordeling over alle inndataposisjoner. Til slutt brukes disse oppmerksomhetsvektene til å beregne et vektet gjennomsnitt av verdi-vektorene, hvor posisjoner med høyere oppmerksomhetsvekt gir større bidrag til den endelige kontekstvektoren. Denne kontekstvektoren kombineres så med original inndata gjennom residualforbindelser og prosesseres videre gjennom feedforward-lag, slik at modellen gradvis kan forbedre sine representasjoner. Hele prosessen er differensierbar, slik at modellen kan lære optimale oppmerksomhetsmønstre gjennom gradientbasert trening.

Oppmerksomhetsmekanismer utgjør grunnsteinen i transformer-arkitekturer, som har blitt det dominerende paradigmet innen dyp læring. I motsetning til RNNs som behandler sekvenser sekvensielt og CNNs som opererer på faste, lokale vinduer, bruker transformere selvoppmerksomhet slik at hver posisjon direkte kan fokusere på alle andre posisjoner samtidig, og muliggjør massiv parallellisering over GPU-er og TPU-er. Transformer-arkitekturen består av alternerende lag med multi-head selvoppmerksomhet og feedforward-nettverk, hvor hvert oppmerksomhetslag lar modellen forbedre forståelsen av inndata ved selektivt å fokusere på ulike aspekter. Multi-head oppmerksomhet kjører flere oppmerksomhetsmekanismer parallelt, hvor hvert hode lærer å fokusere på ulike typer relasjoner—ett kan spesialisere seg på grammatiske avhengigheter, et annet på semantiske sammenhenger, et tredje på langdistanse referanser. Utgangene fra alle hodene sammenkobles og projiseres, slik at modellen kan opprettholde bevissthet om mange språklige fenomener samtidig. Denne arkitekturen har vist seg svært effektiv for store språkmodeller som GPT-4, Claude 3 og Gemini, som bruker dekoder-bare transformerarkitekturer der hvert token kun kan fokusere på tidligere tokens (kausal maskering) for å opprettholde den autoregressive generasjonsegenskapen. Oppmerksomhetsmekanismens evne til å fange opp langtrekkende avhengigheter uten gradientproblemene som plaget RNN-er, har vært avgjørende for at disse modellene kan behandle kontekstvinduer på 100 000+ tokens og samtidig opprettholde sammenheng og konsistens gjennom store mengder tekst. Forskning viser at omtrent 92% av toppmoderne NLP-modeller nå er avhengige av transformerarkitekturer drevet av oppmerksomhetsmekanismer, noe som understreker deres fundamentale betydning for moderne AI-systemer.

I sammenheng med AI-søkeplattformer som ChatGPT, Perplexity, Claude og Google AI Overviews spiller oppmerksomhetsmekanismer en avgjørende rolle i å avgjøre hvilke deler av hentede dokumenter og kunnskapsbaser som er mest relevante for brukerens forespørsel. Når disse systemene genererer svar, vekter oppmerksomhetsmekanismene dynamisk ulike kilder og avsnitt basert på relevans, slik at de kan syntetisere sammenhengende svar fra flere kilder og samtidig opprettholde faktanøyaktighet. Oppmerksomhetsvektene som beregnes under generering, kan analyseres for å forstå hvilken informasjon modellen prioriterte, og gir innsikt i hvordan AI-systemer tolker og besvarer spørsmål. For merkevareovervåking og GEO (Generative Engine Optimization) er forståelse av oppmerksomhetsmekanismer essensielt fordi de avgjør hvilket innhold og hvilke kilder som får fremhevet plass i AI-genererte svar. Innhold som er strukturert i tråd med hvordan oppmerksomhetsmekanismer vekter informasjon—gjennom tydelige enhetsdefinisjoner, autoritative kilder og kontekstuell relevans—er mer sannsynlig å bli sitert og fremhevet i AI-svar. AmICited utnytter innsikt i oppmerksomhetsmekanismer for å spore hvordan merkevarer og domener vises på tvers av AI-plattformer, fordi oppmerksomhetsvektede sitater representerer de mest innflytelsesrike referansene i AI-generert innhold. Etter hvert som virksomheter i økende grad overvåker sin tilstedeværelse i AI-svar, blir det kritisk å forstå at oppmerksomhetsmekanismer styrer siteringsmønsteret for å optimalisere innholdsstrategien og sikre merkevaresynlighet i den generative AI-æraen.

Feltet oppmerksomhetsmekanismer utvikler seg raskt, med stadig mer sofistikerte varianter som adresserer beregningsbegrensninger og forbedrer ytelsen. Sparsomme oppmerksomhetsmønstre begrenser oppmerksomhet til lokale nabolag eller stride posisjoner, og reduserer kompleksiteten fra O(n²) til O(n·√n) samtidig som ytelsen opprettholdes på svært lange sekvenser. Effektive oppmerksomhetsmekanismer som FlashAttention optimaliserer minnetilgangen under oppmerksomhetsberegningen, og oppnår 2-4x hastighetsøkning gjennom bedre GPU-utnyttelse. Grouped query attention og multi-query attention reduserer antallet key-value-hoder uten å gå på bekostning av ytelse, og minsker minnekravene betydelig under inferens—et kritisk hensyn ved utrulling av store modeller i produksjon. Mixture of Experts-arkitekturer kombinerer oppmerksomhet med sparsom ruting, slik at modeller kan skalere til billioner av parametre og samtidig opprettholde regneffektiviteten. Fremvoksende forskning utforsker lærte oppmerksomhetsmønstre som tilpasser seg dynamisk basert på input, og hierarkisk oppmerksomhet som opererer på flere abstraksjonsnivåer. Integrasjon av oppmerksomhetsmekanismer med retrieval-augmented generation (RAG) muliggjør at modeller kan fokusere på relevant ekstern kunnskap, forbedrer faktaverdien og reduserer hallusinasjoner. Etter hvert som AI-systemer tas i bruk i stadig mer kritiske applikasjoner, forbedres oppmerksomhetsmekanismer med forklarbarhetsfunksjoner som gir tydeligere innsikt i modellens beslutninger. Fremtiden vil trolig involvere hybridarkitekturer som kombinerer oppmerksomhet med alternative mekanismer som state-space modeller (eksemplifisert av Mamba), som gir lineær kompleksitet og samtidig opprettholder konkurransedyktig ytelse. Å forstå disse utviklende oppmerksomhetsmekanismene er avgjørende for praktikere som bygger neste generasjons AI-systemer og for organisasjoner som overvåker sin tilstedeværelse i AI-generert innhold, siden mekanismene som avgjør siteringsmønstre og innholdssynlighet stadig utvikler seg.

For organisasjoner som bruker AmICited for å overvåke merkevaresynlighet i AI-svar, gir forståelse av oppmerksomhetsmekanismer viktig kontekst for å tolke siteringsmønstre. Når ChatGPT, Claude eller Perplexity siterer ditt domene i sine svar, har oppmerksomhetsvektene som ble beregnet under genereringen avgjort at ditt innhold var mest relevant for brukerens spørsmål. Høykvalitets, godt strukturert innhold som tydelig definerer entiteter og gir autoritativ informasjon får naturlig høyere oppmerksomhetsvekter, og er derfor mer sannsynlig å bli valgt for sitering. Oppmerksomhetsvisualisering i enkelte AI-plattformer viser hvilke kilder som fikk mest fokus under svargenereringen, og avslører hvilke sitater som var mest innflytelsesrike. Denne innsikten lar organisasjoner optimalisere innholdsstrategien ved å forstå at oppmerksomhetsmekanismer belønner klarhet, relevans og autoritativ kildebruk. Etter hvert som AI-søk vokser—med over 60% av virksomheter som nå investerer i generativ AI—blir evnen til å forstå og optimalisere for oppmerksomhetsmekanismer stadig mer verdifull for å opprettholde merkevaresynlighet og sikre nøyaktig representasjon i AI-generert innhold. Skjæringspunktet mellom oppmerksomhetsmekanismer og merkevareovervåking representerer en ny front innen GEO, hvor forståelse av de matematiske prinsippene bak hvordan AI-systemer vekter og siterer informasjon direkte gir bedre synlighet og innflytelse i det generative AI-økosystemet.

Tradisjonelle RNN-er behandler sekvenser serielt, noe som gjør det vanskelig å fange opp langtrekkende avhengigheter, mens CNN-er har faste lokale mottaksfelt som begrenser deres evne til å modellere fjerne relasjoner. Oppmerksomhetsmekanismer overkommer disse begrensningene ved å beregne relasjoner mellom alle inndataposjoner samtidig, noe som muliggjør parallell behandling og fanger opphengigheter uavhengig av avstand. Denne fleksibiliteten over både tid og rom gjør oppmerksomhetsmekanismer betydelig mer effektive for komplekse sekvensielle og romlige data.

Queries representerer hvilken informasjon modellen søker etter, keys representerer informasjonsinnholdet hvert inndataelement har, og values holder de faktiske dataene som skal aggregeres. Modellen beregner likhetspoeng mellom queries og keys for å avgjøre hvilke values som skal vektes høyest. Denne databaseinspirerte terminologien, popularisert av artikkelen 'Attention is All You Need', gir et intuitivt rammeverk for å forstå hvordan oppmerksomhetsmekanismer selektivt henter og kombinerer relevant informasjon fra inndatasekvenser.

Selvoppmerksomhet beregner relasjoner innenfor en enkelt inndatasekvens, hvor queries, keys og values alle kommer fra samme kilde, slik at modellen kan forstå hvordan ulike elementer henger sammen. Kryssoppmerksomhet, derimot, bruker queries fra én sekvens og keys/values fra en annen sekvens, slik at modellen kan tilpasse og kombinere informasjon fra flere kilder. Kryssoppmerksomhet er essensiell i encoder-decoder-arkitekturer som maskinoversettelse og i multimodale modeller som Stable Diffusion som kombinerer tekst- og bildeinformasjon.

Skalert dot-produkt oppmerksomhet bruker multiplikasjon i stedet for addisjon for å beregne justeringspoeng, noe som gjør det datamessig mer effektivt gjennom matriseoperasjoner som utnytter GPU-parallellisering. Skaleringsfaktoren 1/√dk forhindrer at dot-produktene blir for store når nøkkeldimensjonen er høy, noe som ellers ville ført til at gradientene forsvinner under tilbakepropagering. Selv om additiv oppmerksomhet noen ganger overgår dot-produkt oppmerksomhet for svært store dimensjoner, gjør skalert dot-produkt oppmerksomhets overlegne regneeffektivitet og praktiske ytelse den til standardvalget i moderne transformerarkitekturer.

Multi-head oppmerksomhet kjører flere oppmerksomhetsmekanismer parallelt, hvor hvert hode lærer å fokusere på ulike aspekter av inndata slik som grammatiske relasjoner, semantisk mening eller langdistanseavhengigheter. Hvert hode opererer på ulike lineære projeksjoner av inndata, slik at modellen samtidig kan fange opp ulike typer relasjoner. Utgangene fra alle hodene blir sammenkoblet og projisert, slik at modellen kan opprettholde omfattende bevissthet om flere språklige og kontekstuelle trekk samtidig, noe som betydelig forbedrer representasjonskvaliteten og ytelsen på nedstrømsoppgaver.

Softmax normaliserer de rå justeringspoengene beregnet mellom queries og keys til en sannsynlighetsfordeling hvor alle vektene summerer til 1. Denne normaliseringen sikrer at oppmerksomhetsvektene er tolkbare som viktighetspoeng, med høyere verdier som indikerer større relevans. Softmax-funksjonen er differensierbar, slik at oppmerksomhetsmekanismen kan læres med gradientbasert trening, og dens eksponentielle natur forsterker forskjeller mellom poeng, noe som gjør modellens fokus mer selektivt og tolkbart.

Oppmerksomhetsmekanismer lar disse modellene dynamisk vekte ulike deler av inndata basert på relevans for det nåværende generasjonssteget. Når de genererer et svar, bruker modellen oppmerksomhet for å avgjøre hvilke tidligere token og inndataelementer som skal ha størst innflytelse på neste tokenprediksjon. Denne kontekstbevisste vektingen gjør at modellene kan opprettholde sammenheng, spore entiteter gjennom lange dokumenter, løse tvetydigheter og generere svar som refererer korrekt til bestemte deler av inndata, slik at utgangene blir mer nøyaktige og kontekstuelt passende.

Begynn å spore hvordan AI-chatbots nevner merkevaren din på tvers av ChatGPT, Perplexity og andre plattformer. Få handlingsrettede innsikter for å forbedre din AI-tilstedeværelse.

Lær hva AI-synlighetsattribusjon er, hvordan det skiller seg fra tradisjonell SEO, og hvorfor det er avgjørende for moderne markedsførings-suksess å overvåke hv...

Oppdag den fremvoksende rollen som AI-synlighetsspesialist, dens ansvarsområder, nødvendige ferdigheter og karrieremuligheter i en tid med AI-drevne søk og gene...

Sammenlign byrå og intern overvåking av AI-synlighet. Utforsk kostnader, tidslinjer, kompetansekrav og hybride tilnærminger for å hjelpe deg å velge riktig stra...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.