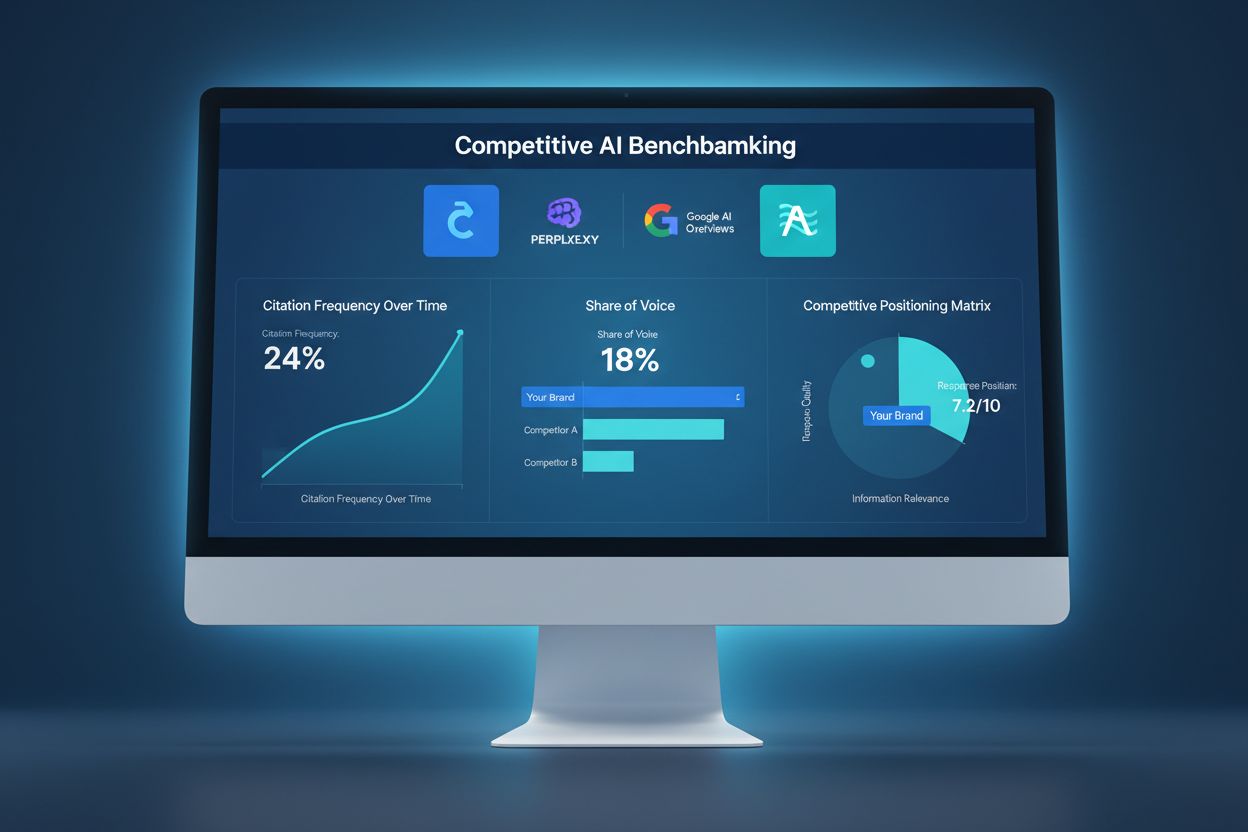

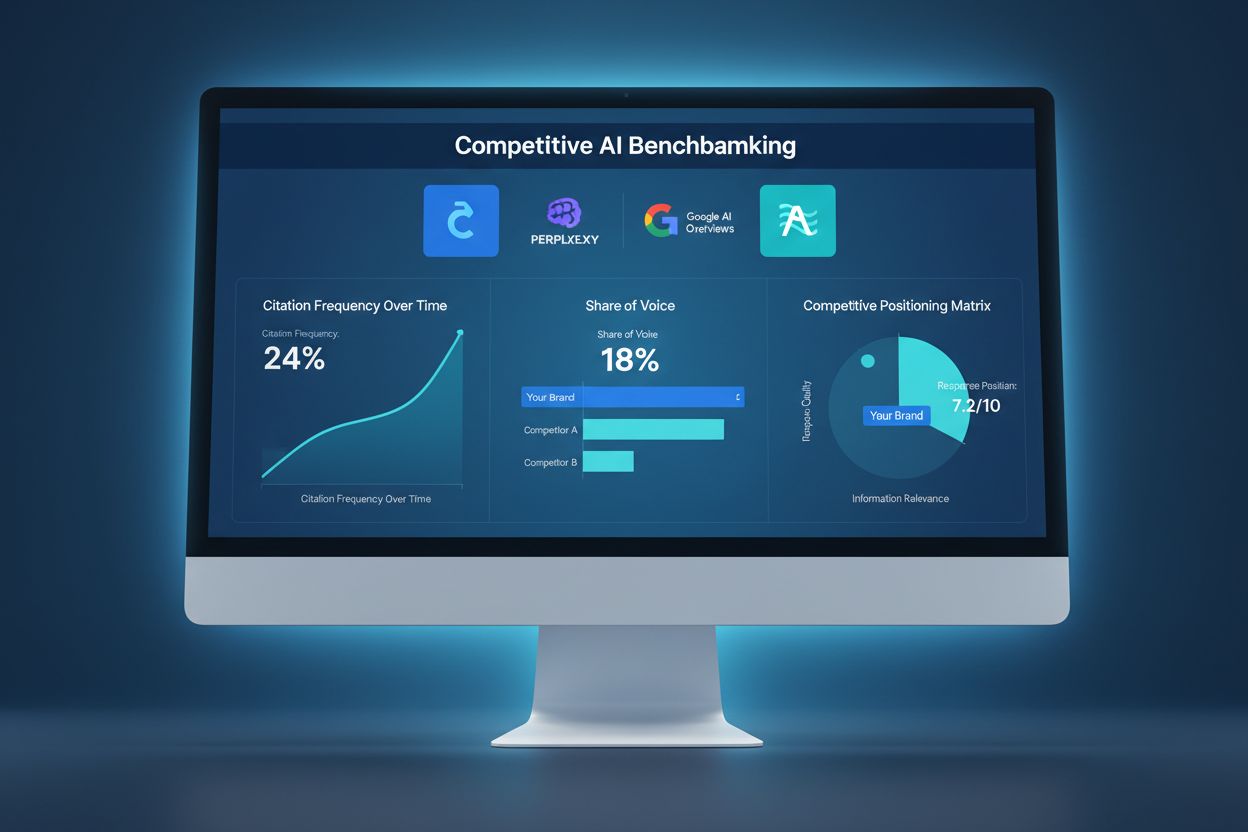

Konkurransedyktig AI-benchmarking

Lær hvordan du kan benchmarke AI-synligheten din mot konkurrenter. Spor siteringer, andel av stemme og konkurranseposisjonering på ChatGPT, Perplexity og Google...

Konkurrerende AI-sabotasje refererer til bevisste forsøk fra konkurrenter på å påvirke en merkevares synlighet, omtale eller ytelse negativt i AI-drevne søkeresultater og chatbot-svar. Dette inkluderer datapåvirkning, falske anmeldelser, desinformasjonskampanjer og manipulering av AI-treningsdata for å skade merkevarens omdømme og redusere AI-sitater.

Konkurrerende AI-sabotasje refererer til bevisste forsøk fra konkurrenter på å påvirke en merkevares synlighet, omtale eller ytelse negativt i AI-drevne søkeresultater og chatbot-svar. Dette inkluderer datapåvirkning, falske anmeldelser, desinformasjonskampanjer og manipulering av AI-treningsdata for å skade merkevarens omdømme og redusere AI-sitater.

Konkurrerende AI-sabotasje refererer til bevisste forsøk på å manipulere, forgifte eller korrumpere dataene som AI-søkemotorer og språkmodeller bruker for å generere resultater og sitater. I motsetning til tradisjonell negativ SEO, som fokuserer på å skade en konkurrents nettsiderangering gjennom lenkesystemer eller tekniske utnyttelser, retter AI-sabotasje seg mot treningsdataene og kildene AI-systemene er avhengige av for å gi svar. Dette skillet er avgjørende fordi AI-systemer som Google AI Overviews, Perplexity og GPT-er siterer kilder direkte fra treningsdataene sine, noe som gjør dem sårbare for koordinerte desinformasjonskampanjer. Den reelle effekten er betydelig: med 60 % av søkene som ender uten at brukeren klikker seg videre til nettsider, kan konkurrenter nå forgifte AI-resultater for å omdirigere trafikk, skade merkevarens omdømme eller fremme feilinformasjon uten å påvirke tradisjonelle søkerangeringer.

Konkurrerende AI-sabotasje opererer gjennom flere sammenkoblede angrepsvektorer som utnytter hvordan AI-systemer henter inn og behandler informasjon. Datapåvirkning er hovedteknikken, og innebærer å injisere falsk, misvisende eller ondsinnet informasjon i kilder AI-systemene bruker til trening—slik som offentlige databaser, forum, anmeldelsessider og nyhetsaggregatorer. Angripere benytter label flipping (å endre metadata for å feilklassifisere innhold), datainjeksjon (legge til falske oppføringer i datasett), og bakdørsangrep (skjulte triggere i treningsdata). Konkurrenter igangsetter også koordinerte falske anmeldelseskampanjer for å oversvømme plattformer med fabrikerte tilbakemeldinger, samtidig som de sprer feilinformasjon og deepfakes gjennom sosiale medier, blogger og AI-indeksert innhold. Sårbarheten ligger i at AI-systemer ofte stoler på mengden og konsistensen av informasjon fremfor å verifisere ektheten. Slik sammenlignes ulike sabotasjemetoder:

| Metode | Hvordan det fungerer | AI-effekt | Vanskelighetsgrad å oppdage |

|---|---|---|---|

| Datapåvirkning | Injisere falsk informasjon i treningsdatasett | AI siterer forgiftede kilder direkte i resultater | Høy – krever dataanalyse |

| Falske anmeldelser | Koordinerte anmeldelsesangrep på plattformer | Skjevfordeler AI-sentimentanalyse og anbefalinger | Middels – mønstergjenkjenning hjelper |

| Desinformasjonskampanjer | Spre falske påstander på indekserte nettsider | AI forsterker falske narrativer i søkeresultater | Høy – krever faktasjekk |

| Deepfakes | Lage syntetiske medier av ledere eller produkter | Skader merkevarens troverdighet når AI siterer dem | Svært høy – krever verifisering |

| Katalogkapring | Kreve konkurrenters bedriftsoppføringer | AI henter falsk informasjon fra kaprede kataloger | Middels – verifiseringskontroller hjelper |

| Falske nyhetsartikler | Publisere fabrikerte historier på nyhetslignende sider | AI behandler som autoritative kilder | Høy – krever kildeverifisering |

AI-systemer er grunnleggende mer sårbare for sabotasje enn tradisjonelle søkemotorer fordi de stoler mer blindt på treningsdata enn mennesker gjør. Mens Googles algoritme vurderer lenkemyndighet og domenets omdømme, lærer AI-modeller bare mønstre fra dataene de trenes på—noe som gjør dem utsatt for koordinerte angrep. Forskning viser at så få som 250 ondsinnede dokumenter kan forgifte en AI-modell, en dramatisk lavere terskel enn tradisjonelle SEO-angrep. Problemet forsterkes av at AI-systemer siterer kilder direkte, noe som betyr at forgiftede data ikke bare påvirker resultater — det blir det autoritative svaret brukerne ser. Å oppdage forgiftede data er eksponentielt vanskeligere enn å identifisere dårlige lenker, fordi manipuleringen skjer på treningsnivå, ofte usynlig for eksterne revisjoner. Med AI-søk som økte med 527 % på kun fem måneder (januar–mai 2025) og 79 % av amerikanere som stoler på AI-søkemotorer, er insentivet for konkurrenter til å sabotere større enn noen gang, mens sikkerhetsinfrastrukturen henger etter.

Det mest kjente eksempelet på AI-sabotasje skjedde da Target ble utsatt for en koordinert desinformasjonskampanje som falskt hevdet at kjeden solgte “Satanist-inspirerte” barneklær. AI-systemer, trent på denne fabrikerte fortellingen, begynte å vise disse falske påstandene i søkeresultater og AI-overblikk, noe som førte til betydelig omdømmeskade før selskapet rakk å svare. E-postsystemer har opplevd lignende angrep gjennom spamfilter-forgiftning, der konkurrenter injiserer ondsinnede mønstre i treningsdata for å få legitime e-poster merket som spam. Konkurrenters anmeldelsesbombing har blitt stadig vanligere, der virksomheter oversvømmer rivalers oppføringer med falske negative anmeldelser som AI-systemer så samler inn i sentiment-score. Katalogkapring er en annen vektor, hvor angripere krever konkurrenters bedriftsprofiler på plattformer som Google Min Bedrift eller bransjekataloger, og mater inn falsk informasjon som AI-systemer indekserer og siterer. Disse sakene viser at AI-sabotasje ikke er teoretisk—det skader virksomheter i dag, og skaden forsterkes fordi AI-søkeresultater fremstår som autoritative og ofte er den første informasjonen brukerne møter.

Å oppdage konkurrerende AI-sabotasje krever en flerlags overvåkningsstrategi som følger med på hvordan din merkevare vises i AI-søkeresultater og siteringskilder. Første steg er kontinuerlig overvåkning av AI-søkeresultater for din merkevare, produkter og nøkkelpersoner på plattformer som Google AI Overviews, Perplexity, ChatGPT og Claude. Sentimentsporing på tvers av indekserte kilder hjelper med å identifisere plutselige endringer i omtalen av din merkevare—et faresignal for koordinerte desinformasjonskampanjer. Identifisering av falske anmeldelser innebærer å analysere anmeldelsesmønstre for statistiske avvik, som plutselige hopp i én-stjerners vurderinger eller anmeldelser med identisk språk. Tidlig oppdagelse er kritisk; forskning viser at de første 48 timene etter et sabotasjeangrep er avgjørende for å begrense og svare. Overvåkningen bør også følge med på hvilke kilder AI-systemer siterer om din merkevare, slik at du kan identifisere forgiftede datakilder før de får bred skade. Her er de viktigste deteksjonsmetodene:

Å bygge motstandsdyktighet mot konkurrerende AI-sabotasje krever en proaktiv, flerfasettert forsvarsstrategi som går lenger enn tradisjonell omdømmehåndtering. Å lage innhold av høy kvalitet fra autoritative kilder er ditt sterkeste forsvar—AI-systemer trenes til å gjenkjenne og prioritere innhold fra etablerte, troverdige kilder, noe som gjør det vanskeligere for forgiftede data å konkurrere. Å forsterke korrekt informasjon på tvers av flere indekserte plattformer sikrer at når AI-systemer søker etter informasjon om din merkevare, møter de konsistente, sanne fortellinger fra autoritative kilder. Å sikre din merkevaretilstedeværelse betyr å kreve og verifisere alle bedriftsoppføringer, sosiale medier-profiler og bransjekataloger for å forhindre kapringsangrep. Implementer robuste overvåkningssystemer som sporer din merkevare i AI-søkeresultater i sanntid, slik at du kan reagere raskt på trusler. Utarbeid beredskapsprotokoller som beskriver hvordan teamet ditt skal reagere på oppdaget sabotasje, inkludert dokumentasjon, plattformrapportering og juridiske tiltak når det er nødvendig. Å bygge relasjoner med journalister, bransjeinfluensere og pålitelige publikasjoner gir ekstra lag med troverdighet som AI-systemene gjenkjenner og prioriterer.

Dedikerte AI-overvåkningsplattformer har blitt essensiell infrastruktur for merkevarebeskyttelse i AI-søkets tidsalder. Disse verktøyene gir varsler i sanntid når din merkevare dukker opp i AI-søkeresultater, slik at du kan spore ikke bare rangeringer, men reelle sitater og kildene AI-systemene bruker. AmICited.com utmerker seg som en helhetlig løsning spesialdesignet for å overvåke hvordan din merkevare, produkter og ledere blir sitert på tvers av AI-søkemotorer, inkludert Google AI Overviews, Perplexity og GPT-er. Plattformen sporer hvilke kilder AI-systemer siterer om din merkevare, slik at du kan identifisere forgiftede datakilder og svare før de får omfattende konsekvenser. Integrasjon med din overordnede merkevaresikkerhetsstrategi betyr at du kan korrelere AI-sitasjonsmønstre med tradisjonelle søkemetrikker, sosiale medier-sentiment og anmeldelsesplattformer for å få et komplett bilde av konkurranselandskapet. Ved å kombinere AI-overvåkning med eksisterende omdømmehåndteringsverktøy, skaper du et samlet forsvarssystem som fanger opp sabotasje tidlig og gir dataene du trenger for rask respons.

Etter hvert som konkurrerende AI-sabotasje blir mer utbredt, utvikles det juridiske rammeverket for å håndtere disse nye truslene. DMCA-anmodninger om fjerning kan brukes for å få bort forgiftet innhold fra indekserte kilder, men prosessen er ofte treg og krever tydelig bevis på brudd på opphavsrett eller identitetstyveri. Ærekrenkelseslovgivningen gir mulighet for oppreisning når sabotasje innebærer falske påstander som skader ditt omdømme, selv om det kan være komplisert å bevise skade i AI-sammenheng. De fleste større plattformer har nå rapporteringsmekanismer spesielt for AI-relatert misbruk, inkludert datapåvirkning, falske anmeldelser og desinformasjonskampanjer, selv om håndhevelsen varierer betydelig. Fremvoksende reguleringer som EU AI Act og foreslått amerikansk lovgivning begynner å etablere ansvarsrammer for AI-systemer som forsterker feilinformasjon, og åpner dermed nye muligheter for rettslige skritt. Selskaper bør dokumentere alle sabotasjeangrep grundig, da denne dokumentasjonen blir avgjørende både i rettsprosesser og klager til plattformer. Det blir stadig viktigere å rådføre seg med juridisk rådgiver med erfaring innen AI og digitalt omdømme for å utvikle responsstrategier som følger gjeldende regler.

Landskapet for konkurrerende AI-sabotasje vil fortsette å utvikle seg etter hvert som både angripere og forsvarere utvikler mer sofistikerte teknikker. AI-genererte falske anmeldelser ved hjelp av store språkmodeller vil bli stadig vanskeligere å skille fra autentiske tilbakemeldinger, og krever mer avanserte deteksjonssystemer. Blokkjede-verifisering og desentraliserte troverdighetsmekanismer vokser frem som mulige løsninger for å bekrefte kildeautentisitet før AI-systemer inkorporerer data i treningssett. Plattformleverandører investerer tungt i bedre forsvar, inkludert bedre datavalidering, kildeverifisering og algoritmer for å oppdage forgiftning, selv om slike tiltak alltid vil ligge litt etter nye angrepsmetoder. Fellesskapsbaserte verifiseringssystemer, hvor brukere og eksperter flagger mistenkelig innhold, kan bli standardpraksis og skape en folkeforsvart mot sabotasje. Det konkurransefortrinnet vil i økende grad tilfalle selskaper som ligger i forkant av nye trusler gjennom kontinuerlig overvåkning, raske beredskapsprotokoller og investering i AI-kompetanse på tvers av teamene. Organisasjoner som behandler AI-overvåkning som en kjernekomponent i merkevarebeskyttelsen i dag, vil være best posisjonert til å forsvare seg mot morgendagens mer avanserte angrep.

Tradisjonell negativ SEO retter seg mot søkemotorrangeringer gjennom lenkemanipulasjon og innholdsskraping. Konkurrerende AI-sabotasje retter seg mot AI-treningsdata og modellatferd, og forgifter kildene AI-systemene siterer i svar. AI-systemer er mer sårbare fordi de siterer kilder direkte og stoler mer på treningsdata enn tradisjonelle søkealgoritmer.

Overvåk hvordan AI-plattformer beskriver din merkevare ukentlig ved hjelp av verktøy som AmICited.com. Se etter plutselige endringer i omtale, falske påstander i AI-svar, koordinerte negative anmeldelser eller spredning av feilinformasjon på tvers av plattformer. Tidlig oppdagelse innen de første 48 timene er avgjørende for å begrense skade.

Dokumenter alt umiddelbart med skjermbilder og tidsstempler. Rapporter til berørte plattformer (OpenAI, Google, Anthropic). Forsterk korrekt informasjon gjennom egne kanaler. Kontakt juridisk rådgiver dersom ærekrenkelse eller økonomisk skade har oppstått. Implementer overvåkningssystemer for å fange opp fremtidige angrep tidlig.

Forskning viser at angripere kun trenger 250 ondsinnede dokumenter eller 7-8 % av et datasett for å forgifte AI-modeller på en meningsfull måte. Denne lave terskelen gjør AI-systemer spesielt sårbare sammenlignet med tradisjonelle søkemotorer, som har mer sofistikerte mekanismer for å oppdage spam.

Dagens AI-plattformer har begrensede deteksjonsevner og stoler stort sett på brukerrapporter og periodisk opplæring med rene data. Imidlertid implementerer plattformer bedre verifikasjonssystemer, avviksdeteksjon og tilgangskontroller. Ansvaret for tidlig oppdagelse hviler ofte på merkevaren selv.

Bygg et sterkt og autentisk omdømme med innhold av høy kvalitet, overvåk AI-søkeresultater regelmessig, sikre din merkevaretilstedeværelse i kataloger, implementer sanntidsovervåkning og responder raskt på angrep. Forebygging gjennom omdømmebygging er mer effektivt enn utbedring etter sabotasje.

AmICited.com overvåker hvordan AI-plattformer (ChatGPT, Perplexity, Google AI Overviews) refererer til din merkevare, og sporer endringer i omtale og siteringsmønstre. Varsler i sanntid gir beskjed om plutselige endringer i AI-omtale, slik at du kan reagere raskt på mulige sabotasjeforsøk.

Du kan gå til sak for ærekrenkelse, sende DMCA-anmodninger om fjerning av falskt innhold, rapportere til plattformer for brudd på brukervilkår, og potensielt kreve erstatning ved økonomisk skade. Dokumentasjon av sabotasje er avgjørende. Rådfør deg med juridisk ekspertise innen digitale rettigheter og immaterielle verdier.

Beskytt din merkevare mot konkurrerende AI-sabotasje med sanntidsovervåkning på tvers av ChatGPT, Perplexity og Google AI Overviews. Oppdag trusler før de skader ditt omdømme.

Lær hvordan du kan benchmarke AI-synligheten din mot konkurrenter. Spor siteringer, andel av stemme og konkurranseposisjonering på ChatGPT, Perplexity og Google...

Lær hvordan du sporer omtale av konkurrenter i AI-søkemotorer. Overvåk ChatGPT, Perplexity, Claude og Google AI-synlighet med andel av stemme-målinger.

Lær hvordan du overvåker når konkurrenter dukker opp i ChatGPT, Perplexity, Claude og andre AI-søkemotorer. Oppdag verktøy og strategier for å spore AI-synlighe...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.