Bør du blokkere eller tillate AI-crawlere? Beslutningsrammeverk

Lær hvordan du tar strategiske beslutninger om blokkering av AI-crawlere. Vurder innholdstype, trafikkilder, inntektsmodeller og konkurranseposisjon med vårt om...

En strategisk tilnærming som lar nettstedeiere selektivt tillate visse AI-crawlere samtidig som de blokkerer andre, basert på forretningsmål, innholdslisensavtaler og verdivurdering. I stedet for å implementere generelle retningslinjer, vurderer differensiell tilgang hver crawler individuelt for å avgjøre om den gir trafikk, respekterer lisensvilkår eller samsvarer med inntektsmål. Utgivere bruker verktøy som robots.txt, HTTP-headere og plattformspesifikke kontroller for å implementere detaljerte tilgangspolicyer. Denne metoden balanserer innovasjonsmuligheter med innholdsbeskyttelse og rettferdig kompensasjon.

En strategisk tilnærming som lar nettstedeiere selektivt tillate visse AI-crawlere samtidig som de blokkerer andre, basert på forretningsmål, innholdslisensavtaler og verdivurdering. I stedet for å implementere generelle retningslinjer, vurderer differensiell tilgang hver crawler individuelt for å avgjøre om den gir trafikk, respekterer lisensvilkår eller samsvarer med inntektsmål. Utgivere bruker verktøy som robots.txt, HTTP-headere og plattformspesifikke kontroller for å implementere detaljerte tilgangspolicyer. Denne metoden balanserer innovasjonsmuligheter med innholdsbeskyttelse og rettferdig kompensasjon.

Eksplosjonen av AI-crawlere har fundamentalt endret det tiår gamle forholdet mellom nettstedeiere og roboter. I mange år fungerte internett med en enkel utveksling: søkemotorer som Google indekserte innhold og sendte trafikk tilbake til de opprinnelige kildene, noe som skapte et symbiotisk forhold som belønnet kvalitetsinnhold. I dag opererer en ny generasjon AI-crawlere – inkludert GPTBot, ClaudeBot, PerplexityBot og dusinvis av andre – etter andre regler. Disse robotene skraper innhold ikke for å indeksere det for oppdagelse, men for å mate det direkte inn i AI-modeller som genererer svar uten å sende brukere tilbake til den opprinnelige kilden. Effekten er tydelig: ifølge Cloudflare-data har OpenAI sin GPTBot et crawl-til-henvisningsforhold på omtrent 1 700:1, mens Anthropics ClaudeBot når 73 000:1, noe som betyr at for hver besøkende som sendes tilbake til en utgivers nettsted, blir tusenvis av sider crawlet for treningsdata. Denne ødelagte utvekslingen har tvunget utgivere til å revurdere sine crawler-tilgangspolicyer, og bevege seg bort fra det binære valget “tillat alle” eller “blokker alle” mot en mer nyansert strategi: differensiell crawler-tilgang. I stedet for generelle retningslinjer vurderer nå kloke utgivere hver crawler individuelt, og stiller kritiske spørsmål om verdi, lisensiering og samsvar med forretningsmål.

Å forstå de ulike typene AI-crawlere er avgjørende for å implementere en effektiv differensiell tilgangsstrategi, ettersom hver har ulike formål med varierende innvirkning på virksomheten din. AI-crawlere faller i tre hovedkategorier: treningscrawlere (GPTBot, ClaudeBot, anthropic-ai, CCBot, Bytespider) som samler innhold for modelltrening; søkemotor-crawlere (OAI-SearchBot, PerplexityBot, Google-Extended) som indekserer innhold for AI-drevne søkeresultater; og brukerutløste agenter (ChatGPT-User, Claude-Web, Perplexity-User) som kun henter innhold når brukere eksplisitt ber om det. Verdiforslaget varierer dramatisk mellom disse kategoriene. Treningscrawlere genererer vanligvis minimal trafikk tilbake til nettstedet ditt—de trekker ut verdi uten gjensidig fordel—og er derfor ofte gode kandidater for blokkering. Søkemotor-crawlere derimot, kan gi betydelig henvisningstrafikk og abonnements-konverteringer, på lik linje med tradisjonelle søkemotorer. Brukerutløste agenter befinner seg midt imellom, og aktiveres bare når brukere aktivt benytter AI-systemer. The Atlantic, en av de største digitale utgiverne, implementerte et sofistikert poengkort for å vurdere crawlere, og sporet både trafikkvolum og abonnements-konverteringer for hver bot. Deres analyse viste at mens noen crawlere gir reell verdi, genererer andre tilnærmet null trafikk samtidig som de bruker betydelig båndbredde. Denne datadrevne tilnærmingen gjør det mulig for utgivere å ta informerte beslutninger fremfor å basere seg på antakelser.

| Crawler-type | Eksempler | Hovedformål | Typisk trafikkverdi | Anbefalt tilgang |

|---|---|---|---|---|

| Trening | GPTBot, ClaudeBot, anthropic-ai, CCBot, Bytespider | Modelltreningsdatasett | Svært lav (1 700:1 til 73 000:1 forhold) | Ofte blokkert |

| Søk | OAI-SearchBot, PerplexityBot, Google-Extended | AI-søkeindeksering | Middels til høy | Ofte tillatt |

| Brukerutløst | ChatGPT-User, Claude-Web, Perplexity-User | Direkte brukerforespørsler | Variabel | Vurderes fra sak til sak |

Å implementere differensiell crawler-tilgang krever en kombinasjon av tekniske verktøy og strategiske beslutninger, med flere metoder tilgjengelig avhengig av tekniske evner og forretningsbehov. Det mest grunnleggende verktøyet er robots.txt, en enkel tekstfil i rotmappen på nettstedet ditt som kommuniserer crawler-tilgangspreferanser via User-agent-direktiver. Selv om robots.txt er frivillig og kun 40–60 % av AI-roboter respekterer den, er det fortsatt første forsvarslinje og gratis å implementere. For utgivere som ønsker sterkere håndheving, lager og oppdaterer Cloudflares administrerte robots.txt crawler-direktiver automatisk, legger dem til i din eksisterende fil og eliminerer behovet for manuell vedlikehold. Utover robots.txt finnes det flere håndhevingsmekanismer som gir ytterligere kontroll:

Den mest effektive tilnærmingen kombinerer flere lag: robots.txt for etterlevelse, WAF-regler for håndheving og overvåkingsverktøy for å spore effektivitet og identifisere nye trusler.

Å implementere differensiell crawler-tilgang krever mer enn bare teknisk gjennomføring—det handler også om å utvikle en sammenhengende forretningsstrategi i tråd med inntektsmodellen og den konkurransemessige posisjonen din. The Atlantics tilnærming gir et praktisk rammeverk: de vurderer hver crawler basert på to hovedparametre—trafikkvolum og abonnements-konverteringer—og spør om crawleren genererer tilstrekkelig verdi til å rettferdiggjøre tilgang til innholdet. For en utgiver med 80 dollar i årlig abonnementsverdi representerer en crawler som gir 1 000 abonnenter 80 000 dollar i årlige inntekter, noe som fundamentalt endrer tilgangsbeslutningen. Men trafikk- og abonnements-metrikker er bare én del av regnestykket. Utgivere må også vurdere:

De mest strategiske utgiverne implementerer gradert tilgang: tillater søkemotor-crawlere som gir trafikk, blokkerer treningscrawlere som ikke gjør det, og forhandler lisensavtaler med de mest verdifulle AI-selskapene. Denne tilnærmingen maksimerer både synlighet og inntekt, samtidig som intellektuell eiendom beskyttes.

Selv om differensiell crawler-tilgang gir betydelige fordeler, er virkeligheten mer kompleks enn teorien, med flere grunnleggende utfordringer som begrenser effektiviteten og krever kontinuerlig oppfølging. Den mest kritiske begrensningen er at robots.txt er frivillig—crawlere som respekterer den gjør det av eget valg, ikke av plikt. Forskning viser at robots.txt stopper bare 40–60 % av AI-roboter, og ytterligere 30–40 % fanges ved blokkering av user-agent, mens 10–30 % av crawlerne opererer uten restriksjoner. Noen AI-selskaper og ondsinnede aktører ignorerer bevisst robots.txt-direktiver, og vurderer tilgang til innhold som mer verdifullt enn etterlevelse. I tillegg utvikles crawler-unndragelsesteknikker stadig: avanserte roboter forfalsker user agents for å fremstå som legitime nettlesere, bruker distribuerte IP-adresser for å unngå oppdagelse og benytter headless-browsere som etterligner menneskelig adferd. Google-Extended-dilemmaet eksemplifiserer kompleksiteten: blokkering av Google-Extended forhindrer at innholdet ditt trenes opp av Gemini AI, men Google AI Overviews (som vises i søkeresultater) bruker vanlige Googlebot-regler, noe som betyr at du ikke kan velge bort AI Overviews uten å ofre søkesynlighet. Overvåking og håndhevelse krever også betydelige ressurser—det å spore nye crawlere, oppdatere policyer og validere effektivitet krever kontinuerlig oppmerksomhet. Til slutt er det juridiske landskapet fortsatt usikkert: selv om opphavsrettsloven teoretisk beskytter innhold, er håndhevelse mot AI-selskaper kostbart og utfallet uforutsigbart, og utgiverne blir stående igjen med teknisk kontroll uten juridisk sikkerhet.

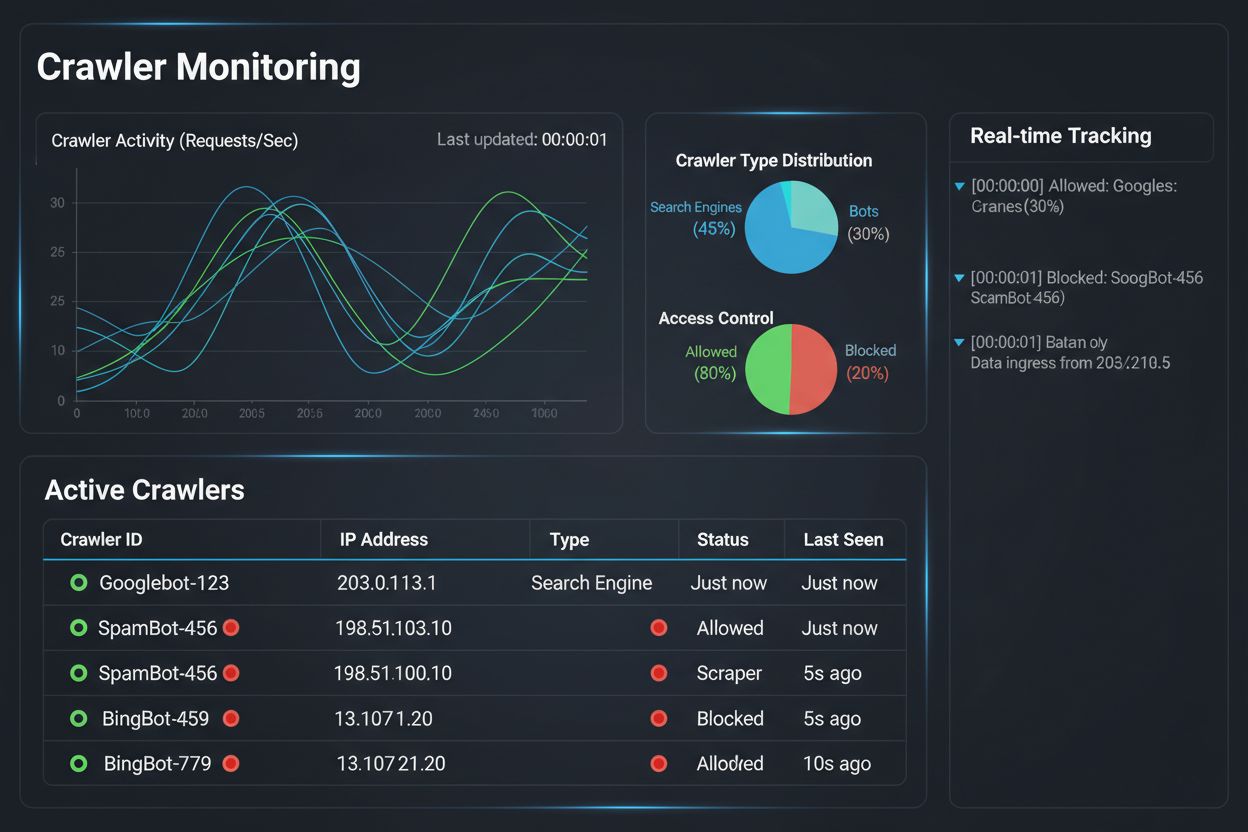

Å implementere en differensiell crawler-tilgangsstrategi er bare halve jobben; den andre halvdelen er å forstå den faktiske effekten av policyene dine gjennom omfattende overvåking og måling. Det er her AmICited.com blir essensiell i din crawler-styringsstrategi. AmICited spesialiserer seg på å overvåke hvordan AI-systemer refererer og siterer merkevaren din på tvers av GPT-er, Perplexity, Google AI Overviews og andre AI-plattformer—og gir innsikt i hvilke crawlere som faktisk bruker innholdet ditt og hvordan det vises i AI-genererte svar. I stedet for å stole på serverlogger og gjetting, viser AmICiteds overvåkningspanel deg nøyaktig hvilke AI-systemer som har fått tilgang til innholdet ditt, hvor ofte, og viktigst av alt, om innholdet ditt blir sitert eller bare absorbert i treningsdata uten attribusjon. Denne informasjonen gir direkte grunnlag for dine differensielle tilgangsbeslutninger: hvis en crawler får tilgang til innholdet ditt men aldri siterer det i AI-svar, blir blokkering en klar forretningsbeslutning. AmICited muliggjør også konkurransesammenligning, og viser hvordan synligheten til innholdet ditt i AI-systemer står seg mot konkurrenter, slik at du kan vurdere om tilgangspolicyene dine er for restriktive eller for åpne. Plattformens sanntidsvarsler gir beskjed når nye AI-systemer begynner å referere til innholdet ditt, slik at du raskt kan justere policyene. Ved å kombinere AmICiteds overvåkingsmuligheter med Cloudflares håndhevingsverktøy får utgivere full oversikt og kontroll: de kan se hvilke crawlere som får tilgang til innholdet, måle forretningspåvirkningen og justere policyene deretter. Denne datadrevne tilnærmingen gjør crawler-styring til en strategisk forretningsfunksjon, ikke bare et teknisk punkt på sjekklisten.

Landskapet for differensiell crawler-tilgang utvikler seg raskt, med nye standarder og forretningsmodeller som endrer hvordan utgivere og AI-selskaper samhandler rundt innhold. IETF AI-preferanseforslaget representerer en viktig utvikling, og etablerer standardiserte måter for nettsteder å kommunisere sine preferanser for AI-trening, inferens og søk. I stedet for å stole på robots.txt—en 30 år gammel standard laget for søkemotorer—gir dette nye rammeverket eksplisitt, detaljert kontroll over hvordan AI-systemer kan bruke innholdet. Samtidig får tillatelsesbaserte forretningsmodeller økt fotfeste, der Cloudflares Pay Per Crawl-initiativ baner vei for at AI-selskaper betaler utgivere for tilgang til innhold, og gjør crawlere om til inntektskilder. Dette skiftet fra blokkering til lisensiering representerer en grunnleggende endring i internettøkonomien: i stedet for å kjempe om tilgang, forhandler utgivere og AI-selskaper om rettferdig kompensasjon. Crawler-autentisering og verifiseringsstandarder er også i utvikling, med kryptografiske verifiseringsmetoder som lar utgivere bekrefte crawler-identitet og forhindre forfalskede forespørsler. Fremover kan vi forvente økte regulatoriske rammer som adresserer AI-treningsdata, og potensielt krever eksplisitt samtykke og kompensasjon for innholdsbruk. Sammenfallet av disse trendene—tekniske standarder, lisensieringsmodeller, autentiseringsmekanismer og regulatorisk press—tyder på at differensiell crawler-tilgang vil utvikle seg fra en defensiv strategi til en sofistikert forretningsfunksjon der utgivere aktivt styrer, overvåker og tjener penger på AI-crawler-tilgang. Utgivere som implementerer omfattende overvåking og strategiske policyer i dag, vil være best posisjonert for å utnytte disse nye mulighetene.

Å blokkere alle crawlere fjerner innholdet ditt fullstendig fra AI-systemer, og eliminerer både risiko og muligheter. Differensiell tilgang lar deg vurdere hver crawler individuelt, og blokkerer de som ikke gir verdi, samtidig som du tillater de som gir trafikk eller representerer lisensieringsmuligheter. Denne nyanserte tilnærmingen maksimerer både synlighet og inntekter, samtidig som intellektuell eiendom beskyttes.

Du kan overvåke crawler-aktivitet gjennom serverlogger, Cloudflares analysepanel eller spesialiserte overvåkingsverktøy som AmICited.com. AmICited sporer spesielt hvilke AI-systemer som får tilgang til innholdet ditt, og hvordan merkevaren din vises i AI-genererte svar, og gir forretningsinnsikt utover tekniske logger.

Nei. Å blokkere AI-treningscrawlere som GPTBot, ClaudeBot og CCBot påvirker ikke Google- eller Bing-søkerangeringen din. Tradisjonelle søkemotorer bruker andre crawlere (Googlebot, Bingbot) som opererer uavhengig. Blokker kun disse hvis du ønsker å forsvinne helt fra søkeresultatene.

Ja, dette er den mest strategiske tilnærmingen for mange utgivere. Du kan tillate søkefokuserte crawlere som OAI-SearchBot og PerplexityBot (som gir trafikk), mens du blokkerer treningscrawlere som GPTBot og ClaudeBot (som vanligvis ikke gjør det). Dette opprettholder synligheten i AI-søkeresultater, samtidig som innhold beskyttes mot å bli absorbert i treningsdatasett.

Selv om de største crawlerne fra OpenAI, Anthropic og Google respekterer robots.txt, ignorerer noen roboter den bevisst. Hvis en crawler ikke respekterer robots.txt, trenger du ekstra håndheving, som WAF-regler, IP-blokkering eller Cloudflares botstyringsfunksjoner. Dette er grunnen til at overvåkingsverktøy som AmICited er essensielle—de viser deg hvilke crawlere som faktisk respekterer retningslinjene dine.

Gjennomgå retningslinjene dine minst kvartalsvis, da AI-selskaper jevnlig introduserer nye crawlere. Anthropic slo sammen sine 'anthropic-ai'- og 'Claude-Web'-roboter til 'ClaudeBot', noe som ga den nye boten midlertidig ubegrenset tilgang til nettsteder som ikke hadde oppdatert reglene sine. Regelmessig overvåking med verktøy som AmICited hjelper deg å ligge i forkant av endringene.

Googlebot er Googles søkecrawler som indekserer innhold for søkeresultater. Google-Extended er et kontrolltoken som spesifikt styrer om innholdet ditt brukes til Gemini AI-trening. Du kan blokkere Google-Extended uten å påvirke søkerangering, men vær oppmerksom på at Google AI Overviews (som vises i søkeresultater) bruker vanlige Googlebot-regler, så du kan ikke velge bort AI Overviews uten å ofre søkesynlighet.

Ja, nye lisensieringsmodeller som Cloudflares Pay Per Crawl gjør det mulig for utgivere å ta betalt fra AI-selskaper for tilgang til innholdet. Dette gjør crawlere om til inntektskilder i stedet for trusler. Dette krever imidlertid forhandlinger med AI-selskaper og kan innebære juridiske avtaler. AmICited's overvåking hjelper deg å identifisere hvilke crawlere som representerer de mest verdifulle lisensieringsmulighetene.

Følg med på hvilke AI-systemer som får tilgang til innholdet ditt og hvordan merkevaren din vises i AI-genererte svar. Få sanntidsinnsikt i crawler-adferd og målrett forretningspåvirkningen av dine differensielle tilgangspolicyer.

Lær hvordan du tar strategiske beslutninger om blokkering av AI-crawlere. Vurder innholdstype, trafikkilder, inntektsmodeller og konkurranseposisjon med vårt om...

Fullstendig referanseguide for AI-crawlere og roboter. Identifiser GPTBot, ClaudeBot, Google-Extended og 20+ andre AI-crawlere med brukeragenter, crawl-frekvens...

Lær hvordan du bruker robots.txt for å kontrollere hvilke AI-roboter som får tilgang til innholdet ditt. Komplett guide til blokkering av GPTBot, ClaudeBot og a...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.