Finjustering av AI-modell

Lær hvordan finjustering av AI-modeller tilpasser forhåndstrente modeller for spesifikke bransje- og merkevarerelaterte oppgaver, forbedrer nøyaktigheten og red...

Finjustering er prosessen med å tilpasse en forhåndstrent AI-modell til å utføre spesifikke oppgaver ved å trene den på et mindre, domenespesifikt datasett. Denne teknikken justerer modellens parametere for å utmerke seg i spesialiserte bruksområder, samtidig som den utnytter den brede kunnskapen som allerede er lært under den innledende forhåndstreningen, noe som gjør det mer effektivt og kostnadseffektivt enn å trene fra bunnen av.

Finjustering er prosessen med å tilpasse en forhåndstrent AI-modell til å utføre spesifikke oppgaver ved å trene den på et mindre, domenespesifikt datasett. Denne teknikken justerer modellens parametere for å utmerke seg i spesialiserte bruksområder, samtidig som den utnytter den brede kunnskapen som allerede er lært under den innledende forhåndstreningen, noe som gjør det mer effektivt og kostnadseffektivt enn å trene fra bunnen av.

Finjustering er prosessen med å tilpasse en forhåndstrent AI-modell til å utføre spesifikke oppgaver ved å trene den på et mindre, domenespesifikt datasett. I stedet for å bygge en AI-modell fra bunnen av—noe som krever enorme beregningsressurser og store mengder merkede data—utnytter finjustering den brede kunnskapen en modell allerede har tilegnet seg under innledende forhåndstrening og forfiner den for spesialiserte applikasjoner. Denne teknikken har blitt grunnleggende for moderne dyp læring og generativ AI, og gjør det mulig for organisasjoner å tilpasse kraftige modeller som store språkmodeller (LLM-er) til deres unike forretningsbehov. Finjustering representerer en praktisk implementering av overføringslæring, hvor kunnskap oppnådd fra én oppgave forbedrer ytelsen på en relatert oppgave. Intuisjonen er enkel: det er langt enklere og billigere å foredle ferdighetene til en modell som allerede forstår generelle mønstre enn å trene en ny modell fra bunnen av for et spesifikt formål.

Finjustering oppstod som en avgjørende teknikk etter hvert som dyp læringsmodeller vokste eksponentielt i størrelse og kompleksitet. På begynnelsen av 2010-tallet oppdaget forskere at forhåndstrening av modeller på enorme datasett, og deretter tilpasse dem til spesifikke oppgaver, dramatisk forbedret ytelsen samtidig som treningstiden ble redusert. Denne tilnærmingen fikk gjennomslag med fremveksten av transformermodeller og BERT (Bidirectional Encoder Representations from Transformers), som viste at forhåndstrente modeller effektivt kunne finjusteres for en rekke underliggende oppgaver. Eksplosjonen av generativ AI og store språkmodeller som GPT-3, GPT-4 og Claude har gjort finjustering enda mer relevant, ettersom organisasjoner verden over ønsker å tilpasse disse kraftige modellene til domenespesifikke applikasjoner. Ifølge nylige data om bedriftsadopsjon bruker 51 % av organisasjoner som benytter generativ AI retrieval-augmented generation (RAG), mens finjustering fortsatt er en kritisk komplementær tilnærming for spesialiserte bruksområder. Utviklingen av parameter-effektive finjusteringsmetoder (PEFT) som LoRA (Low-Rank Adaptation) har demokratisert tilgangen til finjustering ved å redusere beregningskravene med opptil 90 %, noe som gjør teknikken tilgjengelig for organisasjoner uten omfattende GPU-infrastruktur.

Finjustering foregår gjennom en veldefinert matematisk og beregningsmessig prosess som justerer modellens parametere (vekter og bias) for å optimalisere ytelsen på nye oppgaver. Under forhåndstreningen lærer en modell generelle mønstre fra enorme datasett gjennom gradient descent og backpropagation, og etablerer et bredt kunnskapsgrunnlag. Finjustering starter med disse forhåndstrente vektene som utgangspunkt og fortsetter treningsprosessen på et mindre, oppgavespesifikt datasett. Hovedforskjellen ligger i bruken av en betydelig mindre læringsrate—størrelsen på vektendringene i hver treningsiterasjon—for å unngå katastrofal glemsel, der modellen mister viktig generell kunnskap. Finjusteringsprosessen innebærer foroverpasseringer der modellen gir forutsigelser på treningseksempler, tapsberegning som måler forutsigelsesfeil, og bakoverpasseringer der gradienter beregnes og vekter justeres. Denne iterative prosessen gjentas gjennom flere epoker (fullstendige gjennomganger av treningsdataene) til modellen oppnår tilfredsstillende ytelse på valideringsdata. Den matematiske elegansen i finjustering ligger i effektiviteten: ved å starte med forhåndstrente vekter som allerede fanger opp nyttige mønstre, konvergerer modellen til gode løsninger mye raskere enn ved opplæring fra bunnen av, og krever ofte 10-100 ganger mindre data og beregningsressurser.

| Aspekt | Finjustering | Retrieval-Augmented Generation (RAG) | Prompt Engineering | Full modelltrening |

|---|---|---|---|---|

| Kunnskapskilde | Innebygd i modellparametere | Ekstern database/kunnskapsbase | Brukergitt kontekst i prompt | Læres fra bunnen av fra data |

| Datakvalitet | Statisk til ny trening | Sanntid/dynamisk | Aktuell kun i prompt | Frosset ved treningstidspunkt |

| Beregningkostnad | Høy oppstart (trening), lav inferens | Lav oppstart, moderat inferens | Minimal | Ekstremt høy |

| Implementeringskompleksitet | Moderat-høy (krever ML-ekspertise) | Moderat (krever infrastruktur) | Lav (ingen trening nødvendig) | Svært høy |

| Tilpasningsdybde | Dyp (modelladferd endres) | Grunn (kun innhenting) | Overflatisk (på prompt-nivå) | Komplett (fra grunnen av) |

| Oppdateringsfrekvens | Uker/måneder (krever ny trening) | Sanntid (oppdater database) | Per spørring (manuelt) | Upraktisk for hyppige oppdateringer |

| Utdata-konsistens | Høy (lærte mønstre) | Variabel (avhengig av innhenting) | Moderat (prompt-avhengig) | Avhenger av treningsdata |

| Kildeattribusjon | Ingen (implisitt i vekter) | Full (dokumenter sitert) | Delvis (prompt synlig) | Ingen |

| Skalerbarhet | Flere modeller trengs per domene | Én modell, flere datakilder | Én modell, flere prompt | Upraktisk i stor skala |

| Best for | Spesialiserte oppgaver, konsistent formatering | Aktuell informasjon, åpenhet | Rask iterasjon, enkle oppgaver | Nye domener, unike krav |

Finjustering følger en strukturert arbeidsflyt som forvandler en generell modell til en spesialisert ekspert. Prosessen starter med datapreparering, der organisasjoner samler og kuraterer eksempler relevante for deres spesifikke oppgave. For en juridisk AI-assistent kan dette innebære tusenvis av juridiske dokumenter med relevante spørsmål og svar. For et medisinsk diagnostikkverktøy kan det være kliniske saker med diagnoser. Kvaliteten på dette datasettet er avgjørende—forskning viser konsekvent at et mindre sett med eksempler av høy kvalitet gir bedre resultater enn et større sett med støyende eller inkonsistente data. Når dataene er klare, deles de opp i trenings-, validerings- og testsett for å sikre at modellen generaliserer godt til ukjente eksempler.

Den faktiske finjusteringsprosessen starter med å laste den forhåndstrente modellen og dens vekter i minnet. Modellarkitekturen forblir uendret; kun vektene justeres. Under hver treningsiterasjon prosesserer modellen et parti treningsdata, gir forutsigelser og sammenligner dem med riktige svar ved hjelp av en tap-funksjon som kvantifiserer forutsigelsesfeil. Backpropagation beregner deretter gradienter—matematiske mål for hvordan hver vekt bør endres for å redusere tapet. En optimaliseringsalgoritme som Adam eller SGD (Stochastic Gradient Descent) bruker disse gradientene til å oppdatere vektene, typisk med en læringsrate som er 10-100 ganger lavere enn ved forhåndstrening for å bevare generell kunnskap. Denne prosessen gjentas gjennom flere epoker, med modellen som gradvis spesialiserer seg på den oppgavespesifikke dataen. Gjennom hele treningen evalueres modellen på valideringssettet for å overvåke ytelsen og oppdage overtilpasning—når modellen memorerer treningsdata fremfor å lære generaliserbare mønstre. Når valideringsytelsen flater ut eller begynner å falle, stoppes treningen for å forhindre overtilpasning.

Full finjustering oppdaterer alle modellparametere, noe som kan være svært ressurskrevende for store modeller. En modell med milliarder av parametere krever lagring av gradienter for hver parameter under backpropagation, og bruker enorme mengder GPU-minne. For en 7-milliarders parameter-modell kan full finjustering kreve over 100 GB GPU-minne, noe som gjør det utilgjengelig for de fleste organisasjoner. Likevel gir full finjustering ofte best ytelse siden alle modellvekter kan tilpasses den nye oppgaven.

Parameter-effektive finjusteringsmetoder (PEFT) løser denne begrensningen ved kun å oppdatere et lite utvalg parametere. LoRA (Low-Rank Adaptation), en av de mest populære PEFT-teknikkene, legger til små trenbare matriser i spesifikke lag mens de opprinnelige vektene holdes frosset. Disse lavrangsmatrisene fanger opp oppgavespesifikke tilpasninger uten å endre basismodellen. Forskning viser at LoRA oppnår ytelse sammenlignbar med full finjustering samtidig som man bruker 90 % mindre minne og trener 3-5 ganger raskere. QLoRA tar dette enda lenger ved å kvantisere basismodellen til 4-bits presisjon, noe som reduserer minnekravet med ytterligere 75 %. Andre PEFT-tilnærminger inkluderer adaptere (små oppgavespesifikke lag satt inn i modellen), prompt-tuning (lærer “myke” prompts i stedet for modellvekter), og BitFit (oppdaterer kun bias-termer). Disse metodene har demokratisert finjustering og gjør det mulig for organisasjoner uten massive GPU-klynger å tilpasse toppmoderne modeller.

Finjustering av LLM-er innebærer unike hensyn ulikt finjustering av datavisjon eller tradisjonelle NLP-modeller. Forhåndstrente LLM-er som GPT-3 eller Llama trenes gjennom selv-overvåket læring på enorme tekstsamlinger, og lærer å forutsi neste ord i sekvenser. Selv om denne forhåndstreningen gir kraftige tekstgenereringsevner, lærer den ikke modellen å følge brukerens instruksjoner eller forstå hensikt. En forhåndstrent LLM spurt “lær meg å skrive en CV” kan simpelthen fullføre setningen med “ved å bruke Microsoft Word” i stedet for å gi faktisk veiledning i CV-skriving.

Instruksjonsfinjustering løser denne begrensningen ved å finjustere på datasett med (instruksjon, respons)-par som dekker ulike oppgaver. Disse datasettene lærer modellen å gjenkjenne ulike instruksjonstyper og svare hensiktsmessig. En instruksjonsfinjustert modell lærer at prompt som starter med “lær meg å” skal få trinnvis veiledning, ikke setningsfullføringer. Denne spesialiserte finjusteringstilnærmingen har vist seg avgjørende for å skape praktiske AI-assistenter.

Forsterkningslæring fra menneskelig tilbakemelding (RLHF) representerer en avansert finjusteringsteknikk som supplerer instruksjonsfinjustering. I stedet for å stole utelukkende på merkede eksempler, inkorporerer RLHF menneskelige preferanser for å optimalisere kvaliteter som er vanskelige å spesifisere gjennom diskrete eksempler—som hjelpsomhet, faktanøyaktighet, humor eller empati. Prosessen innebærer å generere flere modellutdata for prompt, la mennesker vurdere kvaliteten, trene en belønningsmodell til å forutsi hvilke utdata mennesker foretrekker, og deretter bruke forsterkningslæring for å optimalisere LLM-en etter dette belønningssignalet. RLHF har vært avgjørende for å tilpasse modeller som ChatGPT til menneskelige verdier og preferanser.

Finjustering har blitt sentralt i bedrifters AI-strategier, og gjør det mulig å implementere tilpassede modeller som reflekterer unike krav og merkevarens stemme. Ifølge Databricks’ 2024 State of AI-rapport, som analyserte data fra over 10 000 organisasjoner, blir bedrifter dramatisk mer effektive i å implementere AI-modeller, med forholdet mellom eksperimentelle og produksjonsmodeller forbedret fra 16:1 til 5:1—en tredobling i effektivitet. Mens RAG-adopsjonen har økt til 51 % blant brukere av generativ AI, forblir finjustering kritisk for spesialiserte applikasjoner hvor konsistent utdataformat, domeneekspertise eller offline-distribusjon er essensielt.

Finanstjenester leder an i AI-adopsjon med høyest GPU-utnyttelse og 88 % vekst i GPU-bruk over seks måneder, mye drevet av finjustering av modeller for svindeldeteksjon, risikovurdering og algoritmisk handel. Helse og livsvitenskap har overraskende vært tidlig ute, med 69 % av Python-biblioteksbruken viet til naturlig språkprosessering, som gjenspeiler finjusteringsapplikasjoner i legemiddeloppdagelse, klinisk forskningsanalyse og medisinsk dokumentasjon. Industri og bil har hatt 148 % årlig vekst i NLP, og bruker finjusterte modeller til kvalitetskontroll, optimalisering av forsyningskjeden og analyse av kundetilbakemeldinger. Disse adopsjonsmønstrene viser at finjustering har gått fra eksperimentelle prosjekter til produksjonssystemer som gir målbar forretningsverdi.

Finjustering gir flere overbevisende fordeler som forklarer dens fortsatte betydning til tross for fremveksten av alternative tilnærminger. Domenespesifikk nøyaktighet er kanskje den viktigste fordelen—en modell finjustert på tusenvis av juridiske dokumenter kan ikke bare juridisk terminologi, men forstår også juridisk resonnement, passende klausulstrukturer og relevante presedenser. Denne dype spesialiseringen gir utdata som matcher ekspertstandarder på måter generiske modeller ikke kan oppnå. Effektivitetsgevinster gjennom finjustering kan være dramatiske; forskning fra Snorkel AI viste at en finjustert liten modell oppnådde GPT-3-kvalitet, men var 1 400 ganger mindre, krevde mindre enn 1 % av treningsetikettene, og kostet 0,1 % så mye å kjøre i produksjon. Denne effektiviteten endrer økonomien ved AI-implementering, og gjør avansert AI tilgjengelig for organisasjoner med begrensede budsjetter.

Tilpasset tone og stilkontroll gjør det mulig for organisasjoner å opprettholde merkevarekonsistens og kommunikasjonsstandarder. En bedrifts-spesifikk chatbot kan finjusteres til å følge retningslinjer for organisasjonens stemme, enten formell og profesjonell for juridiske applikasjoner eller varm og samtalebasert for detaljhandel. Mulighet for offline-distribusjon er en annen viktig fordel—når modellen er finjustert, inneholder den all nødvendig kunnskap i sine parametere og krever ikke ekstern datatilgang, noe som gjør den egnet for mobilapplikasjoner, innebygde systemer og sikre miljøer uten internettforbindelse. Reduserte hallusinasjoner i spesialiserte domener skjer fordi modellen har lært nøyaktige mønstre for det aktuelle domenet under finjustering, og dermed får mindre tendens til å generere plausibel, men feilaktig informasjon.

Til tross for fordelene gir finjustering betydelige utfordringer som organisasjoner må vurdere nøye. Datakrav er en betydelig barriere—finjustering krever hundre til tusenvis av merkede eksempler av høy kvalitet, og å forberede slike datasett innebærer omfattende innsamling, rensing og merking som kan ta uker eller måneder. De beregningsmessige kostnadene forblir høye; full finjustering av store modeller krever kraftige GPU-er eller TPU-er, med treningsrunder som potensielt koster titusenvis av dollar. Selv parameter-effektive metoder krever spesialisert maskinvare og ekspertise som mange organisasjoner mangler.

Katastrofal glemsel er en vedvarende risiko der finjustering fører til at modeller mister generell kunnskap lært under forhåndstrening. En modell finjustert mye på juridiske dokumenter kan være utmerket til kontraktanalyse, men slite med grunnleggende oppgaver den tidligere håndterte godt. Denne innsnevringseffekten krever ofte at man opprettholder flere spesialiserte modeller i stedet for å stole på én allsidig assistent. Vedlikeholdsbyrde øker etter hvert som domenekunnskap utvikler seg—når nye reguleringer trer i kraft, forskning går videre, eller produktfunksjoner endres, må modellen trenes på nytt på oppdaterte data, en prosess som kan ta uker og koste tusenvis av dollar. Denne treningssyklusen kan føre til at modeller blir farlig utdaterte i raskt skiftende felt.

Manglende kildeattribusjon skaper utfordringer for åpenhet og tillit i applikasjoner med høy risiko. Finjusterte modeller genererer svar fra interne parametere i stedet for eksplisitt innhentede dokumenter, noe som gjør det nesten umulig å verifisere hvor spesifikk informasjon stammer fra. I helsevesenet kan leger ikke verifisere hvilke studier som informerte en anbefaling. I juridiske applikasjoner kan advokater ikke kontrollere hvilke saker som påvirket rådene. Denne uklarheten gjør finjusterte modeller uegnet for applikasjoner som krever revisjonsspor eller etterlevelse. Overtilpasningsrisiko forblir betydelig, spesielt med mindre datasett, hvor modeller memorerer spesifikke eksempler i stedet for å lære generaliserbare mønstre, noe som gir dårlig ytelse på tilfeller som avviker fra treningsdataene.

Finjusteringslandskapet utvikler seg raskt, med flere viktige trender som former fremtiden. Fortsatt utvikling av parameter-effektive metoder lover å gjøre finjustering stadig mer tilgjengelig, med nye teknikker som reduserer beregningskravene ytterligere samtidig som ytelsen opprettholdes eller forbedres. Forskning på few-shot finjustering har som mål å oppnå effektiv spesialisering med minimale merkede data, noe som potensielt reduserer datainnsamlingsbyrden som i dag begrenser finjusteringsadopsjon.

Hybride tilnærminger som kombinerer finjustering med RAG får økt oppslutning ettersom organisasjoner innser at disse teknikkene utfyller hverandre. En modell finjustert for domeneekspertise kan utvides med RAG for tilgang til oppdatert informasjon, og kombinerer styrkene fra begge tilnærmingene. Denne hybride strategien blir stadig vanligere i produksjonssystemer, spesielt i regulerte bransjer hvor både spesialisering og oppdatert informasjon er viktig.

Føderert finjustering er et nytt område hvor modeller finjusteres på distribuert data uten å sentralisere sensitiv informasjon, noe som adresserer personvernhensyn i helse, finans og andre regulerte sektorer. Kontinuerlig læring-tilnærminger som gjør det mulig for modeller å tilpasse seg ny informasjon uten katastrofal glemsel, kan forandre hvordan organisasjoner vedlikeholder finjusterte modeller etter hvert som domener endres. Multimodal finjustering som strekker seg utover tekst til bilder, lyd og video, gjør det mulig for organisasjoner å tilpasse modeller for stadig mer varierte applikasjoner.

Integreringen av finjustering med AI-overvåkingsplattformer som AmICited er en annen viktig trend. Etter hvert som organisasjoner distribuerer finjusterte modeller på tvers av ulike AI-plattformer—including ChatGPT, Claude, Perplexity og Google AI Overviews—blir det avgjørende å spore hvordan disse tilpassede modellene vises i AI-genererte svar for merkevaresynlighet og attribusjon. Denne konvergensen mellom finjusteringsteknologi og AI-overvåkingsinfrastruktur reflekterer modningen av generativ AI fra eksperimentelle prosjekter til produksjonssystemer som krever omfattende oppfølging og måling.

+++

Finjustering er et spesifikt underområde av overføringslæring. Mens overføringslæring generelt refererer til å bruke kunnskap fra én oppgave for å forbedre ytelsen på en annen oppgave, innebærer finjustering spesifikt å ta en forhåndstrent modell og trene den på nytt på et nytt, oppgavespesifikt datasett. Overføringslæring er paraplybegrepet, og finjustering er en implementeringsmetode. Finjustering justerer modellens vekter gjennom veiledet læring på merkede eksempler, mens overføringslæring kan involvere ulike teknikker, inkludert funksjonsuttrekking uten noen ny trening.

Mengden data som kreves avhenger av modellstørrelse og oppgavekompleksitet, men ligger vanligvis fra hundre til tusenvis av merkede eksempler. Mindre, mer fokuserte datasett med eksempler av høy kvalitet presterer ofte bedre enn større datasett med dårlig kvalitet eller inkonsekvent merking. Forskning viser at et mindre datasett av høy kvalitet er mer verdifullt enn et større datasett av lav kvalitet. For parameter-effektive finjusteringsmetoder som LoRA, kan du trenge enda mindre data enn ved full finjustering.

Katastrofal glemsel oppstår når finjustering får en modell til å miste eller destabilisere den generelle kunnskapen den lærte under forhåndstreningen. Dette skjer når læringsraten er for høy eller finjusteringsdatasettet er for ulikt det opprinnelige treningsdatasettet, noe som fører til at modellen overskriver viktige lærte mønstre. For å forhindre dette bruker fagfolk mindre læringsrater under finjustering og benytter teknikker som regularisering for å bevare modellens kjerneegenskaper samtidig som den tilpasses nye oppgaver.

Parameter-effektive finjusteringsmetoder (PEFT) som Low-Rank Adaptation (LoRA) reduserer de beregningsmessige kravene ved kun å oppdatere et lite utvalg av modellens parametere i stedet for alle vektene. LoRA legger til små trenbare matriser i spesifikke lag, mens de opprinnelige vektene holdes frosset, og oppnår lignende ytelse som full finjustering samtidig som man bruker 90 % mindre minne og beregning. Andre PEFT-metoder inkluderer adaptere, prompt-tuning og kvantiseringstilnærminger, noe som gjør finjustering tilgjengelig for organisasjoner uten massive GPU-ressurser.

Finjustering innebygger kunnskap direkte i modellparametrene gjennom trening, mens Retrieval-Augmented Generation (RAG) henter informasjon fra eksterne databaser ved spørring. Finjustering utmerker seg for spesialiserte oppgaver og konsistent utdataformat, men krever betydelige datakrefter og blir utdatert etter hvert som informasjon endres. RAG gir sanntidsinformasjon og enklere oppdateringer, men kan gi mindre spesialiserte utdata. Mange organisasjoner bruker begge tilnærminger sammen for optimale resultater.

Instruksjonsfinjustering er en spesialisert form for finjustering som trener modeller til å følge brukerens instruksjoner bedre og svare på ulike oppgaver. Det bruker datasett med (instruksjon, respons)-par som dekker ulike bruksområder som spørsmål-svar, oppsummering og oversettelse. Standard finjustering optimaliserer vanligvis for én enkelt oppgave, mens instruksjonsfinjustering lærer modellen å håndtere flere instruksjonstyper og følge retninger mer effektivt, noe som er spesielt verdifullt for å skape allsidige assistenter.

Ja, finjusterte modeller kan distribueres på edge-enheter og i offline-miljøer, noe som er en av deres viktigste fordeler sammenlignet med RAG-baserte tilnærminger. Når finjusteringen er fullført, inneholder modellen all nødvendig kunnskap i sine parametere og krever ikke ekstern datatilgang. Dette gjør finjusterte modeller ideelle for mobilapplikasjoner, innebygde systemer, IoT-enheter og sikre miljøer uten internettforbindelse, selv om modellstørrelse og beregningskrav må vurderes for ressursbegrensede enheter.

Begynn å spore hvordan AI-chatbots nevner merkevaren din på tvers av ChatGPT, Perplexity og andre plattformer. Få handlingsrettede innsikter for å forbedre din AI-tilstedeværelse.

Lær hvordan finjustering av AI-modeller tilpasser forhåndstrente modeller for spesifikke bransje- og merkevarerelaterte oppgaver, forbedrer nøyaktigheten og red...

Omfattende definisjon av AI-inferens: prosessen der trente AI-modeller genererer utdata fra inndata. Lær hvordan inferens skiller seg fra trening, optimaliserin...

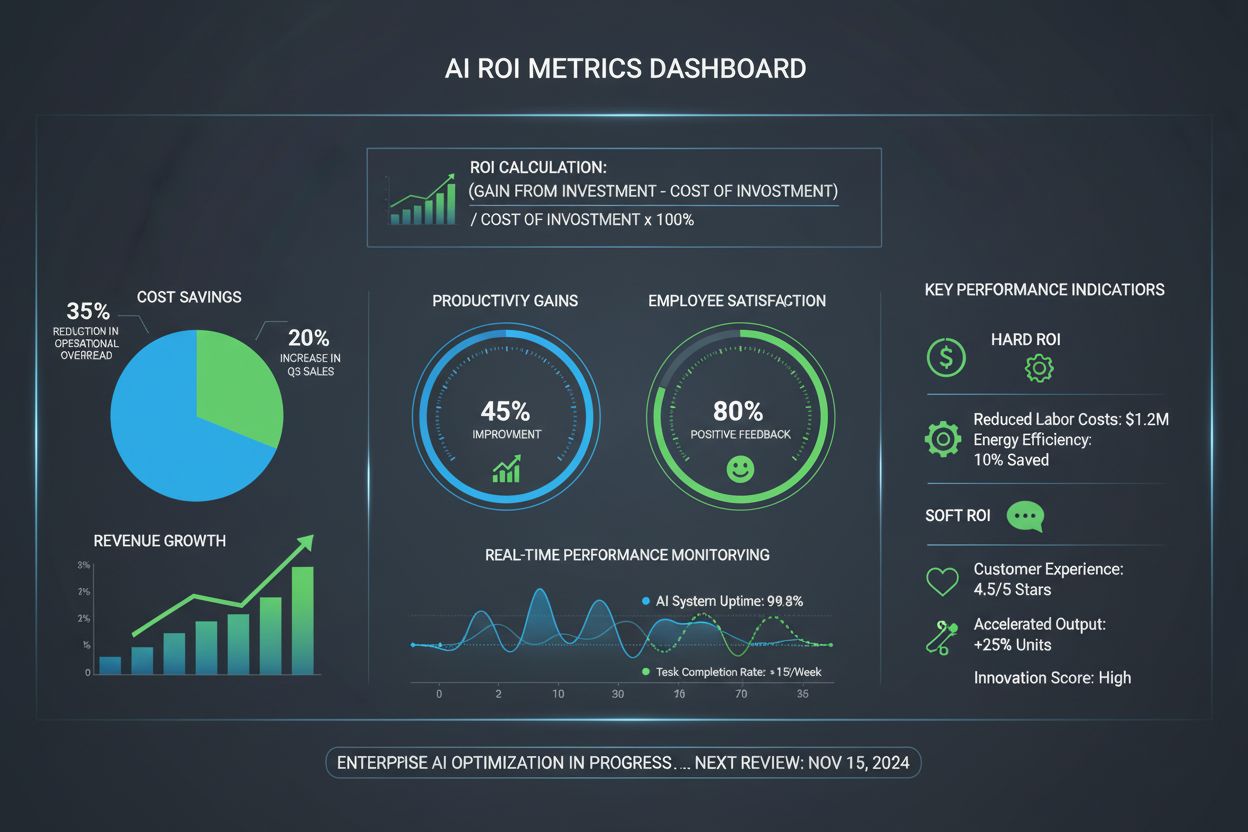

AI ROI måler de økonomiske og operative avkastningene fra AI-investeringer. Lær hvordan du beregner hard og myk ROI, nøkkelmetrikker og strategier for å maksime...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.