Hvordan optimaliserer jeg for Google Gemini? Komplett guide til AI-søkeoptimalisering

Lær hvordan du optimaliserer innholdet ditt for Google Gemini og andre AI-søkemotorer. Mestre Answer Engine Optimization (AEO)-strategier for å øke merkevarens ...

Google Gemini er en familie av multimodale store språkmodeller (LLMs) utviklet av Google DeepMind som behandler og genererer tekst, bilder, lyd og video. Den representerer Googles etterfølger til LaMDA og PaLM 2, designet for å forstå og resonnere på tvers av flere datatyper samtidig, og driver Gemini AI-chatboten og er integrert i Googles økosystem av produkter og tjenester.

Google Gemini er en familie av multimodale store språkmodeller (LLMs) utviklet av Google DeepMind som behandler og genererer tekst, bilder, lyd og video. Den representerer Googles etterfølger til LaMDA og PaLM 2, designet for å forstå og resonnere på tvers av flere datatyper samtidig, og driver Gemini AI-chatboten og er integrert i Googles økosystem av produkter og tjenester.

Google Gemini er en familie av multimodale store språkmodeller (LLMs) utviklet av Google DeepMind, og representerer etterfølgeren til tidligere modeller som LaMDA og PaLM 2. I motsetning til tradisjonelle språkmodeller som kun behandler tekst, er Gemini grunnleggende konstruert for å håndtere flere datamodaliteter samtidig, inkludert tekst, bilder, lyd, video og programvarekode. Modellen driver Gemini AI-chatboten (tidligere kjent som Bard) og blir i økende grad integrert i Googles økosystem av produkter og tjenester. Geminis multimodale arkitektur gjør det mulig å forstå komplekse relasjoner mellom ulike typer informasjon, noe som gjør den i stand til oppgaver som spenner fra bildeanalyse og kodegenerering til sanntidsoversettelse og dokumentforståelse. Begrepet “Gemini” stammer fra latin og betyr “tvillinger”, med referanse til samarbeidet mellom Google DeepMind og Google Brain-teamene, og var også inspirert av NASAs Project Gemini-romfartsprogram.

Googles vei mot å skape Gemini reflekterer mange år med grunnleggende forskning på store språkmodeller og nevrale nettverksarkitekturer. I 2017 introduserte Google-forskere transformer-arkitekturen, et banebrytende nevralt nettverksdesign som ble fundamentet for de fleste moderne LLM-er. Selskapet utviklet deretter Meena (2020), en samtale-AI med 2,6 milliarder parametre, etterfulgt av LaMDA (Language Model for Dialogue Applications) i 2021, som spesialiserte seg på dialogoppgaver. Lanseringen av PaLM (Pathways Language Model) i 2022 brakte forbedrede kode-, flerspråklige og resonnementsegenskaper. Google lanserte deretter Bard tidlig i 2023, opprinnelig drevet av en lettvektsvariant av LaMDA, før den ble oppgradert til PaLM 2 i midten av 2023. Selskapet kunngjorde offisielt Gemini 1.0 i desember 2023, som markerte et betydelig sprang i multimodale evner. I 2024 rebrandet Google Bard til Gemini og lanserte Gemini 1.5, som introduserte et revolusjonerende kontekstvindu på 2 millioner tokens. Nylig introduserte Gemini 2.0 og Gemini 2.5 (lansert i desember 2024) agentiske AI-egenskaper, som lar modellen ta autonome handlinger og resonnere over utvidede kontekster. Denne utviklingen viser Googles satsing på å fremme AI-evner samtidig som de holder fokus på praktiske, virkelige bruksområder.

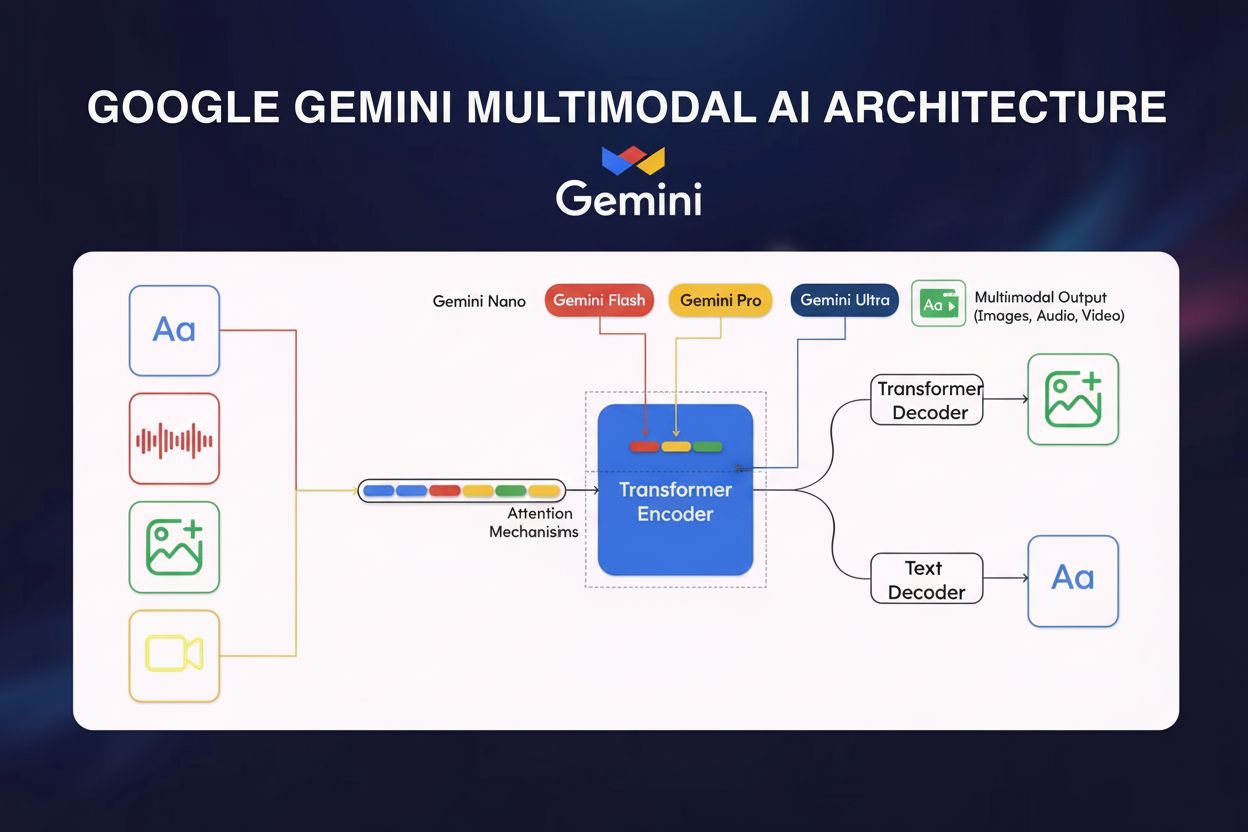

Det tekniske fundamentet til Google Gemini bygger på flere sofistikerte arkitektoniske innovasjoner som skiller den fra konkurrerende modeller. I kjernen benytter Gemini en transformer-basert nevralt nettverksarkitektur optimalisert med Cloud TPU v5p (Tensor Processing Units) for høyytelses trening og inferens. Modellens multimodale koder integrerer visuelle data, tale og tekst gjennom spesialiserte prosesseringsbaner som konvergerer til et samlet representasjonsrom. En sentral innovasjon er kryss-modal oppmerksomhetsmekanisme, som gjør det mulig å etablere meningsfulle forbindelser mellom ulike datatyper—for eksempel å koble visuelle elementer i et bilde til tekstbeskrivelser eller forstå hvordan lydinnhold forholder seg til visuelle sammenhenger. Gemini 1.5 Pro introduserte Mixture of Experts (MoE)-arkitektur, som representerer et paradigmeskifte i modelleffektivitet. I stedet for å aktivere alle nevrale nettverksparametre for hver input, deler MoE modellen i mindre ekspertnettverk, hver spesialisert på spesielle domener eller datatyper. Modellen lærer å selektivt aktivere kun de mest relevante ekspertene basert på inputens egenskaper, noe som dramatisk reduserer ressursbruken uten å gå på kompromiss med ytelse. Denne arkitekturen gjør at Gemini 1.5 Flash kan oppnå sammenlignbar ytelse med Gemini 1.0 Ultra samtidig som den er betydelig mer effektiv, muliggjort gjennom kunstdestillasjon—en maskinlæringsteknikk hvor innsikt fra den større Pro-modellen overføres til den mer kompakte Flash-varianten. Kontekstvinduet—antall tokens en modell kan prosessere samtidig—har økt dramatisk: fra 32 000 tokens i Gemini 1.0 til 1 million tokens i Gemini 1.5 Flash og 2 millioner tokens i Gemini 1.5 Pro, slik at hele bøker, lange videoer eller tusenvis av kodelinjer kan behandles i én enkelt interaksjon.

| Modellvariant | Størrelse/Nivå | Kontekstvindu | Primære bruksområder | Distribusjon | Hovedfordel |

|---|---|---|---|---|---|

| Gemini 1.0 Nano | Minst | 32 000 tokens | Mobiloppgaver, lokal behandling, bildetekst, chat-svar | Android-enheter (Pixel 8 Pro+), Chrome desktop | Kjører uten internettforbindelse |

| Gemini 1.0 Ultra | Størst | 32 000 tokens | Kompleks resonnement, avansert koding, matematisk analyse, multimodalt resonnement | Skybasert, bedrift | Høyest nøyaktighet på benchmarktester |

| Gemini 1.5 Pro | Middels | 2 millioner tokens | Dokumentanalyse, kode-repositorier, langt innhold, bedriftsapplikasjoner | Google Cloud, API-tilgang | Lengst kontekstvindu, balansert ytelse |

| Gemini 1.5 Flash | Lettvekt | 1 million tokens | Raske svar, kostnadseffektiv behandling, sanntidsapplikasjoner | Sky, mobil, edge | Optimalisert for fart og effektivitet |

| Gemini 2.0/2.5 | Neste generasjon | Variabelt | Agentisk AI, autonome oppgaver, avansert resonnement, sanntidsinteraksjoner | Sky, integrerte tjenester | Agentiske egenskaper, forbedret resonnement |

Den multimodale naturen til Google Gemini representerer et grunnleggende avvik fra tidligere AI-modeller som primært opererte innenfor én modalitet. Geminis evne til å behandle sammenvevde sekvenser av lyd, bilde, tekst og video som både input og output muliggjør sofistikerte resonnementoppgaver som ville vært umulig for enkeltmodalitetsmodeller. For eksempel kan Gemini analysere en video, trekke ut relevant tekst fra bilderuter, forstå talt dialog og generere omfattende sammendrag som syntetiserer informasjon på tvers av alle modaliteter. Denne kapasiteten har dype implikasjoner for virkelige bruksområder: i medisinsk diagnostikk kan Gemini analysere pasientjournaler (tekst), medisinske bilder (visuelt) og pasientintervjuer (lyd) samtidig for å gi helhetlige vurderinger. I kundeservice kan den behandle kundehenvendelser (tekst), analysere produktbilder, gjennomgå videodemonstrasjoner og generere konteksttilpassede svar. Kryss-modal oppmerksomhetsmekanismen som muliggjør denne integrasjonen fungerer ved å skape felles representasjoner der informasjon fra ulike modaliteter kan påvirke hverandres prosessering. Når man f.eks. analyserer et bilde med tilhørende tekst, hjelper tekstkonteksten den visuelle prosesseringen med å fokusere på relevante områder, mens visuell informasjon hjelper til å avklare tvetydige tekstreferanser. Denne toveis påvirkningen gir en mer helhetlig forståelse enn det som ville vært mulig ved å prosessere modaliteter uavhengig. De praktiske implikasjonene for AI-overvåking og merkevaresporing er betydelige: når Gemini genererer svar som inkluderer bilder, tekst og potensielt lyd, må overvåkingssystemer spore hvordan merkevarer fremstår på tvers av alle disse modalitetene, ikke bare i tekstbaserte svar.

Google Gemini Ultra har vist eksepsjonell ytelse på flere standardiserte AI-benchmarks, og etablerer seg som en svært kapabel modell i det konkurranseutsatte landskapet for store språkmodeller. På MMLU-benchmarken (Massive Multitask Language Understanding), som tester naturlig språkforståelse på tvers av 57 ulike fagområder, overgikk Gemini Ultra selv menneskelige eksperter—en betydelig milepæl innen AI-utvikling. For matematisk resonnement (GSM8K-benchmark), presterte Gemini Ultra bedre enn konkurrerende modeller som Claude 2, GPT-4 og Llama 2. Ved kodegenerering (HumanEval-benchmark) demonstrerte Gemini overlegne evner, som muliggjør avansert programmeringsassistanse og kodeanalyse. Ytelsen varierer imidlertid på ulike evalueringsmetrikker: mens Gemini Ultra utmerker seg i dokumentforståelse, bildeforståelse og automatisk talegjenkjenning, viser den mer moderate forbedringer innen områder som allmennkunnskapsresonnement (HellaSwag-benchmark), hvor GPT-4 fortsatt har et forsprang. Gemini 1.5-serien har vært spesielt imponerende, med både Flash- og Pro-variantene som matcher eller overgår Gemini 1.0 Ultra sin ytelse, samtidig som de tilbyr dramatisk forbedret effektivitet og utvidede kontekstvinduer. Denne ytelsesutviklingen er spesielt relevant for AI-siteringsovervåking: ettersom Geminis muligheter forbedres og brukerbasen vokser til 350 millioner månedlige aktive brukere, påvirker nøyaktigheten og grundigheten i svarene direkte hvordan merkevarer og domener representeres i AI-generert innhold. Organisasjoner som bruker plattformer som AmICited kan spore om Geminis svar om deres merkevare er faktuelt korrekte og riktig kontekstualisert.

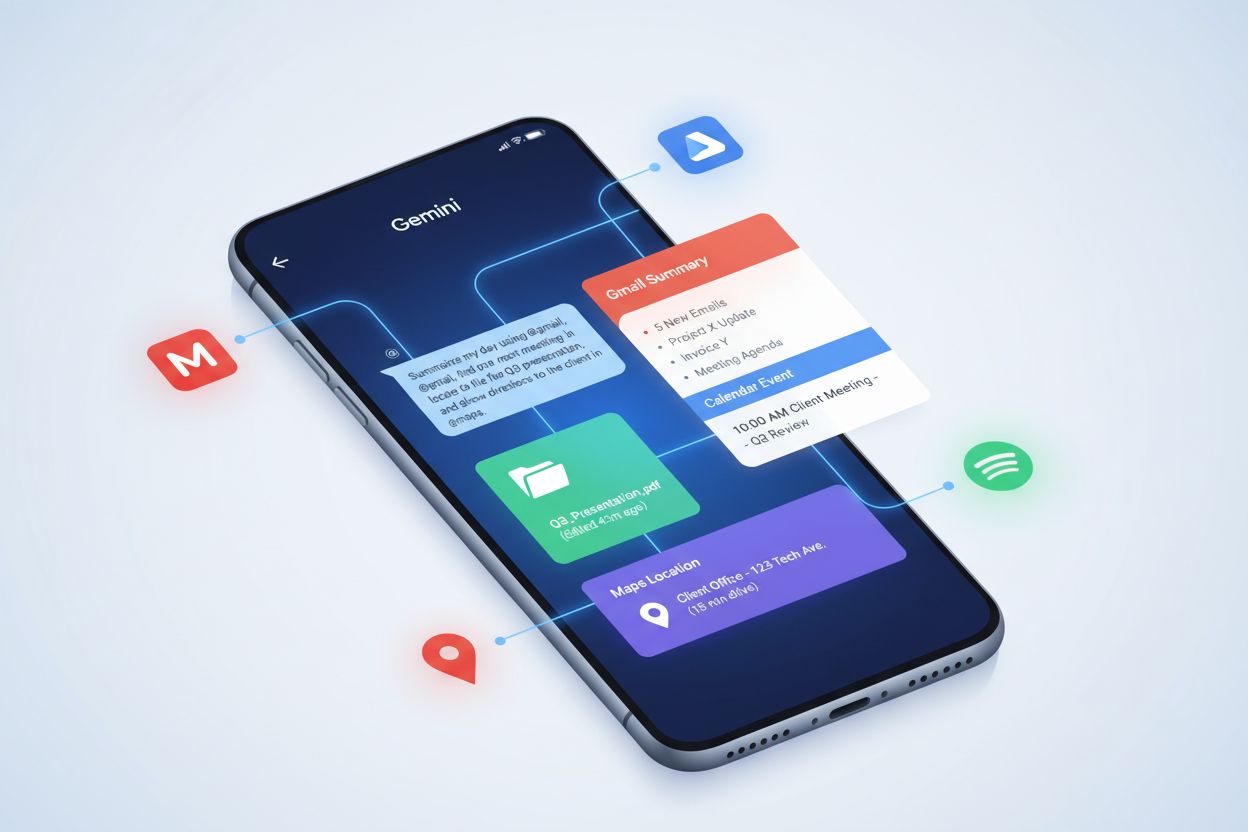

Den strategiske integrasjonen av Google Gemini i Googles produktspekter representerer en av de mest omfattende utrullingene av en AI-modell i et teknologiselskaps tilbud. Gemini er nå standard AI-assistent på Google Pixel 9 og Pixel 9 Pro-smarttelefoner, og erstatter den tidligere Google Assistant, noe som gjør den til det primære AI-grensesnittet for millioner av brukere. I Google Workspace vises Gemini i Docs-sidepanelet for å bistå med skriving og redigering, i Gmail for å hjelpe med utkast og svarforslag, og på tvers av andre produktivitetsapper. Google Maps benytter Geminis egenskaper for å gi intelligente oppsummeringer av steder og områder, og forbedrer brukeropplevelsen med kontekstuell informasjon. Google Søk har integrert Gemini gjennom AI Overviews, som genererer omfattende svar på brukerspørsmål ved å syntetisere informasjon fra flere kilder. Gemini API er tilgjengelig gjennom Google AI Studio og Google Cloud Vertex AI, slik at utviklere kan integrere Gemini-funksjonalitet i egne applikasjoner. Denne økosystemintegrasjonen har store konsekvenser for merkevareovervåking og AI-siteringssporing. Når en bruker søker informasjon om et selskap eller produkt i Google Søk, kan Gemini generere en AI Overview som inkluderer eller utelater omtale av den merkevaren. Når noen bruker Gmail med Gemini, kan modellen referere til selskapsinformasjon i foreslåtte svar. Når utviklere bygger applikasjoner med Gemini API, skapes det nye kontaktpunkter hvor merkevarer kan dukke opp i AI-generert innhold. Denne utstrakte integrasjonen gjør helhetlig overvåking på tvers av alle disse plattformene essensiell for å opprettholde merkevarens integritet og sikre korrekt representasjon i AI-svar.

Fremveksten av Google Gemini som en stor AI-plattform med 350 millioner månedlige aktive brukere har skapt nye nødvendigheter for merkevareovervåking og AI-siteringssporing. I motsetning til tradisjonelle søkemotorer hvor merkevarer vises i rangerte resultatlister, genererer Gemini syntetiserte svar som kan inkludere eller utelate spesifikke selskaper, produkter eller domener. Når en bruker spør Gemini om en bestemt bransje eller tema, avgjør modellen hvilke kilder som refereres, hvilken informasjon som fremheves, og hvordan merkevareomtaler kontekstualiseres. Dette representerer et betydelig skifte fra tradisjonell SEO, hvor synlighet avhenger av rangering, til det som kan kalles “AI-siteringsoptimalisering”—å sikre at merkevarer vises korrekt og passende i AI-genererte svar. Den multimodale naturen til Gemini øker kompleksiteten i overvåkingen: merkevarer kan dukke opp ikke bare i tekstsvar, men også i bilder, lydtranskripsjoner eller videoreferanser som Gemini genererer. Integrasjonen av Gemini på tvers av Googles økosystem betyr at merkevareomtaler kan forekomme i flere sammenhenger: i Google Søk AI Overviews, i Gmail-forslag, i Google Maps-oppsummeringer og i egne apper bygget med Gemini API. Organisasjoner må forstå hvordan Gemini representerer deres merkevare i disse ulike sammenhengene og om informasjonen som gis er nøyaktig, fullstendig og riktig kontekstualisert. Plattformer som AmICited dekker dette behovet ved å overvåke hvordan merkevarer fremstår i Gemini-svar sammen med andre AI-plattformer som ChatGPT, Perplexity, Claude og Google AI Overviews, og gir omfattende innsikt i AI-generert merkevarerepresentasjon.

Til tross for sine imponerende egenskaper står Google Gemini overfor flere dokumenterte utfordringer som organisasjoner må ta hensyn til når de stoler på dens svar. AI-skjevhet kom tydelig frem i februar 2024 da Google satte Geminis bildegenerering på pause på grunn av unøyaktige og skjeve fremstillinger av historiske personer, der modellen fjernet historisk kontekst rundt rasediversitet. Denne hendelsen viste hvordan multimodale AI-systemer kan videreføre eller forsterke skjevheter i treningsdata. Hallusinasjoner—tilfeller hvor modellen genererer faktuelt feil informasjon—påvirker fortsatt Gemini, spesielt i AI Overviews der brukere kan stole på syntetisert informasjon uten verifisering. Google har erkjent pågående problemer med at Gemini-drevne søkeresultater av og til gir feil eller misvisende svar. Brudd på immaterielle rettigheter er en annen bekymring: Google ble bøtelagt i Frankrike (€250 millioner) for å ha trent Gemini på opphavsrettsbeskyttet nyhetsinnhold uten kunnskap eller samtykke fra utgivere, noe som reiser spørsmål om datakilder og rettferdig bruk. Disse begrensningene har direkte konsekvenser for merkevareovervåking: organisasjoner kan ikke ta for gitt at informasjonen Gemini gir om konkurrenter eller bransjetemaer er korrekt, og de må verifisere hvordan egen merkevare fremstilles. Potensialet for at Gemini kan generere misvisende informasjon om et selskaps produkter, historie eller markedsposisjon skaper risiko som tradisjonell søkemotorovervåking ikke alene kan håndtere. I tillegg har modellen en tendens til å syntetisere informasjon fra flere kilder uten å alltid tydelig tilskrive påstander, noe som gjør at merkevareomtaler i Gemini-svar kan mangle riktig kontekst eller kildehenvisning.

Utviklingen av Google Gemini tyder på fortsatt utvidelse i kapasitet, effektivitet og integrasjon på tvers av Googles økosystem og utover. Gemini 2.0 og 2.5 introduserte agentiske AI-egenskaper, som gjør det mulig for modellen å ta autonome handlinger, planlegge flerstegsoppgaver og resonnere over utvidede kontekster—et betydelig fremskritt fra tidligere versjoner som primært svarte på brukerspørsmål. Fremtidige versjoner forventes å finjustere resonnementsegenskaper ytterligere, håndtere enda større kontekstvinduer og forbedre ytelsen på spesialiserte oppgaver. Project Astra, Googles initiativ for å bygge universelle AI-agenter, representerer den langsiktige visjonen for Gemini: AI-systemer som kan behandle, huske og forstå multimodal informasjon i sanntid, og muliggjøre mer naturlige og kapable interaksjoner. Project Mariner og andre forskningsinitiativer tyder på at Google utforsker hvordan Gemini kan bistå med komplekst kunnskapsarbeid, potensielt automatisere forskning, analyse og beslutningstaking. Integrasjonen av Gemini i flere Google-produkter og -tjenester vil sannsynligvis fortsette, og utvide kontaktpunktene hvor merkevarer dukker opp i AI-genererte svar. Effektivitetsforbedringer på enhet vil gjøre Gemini mer tilgjengelig på mobile enheter og edge-plattformer, og kan øke brukerbasen utover dagens 350 millioner månedlige aktive brukere. Konkurransesituasjonen vil også påvirke Geminis utvikling: etter hvert som andre AI-plattformer som ChatGPT, Claude og Perplexity fortsetter å utvikle seg, må Google opprettholde Geminis konkurransefortrinn innen multimodal behandling, integrasjon med Google-tjenester og sanntidstilgang til kunnskap. For organisasjoner med fokus på AI-overvåking og merkevarerepresentasjon betyr denne utviklingen at sporing av hvordan merkevarer vises i Gemini-svar blir stadig viktigere etter hvert som plattformens evner utvides og brukerbasen vokser. Overgangen til agentisk AI reiser også nye spørsmål om hvordan autonome AI-systemer vil representere og referere til merkevarer når de tar beslutninger eller handler på vegne av brukere.

Google Gemini representerer et grunnleggende skifte i hvordan AI-systemer behandler informasjon og genererer svar, med store implikasjoner for merkevareovervåking og AI-siteringssporing. Som en multimodal AI-modell med 350 millioner månedlige aktive brukere, integrert i Googles økosystem og i kontinuerlig utvikling mot stadig mer kapable agentiske systemer, har Gemini blitt en kritisk plattform å overvåke for organisasjoner. I motsetning til tradisjonelle søkemotorer hvor synlighet avhenger av rangering, skaper Geminis syntetiserte svar nye dynamikker hvor merkevarer kan bli nevnt eller utelatt, og når de nevnes, kan de bli representert korrekt eller feilaktig. Modellens dokumenterte begrensninger—inkludert skjevhet, hallusinasjoner og immaterielle bekymringer—understreker viktigheten av aktiv overvåking fremfor passiv tillit til AI-generert informasjon. Organisasjoner som ønsker å opprettholde merkevarens integritet og sikre nøyaktig representasjon i AI-svar må ta i bruk helhetlige overvåkingsstrategier som sporer hvordan deres merkevare fremstår på tvers av Gemini og andre store AI-plattformer. Dette representerer en ny grense innen digital markedsføring og merkevareforvaltning, hvor suksess avhenger ikke bare av tradisjonell SEO og søkesynlighet, men av å forstå og optimalisere hvordan AI-systemer fremstiller og refererer til merkevarer i sine genererte svar.

Google Gemini er grunnleggende designet som en multimodal AI-modell fra bunnen av, og behandler tekst, bilder, lyd og video samtidig, mens ChatGPT primært fokuserer på tekstbaserte interaksjoner og Claude legger vekt på sikkerhet og etisk resonnement. Geminis integrasjon med Googles økosystem, inkludert Google Søk, Workspace og Cloud-tjenester, gir unike fordeler for bedriftsbrukere. I tillegg gjør Geminis Mixture of Experts (MoE)-arkitektur det mulig å selektivt aktivere spesialiserte nevrale nettverk, noe som gjør den mer effektiv for ulike oppgaver sammenlignet med tradisjonelle transformer-baserte tilnærminger som brukes av konkurrenter.

Google Gemini har nådd 350 millioner månedlige aktive brukere per 2024, noe som viser rask adopsjon på tvers av Googles forbruker- og bedriftsprodukter. Plattformen driver 1,5 milliarder månedlige interaksjoner gjennom Googles integrerte tjenester. Daglige aktive brukere økte fra 9 millioner i oktober 2024 til 35 millioner i april 2025, noe som viser akselererende vekst. Denne vekstbanen posisjonerer Gemini som en av de raskest voksende AI-plattformene globalt, selv om den fortsatt ligger bak noen konkurrenter i enkelte markeder.

Google Gemini finnes i flere versjoner optimalisert for ulike bruksområder: Gemini 1.0 Nano (minste, for mobile enheter med 32K token-kontekst), Gemini 1.0 Ultra (største, for komplekse oppgaver med 32K token-kontekst), Gemini 1.5 Pro (middels størrelse med 2 millioner token-kontekstvindu), og Gemini 1.5 Flash (lettvektsversjon med 1 million token-kontekst). De nyeste Gemini 2.0 og 2.5-modellene introduserer agentiske AI-funksjoner og forbedret resonnement. Hver versjon er laget for spesifikke distribusjonsscenarier, fra behandling på enhet til bedriftsomfattende skyløsninger.

Gemini behandler flere datatyper gjennom en samlet transformer-arkitektur med spesialiserte kodere for hver modalitet (tekst, bilde, lyd, video). Modellen bruker kryss-modal oppmerksomhetsmekanismer for å koble informasjon på tvers av ulike formater, slik at den kan forstå relasjoner mellom f.eks. tekstbeskrivelser og visuelt innhold. I motsetning til modeller som krever separate prosesseringslinjer for ulike datatyper, muliggjør Geminis opprinnelige multimodale design sammenvevde sekvenser av ulike modaliteter både som input og output, noe som gjør den mer effektiv og i stand til komplekse resonnementer.

Mixture of Experts-arkitekturen i Gemini 1.5 Pro deler modellen inn i mindre spesialiserte nevrale nettverk, hvor hvert fungerer som en 'ekspert' innen spesifikke domener eller datatyper. Modellen lærer å selektivt aktivere kun de mest relevante ekspertene basert på input-typen, noe som gir raskere ytelse og lavere beregningskostnader. Denne tilnærmingen gjør at Gemini kan skalere effektivt uten proporsjonal økning i ressursbruk, og gjør den egnet både for ressursbegrensede mobile enheter og store bedriftsdistribusjoner.

Google Gemini integreres systematisk på tvers av sitt produktspekter: den er standard AI-assistent på Google Pixel 9-telefoner, tilgjengelig i Google Workspace for dokumentredigering og e-postutkast, integrert i Google Maps for stedsoppsummeringer, og driver Google Søk sine AI Overviews. Gemini API er tilgjengelig via Google AI Studio og Google Cloud Vertex AI for utviklere. Denne utbredte integrasjonen gjør Gemini til en kritisk komponent for å spore merkevareomtaler i AI-genererte svar på tvers av Googles plattformer, noe som er spesielt relevant for AI-overvåking og siteringssporing.

Google Gemini står overfor flere dokumenterte utfordringer, inkludert AI-skjevhet (Google satte bildegenerering på pause i februar 2024 på grunn av unøyaktige fremstillinger av historiske personer), hallusinasjoner som gir faktuelt feil svar i AI Overviews, og bekymringer rundt immaterielle rettigheter (Google ble ilagt €250 millioner i bot i Frankrike for å ha trent på opphavsrettsbeskyttet nyhetsinnhold uten utgiveres samtykke). Disse begrensningene fremhever viktigheten av å overvåke hvordan Gemini presenterer merkevarer og domener i AI-genererte svar, noe som gjør verktøy som AmICited essensielle for å sikre nøyaktighet og merkevaresikkerhet.

Begynn å spore hvordan AI-chatbots nevner merkevaren din på tvers av ChatGPT, Perplexity og andre plattformer. Få handlingsrettede innsikter for å forbedre din AI-tilstedeværelse.

Lær hvordan du optimaliserer innholdet ditt for Google Gemini og andre AI-søkemotorer. Mestre Answer Engine Optimization (AEO)-strategier for å øke merkevarens ...

Lær hva Gemini Extensions er, hvordan de fungerer, og hvordan de muliggjør AI-drevet produktivitet ved å koble Gemini til Gmail, Drive, Maps og andre tjenester....

Lær hvordan du optimaliserer din merkevare for Google Gemini-siteringer. Oppdag velprøvde strategier for å øke synligheten i AI-genererte svar, hvor 52,15 % av ...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.