Cloaking

Cloaking er en black-hat SEO-teknikk som viser ulikt innhold til søkemotorer og brukere. Lær hvordan det fungerer, risikoene, deteksjonsmetoder, og hvorfor det ...

Skjult tekst refererer til tekst eller lenker på en nettside som er usynlige for brukere, men lesbare for søkemotorroboter og AI-systemer. Denne teknikken brukes vanligvis for å manipulere søkerangeringer og anses som en black-hat SEO-praksis som bryter med søkemotorenes retningslinjer.

Skjult tekst refererer til tekst eller lenker på en nettside som er usynlige for brukere, men lesbare for søkemotorroboter og AI-systemer. Denne teknikken brukes vanligvis for å manipulere søkerangeringer og anses som en black-hat SEO-praksis som bryter med søkemotorenes retningslinjer.

Skjult tekst er innhold plassert på en nettside som er usynlig eller utilgjengelig for menneskelige brukere, men fortsatt lesbart for søkemotorroboter og AI-systemer. Denne teknikken innebærer bruk av ulike HTML- og CSS-metoder for å skjule tekst fra den visuelle visningen av siden, samtidig som den er til stede i kildekoden. Google definerer skjult tekst som “tekst eller lenker i innholdet ditt som brukes til å manipulere Googles søkerangeringer og som kan bli flagget som villedende.” Den viktigste forskjellen mellom legitimt skjult innhold og spam ligger i hensikten: Skjult tekst brukt for å manipulere søkerangeringer bryter med søkemotorenes retningslinjer, mens skjult innhold som er laget for å forbedre brukeropplevelse eller tilgjengelighet, er akseptabelt. Skjult tekst har vært en vedvarende utfordring i SEO siden tidlig på 2000-tallet, da søkealgoritmene var mindre sofistikerte og nettredaktører lettere kunne lure rangeringssystemene. I dag, med avanserte gjennomsøkings-teknologier og AI-drevne deteksjonssystemer, er skjult tekst en av de mest lett identifiserbare og strengt straffede black-hat SEO-praksisene.

Praksisen med å skjule tekst oppstod i de tidlige dagene av søkemotoroptimalisering, da Googles rangeringsalgoritmer var sterkt avhengige av nøkkelordstetthet og analyse av tekst på siden. Nettredaktører oppdaget at de kunne kunstig øke relevansen av nøkkelord ved å inkludere skjult tekst som søkemotorene indekserte, men som brukerne aldri så. Vanlige implementeringer inkluderte hvit tekst på hvit bakgrunn, tekst plassert langt utenfor skjermen med negative CSS-verdier, og tekst med null skriftstørrelse. Denne teknikken var spesielt utbredt mellom 2000 og 2005, før Google innførte avanserte spamdeteksjonssystemer. Praksisen ble så utbredt at bransjeanslag tilsier at omtrent 15–20 % av nettsidene benyttet en form for skjult tekstmanipulasjon på midten av 2000-tallet, selv om denne andelen har sunket betydelig etter hvert som straffene ble strengere og deteksjonen bedre.

Googles respons på misbruk av skjult tekst var rask og omfattende. Søkemotoren begynte å ilegge manuelle tiltak mot nettsteder som brukte skjult tekst, og allerede i 2008 kunne automatiserte deteksjonssystemer identifisere de fleste vanlige teknikker for skjult tekst. Innføringen av mobil-først-indeksering i 2018 endret faktisk samtalen om skjult innhold, da Google innså at noe skjult innhold—som sammenleggbare menyer og utvidbare seksjoner—faktisk forbedret mobil brukeropplevelse. Dette skillet mellom villedende skjult tekst og legitimt skjult innhold ble formalisert i Googles retningslinjer, og ga et tydeligere rammeverk for nettredaktører om hva som er akseptabelt og ikke.

Hvit tekst på hvit bakgrunn er fortsatt den mest beryktede teknikken, selv om det nå er trivielt for søkemotorer å oppdage. Metoden innebærer å sette tekstfarge til hvit (#FFFFFF) på hvit bakgrunn, slik at den blir usynlig for brukere, men fortsatt til stede i HTML-en. CSS-posisjoneringsteknikker bruker negative verdier på egenskaper som text-indent: -9999px for å flytte tekst langt utenfor synlig område, slik at den forblir i DOM-en, men skjult. Manipulering av skriftstørrelse setter tekst til font-size: 0 eller ekstremt små verdier som font-size: 1px, slik at teksten blir uleselig, men teknisk sett til stede på siden.

Null opasitet og synlighets-egenskaper bruker CSS-regler som opacity: 0 eller visibility: hidden for å gjøre teksten usynlig, men samtidig bevare dens plassering i dokumentflyten. Tekst skjult bak bilder innebærer å plassere tekst under bildeelementer ved hjelp av z-index, slik at den er usynlig for brukere, men tilgjengelig for roboter. Misbruk av NoScript-taggen utnytter <noscript>-taggen, som egentlig er ment å vise innhold når JavaScript er deaktivert, ved å fylle den med tekst rik på nøkkelord som søkemotorene kan krype. Nøkkelordfylling i skjulte elementer kombinerer skjulte tekstteknikker med overdreven gjentakelse av nøkkelord, og skaper sider som ser normale ut for brukere men har unaturlig mye nøkkelord i skjulte seksjoner.

Moderne implementeringer har blitt mer sofistikerte, og bruker JavaScript for dynamisk å skjule og vise innhold basert på brukeragent, slik at ulikt innhold vises for søkemotorer og brukere. Noen nettsteder bruker skjulte div-er som aktiveres av spesifikke brukerhandlinger, for å skjule innhold ved første lasting, men gjøre det tilgjengelig for roboter. Disse avanserte teknikkene er nå eksplisitt forbudt under Googles cloaking-policyer og oppdages gjennom headless browser-rendring som simulerer brukeradferd.

| Aspekt | Black-Hat Skjult Tekst (Spam) | White-Hat Skjult Innhold (Legitimt) | AI-robotens perspektiv |

|---|---|---|---|

| Hensikt | Manipulere søkerangeringer gjennom bedrag | Forbedre brukeropplevelse og tilgjengelighet | Oppdages via intensjonsanalyse |

| Brukernytte | Ingen; innholdet har ingen brukerfunksjon | Forbedrer navigasjon, reduserer rot, hjelper tilgjengelighet | Roboter vurderer faktisk brukerfordel |

| Vanlige eksempler | Hvit tekst på hvitt, nøkkelordfylling, tekst utenfor skjermen | Trekkspill, faner, nedtrekksmenyer, skjermleser-tekst | Begge kan krype, men rangeres ulikt |

| Behandling i søkemotor | Manuelle straffer, rangeringsfall, mulig avindeksering | Indekseres normalt, kan få lavere rangeringsvekt | AI-systemer indekserer begge, men prioriterer synlig innhold |

| Deteksjonsmetode | Fargeanalyse, CSS-inspeksjon, rendrings-sammenligning | Analyse av brukerinteraksjon, gjennomgang av tilgjengelighetsmarkering | Headless browser-rendring og DOM-analyse |

| Tidsbruk på gjenoppretting | Uker til måneder etter vurderingsforespørsel | Ingen gjenoppretting nødvendig; ikke regelbrudd | Umiddelbar rekryping etter utbedring |

| Mobil-først-påvirkning | Straffes i alle indekseringsmetoder | Ofte belønnet for å forbedre mobil brukeropplevelse | Mobilrendring er primær evalueringsmetode |

| Tilgjengelighetskrav | Bryter med WCAG-retningslinjer | Følger tilgjengelighetsstandarder | Kompatibilitet for skjermleser verifiseres |

Søkemotorroboter opererer i flere rendringsmoduser for å oppdage skjult tekst. Første modus er rå HTML-analyse, der robotene undersøker kildekoden direkte og finner tekst i DOM-en uavhengig av CSS-styling. Andre modus er rendring av siden, der robotene bruker headless-browsere som Chromium for å rendere siden akkurat slik brukerne ser den, og så sammenligner det rendrerte resultatet med rå HTML. Betydelige avvik mellom disse versjonene utløser algoritmer for deteksjon av skjult tekst.

Googles deteksjonssystem analyserer flere signaler for å identifisere skjult tekst: fargekontrast mellom tekst og bakgrunn, CSS-egenskaper som skjuler elementer, skriftstørrelser under lesbare terskler og posisjoneringsverdier som flytter innhold utenfor skjermen. Systemet vurderer også nøkkelordstetthet og semantisk relevans, og flagger sider der skjult tekst inneholder nøkkelord som ikke har sammenheng med synlig innhold, eller der nøkkelordstettheten i skjulte seksjoner langt overstiger den i synlig innhold. Maskinlæringsmodeller trent på millioner av sider kan nå identifisere subtile teknikker for skjult tekst som enkle regelbaserte systemer ikke ville oppdaget.

AI-roboter som GPTBot, ClaudeBot og PerplexityBot bruker lignende deteksjonsmekanismer, rendrer sider i headless-browsere og analyserer forholdet mellom synlig og skjult innhold. Disse systemene er spesielt avanserte fordi de må forstå innholdets hensikt og semantiske betydning, ikke bare teknisk implementasjon. En side med legitimt skjult innhold (som et trekkspill) vil ha konsistent semantikk mellom synlige og skjulte seksjoner, mens en side med spam-skjult tekst vil vise dramatiske temaskifter eller nøkkelordfokus mellom synlig og skjult innhold.

Google ilegger manuelle tiltak spesifikt for brudd på skjult tekst, som vises i rapporten for manuelle tiltak i Google Search Console. Nettsteder som mottar denne straffen opplever vanligvis rangeringsfall på 50–90 % for berørte sider, og noen mister all synlighet i søk fullstendig. Straffen kan være for hele nettstedet eller for enkeltsider, avhengig av omfanget av skjult tekst på domenet. Gjenoppretting krever fullstendig fjerning av all skjult tekst, bekreftelse på at nettstedet ikke lenger bryter retningslinjer, og innsending av vurderingsforespørsel via Search Console.

Gjennomgangsprosessen tar vanligvis 2–4 uker for første vurdering, men komplekse saker kan ta lengre tid. Googles gjennomgangsteam undersøker manuelt for å bekrefte at all skjult tekst er fjernet og at nettstedet nå følger retningslinjene. Omtrent 60–70 % av vurderingsforespørslene blir innledningsvis avvist, slik at nettredaktører må gjøre flere utbedringer og sende inn på nytt. Selv etter vellykket vurdering kan nettsteder oppleve en “tillitsstraff” hvor rangeringene gjenopprettes sakte over flere måneder, mens Googles algoritmer gjenoppbygger tillit til at nettstedet følger reglene.

Andre søkemotorer og AI-systemer gir lignende straffer. Bing har egne spamdeteksjonssystemer for skjult tekst, og AI-søkemotorer som Perplexity og Claude kan nedprioritere eller ekskludere innhold fra nettsteder som er kjent for å bruke skjult tekst. Den samlede effekten av slike straffer kan ødelegge et nettsteds organiske trafikk, noe som gjør skjult tekst til en av de dyreste SEO-feilene en nettredaktør kan gjøre.

Trekkspill- og fanebaserte grensesnitt er nå standardmønstre i webdesign som forbedrer brukeropplevelse ved å organisere komplekse opplysninger i sammenleggbare seksjoner. Disse elementene skjuler innhold som standard, men viser det når brukeren interagerer, og reduserer både kognitiv belastning og side-rot. Google støtter eksplisitt disse mønstrene når de implementeres med semantisk HTML og riktige tilgjengelighetsattributter. Nøkkelen er at det skjulte innholdet er semantisk relatert til det synlige og har en reell organisatorisk funksjon.

Nedtrekksmenyer for navigasjon skjuler sekundære navigasjonsvalg inntil brukeren holder musepekeren over eller klikker på hovedmenyelementer. Dette mønsteret er nesten universelt i moderne webdesign og er fullt støttet av søkemotorer. Mobil-først responsiv design baserer seg ofte på skjult innhold, med desktop-navigasjon skjult på mobil og erstattet av hamburgermeny eller andre mobiloptimaliserte løsninger. Googles mobil-først-indeksering belønner faktisk nettsteder som implementerer disse mønstrene effektivt, fordi de viser omtanke for mobil brukeropplevelse.

Skjermleser-tekst og tilgjengelighetsfunksjoner skjuler med hensikt innhold for seende brukere, men gjør det tilgjengelig for brukere med synshemming. Dette inkluderer hopp til hovedinnhold-lenker, beskrivende tekst for bilder og utvidede skjemafelt som gir kontekst til hjelpemidler. Disse løsningene er ikke bare akseptable, men kreves for WCAG-tilgjengelighet. Søkemotorer kjenner igjen og støtter disse mønstrene fordi de har reell tilgjengelighetsverdi.

Utvidbare seksjoner som “Les mer”-knapper, forkortede produktanmeldelser og FAQ-trekkspill er legitime bruksområder for skjult innhold. Disse mønstrene forbedrer sideytelsen ved å redusere innlastingsstørrelsen, samtidig som alt innhold forblir tilgjengelig. Søkemotorer indekserer alt innholdet selv når det er skjult bak en interaksjon, slik at all informasjon er tilgjengelig for rangering.

Fremveksten av AI-drevne søkemotorer som ChatGPT, Perplexity, Google AI Overviews og Claude har skapt nye utfordringer og muligheter knyttet til skjult tekst. Disse systemene krøller og indekserer nettsteder for å trene modellene sine og generere svar, og må håndtere de samme problemene med skjult tekst som tradisjonelle søkemotorer. AI-roboter er spesielt dyktige til å oppdage skjult tekst fordi de rendrer sider på flere måter og analyserer innholdets semantikk for å forstå hensikt.

For overvåkingsplattformer som AmICited skaper skjult tekst en unik utfordring. Når nettsteder bruker skjult tekst med merkevarenavn, kan slike omtaler bli indeksert av AI-roboter, men ikke være synlige for menneskelige brukere. Dette skaper avvik mellom det som vises i AI-svar og det brukeren ser på kildesiden. AmICiteds overvåkingssystem må derfor ta hensyn til både synlig og skjult innhold for å gi nøyaktige tall på merkevareomtaler i AI-søkemotorer. Plattformen sporer ikke bare om merkevaren nevnes, men også kontekst og synlighet av nevnelsene, slik at kundene får full oversikt over sitt digitale fotavtrykk i generative AI-svar.

Skjult tekst kan kunstig øke merkevareomtaler i AI-søkeresultater hvis nettsteder bruker skjult tekst med merkevare-nøkkelord. Dette gir et feilaktig inntrykk av merkevaresynlighet og kan forvrenge markedsanalysen. Samtidig bør legitimt skjult innhold som FAQ-trekkspill med merkevareinformasjon bli korrekt indeksert og kreditert i AI-svar, siden dette innholdet gir reell verdi for brukerne. Å forstå forskjellen mellom disse tilfellene er avgjørende for nøyaktig merkevareovervåking og konkurranseanalyse.

Sofistikeringen av deteksjon av skjult tekst fortsetter å øke etter hvert som søkemotorer og AI-systemer investerer i kraftigere rendrings- og analyseteknologier. Maskinlæringsmodeller blir stadig bedre til å forstå innholdets hensikt, og gjør det nærmest umulig å skjule manipulerende tekst for deteksjonssystemene. Fremtidige systemer vil trolig inkludere adferdsanalyse, hvor brukerinteraksjon undersøkes for å identifisere sider der skjult innhold ikke får reell brukerengasjement.

Blockchain og transparensteknologier kan etter hvert spille en rolle i verifisering av innhold, slik at brukere og søkemotorer kan sjekke at nettsideinnhold ikke er manipulert eller skjult. Regulatoriske rammeverk rundt AI og søk kan til slutt kreve eksplisitt opplysning om skjult innhold, på samme måte som det kreves for annonsering. Fremveksten av zero-party-data og eksplisitte samtykkeløsninger kan endre hvordan skjult innhold oppfattes, der brukerne selv aktivt velger å vise eller skjule innhold fremfor at det skjules som standard.

AI-søkemotorer vil sannsynligvis bli enda mer aggressive i å straffe skjult tekst, ettersom de konkurrerer om å gi de mest pålitelige og transparente søkeresultatene. Integrering av brukertilbakemeldingssystemer i AI-søk kan gjøre det mulig for brukere å rapportere skjult tekst og manipulerende innhold, og dermed skape et folkedrevet deteksjonslag på toppen av automatiske systemer. Fremtiden for SEO vil sannsynligvis bevege seg bort fra teknisk manipulasjon og mot reell innholdskvalitet, brukeropplevelsesoptimalisering og åpen kommunikasjon mellom nettsteder og søkesystemer.

For overvåkingsplattformer som AmICited innebærer utviklingen av deteksjon av skjult tekst stadig mer presis sporing av merkevareomtaler på tvers av AI-systemer. Etter hvert som AI-roboter blir mer avanserte, blir skillet mellom legitimt og manipulerende skjult innhold tydeligere, og gir mer presis merkevareovervåking og konkurranseanalyse. Organisasjoner som fokuserer på transparente, brukersentrerte innholdsstrategier vil nyte bedre synlighet både i tradisjonelle og AI-drevne søkeresultater.

De mest utbredte teknikkene for skjult tekst inkluderer hvit tekst på hvite bakgrunner, CSS-posisjonering for å flytte tekst utenfor skjermen ved hjelp av negative text-indent-verdier, sette skriftstørrelsen til null, skjule tekst bak bilder og bruke null opasitet. Disse metodene var spesielt vanlige på begynnelsen av 2000-tallet, da søkealgoritmene var mindre sofistikerte. Moderne søkemotorer som Google, Perplexity og Claude kan nå oppdage disse teknikkene gjennom avanserte gjennomsøkings- og rendringsmuligheter, noe som gjør dem ineffektive og risikable for SEO.

Søkemotorer oppdager skjult tekst ved å analysere HTML og CSS på nettsider for å identifisere avvik mellom det brukere ser og det robotene har tilgang til. De undersøker fargeverdier, CSS-egenskaper som display:none og visibility:hidden, skriftstørrelser og posisjoneringsattributter. AI-roboter som GPTBot og ClaudeBot bruker lignende deteksjonsmetoder, render sider slik brukerne ville sett dem og sammenligner det rendrerte resultatet med den underliggende HTML-en. Googles URL Inspection Tool i Search Console hjelper også nettredaktører med å identifisere brudd på skjult tekst på egne nettsider.

Nettsteder som blir tatt for å bruke skjult tekst for å manipulere rangeringer, risikerer strenge straffer, inkludert manuelle tiltak fra Google, betydelige fall i rangeringer, fullstendig fjerning fra søkeresultatene og ekskludering fra spesielle søkerfunksjoner som Google News eller Discover. Disse straffene kan gjelde for hele nettstedet eller for spesifikke sider, avhengig av omfanget av bruddet. For å komme seg etter dette må man sende inn en forespørsel om ny vurdering etter å ha fjernet all skjult tekst og vise at man følger søkemotorenes retningslinjer. Prosessen kan ta uker eller måneder, hvor trafikk og synlighet er sterkt redusert.

Nei, ikke alt skjult innhold bryter med søkemotorenes retningslinjer. White-hat skjult innhold inkluderer trekkspillmenyer, fanebaserte grensesnitt, nedtrekksnavigasjon og innhold som blir vist gjennom brukerinteraksjon for å forbedre brukeropplevelsen. Skjult tekst for skjermlesere for tilgjengelighetsformål er også akseptabelt. Den avgjørende forskjellen er hensikten: Hvis skjult innhold er laget for å manipulere rangeringer fremfor å forbedre brukeropplevelse eller tilgjengelighet, bryter det med retningslinjene. Googles mobil-først-indeksering støtter faktisk skjult innhold når det forbedrer brukeropplevelsen og navigasjonen på mobil.

Skjult tekst skaper utfordringer for AI-overvåkingsplattformer som sporer merkevare-omtale på tvers av AI-systemer som ChatGPT, Perplexity og Claude. Hvis nettsteder bruker skjult tekst med merkevarenavn, kan disse nevnelsene bli indeksert av AI-roboter, men ikke være synlige for mennesker, noe som skaper avvik i overvåkingsdataene. AmICiteds sporingssystemer må ta hensyn til både synlig og skjult innhold for å gi nøyaktige tall for merkevarens synlighet i AI-søkemotorer, slik at kundene forstår sitt fulle digitale fotavtrykk i generative AI-responser.

Legitime bruksområder for skjult innhold inkluderer å forbedre mobil brukeropplevelse med sammenleggbare menyer og trekkspill, gi tilleggsinformasjon via utvidbare seksjoner, implementere tilgjengelighetsfunksjoner for skjermlesere og organisere kompleks produktinformasjon med faner. Nettbutikker skjuler ofte detaljerte spesifikasjoner og anmeldelser bak utvidbare seksjoner for å redusere side-rot. Nyhetssider bruker skjult innhold for avkortede artikkelutdrag med 'les mer'-funksjon. Disse løsningene bryter ikke med retningslinjene fordi de har et reelt brukerfokus, ikke for å manipulere søkerangeringer.

Deteksjon av skjult tekst har utviklet seg betydelig fra enkel mønstergjenkjenning til avanserte maskinlæringsmodeller som forstår siderendring, brukerinteraksjon og innholdets hensikt. Moderne systemer rendrer sider i headless-browsere for å se akkurat det brukerne ser, og sammenligner dette med underliggende HTML og CSS. AI-systemer kan nå identifisere subtile variasjoner i tekstfarge, opasitet og posisjonering som eldre algoritmer gikk glipp av. I tillegg bidrar naturlig språkprosessering til å oppdage nøkkelordfylling og unaturlige tekstmønstre som indikerer manipulasjon, noe som gjør det stadig vanskeligere å skjule innhold for deteksjonssystemer.

Begynn å spore hvordan AI-chatbots nevner merkevaren din på tvers av ChatGPT, Perplexity og andre plattformer. Få handlingsrettede innsikter for å forbedre din AI-tilstedeværelse.

Cloaking er en black-hat SEO-teknikk som viser ulikt innhold til søkemotorer og brukere. Lær hvordan det fungerer, risikoene, deteksjonsmetoder, og hvorfor det ...

Lær hvordan du identifiserer innholdshull for AI-søkemotorer som ChatGPT og Perplexity. Oppdag metoder for å analysere LLM-synlighet, finne manglende temaer og ...

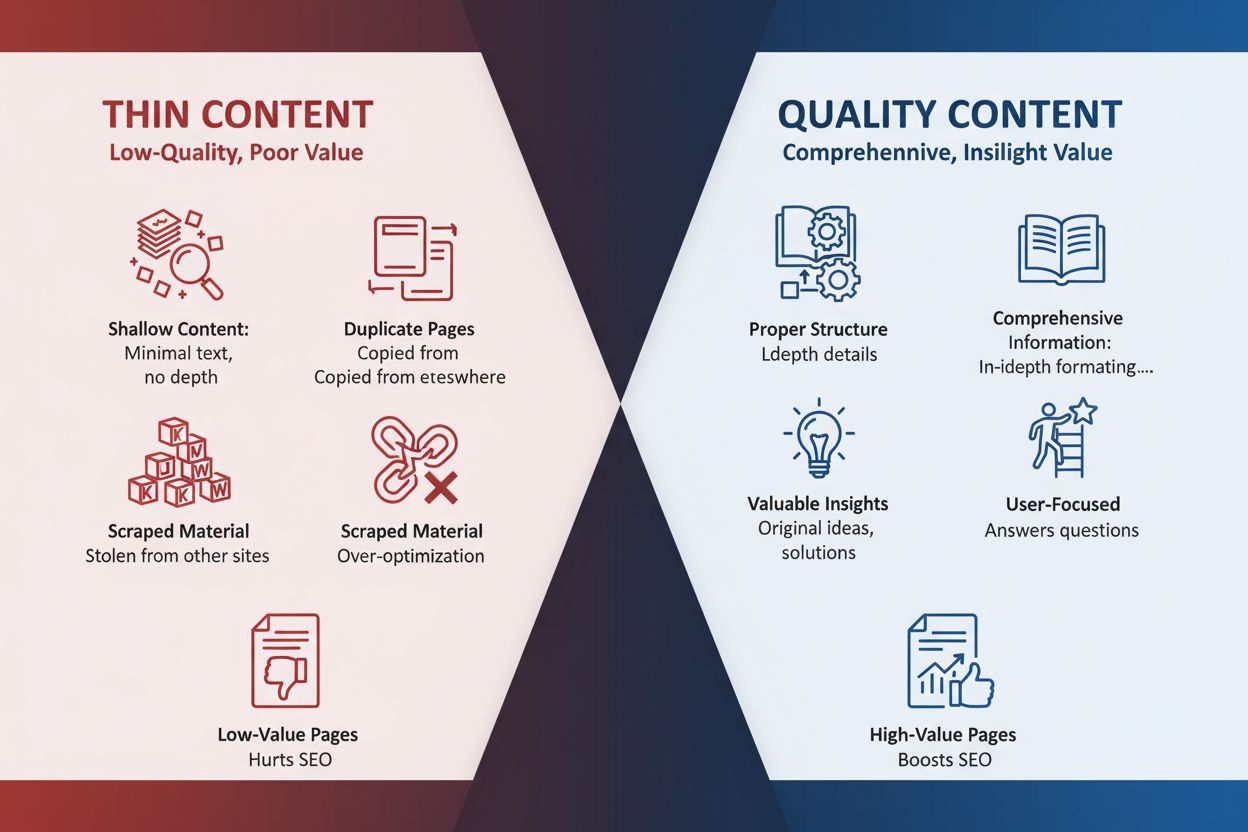

Definisjon av tynt innhold: nettsider med utilstrekkelig verdifull informasjon. Lær om typer, SEO-påvirkning, identifiseringsmetoder og strategier for å forbedr...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.