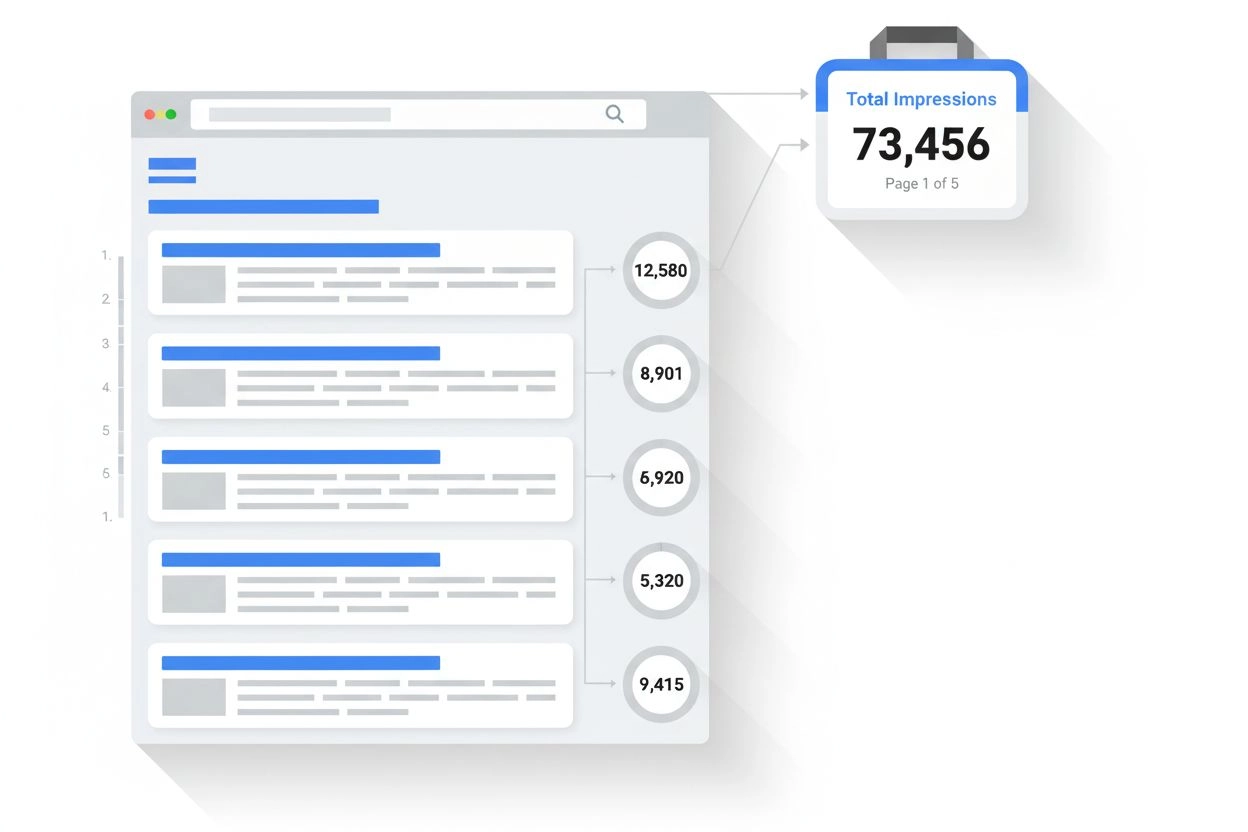

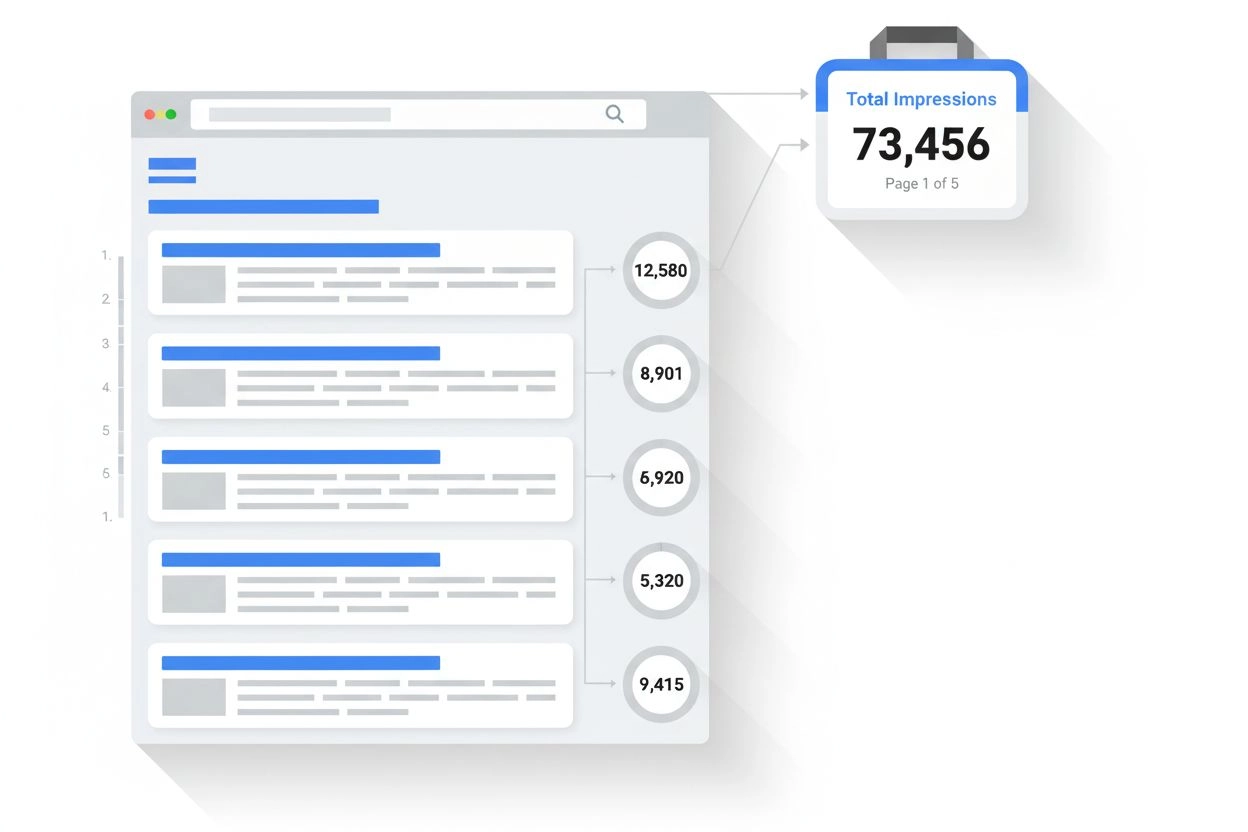

Impresjon

Lær hva en impresjon er i søkeresultater og AI-overvåking. Forstå hvordan impresjoner telles på tvers av Google Søk, Perplexity, ChatGPT og andre plattformer, o...

Inferens er prosessen der en trent AI-modell genererer utdata, prediksjoner eller konklusjoner fra nye inndata ved å anvende mønstre og kunnskap tilegnet under treningen. Dette representerer driftsfasen hvor AI-systemer benytter sin lærte intelligens på reelle problemer i produksjonsmiljøer.

Inferens er prosessen der en trent AI-modell genererer utdata, prediksjoner eller konklusjoner fra nye inndata ved å anvende mønstre og kunnskap tilegnet under treningen. Dette representerer driftsfasen hvor AI-systemer benytter sin lærte intelligens på reelle problemer i produksjonsmiljøer.

Inferens er prosessen der en trent kunstig intelligens-modell genererer utdata, prediksjoner eller konklusjoner fra nye inndata ved å anvende mønstre og kunnskap tilegnet under treningsfasen. I sammenheng med AI-systemer representerer inferens driftsfasen der maskinlæringsmodeller går fra laboratoriet og ut i produksjonsmiljøer for å løse reelle problemer. Når du samhandler med ChatGPT, Perplexity, Google AI Overviews eller Claude, opplever du AI-inferens i praksis—modellen tar inn dine inndata og genererer intelligente svar basert på mønstre den har lært fra massive treningsdatasett. Inferens er grunnleggende forskjellig fra trening; mens trening lærer modellen hva den skal gjøre, er det under inferens modellen faktisk gjør det, og anvender sin lærte kunnskap på data den aldri har sett før.

Forskjellen mellom AI-trening og AI-inferens er avgjørende for å forstå hvordan moderne kunstig intelligens-systemer fungerer. Under treningsfasen mater datasientister enorme, kuraterte datasett inn i nevrale nettverk, slik at modellen kan lære mønstre, sammenhenger og beslutningsregler gjennom iterativ optimalisering. Denne prosessen er svært ressurskrevende, og krever ofte uker eller måneder med prosessering på spesialisert maskinvare som GPU-er og TPU-er. Når treningen er ferdig og modellen har funnet optimale vekter og parametere, går den inn i inferensfasen. Da er modellen fryst—den lærer ikke lenger fra nye data—og anvender i stedet sine lærte mønstre for å generere prediksjoner eller utdata på tidligere usette inndata. Ifølge forskning fra IBM og Oracle er det under inferens den virkelige forretningsverdien av AI realiseres, ettersom det muliggjør utrulling av AI-funksjoner i stor skala på tvers av produksjonssystemer. AI-inferensmarkedet ble verdsatt til 106,15 milliarder USD i 2025 og forventes å vokse til 254,98 milliarder USD innen 2030, noe som reflekterer en eksplosiv etterspørsel etter inferensevner på tvers av bransjer.

AI-inferens opererer gjennom en flertrinnsprosess som forvandler rå inndata til intelligente utdata. Når en bruker sender et spørsmål til en stor språkmodell som ChatGPT, starter inferensrørledningen med inndatakoding, der tekst konverteres til numeriske tokens som det nevrale nettverket kan prosessere. Modellen går deretter inn i prefase, hvor alle inndata-tokens behandles samtidig gjennom alle lag i det nevrale nettverket, slik at modellen forstår kontekst og sammenhenger i brukerens spørsmål. Denne fasen er beregningstung, men nødvendig for forståelse. Etter prefase går modellen inn i dekodefasen, der den genererer utdata-tokens sekvensielt, én om gangen, hvor hvert nye token avhenger av alle tidligere tokens i sekvensen. Denne sekvensielle genereringen gir den karakteristiske strømmeffekten brukere ser ved interaksjon med AI-chatboter. Til slutt konverterer utdatakonverteringsfasen de predikerte tokens tilbake til lesbar tekst, bilder eller andre formater brukeren kan forstå og samhandle med. Hele denne prosessen må skje på millisekunder for sanntidsapplikasjoner, noe som gjør optimering av inferenslatens til et kritisk fokus for AI-tjenesteleverandører.

Organisasjoner som implementerer AI-systemer må velge mellom tre primære inferensarkitekturer, hver optimalisert for ulike bruksområder og ytelseskrav. Batch-inferens prosesserer store mengder data offline på fastsatte intervaller, og passer dermed for scenarier der sanntidsrespons ikke kreves, som å generere daglige analysepaneler, ukentlige risikovurderinger eller nattlige anbefalingsoppdateringer. Denne tilnærmingen er svært effektiv og kostnadsbesparende fordi den kan prosessere tusenvis av prediksjoner samtidig, og dermed fordele beregningskostnaden på mange forespørsler. Online-inferens, også kalt dynamisk inferens, genererer prediksjoner umiddelbart på forespørsel med minimal latens, og er derfor avgjørende for interaktive applikasjoner som chatboter, søkemotorer og sanntids svindeldeteksjon. Online-inferens krever sofistikert infrastruktur for å opprettholde lav latens og høy tilgjengelighet, ofte med caching-strategier og modelloptimalisering for å sikre svar innen millisekunder. Streaming-inferens prosesserer kontinuerlig data fra sensorer, IoT-enheter eller sanntids datastrømmer, og gir prediksjoner på hvert datapunkt etter hvert som det ankommer. Denne typen driver applikasjoner som prediktivt vedlikehold av utstyr, autonome kjøretøy som prosesserer sensordata i sanntid, og smarte bysystemer som kontinuerlig analyserer trafikkmønstre. Hver inferenstype stiller ulike krav til arkitektur, maskinvare og optimaliseringsstrategier.

| Aspekt | Batch-inferens | Online-inferens | Streaming-inferens |

|---|---|---|---|

| Krav til latens | Sekunder til minutter | Millisekunder | Sanntid (under ett sekund) |

| Databehandling | Store datasett offline | Enkeltforespørsler på forespørsel | Kontinuerlig datastrøm |

| Bruksområder | Analyse, rapportering, anbefalinger | Chatboter, søk, svindeldeteksjon | IoT-overvåking, autonome systemer |

| Kostnadseffektivitet | Høy (fordelt på mange prediksjoner) | Middels (krever alltid aktiv infrastruktur) | Middels til høy (avhengig av datavolum) |

| Skalerbarhet | Utmerket (prosessering i bulk) | God (krever lastbalansering) | Utmerket (distribuert prosessering) |

| Prioritert modelloptimalisering | Gjennomstrømning | Balanse mellom latens og gjennomstrømning | Balanse mellom latens og nøyaktighet |

| Maskinvarekrav | Standard GPU-er/CPU-er | Høyytelses GPU-er/TPU-er | Spesialisert edge-maskinvare eller distribuerte systemer |

Inferensoptimalisering har blitt en kritisk disiplin ettersom organisasjoner ønsker å implementere AI-modeller mer effektivt og kostnadsbesparende. Kvantisering er en av de mest effektive optimaliseringsteknikkene, og reduserer den numeriske presisjonen til modellvekter fra standard 32-bit flyttall til 8-bit eller til og med 4-bit heltall. Dette kan redusere modellstørrelsen med 75-90 % samtidig som 95-99 % av den opprinnelige nøyaktigheten beholdes, noe som gir raskere inferens og lavere minnekrav. Modellbeskjæring fjerner ikke-kritiske nevroner, forbindelser eller hele lag fra det nevrale nettverket, og eliminerer overflødige parametere som ikke bidrar betydelig til prediksjoner. Forskning viser at beskjæring kan redusere modellkompleksitet med 50-80 % uten betydelig tap av nøyaktighet. Kunnskapsdestillasjon trener en mindre, raskere “studentmodell” til å etterligne atferden til en større, mer nøyaktig “lærermodell”, og muliggjør implementering på ressursbegrensede enheter med rimelig ytelse. Batchprosessering optimalisering grupperer flere inferensforespørsler sammen for å maksimere GPU-utnyttelse og gjennomstrømning. Nøkkel-verdi caching lagrer mellomresultater for å unngå unødvendige beregninger under dekodefasen i språkmodell-inferens. Ifølge NVIDIA-forskning kan kombinasjon av flere optimaliseringsteknikker gi 10x ytelsesforbedringer og redusere infrastrukturkostnader med 60-70 %. Disse optimaliseringene er essensielle for å kunne kjøre inferens i stor skala, spesielt for organisasjoner med tusenvis av samtidige inferensforespørsler.

Maskinvareakselerasjon er avgjørende for å møte latens- og gjennomstrømningskravene til moderne AI-inferensarbeidsmengder. Grafikkprosesseringsenheter (GPU-er) er fortsatt de mest brukte inferensakseleratorene takket være deres arkitektur for parallellprosessering, som er svært godt egnet til matriseoperasjoner som dominerer nevrale nettverk. NVIDIA GPU-er driver majoriteten av verdens inferensimplementeringer for store språkmodeller, med sine spesialiserte CUDA-kjerner for massiv parallellisme. Tensor Processing Units (TPU-er), utviklet av Google, er spesialdesignede ASIC-er optimalisert for nevrale nettverksoperasjoner, og gir overlegen ytelse per watt sammenlignet med generelle GPU-er for visse arbeidsmengder. Field-Programmable Gate Arrays (FPGA-er) tilbyr tilpassbar maskinvare som kan programmeres for spesifikke inferensoppgaver, og gir fleksibilitet for spesialiserte bruksområder. Application-Specific Integrated Circuits (ASIC-er) som Googles TPU eller Cerebras’ WSE-3 er skreddersydd for bestemte inferensarbeidsmengder, og gir eksepsjonell ytelse, men med begrenset fleksibilitet. Valg av maskinvare avhenger av flere faktorer: modellarkitektur, ønsket latens, krav til gjennomstrømning, strømbesparelse og totalkostnad. For edge-inferens på mobile enheter eller IoT-sensorer muliggjør spesialiserte edge-akseleratorer og nevrale prosesseringsenheter (NPU-er) effektiv inferens med minimalt strømforbruk. Den globale overgangen til AI-fabrikker—høyt optimalisert infrastruktur for produksjon av intelligens i stor skala—har ført til store investeringer i inferensmaskinvare, med bedrifter som ruller ut tusenvis av GPU-er og TPU-er i datasentre for å møte økende etterspørsel etter AI-tjenester.

Generative AI-systemer som ChatGPT, Claude og Perplexity er helt avhengige av inferens for å generere menneskelignende tekst, kode, bilder og annet innhold. Når du sender en forespørsel til disse systemene, starter inferensprosessen med å tokenisere inndataene dine til numeriske representasjoner som det nevrale nettverket kan prosessere. Modellen utfører så prefasen, der alle inndata-tokens behandles samtidig for å bygge en helhetlig forståelse av forespørselen, inkludert kontekst, intensjon og nyanser. Deretter går modellen inn i dekodefasen, hvor den genererer utdata-tokens sekvensielt, og forutsier det mest sannsynlige neste token basert på alle tidligere tokens og lærte mønstre fra treningsdataene. Denne token-for-token-genereringen er grunnen til at du ser strømmet tekst vises i sanntid når du bruker disse tjenestene. Inferensprosessen må balansere flere motstridende mål: å generere nøyaktige, sammenhengende og kontekstuelt riktige svar samtidig som lav latens opprettholdes for å holde brukeren engasjert. Spekulativ dekoding, en avansert inferensoptimaliseringsteknikk, lar en mindre modell forutsi flere fremtidige tokens mens den større modellen validerer prediksjonene, noe som gir betydelig lavere latens. Omfanget av inferens for store språkmodeller er enormt—OpenAI’s ChatGPT håndterer millioner av inferensforespørsler daglig, hver med hundrevis eller tusenvis av tokens, og krever massiv beregningsinfrastruktur og avanserte optimaliseringsstrategier for å være økonomisk bærekraftig.

For organisasjoner som er opptatt av sin merkevaretilstedeværelse og innholdssitering i AI-genererte svar, har inferensovervåking blitt stadig viktigere. Når AI-systemer som Perplexity, Google AI Overviews eller Claude genererer svar, utfører de inferens på sine trente modeller for å produsere utdata som kan referere til eller sitere ditt domene, merkevare eller innhold. Å forstå hvordan inferenssystemer fungerer hjelper organisasjoner å optimalisere innholdsstrategien for å sikre korrekt representasjon i AI-genererte svar. AmICited spesialiserer seg på å overvåke hvor merker og domener vises i AI-inferensutdata på tvers av flere plattformer, og gir innsikt i hvordan AI-systemer siterer og refererer til innholdet ditt. Slik overvåking er avgjørende fordi inferenssystemer kan generere svar som inkluderer eller utelater din merkevare avhengig av treningsdatakvalitet, relevanssignaler og modelloptimalisering. Organisasjoner kan bruke inferensovervåkingsdata til å forstå hvilket innhold som blir sitert, hvor ofte merkevaren dukker opp i AI-svar, og om domenet blir korrekt kreditert. Denne innsikten muliggjør datadrevne beslutninger om innholdsoptimalisering, SEO-strategi og merkevareposisjonering i det nye AI-drevne søkelandskapet. Etter hvert som inferens blir hovedgrensesnittet for informasjonsinnhenting, er det like viktig å overvåke AI-genererte utdata som tradisjonell søkemotoroptimalisering.

Implementering av inferenssystemer i stor skala innebærer en rekke tekniske, operasjonelle og strategiske utfordringer som organisasjoner må håndtere. Latensstyring er en vedvarende utfordring, da brukere forventer svar på under ett sekund fra interaktive AI-applikasjoner, mens komplekse modeller med milliarder av parametere krever betydelig beregningstid. Optimalisering av gjennomstrømning er like kritisk—organisasjoner må betjene tusenvis eller millioner av samtidige inferensforespørsler samtidig som latens og nøyaktighet opprettholdes. Modelldrift oppstår når inferensytelsen svekkes over tid fordi virkelige data avviker fra treningsdataene, noe som krever kontinuerlig overvåking og periodisk modelltrening. Tolkbarhet og forklarbarhet blir stadig viktigere etter hvert som AI-inferenssystemer tar beslutninger som påvirker brukere, og organisasjoner må forstå og forklare hvordan modellene kommer frem til bestemte prediksjoner. Regulatorisk etterlevelse gir økende utfordringer, med regler som EUs AI Act som stiller krav til åpenhet, skjevhetsdeteksjon og menneskelig kontroll i AI-inferenssystemer. Datakvalitet er fundamentalt—inferenssystemer kan bare være så gode som dataene de ble trent på, og dårlige treningsdata gir skjeve, unøyaktige eller skadelige inferensutdata. Infrastrukturkostnader kan være betydelige, da inferens i stor skala krever store investeringer i GPU-er, TPU-er, nettverk og kjølingsinfrastruktur. Kompetansemangel gjør at organisasjoner sliter med å finne ingeniører og datasientister med ekspertise i inferensoptimalisering, modelldistribusjon og MLOps, noe som øker rekrutteringskostnader og forsinker utrulling.

Fremtiden for AI-inferens utvikler seg raskt i flere transformative retninger som vil endre måten organisasjoner implementerer og bruker AI-systemer. Edge-inferens—å kjøre inferens på lokale enheter i stedet for datasentre i skyen—øker, drevet av fremskritt innen modellkompresjon, spesialisert edge-maskinvare og personvernhensyn. Dette vil muliggjøre sanntids AI-funksjoner på smarttelefoner, IoT-enheter og autonome systemer uten avhengighet av skytilkobling. Multimodal inferens, hvor modeller prosesserer og genererer tekst, bilder, lyd og video samtidig, blir stadig vanligere, og krever nye optimaliseringsstrategier og maskinvaretilnærminger. Resonnerende modeller som utfører flerstegs-inferens for å løse komplekse oppgaver er på vei, med systemer som OpenAI’s o1 som viser at inferens også kan skaleres med mer beregningstid og tokens, ikke bare modellstørrelse. Disaggregert servering vinner frem, der separate maskinvareklynger håndterer pre- og dekodefaser i inferensen, og optimaliserer ressursbruk for ulike beregningsmønstre. Spekulativ dekoding og andre avanserte inferensteknikker blir standardpraksis, og muliggjør 2-3x lavere latens. Inferens ved kanten kombinert med federert læring vil gjøre det mulig for organisasjoner å implementere AI lokalt samtidig som personvernet ivaretas og båndbreddebehovet reduseres. AI-inferensmarkedet forventes å vokse med 19,2 % årlig frem til 2030, drevet av økt bruk i næringslivet, nye bruksområder og et økonomisk behov for å optimalisere inferenskostnader. Etter hvert som inferens blir den dominerende arbeidsmengden i AI-infrastruktur, vil optimaliseringsteknikker, spesialisert maskinvare og programvare for inferens bli stadig mer avansert og avgjørende for konkurransefortrinn.

AI-trening er prosessen der en modell læres opp til å gjenkjenne mønstre ved å bruke store datasett, mens AI-inferens er når den trente modellen anvender det den har lært for å generere prediksjoner eller utdata på nye data. Trening er ressurskrevende og skjer én gang, mens inferens vanligvis er raskere, mindre ressurskrevende og skjer kontinuerlig i produksjonsmiljøer. Tenk på trening som å lese til en eksamen, og inferens som å ta selve eksamenen.

Inferenslatens—tiden det tar for en modell å generere et utdata—er avgjørende for brukeropplevelse og sanntidsapplikasjoner. Lav latens muliggjør umiddelbare svar i chatboter, sanntidsoversettelse, autonome kjøretøy og systemer for svindeldeteksjon. Høy latens kan gjøre applikasjoner ubrukelige for tidskritiske oppgaver. Virksomheter optimaliserer latens med teknikker som kvantisering, modellbeskjæring og spesialisert maskinvare som GPU-er og TPU-er for å oppfylle tjenestenivåavtaler.

De tre primære typene er batch-inferens (prosessering av store datasett offline), online inferens (generering av prediksjoner umiddelbart på forespørsel) og streaming-inferens (kontinuerlig prosessering av data fra sensorer eller IoT-enheter). Batch-inferens passer for scenarier som daglige analysepaneler, online inferens driver chatboter og søkemotorer, og streaming-inferens muliggjør sanntids overvåkningssystemer. Hver type har ulike krav til latens og bruksområder.

Kvantisering reduserer den numeriske presisjonen til modellvekter fra 32-bit til 8-bit eller lavere, noe som reduserer modellstørrelse og beregningskrav betydelig uten å miste nøyaktighet. Beskjæring fjerner ikke-kritiske nevroner eller forbindelser fra nevrale nettverk, og reduserer kompleksiteten. Begge teknikker kan redusere inferenslatens med 50-80 % og senke maskinvarekostnadene. Disse optimaliseringsmetodene er avgjørende for å distribuere modeller på edge-enheter og mobile plattformer.

Inferens er kjernemekanismen som gjør det mulig for generative AI-systemer å produsere tekst, bilder og kode. Når du gir ChatGPT en forespørsel, tokeniserer inferensprosessen inndataene dine, prosesserer dem gjennom de trente lagene i det nevrale nettverket og genererer utdata-tokens ett om gangen. Prefase behandler alle inndata-tokens samtidig, mens dekodefasen genererer utdata sekvensielt. Denne inferensevnen gjør store språkmodeller responsive og praktiske for reelle bruksområder.

Inferensovervåking sporer hvordan AI-modeller presterer i produksjon, inkludert nøyaktighet, latens og utdatakvalitet. Plattformer som AmICited overvåker hvor merker og domener vises i AI-genererte svar på tvers av systemer som ChatGPT, Perplexity og Google AI Overviews. Innsikt i inferensatferd hjelper organisasjoner å sikre at innholdet deres blir korrekt sitert og representert når AI-systemer genererer utdata som refererer til deres domener eller merkevareinformasjon.

Vanlige inferensakseleratorer inkluderer GPU-er (grafikkprosesseringsenheter) for parallellprosessering, TPU-er (Tensor Processing Units) optimalisert for nevrale nettverk, FPGA-er (Field-Programmable Gate Arrays) for fleksible arbeidsmengder, og ASIC-er (Application-Specific Integrated Circuits) designet for spesifikke oppgaver. GPU-er er mest utbredt på grunn av balansen mellom ytelse og pris, mens TPU-er utmerker seg på storskala inferens. Valget avhenger av krav til gjennomstrømning, latens og budsjett.

Det globale AI-inferensmarkedet ble verdsatt til 106,15 milliarder USD i 2025 og forventes å nå 254,98 milliarder USD innen 2030, noe som tilsvarer en årlig vekstrate (CAGR) på 19,2 %. Denne raske veksten reflekterer økt bruk av AI-applikasjoner i næringslivet, med 78 % av organisasjoner som bruker AI i 2024, opp fra 55 % i 2023. Veksten drives av etterspørsel etter sanntids-AI på tvers av bransjer som helse, finans, detaljhandel og autonome systemer.

Begynn å spore hvordan AI-chatbots nevner merkevaren din på tvers av ChatGPT, Perplexity og andre plattformer. Få handlingsrettede innsikter for å forbedre din AI-tilstedeværelse.

Lær hva en impresjon er i søkeresultater og AI-overvåking. Forstå hvordan impresjoner telles på tvers av Google Søk, Perplexity, ChatGPT og andre plattformer, o...

Lær hvordan du identifiserer, overvåker og løser AI-innholdstvister når kunstig intelligens genererer unøyaktig eller skadelig informasjon om din merkevare. Opp...

Lær om AI-innholdslisensieringsavtaler som regulerer hvordan kunstig intelligens bruker opphavsrettsbeskyttet innhold. Utforsk lisensieringstyper, nøkkelkompone...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.