Hva er Prompt Engineering for AI-søk – Komplett Guide

Lær hva prompt engineering er, hvordan det fungerer med AI-søkemotorer som ChatGPT og Perplexity, og oppdag essensielle teknikker for å optimalisere dine AI-søk...

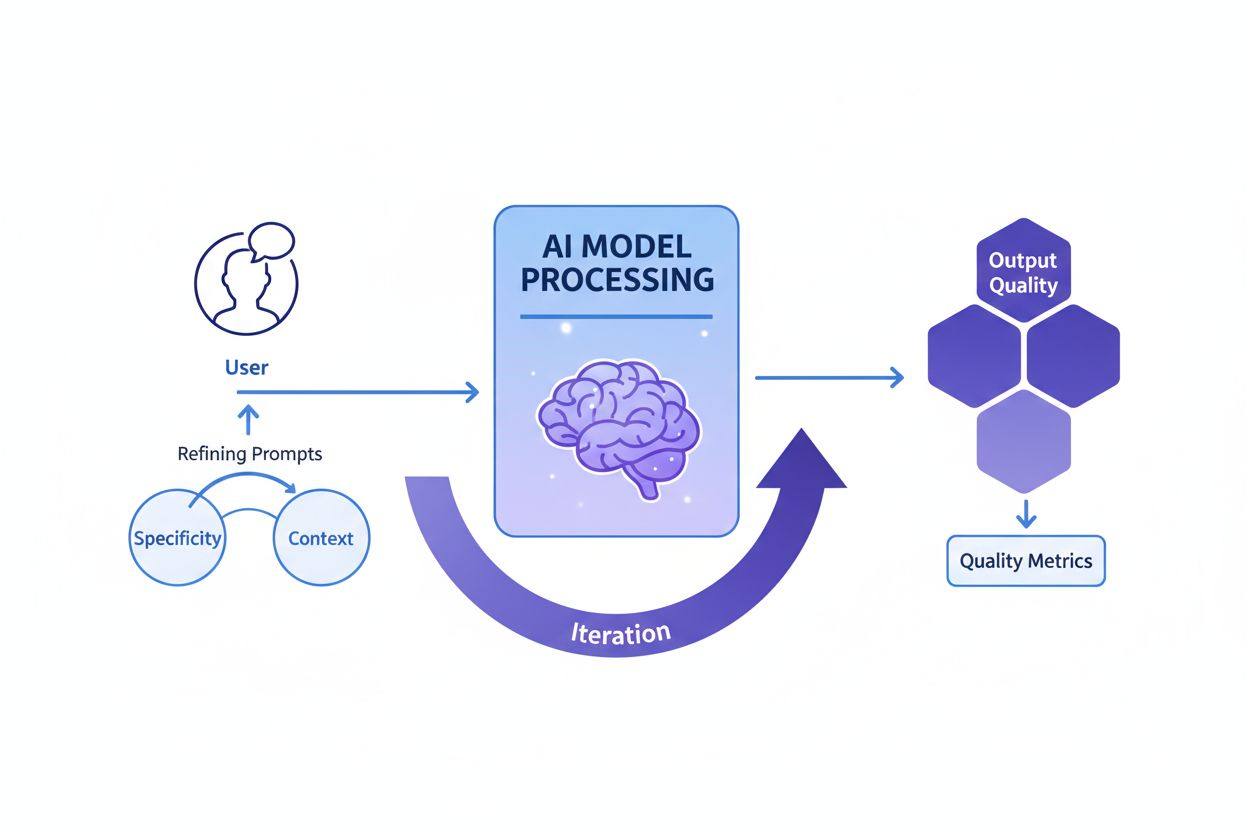

Prompt engineering er prosessen med å utforme, forbedre og optimalisere instruksjoner i naturlig språk for å veilede generative KI-modeller mot å produsere ønskede, nøyaktige og relevante resultater. Det innebærer iterativ eksperimentering med formulering, kontekst og struktur for å maksimere KI-ytelsen uten å endre den underliggende modellen.

Prompt engineering er prosessen med å utforme, forbedre og optimalisere instruksjoner i naturlig språk for å veilede generative KI-modeller mot å produsere ønskede, nøyaktige og relevante resultater. Det innebærer iterativ eksperimentering med formulering, kontekst og struktur for å maksimere KI-ytelsen uten å endre den underliggende modellen.

Prompt engineering er den systematiske prosessen med å designe, forbedre og optimalisere instruksjoner i naturlig språk—kalt prompter—for å veilede generative KI-modeller mot å produsere ønskede, nøyaktige og kontekstuelt relevante resultater. I stedet for å endre den underliggende KI-modellen arbeider prompt-ingeniører med modellens eksisterende egenskaper ved nøye å strukturere innspillene sine for å påvirke hvordan modellen behandler informasjon og genererer svar. Denne disiplinen vokste frem som en kritisk ferdighet under KI-boomen 2023–2025, da organisasjoner innså at tilgang til kraftige KI-verktøy som ChatGPT, Claude, Perplexity og Google AI ikke var tilstrekkelig uten ekspertise i effektiv kommunikasjon med disse systemene. Prompt engineering bygger bro mellom menneskelig hensikt og KI-evne, og omformer vage forretningsmål til handlingsorienterte, høykvalitets KI-resultater. Praksisen er fundamentalt iterativ, og krever kontinuerlig eksperimentering, testing og forbedring for å oppnå optimale resultater for spesifikke bruksområder.

Konseptet prompt engineering oppstod organisk etter den offentlige lanseringen av ChatGPT i november 2022, da millioner av brukere begynte å eksperimentere med hvordan man kunne få bedre resultater fra store språkmodeller. Tidlige brukere oppdaget at kvaliteten på KI-resultater varierte dramatisk basert på hvordan spørsmål ble formulert, hvilken kontekst som ble gitt, og hvor spesifikke instruksjonene var. Denne observasjonen førte til at prompt engineering ble formalisert som en egen disiplin. Innen 2023 begynte store teknologiselskaper som OpenAI, Google, Microsoft og Anthropic å ansette dedikerte prompt-ingeniører, med enkelte stillinger som tilbød lønn over 300 000 dollar. Det globale markedet for prompt engineering ble verdsatt til omtrent 222,1 millioner dollar i 2023, og forventes å nå 2,06 milliarder dollar innen 2030, noe som gir en betydelig årlig vekstrate (CAGR). Denne raske markedsveksten reflekterer økende anerkjennelse av at prompt engineering ikke er en forbigående trend, men en grunnleggende ferdighet for organisasjoner som bruker KI i stor skala. Disiplinen har utviklet seg fra enkel prøving og feiling til en sofistikert praksis med etablerte teknikker, evalueringsrammeverk og beste praksis dokumentert av ledende KI-forskningsinstitusjoner og bransjeeksperter.

Effektiv prompt engineering bygger på flere grunnleggende prinsipper som skiller høykvalitets prompter fra ineffektive. Spesifisitet er avgjørende—jo mer detaljert og beskrivende en prompt er, desto bedre kan KI-modellen forstå de eksakte kravene og generere tilpassede resultater. I stedet for å be KI-en «skriv om hunder», kan en spesifikk prompt be om «skriv en veterinærguide på 300 ord om helseproblemer hos golden retriever for dyreeiere med et leseferdighetsnivå på 8. klasse, med fokus på forebyggende tiltak». Kontekstsikring er like viktig – å gi relevant bakgrunnsinformasjon, eksempler eller begrensninger hjelper modellen med å avgrense fokuset og produsere mer relevante svar. Klarhet sikrer at instruksjonene er entydige og direkte kommuniserer ønsket oppgave uten at modellen må tolke vage formuleringer. Iterativ forbedring anerkjenner at første prompt sjelden gir optimale resultater; dyktige prompt-ingeniører tester kontinuerlig variasjoner, analyserer utfall og justerer tilnærmingen basert på resultatene. Tilpasning av tone og stil innebærer å spesifisere ønsket stemme, formalitetsnivå og presentasjonsformat slik at resultatene matcher organisasjonens eller brukerens forventninger. Disse prinsippene gjelder på tvers av alle KI-plattformer, enten du lager prompter for ChatGPT, Perplexity, Claude eller Google AI Overviews, og er universelt verdifulle for alle som ønsker å optimalisere KI-interaksjoner.

Feltet prompt engineering har utviklet en rekke avanserte teknikker for å håndtere forskjellige oppgavetyper og kompleksitetsnivåer. Zero-shot prompting er den mest direkte tilnærmingen, der KI-en får en klar instruksjon eller et spørsmål uten ekstra eksempler eller kontekst. Denne metoden fungerer godt for enkle oppgaver, men kan slite med komplekse resonnementer. Few-shot prompting forbedrer ytelsen ved å gi modellen ett eller flere eksempler som viser ønsket output-format eller tankemønster, og «lærer» modellen gjennom demonstrasjon. Chain-of-thought (CoT) prompting deler opp komplekse problemer i mellomliggende resonnementstrinn, oppmuntrer modellen til å vise tankegangen og øker nøyaktigheten på flertrinnsoppgaver. Prompt chaining deler opp en kompleks oppgave i mindre, sekvensielle deloppgaver, der output fra én prompt brukes som input til neste, noe som øker pålitelighet og konsistens i kompliserte arbeidsflyter. Tree-of-thought prompting generaliserer chain-of-thought ved å utforske flere mulige resoneringsveier samtidig, slik at modellen kan vurdere ulike tilnærminger før den velger den beste. Maieutisk prompting innebærer å be modellen forklare resonnementet sitt, og deretter stille oppfølgingsspørsmål for å utdype spesifikke deler av forklaringen—nyttig for å avdekke og rette inkonsistenser. Generated knowledge prompting instruerer modellen til først å generere relevante fakta eller bakgrunnsinformasjon før hovedoppgaven, slik at modellen kondisjoneres på nyttig kontekst. Self-refine prompting lar modellen løse et problem, kritisere sin egen løsning og revidere basert på kritikken, gjentatt til tilfredsstillende resultat er oppnådd. Hver teknikk har sitt formål, og den mest effektive prompt engineering kombinerer ofte flere teknikker strategisk tilpasset oppgaven.

| Teknikk | Best egnet for | Kompleksitet | Typisk brukstilfelle | Effektivitet |

|---|---|---|---|---|

| Zero-shot Prompting | Enkle, direkte oppgaver | Lav | Grunnleggende spørsmål, enkle instruksjoner | Bra for enkle oppgaver, begrenset for komplekse resonnementer |

| Few-shot Prompting | Oppgaver som krever formatkonsistens | Medium | Innholdsproduksjon, klassifisering, formatering | Utmerket for å vise ønskede output-mønstre |

| Chain-of-Thought | Flertrinns resonnement | Medium-høy | Matematikk, logisk deduksjon, analyse | Betydelig forbedret nøyaktighet på komplekse oppgaver |

| Prompt Chaining | Komplekse arbeidsflyter med avhengigheter | Høy | Flerstegs innholdsproduksjon, databehandling | Utmerket for å bryte ned komplekse problemer |

| Tree-of-Thought | Problemer med flere løsningsveier | Høy | Strategisk planlegging, kreativ problemløsning | Suverent for å utforske alternative tilnærminger |

| Generated Knowledge | Oppgaver som krever bakgrunnskontekst | Medium | Domenespesifikke spørsmål, tekniske forklaringer | Bedre relevans og nøyaktighet gjennom kontekst |

| Self-Refine | Kvalitetskrevende applikasjoner | Høy | Profesjonell skriving, teknisk dokumentasjon | Gir høyeste kvalitet gjennom iterasjon |

Å forstå hvordan prompter påvirker KI-modellens atferd krever grunnleggende kunnskap om hvordan store språkmodeller (LLMs) fungerer. Disse modellene behandler tekst ved å dele den opp i tokens (små tekstbiter) og forutsi det mest sannsynlige neste token basert på mønstre lært under trening. Prompten fungerer som den innledende konteksten som former alle påfølgende prediksjoner. Når en prompt inneholder spesifikke instruksjoner, eksempler eller begrensninger, snevrer det inn sannsynlighetsfordelingen for mulige utfall, og veileder modellen mot svar som samsvarer med promptens hensikt. Temperature- og top-p sampling-parametere påvirker ytterligere resultatvariasjonen—lav temperatur gir mer deterministiske, fokuserte svar, mens høy temperatur øker kreativitet og variasjon. Kontekstvinduet (hvor mye tekst modellen kan ta hensyn til) begrenser hvor mye informasjon som kan inkluderes i en prompt; lengre prompter bruker mer av dette vinduet og kan redusere plassen til selve oppgaven. Gode prompt-ingeniører forstår disse tekniske begrensningene og utformer prompter som fungerer innenfor dem. For organisasjoner som overvåker merkevaresynlighet på KI-plattformer med verktøy som AmICited, er forståelse av disse mekanismene avgjørende fordi brukernes prompter avgjør hvilken informasjon KI-systemene henter frem og siterer. En godt utformet prompt som ber KI-en «list opp de tre beste selskapene innen skybasert databehandling» vil gi et annet resultat enn «list innovative selskaper innen skybasert databehandling grunnlagt etter 2015», og kan dermed påvirke hvilke merkevarer som får synlighet i KI-genererte svar.

Å implementere effektiv prompt engineering i organisasjoner krever at man følger etablerte beste praksiser fra både akademisk forskning og bransjeerfaring. Start enkelt og iterer er grunnprinsippet—begynn med en enkel prompt og legg gradvis til kompleksitet, med testing på hvert trinn for å se hva som forbedrer resultatene. Vær eksplisitt om krav ved å spesifisere ønsket output-format, lengde, tone og eventuelle begrensninger; vage prompter gir vage resultater. Gi relevant kontekst uten å overvelde modellen; inkluder bakgrunnsinformasjon som hjelper modellen å forstå oppgaven, men unngå unødvendige detaljer som bruker opp kontekstvinduet. Bruk tydelige skilletegn som “###” eller “—” for å skille ulike seksjoner i en prompt (instruksjoner, kontekst, eksempler), slik at modellen lettere kan tolke strukturen. Unngå negasjoner ved å si hva du ønsker, ikke hva du ikke vil ha; i stedet for “ikke vær for formell” bruk “bruk en samtalepreget tone”. Test flere varianter systematisk ved å endre én ting om gangen for å forstå hva som gir bedre resultater. Dokumenter vellykkede prompter i et sentralt bibliotek, slik at teamet kan gjenbruke og tilpasse testede maler. Overvåk ytelsesmålinger som nøyaktighet, relevans, konsistens og brukertilfredshet for å vurdere om prompter oppnår ønsket effekt. Inkluder tilbakemeldingssløyfer der brukerfeedback direkte informerer promptforbedringer, og skaper en kontinuerlig forbedringsprosess. Organisasjoner som implementerer disse praksisene rapporterer betydelige forbedringer i kvalitet og konsistens på KI-resultater, samt redusert tid brukt på manuelle korreksjoner og revisjoner.

Forholdet mellom prompt engineering og KI-synlighetsovervåking blir stadig viktigere for organisasjoner som ønsker innsikt i hvordan deres merkevarer, produkter og innhold fremstår i KI-genererte svar. Plattformer som AmICited sporer merkevarenevnelser på ChatGPT, Perplexity, Google AI Overviews og Claude, men det er brukernes prompter i disse systemene som bestemmer hvilken informasjon KI-en henter frem og siterer. Organisasjoner som forstår prompt engineering kan lage strategiske spørsmål for å avdekke hvordan merkevaren presenteres, hvilke konkurrenter som nevnes samtidig, og hvorvidt innholdet siteres korrekt. For eksempel kan et selskap utforme prompter som «hva er de beste løsningene for databehandling i virksomheter?» for å se hvordan KI-systemene plasserer deres produkter i forhold til konkurrenter. Ved å analysere hvilke prompter som gir gunstige eller ugunstige nevnelser, kan organisasjoner utvikle innholdsstrategier som forbedrer synligheten i KI-genererte svar. Dette representerer en ny grense innen søkemotoroptimalisering (SEO) og merkevarebygging, der evnen til å kommunisere med KI-systemer blir like viktig som tradisjonell søkeordoptimalisering. Selskaper som investerer i prompt engineering får strategiske fordeler i det KI-drevne informasjonslandskapet, og sikrer at deres merkevarer får riktig synlighet og korrekt representasjon.

Å måle om en prompt virkelig er effektiv krever tydelige, objektive kriterier tilpasset spesifikke forretningsmål. Nøyaktighet måler om svarene er faktiske riktige, spesielt viktig i helse, finans og jus der feil kan få store konsekvenser. Relevans vurderer hvor tett svaret samsvarer med brukerens opprinnelige hensikt, ofte målt med semantiske likhetsskår eller manuell evaluering. Konsistens vurderer om identiske prompter gir like svar over flere forsøk, avgjørende for applikasjoner som krever forutsigbarhet. Fullstendighet avgjør om svarene dekker alle nødvendige elementer eller informasjon, målt som andel dekkede komponenter av totalt påkrevde. Spesifisitet vurderer detaljnivået i svarene, viktig for teknisk dokumentasjon og spesialiserte områder. Lesbarhet og sammenheng måler klarhet og logisk flyt, vurdert med lesbarhetsformler eller menneskelig evaluering. Brukertilfredshet reflekterer hvor fornøyde sluttbrukerne er med svarene, typisk samlet inn via spørreundersøkelser eller innebygde tilbakemeldingsmekanismer. Organisasjoner som implementerer omfattende evalueringsrammeverk rapporterer at prompeffektiviteten forbedres med 40–60 % gjennom systematisk måling og forbedring. Verktøy som Portkey, DSPy og Hugging Face’s Evaluate Library gir automatiske måltall for disse dimensjonene, mens A/B-testplattformer muliggjør sammenligning av ulike prompt-versjoner. De mest sofistikerte organisasjonene kombinerer flere evalueringsmetoder og vekter måltall etter egne prioriteringer for å gi en samlet kvalitetsscore.

Jobbmarkedet for prompt engineering har hatt eksplosiv vekst, noe som gjenspeiler hvor avgjørende denne ferdigheten er i KI-tiden. Per 2025 rapporterer Glassdoor en gjennomsnittlig grunnlønn på cirka 123 274 dollar årlig for prompt-ingeniører, med stillinger fra 90 000 på 25. persentil til over 335 000 for spesialroller hos ledende KI-selskaper som Anthropic. Indeed lister over 110 000 ledige stillinger som prompt-ingeniør, noe som viser vedvarende etterspørsel på tvers av bransjer. Store teknologiselskaper som Google, Microsoft, Amazon og Meta rekrutterer aktivt prompt-ingeniører med lønn fra 110 000–250 000 dollar. KI-fokuserte selskaper som OpenAI, Anthropic, Cohere og Midjourney tilbyr utfordrende oppgaver med fjernarbeid og betydelige aksjepakker. Større virksomheter innen finans, helse, forsikring og andre regulerte sektorer ansetter prompt-ingeniører for KI-integrasjon, ofte med titler som “AI Solutions Architect”. Konsulentselskaper inkludert de fire store og spesialiserte aktører som Booz Allen Hamilton lyser ut stillinger opptil 212 000 dollar for offentlig og privat sektor. Frilansmuligheter på plattformer som Upwork og Toptal gir 100–300 dollar i timen for erfarne fagfolk. Karriereveien krever vanligvis bachelorgrad i informatikk eller lignende, men folk med bakgrunn fra skriving, journalistikk og kreative fag har også lykkes. Viktigst av alt er dokumenterbare ferdigheter med KI-verktøy, en portefølje som viser prompt engineering-evner og kontinuerlig læring etter hvert som feltet utvikler seg.

Prompt engineering står foran betydelig utvikling etter hvert som KI-teknologi og organisasjonspraksis modnes. Multimodal prompting vil i økende grad kombinere tekst, kode, bilder og andre datatyper i én prompt, og krever at ingeniører forstår hvordan ulike modaliteter samspiller i KI-systemer. Adaptive prompter som automatisk justerer seg etter kontekst, brukeradferd og sanntidsfeedback blir mer avanserte, og beveger seg fra statiske maler til dynamiske, responsive systemer. Kontekst engineering vokser frem som en videreføring av prompt engineering, med vekt på den bredere konteksten prompter opererer i, ikke bare selve teksten. Etikk- og rettferdighetsfokusert prompting vil bli viktigere etter hvert som organisasjoner prioriterer ansvarlig KI-bruk, med prompter eksplisitt utformet for å redusere skjevheter, sikre åpenhet og etterleve regulatoriske krav. Integrasjon med KI-agenter vil viske ut skillet mellom prompt engineering og bredere KI-orkestrering, ettersom prompter blir komponenter i større autonome systemer. Rollen “prompt-ingeniør” kan utvikle seg eller smelte sammen med tilstøtende roller som “KI-strateg”, “kontekst-ingeniør” eller “KI-produktleder”, i takt med modningen av feltet. Organisasjoner som investerer i prompt engineering-kompetanse nå vil være godt posisjonert for å lede an i den KI-drevne økonomien, ettersom evnen til å kommunisere effektivt med og veilede KI-systemer blir stadig viktigere for konkurransekraft. For selskaper som bruker AmICited til å overvåke merkevaresynlighet i KI-svar, vil prompt engineering-kunnskap bli essensiell for å optimalisere deres tilstedeværelse i KI-søkelandskapet og sikre korrekt representasjon på plattformer som ChatGPT, Perplexity, Google AI og Claude.

Prompt engineering skiller seg grunnleggende fra tradisjonell programmering: I stedet for å skrive eksplisitt kode som direkte styrer oppførselen, veileder prompt-ingeniører KI-modeller gjennom instruksjoner i naturlig språk. Tradisjonell programmering krever presis syntaks og logikk, mens prompt engineering bygger på iterativ forbedring, konteksttilførsel og strategisk formulering for å styre KI-resultatene mot ønsket utfall. Begge krever problemløsningsferdigheter, men prompt engineering legger vekt på kommunikasjon og eksperimentering fremfor streng kodesyntaks.

Prompt engineering påvirker direkte hvordan merkevarer fremstår i KI-genererte svar på plattformer som ChatGPT, Perplexity, Google AI Overviews og Claude. Godt utformede prompter kan avgjøre om og hvordan KI-systemer siterer, nevner eller anbefaler merkevarer. For organisasjoner som bruker verktøy som AmICited for å overvåke KI-synlighet, hjelper forståelsen av prompt engineering med å forutsi og optimalisere hvordan merkevaren vises i KI-responser, og sikrer korrekt representasjon og konkurransedyktig posisjonering i KI-søkelandskapet.

Nøkkel-teknikker inkluderer chain-of-thought prompting (dele opp komplekse problemer i trinn), few-shot prompting (gi eksempler), zero-shot prompting (direkte instruksjoner), prompt chaining (dele opp oppgaver i deloppgaver) og tree-of-thought prompting (utforske flere resoneringsveier). Effektiviteten til hver teknikk avhenger av oppgavens kompleksitet, modellens evner og ønsket output-type. De mest vellykkede implementeringene kombinerer ofte flere teknikker tilpasset spesifikke bruksområder.

Effektiviteten til en prompt måles med metrikker som nøyaktighet (faktisk korrekthet), relevans (samsvar med hensikt), konsistens (reproduserbarhet), fullstendighet (dekning av nødvendige elementer) og brukertilfredshet. Evalueringsmetoder inkluderer manuell gjennomgang, automatisert vurdering med verktøy som BLEU- og ROUGE-score, A/B-testing av ulike prompt-versjoner og innsamling av direkte brukerfeedback. Organisasjoner kombinerer ofte flere metrikker i en vektet score som reflekterer deres spesifikke prioriteringer.

Prompt-ingeniører trenger sterke kommunikasjons- og skriveferdigheter, forståelse for hvordan store språkmodeller fungerer, kjennskap til KI-begreper som tokenisering og kontekstvinduer, samt kreative problemløsningsevner. Tekniske ferdigheter i Python, SQL eller JavaScript er ofte en fordel, men ikke alltid et krav. Domenekompetanse i spesifikke bransjer (helse, finans, jus) gir høyere lønn. Viktigst av alt viser suksessrike prompt-ingeniører kontinuerlig læring og eksperimentering.

Prompt engineering er avgjørende for KI-overvåking fordi prompter brukerne legger inn i KI-systemer bestemmer hvilken informasjon systemene henter frem og siterer. Ved å forstå prompt engineering kan organisasjoner lage spørsmål som hjelper dem å oppdage hvordan deres merkevare, innhold eller domene fremstår i KI-responser. AmICited sporer disse forekomstene på tvers av flere KI-plattformer, noe som gjør prompt engineering-kunnskap essensiell for å optimalisere merkevaresynlighet i KI-generert innhold.

Arbeidsmarkedet for prompt-ingeniører er fortsatt sterkt, med gjennomsnittslønn på rundt 123 274 dollar årlig ifølge Glassdoor, og stillinger fra 90 000 til over 335 000 dollar avhengig av erfaring og selskap. Over 110 000 stillinger som prompt-ingeniør er for tiden utlyst på jobbportaler. Feltet utvikler seg fra en spesialisert rolle mot bredere KI-integrasjonsansvar, med muligheter i teknologiselskaper, virksomheter, konsulenter og frilansplattformer. Fjernarbeid er utbredt, slik at geografisk plassering er mindre begrensende.

Prompt engineering forventes å utvikle seg mot multimodal prompting (kombinere tekst, kode og bilder), adaptive prompter som justerer seg etter kontekst, og økt fokus på KI-etikk og rettferdighet. Etter hvert som KI-modeller blir mer kapable, kan prompt engineering smelte sammen med bredere KI-strategi- og kontekst engineering-roller. Feltet vil sannsynligvis vektlegge ansvarlig KI-praksis, reduksjon av skjevheter og sikre åpenhet i KI-genererte resultater på tvers av plattformer som overvåkes av AmICited.

Begynn å spore hvordan AI-chatbots nevner merkevaren din på tvers av ChatGPT, Perplexity og andre plattformer. Få handlingsrettede innsikter for å forbedre din AI-tilstedeværelse.

Lær hva prompt engineering er, hvordan det fungerer med AI-søkemotorer som ChatGPT og Perplexity, og oppdag essensielle teknikker for å optimalisere dine AI-søk...

Lær hvordan prompt engineering forbedrer GEO-strategien din for å få merkevaren din sitert av AI-søkemotorer som ChatGPT, Perplexity og Google AI Overviews.

Diskusjon i fellesskapet om hvorvidt markedsførere trenger ferdigheter i prompt engineering for å optimalisere for AI-søk. Forståelse av hvordan brukere stiller...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.