JavaScript SEO

JavaScript SEO optimaliserer JavaScript-rendret nettsteder for søkemotorindeksering og crawling. Lær beste praksis, gjengivelsesmetoder og strategier for å øke ...

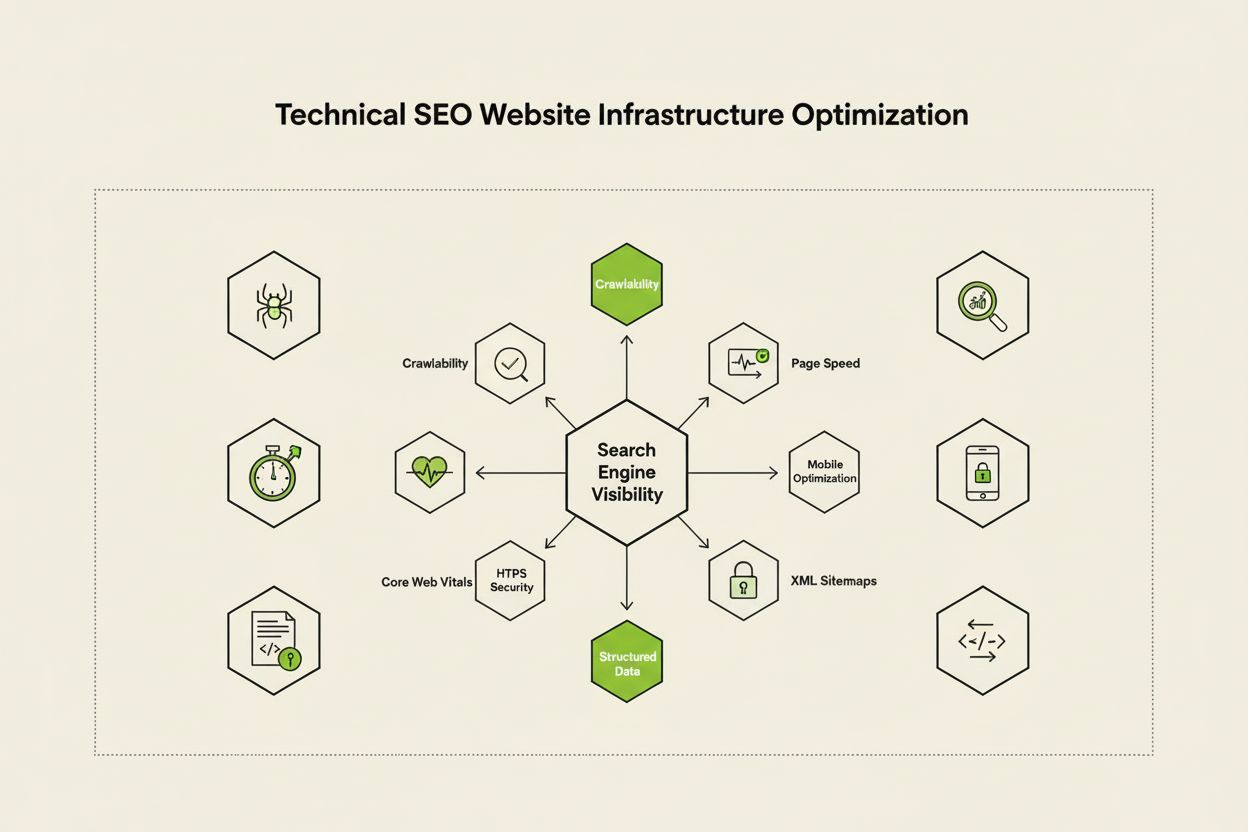

Teknisk SEO er prosessen med å optimalisere et nettsteds infrastruktur slik at søkemotorer kan gjennomsøke, gjengi, indeksere og levere innhold korrekt og effektivt. Det omfatter nettstedets hastighet, mobilvennlighet, nettstedsarkitektur, sikkerhet og implementering av strukturert data for å sikre at søkemotorer kan oppdage og rangere sidene dine.

Teknisk SEO er prosessen med å optimalisere et nettsteds infrastruktur slik at søkemotorer kan gjennomsøke, gjengi, indeksere og levere innhold korrekt og effektivt. Det omfatter nettstedets hastighet, mobilvennlighet, nettstedsarkitektur, sikkerhet og implementering av strukturert data for å sikre at søkemotorer kan oppdage og rangere sidene dine.

Teknisk SEO er prosessen med å optimalisere et nettsteds bakgrunnsinfrastruktur for å sikre at søkemotorer effektivt kan gjennomsøke, gjengi, indeksere og levere innholdet korrekt. I motsetning til on-page SEO, som fokuserer på innholdskvalitet og nøkkelordsoptimalisering, adresserer teknisk SEO de grunnleggende elementene som avgjør om søkemotorer i det hele tatt kan få tilgang til og forstå nettstedet ditt. Dette inkluderer nettstedshastighet, mobiltilpasning, nettstedsarkitektur, sikkerhetsprotokoller, implementering av strukturert data og crawlability-faktorer. Teknisk SEO fungerer som det usynlige fundamentet alle andre SEO-tiltak er avhengige av—uten dette forblir selv det beste innholdet usynlig for søkemotorer og brukere. Ifølge bransjeundersøkelser rapporterte 91 % av markedsførere at SEO forbedret nettstedets ytelse i 2024, hvor teknisk optimalisering spilte en avgjørende rolle i å oppnå målbare resultater. Betydningen av teknisk SEO har økt etter hvert som søkemotorene blir mer sofistikerte og AI-drevne søkeplattformer dukker opp, noe som krever at nettsteder oppfyller stadig strengere tekniske standarder for synlighet.

Teknisk SEO hviler på fire sammenkoblede søyler som jobber sammen for å maksimere synligheten i søkemotorer. Crawlability avgjør om Googlebot og andre søkemotorroboter kan få tilgang til sidene dine via lenker, sitemaps og interne navigasjonsstrukturer. Indekserbarhet sikrer at gjennomsøkte sider faktisk blir lagret i Googles indeks og kan vises i søkeresultatene. Ytelse og Core Web Vitals måler hvor raskt sidene lastes og hvor responsive de er for brukerinteraksjoner—faktorer som direkte påvirker rangering og brukeropplevelse. Mobiloptimalisering sørger for at nettstedet ditt fungerer feilfritt på smarttelefoner og nettbrett, som nå står for over 60 % av all søketrafikk ifølge Sistrix-forskning. Disse fire søylene er avhengige av hverandre; svakhet i ett område kan svekke effekten av de andre. For eksempel vil et raskt lastende skrivebordsnettsted som fungerer dårlig på mobil ha problemer med å rangere i Googles mobile-first-indeks, uansett hvor godt crawlability er optimalisert. Å forstå hvordan disse søylene samhandler er avgjørende for å utvikle en helhetlig teknisk SEO-strategi som dekker alle aspekter av synlighet i søkemotorer.

Selv om de ofte forveksles, representerer crawlability og indekserbarhet to ulike stadier i søkemotorprosessen. Crawlability handler om hvorvidt en søkemotor kan oppdage og få tilgang til sidene dine ved å følge interne lenker, eksterne lenker og XML-sitemaps. Det svarer på spørsmålet: “Kan Googlebot nå denne siden?” Hvis en side ikke er crawlbar—kanskje fordi den er blokkert av robots.txt, skjult bak JavaScript eller foreldreløs uten interne lenker—kan den ikke gå videre til indekseringsstadiet. Indekserbarhet, derimot, avgjør om en gjennomsøkt side faktisk blir lagret i Googles indeks og kan vises i søkeresultater. En side kan være fullstendig crawlbar, men likevel ikke indeksert hvis den inneholder en noindex-metatag, har duplisert innhold eller ikke oppfyller Googles kvalitetskrav. Ifølge Search Engine Lands omfattende tekniske SEO-guide er det avgjørende å forstå denne forskjellen fordi løsningen på crawlability-problemer er annerledes enn for indekseringsproblemer. Crawlability-problemer handler ofte om nettstedsstruktur, robots.txt-konfigurasjon og intern lenking, mens indekserbarhetsproblemer ofte gjelder metatagger, kanoniske tagger, innholdskvalitet og gjengivelsesproblemer. Begge må adresseres for å oppnå optimal synlighet i søk.

Core Web Vitals er tre spesifikke måleparametere som Google bruker for å måle reell brukeropplevelse og som direkte påvirker rangeringene. Largest Contentful Paint (LCP) måler hvor raskt det største synlige elementet på en side lastes—Google anbefaler en LCP på 2,5 sekunder eller mindre. Interaction to Next Paint (INP), som erstattet First Input Delay i 2024, måler hvor responsiv en side er for brukerinteraksjoner som klikk og trykk—målet er under 200 millisekunder. Cumulative Layout Shift (CLS) måler visuell stabilitet ved å spore uventede layout-endringer under lasting—en score under 0,1 regnes som bra. Forskning fra DebugBear viser at nettsteder må ha 75 % av brukerne med “God” ytelse på alle tre parametere for å få maksimalt rangeringsutbytte. Overgangen til INP som rangeringsfaktor gjenspeiler Googles satsing på å vurdere generell siderespons gjennom hele brukerens interaksjon, ikke bare ved første lasting. Å optimalisere Core Web Vitals krever en bred tilnærming: Forbedring av LCP innebærer bildeoptimalisering, bruk av CDN og utsettelse av ikke-kritisk JavaScript; forbedring av INP krever oppdeling av tunge JavaScript-oppgaver og optimalisering av event handlers; reduksjon av CLS handler om å reservere plass til dynamisk innhold og unngå annonser som flytter layout. Disse måleparametrene er blitt ufravikelige for konkurransedyktig SEO, da sider med dårlige Core Web Vitals får rangeringsstraff og høyere fluktfrekvens.

Nettstedsarkitektur refererer til hvordan sidene på nettstedet ditt er organisert, strukturert og koblet sammen gjennom interne lenker. En godt utformet arkitektur har flere viktige funksjoner: Den hjelper søkemotorer å forstå innholdshierarkiet ditt, fordeler lenkekraft (rangeringseffekt) på tvers av nettstedet, sikrer at viktige sider er lett å finne, og forbedrer brukernavigasjonen. Den ideelle nettstedsarkitekturen følger et tydelig hierarki med forsiden øverst, kategorisider på andre nivå, og individuelle innholdssider dypere ned. Beste praksis tilsier at alle viktige sider bør være tilgjengelige innen tre klikk fra forsiden, slik at Googlebot ikke sløser crawl budget på dype, isolerte sider. Interne lenker fungerer som bindevevet i arkitekturen, og leder både brukere og søkemotorer gjennom innholdet ditt. Strategisk internlenking samler rangeringssignaler på prioriterte sider, etablerer tematiske relasjoner mellom beslektet innhold, og hjelper søkemotorene å forstå hvilke sider som er viktigst. For eksempel skaper en hub-og-eker-modell—hvor en omfattende hovedside lenker til flere relaterte undersider, som igjen lenker tilbake til hovedsiden—en kraftig struktur som signaliserer tematisk autoritet til søkemotorer. Dårlig nettstedsarkitektur, med foreldreløse sider, inkonsekvent navigasjon og dype nestinger, tvinger søkemotorer til å sløse crawl budget på mindre viktig innhold og gjør det vanskelig å bygge tematisk autoritet. Selskaper som restrukturerer nettstedsarkitekturen opplever ofte drastiske forbedringer i indekseringshastighet og rangeringsytelse.

Mobile-first-indeksering betyr at Google primært bruker mobilversjonen av nettstedet ditt for gjennomsøking, indeksering og rangering—ikke skrivebordsversjonen. Dette grunnleggende skiftet gjenspeiler at over 60 % av alle søk nå kommer fra mobile enheter. For teknisk SEO betyr det at mobilopplevelsen må være feilfri: responsivt design som tilpasser seg alle skjermstørrelser, berøringsvennlig navigasjon med god avstand mellom klikkbare elementer, lesbar skriftstørrelse uten zoom og raske lastetider optimalisert for mobilnett. Responsivt design bruker fleksible oppsett og bilder for å tilpasse seg automatisk til ulike skjermstørrelser, og sikrer jevn funksjonalitet på tvers av enheter. Vanlige feil med mobiloptimalisering inkluderer påtrengende pop-ups som blokkerer hovedinnhold, tekst som er for liten til å leses uten zoom, knapper som er for tett sammen til nøyaktig berøring, og sider som laster sakte på mobilnett. Googles Mobile-Friendly Test og Lighthouse-analyser kan avdekke slike problemer, men testing på faktiske mobile enheter er fortsatt avgjørende. Forholdet mellom mobiloptimalisering og rangering er direkte: Sider med dårlig mobilopplevelse får rangeringsstraff, mens sider optimalisert for mobil får bedre synlighet. For nettbutikker, SaaS-plattformer og innholdsaktører er mobiloptimalisering ikke valgfritt—det er grunnleggende for konkurransedyktig synlighet i søk.

XML-sitemaps fungerer som veikart for søkemotorer, og lister opp alle URL-ene du vil ha indeksert sammen med metadata som sist endret-dato og prioritet. En godt vedlikeholdt sitemap bør kun inneholde kanoniske, indekserbare URL-er—og utelukke omdirigeringer, 404-sider og duplisert innhold. Robots.txt er en tekstfil i rotmappen på nettstedet ditt som gir instruksjoner til søkemotor-roboter om hvilke kataloger og filer de kan og ikke kan få tilgang til. Robots.txt kan blokkere gjennomsøking, men det hindrer ikke nødvendigvis indeksering hvis siden oppdages på andre måter; bruk noindex-metatagger for reell ekskludering. Crawl budget refererer til hvor mange sider Googlebot vil gjennomsøke på nettstedet ditt innenfor en gitt periode—en begrenset ressurs som må styres strategisk. Store nettsteder med millioner av sider må optimalisere crawl budget ved å sikre at Googlebot fokuserer på innhold med høy verdi, fremfor å sløse ressurser på sider med lav prioritet, duplisert innhold eller variasjoner fra filtrert navigasjon. Vanlig crawl budget-sløsing skjer når søkeparametre genererer endeløse URL-variasjoner, når staging- eller utviklingsmiljøer er åpne for roboter, eller når tynt innhold får for mange interne lenker. Ifølge Googles offisielle retningslinjer er crawl budget-styring spesielt viktig for store nettsteder, da ineffektiv gjennomsøking kan forsinke oppdagelsen og indekseringen av nytt eller oppdatert innhold. Verktøy som Google Search Console sin Crawl Stats-rapport og serverlogganalyse viser nøyaktig hvilke sider Googlebot besøker og hvor ofte, og muliggjør datadrevet optimalisering av crawl budget.

Strukturert data, implementert ved hjelp av schema markup, hjelper søkemotorer å forstå meningen og konteksten til innholdet ditt utover enkel tekstanalyse. Schema markup bruker standardiserte vokabularer (fra schema.org) for å merke ulike innholdstyper—produkter, artikler, oppskrifter, arrangementer, lokale virksomheter og mer. Når det implementeres riktig, muliggjør schema markup utvidede resultater i søk, hvor Google viser forbedret informasjon som stjernerangering, priser, koketider eller arrangementsdatoer direkte i søkeresultatene. Denne økte synligheten kan gi betydelig bedre klikkrater og brukerengasjement. Ulike innholdstyper krever ulike schema-implementeringer: Article schema for blogginnlegg og nyhetsinnhold, Product schema for nettbutikksider, FAQ schema for ofte stilte spørsmål, Local Business schema for fysiske butikker, og Event schema for kommende arrangementer. Implementering skjer vanligvis med JSON-LD-format, som er Googles foretrukne metode. Schema markup må imidlertid nøyaktig reflektere faktisk innhold på siden—villedende eller oppdiktet schema kan føre til manuelle straffer. Ifølge forskning fra Search Engine Land kvalifiserer kun sider med gyldig og relevant schema markup for utvidede resultater, og implementeringsnøyaktighet er derfor kritisk. Organisasjoner som implementerer omfattende schema markup på sine viktigste sider opplever ofte bedre synlighet både i tradisjonelle søkeresultater og AI-drevne søkeplattformer, da disse systemene er avhengige av strukturert data for å forstå og sitere innhold korrekt.

HTTPS (Hypertext Transfer Protocol Secure) krypterer data som overføres mellom brukernes nettlesere og din webserver, beskytter sensitiv informasjon og signaliserer pålitelighet både for brukere og søkemotorer. Google har bekreftet at HTTPS er en rangeringsfaktor, og nettsteder uten HTTPS får både direkte rangeringsstraff og indirekte konsekvenser som nettleservarsler som fraråder brukere fra å besøke dem. Implementering av HTTPS krever at du skaffer et SSL/TLS-sertifikat fra en pålitelig sertifikatutsteder og konfigurerer serveren til å bruke HTTPS for alle sider. Utover grunnleggende HTTPS-implementering gir sikkerhetsheadere som Content-Security-Policy, Strict-Transport-Security og X-Content-Type-Options ekstra beskyttelse mot vanlige netttrusler. Mixed content-feil—hvor HTTPS-sider laster HTTP-ressurser—undergraver sikkerheten og kan utløse nettleservarsler. Forholdet mellom sikkerhet og SEO strekker seg utover rangering: sikre nettsteder bygger brukertillit, reduserer fluktfrekvens og gir bedre konverteringer. For nettbutikker som håndterer betalinger, SaaS-plattformer med brukerdata og alle nettsteder som samler inn personopplysninger, er sikkerhet ikke valgfritt. Regelmessige sikkerhetsrevisjoner med verktøy som Google Search Console sin rapport om sikkerhetsproblemer og tredjeparts sårbarhetsskannere bidrar til å identifisere og løse sikkerhetsproblemer før de påvirker rangering eller brukertillit.

| Aspekt | Teknisk SEO | On-Page SEO | Off-Page SEO |

|---|---|---|---|

| Hovedfokus | Nettstedsinfrastruktur, hastighet, crawlability, indekserbarhet | Innholdskvalitet, nøkkelord, metatagger, overskrifter | Tilbakekoblinger, merkevareomtaler, sosiale signaler |

| Søkemotortilgang | Sikrer at søkemotorer kan gjennomsøke og indeksere sider | Hjelper søkemotorer å forstå sidens relevans | Bygger autoritet og tillitssignaler |

| Nøkkelfaktorer | Nettstedshastighet, mobiloptimalisering, Core Web Vitals, nettstedsarkitektur, HTTPS, strukturert data | Nøkkelordsplassering, innholdsdypde, intern lenking, metabeskrivelser | Tilbakekoblingsprofil, domenemyndighet, merkevareomtaler |

| Verktøy | PageSpeed Insights, Google Search Console, Screaming Frog, Lighthouse | Yoast SEO, Surfer SEO, Content Genius | Ahrefs, Semrush, Moz, Majestic |

| Rangeringspåvirkning | Grunnleggende—uten dette kan ikke sider rangeres | Direkte—forbedrer relevans for målnøkkelord | Betydelig—bygger autoritet og tillit |

| Innvirkning på brukeropplevelse | Høy—påvirker sidehastighet, mobilbrukervennlighet, tilgjengelighet | Middels—påvirker lesbarhet og engasjement | Lav—indirekte gjennom merkevareopplevelse |

| Implementeringstid | Løpende—krever kontinuerlig overvåking og optimalisering | Løpende—krever innholdsoppdateringer og optimalisering | Langsiktig—krever vedvarende linkbuilding |

| ROI-måling | Crawlingeffektivitet, indekseringsrate, Core Web Vitals-score, rangeringer | Nøkkelordsrangeringer, organisk trafikk, klikkrater | Tilbakekoblingsvekst, domenemyndighet, henvisningstrafikk |

JavaScript SEO adresserer de unike utfordringene JavaScript-tunge nettsteder, single-page applications (SPA) og dynamisk gjengivelse gir. Historisk sett slet Googlebot med JavaScript fordi det krevde gjengivelse—å kjøre JavaScript-kode for å bygge den endelige siden—noe som la til kompleksitet og forsinkelse i gjennomsøkingsprosessen. Moderne Googlebot gjengir nå de fleste sider før indeksering, men denne prosessen introduserer nye hensyn for teknisk SEO. Server-side rendering (SSR) genererer komplett HTML på serveren før den sendes til nettleseren, slik at søkemotorer umiddelbart ser alt innhold uten å vente på JavaScript. Statisk nettsteds-generering (SSG) forhåndsgjengir sider ved bygging, og lager statiske HTML-filer som lastes umiddelbart. Dynamisk gjengivelse gir forhåndsgjengitt HTML til søkemotorer, mens brukere får JavaScript, men Google har uttalt at dette er en midlertidig løsning. Det viktigste prinsippet: alt essensielt innhold, metatagger og strukturert data bør være synlig i den opprinnelige HTML-en, ikke lastes dynamisk etter JavaScript-kjøring. Sider som skjuler kritisk innhold bak JavaScript risikerer ufullstendig eller forsinket indeksering. React-, Vue- og Angular-rammeverk krever spesiell oppmerksomhet—mange organisasjoner som bruker disse implementerer Next.js eller Nuxt.js spesifikt for å håndtere server-side rendering og forbedre SEO-ytelsen. Testing av hvordan Googlebot ser sidene dine med Google Search Console sin URL-inspeksjon og gjengitt forhåndsvisning avslører om JavaScript-avhengig innhold blir korrekt indeksert.

Effektiv implementering av teknisk SEO krever en systematisk tilnærming som prioriterer optimaliseringer med høyest effekt. Start med grunnleggende elementer: Sørg for at nettstedet ditt er crawlbar ved å sjekke robots.txt og intern lenking, verifiser at viktige sider er indekserbare ved å sjekke for noindex-tagger og kanoniske problemer, og etabler et utgangspunkt for Core Web Vitals-ytelse. Deretter, adresser ytelsesoptimalisering: Komprimer og optimaliser bilder, implementer lazy loading for innhold under folden, utsett ikke-kritisk JavaScript, og bruk Content Delivery Networks (CDN) for raskere innholdslevering. Så, optimaliser nettstedsstruktur: Sørg for at viktige sider er innen tre klikk fra forsiden, implementer brødsmulenavigasjon med schema markup, og skap klare interne lenkemønstre som leder både brukere og søkemotorer. Implementer strukturert data for dine viktigste innholdstyper—produkter, artikler, lokal bedriftsinformasjon eller arrangementer—med JSON-LD-format og valider med Googles Rich Results Test. Overvåk kontinuerlig med Google Search Console for indekseringsproblemer, PageSpeed Insights for Core Web Vitals og serverlogger for gjennomsøkingsmønstre. Etabler ansvarlighet ved å spore nøkkelparametere som antall indekserte sider, Core Web Vitals-score og crawlingeffektivitet over tid. Organisasjoner som behandler teknisk SEO som en kontinuerlig prosess fremfor et engangsprosjekt overgår jevnlig konkurrentene på synlighet i søk og brukeropplevelse.

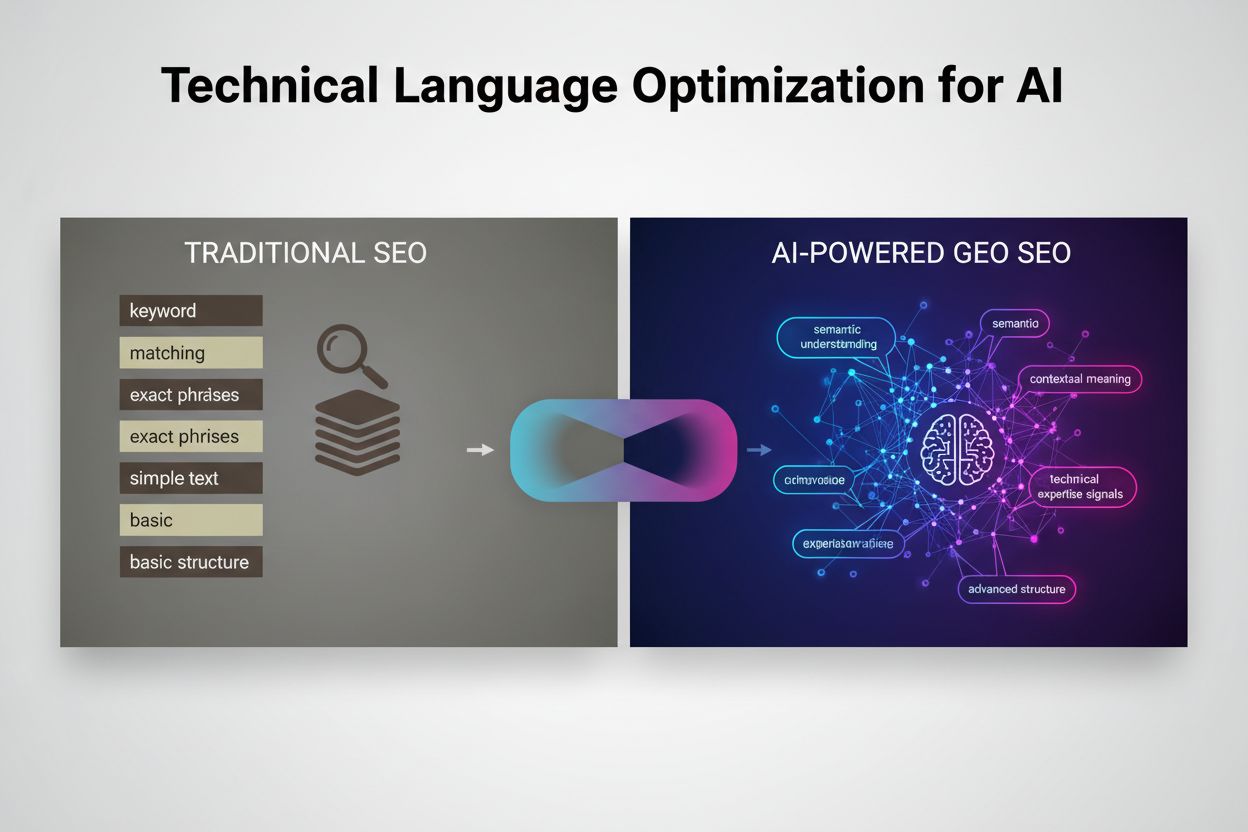

Etter hvert som AI-drevne søkeplattformer som Google AI Overviews, Perplexity, ChatGPT og Claude blir stadig mer fremtredende, har betydningen av teknisk SEO blitt utvidet utover tradisjonelt Google-søk. Disse AI-systemene er avhengige av riktig indeksert, godt strukturert innhold fra søkemotorindekser for å generere svar og siteringer. Teknisk SEO sikrer at innholdet ditt er oppdagbart og korrekt tolket av AI-systemer gjennom flere mekanismer: Riktig indeksering gjør innholdet tilgjengelig for AI-opplæring og -henting, strukturert data hjelper AI-systemer å forstå kontekst og mening, og semantisk rikdom gjør at AI-systemer gjenkjenner innholdet ditt som autoritativt og relevant. Ifølge forskning fra Conductor og Botify kommer sider som vises i AI Overviews ofte fra godt indekserte, teknisk solide nettsteder med sterke semantiske signaler. Forholdet er toveis: Tradisjonell SEO fokuserer på rangering for spesifikke nøkkelord, mens AI-søk fokuserer på å gi omfattende svar som kan sitere flere kilder. Dette skiftet betyr at teknisk SEO må støtte begge paradigmer—sikre at sider indekseres for tradisjonelt søk, samtidig som de er semantisk rike nok for at AI-systemer kan gjenkjenne og sitere dem. Organisasjoner som overvåker synligheten på tvers av flere AI-plattformer med verktøy som AmICited kan identifisere hvilke tekniske optimaliseringer som mest effektivt forbedrer siteringsrater og synlighet i generative søkeresultater.

Effektiv teknisk SEO krever sporing av spesifikke parametere som indikerer nettstedets helse og søkemotor-tilgjengelighet. Antall indekserte sider viser hvor mange av de tiltenkte sidene dine som faktisk er lagret i Googles indeks—sammenligning med totalt antall indekserbare sider gir din indeks-effektivitetsrate. Crawlingeffektivitet måler hvor effektivt Googlebot bruker sitt crawl budget, beregnet ved å dele antall gjennomsøkte sider på totalt antall sider på nettstedet. Core Web Vitals-score indikerer brukeropplevelseskvalitet for lastetid (LCP), interaktivitet (INP) og visuell stabilitet (CLS). Mobilbrukervennlighetsproblemer sporet i Google Search Console avslører feil som små trykkflater, feil i viewport-konfigurasjon, eller påtrengende pop-ups. Lengde på omdirigeringskjeder bør minimeres for å bevare lenkekraft og redusere crawl-forsinkelser. Dekning av strukturert data viser hvor stor andel av sidene dine som har gyldig schema markup. Sidehastighetsparametere som First Contentful Paint (FCP), Time to Interactive (TTI) og Total Blocking Time (TBT) gir detaljert ytelsesinnsikt. Organisasjoner bør etablere basisverdier for disse parameterne, sette forbedringsmål og følge opp månedlig eller kvartalsvis. Plutselige endringer i disse parameterne varsler ofte tekniske problemer før de påvirker rangeringene, slik at man kan utbedre proaktivt. Verktøy som Google Search Console, PageSpeed Insights, Lighthouse og enterprise-plattformer som Semrush gir omfattende dashbord for overvåking av disse parameterne på hele nettstedet.

Det tekniske SEO-landskapet utvikler seg kontinuerlig i takt med algoritmeendringer, ny teknologi og endret brukeradferd. AI-drevet indeksering og rangering vil i økende grad påvirke hvilke sider som indekseres og hvordan de rangeres, noe som krever at teknisk SEO støtter semantisk forståelse og entitetsgjenkjenning. Edge computing og serverløse arkitekturer muliggjør raskere innholdslevering og sanntidsoptimalisering ved nettverkskanten, reduserer latens og forbedrer Core Web Vitals. Økt fokus på E-E-A-T-signaler (Experience, Expertise, Authoritativeness, Trustworthiness) betyr at teknisk SEO må støtte innholdstroverdighet gjennom korrekt forfattermarkup, publiseringsdatoer og tillitssignaler. Multisurface-optimalisering vil bli standard etter hvert som AI-søkeplattformer vokser frem, og krever at nettsteder optimaliserer for synlighet på tvers av Google, Perplexity, ChatGPT, Claude og andre nye plattformer. Personvern-først-analyse og innsamling av førstepartsdata vil forme hvordan organisasjoner måler effekten av teknisk SEO, med overgang fra tredjepartscookies til server-side-sporing og samtykkebasert måling. Modning av JavaScript-rammeverk vil fortsette å forbedre SEO-muligheter, med rammeverk som Next.js, Nuxt.js og Remix som blir standard for SEO-vennlige applikasjoner. Automatisert teknisk SEO drevet av AI vil muliggjøre raskere avdekking og utbedring av problemer, hvor plattformer automatisk identifiserer og foreslår løsninger for crawlability-, indekserings- og ytelsesproblemer. Organisasjoner som ligger i forkant av disse trendene ved å kontinuerlig oppdatere teknisk infrastruktur og følge med på nye beste praksiser, vil opprettholde konkurransefortrinn i organisk synlighet.

Teknisk SEO fokuserer på å optimalisere et nettsteds bakgrunnsinfrastruktur—slik som nettstedshastighet, crawlability, indekserbarhet og serverkonfigurasjon—for å hjelpe søkemotorer å oppdage og prosessere innhold. On-page SEO, derimot, konsentrerer seg om å optimalisere individuelle sideelementer som nøkkelordsplassering, metatagger, overskrifter og innholdskvalitet for å forbedre relevansen for spesifikke søk. Mens teknisk SEO sikrer at søkemotorer kan få tilgang til nettstedet ditt, sørger on-page SEO for at de forstår hva innholdet ditt handler om og hvorfor det er viktig for brukerne.

Core Web Vitals—Largest Contentful Paint (LCP), Interaction to Next Paint (INP) og Cumulative Layout Shift (CLS)—er bekreftede rangeringsfaktorer som måler reell brukeropplevelse. Ifølge DebugBear-forskning må nettsteder ha 75 % av brukerne med en 'God' opplevelse på alle tre måleparametere for å motta maksimal rangeringsboost. Dårlige Core Web Vitals kan føre til rangeringsstraff, lavere klikkrater og høyere fluktfrekvens, noe som direkte påvirker organisk synlighet og brukerengasjement.

Crawlability avgjør om søkemotor-roboter kan få tilgang til og følge lenker gjennom hele nettstedet ditt. Hvis Googlebot ikke kan gjennomsøke sidene dine grunnet blokkerte ressurser, dårlig nettstedsstruktur eller robots.txt-restriksjoner, kan ikke disse sidene bli indeksert eller rangert. Uten riktig crawlability forblir selv innhold av høy kvalitet usynlig for søkemotorer, og det blir umulig å oppnå organisk synlighet uansett innholdskvalitet eller lenkeprofil.

Etter hvert som AI-drevne søkeplattformer som Google AI Overviews og Perplexity blir mer fremtredende, forblir teknisk SEO grunnleggende. Disse AI-systemene er avhengige av riktig indeksert, godt strukturert innhold fra Googles indeks for å generere svar. Teknisk SEO sikrer at innholdet ditt er oppdagbart, korrekt gjengitt og semantisk rikt nok til at AI-systemer kan sitere og referere det. Uten solide tekniske grunnlag vil ikke innholdet ditt vises i AI Overviews eller andre generative søkeresultater.

For de fleste nettsteder anbefales det å gjennomføre en omfattende teknisk SEO-revisjon kvartalsvis, med månedlig overvåking av kritiske problemer. Større virksomhetsnettsteder med hyppige oppdateringer bør revidere månedlig eller implementere kontinuerlig overvåking. Etter store endringer på nettstedet, migreringer eller redesign er umiddelbare revisjoner essensielt. Regelmessige revisjoner hjelper deg å fange opp problemer tidlig før de påvirker rangeringene, og sikrer at nettstedet opprettholder optimal crawlability, indekserbarhet og ytelse.

Nettstedsarkitektur avgjør hvordan søkemotorer navigerer og forstår innholdshierarkiet på nettstedet ditt. En godt optimalisert arkitektur sikrer at viktige sider er innen tre klikk fra forsiden, fordeler lenkekraft effektivt, og hjelper søkemotorer å prioritere gjennomsøking av innhold med høy verdi. Dårlig nettstedsarkitektur kan føre til foreldreløse sider, bortkastet crawl budget og vanskeligheter med å etablere tematisk autoritet, noe som alle påvirker rangering og synlighet negativt.

Sidehastighet påvirker direkte både søkerangeringer og brukeradferd. Google har bekreftet at Core Web Vitals—som måler lastetid, interaktivitet og visuell stabilitet—er rangeringsfaktorer. Sider som laster sakte får høyere fluktfrekvens, lavere engasjement og færre konverteringer. Studier viser at sider som laster inn på under 2,5 sekunder gir betydelig bedre brukerbevaring og rangeringsresultater sammenlignet med tregere sider, noe som gjør hastighetsoptimalisering kritisk for SEO-suksess.

Begynn å spore hvordan AI-chatbots nevner merkevaren din på tvers av ChatGPT, Perplexity og andre plattformer. Få handlingsrettede innsikter for å forbedre din AI-tilstedeværelse.

JavaScript SEO optimaliserer JavaScript-rendret nettsteder for søkemotorindeksering og crawling. Lær beste praksis, gjengivelsesmetoder og strategier for å øke ...

YouTube SEO er prosessen med å optimalisere videoer og kanaler for å rangere høyere i YouTube-søk. Lær rangeringsfaktorer, optimaliseringsstrategier og beste pr...

Bli ekspert på optimalisering av teknisk språk for GEO. Lær når og hvordan du bruker bransjeterminologi for å forbedre AI-sitater og søkesynlighet med ekspertrå...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.