Ewolucja metryk wraz z dojrzewaniem wyszukiwania AI

Dowiedz się, jak ewoluować swoje ramy pomiarowe wraz z rozwojem wyszukiwania AI. Poznaj metryki oparte na cytowaniach, pulpity widoczności AI i kluczowe wskaźni...

Dowiedz się, jak systemy AI oceniają jakość treści poza tradycyjnymi metrykami SEO. Poznaj semantyczne rozumienie, dokładność faktów i sygnały jakości ważne dla LLM i AI Overviews.

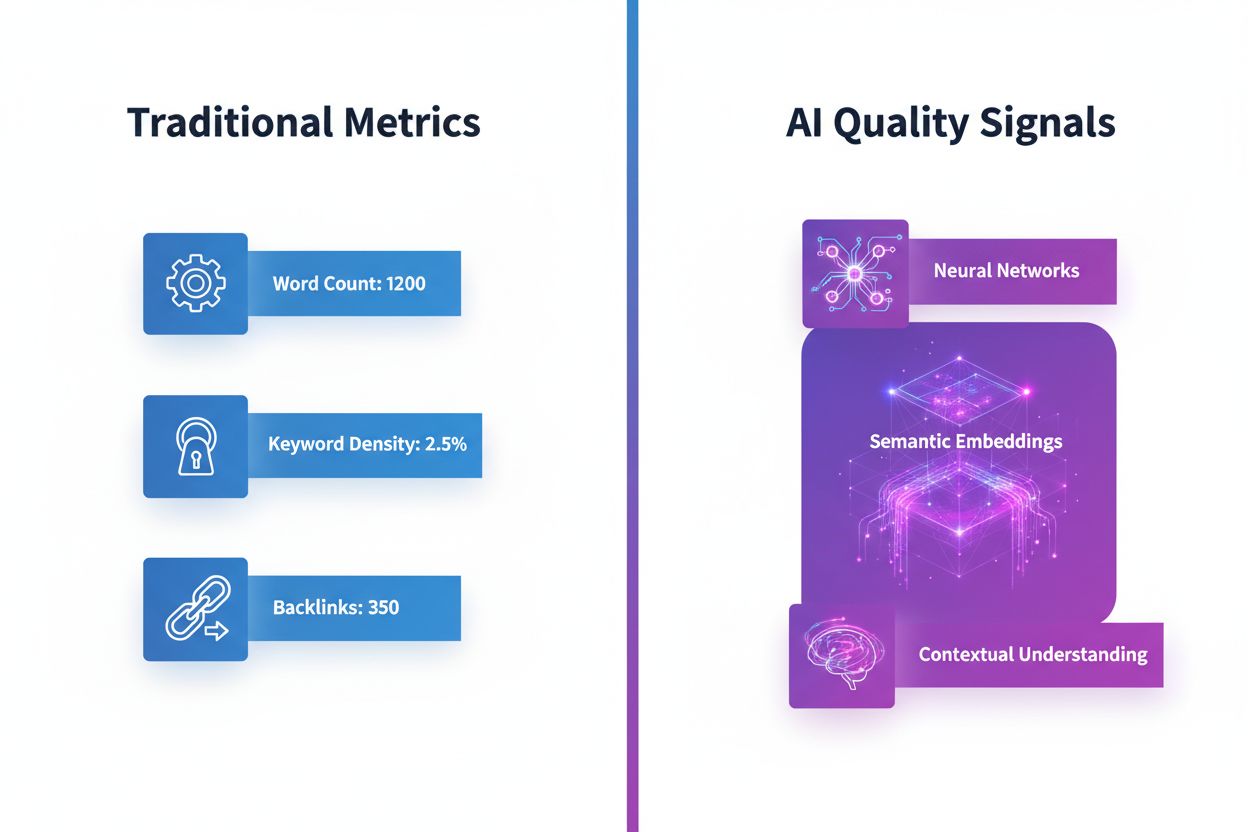

Przez lata twórcy treści optymalizowali pod kątem tradycyjnych metryk SEO — liczby słów, gęstości słów kluczowych, linków zwrotnych i szybkości strony. Jednak te powierzchowne wskaźniki pokazują tylko część obrazu, jeśli chodzi o to, jak systemy AI oceniają jakość treści. Nowoczesne modele językowe (LLM), takie jak GPT-4, Claude czy Perplexity, analizują treści z zupełnie innej perspektywy: semantycznego rozumienia, dokładności faktów i trafności kontekstowej. Zamiast liczyć słowa kluczowe, modele AI oceniają, czy treść rzeczywiście przekazuje znaczenie, czy twierdzenia da się zweryfikować i czy informacje bezpośrednio odpowiadają intencji użytkownika. Ta zmiana to prawdziwa rewolucja w myśleniu o jakości treści w świecie napędzanym przez AI.

Duże modele językowe stosują wyrafinowane ramy oceny, wykraczające daleko poza tradycyjne metryki. Wykorzystują wiele wymiarów oceny, z których każdy uchwytuje inny aspekt jakości treści. Zrozumienie tych wymiarów pomaga twórcom lepiej dopasować swoje działania do sposobu, w jaki systemy AI faktycznie postrzegają i klasyfikują informacje.

| Wymiar jakości | Tradycyjna metryka | Metoda oceny AI | Znaczenie |

|---|---|---|---|

| Znaczenie semantyczne | Częstość słów kluczowych | Podobieństwo embeddingów, rozumienie kontekstu | Krytyczne |

| Dokładność faktów | Liczba cytowań | Metryki wiarygodności, wykrywanie halucynacji | Krytyczne |

| Trafność | Dopasowanie słów kluczowych | Scoring trafności odpowiedzi, zgodność z zadaniem | Krytyczne |

| Spójność | Wynik czytelności | Analiza logicznego przepływu, kontrola spójności | Wysokie |

| Struktura | Liczba nagłówków | Ocena struktury argumentów | Wysokie |

| Jakość źródła | Autorytet domeny | Weryfikacja atrybucji, ugruntowanie źródła | Wysokie |

| Dopasowanie tonu | Analiza sentymentu | Dopasowanie intencji, spójność stylu | Średnie |

Te metody oceny — w tym BLEU, ROUGE, BERTScore i metryki oparte na embeddingach — pozwalają systemom AI z dużą precyzją oceniać jakość treści. Zamiast polegać na prostym nakładaniu się słów, nowoczesna ocena AI wykorzystuje podobieństwo semantyczne do sprawdzenia, czy różne sformułowania przekazują to samo znaczenie, ocenę bezreferencyjną do analizy wewnętrznych cech tekstu oraz podejście LLM-as-a-Judge, gdzie zaawansowane modele oceniają wyniki na podstawie szczegółowych kryteriów.

Jedną z największych różnic między tradycyjną a AI-ową oceną jest sposób analizowania znaczenia semantycznego. Tradycyjne metryki penalizują parafrazowanie i użycie synonimów, traktując „odszedł szybko” i „wyszedł w pośpiechu” jako zupełnie różne zwroty. Systemy AI jednak rozpoznają je jako semantycznie równoważne dzięki ocenie opartej na embeddingach. Zamieniają tekst na wielowymiarowe wektory oddające znaczenie, co pozwala AI zrozumieć, że dwa zdania wyrażające tę samą ideę powinny być ocenione podobnie, niezależnie od słownictwa.

To semantyczne rozumienie obejmuje także trafność kontekstową — systemy AI oceniają, czy treść pasuje do szerszego kontekstu rozmowy lub tematu. Odpowiedź może używać zupełnie innego słownictwa niż pytanie, ale wciąż być bardzo trafna, jeśli odpowiada na ukrytą intencję. Modele AI oceniają to poprzez metryki podobieństwa semantycznego, które mierzą, jak blisko znaczenie odpowiedzi pokrywa się z pytaniem — a nie poprzez dopasowanie słów kluczowych. Dzięki temu dobrze napisane, naturalnie płynące treści, które wyczerpują temat, osiągają wyższe wyniki niż teksty napakowane słowami kluczowymi, ale pozbawione spójności.

Być może najważniejszym sygnałem jakości dla systemów AI jest dokładność faktów. W przeciwieństwie do tradycyjnych metryk SEO, które pomijają prawdziwość, nowoczesne ramy oceny AI wprost sprawdzają, czy treść zawiera możliwe do weryfikacji fakty, czy niepoparte twierdzenia. Systemy AI wykorzystują metryki wiarygodności, by ocenić, czy stwierdzenia bazują na dostarczonym materiale źródłowym, oraz wykrywanie halucynacji, by rozpoznać, kiedy modele lub autorzy wymyślają informacje.

Te metody polegają na porównywaniu twierdzeń z autorytatywnymi źródłami lub bazami wiedzy. Jeśli w treści pojawia się informacja, że „stolicą Francji jest Paryż”, systemy AI weryfikują to w swoich danych treningowych i źródłach zewnętrznych. Co ważniejsze, AI ocenia ugruntowanie — czy dane stwierdzenia są poparte dowodami. Streszczenie zawierające informacje nieobecne w oryginalnym źródle dostanie niską ocenę wiarygodności, nawet jeśli są one technicznie poprawne. Ten nacisk na dokładność oznacza, że twórcy muszą zadbać, by każde twierdzenie było wiedzą powszechną, odpowiednio cytowane lub wyraźnie oznaczone jako opinia lub spekulacja.

Systemy AI oceniają, jak dobrze pomysły łączą się i logicznie rozwijają w tekście. Ocena spójności sprawdza, czy zdania płynnie przechodzą jedno w drugie, argumenty się uzupełniają, a ogólna struktura jest sensowna. Treści z wyraźnymi zdaniami wprowadzającymi, logiczną organizacją akapitów i płynnymi przejściami wypadają lepiej w metrykach spójności niż rozwlekłe, chaotyczne teksty.

Logiczny przepływ jest szczególnie ważny przy złożonych tematach. AI sprawdza, czy wyjaśnienia przechodzą od prostych do złożonych, czy najpierw wprowadzane są podstawy, zanim pojawią się zaawansowane pojęcia, i czy wnioski logicznie wynikają z przedstawionych dowodów. Dobrze zorganizowana treść, która prowadzi czytelnika przez klarowną sekwencję myśli, jest dla AI dowodem wyższej jakości niż tekst skaczący po tematach lub powtarzający informacje.

Systemy AI oceniają, czy treść realnie odpowiada na pytanie lub realizuje zamierzony cel. Metryki trafności odpowiedzi mierzą, jak bezpośrednio tekst odnosi się do zapytania użytkownika — wysokie wyniki uzyskują treści, które pozostają w temacie i unikają dygresji. Jeśli ktoś pyta „Jak naprawić cieknący kran?”, a dostaje odpowiedź o historii hydrauliki, treść nie przechodzi testu trafności, nawet jeśli jest dobrze napisana i poprawna merytorycznie.

Zgodność z zadaniem pogłębia to podejście — AI sprawdza, czy treść pasuje do zamierzonego celu i intencji użytkownika. Instrukcja techniczna powinna być szczegółowa i precyzyjna; szybki przewodnik — zwięzły i czytelny; artykuł perswazyjny — zawierać przekonujące argumenty. Treść dopasowana do tych oczekiwań uzyskuje lepsze wyniki niż taka, która nie trafia w potrzeby, niezależnie od innych cech jakościowych. Oznacza to, że zrozumienie odbiorcy i celu jest dla AI równie istotne, jak sama jakość tekstu.

Systemy AI bardzo cenią ugruntowanie wiedzy — czyli osadzanie twierdzeń w autorytatywnych źródłach. Treści cytujące wiarygodne źródła, z poprawną atrybucją i jasnym rozróżnieniem między faktami a interpretacjami, osiągają wyższe oceny jakości. Precyzja kontekstowa mierzy, jak dobrze przytoczone źródła faktycznie potwierdzają dane twierdzenia, a przypomnienie kontekstowe sprawdza, czy ujęto wszystkie istotne informacje wspierające.

Przejrzysta atrybucja spełnia wiele funkcji w ocenie AI. Pokazuje, że autor przeprowadził research, pozwala czytelnikom samodzielnie zweryfikować informacje i umożliwia systemom AI ocenę wiarygodności treści. Teksty ogólnikowo powołujące się na „badania pokazują”, bez szczegółów, wypadają gorzej niż te, które cytują konkretne prace z autorami, datami i wynikami. Akcent na jakość źródeł oznacza, że twórcy powinni poświęcać czas na znalezienie autorytatywnych materiałów i ich właściwą atrybucję.

Poza treściami faktograficznymi systemy AI oceniają, czy ton i styl odpowiadają oczekiwaniom i intencji odbiorcy. Odpowiedź obsługi klienta powinna być pomocna i profesjonalna; tekst literacki — zgodny z gatunkiem; dokument techniczny — precyzyjny i formalny. AI wykorzystuje podejście LLM-as-a-Judge, gdzie zaawansowane modele analizują, czy ton jest adekwatny do kontekstu i czy wybory stylistyczne wzmacniają lub osłabiają przekaz.

Spójność to kolejny istotny czynnik — AI sprawdza, czy ton, terminologia i styl pozostają konsekwentne w całym tekście. Przełączanie się między formalnym a potocznym językiem, używanie różnych terminów na to samo pojęcie czy niespodziewane zmiany perspektywy sygnalizują niższą jakość. Treści utrzymujące jednolity głos i styl są oceniane wyżej niż te, które sprawiają wrażenie niespójnych.

Zrozumienie sposobu, w jaki AI ocenia jakość treści, ma konkretne konsekwencje dla podejścia do ich tworzenia. Oto praktyczne strategie, dzięki którym Twoje treści będą uznawane przez AI za wysokiej jakości:

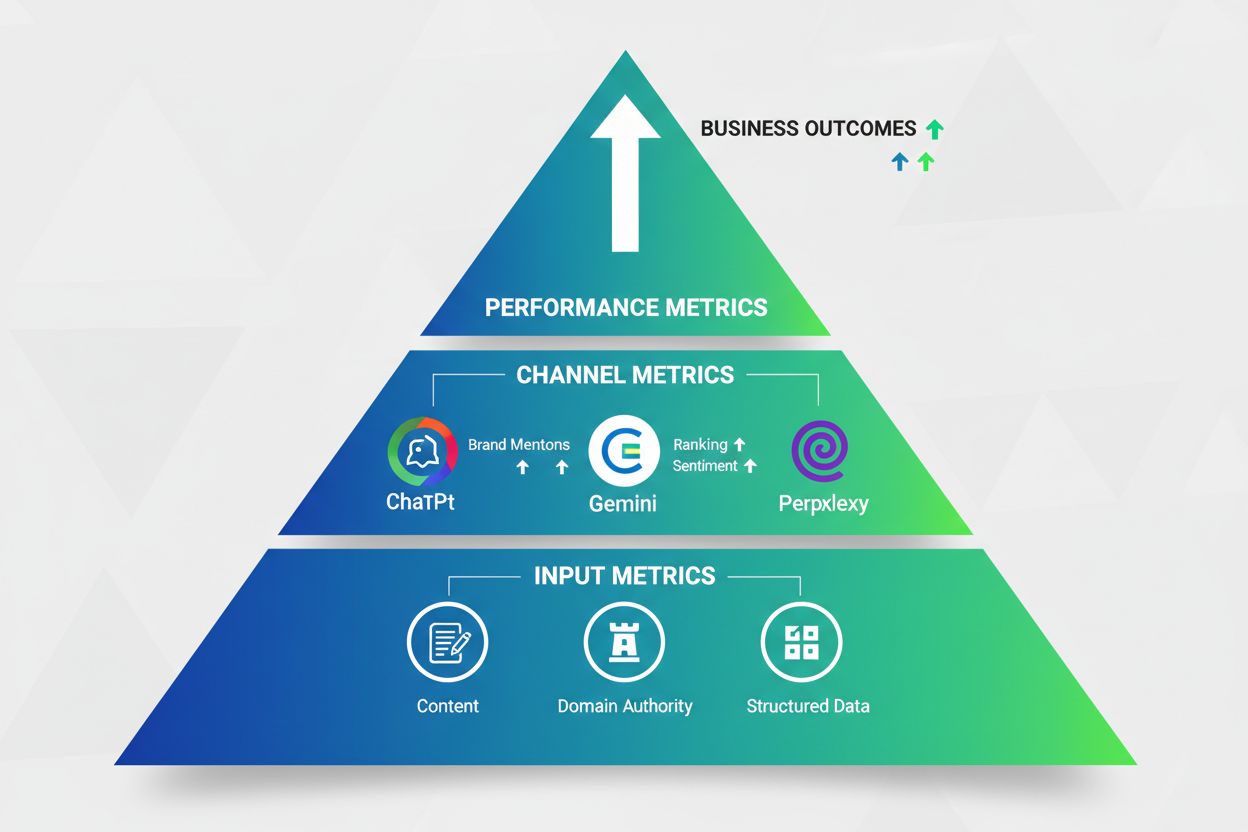

W miarę jak systemy AI stają się coraz ważniejsze dla odkrywania treści i cytowań, kluczowe jest zrozumienie, jak Twoja marka i treści są przez nie rozpoznawane. AmICited.com umożliwia monitorowanie tego, jak systemy AI — w tym GPT, Perplexity, Google AI Overviews i inne platformy LLM — cytują i odnoszą się do Twoich treści oraz marki.

Zamiast polegać na tradycyjnych metrykach, które nie oddają uznania AI, AmICited śledzi konkretne sygnały jakości istotne dla nowoczesnych systemów AI. Platforma monitoruje, czy Twoje treści są cytowane jako autorytatywne, jak często systemy AI odnoszą się do Twojej marki i w jakim kontekście pojawiają się na różnych platformach AI. Ta widoczność jest nieoceniona, by zrozumieć, czy Twoje treści spełniają standardy jakości, które AI faktycznie bierze pod uwagę przy ocenie i cytowaniu.

Korzystając z AmICited, zyskujesz wgląd w to, jak AI postrzega jakość Twoich treści, z jakimi tematami jest kojarzona Twoja marka i gdzie można się poprawić, by zwiększyć liczbę cytowań przez AI. Takie podejście oparte na danych pozwala lepiej dopasować strategię treści do rzeczywistych kryteriów oceny i rekomendacji przez nowoczesne systemy AI. W czasach, gdy wyszukiwanie i odkrywanie treści przez AI nabiera kluczowego znaczenia, monitorowanie swojej obecności w tych systemach staje się równie ważne, jak kiedyś klasyczne SEO.

Systemy AI skupiają się na semantycznym rozumieniu, dokładności faktów i trafności kontekstowej, a nie na częstotliwości słów kluczowych i linkach zwrotnych. Wykorzystują metryki oparte na embeddingach do rozumienia znaczenia, metryki wiarygodności do weryfikacji faktów oraz scoring trafności, by upewnić się, że treść odpowiada intencji użytkownika. Oznacza to, że dobrze napisane, wyczerpujące treści, które kompleksowo omawiają temat, zdobywają wyższe oceny niż treści napakowane słowami kluczowymi.

Podobieństwo semantyczne mierzy, czy różne sformułowania przekazują to samo znaczenie. Systemy AI wykorzystują ocenę opartą na embeddingach, by rozpoznać, że „odszedł szybko” i „wyszedł w pośpiechu” są semantycznie równoważne, mimo użycia innych słów. Ma to znaczenie, bo AI nagradza naturalny, zróżnicowany styl nad powtarzanie słów kluczowych i rozpoznaje parafrazowanie jako wysokiej jakości treść.

Systemy AI używają metryk wiarygodności, porównując twierdzenia w treści z autorytatywnymi źródłami i bazami wiedzy. Oceniają, czy stwierdzenia są oparte na dostarczonym materiale źródłowym i czy informacje są poparte dowodami. Treści zawierające niepoparte twierdzenia lub informacje nieobecne w źródłach osiągają niskie wyniki w metrykach dokładności faktów.

Systemy AI cenią ugruntowanie wiedzy — osadzanie twierdzeń w autorytatywnych źródłach. Treści cytujące wiarygodne źródła z prawidłową atrybucją pokazują jakość badań i pozwalają AI ocenić wiarygodność. Przejrzysta atrybucja umożliwia czytelnikom samodzielną weryfikację oraz sygnalizuje AI, że autor dokładnie zbadał temat.

Systemy AI oceniają logiczny przepływ i spójność, sprawdzając, czy pomysły łączą się naturalnie, argumenty się uzupełniają, a cała struktura ma sens. Używaj jasnych zdań wprowadzających, logicznie porządkuj akapity, stosuj płynne przejścia między wątkami i przechodź od prostych do złożonych pojęć. Dobrze uporządkowana treść z wyraźną progresją wypada lepiej niż chaotyczna.

Systemy AI oceniają, czy ton i styl odpowiadają oczekiwaniom i intencji użytkownika. Spójność jest kluczowa — utrzymanie tego samego głosu, terminologii i stylu w całej treści sygnalizuje wyższą jakość. Przełączanie między formalnym a potocznym językiem, stosowanie różnych określeń na te same pojęcia czy niespodziewana zmiana perspektywy obniżają ocenę jakości w AI.

AmICited monitoruje, jak systemy AI takie jak GPT, Perplexity i Google AI Overviews cytują i odnoszą się do Twoich treści oraz marki. Platforma śledzi, czy Twoje treści są uznawane za autorytatywne, jak często systemy AI odnoszą się do Twojej marki i w jakim kontekście się pojawiają. Ta widoczność pozwala zrozumieć, czy Twoje treści spełniają standardy jakości AI i gdzie warto się poprawić.

Ocena oparta na referencjach porównuje treść z wcześniej określonymi prawidłowymi odpowiedziami, co sprawdza się w zadaniach z jednoznacznymi rozwiązaniami. Ocena bezreferencyjna ocenia wewnętrzne cechy tekstu bez porównania do konkretnych odpowiedzi, co jest kluczowe dla zadań otwartych. Nowoczesne systemy AI używają obu podejść w zależności od zadania, przy czym ocena bezreferencyjna zyskuje na znaczeniu dla treści kreatywnych i konwersacyjnych.

Śledź, jak GPT, Perplexity i Google AI Overviews cytują i odnoszą się do Twojej marki dzięki platformie monitorującej AI od AmICited.

Dowiedz się, jak ewoluować swoje ramy pomiarowe wraz z rozwojem wyszukiwania AI. Poznaj metryki oparte na cytowaniach, pulpity widoczności AI i kluczowe wskaźni...

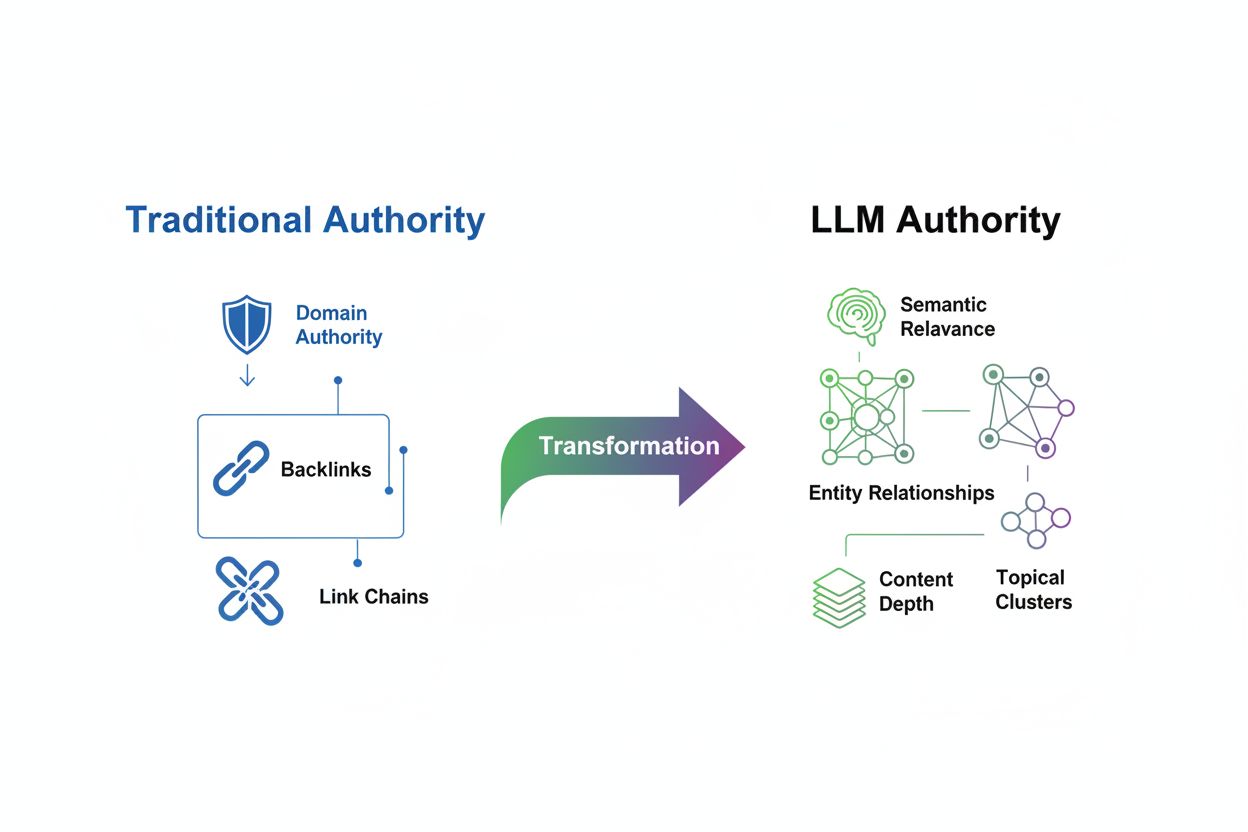

Dowiedz się, jak budować autorytet tematyczny dla LLM-ów dzięki głębi semantycznej, optymalizacji encji i klastrom treści. Opanuj strategie, które sprawiają, że...

Dowiedz się, jak skutecznie ustalać OKR-y dla widoczności AI i celów GEO. Poznaj trójstopniowy framework pomiarowy, śledzenie wzmianek o marce oraz strategie wd...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.