Kompletny przewodnik blokowania (lub zezwalania) na roboty AI

Dowiedz się, jak blokować lub zezwalać robotom AI, takim jak GPTBot i ClaudeBot, za pomocą robots.txt, blokowania na poziomie serwera oraz zaawansowanych metod ...

Dowiedz się, jak podejmować strategiczne decyzje dotyczące blokowania robotów AI. Oceń typ treści, źródła ruchu, modele przychodów i pozycję konkurencyjną dzięki naszym kompleksowym ramom decyzyjnym.

Roboty AI stały się potężnym graczem w ekosystemie cyfrowym, zasadniczo zmieniając sposób odkrywania, indeksowania i wykorzystywania treści w internecie. Te zautomatyzowane systemy zostały zaprojektowane do systematycznego przeszukiwania stron, wydobywania danych i przekazywania ich do modeli uczenia maszynowego napędzających wyszukiwarki czy aplikacje generatywnej AI. Wyróżniamy trzy główne typy robotów: skrapery danych zbierające konkretne informacje do celów komercyjnych, roboty wyszukiwarek jak Googlebot, indeksujące treści pod kątem wyników wyszukiwania, oraz roboty asystentów AI, które zbierają dane treningowe dla dużych modeli językowych. Przykładami są GPTBot (OpenAI), Claude-Web (Anthropic) czy robot AI Overviews od Google – każdy z innym celem i profilem wpływu. Według najnowszych analiz, już 21% z tysiąca największych stron wdrożyło jakąś formę blokady robotów AI, co pokazuje rosnącą świadomość potrzeby zarządzania tymi automatycznymi odwiedzającymi. Zrozumienie, które roboty odwiedzają Twoją stronę i w jakim celu, to pierwszy kluczowy krok do świadomej decyzji o blokowaniu lub dopuszczeniu ich. Stawka jest wysoka, bo decyzja ta ma bezpośredni wpływ na widoczność Twoich treści, wzorce ruchu i – ostatecznie – model przychodów.

Zamiast podejmować zero-jedynkową decyzję o blokowaniu lub dopuszczaniu wszystkich robotów AI, lepszym podejściem jest ocena swojej sytuacji według ram BEDC (Model Biznesowy, Ryzyko Ekspozycji, Zależność od ruchu organicznego, Pozycja Konkurencyjna). Każdy z tych czterech czynników ma inną wagę w zależności od charakterystyki Twojej strony, a razem tworzą kompletną matrycę decyzyjną uwzględniającą złożoność współczesnego publikowania w internecie. Ramy te uznają, że nie ma uniwersalnej odpowiedzi – to, co działa dla organizacji newsowej, może być nieodpowiednie dla firmy SaaS, a to, co korzystne dla uznanej marki, może zaszkodzić nowemu graczowi. Systematyczna ocena każdego czynnika pozwala wyjść poza emocjonalne reakcje na AI i podejmować decyzje oparte na danych, zgodne z celami biznesowymi.

| Czynnik | Rekomendacja | Kluczowa kwestia |

|---|---|---|

| Model Biznesowy | Strony utrzymujące się z reklam powinny być ostrożniejsze; modele subskrypcyjne mogą być bardziej otwarte | Zależność przychodów od bezpośredniego zaangażowania użytkowników vs. licencjonowania |

| Ryzyko Ekspozycji | Oryginalne badania i unikalne dane należy blokować; treści masowe mogą być bardziej dostępne | Przewaga konkurencyjna związana z unikalnymi informacjami lub danymi |

| Zależność od wyszukiwania organicznego | Wysoka zależność (>40% ruchu) sugeruje dopuszczenie robotów Google, ale blokadę asystentów AI | Równowaga między widocznością w wyszukiwarkach a ochroną danych treningowych AI |

| Pozycja konkurencyjna | Liderzy rynku mogą blokować; nowi gracze mogą zyskać na widoczności w AI | Efekt pierwszego ruchu w partnerstwach AI vs. ochrona treści |

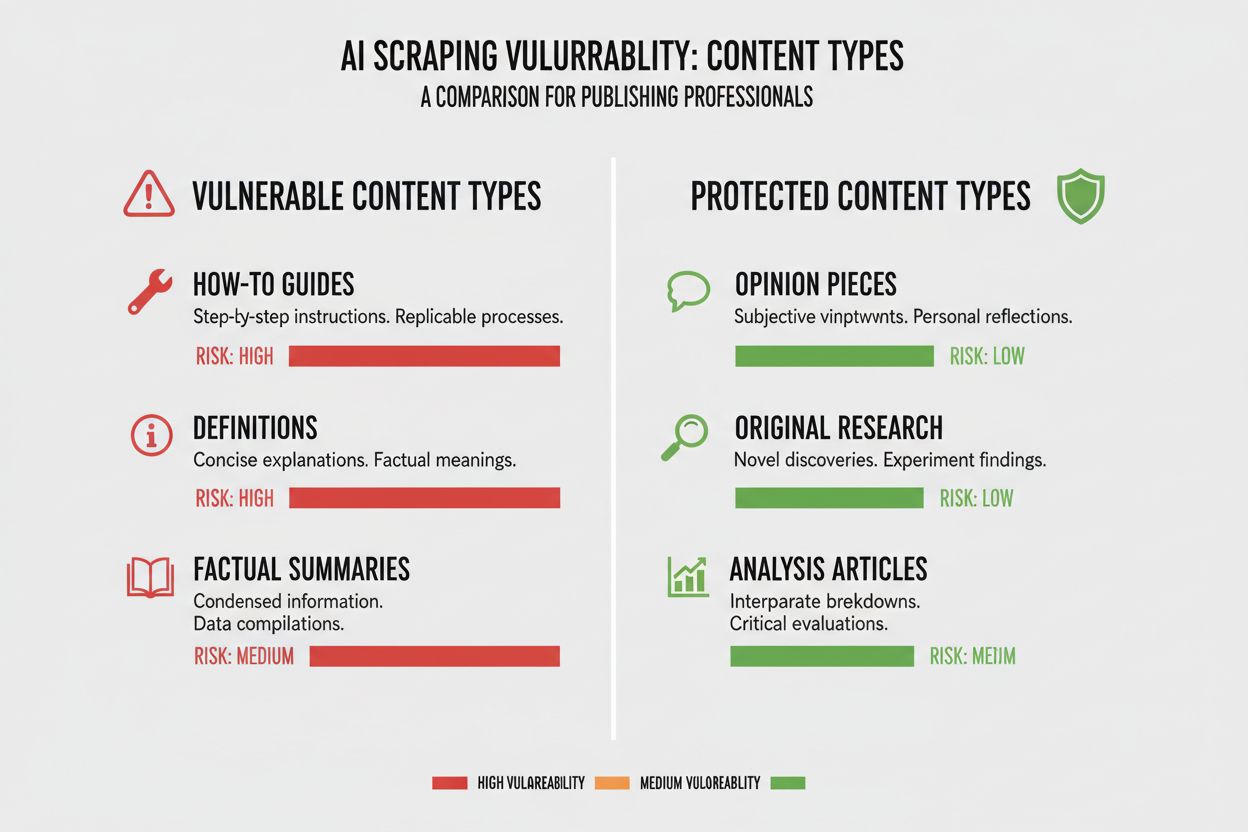

Różne typy treści mają bardzo zróżnicowaną podatność na crawling AI, dlatego zrozumienie pozycji swoich materiałów jest kluczowe. Oryginalne badania i własne dane to Twoje najcenniejsze zasoby i zasługują na najsilniejszą ochronę, bo modele AI uczące się na tych treściach mogą konkurować z Twoim modelem monetyzacji. Wiadomości i informacje z ostatniej chwili zajmują pozycję pośrednią – ich wartość szybko maleje, ale indeksacja przez wyszukiwarki nadal jest kluczowa dla ruchu, co rodzi napięcie między widocznością a ochroną danych treningowych. Treści masowe jak poradniki, tutoriale czy ogólne informacje są mniej narażone, bo są szeroko dostępne i rzadko głównym źródłem przychodów. Treści głosowe i multimedialne są naturalnie chronione, bo obecne roboty AI mają trudności z pozyskiwaniem wartości z audio i wideo, co czyni te formaty bezpieczniejszymi. Ponadczasowe edukacyjne materiały i felietony są gdzieś pośrodku — cenne dla ruchu z wyszukiwarki, ale mniej bezpośrednio zagrożone przez AI. Kluczowe jest, by strategia blokowania była proporcjonalna do przewagi konkurencyjnej, jaką dają dane treści – chroń to, co najcenniejsze, a dla treści korzystających z szerokiej dystrybucji pozwól na crawling.

Zależność od ruchu organicznego to kluczowy czynnik w decyzji dotyczącej robotów AI, bo bezpośrednio pokazuje kompromis między widocznością a ochroną treści. Strony, które uzyskują ponad 40% ruchu z wyszukiwarek, stoją przed poważnym dylematem: blokując roboty AI, często blokują też lub ograniczają roboty Google, co niszczy ich widoczność i ruch organiczny. Rozróżnienie między Google-Extended (crawl dla treningu AI) a Googlebot (crawl dla indeksowania wyszukiwania) jest tu kluczowe — teoretycznie można dopuścić jeden, blokując drugi, ale to zwiększa złożoność techniczną. Wymownym przykładem są dane z New York Timesa: publikacja odnotowała ok. 240 600 wizyt z robotów AI w określonym okresie, co pokazuje skalę ruchu AI dla dużych wydawców. Jednak dane Akamai pokazują, że zablokowanie robotów daje 96% mniej ruchu referencyjnego z tych źródeł, co sugeruje, że udział robotów AI w ruchu jest minimalny w porównaniu do wyszukiwarek. Wskaźnik crawl-to-referral dla robotów AI jest bardzo niski – często mniej niż 0,15% zaindeksowanych treści generuje powroty – więc blokada robotów AI ma znikomy wpływ na rzeczywisty ruch użytkowników. Dla stron zależnych od wyszukiwania organicznego decyzję o blokadzie robotów AI trzeba rozważyć wobec ryzyka przypadkowej blokady Googlebota, co byłoby znacznie bardziej szkodliwe.

Twój model przychodów w zasadniczy sposób wpływa na podejście do robotów AI, bo różne strategie monetyzacji tworzą różne motywacje wokół dystrybucji i ochrony treści. Strony utrzymujące się z reklam są w największym konflikcie z robotami AI, bo ich przychód zależy od odwiedzin i wyświetleń reklam, a modele AI podsumowujące treści zmniejszają motywację do kliknięcia. Modele subskrypcyjne mogą być bardziej liberalne wobec robotów AI, bo przychody pochodzą z subskrypcji, a obecność w AI może nawet napędzać zapisy. Modele hybrydowe, łączące reklamy, subskrypcje i afiliacje, wymagają zróżnicowanego podejścia – blokada może chronić reklamę, ale ograniczyć afiliacje czy wzrost subskrypcji. Nową możliwością jest model referencyjny AI, gdzie strony mogą zarabiać, udostępniając treści robotom AI w zamian za cytowanie i przekierowania – to dopiero się rozwija, ale może zmienić ekonomię dystrybucji treści. Aby zrozumieć wpływ robotów AI na Twój biznes, narzędzia typu AmICited.com dają wgląd w to, gdzie Twoje treści są cytowane i wykorzystywane przez AI, pokazując rzeczywistą wartość tej wymiany. Kluczowe jest dogłębne zrozumienie swojego modelu przychodów, by przewidzieć wpływ robotów AI na każdy strumień, zamiast podejmować decyzje wyłącznie z zasady.

Po podjęciu decyzji o blokadzie określonych robotów AI, wdrożenie techniczne wymaga zrozumienia zarówno możliwości, jak i ograniczeń dostępnych narzędzi. Najczęstszym rozwiązaniem jest robots.txt, czyli prosty plik tekstowy w głównym katalogu strony, instruujący roboty, które części serwisu są dostępne, a które nie. Istnieje jednak istotne ograniczenie: robots.txt to dobrowolny standard, a złośliwe lub agresywne roboty mogą go ignorować. Przykład blokady wybranych robotów AI w robots.txt:

User-agent: GPTBot

Disallow: /

User-agent: CCBot

Disallow: /

User-agent: anthropic-ai

Disallow: /

User-agent: Claude-Web

Disallow: /

Poza robots.txt warto rozważyć blokadę następujących głównych robotów AI:

Dla silniejszej ochrony wiele organizacji wdraża blokowanie na poziomie CDN (np. Cloudflare), co pozwala zablokować ruch już na brzegu sieci, zanim dotrze do serwera, zapewniając lepszą wydajność i bezpieczeństwo. Podejście dwuwarstwowe, łączące robots.txt z blokadą na CDN, daje najpełniejszą ochronę — zatrzymuje zarówno roboty respektujące robots.txt, jak i te, które go ignorują. Trzeba pamiętać, że blokowanie na poziomie CDN wymaga większego zaawansowania technicznego i może mieć niezamierzone skutki, jeśli nie jest poprawnie skonfigurowane, dlatego najlepiej sprawdza się w organizacjach z dedykowanymi zasobami IT.

Nieprzyjemna prawda o blokowaniu robotów AI jest taka, że faktyczny wpływ na ruch jest często znacznie mniejszy, niż sugerują emocje wokół AI – dane pokazują znacznie bardziej zniuansowany obraz, niż oczekuje wielu wydawców. Według najnowszych analiz roboty AI stanowią średnio 0,15% całego ruchu na stronie u większości wydawców, co jest zaskakująco małą liczbą wobec całej uwagi, jaką poświęca się temu zagadnieniu. Jednak tempo wzrostu ruchu generowanego przez roboty AI jest gwałtowne — niektóre raporty pokazują 7-krotny wzrost rok do roku liczby zapytań tych robotów, co oznacza, że choć obecnie wpływ jest niewielki, trajektoria jest stroma. ChatGPT odpowiada za ok. 78% całego ruchu robotów AI, co czyni crawler OpenAI dominującym graczem, a inne firmy AI mają znacznie mniejszy udział. Dane crawl-to-referral są tu szczególnie wymowne: nawet jeśli roboty pobierają miliony stron, faktyczne powroty użytkowników z tych źródeł to często poniżej 0,15%, co oznacza, że blokada praktycznie nie wpływa na realny ruch. Blokowanie robotów AI redukuje ruch referencyjny o 96%, ale skoro ten ruch był minimalny (często <0,15% całego ruchu), to net effect dla biznesu jest zazwyczaj pomijalny. Powstaje więc paradoks: blokada robotów AI wydaje się zasadnym protestem przeciw kradzieży treści, ale faktyczny wpływ biznesowy jest tak mały, że trudno go zauważyć w analizach. Prawdziwe pytanie nie brzmi, czy blokada robotów zaszkodzi Twojemu ruchowi — zazwyczaj nie — tylko czy dopuszczenie ich stwarza strategiczne szanse lub ryzyka, które przewyższają minimalny udział ruchu z tych źródeł.

Twoja pozycja konkurencyjna na rynku zasadniczo wpływa na strategię wobec robotów AI, bo optymalne podejście dla lidera rynku jest zupełnie inne niż dla nowego gracza. Dominujący gracze jak New York Times, Wall Street Journal czy główne media mogą sobie pozwolić na blokadę robotów AI, bo mają rozpoznawalną markę i bezpośrednie relacje z odbiorcami, więc nie polegają na odkryciach przez AI. Nowi gracze i niszowi wydawcy muszą kalkulować inaczej: indeksacja przez systemy AI i obecność w generowanych przez AI podsumowaniach może być jedną z niewielu szans na przebicie się przez konkurencję. Efekt pierwszego ruchu w partnerstwach z AI może być znaczący – wydawcy, którzy wcześnie wynegocjują dobre warunki z firmami AI, mogą liczyć na lepsze cytowanie, przekierowania czy umowy licencyjne niż ci, którzy poczekają. Istnieje także efekt subsydiowania: gdy liderzy blokują roboty AI, firmy AI coraz bardziej polegają na treściach tych wydawców, którzy na crawling pozwalają, co może im zapewnić nieproporcjonalną widoczność w systemach AI. To rodzi dynamikę, w której blokada robotów może wręcz zaszkodzić, jeśli konkurenci się otwierają i zyskują na obecności w AI. Zrozumienie swojej pozycji konkurencyjnej jest kluczowe, by przewidzieć, jak decyzja o blokadzie wpłynie na Twoją sytuację względem konkurencji.

Podjęcie decyzji o blokadzie lub dopuszczeniu robotów AI wymaga systematycznej oceny swojej sytuacji według konkretnych kryteriów. Skorzystaj z tej checklisty przy podejmowaniu decyzji:

Ocena ekspozycji treści

Analiza składu ruchu

Ocena pozycji rynkowej

Ocena ryzyka przychodowego

Po tej wstępnej ocenie wdrażaj przeglądy kwartalne swojej strategii wobec robotów AI, bo sytuacja zmienia się bardzo szybko i optymalna decyzja dziś może być inna za kilka miesięcy. Korzystaj z narzędzi typu AmICited.com do śledzenia cytowań i wykorzystania Twoich treści przez AI — to da konkretne dane o wartości tej wymiany. Kluczowy wniosek: tej decyzji nie podejmuje się raz na zawsze – wymaga ciągłej ewaluacji i dostosowywania w miarę dojrzewania rynku AI i zmiany okoliczności biznesowych.

Ważną, nową możliwością, która może całkowicie zmienić krajobraz robotów AI, jest funkcja płatności za crawl od Cloudflare – wprowadza ona model internetu opartego na zezwoleniach, gdzie właściciele stron mogą zarabiać na dostępie robotów AI zamiast je tylko blokować lub dopuszczać. To podejście uznaje, że firmy AI czerpią wartość z crawlowania Twoich treści, a zamiast prowadzić wojnę blokad, możesz negocjować rekompensatę za ten dostęp. Model ten opiera się na kryptograficznej weryfikacji, by tylko autoryzowane roboty miały dostęp do treści, uniemożliwiając nieuprawnione skrapowanie, a legalnym firmom AI pozwalając płacić za dostęp. Daje to precyzyjną kontrolę nad tym, które roboty mogą pobierać które treści, pozwalając monetyzować najcenniejsze materiały i jednocześnie otwierać się na wyszukiwarki i inne korzystne roboty. Model płatności za crawl umożliwia też audyt AI — widzisz dokładnie, które treści, kiedy i przez kogo zostały pobrane, co daje transparentność niemożliwą przy klasycznych blokadach. Dla wydawców, którzy wdrażają tę strategię, monitoring AmICited.com staje się jeszcze bardziej wartościowy, bo pozwala nie tylko śledzić cytowania w AI, ale i potwierdzać, że otrzymujesz właściwą rekompensatę za wykorzystanie treści. Choć model ten dopiero się rozwija i adopcja jest ograniczona, to może być znacznie dojrzalszym podejściem niż prosty wybór blokuj/zezwól – takim, które uznaje wzajemną wartość relacji między wydawcami a firmami AI, jednocześnie chroniąc Twoje interesy technicznie i kontraktowo.

Blokowanie robotów AI uniemożliwia im dostęp do Twoich treści poprzez robots.txt lub blokowanie na poziomie CDN, chroniąc Twoje treści przed wykorzystaniem w treningu AI. Dopuszczenie robotów oznacza, że Twoje treści mogą być indeksowane przez systemy AI, potencjalnie pojawiając się w generowanych przez AI podsumowaniach i odpowiedziach. Wybór zależy od typu Twoich treści, modelu przychodów i pozycji konkurencyjnej.

Blokowanie robotów AI nie zaszkodzi bezpośrednio Twojemu SEO, jeśli zablokujesz tylko roboty typowo AI, takie jak GPTBot, a dopuścisz Googlebota. Jednak przypadkowe zablokowanie Googlebota znacząco zaszkodzi Twojej pozycji w wyszukiwarkach. Kluczowe jest precyzyjne blokowanie tylko robotów trenujących AI przy zachowaniu dostępu dla wyszukiwarek.

Tak, możesz użyć robots.txt, aby zablokować konkretne roboty po ich user-agent, a inne dopuścić. Przykładowo, możesz zablokować GPTBot, a dopuścić Google-Extended lub odwrotnie. Takie precyzyjne podejście pozwala chronić treści przed wybranymi firmami AI, pozostając widocznym dla innych.

robots.txt to dobrowolny standard, który zakłada respektowanie Twoich instrukcji przez roboty – niektóre firmy AI go ignorują. Blokowanie na poziomie CDN (np. Cloudflare) zatrzymuje ruch już na brzegu sieci, zanim trafi na Twój serwer, zapewniając silniejsze egzekwowanie. Najlepszą ochronę daje podejście dwuwarstwowe z obiema metodami.

Możesz sprawdzić logi serwera pod kątem user-agentów znanych robotów AI, takich jak GPTBot, CCBot czy Claude-Web. Narzędzia typu AmICited.com oferują monitoring, który pozwala śledzić, gdzie Twoje treści pojawiają się w systemach AI i jak często są pobierane przez roboty AI.

Płatność za crawl to nowy model, w którym firmy AI płacą za dostęp do Twoich treści. Choć jest to wciąż faza testowa i nie jest powszechny, daje potencjalnie nowe źródło przychodów. Opłacalność zależy od ilości zapytań robotów AI i stawek, jakie gotowe są płacić firmy AI.

Jeśli robot AI ignoruje Twoje robots.txt, wdroż blokowanie na poziomie CDN przez usługę typu Cloudflare. Możesz też skonfigurować serwer, by zwracał błąd 403 dla znanych user-agentów robotów AI. W przypadku uporczywych naruszeń rozważ działania prawne lub kontakt bezpośredni z firmą AI.

Strategię wobec robotów AI należy przeglądać co kwartał, ponieważ sytuacja szybko się zmienia. Monitoruj ruch robotów AI, pojawianie się nowych robotów na rynku oraz zmiany w swojej pozycji konkurencyjnej. Korzystaj z narzędzi takich jak AmICited.com, by śledzić wykorzystanie Twoich treści przez AI i na bieżąco dostosowywać strategię.

Śledź, gdzie Twoje treści pojawiają się w odpowiedziach generowanych przez AI i zrozum wpływ robotów AI na Twój biznes dzięki kompleksowej platformie monitorującej AmICited.com.

Dowiedz się, jak blokować lub zezwalać robotom AI, takim jak GPTBot i ClaudeBot, za pomocą robots.txt, blokowania na poziomie serwera oraz zaawansowanych metod ...

Dowiedz się, jak skonfigurować robots.txt dla robotów AI, w tym GPTBot, ClaudeBot i PerplexityBot. Poznaj kategorie robotów AI, strategie blokowania oraz najlep...

Dyskusja społeczności na temat tego, czy pozwolić GPTBot i innym robotom AI na indeksowanie strony. Właściciele stron dzielą się doświadczeniami, wpływem na wid...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.