Współczynniki konwersji ruchu AI: Dlaczego jakość przewyższa ilość

Dowiedz się, dlaczego ruch AI konwertuje 23x lepiej niż wyszukiwanie organiczne. Sprawdź, jak optymalizować pod platformy AI i mierzyć prawdziwy ROI z wizyt gen...

Odkryj, dlaczego jakość danych jest ważniejsza niż ilość dla modeli AI. Poznaj strategie alokacji zasobów, skutki kosztowe oraz praktyczne ramy optymalizacji inwestycji w dane treningowe AI.

Utrwalona wiedza w uczeniu maszynowym od dawna głosi, że „więcej danych to zawsze lepiej”. Jednak najnowsze badania kwestionują to założenie, przedstawiając przekonujące dowody, że jakość danych znacznie przewyższa ilość w określaniu wydajności modeli AI. Badanie z arxiv z 2024 roku (2411.15821) analizujące małe modele językowe wykazało, że jakość danych treningowych odgrywa znacznie większą rolę niż sama objętość, ujawniając, że zależność między ilością danych a dokładnością modelu jest znacznie bardziej złożona, niż wcześniej sądzono. Konsekwencje kosztowe są znaczące: organizacje, które mocno inwestują w pozyskiwanie danych bez priorytetu dla jakości, często marnują zasoby na przechowywanie, przetwarzanie i koszty obliczeniowe, osiągając przy tym malejące korzyści w zakresie wydajności modeli.

Jakość danych to nie jednolity koncept, lecz wielowymiarowa rama obejmująca kilka kluczowych aspektów. Dokładność odnosi się do tego, na ile dane odpowiadają rzeczywistości oraz czy etykiety są przypisane prawidłowo. Spójność zapewnia jednolitość formatów i standardów w całym zbiorze danych. Kompletność mierzy, czy wszystkie potrzebne informacje są obecne i nie ma istotnych luk lub braków. Trafność określa, czy dane bezpośrednio odnoszą się do problemu, który model AI ma rozwiązać. Wiarygodność wskazuje na zaufanie do źródła danych i jego stabilność w czasie. Wreszcie, szum to niepożądane wariacje lub błędy mogące wprowadzać model w błąd podczas treningu. Zrozumienie tych wymiarów pomaga organizacjom strategicznie priorytetyzować wysiłki związane z kuracją danych.

| Wymiar jakości | Definicja | Wpływ na AI |

|---|---|---|

| Dokładność | Poprawność etykiet i reprezentacji danych | Bezpośrednio wpływa na wiarygodność przewidywań modelu; błędne etykiety powodują systematyczne błędy |

| Spójność | Jednolite formatowanie i ustandaryzowana struktura danych | Zapewnia stabilny trening; niespójności mylą algorytmy uczące się |

| Kompletność | Obecność wszystkich potrzebnych informacji bez braków | Brakujące wartości zmniejszają efektywną ilość danych treningowych; wpływają na uogólnianie |

| Trafność | Dane bezpośrednio dotyczą domeny problemu | Wysoce trafne dane przewyższają duże ilości danych ogólnych |

| Wiarygodność | Zaufanie do źródeł danych i ich stabilność | Niewiarygodne źródła wprowadzają systematyczne błędy; wpływają na odporność modelu |

| Szum | Niepożądane wariacje i błędy pomiarowe | Kontrolowany szum poprawia odporność; nadmiar szumu pogarsza wydajność |

Dążenie do ilości danych bez zabezpieczeń jakościowych wywołuje lawinę problemów wykraczających daleko poza metryki wydajności modeli. Badania Rishabha Iyera pokazują, że eksperymenty z szumem etykiet ujawniają dramatyczne spadki dokładności—błędnie oznaczone dane aktywnie pogarszają jakość modeli, zamiast po prostu dostarczać neutralnych przykładów treningowych. Poza aspektami dokładności, organizacje mierzą się z rosnącymi kosztami przechowywania i przetwarzania zbiorów danych, które nie poprawiają działania modeli, a także istotnymi kosztami środowiskowymi wynikającymi z niepotrzebnego zużycia mocy obliczeniowej. Obrazowanie medyczne to trzeźwiący przykład z życia: zbiór tysięcy błędnie oznaczonych zdjęć rentgenowskich może wytrenować model, który z przekonaniem popełnia groźne błędy diagnostyczne, potencjalnie zagrażając pacjentom. Fałszywa ekonomia taniego, niskiej jakości pozyskiwania danych staje się widoczna, gdy uwzględnić koszty ponownego treningu, debugowania i niepowodzeń wdrożeniowych spowodowanych złymi danymi treningowymi.

Jakość specyficzna dla domeny regularnie przewyższa ogólną objętość w praktycznych zastosowaniach AI. Rozważmy klasyfikator sentymentu dla recenzji filmowych: starannie wyselekcjonowany zbiór 10 000 recenzji filmowych znacznie przewyższy ogólny zbiór 100 000 przykładów z wiadomości finansowych, mediów społecznościowych i recenzji produktów. Trafność danych treningowych względem konkretnej domeny problemowej ma znacznie większe znaczenie niż czysta skala, ponieważ modele uczą się wzorców typowych dla rozkładu treningowego. Gdy dane nie są powiązane z docelowym zastosowaniem, model uczy się fałszywych korelacji i nie uogólnia się na rzeczywiste przypadki użycia. Organizacje powinny priorytetyzować gromadzenie mniejszych zbiorów dokładnie dopasowanych do problemu zamiast akumulowania ogromnych ogólnych zbiorów wymagających intensywnej filtracji i wstępnego przetwarzania.

Optymalne podejście do strategii danych nie leży na żadnym z ekstremów, lecz w znalezieniu „strefy Goldilocks”—czyli punktu równowagi między ilością a jakością danych odpowiedniego dla danego problemu. Zbyt mało danych, nawet idealnie oznaczonych, powoduje niedouczenie modeli i uniemożliwia im uchwycenie złożoności świata rzeczywistego. Z kolei nadmiar danych z problemami jakościowymi powoduje marnotrawstwo zasobów obliczeniowych i niestabilność treningu. Badanie z arxiv pokazuje to konkretnie: minimalna duplikacja zwiększyła dokładność o 0,87% przy poziomie 25% duplikatów, podczas gdy nadmierna duplikacja (100%) spowodowała katastrofalny spadek dokładności o 40%. Idealna równowaga zależy od wielu czynników, w tym typu algorytmu, złożoności problemu, dostępnych zasobów obliczeniowych i naturalnej zmienności w docelowej domenie. Rozkład danych powinien odzwierciedlać rzeczywistą zmienność, a nie być sztucznie ujednolicony, co pozwala modelom uczyć się radzenia sobie z różnorodnością występującą w produkcji.

Nie wszystkie dodatkowe dane są sobie równe—rozróżnienie między korzystną augmentacją a szkodliwą degradacją jest kluczowe dla skutecznej strategii. Kontrolowane przekształcenia i techniki augmentacji poprawiają odporność modeli, ucząc algorytmy radzenia sobie z wariacjami rzeczywistymi, jak np. drobne obroty, zmiany oświetlenia czy niewielkie wariacje etykiet. Przykład zbioru MNIST z odręcznymi cyframi: modele trenowane na wersjach z augmentacją (obroty, skalowanie, lekkie zniekształcenia) lepiej generalizują do rzeczywistych ręcznych zapisów niż modele uczone wyłącznie na oryginałach. Jednak poważne uszkodzenia—losowy szum, systematyczne błędne oznaczenia czy wtrysk nieistotnych danych—aktywnie pogarszają wyniki i marnują zasoby. Kluczowa różnica to intencjonalność: augmentacja jest celowo zaprojektowana, by odzwierciedlać realistyczne wariacje, podczas gdy dane śmieciowe to bezładny szum mylący algorytmy. Organizacje muszą odróżniać te podejścia podczas rozbudowy zbiorów danych.

Dla organizacji z ograniczonymi zasobami uczenie aktywne zapewnia potężne rozwiązanie pozwalające zmniejszyć zapotrzebowanie na dane przy zachowaniu lub poprawie wydajności modeli. Zamiast biernie gromadzić i oznaczać wszystkie dostępne dane, algorytmy uczenia aktywnego identyfikują, które nieoznaczone przykłady będą najbardziej przydatne dla modelu, znacząco ograniczając nakład pracy na etykietowanie. Pozwala to osiągać wysoką wydajność modelu przy znacznie mniejszej ilości oznaczonych danych, skupiając wysiłek ludzki na najbardziej wartościowych przykładach. Uczenie aktywne demokratyzuje rozwój AI, czyniąc go dostępnym dla zespołów bez ogromnych budżetów na etykietowanie, pozwalając im budować skuteczne modele dzięki strategicznemu doborowi danych, a nie czystej objętości. Ucząc się efektywnie na mniejszej liczbie danych, organizacje mogą szybciej iterować, ograniczać koszty i przenosić zasoby na zapewnianie jakości, zamiast na niekończące się pozyskiwanie danych.

Strategiczna alokacja zasobów wymaga fundamentalnego priorytetowania jakości nad ilością w decyzjach dotyczących danych. Organizacje powinny inwestować w solidne pipeline’y walidacji danych wychwytujące błędy zanim trafią do zbiorów treningowych, wdrażając automatyczne kontrole spójności, kompletności i dokładności. Narzędzia do profilowania danych mogą wykrywać problemy jakościowe na dużą skalę, ujawniając wzorce błędnych oznaczeń, brakujących wartości czy nieistotnych przykładów do usunięcia przed treningiem. Uczenie aktywne redukuje ilość danych wymagających przeglądu ludzkiego, gwarantując, że sprawdzane przykłady mają największy wpływ. Ciągły monitoring wydajności modelu w produkcji ujawnia, czy jakość danych treningowych przekłada się na rzeczywiste niepowodzenia, umożliwiając szybkie pętle zwrotne poprawiające proces. Optymalna strategia równoważy pozyskiwanie danych z rygorystyczną kuracją, uznając, że 1 000 perfekcyjnie oznaczonych przykładów często przewyższa 100 000 szumiących zarówno pod względem wydajności, jak i całkowitych kosztów.

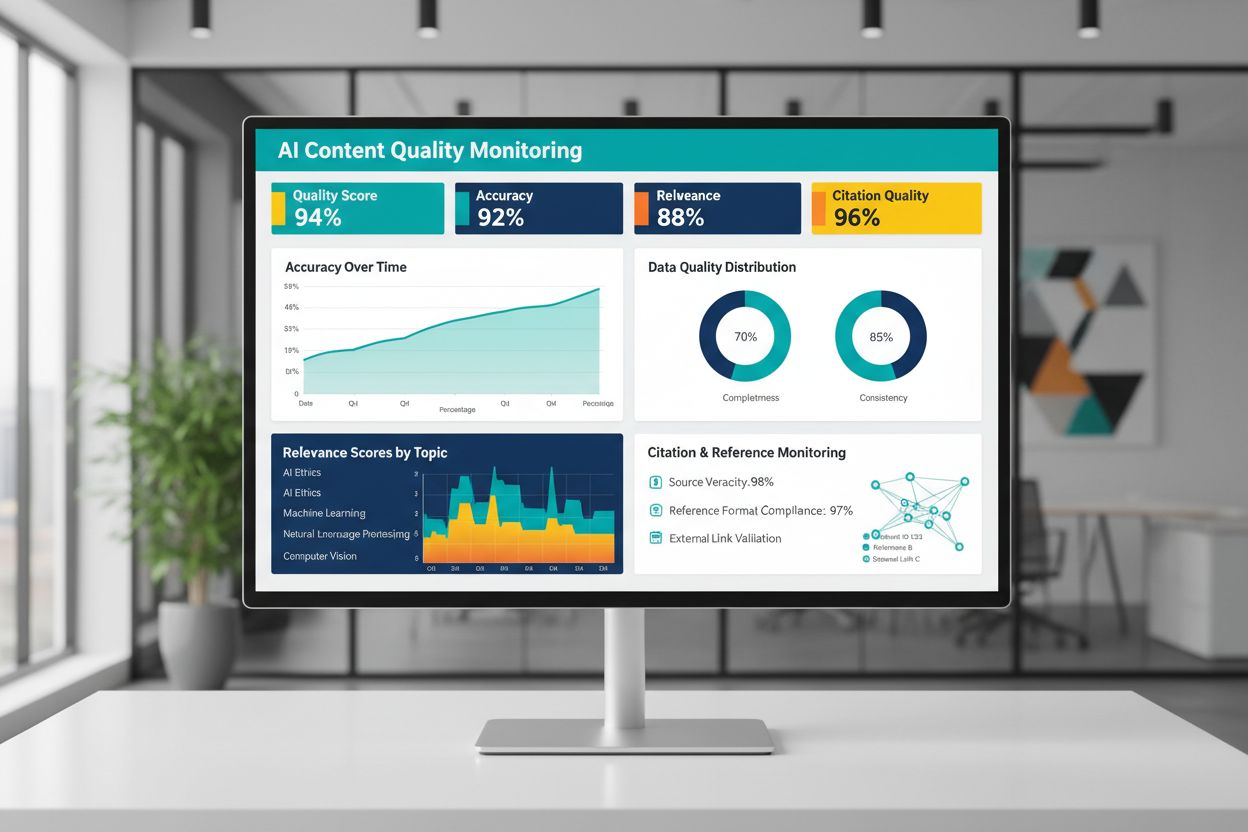

Jakość treści generowanych przez AI lub trenowanych przez AI zależy fundamentalnie od jakości danych treningowych, dlatego ciągły monitoring wyników AI jest niezbędny dla zachowania wiarygodności. Platformy takie jak AmICited.com odpowiadają na tę potrzebę, monitorując odpowiedzi AI i śledząc poprawność cytowań—bezpośredni wskaźnik jakości i wiarygodności treści. Gdy systemy AI są trenowane na danych niskiej jakości, z błędnymi cytowaniami lub niepoprawnymi informacjami, ich odpowiedzi dziedziczą te wady, potencjalnie rozpowszechniając dezinformację na dużą skalę. Narzędzia monitorujące powinny śledzić nie tylko metryki dokładności, ale również trafność, spójność i obecność dowodów wspierających twierdzenia AI. Organizacje wdrażające AI muszą ustanawiać pętle zwrotne wykrywające, kiedy wyniki odbiegają od standardów jakości, umożliwiając szybkie douczanie modeli lub korektę danych. Inwestycja w infrastrukturę monitorującą szybko się zwraca, pozwalając wykryć degradację jakości zanim wpłynie ona na użytkowników lub naruszy wiarygodność organizacji.

Przekładanie zasad jakości danych na praktykę wymaga strukturalnego podejścia, które rozpoczyna się od oceny i przechodzi przez pomiar aż do iteracji. Zacznij od oceny aktualnego poziomu—sprawdź jakość istniejących danych treningowych przez audyty i profilowanie. Zdefiniuj jasne metryki jakości dopasowane do Twojego zastosowania, czy to progi dokładności, standardy spójności, czy kryteria trafności. Wprowadź praktyki zarządzania danymi ustalające odpowiedzialność, procedury walidacji i bramki jakości przed wejściem danych do pipeline’u treningowego. Zacznij od mniejszych, starannie wyselekcjonowanych zbiorów zamiast od razu przetwarzać ogromne wolumeny, co pozwoli wdrożyć standardy jakości i procesy na kontrolowaną skalę. Mierz postępy precyzyjnie, porównując wyniki modeli przed i po interwencjach jakościowych, uzyskując dowody na sens dalszych inwestycji. Skaluj stopniowo, doskonaląc procesy i rozszerzając zbiory danych dopiero po udowodnieniu, że poprawa jakości przekłada się na rzeczywiste zyski.

Nie. Najnowsze badania pokazują, że jakość danych często liczy się bardziej niż ich ilość. Dane słabej jakości, błędnie oznaczone lub nieistotne mogą aktywnie pogarszać wydajność modelu, nawet w dużej skali. Kluczem jest znalezienie właściwej równowagi między wystarczającą ilością danych do skutecznego treningu a utrzymaniem wysokich standardów jakości.

Jakość danych obejmuje wiele wymiarów: dokładność (poprawne etykiety), spójność (jednolite formatowanie), kompletność (brak brakujących wartości), trafność (zgodność z problemem), wiarygodność (zaufane źródła) i poziom szumu. Zdefiniuj metryki dopasowane do Twojego zastosowania i wdroż bramki walidacyjne wychwytujące problemy z jakością przed treningiem.

Idealny rozmiar zależy od złożoności algorytmu, typu problemu i dostępnych zasobów. Zamiast dążyć do maksymalnego rozmiaru, celuj w „strefę Goldilocks”—czyli tyle danych, by uchwycić prawidłowości ze świata rzeczywistego, bez przeładowania zbioru nieistotnymi lub powtarzalnymi przykładami. Zacznij od niewielkiej liczby wyselekcjonowanych danych i skaluj stopniowo, obserwując poprawę wyników.

Augmentacja danych polega na kontrolowanych przekształceniach (obrotach, drobnych zniekształceniach, zmianach oświetlenia), które zachowują prawdziwą etykietę, ucząc modele radzenia sobie ze zmiennością świata rzeczywistego. To coś innego niż dane śmieciowe—augmentacja jest celowa i odzwierciedla realistyczne wariacje, dzięki czemu modele są bardziej odporne po wdrożeniu.

Uczenie aktywne identyfikuje, które nieoznaczone przykłady będą najbardziej informatywne dla modelu, znacząco redukując nakład pracy przy etykietowaniu. Zamiast oznaczać wszystkie dostępne dane, skupiasz wysiłek ludzki na najistotniejszych przykładach, osiągając wysoką wydajność przy znacznie mniejszej ilości oznaczonych danych.

Priorytet dla jakości nad ilością. Inwestuj w walidację danych, narzędzia do profilowania oraz procesy zarządzania, które zapewniają wysoką jakość danych treningowych. Badania pokazują, że 1 000 perfekcyjnie oznaczonych przykładów często przewyższa 100 000 szumiących pod względem wydajności modelu i całkowitych kosztów utrzymania.

Dane słabej jakości generują wiele kosztów: ponowne treningi modeli, debugowanie, niepowodzenia wdrożeń, koszty magazynowania i marnowanie zasobów obliczeniowych. W krytycznych dziedzinach, takich jak obrazowanie medyczne, niska jakość danych treningowych może skutkować niebezpiecznymi błędami. Fałszywa oszczędność tanich, niskiej jakości danych staje się widoczna, gdy uwzględnić te ukryte koszty.

Wdróż ciągłe monitorowanie wyników AI, śledząc dokładność, trafność, spójność i jakość cytowań. Platformy takie jak AmICited monitorują, jak systemy AI odnoszą się do informacji i śledzą poprawność cytowań. Ustanów pętle zwrotne łączące wyniki produkcyjne z jakością danych treningowych, by szybko usprawniać proces.

Śledź, jak systemy AI odnoszą się do Twojej marki i zapewnij dokładność treści dzięki platformie monitoringu AI AmICited. Zrozum jakość odpowiedzi generowanych przez AI na temat Twojego biznesu.

Dowiedz się, dlaczego ruch AI konwertuje 23x lepiej niż wyszukiwanie organiczne. Sprawdź, jak optymalizować pod platformy AI i mierzyć prawdziwy ROI z wizyt gen...

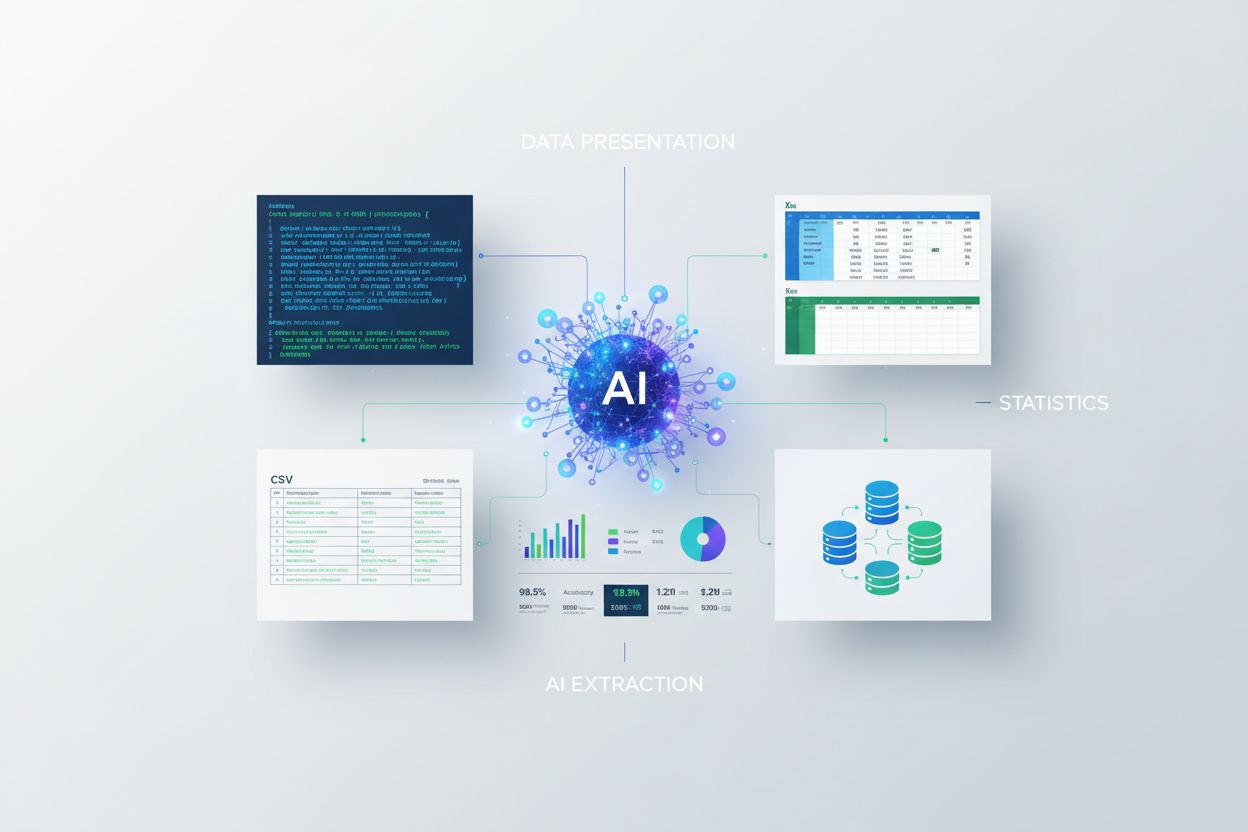

Dowiedz się, jak prezentować statystyki do ekstrakcji przez AI. Poznaj najlepsze praktyki formatowania danych, porównanie JSON vs CSV oraz jak przygotować dane ...

Dyskusja społeczności na temat wymagań jakościowych treści dla cytowań w wyszukiwarkach AI. Zrozumienie, jaki próg jakości trzeba spełnić, by być cytowanym prze...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.