LLM Meta Answers

Dowiedz się, czym są LLM Meta Answers i jak optymalizować treści, by zwiększyć ich widoczność w odpowiedziach generowanych przez AI takich jak ChatGPT, Perplexi...

Dowiedz się, jak tworzyć metaodpowiedzi LLM, które są cytowane przez systemy AI. Poznaj techniki strukturalne, strategie zagęszczania odpowiedzi i formaty treści gotowych do cytowania, które zwiększają widoczność w wynikach wyszukiwania AI.

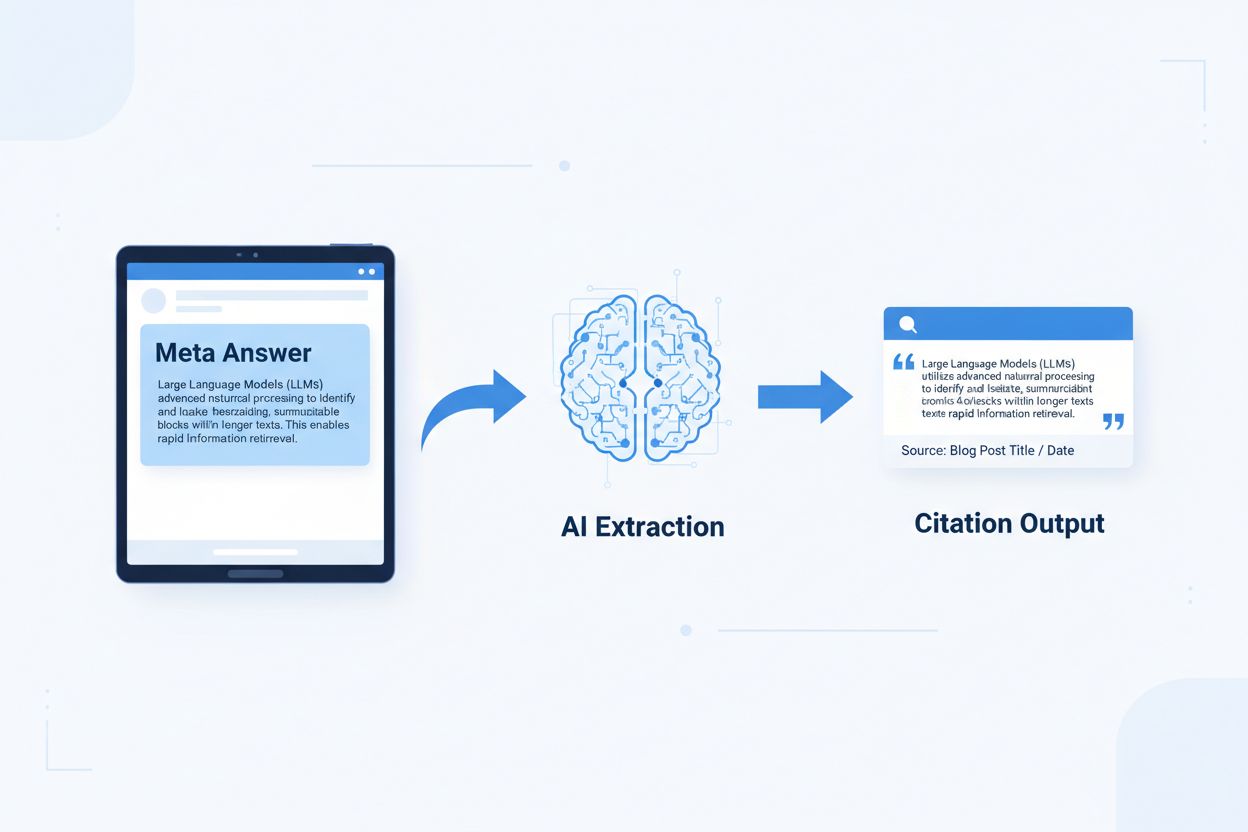

Metaodpowiedzi LLM to samodzielne, zoptymalizowane pod AI bloki treści, które mogą być bezpośrednio wyodrębniane i cytowane przez modele językowe bez potrzeby dodatkowego kontekstu. W przeciwieństwie do tradycyjnej treści internetowej, która opiera się na nawigacji, nagłówkach i otaczającym kontekście dla nadania znaczenia, metaodpowiedzi funkcjonują jako samodzielne wnioski, zachowujące pełną wartość semantyczną nawet po wyizolowaniu. To rozróżnienie ma znaczenie, ponieważ współczesne systemy AI nie czytają stron internetowych jak ludzie—dzielą treść na fragmenty, oceniają jej trafność i wydobywają fragmenty wspierające ich odpowiedzi. Gdy AI napotyka dobrze zbudowane metaodpowiedzi, może je cytować z pewnością, ponieważ informacje są kompletne, weryfikowalne i niezależne kontekstowo. Badania Onely wskazują, że treści zoptymalizowane pod kątem cytowań przez AI otrzymują 3-5 razy więcej wzmianek w wynikach LLM w porównaniu do treści w tradycyjnym formacie, co bezpośrednio wpływa na widoczność marki w odpowiedziach generowanych przez AI. Ta zmiana to fundamentalna transformacja: zamiast rywalizować o pozycje w wyszukiwarkach, metaodpowiedzi konkurują o uwzględnienie w odpowiedziach AI. Platformy monitorujące cytowania, takie jak AmICited.com, śledzą te wzmianki AI jako kluczowy wskaźnik efektywności, ujawniając, że organizacje z treściami gotowymi do cytowania odnotowują mierzalny wzrost ruchu oraz autorytetu marki generowanego przez AI. Połączenie jest bezpośrednie—treści skonstruowane jako metaodpowiedzi są cytowane częściej, co zwiększa widoczność marki w środowisku informacji zdominowanym przez AI.

Treść gotowa do cytowania wymaga konkretnych elementów strukturalnych, które sygnalizują systemom AI: „To jest kompletna odpowiedź nadająca się do cytowania”. Najskuteczniejsze metaodpowiedzi łączą jasne zdanie wprowadzające, dowody wspierające i samodzielne podsumowanie w jednej logicznej całości. Te elementy współdziałają, tworząc to, co systemy AI rozpoznają jako wiedzę nadającą się do ekstrakcji—inforamcje, które mogą istnieć samodzielnie bez potrzeby odwiedzenia strony źródłowej. Takie podejście strukturalne zasadniczo różni się od tradycyjnej treści internetowej, która często rozprasza informacje na wielu stronach i polega na odnośnikach wewnętrznych dla budowy kontekstu.

| Element gotowy do cytowania | Dlaczego systemy AI go preferują |

|---|---|

| Zdanie wprowadzające z tezą | Natychmiast sygnalizuje kluczową wartość odpowiedzi; AI ocenia trafność już w pierwszych 20 tokenach |

| Dowody (dane/przykłady) | Dostarcza weryfikowalnego wsparcia; zwiększa pewność poprawności cytowania |

| Konkretne metryki lub statystyki | Mierzalne twierdzenia są częściej cytowane; zmniejszają niejasność |

| Definicja lub wyjaśnienie | Zapewnia samodzielność; AI nie potrzebuje zewnętrznego kontekstu |

| Wnioski do zastosowania | Sygnalizuje kompletność; informuje AI, że odpowiedź jest zakończona |

| Atrybucja źródła | Buduje zaufanie; AI preferuje cytowanie treści o jasnym pochodzeniu |

Wskazówki wdrożeniowe dla maksymalnej ekstraktowalności przez AI:

Optymalny rozmiar fragmentu do ekstrakcji przez AI to 256-512 tokenów, czyli około 2-4 dobrze skonstruowanych akapitów. Ten zakres to tzw. sweet spot, w którym AI może wydobyć istotne informacje bez utraty kontekstu lub włączania nieistotnych treści. Fragmenty poniżej 256 tokenów często nie zawierają wystarczającego kontekstu do pewnego cytowania, natomiast powyżej 512 tokenów AI musi je podsumowywać lub ucinać, co obniża możliwość bezpośredniego cytowania. Dzielenie według akapitów—gdzie każdy akapit stanowi zamkniętą myśl—sprawdza się lepiej niż arbitralne cięcie po tokenach, ponieważ zachowuje spójność semantyczną i logiczny ciąg, który oceniają systemy AI.

Dobre dzielenie zachowuje granice semantyczne:

✓ DOBRZE: "Treść gotowa do cytowania wymaga konkretnych elementów strukturalnych.

Najskuteczniejsze metaodpowiedzi łączą jasne zdanie wprowadzające,

dowody wspierające i samodzielne podsumowanie w jednej

logicznej całości. Te elementy współdziałają, tworząc to,

co systemy AI rozpoznają jako wiedzę nadającą się do ekstrakcji."

✗ ŹLE: "Treść gotowa do cytowania wymaga konkretnych elementów strukturalnych,

które sygnalizują systemom AI: 'To jest kompletna odpowiedź nadająca się do cytowania'. Najskuteczniejsze metaodpowiedzi łączą jasne zdanie wprowadzające, dowody wspierające i samodzielne podsumowanie w jednej logicznej całości. Te elementy współdziałają, tworząc to, co systemy AI rozpoznają jako wiedzę nadającą się do ekstrakcji—inforamcje, które mogą istnieć samodzielnie bez potrzeby odwiedzenia strony źródłowej. Takie podejście strukturalne zasadniczo różni się od tradycyjnej treści internetowej, która często rozprasza informacje na wielu stronach i polega na odnośnikach wewnętrznych dla budowy kontekstu."

Przykład dobry utrzymuje spójność semantyczną i kończy się w naturalnym punkcie. Zły przykład łączy wiele wątków, zmuszając AI do ucina lub włączania nieistotnego kontekstu. Strategie nakładania się—gdzie ostatnie zdanie fragmentu zapowiada kolejny—pomagają AI zrozumieć powiązania treści bez utraty ekstraktowalności. Praktyczna lista kontrolna dla optymalizacji dzielenia: Czy każdy fragment odpowiada na jedno pytanie? Czy jest zrozumiały bez czytania sąsiednich akapitów? Czy zawiera 256-512 tokenów? Czy kończy się w naturalnym miejscu semantycznym?

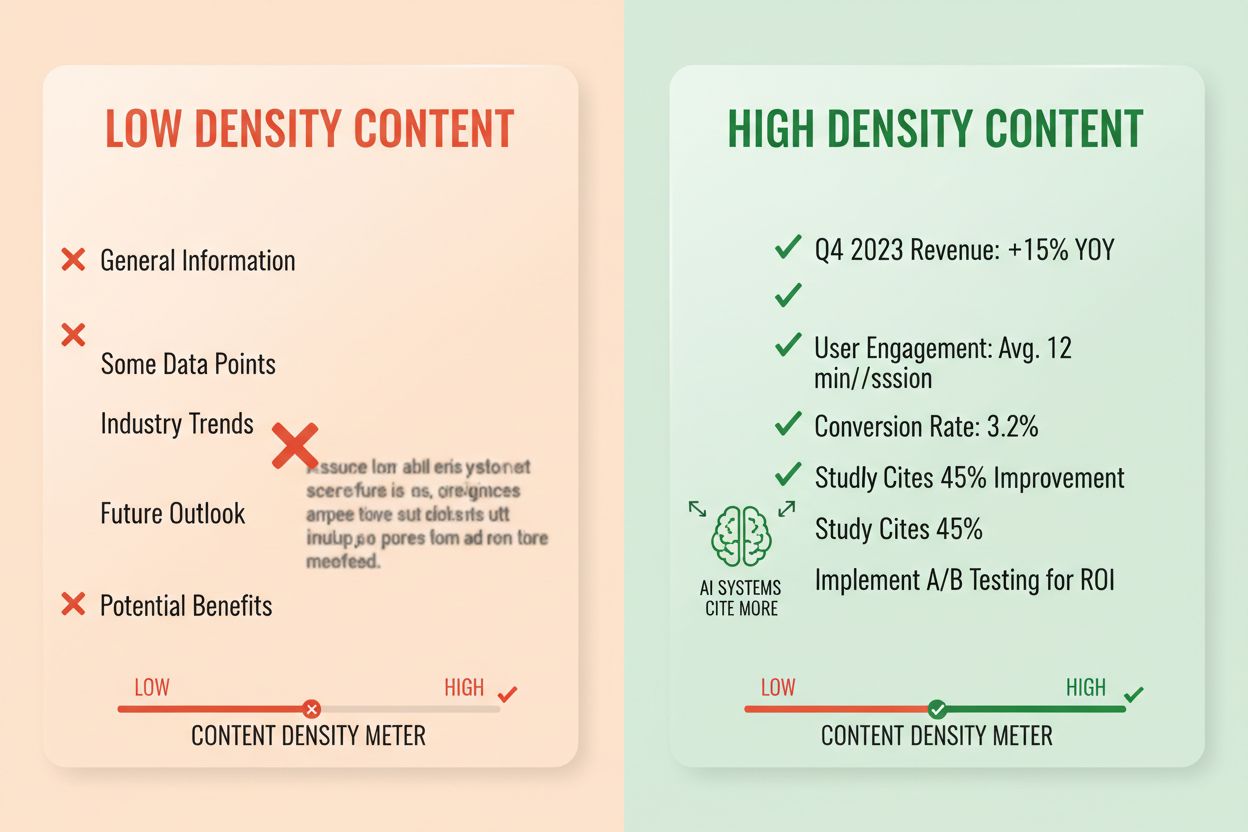

Gęstość odpowiedzi mierzy stosunek informacji praktycznych do całkowitej liczby słów, a treści o wysokiej gęstości uzyskują 2-3 razy więcej cytowań AI niż alternatywy o niskiej gęstości. Akapit o gęstości odpowiedzi 80% zawiera głównie tezy, dowody i praktyczne wnioski, podczas gdy akapit o gęstości 40% zawiera dużo wypełniaczy, powtórzeń lub budowania kontekstu, które nie wspierają bezpośrednio odpowiedzi. Systemy AI oceniają gęstość niejawnie—chętniej wyodrębniają i cytują fragmenty, gdzie każde zdanie przyczynia się do odpowiedzi na pytanie użytkownika. Elementy wysokiej gęstości to konkretne statystyki, instrukcje krok po kroku, dane porównawcze, definicje i praktyczne rekomendacje. Wzorce niskiej gęstości to długie wstępy, powtarzanie, pytania retoryczne i opowiadania, które nie rozwijają głównej tezy.

Sposób pomiaru: Policz zdania, które bezpośrednio odpowiadają na pytanie, w porównaniu do tych, które budują kontekst lub przejścia. Akapit o wysokiej gęstości może wyglądać tak: „Treść gotowa do cytowania otrzymuje 3-5 razy więcej wzmianek w AI (statystyka). Dzieje się tak, ponieważ systemy AI wydobywają kompletne, samodzielne odpowiedzi (wyjaśnienie). Stosuj format odpowiedź-na-początku i semantyczne dzielenie na fragmenty, by zmaksymalizować gęstość (działanie).” Wersja o niskiej gęstości może dodać: „Wiele organizacji ma problem z widocznością w AI. Krajobraz cyfrowy szybko się zmienia. Strategia treści znacznie ewoluowała. Treści gotowe do cytowania stają się coraz ważniejsze…” Druga wersja rozmywa przekaz kontekstem nie wspierającym odpowiedzi.

Rzeczywiste statystyki: Treści o gęstości odpowiedzi powyżej 70% średnio uzyskują 4,2 cytowania miesięcznie w wynikach AI, w porównaniu do 1,1 cytowania dla treści poniżej 40% gęstości. Organizacje, które przebudowały istniejące treści pod kątem gęstości, odnotowały średnio 156% wzrost cytowań w ciągu 60 dni. Przykład wysokiej gęstości: „Używaj fragmentów o długości 256-512 tokenów dla optymalnej ekstrakcji AI (teza). Ten zakres zachowuje kontekst i zapobiega ucinaniu (dowód). Wdrażaj dzielenie według akapitów dla zachowania spójności semantycznej (działanie).” Wersja niskiej gęstości: „Dzielenie na fragmenty jest ważne dla systemów AI. Istnieją różne podejścia do organizacji treści. Niektórzy preferują mniejsze fragmenty, inni większe. Właściwe podejście zależy od twoich potrzeb.” Wersja wysokiej gęstości daje praktyczne wskazówki; niska gęstość prezentuje oczywistości bez konkretów.

Konkretne struktury treści sygnalizują systemom AI, że informacje są zorganizowane do ekstrakcji, znacząco zwiększając prawdopodobieństwo cytowania. Sekcje FAQ są wyjątkowo skuteczne, ponieważ jawnie łączą pytania z kompletnymi odpowiedziami, dzięki czemu AI może łatwo zidentyfikować i wydobyć odpowiednie fragmenty. Tabele porównawcze pozwalają AI szybko ocenić różne opcje i cytować konkretne wiersze odpowiadające na pytania użytkowników. Instrukcje krok po kroku dają wyraźne granice semantyczne i często są cytowane, gdy użytkownicy pytają „jak…”. Listy definicji łączą terminy z wyjaśnieniami, tworząc naturalne punkty do ekstrakcji. Ramki podsumowań podkreślają kluczowe wnioski, a listy artykułowane rozbijają złożone tematy na oddzielne, cytowalne elementy.

Elementy strukturalne maksymalizujące wyszukiwalność AI:

Praktyczne przykłady: Sekcja FAQ z pytaniem „Czym jest gęstość odpowiedzi?” i pełną definicją staje się bezpośrednim źródłem cytowania. Tabela porównawcza „Element gotowy do cytowania | Dlaczego AI to preferuje” (jak w sekcji 2) jest cytowana przy pytaniach porównawczych. Przewodnik „Jak wdrożyć semantyczne dzielenie” z ponumerowanymi krokami staje się cytowaną instrukcją. Te struktury działają, bo odpowiadają sposobowi przetwarzania i ekstrakcji informacji przez AI—AI szuka par pytanie-odpowiedź, porównań i wyraźnych kroków.

Semantyczne znaczniki HTML5 sygnalizują strukturę treści systemom AI, zwiększając dokładność ekstrakcji i prawdopodobieństwo cytowania o 40-60%. Właściwa hierarchia nagłówków (H1 dla głównych tematów, H2 dla podtematów, H3 dla punktów wspierających) pomaga AI zrozumieć relacje i granice ekstrakcji. Semantyczne elementy jak <article>, <section>, <aside> dostarczają dodatkowego kontekstu o przeznaczeniu treści. Oznaczenia schema.org—szczególnie w formacie JSON-LD—wyraźnie informują AI o obecnych informacjach, umożliwiając pewniejsze cytowania.

Przykład JSON-LD dla FAQ:

{

"@context": "https://schema.org",

"@type": "FAQPage",

"mainEntity": [{

"@type": "Question",

"name": "Czym jest gęstość odpowiedzi?",

"acceptedAnswer": {

"@type": "Answer",

"text": "Gęstość odpowiedzi mierzy stosunek informacji praktycznych do liczby słów. Treści o wysokiej gęstości uzyskują 2-3 razy więcej cytowań AI niż alternatywy o niskiej gęstości."

}

}]

}

Przykład JSON-LD dla metadanych artykułu:

{

"@context": "https://schema.org",

"@type": "Article",

"headline": "Tworzenie metaodpowiedzi LLM",

"author": {"@type": "Organization", "name": "AmICited"},

"datePublished": "2024-01-15",

"articleBody": "..."

}

Meta treści—w tym metaopisy i tagi Open Graph—pomagają AI zrozumieć cel treści przed jej analizą. Poprawa wydajności i dostępności (szybkie ładowanie, optymalizacja mobilna, właściwe alt texty) pośrednio wspierają wyszukiwalność AI poprzez zapewnienie pełnej indeksowalności strony. Lista kontrolna wdrożenia technicznego: Czy twój HTML jest semantyczny i właściwie zbudowany? Czy wdrożyłeś oznaczenia schema.org dla swojego typu treści? Czy metaopisy dokładnie podsumowują treść? Czy twoja strona jest zoptymalizowana pod urządzenia mobilne i szybko się ładuje? Czy obrazy mają poprawne opisy alt?

Monitorowanie cytowań stało się kluczowe w mierzeniu skuteczności treści, a większość organizacji nie widzi, jak często ich treści pojawiają się w odpowiedziach AI. Testowanie ekstrakcji polega na zadawaniu docelowych pytań głównym LLM (ChatGPT, Claude, Gemini) i dokumentowaniu, które źródła są cytowane w odpowiedziach. Audyt treści systematycznie ocenia istniejące treści względem standardów gotowości do cytowania, wskazując luki i możliwości optymalizacji. Wskaźniki skuteczności powinny obejmować częstotliwość cytowań, kontekst cytowania (jak treść jest wykorzystywana) oraz dynamikę wzrostu cytowań. Iteracyjna optymalizacja to testowanie zmian strukturalnych, mierzenie wpływu na cytowania i skalowanie skutecznych wzorców.

| Narzędzie monitorujące | Główna funkcja | Najlepsze zastosowanie |

|---|---|---|

| AmICited.com | Kompleksowy monitoring cytowań AI we wszystkich głównych LLM | Pełna widoczność cytowań i analiza konkurencji |

| Otterly.AI | Wykrywanie treści AI i monitorowanie cytowań | Identyfikacja, gdzie twoje treści pojawiają się w wynikach AI |

| Peec AI | Wydajność treści w systemach AI | Pomiar częstotliwości i trendów cytowań |

| ZipTie | Monitoring treści generowanych przez AI | Śledzenie wzmianek o marce w odpowiedziach AI |

| PromptMonitor | Analiza wyników LLM | Zrozumienie, jak AI wykorzystuje twoje treści |

AmICited.com wyróżnia się jako najlepsze rozwiązanie, ponieważ zapewnia monitoring w czasie rzeczywistym w ChatGPT, Claude, Gemini i innych głównych LLM, oferuje benchmarking konkurencji i szczegółowy kontekst cytowań. Platforma pokazuje nie tylko, czy twoja treść jest cytowana, ale jak jest wykorzystywana—czy jest cytowana dosłownie, parafrazowana, czy wykorzystywana jako dowód. Sposób pomiaru: Ustal bazową częstotliwość cytowań dla 20 najważniejszych treści. Wdróż optymalizacje cytowań na 5-10 z nich. Mierz zmiany cytowań przez 30-60 dni. Skaluj skuteczne wzorce na pozostałe treści. Śledź wskaźniki jak częstotliwość cytowań, tempo wzrostu, kontekst cytowania i udział w cytowaniach na tle konkurencji.

Błąd 1: Ukrywanie odpowiedzi w kontekście. Wielu twórców zaczyna od informacji wstępnych, historii lub opisania problemu, zanim poda faktyczną odpowiedź. AI ocenia trafność w pierwszych 50-100 tokenach; jeśli nie znajdzie odpowiedzi, przechodzi do kolejnego źródła. Problem: Użytkownicy pytający „Czym jest gęstość odpowiedzi?” trafiają na akapit zaczynający się od „Strategia treści znacznie ewoluowała…”, zamiast definicji. Rozwiązanie: Stosuj format odpowiedź-na-początku—zacznij od kluczowego wniosku, dopiero potem dodaj kontekst.

Błąd 2: Odpowiedzi wymagające zewnętrznego kontekstu. Treści odwołujące się do „poprzedniej sekcji” lub „jak wspomniano wcześniej” nie mogą być wyodrębnione samodzielnie. Problem: Akapit „Stosując wcześniejsze podejście, wdrażaj te kroki…” odpada, bo brak w nim opisanego podejścia. Rozwiązanie: Każda odpowiedź powinna być samodzielna; zawrzyj niezbędny kontekst w samym fragmencie, nawet jeśli oznacza to drobne powtórzenia.

Błąd 3: Mieszanie kilku odpowiedzi w jednym fragmencie. Akapity odpowiadające na wiele pytań zmuszają AI do ucinania lub włączenia nieistotnych informacji. Problem: Akapit 600-wyrazowy obejmujący „Czym jest gęstość odpowiedzi?” ORAZ „Jak ją mierzyć?” ORAZ „Dlaczego jest ważna?” jest za długi do pewnej ekstrakcji. Rozwiązanie: Twórz osobne, skupione fragmenty dla każdego pytania lub pojęcia.

Błąd 4: Używanie ogólników zamiast konkretnych metryk. Zwroty jak „wiele”, „niektóre”, „często”, „zazwyczaj” obniżają pewność cytowania, bo są nieprecyzyjne. Problem: „Wiele organizacji notuje poprawę” jest mniej cytowalne niż „Organizacje, które zrestrukturyzowały treść, osiągnęły 156% wzrost cytowań.” Rozwiązanie: Zastąp ogólniki konkretnymi danymi; jeśli brak dokładnych liczb, użyj zakresów („40-60%”) zamiast niejasnych określeń.

Błąd 5: Pomijanie znaczników strukturalnych. Treść bez właściwej struktury HTML, nagłówków czy oznaczenia schema.org jest trudniejsza dla AI do analizy i wyodrębnienia. Problem: Akapit bez nagłówka, semantycznego HTML i oznaczeń schema jest traktowany jako tekst ogólny, a nie wyodrębniona odpowiedź. Rozwiązanie: Stosuj semantyczny HTML5, właściwą hierarchię nagłówków i oznaczenia schema.org dla typu treści.

Błąd 6: Zbyt krótkie lub zbyt długie odpowiedzi. Fragmenty poniżej 150 tokenów są zbyt ubogie w kontekst; powyżej 700 wymuszają ucinanie. Problem: Odpowiedź 100-wyrazowa nie zawiera dowodów; 1000-wyrazowa jest dzielona na wiele ekstraktów. Rozwiązanie: Celuj w 256-512 tokenów (2-4 akapity); zawrzyj tezę, dowód i wniosek w tym zakresie.

Spójność pojęć—konsekwentne używanie identycznej terminologii dla tego samego pojęcia w całej treści—zwiększa prawdopodobieństwo cytowania przez AI, sygnalizując autorytatywność wiedzy. Jeśli definiujesz „gęstość odpowiedzi” w jednej sekcji, używaj tej nazwy konsekwentnie, nie zamieniaj na „gęstość informacji” czy „gęstość treści”. AI traktuje spójność pojęć jako sygnał eksperckości i chętniej cytuje treści z precyzyjną, konsekwentną terminologią. Dotyczy to nazw produktów, metodologii, pojęć technicznych—spójność buduje zaufanie do cytowania.

Wzmianki o podmiotach trzecich i własne badania znacząco zwiększają częstotliwość cytowań. Treści odwołujące się do innych autorytatywnych źródeł (z właściwą atrybucją) sygnalizują wiarygodność, a własne badania czy dane czynią treść unikatową i cytowalną. Gdy zamieszczasz statystyki z własnych badań lub studia przypadków własnych klientów, AI rozpoznaje to jako oryginalny wniosek niedostępny gdzie indziej. Organizacje publikujące własne badania mają 3-4 razy wyższy wskaźnik cytowań niż te bazujące wyłącznie na syntezie. Strategia: Przeprowadzaj oryginalne badania branżowe, publikuj wyniki z metodologią i cytuj je w metaodpowiedziach.

Sygnały świeżości—daty publikacji, aktualizacji, odniesienia do bieżących wydarzeń—pomagają AI ocenić aktualność treści. Treści zaktualizowane w ciągu ostatnich 30 dni mają wyższy priorytet cytowania, szczególnie w tematach podlegających szybkim zmianom. Dodaj daty publikacji do schema.org i znaczniki aktualizacji przy każdej rewizji treści. Strategia: Wprowadź harmonogram odświeżania treści; aktualizuj najlepiej działające co 30-60 dni, dodając nowe dane, przykłady czy rozszerzone wyjaśnienia.

Sygnały E-E-A-T (Doświadczenie, Ekspertyza, Autorytatywność, Wiarygodność) wpływają na decyzje AI o cytowaniu. Treści tworzone przez rozpoznawalnych ekspertów, publikowane na domenach autorytatywnych i poparte referencjami uzyskują wyższy priorytet cytowania. Dodawaj biogramy autorów z odpowiednimi kwalifikacjami, publikuj na uznanych domenach i zdobywaj linki zwrotne z branżowych portali. Strategia: Prezentuj ekspertów, zamieszczaj informacje o kwalifikacjach w biogramach autorów, zdobywaj linki z uznanych publikacji branżowych.

Gęstość marki generatywnej—stosunek unikalnych spostrzeżeń markowych do informacji ogólnych—decyduje, czy AI cytuje ciebie, czy konkurencję. Treści zawierające własne ramy działania, unikalne metodologie lub podejścia markowe są chętniej cytowane, bo są wyróżniające. Ogólne treści o „najlepszych praktykach” są cytowane rzadziej niż omówienie „Frameworku Optymalizacji Cytowań AmICited”, bo wersja markowa jest unikalna i identyfikowalna. Organizacje z wysoką gęstością marki

Metaodpowiedzi LLM są projektowane specjalnie pod kątem ekstrakcji i cytowania przez AI, podczas gdy wyróżnione fragmenty są zoptymalizowane pod kątem wyświetlania w wynikach wyszukiwania Google. Metaodpowiedzi priorytetowo traktują samodzielność i spójność semantyczną, podczas gdy wyróżnione fragmenty koncentrują się na zwięzłości i dopasowaniu słów kluczowych. Oba podejścia mogą współistnieć w twoich treściach, ale metaodpowiedzi wymagają innej optymalizacji strukturalnej.

Optymalna długość to 256-512 tokenów, co odpowiada około 2-4 dobrze zbudowanym akapitom lub 200-400 słowom. Ten zakres zapewnia wystarczający kontekst dla pewnej ekstrakcji przez AI, jednocześnie zapobiegając ucinaniu treści. Krótsze odpowiedzi tracą kontekst, dłuższe zmuszają systemy AI do podsumowywania lub dzielenia na wiele ekstraktów.

Tak, ale wymaga to restrukturyzacji. Przeanalizuj istniejące treści pod kątem formatu odpowiedź-na-początku, spójności semantycznej i samodzielności. Większość treści można dostosować, przenosząc kluczowe wnioski na początek, usuwając odwołania krzyżowe i zapewniając, że każda sekcja odpowiada na pełne pytanie bez potrzeby zewnętrznego kontekstu.

Aktualizuj najlepiej działające treści co 30-60 dni, dodając nowe statystyki, najnowsze przykłady lub rozbudowane wyjaśnienia. Systemy AI priorytetowo traktują treści zaktualizowane w ciągu ostatnich 30 dni, szczególnie w tematach, gdzie dane często się zmieniają. Dodaj daty publikacji i aktualizacji w oznaczeniach schema.org.

Gęstość odpowiedzi bezpośrednio koreluje z częstotliwością cytowań. Treści o gęstości odpowiedzi powyżej 70% średnio uzyskują 4,2 cytowania miesięcznie w wynikach AI, w porównaniu do 1,1 cytowania dla treści poniżej 40% gęstości. Treści o wysokiej gęstości przekazują wartościowe informacje bez zbędnych wypełniaczy, co sprawia, że są bardziej wartościowe dla systemów AI do cytowania.

Skorzystaj z platform monitorujących cytowania, takich jak AmICited.com, która śledzi cytowania w ChatGPT, Claude, Gemini i innych głównych LLM. Przeprowadzaj testy ręczne, zadając swoje pytania systemom AI i dokumentując, które źródła są cytowane. Zmierz bazową częstotliwość cytowań, wprowadź optymalizacje i śledź zmiany przez 30-60 dni.

Podstawowa struktura metaodpowiedzi pozostaje spójna na wszystkich platformach, ale możesz zoptymalizować treści pod kątem preferencji danej platformy. ChatGPT preferuje treści kompleksowe i dobrze udokumentowane. Perplexity kładzie nacisk na najnowsze informacje i jasne cytowania. Google AI Overviews stawia na uporządkowane dane i sygnały E-E-A-T. Testuj warianty i monitoruj skuteczność cytowań na różnych platformach.

AmICited zapewnia monitorowanie w czasie rzeczywistym cytowań twoich treści na wszystkich głównych platformach AI, pokazując dokładnie, gdzie pojawiają się twoje metaodpowiedzi, jak są wykorzystywane i jaki masz udział w cytowaniach na tle konkurencji. Platforma ujawnia kontekst cytowań — czy treść jest cytowana dosłownie, parafrazowana, czy wykorzystywana jako dowód — co umożliwia podejmowanie decyzji opartych na danych.

Zobacz dokładnie, gdzie twoje treści są cytowane przez ChatGPT, Perplexity, Google AI Overviews i inne systemy AI. Śledź trendy cytowań, monitoruj konkurencję i optymalizuj swoją strategię treści z AmICited.

Dowiedz się, czym są LLM Meta Answers i jak optymalizować treści, by zwiększyć ich widoczność w odpowiedziach generowanych przez AI takich jak ChatGPT, Perplexi...

Dowiedz się, jak identyfikować i celować w strony źródłowe LLM dla strategicznych backlinków. Sprawdź, które platformy AI najczęściej cytują źródła i zoptymaliz...

Dowiedz się, czym jest LLM Seeding i jak strategicznie publikować treści na platformach o wysokim autorytecie, aby wpłynąć na trenowanie AI i być cytowanym prze...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.