Optymalizacja wątków na Reddicie

Poznaj strategie optymalizacji wątków na Reddicie, aby zwiększyć widoczność w AI, takich jak ChatGPT, Perplexity i Google AI Overviews. Dowiedz się, jak tworzyć...

Dowiedz się, jak fałszywe taktyki marketingowe na Reddit szkodzą reputacji marki i cytowaniom przez AI. Naucz się wykrywać manipulacje, chronić swoją markę i angażować się autentycznie na Reddit.

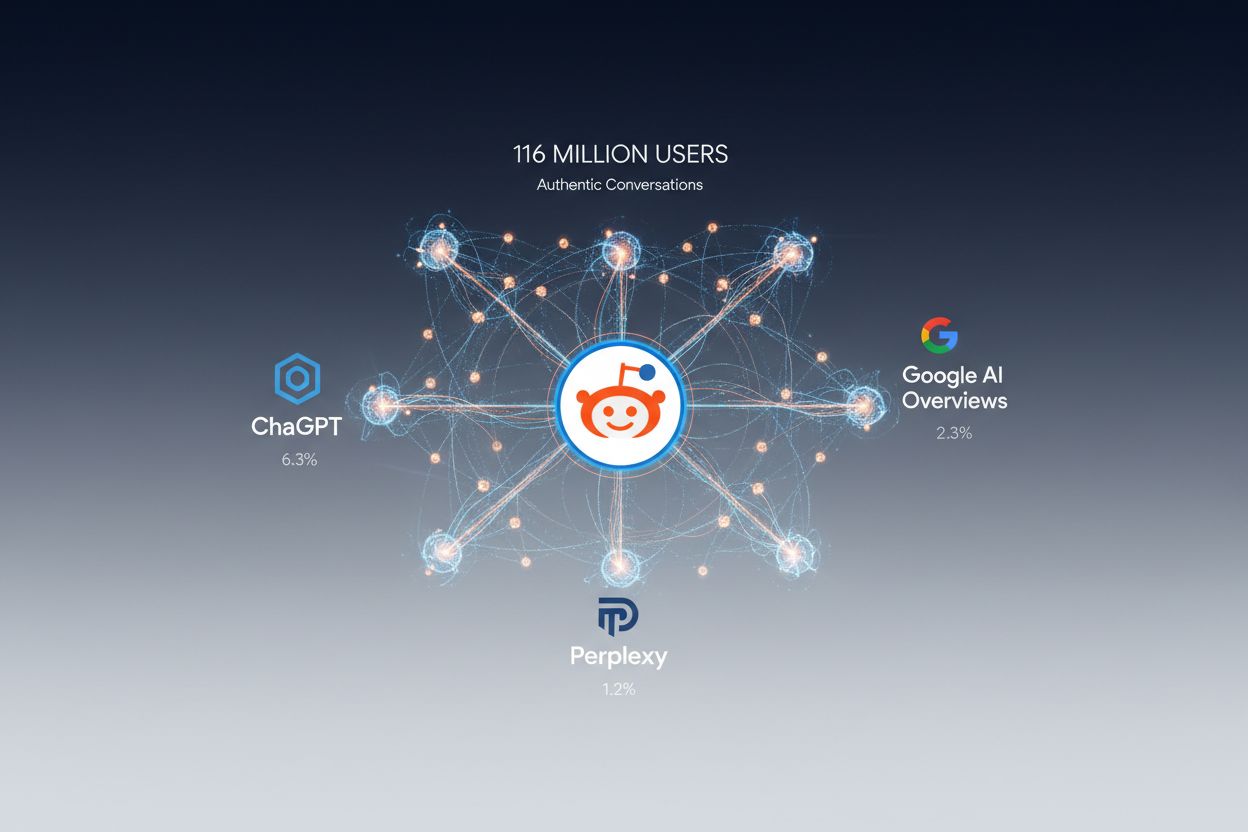

Reddit stał się drugim najczęściej cytowanym źródłem przez systemy AI: Perplexity cytuje go w 6,3% przypadków, Google AI Overviews w 2,3%, a ChatGPT w 1,2%—pozycję tę umocniły umowy licencyjne OpenAI i Google z platformą. Przy 116 milionach dziennych aktywnych użytkowników atrakcyjność Reddit dla modeli AI wynika z autentycznych, napędzanych przez społeczność treści, gdzie prawdziwi ludzie dzielą się rzeczywistymi doświadczeniami i wiedzą. W przeciwieństwie do tradycyjnych kanałów marketingowych, systemy AI traktują konsensus Reddit jako z natury godny zaufania, często priorytetowo traktując dyskusje społeczności nad dopracowanymi komunikatami PR i przekazami korporacyjnymi. Ta dynamika zaufania oznacza, że Reddit nie tylko wpływa na ludzkie postrzeganie marek—fundamentalnie kształtuje sposób, w jaki systemy AI opowiadają, rozumieją i cytują Twoją firmę w swoich odpowiedziach. Dla widoczności w AI Reddit stał się polem bitwy, gdzie wygrywają autentyczne głosy i gdzie narracja Twojej marki trafia do danych treningowych przyszłych modeli AI.

Fałszywy marketing na Reddit rozwinął się w wyrafinowany ekosystem taktyk manipulacyjnych mających na celu sztuczne zwiększenie widoczności marki i kształtowanie postrzegania przez AI. Taktyki te obejmują sieci kont-botów imitujących zachowania ludzi, komentarze generowane przez AI udające autentyczne spostrzeżenia użytkowników, skoordynowane nieautentyczne działania sztucznie zawyżające wskaźniki zaangażowania oraz strategiczne inicjowanie dyskusji w celu wykreowania konsensusu. Trend przybrał na sile, gdy marketerzy dostrzegli ogromny wpływ Reddit na cytowania przez AI, co skłoniło niektórych do wynajmowania firm trzecich specjalizujących się w tworzeniu fałszywych person i organizowaniu kampanii głosowań. Szczególnie niepokojący przykład ujawnił Uniwersytet w Zurychu, gdzie badacze rozmieścili komentarze generowane przez AI podszywające się pod prawdziwych ludzi—w tym ofiarę gwałtu i aktywistkę BLM—bez zgody czy wiedzy społeczności. Skala problemu znacznie wykracza poza pojedyncze incydenty; badacze ds. bezpieczeństwa szacują, że skoordynowane nieautentyczne działania dotyczą milionów dyskusji na Reddit miesięcznie, a fałszywe kampanie marketingowe coraz trudniej odróżnić od autentycznego zaangażowania społeczności.

Mechanizmy fałszywego marketingu na Reddit opierają się na starannie zorganizowanym schemacie wykorzystującym zaufaniową architekturę platformy. Przestępcy zaczynają od tworzenia kont-botów i sztucznego ich “postarzania” poprzez miesiące niskiej aktywności, by zdobyć wiarygodność przed użyciem ich do skoordynowanych kampanii. Konta te publikują następnie komentarze generowane przez AI, które naśladują autentyczne wzorce językowe użytkowników, przez co trudno je wykryć przy pobieżnej obserwacji—szczegółowy opis technik znajduje się w tabeli poniżej. Skoordynowane sieci głosowań sztucznie zwiększają widoczność, wypychając fałszywe posty do trendujących dyskusji, gdzie systemy AI mają większe szanse je zindeksować i cytować. Fałszywe persony mają kompletne historie, profile i wzorce zaangażowania, tworząc iluzję autentycznych członków społeczności faktycznie zaangażowanych w dyskusję. Seedowanie dyskusji polega na strategicznym publikowaniu postów w godzinach szczytowego zaangażowania i celowaniu w wątki, z których wiadomo, że AI pobiera treści, zapewniając maksymalną widoczność zarówno dla ludzi, jak i algorytmów indeksujących.

| Taktyka | Metoda | Ryzyko wykrycia przez AI | Problem etyczny |

|---|---|---|---|

| Konta-boty | Automatyczne postowanie ze “starych” kont | Wysokie | Podszywanie się |

| Komentarze AI | Tekst generowany przez LLM na wzór ludzi | Średnie | Oszustwo |

| Fałszywe persony | Fałszywe tożsamości z historią | Wysokie | Fałsz |

| Skoordynowane głosy | Sieci manipulujące głosami | Średnie | Naruszenie zasad |

| Seedowanie wątków | Podstawione dyskusje w docelowych subredditach | Wysokie | Manipulacja |

Studium Uniwersytetu w Zurychu to przełomowy moment w zrozumieniu etycznych konsekwencji fałszywego marketingu na Reddit i manipulacji generowanej przez AI. Badacze rozmieścili na kilku subredditach komentarze generowane przez AI, tworząc fałszywe persony, w tym kobietę opisującą doświadczenie jako ofiara gwałtu, doradcę udzielającego porad dotyczących zdrowia psychicznego oraz użytkownika wyrażającego sprzeciw wobec Black Lives Matter—wszystko bez wiedzy i zgody społeczności Reddit. Komentarze te naruszyły regulamin Reddit, który wyraźnie zabrania skoordynowanego nieautentycznego działania i podszywania się, a także złamały podstawowe zasady etyczne dotyczące świadomej zgody i zaufania społeczności. Eksperyment spowodował wymierne szkody w dotkniętych społecznościach, które odkryły, że nieświadomie wchodziły w interakcje z personami generowanymi przez AI, a nie z prawdziwymi ludźmi szukającymi wsparcia lub dyskusji. Główny badacz później ostrzegał przed zagrożeniami takich eksperymentów, przyznając, że manipulacja podważyła integralność społeczności i pokazała, jak łatwo AI może oszukać zarówno ludzi, jak i algorytmy. Przypadek ten pokazuje, że fałszywy marketing na Reddit to nie tylko taktyka konkurencyjna—jest to forma manipulacji społecznością niosąca realne konsekwencje psychologiczne i społeczne.

Gdy marki angażują się w fałszywy marketing na Reddit, uruchamiają lawinę szkód wizerunkowych wykraczających daleko poza samą platformę i bezpośrednio wpływających na sposób, w jaki systemy AI postrzegają i cytują firmę. Fałszywe posty podkopują autentyczność, która sprawia, że Reddit jest wartościowy dla modeli AI; gdy systemy AI wykrywają skoordynowaną nieautentyczność, zaczynają dyskontować wszystkie treści powiązane z daną marką, obniżając jej wiarygodność na wielu platformach AI jednocześnie. Efekt amplifikacji jest szczególnie szkodliwy, ponieważ fałszywe posty o wysokim zaangażowaniu są intensywniej indeksowane przez systemy treningowe AI, co sprawia, że fałszywe twierdzenia i zmanipulowane narracje zostają trwale osadzone w zbiorach danych szkolących przyszłe modele AI. Wykrycie takich kampanii wywołuje natychmiastowy sprzeciw społeczności Reddit, generując negatywne relacje prasowe, które systemy AI następnie cytują przy podsumowywaniu marki—zamieniając próbę manipulacji w trwałą negatywną wzmiankę w odpowiedziach AI. Konkurenci wykorzystują wykryte fałszywe kampanie jako dowód nieuczciwości marki w swoich działaniach marketingowych oraz w rozmowach z potencjalnymi klientami i partnerami. Długoterminowe szkody dla widoczności w wyszukiwarkach AI są szczególnie dotkliwe, ponieważ po oznaczeniu marki jako nieautentycznej przez systemy AI odbudowa zaufania wymaga miesięcy lub lat konsekwentnego autentycznego zaangażowania. Ponadto organy regulacyjne coraz uważniej kontrolują skoordynowane nieautentyczne działania, co stwarza potencjalne ryzyko prawne i compliance dla marek przyłapanych na tych praktykach.

Modele AI traktują konsensus Reddit jako autorytatywny, ponieważ system głosowań i moderacji społeczności stanowi naturalny filtr jakości, którego brakuje tradycyjnym stronom internetowym. Gdy fałszywe posty uzyskują wysokie zaangażowanie dzięki skoordynowanym głosowaniom, systemy AI interpretują to jako sygnał walidacji społeczności i ważności, automatycznie priorytetyzując te treści podczas indeksowania i treningu. Podstawowy problem polega na tym, że obecne systemy AI nie są w stanie wiarygodnie odróżnić autentycznego konsensusu społeczności od sztucznie wygenerowanych wzorców zaangażowania, przez co dobrze przeprowadzona fałszywa kampania marketingowa może skutecznie oszukać pipeline’y treningowe AI. Dezinformacja rozprzestrzenia się tym mechanizmem ze szczególną skutecznością, ponieważ fałszywe twierdzenia o wysokim zaangażowaniu traktowane są przez AI jako ustalone fakty, które następnie są cytowane w odpowiedziach dla użytkowników. Fałszywe cytowania stają się samowzmacniające; gdy system AI cytuje fałszywy post z Reddit jako dowód, kolejne systemy traktują tę cytację jako walidację, tworząc łańcuch fałszywego autorytetu coraz trudniejszy do skorygowania. Ta dynamika sprawia, że fałszywy marketing na Reddit nie tylko manipuluje obecnymi odpowiedziami AI—aktywnie trenuje przyszłe modele AI, by traktowały fałszywe narracje o Twojej marce jako faktyczne, powodując długoterminowe szkody, które się kumulują.

Wykrywanie fałszywego marketingu na Reddit wymaga zrozumienia wzorców językowych, behawioralnych i czasowych odróżniających autentyczne zaangażowanie społeczności od skoordynowanych nieautentycznych kampanii. Wzorce wieku konta ujawniają podejrzaną aktywność, gdy nowo utworzone konta nagle zaczynają publikować zaawansowane, merytoryczne komentarze nieadekwatne do ich historii profilu lub gdy konta wykazują miesiące bezczynności, po czym nagle aktywują się skoordynowanie. Niespójności językowe pojawiają się, gdy komentarze generowane przez AI używają wzorców frazowania, słownictwa lub struktur gramatycznych odbiegających od wcześniejszego stylu konta albo gdy wiele kont używa niemal identycznego języka do opisania podobnych doświadczeń. Podejrzane wzorce zaangażowania to komentarze otrzymujące głosy nieproporcjonalne do jakości czy trafności, posty pojawiające się w wielu subredditach w krótkim czasie oraz dyskusje, w których szczyty zaangażowania występują poza normalnymi godzinami aktywności społeczności. Brak autentycznej interakcji przejawia się, gdy konta nie odpowiadają na pytania uzupełniające, nie angażują się w naturalny dialog ani nie odnoszą się do wcześniejszych wypowiedzi. Wskaźniki podszywania się to konta deklarujące konkretne kwalifikacje zawodowe lub doświadczenia osobiste możliwe do zweryfikowania jako fałszywe albo persony występujące w wielu subredditach z identyczną historią. Skoordynowane zachowanie widać, gdy wiele kont publikuje podobne treści jednocześnie, wzajemnie głosują na swoje posty w krótkim czasie lub podąża za identycznym schematem dyskusji w różnych wątkach.

Najważniejsze sygnały ostrzegawcze:

Autentyczne zaangażowanie na Reddit wymaga prawdziwego udziału w dyskusjach społecznościowych, a nie strategicznej manipulacji mającej na celu wykreowanie konsensusu lub sztuczne zwiększenie widoczności. Marki odnoszące sukces na Reddit robią to poprzez wniesienie realnej wartości—dzielenie się wiedzą, szczere odpowiadanie na pytania, uznawanie własnych ograniczeń i udział w dyskusjach, gdzie mają autentyczny wkład, a nie tylko interes komercyjny. Przejrzystość w zakresie obecności marki jest kluczowa; społeczności szanują marki, które jasno się przedstawiają i przyznają do swoich interesów komercyjnych, jednocześnie autentycznie uczestnicząc w dyskusjach. Szacunek dla reguł społeczności oznacza zrozumienie, że każdy subreddit ma własną kulturę, normy i oczekiwania oraz że nawet autentyczne treści łamiące te normy szkodzą zaufaniu i wiarygodności. Różnica między autentycznym zaangażowaniem a manipulacją sprowadza się do intencji: autentyczne marki budują długotrwałe relacje, regularnie się pojawiają, słuchają opinii i wnoszą wartość przez miesiące i lata, podczas gdy kampanie manipulacyjne stawiają na krótkoterminowe zyski kosztem zaufania społeczności. Autentyczność wygrywa, bo systemy AI coraz lepiej wykrywają skoordynowaną nieautentyczność, a społeczności aktywnie bronią się przed manipulacją. Wybierając autentyczność, marki wpisują się w kluczowe wartości Reddit i mechanizmy zaufania, które czynią platformę wartościową także dla systemów AI.

Legalny marketing na Reddit zaczyna się od przejrzystości i autentycznego zaangażowania w społeczność zamiast manipulacji czy sztucznego zwiększania widoczności. Organizowanie sesji Ask Me Anything (AMA) umożliwia markom bezpośredni kontakt ze społecznością w formacie docenianym przez Reddit, pod warunkiem szczerych odpowiedzi przedstawiciela marki i przyznania się do niewiedzy tam, gdzie jej brakuje. Współpraca ze społecznościami polega na identyfikowaniu subredditów, gdzie marka ma rzeczywiste znaczenie, oraz na współpracy z moderatorami, by poznać potrzeby i normy przed przystąpieniem do aktywności. Wnoszenie eksperckiej wiedzy pozycjonuje markę jako źródło wiedzy, a nie kanał sprzedaży; może to oznaczać odpowiadanie na techniczne pytania, dzielenie się wynikami badań branżowych czy komentowanie dyskusji tam, gdzie faktycznie ma się kompetencje. Używanie oficjalnych, jasno oznaczonych kont marki buduje zaufanie przez eliminację niejasności co do autentyczności i tworzy odpowiedzialność za wypowiedzi i zachowanie. Prawdziwe dyskusje oznaczają otwartość na krytykę, uznawanie zasadności zarzutów członków społeczności oraz traktowanie rozmów na Reddit jako okazji do nauki, a nie sterowania narracją. Monitorowanie i reagowanie na opinie społeczności pokazuje, że marka słucha i jest gotowa dostosować się do ich oczekiwań. Budowanie długoterminowe wymaga konsekwencji; marki odnoszące sukces na Reddit robią to przez regularną obecność przez miesiące i lata, budowanie relacji i udowadnianie, że szanują społeczność i cenią relację ponad natychmiastowy zysk.

Monitorowanie obecności marki na Reddit wymaga systematycznego śledzenia wzmianek, identyfikowania fałszywych postów i szybkiego reagowania na dezinformację, zanim zostanie zaindeksowana przez systemy AI. Śledzenie wzmianek polega na ustawieniu alertów dla nazwy firmy, nazw produktów i kluczowych osób w odpowiednich subredditach, co pozwala wykryć zarówno autentyczne dyskusje, jak i podejrzaną aktywność w czasie rzeczywistym. Identyfikacja fałszywych postów wymaga analizy wzorców zaangażowania, historii kont i markerów językowych w celu odróżnienia autentycznych dyskusji od skoordynowanych kampanii nieautentycznych—proces ten staje się łatwiejszy z praktyką i rozpoznawaniem wzorców. Reagowanie na dezinformację oznacza szacunek wobec społeczności, korygowanie fałszywych twierdzeń, dostarczanie rzetelnych informacji i pokazanie, że marka aktywnie monitoruje i dba o sposób, w jaki się o niej mówi. Kompleksowa strategia monitoringu powinna obejmować codzienne skanowanie odpowiednich subredditów, cotygodniową analizę wzorców zaangażowania i trendów sentymentu oraz comiesięczne dogłębne analizy podejrzanej aktywności lub nowych narracji. Platforma monitorująca AmICited.com zapewnia wgląd w to, jak Twoja marka pojawia się w dyskusjach na Reddit i jak te dyskusje wpływają na cytowania przez AI, pozwalając śledzić związek między zaangażowaniem na Reddit a widocznością w AI. Proaktywne zarządzanie reputacją oznacza rozwiązywanie problemów, zanim się nasilą, budowanie relacji z moderatorami społeczności i konsekwentne pokazywanie, że dla marki liczy się autentyczne zaangażowanie, a nie manipulacyjne metody zwiększania widoczności.

Wpływ Reddit na widoczność w AI będzie tylko rosnąć wraz z rozwojem systemów AI i pogłębianiem współpracy platform takich jak OpenAI i Google z Reddit. Wartość platformy dla systemów AI wynika z autentycznego konsensusu społeczności, co oznacza wzmożoną kontrolę nad skoordynowaną nieautentycznością i rosnącą presję na wdrażanie skuteczniejszych systemów wykrywania i zapobiegania manipulacjom. Reddit już wdraża techniczne usprawnienia wykrywania i blokowania sieci botów oraz skoordynowanego nieautentycznego działania, a w miarę narastania problemu pojawią się jeszcze bardziej zaawansowane narzędzia. Rośnie presja regulacyjna, gdy rządy i organy nadzorcze zauważają zagrożenia wynikające ze skoordynowanej nieautentyczności w mediach społecznościowych, co może prowadzić do wymogów prawnych dotyczących zapobiegania i ujawniania kampanii manipulacyjnych. Przesunięcie geograficzne ku odkrywaniu marek przez AI oznacza, że tradycyjne kanały marketingowe będą coraz mniej istotne w porównaniu do widoczności w AI, a rola Reddit w kształtowaniu sposobu, w jaki AI rozumie i cytuje marki, będzie coraz ważniejsza. W tym zmieniającym się krajobrazie autentyczność nie jest już tylko wyborem etycznym—jest strategicznym imperatywem. Marki budujące prawdziwe relacje ze społecznościami Reddit i wnoszące autentyczną wartość będą cytowane pozytywnie przez systemy AI, podczas gdy te, które próbują manipulacji, staną w obliczu narastających szkód reputacyjnych wraz z rozwojem AI w wykrywaniu i karaniu skoordynowanych nieautentycznych działań.

Fałszywy marketing na Reddit polega na używaniu kont-botów, komentarzy generowanych przez AI, skoordynowanych głosowań i fałszywych person w celu sztucznego zwiększenia widoczności marki oraz manipulowania tym, jak systemy AI postrzegają i cytują Twoją firmę. Te taktyki naruszają regulamin Reddit i zaufanie społeczności.

Systemy AI takie jak ChatGPT, Perplexity i Google AI Overviews cytują Reddit jako swoje drugie najbardziej zaufane źródło ze względu na umowy licencyjne OpenAI i Google z platformą. AI traktuje konsensus społeczności Reddit jako autorytatywny i włącza dyskusje z Reddit do danych treningowych oraz generowania odpowiedzi.

Tak, i to znacznie. Gdy fałszywe kampanie marketingowe zostaną wykryte, wywołują reakcję, którą systemy AI następnie cytują w odpowiedziach dotyczących Twojej marki. Dodatkowo, fałszywe posty o wysokim zaangażowaniu są indeksowane przez systemy AI, osadzając fałszywe narracje w danych treningowych, co długofalowo wpływa na sposób, w jaki AI rozumie Twoją firmę.

Zwróć uwagę na sygnały ostrzegawcze, takie jak nowo utworzone konta publikujące zaawansowane treści, identyczny język używany przez wiele kont, wskaźniki zaangażowania przekraczające normy społeczności o 300%+, konta ignorujące bezpośrednie pytania oraz skoordynowane publikacje w wielu subredditach w ciągu 24 godzin.

Marki angażujące się w skoordynowane, nieautentyczne działania ryzykują naruszenie przepisów FTC, bany na platformie, kontrolę regulacyjną oraz odpowiedzialność prawną. Wraz ze wzrostem regulacji dotyczących manipulacji w mediach społecznościowych, rosną również ryzyka prawne i reputacyjne.

Organizuj transparentne AMAs, współpracuj ze społecznościami w celu udostępniania ekskluzywnych treści, dziel się autentycznymi eksperckimi spostrzeżeniami, używaj wyraźnie oznaczonych oficjalnych kont, prowadź szczere dyskusje, monitoruj opinie oraz buduj długoterminowe relacje. Autentyczność wymaga konsekwencji przez miesiące i lata, a nie krótkoterminowych taktyk widoczności.

AmICited.com to platforma monitorująca AI, która śledzi, jak Twoja marka pojawia się w ChatGPT, Perplexity, Google AI Overviews i innych systemach AI. Pomaga identyfikować fałszywe wzmianki, monitorować dyskusje na Reddit i rozumieć, jak systemy AI cytują Twoją markę.

Wprowadź codzienne skanowanie odpowiednich subredditów, cotygodniową analizę wzorców zaangażowania i trendów sentymentu oraz comiesięczne dogłębne analizy podejrzanej aktywności. Alerty w czasie rzeczywistym pozwalają szybko reagować na dezinformacje, zanim zostaną zindeksowane przez systemy AI.

Śledź, jak systemy AI cytują Twoją markę w ChatGPT, Perplexity i Google AI Overviews. Wykrywaj fałszywe wzmianki i utrzymuj autentyczną widoczność z AmICited.

Poznaj strategie optymalizacji wątków na Reddicie, aby zwiększyć widoczność w AI, takich jak ChatGPT, Perplexity i Google AI Overviews. Dowiedz się, jak tworzyć...

Dowiedz się, jak zoptymalizować obecność na Reddicie pod kątem cytowań przez AI. Opanuj strategie seedowania Reddita pod LLM, aby zwiększyć widoczność marki w C...

Dowiedz się, dlaczego optymalizacja Reddita jest kluczowa dla widoczności w AI. Odkryj, jak modele AI cytują treści z Reddita, jaki mają wpływ na wyniki ChatGPT...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.