Zapobieganie kryzysom widoczności w AI: Strategie proaktywne

Dowiedz się, jak zapobiegać kryzysom widoczności AI dzięki proaktywnemu monitorowaniu, systemom wczesnego ostrzegania i strategicznym protokołom reagowania. Chr...

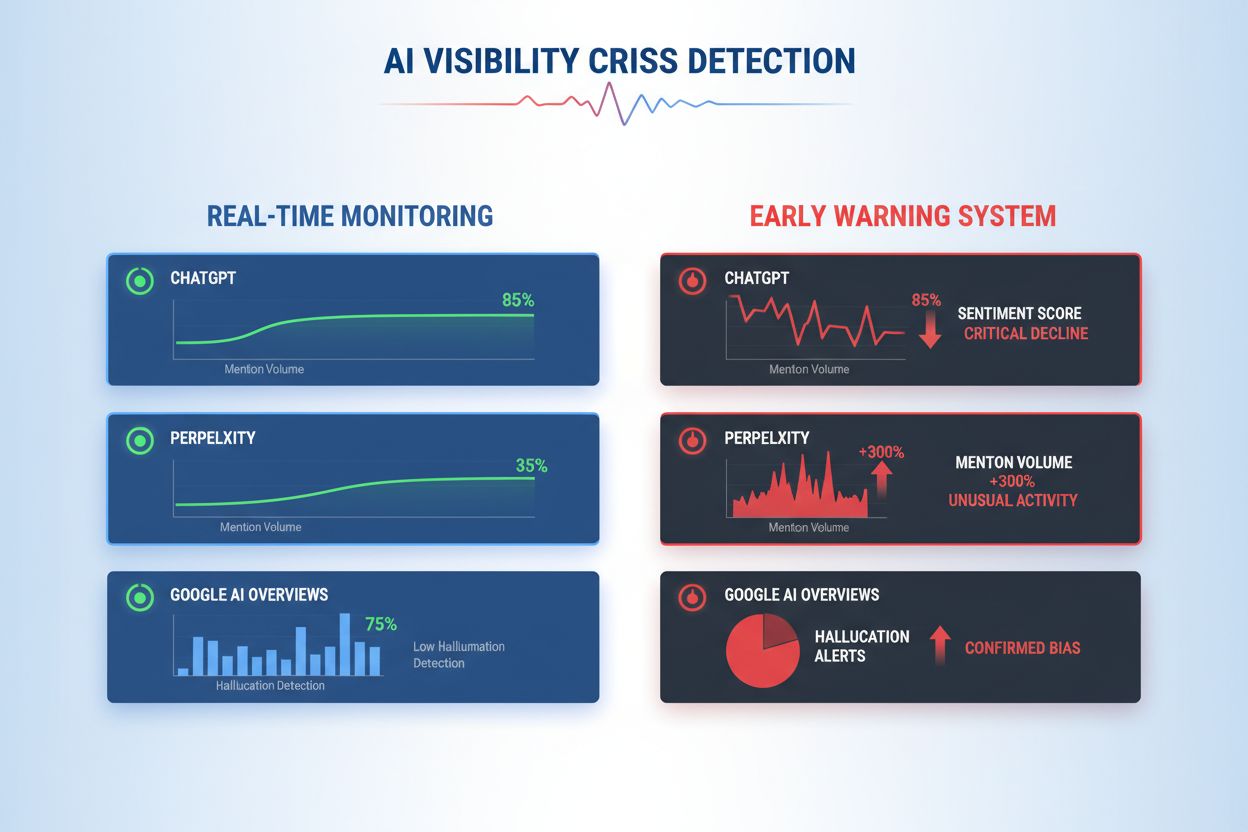

Dowiedz się, jak wcześnie wykrywać kryzysy widoczności AI dzięki monitorowaniu w czasie rzeczywistym, analizie sentymentu i wykrywaniu anomalii. Poznaj sygnały ostrzegawcze oraz najlepsze praktyki ochrony reputacji Twojej marki w AI-wspieranych wyszukiwarkach.

Kryzys widoczności AI pojawia się, gdy systemy sztucznej inteligencji generują nieprawidłowe, wprowadzające w błąd lub szkodliwe odpowiedzi, które niszczą reputację marki i podważają zaufanie publiczne. W przeciwieństwie do tradycyjnych kryzysów PR wywołanych przez ludzkie decyzje lub działania, kryzysy widoczności AI wynikają z przecięcia jakości danych treningowych, algorytmicznych uprzedzeń i generowania treści w czasie rzeczywistym — przez co są znacznie trudniejsze do przewidzenia i kontrolowania. Najnowsze badania pokazują, że 61% konsumentów straciło zaufanie do marek po zetknięciu się z halucynacjami AI lub fałszywymi odpowiedziami AI, a 73% uważa, że firmy powinny odpowiadać za to, co ich systemy AI komunikują publicznie. Kryzysy te rozprzestrzeniają się szybciej niż tradycyjna dezinformacja, ponieważ wydają się autorytatywne, pochodzą z zaufanych kanałów marki i mogą dotrzeć jednocześnie do tysięcy użytkowników, zanim możliwa będzie interwencja człowieka.

Skuteczne wykrywanie kryzysów widoczności AI wymaga monitorowania zarówno wejść (dane, rozmowy, materiały szkoleniowe zasilające Twoje systemy AI), jak i wyjść (to, co Twoja AI faktycznie komunikuje klientom). Monitoring wejść analizuje dane z social listeningu, opinie klientów, zbiory danych treningowych oraz zewnętrzne źródła informacji pod kątem uprzedzeń, dezinformacji czy wzorców mogących zanieczyścić odpowiedzi AI. Monitoring wyjść śledzi, co rzeczywiście generują Twoje systemy AI — odpowiedzi, rekomendacje i treści produkowane w czasie rzeczywistym. Gdy chatbot dużej firmy finansowej zaczął rekomendować inwestycje w kryptowaluty na podstawie stronniczych danych treningowych, kryzys rozprzestrzenił się w mediach społecznościowych w ciągu kilku godzin, wpływając na cenę akcji i zainteresowanie regulatorów. Podobnie, gdy system AI w ochronie zdrowia udzielał nieaktualnych informacji medycznych z uszkodzonych zbiorów danych, wykrycie źródła zajęło trzy dni — w tym czasie tysiące użytkowników otrzymały potencjalnie szkodliwe porady. Luka między jakością wejść a dokładnością wyjść tworzy ślepy punkt, w którym kryzysy mogą rozwijać się niezauważenie.

| Aspekt | Monitoring wejść (Źródła) | Monitoring wyjść (Odpowiedzi AI) |

|---|---|---|

| Co śledzi | Media społecznościowe, blogi, wiadomości, recenzje | ChatGPT, Perplexity, odpowiedzi Google AI |

| Metoda wykrywania | Śledzenie słów kluczowych, analiza sentymentu | Zapytania prompt, analiza odpowiedzi |

| Wskaźnik kryzysu | Wiralowe negatywne posty, rosnące skargi | Halucynacje, błędne rekomendacje |

| Czas reakcji | Godziny do dni | Minuty do godzin |

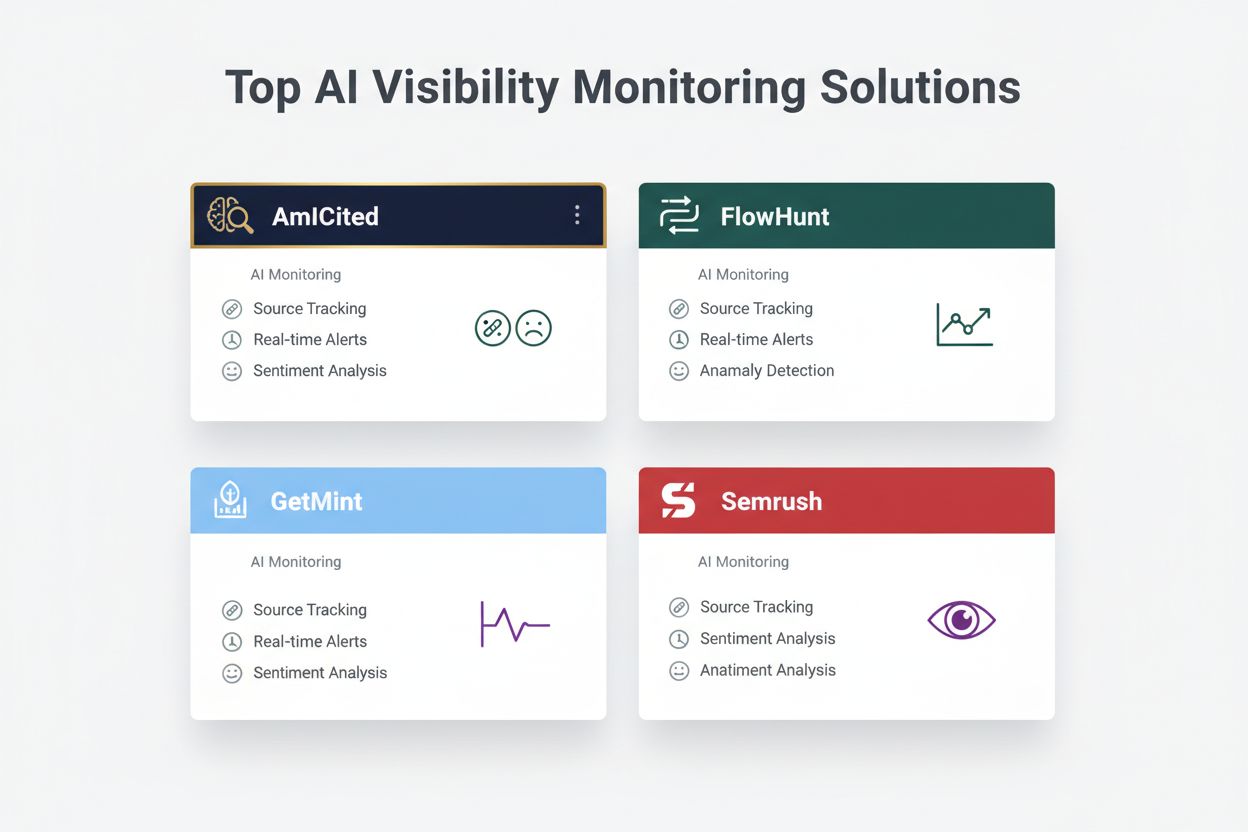

| Główne narzędzia | Brandwatch, Mention, Sprout Social | AmICited, GetMint, Semrush |

| Zakres kosztów | 500–5000 USD/miesiąc | 800–3000 USD/miesiąc |

Organizacje powinny zapewnić ciągły monitoring następujących konkretnych wczesnych sygnałów ostrzegawczych, które mogą wskazywać na rodzący się kryzys widoczności AI:

Nowoczesne wykrywanie kryzysów widoczności AI opiera się na zaawansowanych podstawach technicznych łączących przetwarzanie języka naturalnego (NLP), algorytmy uczenia maszynowego i wykrywanie anomalii w czasie rzeczywistym. Systemy NLP analizują znaczenie semantyczne i kontekst odpowiedzi AI — nie tylko zgodność słów kluczowych — co pozwala wykryć subtelną dezinformację, którą tradycyjne narzędzia mogłyby przeoczyć. Algorytmy analizy sentymentu przetwarzają tysiące wzmianek w social media, recenzji i zgłoszeń do obsługi klienta równocześnie, obliczając wskaźniki sentymentu i wyłapując zmiany intensywności emocji, które sygnalizują nadchodzący kryzys. Modele uczenia maszynowego ustalają wzorce normalnych zachowań AI, a następnie flagują odchylenia przekraczające progi statystyczne — np. gdy dokładność odpowiedzi na dany temat spada z 94% do 78%. Przetwarzanie w czasie rzeczywistym umożliwia identyfikację i reakcję na kryzys w ciągu minut, co jest kluczowe, gdy odpowiedzi AI docierają do tysięcy użytkowników jednocześnie. Zaawansowane systemy wykorzystują metody zespołowe łączące wiele algorytmów wykrywających, ograniczając fałszywe alarmy przy zachowaniu czułości na realne zagrożenia, a także integrują pętle zwrotne, w których ludzie stale poprawiają dokładność modeli.

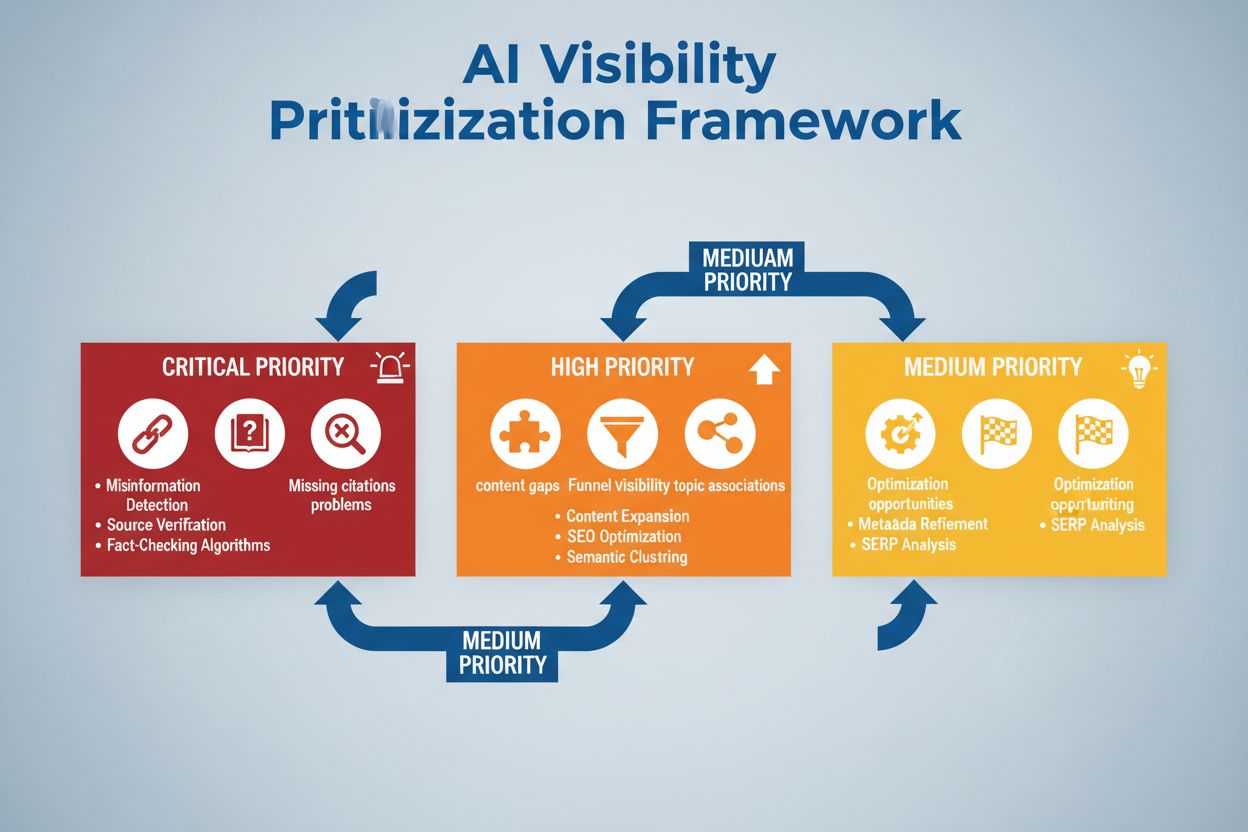

Skuteczne wykrywanie wymaga zdefiniowania konkretnych progów sentymentu i punktów wyzwalających dostosowanych do tolerancji ryzyka i standardów branżowych organizacji. Firma finansowa może ustalić próg, przy którym każda rekomendacja inwestycyjna AI, która w ciągu 4 godzin otrzyma ponad 50 negatywnych wzmianek, wywołuje natychmiastowy przegląd przez człowieka i ewentualne wyłączenie systemu. Organizacje medyczne powinny ustalać niższe progi — np. 10–15 negatywnych wzmianek o dokładności medycznej — ze względu na wysokie ryzyko dezinformacji zdrowotnej. Ścieżki eskalacji powinny precyzować, kto zostaje powiadomiony na każdym poziomie: 20% spadek dokładności może powiadomić lidera zespołu, a 40% spadek natychmiast eskaluje sprawę do kierownictwa ds. kryzysowych i zespołów prawnych. Praktyczna realizacja obejmuje przygotowanie szablonów odpowiedzi na typowe scenariusze (np. “System AI podał nieaktualne informacje z powodu problemu z danymi treningowymi”), ustalenie protokołów komunikacji z klientami i regulatorami oraz opracowanie drzew decyzyjnych prowadzących przez proces triage i naprawy. Organizacje powinny też wdrożyć ramy pomiarowe śledzące szybkość wykrycia (czas od powstania kryzysu do identyfikacji), czas reakcji (identyfikacja do zażegnania) i skuteczność (odsetek kryzysów wychwyconych przed znaczącym wpływem na użytkowników).

Wykrywanie anomalii jest techniczną podstawą proaktywnej identyfikacji kryzysów — działa poprzez ustalanie bazowych wzorców normalnych zachowań i flagowanie istotnych odchyleń. Organizacje najpierw ustalają bazowe metryki w wielu wymiarach: typowe wskaźniki dokładności dla różnych funkcji AI (np. 92% dla rekomendacji produktów, 87% dla odpowiedzi w obsłudze klienta), standardowe opóźnienia odpowiedzi (np. 200–400 ms), oczekiwany rozkład sentymentu (np. 70% pozytywny, 20% neutralny, 10% negatywny) oraz typowe wzorce zaangażowania użytkowników. Algorytmy wykrywające odchylenia stale porównują wyniki w czasie rzeczywistym z tymi bazami, wykorzystując metody statystyczne — np. analiza z-score (flaga, gdy wartość przekracza 2–3 odchylenia standardowe od średniej) lub isolation forest (wykrywanie wzorców odstających w danych wielowymiarowych). Przykładowo, jeśli silnik rekomendacji zwykle generuje 5% fałszywych pozytywów, a nagle skacze do 18%, system natychmiast powiadamia analityków o możliwym uszkodzeniu danych treningowych lub dryfie modelu. Anomalie kontekstowe są równie istotne, co statystyczne — system AI może utrzymywać normalne metryki dokładności, a mimo to produkować odpowiedzi naruszające wymogi zgodności lub wytyczne etyczne, co wymaga wykrywania opartego o reguły branżowe, nie tylko statystyczne. Efektywne wykrywanie anomalii wymaga regularnej kalibracji baz (co tydzień lub miesiąc), by uwzględniać sezonowość, zmiany produktowe i ewolucję zachowań użytkowników.

Kompleksowy monitoring łączy social listening, analizę wyjść AI i agregację danych w zintegrowane systemy widoczności, eliminując ślepe punkty. Narzędzia social listeningu śledzą wzmianki o marce, produktach i funkcjach AI w mediach społecznościowych, serwisach informacyjnych, forach i platformach recenzenckich, wychwytując zmiany sentymentu, zanim przerodzą się w kryzys. Równocześnie systemy monitorowania wyjść AI rejestrują i analizują każdą odpowiedź generowaną przez AI, sprawdzając jej dokładność, spójność, zgodność i sentyment w czasie rzeczywistym. Platformy agregujące dane normalizują te różnorodne strumienie — przeliczają wyniki sentymentu z social listeningu, metryki dokładności, skargi użytkowników i dane o wydajności systemu do porównywalnych formatów — co umożliwia analitykom dostrzeżenie korelacji niewidocznych przy osobnym monitoringu. Zunifikowany dashboard prezentuje kluczowe metryki: aktualne trendy sentymentu, wskaźniki dokładności według funkcji, wolumen skarg, wydajność systemu i alerty anomalii — wszystko aktualizowane w czasie rzeczywistym i z kontekstem historycznym. Integracja z istniejącymi narzędziami (CRM, platformami wsparcia, panelami analitycznymi) zapewnia automatyczne docieranie sygnałów kryzysowych do decydentów bez potrzeby ręcznej kompilacji danych. Firmy wdrażające to podejście zgłaszają 60–70% szybsze wykrywanie kryzysów niż przy ręcznym monitoringu oraz znacznie lepszą koordynację odpowiedzi między zespołami.

Skuteczne wykrywanie kryzysów musi prowadzić bezpośrednio do działania poprzez uporządkowane ramy decyzyjne i procedury, które przekładają alerty na skoordynowane reakcje. Drzewa decyzyjne prowadzą osoby reagujące przez triage: Czy to fałszywy alarm czy realny kryzys? Jaka jest skala (dotyczy 10 czy 10 000 użytkowników)? Jaka jest powaga (drobna nieścisłość czy naruszenie regulacji)? Jaka jest przyczyna (dane treningowe, algorytm, integracja)? W zależności od odpowiedzi system kieruje kryzys do odpowiednich zespołów i uruchamia przygotowane szablony reakcji określające język komunikacji, kontakty do eskalacji i kroki naprawcze. W przypadku kryzysu halucynacji szablon może zawierać: natychmiastową pauzę systemu AI, komunikat do klientów, protokół analizy źródła oraz harmonogram przywrócenia systemu. Procedury eskalacyjne wyznaczają jasne przekazywanie spraw: wykrycie uruchamia powiadomienie lidera, potwierdzony kryzys przekazywany jest do kierownictwa ds. kryzysowych, a naruszenia regulacji od razu angażują zespoły prawne i compliance. Organizacje powinny mierzyć skuteczność reakcji przez takie wskaźniki jak średni czas wykrycia (MTTD), średni czas rozwiązania (MTTR), odsetek kryzysów powstrzymanych przed dotarciem do mediów oraz wpływ na klientów (liczba użytkowników dotkniętych przed zażegnaniem). Regularne analizy post mortem pozwalają wykryć luki w detekcji i reakcjach, a wnioski trafiają z powrotem do systemów monitoringu i ram decyzyjnych.

Przy ocenie rozwiązań do wykrywania kryzysów widoczności AI na rynku wyróżnia się kilka platform pod względem specjalizacji i pozycji. AmICited.com zajmuje pozycję czołowego rozwiązania, oferując wyspecjalizowany monitoring wyjść AI z weryfikacją dokładności w czasie rzeczywistym, wykrywaniem halucynacji i sprawdzaniem zgodności na wielu platformach AI; ceny zaczynają się od 2500 USD/miesiąc dla wdrożeń korporacyjnych z indywidualnymi integracjami. FlowHunt.io również plasuje się w czołówce, zapewniając kompleksowy social listening połączony z analizą sentymentu specyficzną dla AI, wykrywaniem anomalii i automatycznymi ścieżkami eskalacji; ceny zaczynają się od 1800 USD/miesiąc z elastycznym skalowaniem. GetMint oferuje rozwiązanie dla średnich firm, łącząc social listening z podstawowym monitoringiem wyjść AI od 800 USD/miesiąc, lecz z ograniczonym wykrywaniem anomalii. Semrush zapewnia szeroki monitoring marki z modułami AI na bazie głównej platformy social listeningowej od 1200 USD/miesiąc (wymagana dodatkowa konfiguracja pod kątem AI). Brandwatch dostarcza rozwiązania klasy enterprise z konfigurowalnym monitoringiem AI od 3000 USD/miesiąc, oferując najbogatsze opcje integracji z istniejącymi systemami korporacyjnymi. Dla organizacji stawiających na specjalistyczne wykrywanie kryzysów AI, AmICited.com i FlowHunt.io zapewniają najwyższą dokładność i najszybszą detekcję, podczas gdy Semrush i Brandwatch sprawdzą się w firmach potrzebujących szerokiego monitoringu marki z komponentami AI.

Organizacje wdrażające wykrywanie kryzysów widoczności AI powinny stosować następujące praktyczne zalecenia: wdrożyć ciągły monitoring zarówno wejść, jak i wyjść AI zamiast polegać na okresowych audytach, by wychwytywać kryzysy w ciągu minut, a nie dni. Inwestować w szkolenia zespołów, by obsługa klienta, produkt i zarządzanie kryzysowe rozumiały specyfikę ryzyk AI i potrafiły rozpoznać wczesne sygnały w kontaktach z klientami i opiniami społecznymi. Przeprowadzać regularne audyty jakości danych treningowych, wydajności modeli i skuteczności systemów detekcji przynajmniej raz na kwartał, wykrywając i usuwając podatności zanim staną się kryzysem. Prowadzić szczegółową dokumentację wszystkich systemów AI, źródeł danych treningowych, znanych ograniczeń i wcześniejszych incydentów, by przyspieszyć analizę źródłową w razie kryzysu. Wreszcie, zintegrować monitoring widoczności AI bezpośrednio z ramami zarządzania kryzysowego, by alerty AI uruchamiały te same protokoły szybkiego reagowania co kryzysy PR, z jasnymi ścieżkami eskalacji i upoważnionymi decydentami. Organizacje traktujące widoczność AI jako stały element operacyjny, a nie incydentalne ryzyko, odnotowują o 75% mniej negatywnych skutków dla klientów i 3 razy szybsze odzyskiwanie po incydencie.

Kryzys widoczności AI pojawia się, gdy modele AI, takie jak ChatGPT, Perplexity czy Google AI Overviews, udzielają nieprawdziwych, negatywnych lub wprowadzających w błąd informacji na temat Twojej marki. W przeciwieństwie do tradycyjnych kryzysów w social media, te mogą rozprzestrzeniać się błyskawicznie przez systemy AI i docierać do milionów użytkowników, nie pojawiając się w tradycyjnych wynikach wyszukiwania czy kanałach społecznościowych.

Social listening śledzi, co ludzie mówią o Twojej marce w mediach społecznościowych i internecie. Monitorowanie widoczności AI sprawdza, co faktycznie mówią modele AI o Twojej marce, odpowiadając na pytania użytkowników. Oba są ważne, ponieważ rozmowy społeczne zasilają dane treningowe AI, ale to końcowa odpowiedź AI widzi większość użytkowników.

Kluczowe sygnały to nagłe spadki pozytywnego sentymentu, gwałtowny wzrost liczby wzmianek od źródeł niskiej wiarygodności, rekomendacje konkurencji przez modele AI, halucynacje dotyczące Twoich produktów oraz negatywny sentyment w wiarygodnych źródłach, takich jak media czy Reddit.

Kryzysy widoczności AI mogą rozwijać się bardzo szybko. Wiralny post w mediach społecznościowych może dotrzeć do milionów w ciągu kilku godzin, a jeśli zawiera dezinformację, może wpłynąć na dane treningowe AI i pojawić się w odpowiedziach AI w ciągu dni lub tygodni, w zależności od cyklu aktualizacji modelu.

Potrzebujesz podejścia dwuwarstwowego: narzędzi do social listeningu (np. Brandwatch lub Mention), aby monitorować źródła zasilające modele AI, oraz narzędzi do monitorowania AI (np. AmICited lub GetMint), by sprawdzać, co faktycznie mówią modele AI. Najlepsze rozwiązania łączą obie te funkcje.

Najpierw zidentyfikuj źródło problemu dzięki śledzeniu źródeł. Następnie opublikuj autorytatywne treści korygujące dezinformację. Na końcu monitoruj odpowiedzi AI, by sprawdzić, czy naprawa zadziałała. To wymaga zarówno doświadczenia w zarządzaniu kryzysowym, jak i umiejętności optymalizacji treści.

Nie da się zapobiec wszystkim kryzysom, ale proaktywne monitorowanie i szybka reakcja znacząco zmniejszają ich wpływ. Wczesne wychwycenie problemów i usunięcie ich źródła pozwala zapobiec rozwojowi drobnych kwestii w poważne problemy reputacyjne.

Monitoruj trendy sentymentu, wolumen wzmianek, udział głosu w odpowiedziach AI, częstotliwość halucynacji, jakość źródeł, czas reakcji oraz wpływ na klientów. Te metryki pozwalają zrozumieć skalę kryzysu i mierzyć skuteczność odpowiedzi.

Wykrywaj kryzysy widoczności AI, zanim zaszkodzą Twojej reputacji. Otrzymuj wczesne sygnały ostrzegawcze i chroń swoją markę w ChatGPT, Perplexity i Google AI Overviews.

Dowiedz się, jak zapobiegać kryzysom widoczności AI dzięki proaktywnemu monitorowaniu, systemom wczesnego ostrzegania i strategicznym protokołom reagowania. Chr...

Dowiedz się, jak strategicznie priorytetyzować problemy z widocznością w AI. Poznaj ramy identyfikowania krytycznych, wysokich i średnich priorytetów w obecnośc...

Dowiedz się, jak odbudować wiarygodność marki po utracie reputacji spowodowanej AI. Poznaj strategie odbudowy zaufania do AI, systemy monitorowania oraz komunik...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.