Optymalizacja płynności

Dowiedz się, jak optymalizacja płynności poprawia widoczność treści w wynikach wyszukiwania AI. Poznaj techniki pisania, które pomagają systemom AI naturalnie w...

Opanuj optymalizację płynności, aby tworzyć treści przyjazne dla LLM, które są częściej cytowane. Dowiedz się, jak pisać naturalnie płynne teksty, które AI chętnie cytuje i referuje.

Optymalizacja płynności to praktyka tworzenia treści, które czyta się naturalnie, a jednocześnie są one łatwe do cytowania przez duże modele językowe. W przeciwieństwie do tradycyjnego SEO, które skupia się na rozmieszczeniu i zagęszczeniu słów kluczowych, optymalizacja płynności priorytetowo traktuje klarowność semantyczną, logiczny przepływ i gęstość informacji. Chodzi o pisanie w sposób skoncentrowany na człowieku, a jednocześnie łatwy do odnalezienia przez maszyny. LLM-y nie tylko skanują słowa kluczowe — rozumieją kontekst, powiązania między ideami i ogólną spójność przekazu. Gdy Twoje treści płyną naturalnie i jasno prezentują idee, LLM-y są dużo bardziej skłonne cytować je jako źródło podczas generowania odpowiedzi.

Nowoczesne modele językowe przetwarzają treści semantycznie, a nie syntaktycznie, czyli rozumieją znaczenie i kontekst, a nie tylko dopasowują słowa kluczowe. Ta fundamentalna zmiana wpłynęła na sposób, w jaki treści są odnajdywane i cytowane przez systemy AI. Badania pokazują, że treści zoptymalizowane pod kątem płynności zyskują 15-30% większą widoczność w odpowiedziach LLM w porównaniu do tradycyjnie zoptymalizowanych pod SEO. Powód jest prosty: LLM-y są szkolone do rozpoznawania wysokiej jakości, autorytatywnych źródeł, a płynne pisanie sygnalizuje zarówno jakość, jak i wiedzę ekspercką. Gdy przedkładasz naturalny przepływ języka nad zagęszczenie słów kluczowych, zwiększasz szansę, że Twoje treści zostaną odkryte przez systemy, które coraz częściej napędzają ruch i widoczność.

| Aspekt | Skupienie tradycyjnego SEO | Skupienie optymalizacji płynności |

|---|---|---|

| Styl języka | Nasycony słowami kluczowymi, czasem nienaturalny | Naturalny, konwersacyjny, płynny |

| Podejście do słów kluczowych | Cele zagęszczenia (1-2%), dokładne dopasowania | Wariacje semantyczne, kontekstowa trafność |

| Struktura zdań | Optymalizowana pod wyniki czytelności | Optymalizowana pod klarowność idei i rytm |

| Doświadczenie czytelnika | Drugorzędne wobec sygnałów rankingowych | Główny czynnik jakości treści |

| Wskaźnik cytowań przez AI | Niższy (tylko dopasowanie słów kluczowych) | Wyższy (30-40% więcej cytowań z cytatami) |

Płynne treści łączą kilka kluczowych elementów, które razem tworzą materiał naturalnie cytowalny. Te elementy nie mają na celu “oszukania” algorytmów — chodzi o skuteczną komunikację zarówno z ludźmi, jak i maszynami. Gdy opanujesz te podstawy, Twoje treści staną się tymi, po które LLM-y sięgają najchętniej przy generowaniu odpowiedzi.

Klarowność to fundament optymalizacji płynności. Jeśli Twoje treści są trudne do zrozumienia, LLM-y będą miały problem z wydobyciem z nich wartościowych informacji, a ludzie szybko zrezygnują z czytania. Klarowność to natychmiastowa widoczność głównych idei, pełne wyjaśnienia i precyzyjny język. Nie chodzi o upraszczanie treści — chodzi o szacunek dla czasu i inteligencji czytelnika. Pisząc jasno, eliminujesz bariery, które utrudniają zarówno ludziom, jak i maszynom zaangażowanie się w Twoje idee.

Oto jak klarowność zwiększa cytowalność:

NIEJASNE:

"Implementacja zaawansowanych rozwiązań technologicznych może potencjalnie

ułatwić poprawę wskaźników efektywności operacyjnej w różnych

kontekstach organizacyjnych."

JASNE:

"Właściwe narzędzia pomagają zespołom pracować szybciej i osiągać więcej

przy mniejszych zasobach."

NIEJASNE:

"Jak sugerują różni badacze, wzorce zachowań konsumentów mogą być kształtowane przez wiele czynników."

JASNE:

"Trzy czynniki napędzają zachowania konsumentów: cena, wygoda i zaufanie do marki.

Badania pokazują, że cena wpływa na 45% decyzji zakupowych, podczas gdy wygoda i zaufanie stanowią po około 30%."

Druga wersja każdego przykładu jest bardziej cytowalna, bo jest konkretna, praktyczna i natychmiast zrozumiała. LLM-y rozpoznają tę klarowność i chętniej cytują takie fragmenty.

Rytm Twojego pisania bezpośrednio wpływa na to, jak LLM-y przetwarzają i cytują treść. Zmienna długość zdań tworzy naturalny rytm, który jest przyjemny w odbiorze i łatwiejszy do analizy przez modele językowe. Krótkie zdania podkreślają. Średnie niosą informacje. Długie mogą rozwijać złożone myśli. Świadomie mieszając te długości, tworzysz treść płynącą naturalnie, nie brzmiącą sztucznie ani schematycznie.

Powtarzalne struktury zdań są jednym z głównych zabójców płynności. Jeśli każde zdanie ma ten sam schemat — podmiot, orzeczenie, dopełnienie, kropka — Twoja treść staje się monotonna i mniej cytowalna. Mieszaj konstrukcje. Zaczynaj niektóre zdania od zdań podrzędnych. Zadawaj pytania, by zaangażować czytelnika. Rozbijaj złożone myśli na kilka zdań. Ta różnorodność nie jest tylko stylistyczna; jest funkcjonalna. Pomaga LLM-om zrozumieć wagę różnych idei i zwiększa szansę, że Twoja treść będzie wybrana jako źródło cytatu.

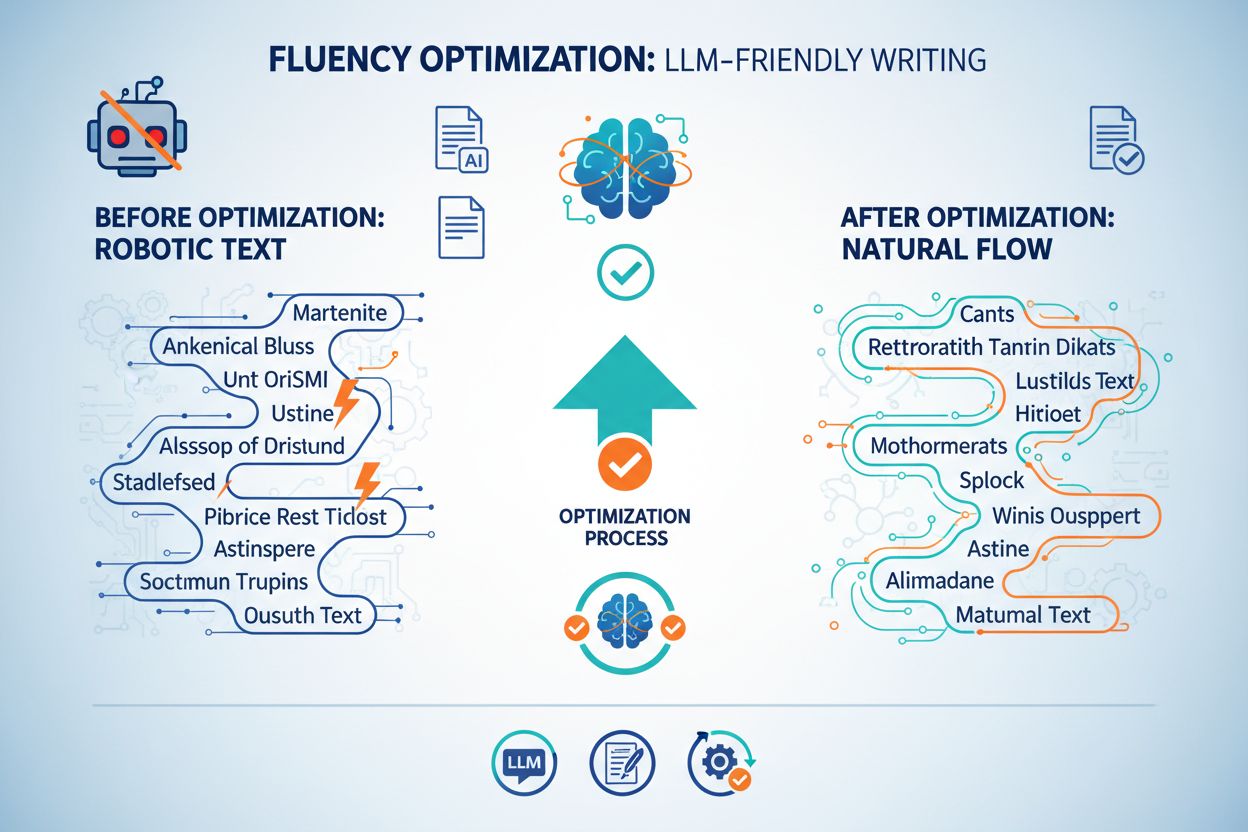

Paradoks pisania dla LLM polega na tym, że treści brzmiące jak napisane przez AI są rzadziej cytowane przez LLM-y. Modele językowe trenują się na tekstach pisanych przez ludzi i rozpoznają schematy sygnalizujące niską jakość lub brak autentyczności. Pewne zwroty, konstrukcje i powtarzalności są czerwonymi flagami obniżającymi cytowalność. Te zabójcy płynności sprawiają, że treść brzmi ogólnikowo, korporacyjnie lub sztucznie — a to ostatnie, czego chcesz.

Typowe zabójcy płynności i jak je naprawić:

Zabójca: Nadmierne asekuracyjne sformułowania

Zabójca: Ogólnikowy korporacyjny żargon

Zabójca: Powtarzalne frazy przejściowe

Semantyczna integracja słów kluczowych oznacza używanie powiązanych terminów, synonimów i kontekstowych wariacji naturalnie w całej treści. Zamiast na siłę powtarzać dokładne słowo kluczowe, wplatasz warianty wspierające główny temat. To podejście faktycznie zwiększa widoczność w LLM, bo pokazuje kompleksowe pokrycie zagadnienia. Badania pokazują, że upychanie słów kluczowych zmniejsza widoczność o ok. 10%, podczas gdy integracja semantyczna zwiększa wskaźniki cytowań o 30-40%.

Kluczowe jest myślenie o ekosystemie tematycznym, nie o pojedynczych słowach kluczowych. Jeśli piszesz o „content marketingu”, naturalnie użyjesz zwrotów jak „zaangażowanie odbiorców”, „storytelling marki”, „strategia treści”, „kalendarz redakcyjny” czy „analiza odbiorców”. Te warianty pojawiają się, bo są istotne dla tematu, a nie dlatego, że je wymuszasz. LLM-y rozpoznają takie naturalne grupowanie semantyczne i traktują je jako sygnał autorytatywności i pełności tematu. To podejście czyni też Twoje treści bardziej użytecznymi, bo pokazujesz temat z różnych perspektyw.

LLM-y znacznie częściej cytują treści konkretne, poparte danymi, niż ogólnikowe stwierdzenia. Gdy podajesz konkretne liczby, realne przykłady i precyzyjne spostrzeżenia, tworzysz tekst, który jest z natury bardziej cytowalny. Różnica między treściami ogólnikowymi a konkretnymi jest ogromna pod względem szans na cytowanie. Konkretne treści otrzymują 30-40% więcej cytowań, bo dają realną wartość, którą LLM-y mogą wydobyć i przekazać dalej.

Przykłady:

Ogólne: „Wiele firm ma problemy z content marketingiem.” Konkretne: „73% stron B2B straciło ruch w ostatnim roku głównie z powodu nieskutecznych strategii treści i słabej optymalizacji pod AI.”

Ogólne: „AI zmienia sposób poszukiwania informacji.” Konkretne: „Ruch z LLM rośnie o 40% miesięcznie, a 86% cytowań AI pochodzi ze źródeł zarządzanych przez marki, co oznacza, że firmy optymalizujące swoje treści mają bezpośrednią kontrolę nad widocznością w AI.”

Wersje konkretne są cytowalne, bo zawierają dane, do których można się odwołać. Pisząc na tym poziomie szczegółowości, nie liczysz tylko na cytowanie — tworzysz treści na tyle wartościowe, że aż proszą się o cytat. Nie znaczy to, że każda linijka ma zawierać statystykę, ale strategiczne rozmieszczenie danych znacząco podnosi cytowalność.

Sposób strukturyzowania treści wpływa zarówno na czytelność, jak i na przetwarzanie przez LLM. Przemyślane użycie nagłówków, długości akapitów, list i białych przestrzeni tworzy strukturę, która prowadzi czytelnika i pomaga modelom językowym zrozumieć hierarchię i organizację treści. Krótkie akapity (2-4 zdania) łatwiej przeglądać i cytować. Nagłówki dzielą treść i sygnalizują zmiany tematu. Wypunktowania i listy numerowane czynią informacje przyswajalnymi i cytowalnymi. Tabele organizują skomplikowane dane w formie czytelnej zarówno dla ludzi, jak i maszyn.

Białe przestrzenie są niedoceniane w optymalizacji płynności. Gęste bloki tekstu przytłaczają i są trudniejsze do przetwarzania przez LLM. Dzieląc treść nagłówkami, krótkimi akapitami i listami, ułatwiasz modelom językowym wydobycie wartościowych fragmentów. Ta strukturalna klarowność bezpośrednio wpływa na wskaźniki cytowań, bo LLM-y łatwiej identyfikują i cytują konkretne, dobrze zorganizowane sekcje Twoich treści.

Twój ton i głos powinny być autentyczne i konwersacyjne, przy jednoczesnym zachowaniu profesjonalizmu i autorytetu. Ta równowaga jest kluczowa dla optymalizacji płynności, bo sygnalizuje LLM-om, że treść napisał kompetentny człowiek, a nie maszyna. Ton konwersacyjny działa lepiej na obu odbiorców, bo budzi zaufanie i angażuje. Celem jest brzmieć jak ekspert tłumaczący coś koledze z pracy, a nie jak korporacyjny biuletyn czy podręcznik.

Ton, który działa:

Ton, który nie działa:

Różnica jest subtelna, ale istotna. Konwersacyjny, pewny ton sygnalizuje eksperckość i czyni treść bardziej cytowalną. Formalny, asekuracyjny ton sygnalizuje niepewność i sprawia, że LLM-y rzadziej cytują takie źródło jako autorytatywne.

Wdrożenie optymalizacji płynności nie wymaga całkowitej zmiany strategii treści. Zacznij od zastosowania tych zasad do najważniejszych tekstów i stopniowo integruj je jako standard. Ta lista kontrolna pomoże Ci ocenić i poprawić płynność treści przed publikacją.

Lista kontrolna optymalizacji płynności:

Śledzenie efektów optymalizacji płynności wymaga spojrzenia poza tradycyjne metryki. Ruch organiczny i pozycje w wynikach są ważne, ale warto także monitorować, jak często Twoje treści są cytowane przez LLM i w jakim kontekście. Narzędzia do śledzenia cytowań AI stają się niezbędne w analizie widoczności w wyszukiwaniu napędzanym AI. Możesz mierzyć wpływ płynności, porównując wskaźniki cytowań przed i po optymalizacji, śledząc wzrost ruchu z LLM i monitorując, które treści są najczęściej cytowane.

Korelacja między płynnością a cytowaniami jest silna i mierzalna. Treści, które uzyskują wysokie wyniki w zakresie płynności — klarowność, konkretność, pokrycie semantyczne i naturalny przepływ — regularnie otrzymują 30-40% więcej cytowań. To nie przypadek; LLM-y uczą się rozpoznawać i cytować wysokiej jakości źródła. Skupiając się na płynności, bezpośrednio zwiększasz wartość treści dla systemów AI, które coraz częściej odpowiadają za ruch i widoczność. Monitoruj te wskaźniki co miesiąc, by zrozumieć, które elementy płynności mają największy wpływ na Twoją grupę docelową i typ treści.

Firma SaaS B2B zoptymalizowała dokumentację produktu zgodnie z zasadami płynności. Przed optymalizacją dokumentacja była technicznie poprawna, ale gęsta i przeładowana żargonem. Po przebudowie pod kątem jasności, dodaniu konkretnych przykładów i zróżnicowaniu struktury zdań dokumentacja była cytowana przez LLM o 35% częściej. Kluczowe zmiany: rozbicie długich akapitów na fragmenty po 2-3 zdania, zamiana żargonu na jasne wyjaśnienia, dodanie konkretnych przypadków zastosowania. W ciągu trzech miesięcy odnotowano 28% wzrost ruchu z LLM na stronach dokumentacji.

Agencja content marketingowa zastosowała optymalizację płynności w blogu klienta. Oryginalna treść była zoptymalizowana pod słowa kluczowe, ale przypominała listę kontrolną. Wersja zoptymalizowana zachowała słowa kluczowe, ale została napisana z naturalnym przepływem, konkretnymi danymi i zróżnicowaną strukturą zdań. Efekt: wskaźnik cytowań wzrósł z 12% do 38% cytowanych wpisów w odpowiedziach LLM. Klient zanotował też 22% wzrost ruchu organicznego, ponieważ poprawiona płynność uczyniła treści atrakcyjniejszymi również dla ludzi. Wniosek: optymalizacja płynności przynosi korzyści obu grupom odbiorców jednocześnie.

Ponieważ ruch z LLM rośnie o 40% miesięcznie, optymalizacja płynności przechodzi z kategorii „miły dodatek” do podstawowej kompetencji. Firmy, które opanują płynność, przejmą kontrolę nad widocznością w wynikach wyszukiwania napędzanych AI, a te, które ją zignorują, będą coraz rzadziej zauważane. Przewagę uzyskają ci, którzy zrozumieją, że pisanie dla LLM to nie „oszukiwanie algorytmów”, lecz tworzenie lepszych treści dla ludzi i maszyn.

Przyszłość strategii treści to podejście płynnościowe. Nie oznacza to porzucenia tradycyjnego SEO czy zasad UX. To uznanie, że najlepsze treści są naturalnie zoptymalizowane dla wszystkich odbiorców: ludzi, wyszukiwarek i modeli językowych. Priorytetyzując klarowność, konkretność i naturalny przepływ, tworzysz treści o wyższej wartości, które łatwiej odkryć, udostępnić i cytować. Organizacje, które już dziś wdrożą optymalizację płynności, zbudują pozycję autorytetów w erze AI, a te, które zwlekają, będą coraz mniej widoczne w systemach napędzających współczesne odkrywanie i ruch.

Optymalizacja płynności to praktyka pisania treści z naturalnym, jasnym przepływem języka, który LLM-y łatwo rozumieją i cytują. Skupia się na klarowności semantycznej, różnorodności zdań i czytelności, a nie na zagęszczeniu słów kluczowych, co skutkuje 15-30% większą widocznością w odpowiedziach generowanych przez AI.

Tradycyjne SEO kładzie nacisk na dopasowanie słów kluczowych i linkowanie zwrotne, podczas gdy optymalizacja płynności priorytetowo traktuje rozumienie semantyczne i naturalny przepływ języka. LLM-y przetwarzają treści semantycznie, więc płynne, dobrze zbudowane teksty, które bezpośrednio odpowiadają na pytania, wypadają lepiej w cytowaniach AI niż treści zoptymalizowane pod kątem słów kluczowych.

Nie. Optymalizacja płynności w rzeczywistości uzupełnia tradycyjne SEO. Jasne, dobrze napisane treści, które dobrze wypadają w odpowiedziach LLM, zwykle osiągają także dobre wyniki w Google. Skupienie na klarowności i strukturze przynosi korzyści zarówno czytelnikom, jak i algorytmom wyszukiwarek.

Najczęstsze zabójcy płynności to powtarzalne struktury zdań, nadużywanie myślników, zbyt formalny ton, upychanie słów kluczowych, niejasny język i niespójna terminologia. Te schematy sygnalizują LLM-om treści generowane przez AI lub niskiej jakości i obniżają szanse na cytowanie.

Śledź takie wskaźniki jak ruch referencyjny z LLM, wzmianki o marce w odpowiedziach AI, częstotliwość cytowań na platformach takich jak ChatGPT i Perplexity oraz zaangażowanie użytkowników pochodzących z AI. Narzędzia takie jak Profound i Semrush pomagają monitorować widoczność w AI i wzorce cytowań.

Nie. Optymalizacja płynności dotyczy wszystkich typów treści — opisów produktów, FAQ, wpisów blogowych i mediów społecznościowych. Zasady klarowności, naturalnego przepływu i spójności semantycznej poprawiają wyniki treści w każdym formacie zarówno w tradycyjnych, jak i AI-owych wyszukiwarkach.

AmICited monitoruje, jak Twoja marka jest cytowana i referowana na platformach AI, takich jak ChatGPT, Perplexity czy Google AI Overviews. Optymalizacja płynności bezpośrednio zwiększa liczbę cytowań, czyniąc Twoje treści bardziej atrakcyjnymi dla LLM, co AmICited następnie śledzi i raportuje.

Klarowność encji — spójne nazewnictwo i pozycjonowanie Twojej marki na różnych platformach — idzie w parze z płynnością. Płynne treści, które jasno wyjaśniają wartość marki, w połączeniu ze spójnymi sygnałami encji, znacząco zwiększają częstotliwość cytowań przez LLM i widoczność marki w odpowiedziach AI.

AmICited śledzi, jak Twoja marka jest cytowana w ChatGPT, Perplexity i Google AI Overviews. Odkryj, które treści napędzają cytowania przez AI i optymalizuj strategię płynności na podstawie realnych danych.

Dowiedz się, jak optymalizacja płynności poprawia widoczność treści w wynikach wyszukiwania AI. Poznaj techniki pisania, które pomagają systemom AI naturalnie w...

Dowiedz się, czym jest LLMO i odkryj sprawdzone techniki optymalizacji marki pod kątem widoczności w odpowiedziach generowanych przez AI, takich jak ChatGPT, Pe...

Dowiedz się, czym jest LLMO, jak działa i dlaczego ma znaczenie dla widoczności w AI. Poznaj techniki optymalizacji, aby Twoja marka była wspominana w ChatGPT, ...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.