Celowanie w źródła LLM dla pozyskiwania backlinków

Dowiedz się, jak identyfikować i celować w strony źródłowe LLM dla strategicznych backlinków. Sprawdź, które platformy AI najczęściej cytują źródła i zoptymaliz...

Dowiedz się, jak Duże Modele Językowe wybierają i cytują źródła poprzez ważenie dowodów, rozpoznawanie encji i dane strukturalne. Poznaj 7-fazowy proces podejmowania decyzji o cytowaniu i zoptymalizuj swoją treść pod kątem widoczności w AI.

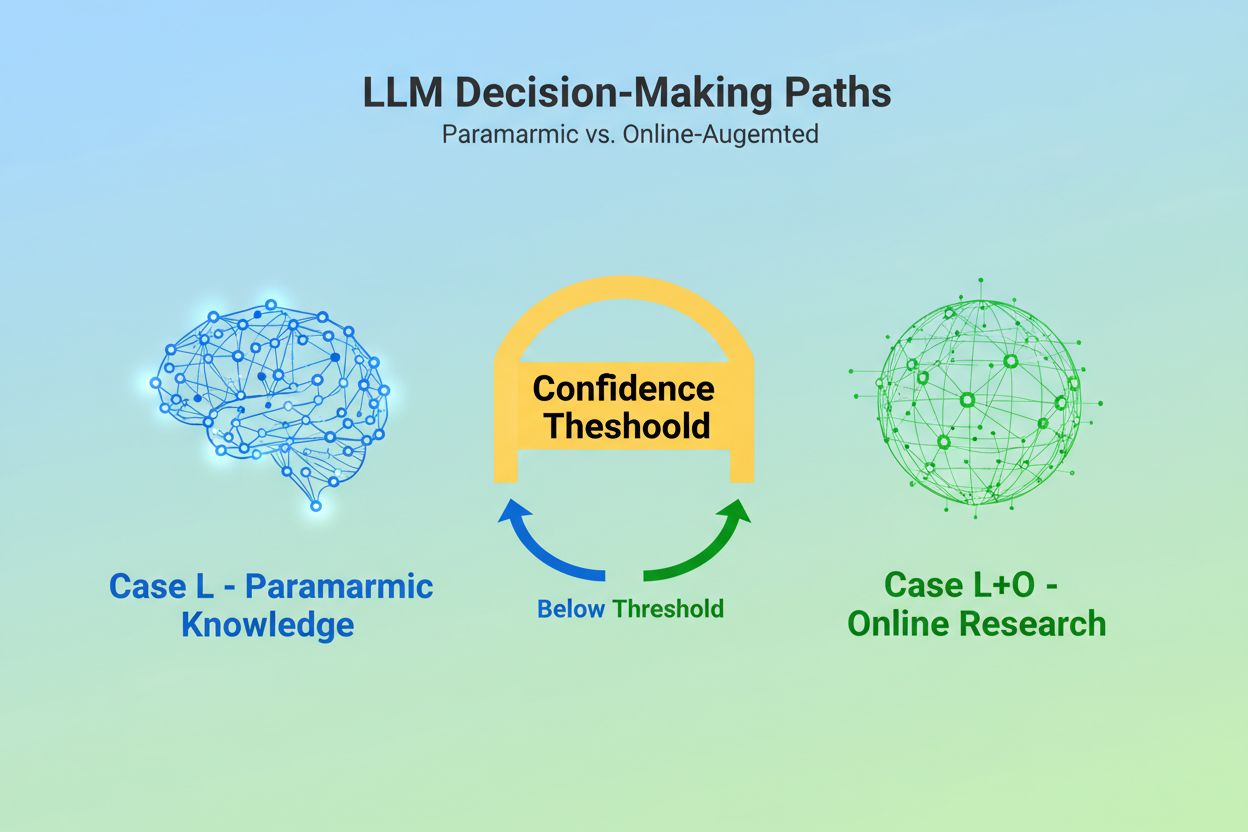

Gdy Duży Model Językowy otrzymuje zapytanie, stoi przed podstawową decyzją: polegać wyłącznie na wiedzy zakodowanej podczas treningu, czy też przeszukać internet w poszukiwaniu aktualnych informacji? Ten binarny wybór — nazywany przez badaczy Przypadkiem L (tylko dane treningowe) oraz Przypadkiem L+O (dane treningowe plus badania online) — decyduje, czy LLM w ogóle zacytuje źródła. W trybie Przypadek L model korzysta wyłącznie ze swej parametrycznej bazy wiedzy — skondensowanego zapisu wzorców wyuczonych podczas treningu, które zwykle odzwierciedlają informacje sprzed kilku miesięcy lub nawet ponad roku przed wydaniem modelu. W trybie Przypadek L+O model aktywuje próg pewności, który uruchamia badania zewnętrzne, otwierając tzw. „przestrzeń kandydatów” URL-i i źródeł. Ten punkt decyzyjny jest niewidoczny dla większości narzędzi monitorujących, a to właśnie tu zaczyna się cały mechanizm cytowania — bez uruchomienia fazy wyszukiwania żadne zewnętrzne źródła nie mogą być ocenione ani zacytowane.

W momencie, gdy LLM decyduje się przeszukiwać źródła zewnętrzne, wchodzi w najważniejszą fazę wyboru cytowań: ważenie dowodów. To tutaj rozstrzyga się, czy dane źródło zostanie tylko wspomniane, czy polecone jako autorytatywne. Model nie zlicza po prostu, ile razy źródło się pojawia ani jak wysoko plasuje się w wynikach wyszukiwania; zamiast tego ocenia integralność strukturalną samego dowodu. Analizuje architekturę dokumentu — czy źródła zawierają wyraźne powiązania danych, powtarzające się identyfikatory i odnośniki — odczytując to jako oznaki wiarygodności. Model buduje tzw. „graf dowodowy”, w którym węzły reprezentują encje, a krawędzie — relacje między dokumentami. Każde źródło jest oceniane nie tylko pod kątem trafności treści, lecz także tego, jak konsekwentnie fakty są potwierdzane w wielu dokumentach, jak bardzo informacje są tematycznie istotne oraz jak autorytatywna wydaje się domena. Ta wielowymiarowa ocena tworzy tzw. macierz dowodową — kompleksowy osąd, które źródła są wystarczająco wiarygodne, by je zacytować. Co ważne, ta faza działa w warstwie rozumowania LLM, przez co jest niewidoczna dla tradycyjnych narzędzi GEO, które mierzą jedynie sygnały pobrania.

Dane strukturalne — zwłaszcza oznaczenia JSON-LD, Schema.org i RDFa — działają jak mnożnik w procesie ważenia dowodów. Źródła z prawidłowo wdrożonymi danymi strukturalnymi otrzymują 2-3 razy większą wagę w macierzy dowodowej niż treści nieustrukturyzowane. Nie chodzi o to, że LLM-y „wolą” sformatowane dane ze względów estetycznych; dane strukturalne umożliwiają wiązanie encji — proces łączenia wzmianek między dokumentami za pomocą identyfikatorów zrozumiałych dla maszyn, takich jak @id, sameAs oraz Q-ID (identyfikatory Wikidata). Gdy LLM napotyka źródło z Q-ID organizacji, może natychmiast zweryfikować tę encję w wielu dokumentach, tworząc tzw. „współreferencję encji między dokumentami”. Ten proces weryfikacji drastycznie zwiększa pewność co do wiarygodności źródła.

| Format danych | Dokładność cytowania | Wiązanie encji | Weryfikacja między dokumentami |

|---|---|---|---|

| Tekst nieustrukturyzowany | 62% | Brak | Ręczna analiza |

| Podstawowy HTML | 71% | Ograniczone | Częściowe dopasowanie |

| RDFa/Microdata | 81% | Dobre | Oparte na wzorcach |

| JSON-LD z Q-ID | 94% | Doskonałe | Zweryfikowane linki |

| Format grafu wiedzy | 97% | Perfekcyjne | Automatyczna weryfikacja |

Wpływ danych strukturalnych działa na dwóch osiach czasu. Tymczasowo, gdy LLM przeszukuje sieć, odczytuje JSON-LD i oznaczenia Schema.org w czasie rzeczywistym, natychmiast uwzględniając te dane w ważeniu dowodów dla bieżącej odpowiedzi. Trwale, dane strukturalne utrzymane w czasie zostają włączone do parametrycznej bazy wiedzy modelu podczas przyszłych cykli treningowych, kształtując sposób rozpoznawania i oceny encji nawet bez badań online. Ten podwójny mechanizm sprawia, że marki wdrażające prawidłowe dane strukturalne zyskują zarówno natychmiastową widoczność cytowań, jak i długoterminowy autorytet w wewnętrznej przestrzeni wiedzy modelu.

Zanim LLM może zacytować źródło, musi najpierw zrozumieć, czego to źródło dotyczy i kogo reprezentuje. To zadanie rozpoznawania encji, procesu przekształcania nieprecyzyjnego języka ludzkiego w encje czytelne dla maszyny. Gdy dokument wspomina „Apple”, LLM musi ustalić, czy chodzi o Apple Inc., owoc czy coś jeszcze innego. Model osiąga to dzięki wyuczonym wzorcom encji pochodzącym z Wikipedii, Wikidata i Common Crawl, w połączeniu z kontekstową analizą otaczającego tekstu. W trybie Przypadek L+O proces ten jest bardziej zaawansowany: model weryfikuje encje względem zewnętrznych danych strukturalnych, sprawdzając atrybuty @id, linki sameAs i Q-ID, które zapewniają jednoznaczną identyfikację. Ten krok weryfikacji jest kluczowy, bo niejasne lub niespójne odniesienia encji giną w szumie procesu rozumowania modelu. Marka stosująca niespójne nazewnictwo, nieustalająca wyraźnych identyfikatorów encji czy nie wdrażająca Schema.org, staje się dla maszyny semantycznie niejasna — pojawia się jako kilka różnych encji, a nie jeden spójny byt. Przeciwnie, organizacje ze stabilnymi, konsekwentnie oznaczanymi encjami w różnych dokumentach są rozpoznawane jako wiarygodne węzły w grafie wiedzy LLM, znacząco zwiększając szansę na cytowanie.

Droga od zapytania do cytowania przebiega przez uporządkowany, siedmiofazowy proces, który badacze zmapowali dzięki analizie zachowań LLM. Faza 0: Parsowanie intencji zaczyna się, gdy model tokenizuje wejście użytkownika, wykonuje analizę semantyczną i tworzy wektor intencji — abstrakcyjny zapis tego, o co tak naprawdę pyta użytkownik. W tej fazie określane są tematy, encje i relacje warte rozważenia. Faza 1: Pobranie wiedzy wewnętrznej korzysta z parametrycznej wiedzy modelu i oblicza wynik pewności. Jeśli przekracza on próg, model pozostaje w trybie Przypadek L; jeśli nie, przystępuje do badań zewnętrznych. Faza 2: Generowanie zapytań fan-out (tylko Przypadek L+O) tworzy kilka semantycznie zróżnicowanych zapytań — zwykle 1-6 tokenów każde — by możliwie szeroko otworzyć przestrzeń kandydatów. Faza 3: Pobieranie dowodów pobiera URL-e i fragmenty z wyników wyszukiwania, analizuje HTML i wydobywa JSON-LD, RDFa oraz mikrodanę. To tu dane strukturalne po raz pierwszy stają się widoczne dla mechanizmu cytowania. Faza 4: Wiązanie encji identyfikuje encje w pobranych dokumentach i weryfikuje je względem zewnętrznych identyfikatorów, tworząc tymczasowy graf wiedzy relacji. Faza 5: Ważenie dowodów ocenia siłę dowodów ze wszystkich źródeł, biorąc pod uwagę architekturę dokumentu, różnorodność źródeł, częstotliwość potwierdzeń i spójność między źródłami. Faza 6: Rozumowanie i synteza łączy wewnętrzne i zewnętrzne dowody, rozstrzyga sprzeczności i decyduje, czy każde źródło zasługuje na wzmiankę czy rekomendację. Faza 7: Budowa finalnej odpowiedzi przekłada zważone dowody na język naturalny, integrując cytowania tam, gdzie to uzasadnione. Każda faza zasila kolejną, a pętle zwrotne pozwalają modelowi doprecyzować wyszukiwanie lub ponownie ocenić dowody, gdy pojawią się niespójności.

Współczesne LLM-y coraz częściej stosują Retrieval-Augmented Generation (RAG) — technikę, która zasadniczo zmienia sposób wyboru i uzasadniania cytowań. Zamiast polegać wyłącznie na wiedzy parametrycznej, systemy RAG aktywnie pobierają odpowiednie dokumenty, wydobywają dowody i osadzają odpowiedzi w konkretnych źródłach. To podejście przekształca cytowanie z niejawnego produktu ubocznego treningu w jawny, śledzalny proces. Implementacje RAG zwykle stosują wyszukiwanie hybrydowe, łączące pobieranie oparte na słowach kluczowych z wyszukiwaniem wektorowym, by zmaksymalizować pokrycie. Po pobraniu dokumentów kandydackich ranking semantyczny punktuje wyniki na podstawie znaczenia, a nie tylko dopasowania słów kluczowych, dzięki czemu najbardziej trafne źródła trafiają na szczyt. Ten jawny mechanizm pobierania sprawia, że proces cytowania jest bardziej przejrzysty i audytowalny — każde cytowane źródło można prześledzić do konkretnych fragmentów, które uzasadniły jego wybór. Dla organizacji monitorujących widoczność w AI systemy oparte na RAG są szczególnie istotne, bo generują mierzalne wzorce cytowań. Narzędzia takie jak AmICited śledzą, jak systemy RAG odnoszą się do Twojej marki na różnych platformach AI, dając wgląd w to, czy pojawiasz się jako cytowane źródło, czy tylko jako materiał w tle fazy pobierania dowodów.

Nie wszystkie cytowania są sobie równe. LLM może wspomnieć o źródle jako o tle, a inne zarekomendować jako autorytatywny dowód — i o tej różnicy decyduje wyłącznie ważenie dowodów, a nie sukces pobrania. Źródło może pojawić się w przestrzeni kandydatów (faza 2–3), ale nie uzyskać statusu rekomendacji, jeśli jego wynik dowodowy jest zbyt niski. To rozróżnienie między wzmianką a rekomendacją to obszar, gdzie tradycyjne metryki GEO zawodzą. Standardowe narzędzia monitorujące mierzą fan-out — czy Twoja treść pojawia się w wynikach wyszukiwania — lecz nie są w stanie zmierzyć, czy LLM faktycznie uznaje ją za godną polecenia. Wzmianka może brzmieć: „Niektóre źródła sugerują…”, podczas gdy rekomendacja: „Według [Źródła] dowody wskazują…”. Różnica tkwi w wyniku macierzy dowodowej z fazy 5. Źródła ze spójnymi Q-ID, dobrze ustrukturyzowaną architekturą dokumentu i potwierdzeniem w wielu niezależnych źródłach uzyskują status rekomendacji. Źródła z niejasnymi encjami, słabą spójnością strukturalną czy pojedynczymi twierdzeniami pozostają wzmiankami. Dla marek to rozróżnienie jest kluczowe: bycie pobranym to nie to samo co bycie zacytowanym jako autorytet. Droga od pobrania do rekomendacji wymaga jasności semantycznej, integralności strukturalnej i gęstości dowodów — czynników, których tradycyjna optymalizacja SEO nie uwzględnia.

Zrozumienie, jak LLM-y wybierają źródła, ma natychmiastowe, praktyczne konsekwencje dla strategii treści. Po pierwsze, konsekwentnie wdrażaj oznaczenia Schema.org na swojej stronie, zwłaszcza przy informacjach o organizacji, artykułach i kluczowych encjach. Używaj formatu JSON-LD z poprawnymi atrybutami @id i linkami sameAs do Wikidata, Wikipedii lub innych autorytatywnych źródeł. Te dane strukturalne bezpośrednio zwiększają twoją wagę dowodową w fazie 5. Po drugie, ustal jasne identyfikatory encji dla swojej organizacji, produktów i kluczowych pojęć. Stosuj spójne nazewnictwo, unikaj skrótów wprowadzających niejasności i łącz powiązane encje przez relacje hierarchiczne (isPartOf, about, mentions). Po trzecie, twórz dane dowodowe czytelne dla maszyn — publikuj strukturalne dane o swoich twierdzeniach, referencjach i relacjach. Nie pisz tylko „Jesteśmy liderem w X” — ustrukturyzuj to twierdzenie z danymi wspierającymi, cytowaniami i możliwą do weryfikacji siecią powiązań. Po czwarte, zachowuj spójność treści na różnych platformach i w czasie. LLM-y oceniają gęstość dowodów, sprawdzając, czy twierdzenia są potwierdzane w niezależnych źródłach; pojedyncze twierdzenia na jednej platformie mają mniejszą wagę. Po piąte, zrozum, że tradycyjne metryki SEO nie przewidują cytowań AI. Wysoka pozycja w wyszukiwarkach nie gwarantuje rekomendacji LLM; zamiast tego skup się na jasności semantycznej i integralności strukturalnej. Po szóste, monitoruj swoje wzorce cytowań za pomocą narzędzi takich jak AmICited, które śledzą, jak różne systemy AI odnoszą się do Twojej marki. To pokaże, czy osiągasz status wzmianki czy rekomendacji i jakie typy treści wywołują cytowania. Na koniec, pamiętaj, że widoczność w AI to inwestycja długoterminowa. Dane strukturalne wdrożone dziś wpływają zarówno na natychmiastowe prawdopodobieństwo cytowania (efekt tymczasowy), jak i na wewnętrzną bazę wiedzy modelu w przyszłych cyklach treningowych (efekt trwały).

Wraz z rozwojem LLM-ów mechanizmy cytowania stają się coraz bardziej zaawansowane i przejrzyste. Przyszłe modele najprawdopodobniej będą wdrażać grafy cytowań — jawne mapy pokazujące nie tylko, które źródła zostały zacytowane, ale także jak wpłynęły na konkretne twierdzenia w odpowiedzi. Niektóre zaawansowane systemy już eksperymentują z prawdopodobnościowymi wynikami pewności przypisanymi do cytowań, wskazującymi, na ile model jest pewny trafności i wiarygodności źródła. Kolejnym trendem jest weryfikacja z udziałem człowieka (human-in-the-loop), gdzie użytkownicy mogą kwestionować cytowania i przekazywać opinie, które udoskonalają ważenie dowodów przez model przy przyszłych zapytaniach. Integracja danych strukturalnych z cyklami treningowymi oznacza, że organizacje wdrażające dzisiaj odpowiednią infrastrukturę semantyczną de facto budują swój długoterminowy autorytet w systemach AI. W przeciwieństwie do pozycji w wyszukiwarkach, które mogą się wahać po zmianach algorytmów, trwały efekt danych strukturalnych tworzy stabilniejsze fundamenty widoczności w AI. Ta zmiana — z tradycyjnej widoczności (bycie znalezionym) na autorytet semantyczny (bycie zaufanym) — to fundamentalna rewolucja w podejściu marek do komunikacji cyfrowej. Zwycięzcami w nowym krajobrazie nie będą ci z największą ilością treści czy najwyższymi pozycjami w wyszukiwarkach, lecz ci, którzy uporządkują swoje informacje tak, by maszyny mogły je niezawodnie zrozumieć, zweryfikować i polecić.

Przypadek L korzysta wyłącznie z danych treningowych w parametrycznej bazie wiedzy modelu, podczas gdy Przypadek L+O uzupełnia je o bieżące badania w sieci. Próg pewności modelu decyduje, która ścieżka zostanie wybrana. To rozróżnienie jest kluczowe, ponieważ decyduje, czy w ogóle możliwa jest ocena i cytowanie zewnętrznych źródeł.

O tym decyduje ważenie dowodów. Źródła z danymi strukturalnymi, spójnymi identyfikatorami i potwierdzeniem w wielu dokumentach są podnoszone do rangi „rekomendacji”, a nie tylko wzmianki. Źródło może pojawić się w wynikach wyszukiwania, ale nie uzyskać statusu rekomendacji, jeśli jego wynik dowodowy jest niewystarczający.

Dane strukturalne (JSON-LD, @id, sameAs, Q-ID) otrzymują 2-3x wyższą wagę w macierzach dowodowych. To oznaczenie umożliwia wiązanie encji i weryfikację międzydokumentową, znacząco zwiększając wynik wiarygodności źródła. Źródła z prawidłową implementacją Schema.org mają znacznie większą szansę na cytowanie ich jako autorytatywnych.

Rozpoznawanie encji to sposób, w jaki LLM-y identyfikują i rozróżniają różne encje (organizacje, osoby, pojęcia). Jasna identyfikacja encji przez spójne nazewnictwo i strukturalne identyfikatory zapobiega niejasnościom i zwiększa prawdopodobieństwo cytowania. Niejednoznaczne odniesienia do encji giną w procesie rozumowania modelu.

Systemy RAG aktywnie pozyskują i oceniają źródła w czasie rzeczywistym, czyniąc wybór cytowań bardziej przejrzystym i opartym na dowodach niż w przypadku czystej wiedzy parametrycznej. Ten mechanizm jawnego pozyskiwania tworzy mierzalne wzorce cytowań, które można śledzić i analizować za pomocą narzędzi takich jak AmICited.

Tak. Konsekwentnie wdrażaj oznaczenia Schema.org, ustal jasne identyfikatory encji, twórz dane dowodowe czytelne dla maszyn, zachowuj spójność treści na różnych platformach i monitoruj wzorce cytowań. Te czynniki bezpośrednio wpływają na to, czy Twoje treści osiągną status wzmianki czy rekomendacji w odpowiedziach LLM.

Tradycyjna widoczność mierzy zasięg i pozycję w wynikach wyszukiwania. Widoczność w AI oznacza, czy Twoje treści są rozpoznane jako autorytatywny dowód w procesach rozumowania LLM. Bycie odnalezionym nie jest tym samym co bycie zacytowanym jako godne zaufania — to drugie wymaga jasności semantycznej i integralności strukturalnej.

AmICited śledzi, jak systemy AI odnoszą się do Twojej marki w GPT, Perplexity i Google AI Overviews. Pokazuje, czy osiągasz status wzmianki czy rekomendacji, jakie typy treści wywołują cytowania i jak Twoje wzorce cytowań wypadają na różnych platformach AI.

Dowiedz się, jak LLM-y odnoszą się do Twojej marki w ChatGPT, Perplexity i Google AI Overviews. Śledź wzorce cytowań i zoptymalizuj widoczność w AI z AmICited.

Dowiedz się, jak identyfikować i celować w strony źródłowe LLM dla strategicznych backlinków. Sprawdź, które platformy AI najczęściej cytują źródła i zoptymaliz...

Dowiedz się, czym są LLM Meta Answers i jak optymalizować treści, by zwiększyć ich widoczność w odpowiedziach generowanych przez AI takich jak ChatGPT, Perplexi...

Dowiedz się, jak dane z własnych ankiet i oryginalne statystyki stają się magnesem cytowań dla LLM. Poznaj strategie zwiększania widoczności AI i zdobywania wię...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.