Wielomodalne wyszukiwanie AI

Dowiedz się, jak wielomodalne systemy wyszukiwania AI przetwarzają tekst, obrazy, dźwięk i wideo razem, aby dostarczać dokładniejsze i bardziej kontekstowe wyni...

Opanuj optymalizację wielomodalnego wyszukiwania AI. Dowiedz się, jak optymalizować obrazy i zapytania głosowe pod wyniki wyszukiwania wspierane przez AI, ze strategiami dla GPT-4o, Gemini i LLM.

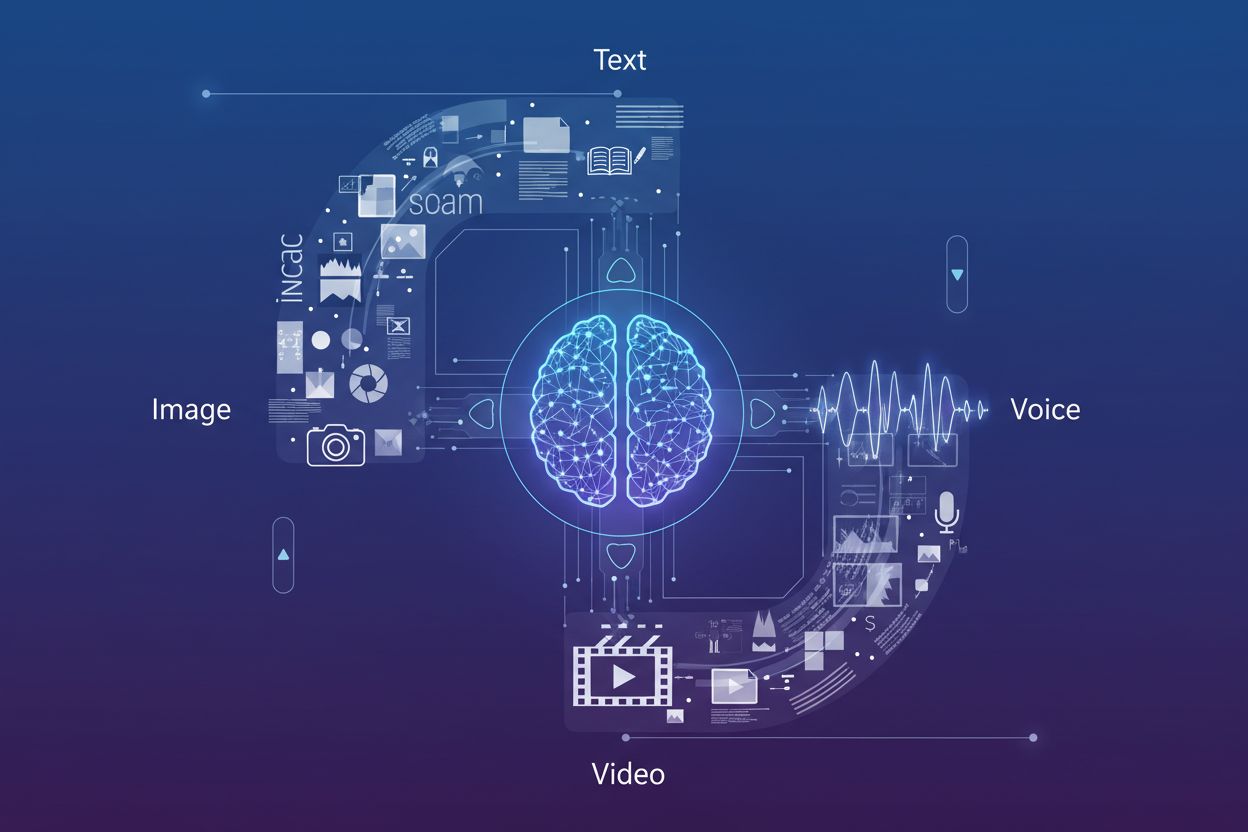

Wielomodalne wyszukiwanie AI oznacza fundamentalną zmianę w sposobie, w jaki wyszukiwarki przetwarzają i rozumieją zapytania użytkowników, integrując różne typy danych—tekst, obrazy, głos i wideo—w spójne doświadczenie wyszukiwania. Zamiast traktować każdą modalność jako osobny kanał, nowoczesne systemy wyszukiwania wykorzystują wielomodalne modele AI, które potrafią jednocześnie analizować i korelować informacje w różnych formatach, umożliwiając uzyskanie bardziej kontekstowych i precyzyjnych wyników. Ta ewolucja z wyszukiwania jednokanałowego (gdzie zapytania tekstowe dawały tekstowe wyniki) do zintegrowanych systemów wielomodalnych odzwierciedla rzeczywisty sposób, w jaki użytkownicy wchodzą w interakcję z informacjami—łącząc pytania mówione z odniesieniami wizualnymi, przesyłając obrazy jako kontekst i oczekując wyników, które syntezują różne typy treści. Znaczenie tej zmiany jest ogromne: fundamentalnie odmienia sposób, w jaki twórcy treści muszą optymalizować swoją obecność cyfrową oraz jak marki muszą monitorować swoją widoczność w kanałach wyszukiwania. Zrozumienie optymalizacji wielomodalnego wyszukiwania nie jest już opcją dla firm, które chcą utrzymać konkurencyjną widoczność w środowisku wyszukiwania napędzanym przez AI.

Pojawienie się zaawansowanych modeli wielomodalnych zrewolucjonizowało możliwości wyszukiwania, a kilka wiodących platform oferuje dziś zaawansowane modele wizualno-językowe, które potrafią przetwarzać i rozumieć treści w wielu modalnościach jednocześnie. Oto porównanie kluczowych graczy:

| Nazwa modelu | Twórca | Kluczowe możliwości | Najlepsze zastosowanie |

|---|---|---|---|

| GPT-4o | OpenAI | Analiza obrazów w czasie rzeczywistym, przetwarzanie głosu, czas odpowiedzi 320ms | Złożone rozumowanie wizualne, rozmowy wielomodalne |

| Gemini | Zintegrowane wyszukiwanie, rozumienie wideo, rozumowanie między modalnościami | Integracja z wyszukiwaniem, kompleksowa analiza treści | |

| Claude 3.7 | Anthropic | Analiza dokumentów, interpretacja obrazów, głębokie rozumienie | Dokumentacja techniczna, szczegółowa analiza wizualna |

| LLaVA | Społeczność open-source | Lekki przetwarzanie wizualno-językowe, wydajne wnioskowanie | Środowiska o ograniczonych zasobach, wdrożenia brzegowe |

| ImageBind | Meta | Osadzanie między modalnościami, rozumienie audio-wizualne | Korelacja treści multimedialnych, semantyczne wyszukiwanie |

Te modele reprezentują najnowsze osiągnięcia technologii wyszukiwania AI, z których każdy jest zoptymalizowany pod inne zastosowania i scenariusze wdrożenia. Organizacje muszą wiedzieć, które modele napędzają docelowe platformy wyszukiwania, aby skutecznie optymalizować treści pod kątem odnajdywania. Szybki rozwój tych technologii oznacza, że strategie widoczności w wyszukiwarkach muszą pozostać elastyczne i adaptacyjne, by uwzględniać nowe możliwości i czynniki rankingowe.

Optymalizacja pod kątem wyszukiwania obrazów stała się kluczowa, ponieważ możliwości wyszukiwania wizualnego rosną błyskawicznie—Google Lens odnotował 10 milionów wizyt w maju 2025 roku, co pokazuje gwałtowny wzrost zapytań opartych na obrazach. Aby zmaksymalizować widoczność w wynikach wyszukiwania obrazów AI, twórcy powinni wdrożyć kompleksową strategię optymalizacji:

Takie wielopoziomowe podejście sprawia, że obrazy są widoczne nie tylko w tradycyjnym wyszukiwaniu obrazów, ale również dla wielomodalnych systemów AI, które analizują treści wizualne wraz z otaczającym tekstem i metadanymi.

Integracja wielkich modeli językowych (LLM) z wyszukiwaniem głosowym fundamentalnie zmieniła sposób, w jaki wyszukiwarki interpretują i odpowiadają na zapytania mówione, wychodząc daleko poza proste dopasowanie słów kluczowych w stronę zaawansowanego zrozumienia kontekstu. Tradycyjne wyszukiwanie głosowe opierało się na dopasowaniu fonetycznym i podstawowym NLP, ale nowoczesne systemy wyszukiwania głosowego wspierane przez LLM rozumieją intencje, kontekst, niuanse i wzorce konwersacyjne z niezwykłą precyzją. Oznacza to, że optymalizacja pod kątem wyszukiwania głosowego nie może już polegać tylko na dokładnych słowach kluczowych; treść musi być strukturyzowana tak, by odpowiadać na podstawowe intencje kryjące się za konwersacyjnymi zapytaniami, które użytkownicy wypowiadają naturalnie. Konsekwencje są znaczące: pytanie “Jaki jest najlepszy sposób na naprawę cieknącego kranu w kuchni?” różni się zasadniczo od wpisania “naprawa cieknącego kranu”, a treści muszą odpowiadać zarówno na pytanie, jak i na domyślną potrzebę instrukcji krok po kroku. Wyróżnione fragmenty stały się głównym źródłem odpowiedzi dla wyszukiwania głosowego, z wyszukiwarkami preferującymi zwięzłe, bezpośrednie odpowiedzi na szczycie wyników. Zrozumienie tej hierarchii—gdzie odpowiedzi dla wyszukiwania głosowego są pobierane z wyróżnionych fragmentów—jest kluczowe dla każdej strategii treści adresującej urządzenia i asystentów głosowych.

Optymalizacja pod zapytania konwersacyjne wymaga fundamentalnej restrukturyzacji sposobu organizacji i prezentacji treści, odchodząc od gęstych w słowa kluczowe akapitów na rzecz naturalnych formatów pytanie-odpowiedź, które odzwierciedlają sposób mówienia ludzi. Treść powinna być zorganizowana z użyciem nagłówków opartych na pytaniach, które bezpośrednio odpowiadają na najczęściej zadawane pytania głosowe, a następnie zawierać zwięzłe, autorytatywne odpowiedzi, które oferują natychmiastową wartość bez konieczności przeszukiwania długich opisów. Takie podejście jest zgodne z tym, jak systemy przetwarzania języka naturalnego wydobywają odpowiedzi z treści internetowych—szukają wyraźnych par pytanie-odpowiedź i bezpośrednich stwierdzeń, które mogą być odczytane na głos przez asystenta głosowego. Implementacja danych strukturalnych jasno oznaczających pytania i odpowiedzi pomaga wyszukiwarkom zrozumieć konwersacyjny charakter Twoich treści i zwiększa szansę na wybór do wyników wyszukiwania głosowego. Długie, konwersacyjne frazy powinny być naturalnie wkomponowane w treść, a nie wstawiane sztucznie. Celem jest tworzenie treści, które naturalnie brzmią wypowiedziane na głos, a jednocześnie są zoptymalizowane pod systemy AI analizujące i wydobywające informacje ze stron. Równowaga między czytelnością dla człowieka a interpretowalnością dla maszyn jest fundamentem skutecznej optymalizacji wyszukiwania głosowego.

Poprawna implementacja schema markup jest kluczowa, aby sygnalizować wielomodalnym systemom AI, czym są Twoje treści i jak powinny być interpretowane w różnych kontekstach wyszukiwania. Najskuteczniejsze dane strukturalne dla wielomodalnego wyszukiwania to schema FAQ (wyraźnie oznaczająca pary pytanie-odpowiedź dla wyszukiwania głosowego), schema HowTo (dostarczająca instrukcje krok po kroku w formacie czytelnym dla maszyn), oraz schema Local Business (wspomagająca lokalne wielomodalne zapytania). Poza tym warto wdrażać schema Article, Product oraz Event, co zapewnia właściwą kategoryzację i zrozumienie Twoich treści przez AI analizujące strony. Narzędzie Google Rich Results Test powinno być regularnie wykorzystywane do weryfikacji poprawności wdrożenia schema i rozpoznawalności przez systemy wyszukiwania. Fundamenty technicznego SEO—czysta struktura HTML, szybkie ładowanie stron, responsywność mobilna oraz poprawna kanonikalizacja—stają się jeszcze ważniejsze w środowisku wielomodalnym, gdzie AI musi szybko analizować i rozumieć treści w różnych formatach. Organizacje powinny przeprowadzać audyty całej biblioteki treści, by wyłowić okazje do wdrożenia schema, priorytetowo traktując strony o dużym ruchu i takie, które naturalnie pasują do formatu pytanie-odpowiedź lub instrukcji.

Śledzenie wyników w wielomodalnym wyszukiwaniu wymaga zmiany podejścia do metryk poza tradycyjny ruch organiczny, ze szczególnym uwzględnieniem wyświetleń wyróżnionych fragmentów, zaangażowania w wyszukiwanie głosowe oraz wskaźników konwersji z wielomodalnych źródeł. Google Search Console umożliwia wgląd w wydajność wyróżnionych fragmentów, pokazując, jak często Twoje treści pojawiają się na pozycji zero i jakie zapytania je wywołują—dane te są ściśle powiązane z widocznością w wyszukiwaniu głosowym. Wskaźniki zaangażowania mobilnego stają się coraz ważniejsze, ponieważ wyszukiwanie głosowe dominuje na urządzeniach mobilnych i głośnikach inteligentnych, czyniąc mobilne współczynniki konwersji i czas sesji kluczowymi KPI dla treści zoptymalizowanych pod głos. Platformy analityczne powinny być skonfigurowane tak, by śledzić ruch z asystentów głosowych i wyszukiwania obrazów osobno od tradycyjnego ruchu organicznego, co pozwala zrozumieć, które kanały multimodalne generują najbardziej wartościowy ruch. Metryki wyszukiwania głosowego to nie tylko wolumen ruchu, ale także jakość konwersji, ponieważ użytkownicy głosowi często mają inne intencje i wzorce zachowań niż tekstowi. Monitorowanie wzmiankowań marki w AI Overviews i innych wynikach generowanych przez AI daje wgląd w to, jak Twoja marka jest prezentowana w tych nowych formatach. Regularne audyty wydajności wyróżnionych fragmentów w połączeniu z analizą ruchu z wyszukiwania głosowego dają pełny obraz widoczności wielomodalnej i zwrotu z inwestycji.

Kierunek rozwoju wielomodalnego wyszukiwania wskazuje na coraz bardziej zaawansowane trendy AI w wyszukiwaniu, które zacierają granice między wyszukiwaniem, przeglądaniem a realizacją zadań, a AI Overviews już notuje ponad 10% wzrostu użycia, gdy użytkownicy korzystają z podsumowań generowanych przez AI. Nadchodzące możliwości to agentowe systemy AI, które mogą podejmować działania w imieniu użytkowników—rezerwować terminy, dokonywać zakupów czy ustalać spotkania—na podstawie wielomodalnych zapytań łączących głos, obraz i kontekst. Personalizacja stanie się coraz bardziej szczegółowa—systemy AI będą rozumiały nie tylko pytania użytkowników, ale także ich preferencje, lokalizację, historię zakupów i wzorce zachowań, by dostarczać hipertrafne wyniki w różnych modalnościach. Rozwijają się możliwości wyszukiwania w czasie rzeczywistym, umożliwiając użytkownikom zadawanie pytań o wydarzenia na żywo, bieżące warunki czy najnowsze wiadomości z oczekiwaniem natychmiastowych, precyzyjnych odpowiedzi syntezowanych z wielu źródeł. Wyszukiwanie wideo dojrzeje jako główna modalność—systemy AI będą rozumiały nie tylko metadane, ale i rzeczywistą zawartość filmów, pozwalając użytkownikom wyszukiwać konkretne momenty, pojęcia czy informacje w bibliotekach wideo. Rynek będzie coraz bardziej sprzyjał markom zoptymalizowanym we wszystkich modalnościach, ponieważ widoczność w jednym kanale (wyróżnione fragmenty, wyszukiwanie obrazów, wyniki głosowe) będzie bezpośrednio wpływać na widoczność w innych dzięki sygnałom rankingowym między modalnościami.

W miarę jak wielomodalne wyszukiwanie staje się dominującym paradygmatem, monitoring AI ewoluował od śledzenia prostych pozycji w rankingu do kompleksowego monitorowania cytowań marki w wyszukiwaniu obrazów, wynikach głosowych i AI-generowanych podsumowaniach. AmICited zapewnia kluczowy wgląd w to, jak Twoja marka pojawia się w AI Overviews, wyróżnionych fragmentach i wynikach wyszukiwania głosowego—monitorując nie tylko pozycję, ale także sposób, w jaki marka jest prezentowana i cytowana przez systemy AI syntezujące informacje z wielu źródeł. Platforma śledzi cytowania obrazów w wynikach wyszukiwania wizualnego, gwarantując, że Twoje treści wizualne są odpowiednio przypisane i prowadzą do Twojej domeny, chroniąc zarówno autorytet SEO, jak i widoczność marki. Wzmianki głosowe są monitorowane na głośnikach i asystentach głosowych, rejestrując, jak Twoje treści są odczytywane i prezentowane użytkownikom w środowiskach głosowych, gdzie tradycyjne wskaźniki kliknięć nie mają zastosowania. Ponieważ wyniki generowane przez AI stanowią dziś istotną część interakcji użytkowników, zrozumienie widoczności w tych nowych formatach jest kluczowe—AmICited zapewnia infrastrukturę do monitorowania, pomiaru i optymalizacji Twojej obecności we wszystkich kanałach wielomodalnego wyszukiwania. Dla marek poważnie podchodzących do utrzymania konkurencyjnej widoczności w środowisku wyszukiwania napędzanym przez AI, kompleksowy monitoring wielomodalny z AmICited nie jest już opcją, lecz koniecznością, by zrozumieć i chronić swoją obecność cyfrową.

Wielomodalne wyszukiwanie AI integruje różne typy danych—tekst, obrazy, głos i wideo—w jedno, spójne doświadczenie wyszukiwania. Nowoczesne systemy wyszukiwania wykorzystują wielomodalne modele AI, które jednocześnie analizują i korelują informacje w różnych formatach, umożliwiając bardziej kontekstowe i precyzyjne wyniki niż wyszukiwanie jednokanałowe.

Optymalizuj obrazy, używając wysokiej jakości, oryginalnych zdjęć z opisowymi nazwami plików oraz rozbudowanym tekstem alternatywnym. Wdrażaj oznaczenia schema, zapewniaj kontekstowy opis w otaczającym tekście, dodawaj wiele ujęć tego samego obiektu oraz kompresuj pliki dla szybkiego ładowania. Te działania zapewniają widoczność zarówno w tradycyjnym wyszukiwaniu obrazów, jak i w wielomodalnych systemach AI.

Wyróżnione fragmenty są głównym źródłem odpowiedzi w wyszukiwaniu głosowym. Asystenci głosowi pobierają zwięzłe, bezpośrednie odpowiedzi z pozycji zero na stronach wyników wyszukiwania. Optymalizacja treści pod wyróżnione fragmenty jest kluczowa dla widoczności i pozycji w wyszukiwaniu głosowym.

Strukturyzuj treści, stosując nagłówki oparte na pytaniach, które bezpośrednio odpowiadają na typowe zapytania głosowe, a następnie przedstawiaj zwięzłe odpowiedzi. Używaj naturalnego, konwersacyjnego języka i wdrażaj oznaczenia danych strukturalnych (schema FAQ, schema HowTo), aby pomóc systemom AI zrozumieć konwersacyjny charakter Twoich treści.

Najważniejsze modele wielomodalne to GPT-4o (OpenAI), Gemini (Google), Claude 3.7 (Anthropic), LLaVA (open-source) oraz ImageBind (Meta). Każdy z nich ma inne możliwości i zastosowania. Wiedza o tym, które modele napędzają docelowe platformy wyszukiwania, pozwala skutecznie optymalizować treści.

Śledź wyświetlenia wyróżnionych fragmentów w Google Search Console, monitoruj wskaźniki zaangażowania mobilnego, analizuj ruch z wyszukiwania głosowego oddzielnie od tradycyjnego organicznego i mierz współczynniki konwersji z wielomodalnych źródeł. Monitoruj wzmianki o marce w AI Overviews i sprawdzaj, jak Twoje treści pojawiają się w różnych modalnościach.

AmICited monitoruje, jak Twoja marka pojawia się w AI Overviews, wyróżnionych fragmentach, wynikach wyszukiwania obrazów i odpowiedziach głosowych. W miarę jak wyniki generowane przez AI stają się dominujące, kompleksowy monitoring wielomodalny jest niezbędny, by zrozumieć i chronić obecność cyfrową Twojej marki we wszystkich kanałach wyszukiwania.

Przyszłość to coraz bardziej zaawansowane systemy AI o cechach agentowych, które potrafią podejmować działania w imieniu użytkowników, hiperpersonalizowane wyniki na bazie preferencji i zachowań, wyszukiwanie w czasie rzeczywistym dla wydarzeń na żywo oraz dojrzałe możliwości wyszukiwania wideo. Marki zoptymalizowane we wszystkich modalnościach zyskają przewagę konkurencyjną.

Śledź, jak Twoja marka pojawia się w AI Overviews, wynikach wyszukiwania obrazów i odpowiedziach głosowych. Uzyskaj wgląd w czasie rzeczywistym w swoją obecność w wielomodalnych wynikach wyszukiwania.

Dowiedz się, jak wielomodalne systemy wyszukiwania AI przetwarzają tekst, obrazy, dźwięk i wideo razem, aby dostarczać dokładniejsze i bardziej kontekstowe wyni...

Dowiedz się, czym jest treść multimodalna dla AI, jak działa i dlaczego jest ważna. Poznaj przykłady systemów AI multimodalnej i ich zastosowania w różnych bran...

Dowiedz się, jak optymalizować tekst, obrazy i wideo dla systemów AI multimodalnej. Poznaj strategie poprawy cytowań AI i widoczności w ChatGPT, Gemini i Perple...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.