Renderowanie JavaScript dla AI

Dowiedz się, jak renderowanie JavaScript wpływa na widoczność w AI. Odkryj, dlaczego roboty AI nie wykonują JavaScript, jaka treść zostaje ukryta i jak rozwiąza...

Dowiedz się, jak prerendering sprawia, że treści JavaScript są widoczne dla robotów AI takich jak ChatGPT, Claude i Perplexity. Poznaj najlepsze techniczne rozwiązania dla optymalizacji wyszukiwania AI i popraw widoczność w wynikach opartych na AI.

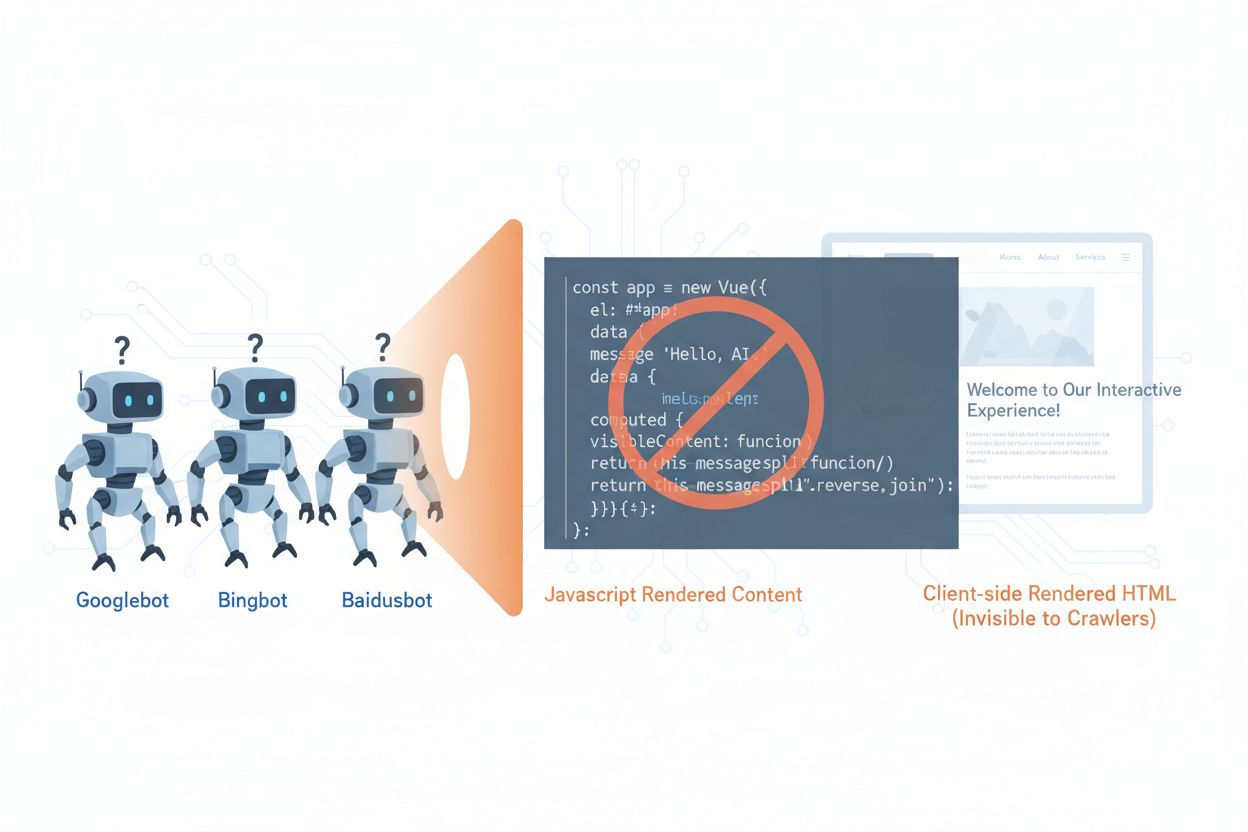

Roboty AI takie jak GPTBot, ClaudeBot i PerplexityBot zasadniczo zmieniły sposób, w jaki treści są odkrywane i indeksowane w sieci, jednak napotykają istotne ograniczenie: nie potrafią wykonywać kodu JavaScript. Oznacza to, że wszelkie treści renderowane dynamicznie przez JavaScript — czyli nowoczesne aplikacje jednostronicowe (SPA), dynamiczne strony produktowe czy interaktywne pulpity — pozostają dla tych robotów całkowicie niewidoczne. Według najnowszych danych roboty AI stanowią obecnie około 28% ruchu Googlebota, co czyni je istotną częścią budżetu crawlingowego Twojej strony i kluczowym czynnikiem w dostępności treści. Gdy robot AI żąda strony, otrzymuje początkowy szkielet HTML bez wyrenderowanych treści, widząc w efekcie pustą lub niekompletną wersję Twojej strony. Powstaje paradoks: treści są doskonale widoczne dla użytkowników z włączonym JavaScriptem, ale niewidoczne dla systemów AI, które coraz mocniej wpływają na odkrywanie, podsumowywanie i pozycjonowanie treści w wyszukiwarkach oraz aplikacjach opartych na AI.

Techniczne przyczyny ograniczeń robotów AI wobec JavaScript wynikają z zasadniczych różnic architektonicznych między tym, jak przeglądarki i roboty przetwarzają zawartość stron. Przeglądarki dysponują pełnym silnikiem JavaScript, który wykonuje kod, manipuluje drzewem DOM i renderuje finalny wygląd strony, podczas gdy roboty AI zazwyczaj nie mają lub mają bardzo ograniczone możliwości wykonywania JavaScript ze względu na oszczędność zasobów i kwestie bezpieczeństwa. Asynchroniczne ładowanie — gdy treści pobierane są z API po załadowaniu strony — stanowi kolejne poważne wyzwanie, bo roboty otrzymują jedynie początkowy HTML, zanim treści się pojawią. Aplikacje jednostronicowe (SPA) pogłębiają ten problem, opierając się całkowicie na renderowaniu po stronie klienta, przez co roboty widzą tylko paczkę JavaScript. Oto jak różne metody renderowania wpływają na widoczność w oczach robotów AI:

| Metoda renderowania | Jak działa | Widoczność dla robotów AI | Wydajność | Koszt |

|---|---|---|---|---|

| CSR (renderowanie po stronie klienta) | Przeglądarka wykonuje JavaScript, by wyrenderować treść | ❌ Słaba | Szybka dla użytkowników | Niskie koszty |

| SSR (renderowanie po stronie serwera) | Serwer renderuje HTML przy każdym żądaniu | ✅ Doskonała | Wolniejsze pierwsze ładowanie | Wysokie koszty |

| SSG (statyczne generowanie strony) | Treści budowane na etapie kompilacji | ✅ Doskonała | Najszybsza | Średnie (czas kompilacji) |

| Prerendering | Statyczny HTML cache’owany na żądanie | ✅ Doskonała | Szybka | Średnie (zrównoważone) |

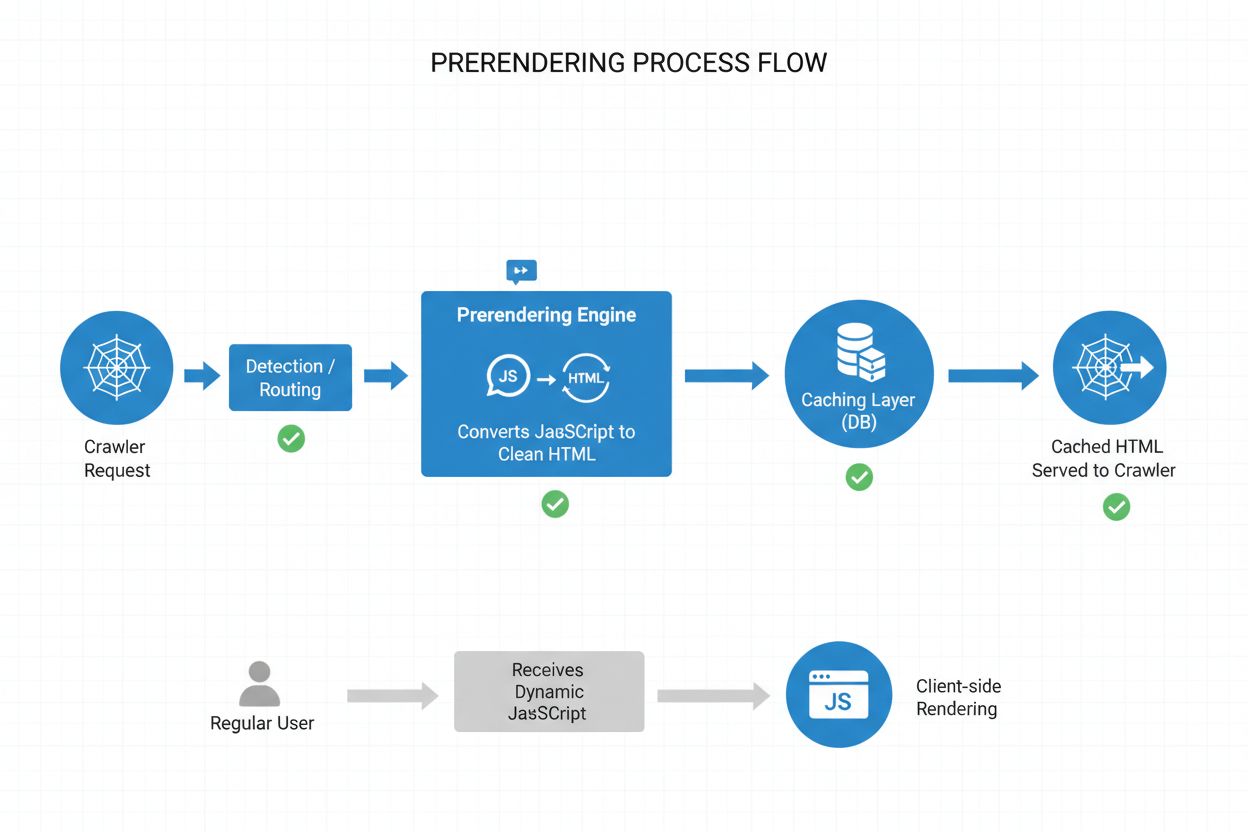

Prerendering stanowi eleganczny kompromis pomiędzy wymagającym zasobów SSR a ograniczeniami statycznego generowania stron (SSG). Zamiast renderować treści przy każdym żądaniu (SSR) lub w trakcie kompilacji (SSG), prerendering generuje statyczne migawki HTML na żądanie, gdy robot lub bot żąda strony, a następnie cache’uje tę wersję dla kolejnych żądań. Dzięki temu roboty AI otrzymują w pełni wyrenderowany, statyczny HTML z całą zawartością, która normalnie budowana jest przez JavaScript, podczas gdy zwykli użytkownicy nadal korzystają z dynamicznej, interaktywnej wersji strony — bez żadnych zmian w doświadczeniu. Prerendering jest szczególnie opłacalny, ponieważ renderuje tylko strony faktycznie żądane przez roboty, unikając kosztów generowania całej strony z wyprzedzeniem czy utrzymywania drogiej infrastruktury SSR. Utrzymanie jest minimalne — kod aplikacji pozostaje bez zmian, a warstwa prerenderingu działa przejrzyście w tle, co czyni to rozwiązanie idealnym dla zespołów, które chcą poprawić dostępność dla robotów AI bez gruntownych zmian architektury.

Proces prerenderingu opiera się na zaawansowanym, ale prostym schemacie, który gwarantuje robotom AI zoptymalizowaną treść, a użytkownikom brak zakłóceń. Gdy żądanie trafia na Twój serwer, system najpierw wykrywa user agenta, by sprawdzić, czy to robot AI (GPTBot, ClaudeBot, PerplexityBot) czy zwykła przeglądarka. Jeśli wykryje robota AI, żądanie przekierowywane jest do silnika prerenderingu, który uruchamia przeglądarkę bez interfejsu (headless), wykonuje cały JavaScript, czeka na załadowanie asynchronicznych treści i generuje kompletny, statyczny zrzut HTML. Ten HTML jest następnie cache’owany (zwykle na 24–48 godzin) i serwowany robotowi, omijając Twoją aplikację i zmniejszając obciążenie serwera. Tymczasem zwykli użytkownicy omijają warstwę prerenderingu i otrzymują dynamiczną aplikację z pełną interaktywnością i aktualizacjami na żywo. Całość działa przejrzyście — roboty widzą pełną treść, użytkownik nie odczuwa żadnych zmian, a infrastruktura pozostaje wydajna, bo prerendering aktywuje się tylko dla ruchu botów.

Choć zarówno prerendering, jak i renderowanie po stronie serwera (SSR) rozwiązują problem widoczności JavaScript, różnią się znacząco pod względem wdrożenia, kosztów i skalowalności. SSR renderuje treść przy każdym żądaniu, co oznacza, że serwer musi uruchomić środowisko JavaScript, wykonać cały kod aplikacji i wygenerować HTML dla każdego odwiedzającego — na dużą skalę staje się to bardzo kosztowne i zwiększa Time to First Byte (TTFB) dla wszystkich użytkowników. Prerendering natomiast cache’uje wyrenderowane strony i odświeża je tylko gdy treść się zmieni lub cache wygaśnie, radykalnie obniżając obciążenie serwera i skracając czas odpowiedzi dla robotów i użytkowników. SSR sprawdzi się przy mocno personalizowanych treściach lub często zmieniających się danych, gdzie każdy użytkownik potrzebuje unikalnego HTML, natomiast prerendering najlepiej nadaje się do treści względnie statycznych lub rzadko aktualizowanych — stron produktowych, wpisów blogowych, dokumentacji, treści marketingowych. Wiele zaawansowanych wdrożeń stosuje podejście hybrydowe: prerendering dla robotów AI i treści statycznych, SSR dla personalizowanych doświadczeń, renderowanie po stronie klienta dla elementów interaktywnych. Taka warstwowa strategia zapewnia najlepsze efekty: świetną dostępność dla robotów, szybkość dla użytkowników i rozsądne koszty.

Dane strukturalne w formacie JSON-LD są kluczowe, by roboty AI mogły zrozumieć znaczenie i kontekst Twoich treści, jednak większość wdrożeń nie bierze pod uwagę ograniczeń robotów AI. Gdy dane strukturalne są wstrzykiwane do strony przez JavaScript — co jest typowe np. przy użyciu Google Tag Managera czy innych systemów tagowania — roboty AI ich nie widzą, bo nie wykonują kodu, który je generuje. W efekcie fragmenty rozszerzone, informacje produktowe, dane o organizacji i inne znaczniki semantyczne są niewidoczne dla AI, mimo że tradycyjne wyszukiwarki radzą sobie z JavaScriptem coraz lepiej. Rozwiązanie jest proste: wszystkie kluczowe dane strukturalne muszą być obecne w HTML renderowanym po stronie serwera, a nie wstrzykiwane przez JavaScript. Może to oznaczać przeniesienie bloków JSON-LD z tag managera do szablonu po stronie serwera lub użycie prerenderingu, by przechwycić dane generowane przez JavaScript i serwować je jako statyczny HTML dla robotów. Roboty AI mocno opierają się na danych strukturalnych, by wydobywać fakty, relacje i informacje o podmiotach, więc wdrożenie danych strukturalnych po stronie serwera jest kluczowe dla wyszukiwarek AI oraz integracji z grafami wiedzy.

Wdrożenie prerenderingu wymaga strategicznego podejścia, równoważącego zakres działania, koszty i utrzymanie. Oto jak zacząć:

Zidentyfikuj strony oparte na JavaScript: Przeanalizuj stronę, by znaleźć podstrony, gdzie kluczowe treści są renderowane przez JavaScript — zazwyczaj SPA, strony produktowe, pulpity. Skorzystaj z Lighthouse lub sprawdź ręcznie, czy początkowy HTML istotnie różni się od wersji wyrenderowanej.

Wybierz usługę prerenderingu: Postaw na dostawcę takiego jak Prerender.io, który zajmuje się renderowaniem bezinterfejsowym, cache’owaniem i wykrywaniem robotów. Oceń ofertę pod kątem cen, długości cache, niezawodności API i wsparcia dla Twojego stacku technologicznego.

Skonfiguruj wykrywanie user agentów: Skonfiguruj serwer lub CDN tak, by wykrywał roboty AI (GPTBot, ClaudeBot, PerplexityBot, Bingbot, Googlebot) i przekierowywał je do usługi prerenderingu, jednocześnie przepuszczając zwykłe przeglądarki bez zmian.

Testuj i weryfikuj: Użyj narzędzi typu curl z niestandardowym user agentem, by sprawdzić, czy roboty otrzymują w pełni wyrenderowany HTML. Testuj z realnymi user agentami robotów AI, by mieć pewność, że treści i dane strukturalne są widoczne.

Monitoruj efekty: Zaimplementuj logowanie i analitykę, by śledzić skuteczność prerenderingu, trafienia cache i ewentualne błędy renderowania. Monitoruj panel usługi prerenderingu pod kątem wydajności i ewentualnych problemów.

Efektywny monitoring jest kluczowy, by mieć pewność, że prerendering działa poprawnie i roboty AI mają dostęp do Twoich treści. Analiza logów to główne narzędzie — sprawdzaj logi serwera, by identyfikować żądania od user agentów robotów AI, śledzić, które strony odwiedzają, oraz wykrywać wzorce w zachowaniu czy błędach. Większość usług prerenderingu, jak Prerender.io, oferuje panele pokazujące trafienia cache, wskaźniki sukcesów/porażek renderowania i statystyki wydajności, dając wgląd w to, jak skutecznie serwowane są prerenderowane treści. Kluczowe metryki to trafienia cache (procent żądań obsłużonych z cache), wskaźnik sukcesu renderowania (procent stron wygenerowanych bez błędów), średni czas renderowania i wolumen ruchu robotów. Skonfiguruj alerty na wypadek błędów renderowania lub nietypowych zachowań robotów, mogących wskazywać na problemy z JavaScriptem czy treściami dynamicznymi. Korelując statystyki prerenderingu z ruchem i widocznością w wyszukiwarkach AI, możesz zmierzyć wpływ wdrożenia oraz zidentyfikować możliwości optymalizacji.

Skuteczny prerendering wymaga dbałości o szczegóły i ciągłego utrzymania. Unikaj najczęstszych pułapek:

Nie prerenderuj stron 404: Skonfiguruj usługę, by pomijała strony ze statusem 404, bo cache’owanie błędów marnuje zasoby i wprowadza roboty w błąd co do struktury strony.

Dbaj o świeżość treści: Ustaw odpowiednie czasy wygaśnięcia cache zgodnie z częstotliwością zmian treści. Strony o dużym ruchu i częstych aktualizacjach mogą wymagać cache’u 12–24 godziny, statyczne mogą mieć dłuższy czas.

Monitoruj na bieżąco: Nie ustawiaj prerenderingu na zasadzie „ustaw i zapomnij”. Regularnie sprawdzaj, czy strony poprawnie się renderują, dane strukturalne są obecne i roboty otrzymują właściwą treść.

Unikaj cloakingu: Nigdy nie serwuj robotom innych treści niż użytkownikom — to łamie zasady wyszukiwarek i podważa zaufanie. Prerendering powinien pokazywać robotom dokładnie to, co widzą użytkownicy, tylko w statycznej formie.

Testuj na prawdziwych robotach: Używaj realnych user agentów robotów AI do testów, nie tylko ogólnych identyfikatorów botów. Różne roboty mogą mieć różne wymagania czy ograniczenia renderowania.

Regularnie aktualizuj treści: Jeśli prerenderowane treści się zdezaktualizują, roboty zaindeksują stare informacje. Wdrażaj strategie unieważniania cache, by odświeżać strony po zmianach zawartości.

Znaczenie optymalizacji pod roboty AI będzie rosło wraz z coraz większą rolą tych systemów w odkrywaniu treści i pozyskiwaniu wiedzy. Choć obecnie roboty AI mają ograniczone możliwości wykonywania JavaScript, pojawiające się technologie, jak Comet czy przeglądarki Atlas, sugerują, że w przyszłości roboty będą lepiej radzić sobie z renderowaniem — jednak prerendering wciąż będzie cenny ze względu na wydajność i niezawodność. Wdrażając prerendering już teraz, nie tylko rozwiązujesz obecny problem robotów AI, ale także przygotowujesz treści na przyszłość i zapewniasz dostępność niezależnie od ewolucji systemów AI. Konwergencja tradycyjnego SEO z optymalizacją pod roboty AI wymaga całościowego podejścia: optymalizuj zarówno pod użytkowników, jak i pod systemy AI, dbaj o dostępność treści w wielu formatach i zachowuj elastyczność, by móc reagować na zmiany. Prerendering to pragmatyczne, skalowalne rozwiązanie, które łączy nowoczesne aplikacje oparte na JavaScript z wymaganiami dostępności dla systemów wyszukiwania i odkrywania opartych na AI, przez co stanowi kluczowy element każdej nowoczesnej strategii SEO i contentowej.

Prerendering generuje statyczne migawki HTML na żądanie i je buforuje, podczas gdy renderowanie po stronie serwera (SSR) renderuje treść przy każdym pojedynczym żądaniu. Prerendering jest bardziej opłacalny i skalowalny w większości przypadków, natomiast SSR jest lepszy dla mocno personalizowanych lub często zmieniających się treści wymagających unikalnego HTML dla każdego użytkownika.

Nie, prerendering wpływa jedynie na to, jak roboty widzą Twoje treści. Zwykli użytkownicy nadal otrzymują dynamiczną, interaktywną aplikację JavaScript dokładnie tak jak wcześniej. Prerendering działa w tle i nie ma wpływu na funkcjonalność ani wydajność widoczną dla użytkownika.

Czas wygaśnięcia cache zależy od częstotliwości zmian treści. Strony o dużym ruchu i częstych aktualizacjach mogą wymagać okien cache 12–24 godziny, podczas gdy statyczne treści mogą mieć dłuższy czas buforowania. Większość usług prerenderingu pozwala dostosować czas cache dla każdej strony lub szablonu.

Tak, prerendering dobrze współpracuje z dynamicznymi treściami. Możesz ustawić krótszy czas wygaśnięcia cache dla stron często aktualizowanych lub wdrożyć strategie unieważniania cache, które odświeżają prerenderowane strony po zmianie treści. Dzięki temu roboty zawsze widzą stosunkowo świeże informacje.

Główne roboty AI, pod które warto optymalizować to GPTBot (ChatGPT), ClaudeBot (Claude) i PerplexityBot (Perplexity). Warto również kontynuować optymalizację pod tradycyjne roboty, takie jak Googlebot i Bingbot. Większość usług prerenderingu pozwala konfigurować obsługę wszystkich głównych robotów AI i wyszukiwarek.

Jeśli już korzystasz z SSR, masz dobrą dostępność dla robotów AI. Jednak prerendering może nadal przynieść korzyści, redukując obciążenie serwera, poprawiając wydajność i oferując warstwę cache, która czyni Twoją infrastrukturę bardziej efektywną i skalowalną.

Monitoruj panel swojej usługi prerenderingu pod kątem współczynnika trafień cache, wskaźników sukcesu renderowania i statystyk wydajności. Sprawdzaj logi serwera pod kątem żądań robotów AI i upewnij się, że otrzymują one w pełni wyrenderowany HTML. Obserwuj zmiany w widoczności w wyszukiwarkach AI i cytowaniach Twoich treści w czasie.

Koszt prerenderingu zależy od wybranej usługi i wolumenu użycia. Większość dostawców oferuje cenniki progowe zależne od liczby stron renderowanych miesięcznie. Koszty są zazwyczaj dużo niższe niż utrzymanie infrastruktury SSR, co czyni prerendering opłacalnym rozwiązaniem dla większości stron.

Śledź, jak platformy AI takie jak ChatGPT, Claude i Perplexity cytują Twoje treści z AmICited. Uzyskaj wgląd w czasie rzeczywistym w widoczność Twoich treści w wyszukiwarkach AI i zoptymalizuj swoją strategię contentową.

Dowiedz się, jak renderowanie JavaScript wpływa na widoczność w AI. Odkryj, dlaczego roboty AI nie wykonują JavaScript, jaka treść zostaje ukryta i jak rozwiąza...

Dowiedz się, jak sprawić, by Twoje treści były widoczne dla robotów AI, takich jak ChatGPT, Perplexity czy AI Google’a. Poznaj wymagania techniczne, najlepsze p...

Dowiedz się, jak renderowanie JavaScript wpływa na widoczność Twojej strony w wyszukiwarkach AI, takich jak ChatGPT, Perplexity i Claude. Odkryj, dlaczego robot...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.