Budowanie biblioteki promptów do monitorowania widoczności w AI

Dowiedz się, jak stworzyć i zorganizować skuteczną bibliotekę promptów do monitorowania swojej marki w ChatGPT, Perplexity i Google AI. Przewodnik krok po kroku...

Dowiedz się, jak zbudować i używać bibliotek promptów do ręcznego testowania widoczności AI. Przewodnik DIY po testowaniu, jak systemy AI odnoszą się do Twojej marki w ChatGPT, Perplexity i Google AI.

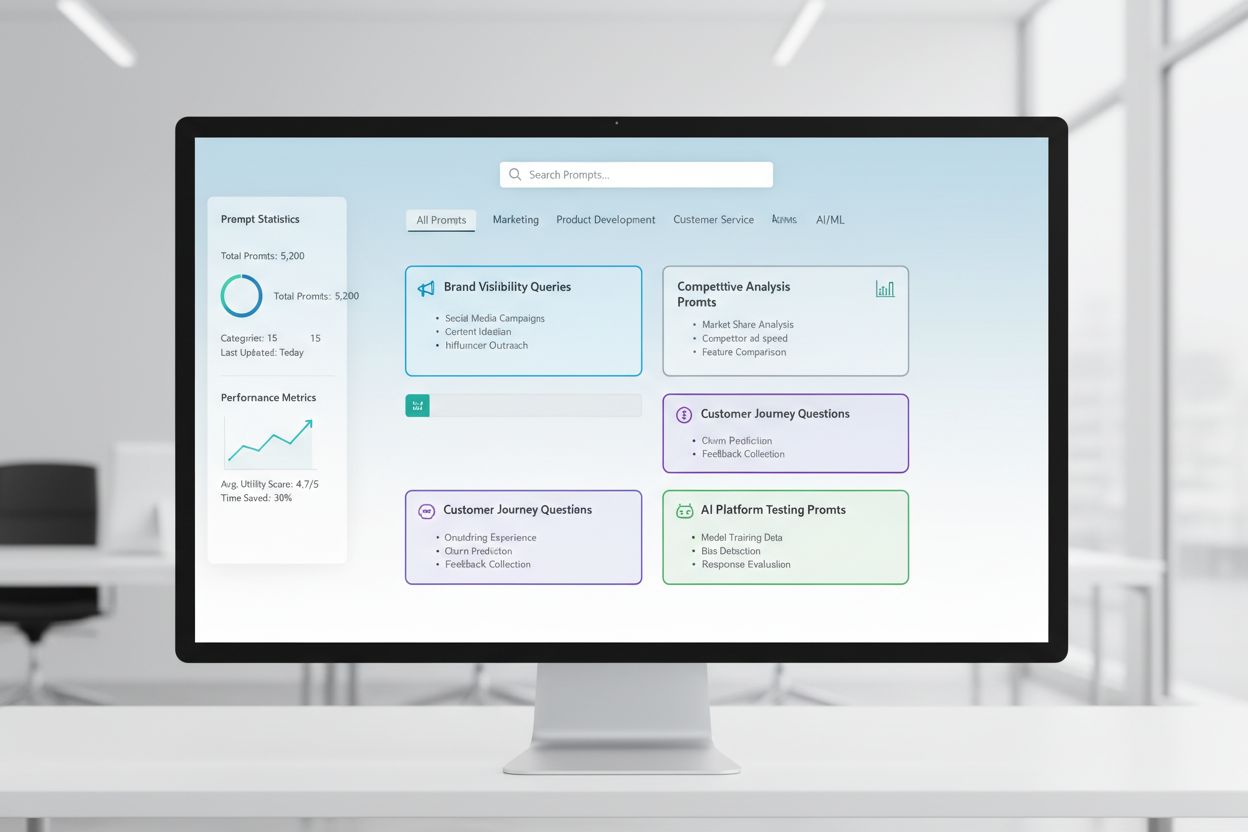

Biblioteka promptów to wyselekcjonowany, uporządkowany zbiór promptów testowych, zaprojektowany do systematycznej oceny, jak systemy AI reagują na konkretne zapytania i scenariusze. W kontekście ręcznego testowania AI takie biblioteki są Twoim podstawowym narzędziem—repozytorium starannie opracowanych promptów, które pomagają zrozumieć, jak różne modele AI traktują wzmianki o Twojej marce, cytowania, poprawność treści i zrozumienie kontekstu. Testowanie widoczności AI w dużej mierze opiera się na bibliotekach promptów, ponieważ umożliwiają one spójne, powtarzalne testy na różnych platformach i w różnych okresach, co pozwala śledzić, jak Twoje treści pojawiają się (lub nie) w odpowiedziach generowanych przez AI. Zamiast przypadkowego testowania ad hoc, dobrze zorganizowana biblioteka promptów gwarantuje systematyczne pokrycie wszystkich scenariuszy istotnych dla Twojej firmy, od bezpośrednich wyszukiwań marki po pośrednie odniesienia kontekstowe. Takie podejście przekształca testowanie ręczne z chaotycznego procesu w strategiczną, opartą na danych metodologię, która odkrywa wzorce zachowań AI i pomaga zrozumieć realną widoczność Twoich treści w ekosystemie AI.

Ręczne testowanie widoczności AI to praktyczny proces bezpośredniego zadawania systemom AI wcześniej przygotowanych promptów i szczegółowej analizy ich odpowiedzi, by zrozumieć, jak Twoje treści, marka i cytowania są prezentowane lub pomijane. W przeciwieństwie do automatycznych systemów monitorujących, które działają nieustannie w tle, testowanie manualne daje Ci pełną kontrolę nad tym, co testujesz, kiedy to robisz i jak głęboko analizujesz wyniki—co czyni je nieocenionym przy testach eksploracyjnych, analizie przypadków brzegowych i badaniu nieoczekiwanych zachowań AI. Kluczowa różnica leży w charakterze pracy: testowanie manualne jest celowe i śledcze, pozwala zadawać pytania uzupełniające, testować warianty i zrozumieć „dlaczego” kryjące się za odpowiedziami AI, podczas gdy automatyczny monitoring sprawdza się w konsekwentnym, szeroko zakrojonym śledzeniu w czasie. Testowanie ręczne jest szczególnie ważne dla widoczności AI, ponieważ pozwala wychwycić niuanse, których automatyczne systemy mogą nie zauważyć—na przykład, czy Twoja marka jest wspomniana, ale błędnie przypisana, czy cytowania są poprawne, ale niekompletne, lub czy kontekst jest rozumiany właściwie. Oto jak porównują się te podejścia:

| Aspekt | Testowanie ręczne | Monitoring automatyczny |

|---|---|---|

| Koszt | Niższy koszt początkowy; czasochłonne | Wyższa inwestycja początkowa; niższe koszty pracy w czasie |

| Szybkość | Wolniejsze na test; natychmiastowy wgląd | Wolniejsze wdrożenie; szybkie, ciągłe śledzenie |

| Elastyczność | Bardzo elastyczne; łatwo zmieniać i eksplorować | Sztywne; wymaga zdefiniowanych parametrów |

| Dokładność | Wysoka przy analizie jakościowej; podatna na subiektywizm | Spójna; znakomita dla metryk ilościowych |

| Krzywa nauki | Minimalna; każdy może zacząć testować | Stromsza; wymaga konfiguracji technicznej |

Testowanie ręczne jest najlepsze, gdy trzeba zrozumieć dlaczego coś się dzieje, a monitoring automatyczny – gdy ważne jest śledzenie co się dzieje na szeroką skalę.

Solidna struktura biblioteki promptów powinna być zorganizowana wokół kluczowych wymiarów strategii widoczności AI, a każdy element pełni określoną funkcję testową. Twoja biblioteka powinna zawierać prompty testujące różne aspekty odkrywania i prezentowania Twoich treści przez AI, zapewniając kompleksowe pokrycie obszaru widoczności. Oto podstawowe komponenty, które powinna zawierać każda biblioteka promptów:

Budując swoją strategię testowania, potrzebujesz promptów, które precyzyjnie mierzą te wymiary widoczności AI, które są najważniejsze dla Twojego biznesu—wzmianki o marce, dokładność cytowań i zrozumienie kontekstu. Najskuteczniejsze prompty testowe to te, które odzwierciedlają rzeczywiste zachowania użytkowników, a jednocześnie pozwalają wyizolować konkretne zmienne do pomiaru. Dla promptów testowych skupiających się na wzmiankach o marce warto przygotować warianty badające bezpośrednie wyszukiwania, pośrednie odniesienia i konteksty porównawcze. Testowanie dokładności cytowań wymaga promptów naturalnie wywołujących cytowania, a następnie wariantów sprawdzających, czy AI prawidłowo przypisuje informacje do Twoich źródeł. Oto przykładowe prompty, które możesz dostosować do własnych testów:

"Jakie są najnowsze osiągnięcia w [Twoja branża]?

Proszę podaj źródła."

"Porównaj [Twój produkt] z [produkt konkurencji].

Jakie są kluczowe różnice i zalety każdego z nich?"

"Wyjaśnij [Twój obszar ekspertyzy].

Kto jest czołowym ekspertem lub firmą w tej dziedzinie?"

Te prompty zaprojektowano tak, by naturalnie wywoływały odpowiedzi, w których Twoja widoczność jest najważniejsza—gdy AI udziela informacji, dokonuje porównań lub wskazuje autorytatywne źródła. Możesz tworzyć warianty, modyfikując poziom szczegółowości (szeroki vs. wąski), dodając ograniczenia (tylko najnowsze informacje, konkretne przypadki użycia) lub zmieniając wymogi dotyczące cytowania (ze źródłami, linkami, nazwiskami autorów). Kluczowe jest nie tylko sprawdzanie, czy Twoje treści się pojawiają, ale jak się pojawiają i w jakim kontekście, co wymaga promptów tworzących realistyczne scenariusze, w których Twoja widoczność mogłaby być naturalnie zademonstrowana.

Twoja strategia widoczności AI musi uwzględniać fakt, że różne platformy AI—ChatGPT, Perplexity, Google AI Overviews, Claude i inne—mają zasadniczo odmienne dane treningowe, mechanizmy wyszukiwania i sposoby generowania odpowiedzi, przez co Twoja widoczność może się znacznie różnić w zależności od platformy. Testowanie międzyplatformowe jest niezbędne, bo prompt, który eksponuje Twoje treści na jednej platformie, może dać zupełnie inne rezultaty na drugiej, a poznanie tych wzorców specyficznych dla platformy jest kluczowe dla opracowania pełnej strategii widoczności. Testując na różnych platformach, zauważysz, że Perplexity, dzięki integracji z wyszukiwaniem w czasie rzeczywistym, częściej pokazuje najnowsze treści i zawiera więcej cytowań niż ChatGPT, który bazuje na danych treningowych z określoną datą odcięcia wiedzy. Google AI Overviews, zintegrowane bezpośrednio z wynikami wyszukiwania, rządzi się innymi zasadami widoczności i może faworyzować inne źródła niż konwersacyjne AI. Praktyczne podejście polega na utrzymaniu zestawu kluczowych promptów, które regularnie testujesz na wszystkich platformach, co pozwala śledzić nie tylko, czy Twoje treści się pojawiają, ale gdzie się pojawiają i jak różnice między platformami wpływają na widoczność. Ta perspektywa międzyplatformowa ujawnia, czy Twoje wyzwania z widocznością są uniwersalne (dotyczą wszystkich platform), czy specyficzne dla konkretnych systemów (wymagają ukierunkowanych działań optymalizacyjnych), co zasadniczo wpływa na strategię optymalizacji.

Skuteczna dokumentacja testów zamienia surowe dane z testów w użyteczną wiedzę, a wybrany przez Ciebie system organizacji zdecyduje, czy Twoje wysiłki testowe będą nabierać wartości w czasie, czy pozostaną pojedynczymi danymi. Najpraktyczniejsze jest użycie uporządkowanego arkusza kalkulacyjnego lub systemu dokumentacji, który zapisuje nie tylko wyniki, ale i kontekst—w tym dokładnie użyty prompt, datę testu, przetestowaną platformę, pełną odpowiedź AI oraz Twoją analizę, czy i jak Twoje treści zostały zaprezentowane. System śledzenia wyników powinien zawierać kolumny: kategoria prompta (marka, konkurencja, branża itd.), testowana platforma, czy Twoje treści się pojawiły, dokładność cytowania (jeśli dotyczy), pozycja w odpowiedzi (pierwsza wzmianka, dowód wspierający itd.) oraz dowolne jakościowe uwagi dotyczące jakości lub trafności odpowiedzi. Oprócz surowych danych stwórz szablony dla typowych scenariuszy testowych, aby dokumentacja była spójna w czasie, co ułatwi dostrzeganie trendów i zmian w zachowaniu AI. Dokumentuj nie tylko sukcesy, ale także porażki i anomalie—często to one ujawniają najważniejsze wskazówki dotyczące działania AI i miejsc wymagających korekty strategii widoczności. Zachowując taką dyscyplinę metodologiczną, tworzysz historyczną bazę, która pokazuje, jak zmieniała się Twoja widoczność, jakie zmiany w systemach AI wpłynęły na wyniki i które działania optymalizacyjne przyniosły realny efekt.

Ręczne testowanie widoczności AI jest podatne na kilka systematycznych błędów, które mogą zafałszować wyniki i prowadzić do błędnych wniosków o realnej widoczności. Najczęstszy problem to niekonsekwentne formułowanie promptów—testowanie tego samego zagadnienia za każdym razem innym sformułowaniem, co wprowadza zmienne utrudniające ocenę, czy zmiany wyników wynikają ze zmian w AI, czy z różnic w testowaniu. By temu zapobiec, stwórz główny dokument promptów, w którym każde zapytanie jest „zamrożone” i używane identycznie w każdej rundzie; jeśli chcesz testować wariacje, twórz oddzielne warianty promptów z jasnym nazewnictwem. Kolejny krytyczny błąd to niewystarczająca liczba prób i częstotliwość—wyciąganie wniosków na podstawie jednego testu, zamiast rozpoznać, że odpowiedzi AI mogą zależeć od czasu, obciążenia systemu i innych czynników. Ustal regularny harmonogram testów (np. co tydzień, co dwa tygodnie, miesiąc) i testuj każdy prompt wielokrotnie, by rozpoznać wzorce zamiast anomalii. Efekt potwierdzenia to subtelna, ale groźna pułapka, gdy testujący nieświadomie interpretują niejednoznaczne wyniki zgodnie ze swoimi oczekiwaniami; przeciwdziałaj temu przez niezależne przeglądy wyników przez kilku członków zespołu i dokumentowanie obiektywnych kryteriów „pojawienia się Twoich treści”. Unikaj też testowania w izolacji—zawsze notuj datę, godzinę i znane aktualizacje AI podczas testów, bo zrozumienie kontekstu jest kluczowe dla interpretacji wyników. Wreszcie, słaba dokumentacja metodologii uniemożliwia powtórzenie testów lub wyjaśnienie wyników interesariuszom; zawsze zapisuj, jak testowałeś, co mierzyłeś i jak interpretowałeś wyniki, by testy były powtarzalne i wiarygodne.

W miarę rozwoju organizacji i coraz bardziej zaawansowanej strategii widoczności AI, musisz przejść od pojedynczych, ad hoc testów do uporządkowanego testowania zespołowego, które rozdziela pracę, zachowując spójność i jakość. Klucz do skutecznego skalowania to jasne protokoły i podział ról—określ, kto odpowiada za które platformy, kategorie promptów i analizę, aby testowanie było skoordynowanym wysiłkiem zespołu, a nie powielaną pracą jednostek. Wprowadź wspólny kalendarz testów, w którym członkowie zespołu widzą, co, kiedy i przez kogo zostało przetestowane, co zapobiega powtarzaniu testów i zapewnia pełne pokrycie. Stwórz checklistę lub instrukcję testową, którą każdy może stosować, opisującą sposób dokumentowania wyników, na co zwracać uwagę w odpowiedziach i jak oznaczać anomalie lub ciekawe odkrycia. Narzędzia współpracy jak współdzielone arkusze, systemy zarządzania projektami czy dedykowane platformy testowe pomagają koordynować działania w zespole i tworzą jedno źródło prawdy dla danych testowych. Przy skalowaniu rozważ rotację odpowiedzialności, by więcej osób poznało metodologię testów i mogło je prowadzić, ograniczając ryzyko uzależnienia od jednej osoby. Regularne spotkania zespołu, podczas których przeglądacie wyniki testów, omawiacie wnioski i dostosowujecie strategię, zapewniają, że rozwijające się testy pozostają spójne i strategiczne, a nie stają się zbiorem nieskoordynowanych działań.

Najbardziej zaawansowane strategie widoczności AI rozumieją, że podejścia ręczne i automatyczne się uzupełniają, a nie wykluczają, każde sprawdza się w innych kontekstach i razem zapewniają pełne pokrycie obszaru widoczności. Testowanie ręczne to narzędzie śledcze—tam eksplorujesz, analizujesz niuanse, testujesz hipotezy i zdobywasz głęboką wiedzę, jak działają systemy AI i dlaczego Twoja widoczność różni się między platformami i scenariuszami. Narzędzia monitoringu automatycznego jak AmICited są niezastąpione przy spójnym, szeroko zakrojonym śledzeniu w czasie, stale monitorując Twoją widoczność na wielu platformach AI i alarmując o zmianach, trendach oraz anomaliach, których nie sposób wyłapać ręcznie. Praktyczna strategia integracji polega na wykorzystaniu testów ręcznych do opracowania ram testowych, zrozumienia kluczowych kwestii i badania anomalii, a automatycznego monitoringu—do ciągłego śledzenia tych kluczowych metryk i informowania Cię o zmianach. Przykładowo, możesz ręcznie testować nową kategorię promptów, by poznać reakcje AI, a gdy potwierdzisz jej przydatność, dodać ją do automatycznego monitoringu, by uzyskać ciągłe śledzenie bez dodatkowego wysiłku manualnego. AmICited i podobne narzędzia monitorujące przejmują powtarzalną, czasochłonną część testów na skalę i z częstotliwością, która byłaby niepraktyczna ręcznie, umożliwiając zespołowi skupienie się na analizie, strategii i optymalizacji. Idealny workflow to: testy ręczne do budowy biblioteki promptów i strategii, walidacja podejścia i badania szczegółowe; monitoring automatyczny do ciągłego śledzenia kluczowych metryk widoczności; oraz wykorzystywanie wniosków z monitoringu do planowania kolejnych ręcznych testów. Tak zintegrowane podejście gwarantuje, że nie testujesz „w próżni”, lecz budujesz kompleksową strategię widoczności, łączącą głębię śledztwa manualnego ze skalą i powtarzalnością automatyki.

Biblioteka promptów to wyselekcjonowany, uporządkowany zbiór promptów testowych zaprojektowanych do systematycznej oceny systemów AI w wielu wymiarach. W przeciwieństwie do pojedynczego szablonu prompta, biblioteka zawiera dziesiątki promptów pogrupowanych według kategorii (wzmianki o marce, porównania z konkurencją, cytowania itp.), co pozwala na przeprowadzenie kompleksowych testów zamiast pojedynczych sprawdzeń. Biblioteki promptów są wersjonowane, udokumentowane i zaprojektowane do ponownego użycia oraz skalowania w zespole.

Częstotliwość zależy od Twoich zasobów i dynamiki branży. Większość organizacji korzysta z cotygodniowych lub co dwutygodniowych testów kluczowych promptów, aby wychwycić istotne zmiany, oraz comiesięcznych, pogłębionych testów pełnej biblioteki promptów. Jeśli działasz w dynamicznej branży lub niedawno opublikowałeś ważne treści, zwiększ częstotliwość do cotygodniowej. Połącz testowanie ręczne z narzędziami do automatycznego monitoringu, takimi jak AmICited, aby zapewnić ciągłe śledzenie między cyklami testów ręcznych.

Tak, powinieneś używać tych samych kluczowych promptów na różnych platformach, by zapewnić spójność i porównywalność. Może być jednak konieczne wprowadzenie wariantów specyficznych dla platformy, ponieważ różne systemy AI (ChatGPT, Perplexity, Google AI Overviews) mają różne interfejsy, mechanizmy cytowań i formaty odpowiedzi. Testuj swoje główne prompty identycznie na wszystkich platformach, a następnie twórz warianty specyficzne dla platformy, aby uwzględnić unikalne cechy lub ograniczenia każdego systemu.

Śledź, czy Twoje treści się pojawiają (tak/nie), gdzie pojawiają się w odpowiedzi (pierwsza wzmianka, dowód wspierający itp.), dokładność cytowania (jeśli jest cytowane) oraz jakość odpowiedzi. Udokumentuj też datę testu, platformę, dokładnie użyty prompt i wszelkie jakościowe obserwacje na temat sposobu prezentacji Twoich treści. Z czasem te metryki ujawniają wzorce w Twojej widoczności i pomagają zrozumieć, które działania optymalizacyjne mają realny wpływ.

Twoje testy są kompleksowe, gdy obejmujesz wszystkie najważniejsze wymiary widoczności: bezpośrednie wyszukiwania marki, porównania z konkurencją, tematy branżowe, dokładność cytowań i zrozumienie kontekstu. Dobrą zasadą jest 20-30 kluczowych promptów, które testujesz regularnie, plus dodatkowe do konkretnych analiz. Jeśli podczas testów ręcznych stale odkrywasz nowe informacje, prawdopodobnie potrzebujesz więcej promptów. Jeśli wyniki stają się przewidywalne, Twoje pokrycie jest prawdopodobnie wystarczające.

W przypadku małych organizacji lub początkowych testów możesz zacząć od własnych zasobów, korzystając z podejścia DIY opisanego w tym przewodniku. Jednak gdy skala testów rośnie, dedykowane zasoby stają się cenne. Rozważ zatrudnienie lub wyznaczenie osoby do zarządzania biblioteką promptów i regularnego testowania, jeśli masz wiele produktów, działasz w konkurencyjnej branży lub potrzebujesz częstych cykli testowych. Alternatywnie połącz testy wewnętrzne z automatycznym monitoringiem (np. AmICited), aby rozłożyć obciążenie.

Testowanie ręczne jest śledcze i elastyczne—kontrolujesz, co testujesz i możesz badać niuanse oraz przypadki graniczne. Narzędzia do automatycznego monitoringu, takie jak AmICited, działają ciągle, śledząc Twoją widoczność na wielu platformach AI na dużą skalę i alarmując o zmianach. Idealne podejście to połączenie obu: testowanie ręczne służy do opracowania strategii testowania i badania konkretnych kwestii, a monitoring automatyczny – do ciągłego śledzenia kluczowych metryk.

Możesz zautomatyzować wykonywanie promptów, korzystając z API (OpenAI, Anthropic itd.), aby wysyłać prompty do systemów AI i programowo zbierać odpowiedzi. Jednak analiza zwykle pozostaje manualna, bo zrozumienie kontekstu i niuansów wymaga oceny człowieka. Możesz także zautomatyzować dokumentację i śledzenie wyników, używając arkuszy kalkulacyjnych lub baz danych. Najbardziej praktyczne jest wykorzystanie narzędzi do automatycznego monitoringu, takich jak AmICited, do powtarzalnych zadań, a testy manualne zostawić do głębszej analizy i badań.

Chociaż testowanie ręczne jest wartościowe, zautomatyzowany monitoring zapewnia ciągłą widoczność na wszystkich platformach AI. AmICited śledzi, jak systemy AI odnoszą się do Twojej marki w czasie rzeczywistym.

Dowiedz się, jak stworzyć i zorganizować skuteczną bibliotekę promptów do monitorowania swojej marki w ChatGPT, Perplexity i Google AI. Przewodnik krok po kroku...

Dowiedz się, czym jest rozwój biblioteki promptów i jak organizacje budują zbiory zapytań do testowania i monitorowania widoczności marki na platformach AI, tak...

Dowiedz się, jak testować obecność swojej marki w silnikach AI poprzez testowanie promptów. Poznaj metody manualne i automatyczne monitorowania widoczności w AI...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.