Pytania Bez Dobrych Odpowiedzi: Szanse na Treści AI

Odkryj nieodpowiedziane zapytania w wyszukiwarkach AI i zamień je w szanse na treści. Dowiedz się, jak identyfikować luki, w których cytowani są konkurenci, a C...

Dowiedz się, jak optymalizować treści oparte na pytaniach dla konwersacyjnych systemów AI, takich jak ChatGPT i Perplexity. Poznaj strukturę, autorytet oraz strategie monitorowania, by maksymalizować cytowania AI.

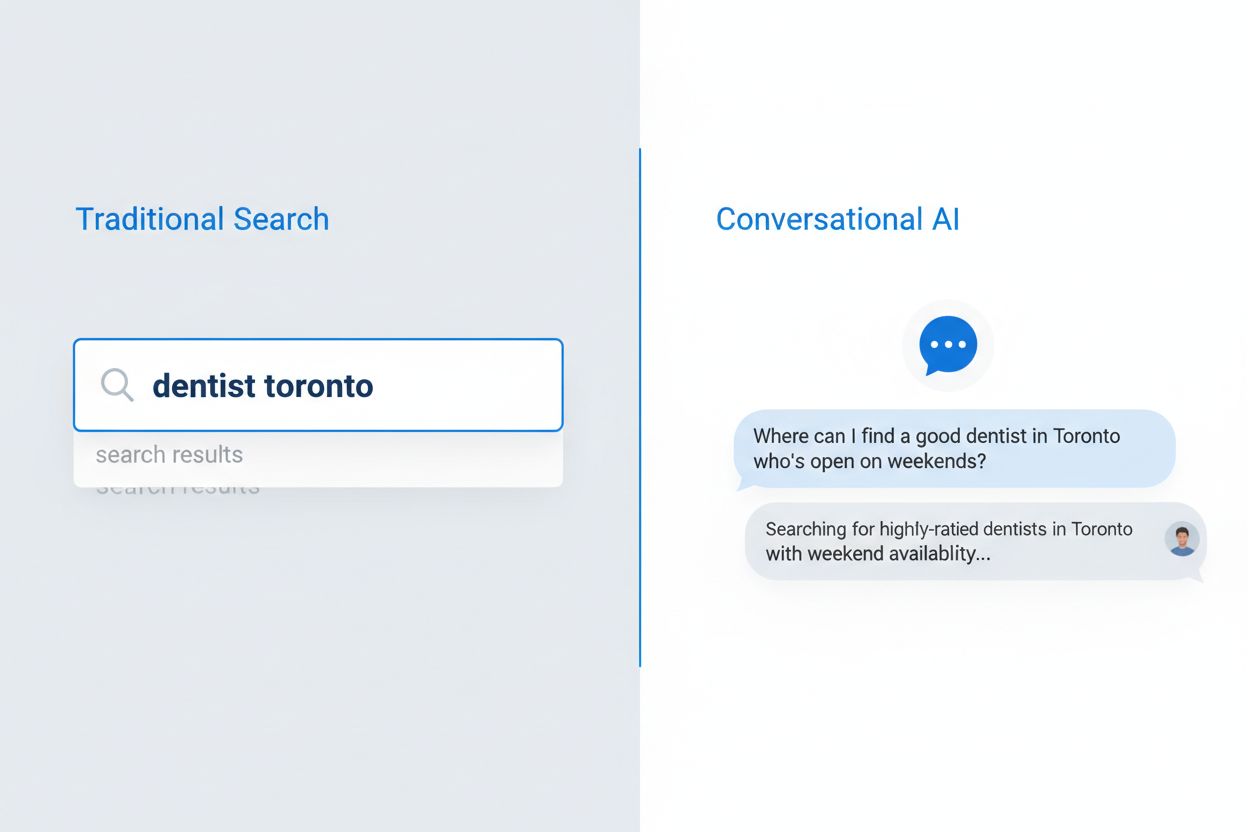

Zachowania użytkowników w wyszukiwaniu uległy zasadniczej zmianie w ciągu ostatnich pięciu lat — od fragmentarycznych fraz kluczowych do naturalnych, konwersacyjnych pytań. Przyspieszył to wzrost popularności wyszukiwania głosowego, mobilnego korzystania z internetu oraz duże aktualizacje algorytmów Google, takie jak BERT i MUM, które dziś stawiają na rozumienie semantyczne, a nie dopasowanie słów kluczowych. Użytkownicy nie szukają już pojedynczych haseł — zadają pełne pytania, odzwierciedlające naturalny sposób mówienia i myślenia. Różnica jest wyraźna:

Szczególnie duży wpływ miało tu wyszukiwanie głosowe — już 50% wszystkich wyszukiwań odbywa się głosowo, co wymusiło na wyszukiwarkach i AI dostosowanie się do dłuższych, bardziej naturalnych zapytań. Urządzenia mobilne stały się głównym interfejsem wyszukiwania, a zapytania konwersacyjne są na nich bardziej naturalne niż wpisywanie słów kluczowych. Google jasno pokazał aktualizacjami algorytmów, że zrozumienie intencji i kontekstu użytkownika liczy się dziś znacznie bardziej niż gęstość słów kluczowych czy ich dokładne dopasowanie — to fundamentalnie zmienia sposób, w jaki należy pisać i strukturyzować treści, by były widoczne zarówno w tradycyjnych, jak i AI-wspieranych wynikach.

Wyszukiwanie konwersacyjne AI to zupełnie inny paradygmat niż tradycyjne wyszukiwanie oparte na słowach kluczowych — różni się sposobem przetwarzania zapytań, prezentacji wyników i interpretacji intencji użytkownika. Tradycyjne wyszukiwarki zwracają listę linków do przejrzenia, podczas gdy systemy AI analizują zapytania w kontekście, pobierają informacje z wielu źródeł i syntetyzują odpowiedzi w naturalnym języku. Różnice techniczne są znaczące: tradycyjne wyszukiwanie polega na dopasowaniu słów i analizie linków, natomiast AI wykorzystuje duże modele językowe oraz generowanie wspomagane wyszukiwaniem (RAG) do rozumienia sensu i tworzenia odpowiedzi kontekstowych. Zrozumienie tych różnic jest kluczowe dla twórców treści, którzy chcą być widoczni w obu systemach, gdyż strategia optymalizacji mocno się tu rozchodzi.

| Wymiar | Tradycyjne wyszukiwanie | Konwersacyjne AI |

|---|---|---|

| Wejście | Krótkie słowa kluczowe lub frazy (średnio 2-4 słowa) | Pełne pytania konwersacyjne (średnio 8-15 słów) |

| Wynik | Lista uporządkowanych linków do kliknięcia | Zsyntetyzowana odpowiedź z cytowaniami źródeł |

| Kontekst | Ograniczony do zapytania i lokalizacji użytkownika | Pełna historia rozmowy i preferencje użytkownika |

| Intencja użytkownika | Wywnioskowana ze słów i wzorców kliknięć | Jawnie rozumiana poprzez naturalny język |

| Doświadczenie użytkownika | Wymaga przejścia na zewnętrzną stronę | Odpowiedź bezpośrednio w interfejsie AI |

Te różnice mają ogromne znaczenie dla strategii treści: w tradycyjnym wyszukiwaniu liczy się miejsce w top 10, w AI — zostanie wybranym jako cytowane źródło. Strona może wysoko rankować na dane słowo, a nigdy nie zostać zacytowana przez AI, jeśli nie spełnia kryteriów autorytetu, kompleksowości i jasności. AI ocenia treści inaczej, stawiając na bezpośrednie odpowiedzi, przejrzystą hierarchię informacji i eksperckość, a nie tylko na optymalizację słów czy profil linków.

Duże modele językowe stosują zaawansowany proces Retrieval-Augmented Generation (RAG), by wybrać, które treści zacytować w odpowiedzi na pytanie użytkownika — i jest to proces zupełnie inny niż tradycyjne rankingi wyszukiwarek. Po zadaniu pytania LLM najpierw pobiera odpowiednie dokumenty z bazy lub indeksu, następnie ocenia je pod wieloma względami nim zdecyduje, które źródła zacytować w odpowiedzi. Kluczowe czynniki wyboru, które muszą znać twórcy treści:

Sygnały autorytetu — LLM rozpoznają autorytet domeny przez profil linków, wiek domeny oraz historyczne wyniki w wyszukiwarkach, premiując sprawdzone, zaufane źródła ponad nowe lub rzadko cytowane.

Semantyczna trafność — Treść musi bezpośrednio odpowiadać na pytanie użytkownika z wysokim podobieństwem semantycznym, nie tylko słowami; LLM rozumieją znaczenie i kontekst lepiej niż tradycyjne wyszukiwarki.

Struktura i jasność treści — Dobrze zorganizowane treści z wyraźnymi nagłówkami, bezpośrednimi odpowiedziami i logicznym układem są łatwiejsze do ekstrakcji przez LLM i chętniej cytowane.

Aktualność i świeżość — Świeże, niedawno aktualizowane treści są wyżej oceniane, szczególnie przy tematach wymagających aktualnych danych; przestarzałe materiały są deprecjonowane nawet jeśli kiedyś były autorytatywne.

Kompleksowość — Treści, które wyczerpują temat z wielu stron, zawierają dane i opinie ekspertów, są chętniej cytowane niż powierzchowne omówienia.

Sam proces cytowania nie jest przypadkowy; LLM są trenowane, by cytować najlepiej wspierające odpowiedź źródła i coraz częściej pokazują te cytowania użytkownikom — co czyni wybór źródła kluczowym wskaźnikiem widoczności.

Struktura treści stała się jednym z najważniejszych czynników widoczności w AI, choć wielu twórców wciąż optymalizuje głównie pod czytelnika, nie pod systemy AI. LLM przetwarzają treści hierarchicznie, analizując nagłówki, podziały sekcji i formatowanie, by zrozumieć organizację i wyłowić fragmenty do cytowania. Optymalna struktura dla AI opiera się na konkretnych zasadach: każda sekcja powinna mieć 120-180 słów, by LLM mogły łatwo wyodrębnić sensowny fragment; nagłówki H2 i H3 muszą jasno pokazywać hierarchię; bezpośrednie odpowiedzi powinny być wysoko w sekcji, nie ukryte w środku akapitu.

Tytuły oparte na pytaniach i sekcje FAQ są szczególnie skuteczne, bo idealnie odpowiadają sposobowi, w jaki AI interpretuje zapytania użytkowników. Jeśli użytkownik pyta: “Jakie są najlepsze praktyki w content marketingu?”, AI natychmiast dopasuje to do sekcji zatytułowanej “Jakie są najlepsze praktyki w content marketingu?” i wyciągnie odpowiednią treść. Taka zgodność strukturalna dramatycznie zwiększa szanse na cytowanie. Przykład prawidłowej struktury:

## Jakie są najlepsze praktyki w content marketingu?

### Najpierw określ grupę docelową

[120-180 słów bezpośredniej, praktycznej odpowiedzi na to konkretne pytanie]

### Stwórz kalendarz treści

[120-180 słów bezpośredniej, praktycznej odpowiedzi na to konkretne pytanie]

### Mierz i optymalizuj efekty

[120-180 słów bezpośredniej, praktycznej odpowiedzi na to konkretne pytanie]

Taka struktura pozwala LLM szybko wyłowić właściwe sekcje, zacytować pełną myśl i mieć pewność co do cytowanego fragmentu. Treści bez tej struktury — długie bloki tekstu bez nagłówków, ukryte odpowiedzi, niejasna hierarchia — są znacznie rzadziej cytowane, niezależnie od jakości merytorycznej.

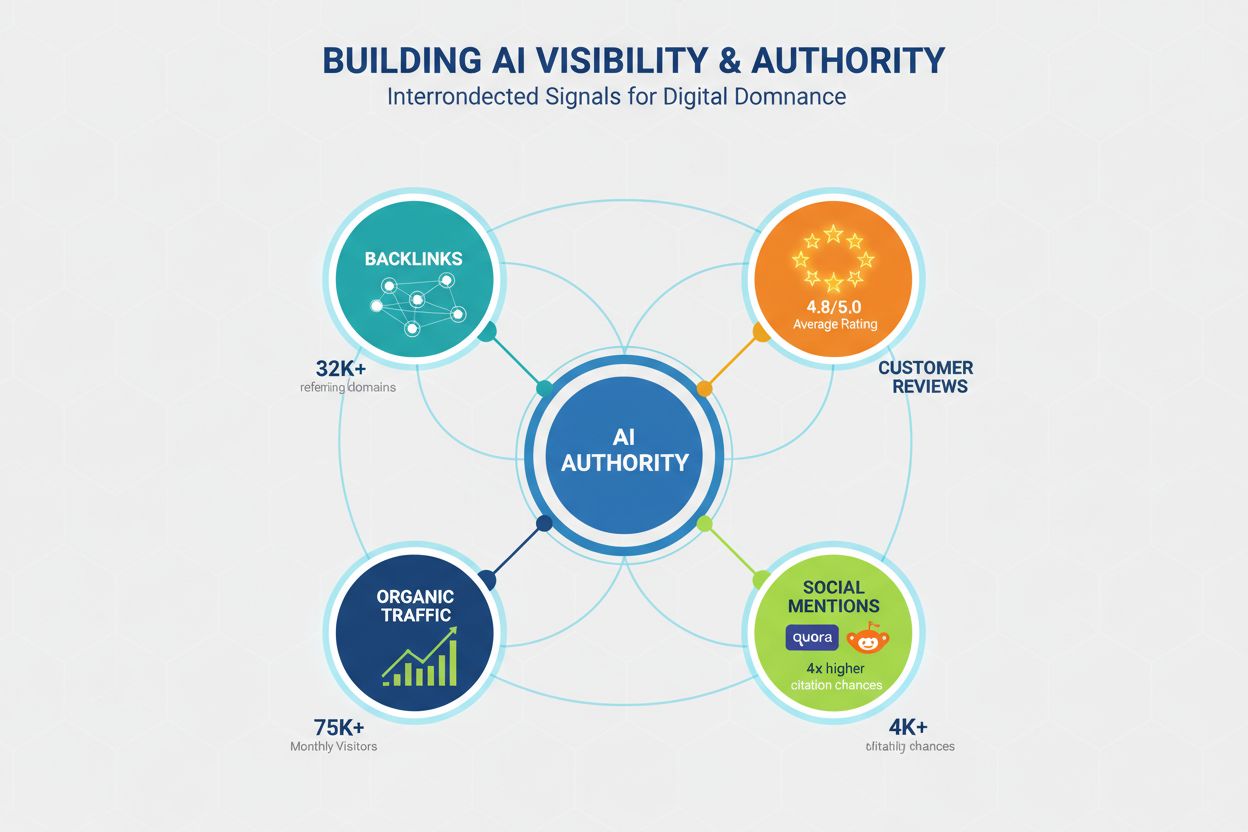

Autorytet wciąż jest kluczowy dla widoczności w AI, ale sygnały go budujące wykraczają poza tradycyjne SEO. LLM rozpoznają autorytet wielokanałowo, więc twórcy muszą budować wiarygodność na kilku płaszczyznach. Badania pokazują, że domeny z 32 000+ linkujących domen mają zdecydowanie wyższe wskaźniki cytowań, a Domain Trust silnie koreluje z widocznością w AI. Jednak autorytet to nie tylko linki — to złożone zjawisko obejmujące:

Profil linków — Jakościowe linki z autorytatywnych domen świadczą o ekspertyzie; 50+ wartościowych linków to 4,8x więcej cytowań niż przy minimalnej liczbie linków.

Dowody społeczne i obecność w społecznościach — Wzmianki na Quora, Reddit czy branżowych forach pokazują, że treści są zaufane i polecane przez użytkowników; aktywność tam buduje wiarygodność.

Platformy opinii i oceny — Obecność na Trustpilot, G2, Capterra itp. z pozytywnymi opiniami buduje sygnały zaufania rozpoznawane przez LLM; marki z oceną 4,5+ gwiazd otrzymują 3,2x więcej cytowań.

Ruch na stronie głównej i rozpoznawalność marki — Bezpośredni ruch wskazuje na rozpoznawalność i zaufanie; LLM chętniej cytują treści znanych marek niż anonimowych źródeł.

Eksperckie autorstwo i biogramy — Treści podpisane przez uznanych ekspertów z jasnymi kompetencjami są wyżej oceniane; ekspertyza autora to osobny sygnał autorytetu, niezależny od domeny.

Budowanie autorytetu pod AI to długofalowa strategia wykraczająca poza SEO — obejmuje zaangażowanie społeczności, zarządzanie opiniami i budowanie marki obok optymalizacji technicznej.

Głębia treści to jeden z najsilniejszych predyktorów cytowań AI — badania dowodzą, że kompleksowe, szczegółowo opracowane materiały są znacznie częściej cytowane niż powierzchowne. Minimalny próg dla konkurencyjnej widoczności to ok. 1900 słów, ale prawdziwie dominujące materiały sięgają 2900+ słów. To nie kwestia objętości dla samej objętości — liczy się ilość informacji, danych i różnorodność perspektyw.

Dane są jednoznaczne:

Wpływ cytatów ekspertów — Treści z 4+ cytatami ekspertów mają średnio 4,1 cytowania, wobec 2,4 dla treści bez perspektywy ekspertów; LLM rozpoznają ekspertyzę.

Gęstość danych statystycznych — Treści z 19+ punktami danych statystycznych mają średnio 5,4 cytowania, wobec 2,8 przy minimalnych danych; LLM preferują poparte danymi tezy.

Kompleksowość tematu — Treści obejmujące 8+ podtematów mają średnio 5,1 cytowania, wobec 3,2 dla tych z 3-4 podtematami; szerokość opracowania ma ogromne znaczenie.

Oryginalne badania — Treści z własnymi badaniami, ankietami lub danymi mają średnio 6,2 cytowania — to najwyższy wskaźnik widoczności AI.

Głębia jest kluczowa, bo LLM są trenowane, by dawać wyczerpujące, poparte źródłami odpowiedzi i naturalnie wybierają treści pozwalające cytować różne perspektywy i dane w jednym miejscu.

Świeżość treści to krytyczny, często pomijany czynnik widoczności w AI — badania dowodzą, że aktualizowane materiały otrzymują znacznie więcej cytowań niż przestarzałe. Różnica jest ogromna: treści zaktualizowane w ciągu trzech miesięcy mają średnio 6,0 cytowań, podczas gdy nieaktualizowane od roku — tylko 3,6. To odzwierciedla preferencję LLM do aktualnych informacji i świadomość, że świeże treści są bardziej wiarygodne.

Kwartalny plan odświeżania powinien być standardem dla treści celujących w AI. Nie chodzi o całkowite przepisywanie — wystarczą strategiczne aktualizacje: nowe statystyki, odświeżone przykłady, uaktualnione case studies, najnowsze trendy. Przy tematach szybko zmieniających się (technologie, trendy marketingowe, branżowe newsy) warto rozważyć aktualizacje miesięczne. Proces odświeżania obejmuje:

Treści, które stoją w miejscu, gdy branża się zmienia, stopniowo tracą widoczność w AI, nawet jeśli kiedyś były autorytatywne — bo LLM rozumieją, że przestarzałe informacje są mniej wartościowe.

Wydajność techniczna staje się coraz ważniejsza dla widoczności w AI — LLM i systemy, które je zasilają, premiują treści z szybkich, zoptymalizowanych stron. Core Web Vitals — metryki Google oceniające doświadczenie użytkownika — silnie korelują z cytowaniami, co pokazuje, że LLM uwzględniają sygnały UX przy wyborze źródeł. Różnica jest znaczna: strony z First Contentful Paint (FCP) poniżej 0,4 s mają średnio 6,7 cytowania, a te powyżej 2,5 s — tylko 2,1.

Optymalizacja techniczna pod AI powinna obejmować:

Largest Contentful Paint (LCP) — Cel poniżej 2,5 s; strony spełniające ten próg mają średnio 5,8 cytowania, wolniejsze — 2,9.

Cumulative Layout Shift (CLS) — Utrzymuj wynik poniżej 0,1; niestabilne układy sygnalizują LLM niską jakość i zmniejszają szansę na cytowanie.

Interaction to Next Paint (INP) — Optymalizuj responsywność poniżej 200 ms; strony interaktywne mają średnio 5,2 cytowania, wolne — 3,1.

Responsywność mobilna — Mobile-first indexing sprawia, że wydajność mobilna jest kluczowa; strony z niską jakością mobilną mają o 40% mniej cytowań.

Czysty, semantyczny HTML — Poprawna hierarchia nagłówków, semantyczne tagi i schludny kod pomagają LLM efektywniej analizować treści i zwiększają szansę na cytowanie.

Wydajność techniczna to nie tylko UX — to bezpośredni sygnał dla AI o jakości i wiarygodności treści.

Optymalizacja pod pytania to najprostszy sposób na dostosowanie treści do konwersacyjnych wzorców wyszukiwania AI, a jej wpływ jest szczególnie widoczny dla mniejszych domen bez dużego autorytetu. Badania pokazują, że tytuły w formie pytań mają 7x większy wpływ dla domen poniżej 50 tys. miesięcznych użytkowników niż tradycyjne tytuły, co czyni tę strategię bardzo wartościową dla rozwijających się marek. Sekcje FAQ są równie skuteczne — podwajają szanse na cytowanie, jeśli są dobrze skonstruowane.

Różnica między tytułami opartymi na pytaniach a tradycyjnymi jest wyraźna:

Zły tytuł: “Top 10 narzędzi marketingowych”

Dobry tytuł: “Jakie są najlepsze narzędzia marketingowe dla małych firm?”

Zły tytuł: “Strategia content marketingu”

Dobry tytuł: “Jak małe firmy powinny opracować strategię content marketingu?”

Zły tytuł: “Najlepsze praktyki e-mail marketingu”

Dobry tytuł: “Jakie są najlepsze praktyki e-mail marketingu dla e-commerce?”

Praktyczne taktyki optymalizacyjne:

Optymalizacja tytułów — Uwzględnij główne pytanie, na które odpowiada treść; używaj naturalnego języka, nie fraz nafaszerowanych słowami kluczowymi.

Sekcje FAQ — Twórz oddzielne sekcje FAQ z 5-10 pytaniami i bezpośrednimi odpowiedziami; to podwaja szanse na cytowanie w konkurencyjnych zapytaniach.

Dopasowanie podnagłówków — Używaj H2 i H3 odpowiadających popularnym wzorcom pytań; ułatwia to LLM dopasowanie zapytań do treści.

Lokalizacja odpowiedzi — Bezpośrednie odpowiedzi umieszczaj na początku sekcji, nie chowaj ich w środku akapitów; LLM łatwiej je wtedy wyłapują.

Optymalizacja pod pytania to nie trik, lecz dostosowanie struktury treści do rzeczywistych potrzeb użytkowników i sposobu, w jaki AI interpretuje te potrzeby.

Wielu twórców marnuje czas i zasoby na taktyki, które nie mają wpływu na widoczność w AI albo wręcz ją szkodzą. Zrozumienie tych mitów pozwala skupić się na tym, co naprawdę działa. Jednym z utrzymujących się mitów jest znaczenie plików LLMs.txt — badania pokazują, że ich wpływ na cytowania jest znikomy (3,8 vs 4,1 cytowania średnio dla domen z i bez tego pliku).

Czego unikać:

Samo FAQ schema nie pomaga — FAQ schema jest przydatne w tradycyjnym SEO, ale dla AI ma minimalne znaczenie; rzeczywista struktura treści jest ważniejsza. Treści z FAQ schema i złą strukturą mają średnio 3,6 cytowania, a dobrze zorganizowane bez schema — 4,2.

Nadmierna optymalizacja szkodzi — Nadmiernie zoptymalizowane adresy, tytuły i metaopisy wręcz zmniejszają szansę na cytowanie; takie treści mają 2,8 cytowania, a naturalnie napisane — 5,9. LLM rozpoznają i penalizują sztuczną optymalizację.

Nasycanie słowami kluczowymi nie pomaga LLM — W przeciwieństwie do wyszukiwarek LLM rozumieją sens i penalizują keyword stuffing; naturalny język jest znacznie skuteczniejszy.

Same linki nie gwarantują widoczności — Autorytet ma znaczenie, ale jakość i struktura treści są ważniejsze; domena o wysokim autorytecie z kiepsko zorganizowaną treścią będzie cytowana rzadziej niż dobrze ustrukturyzowana, ale mniej znana.

Długość bez treści nie działa — Sztuczne rozwlekanie tekstu bez wartości merytorycznej wręcz zmniejsza szansę na cytowanie; LLM rozpoznają i penalizują „lanie wody”.

Stawiaj na autentyczną jakość, jasną strukturę i prawdziwą ekspertyzę, a nie sztuczki optymalizacyjne.

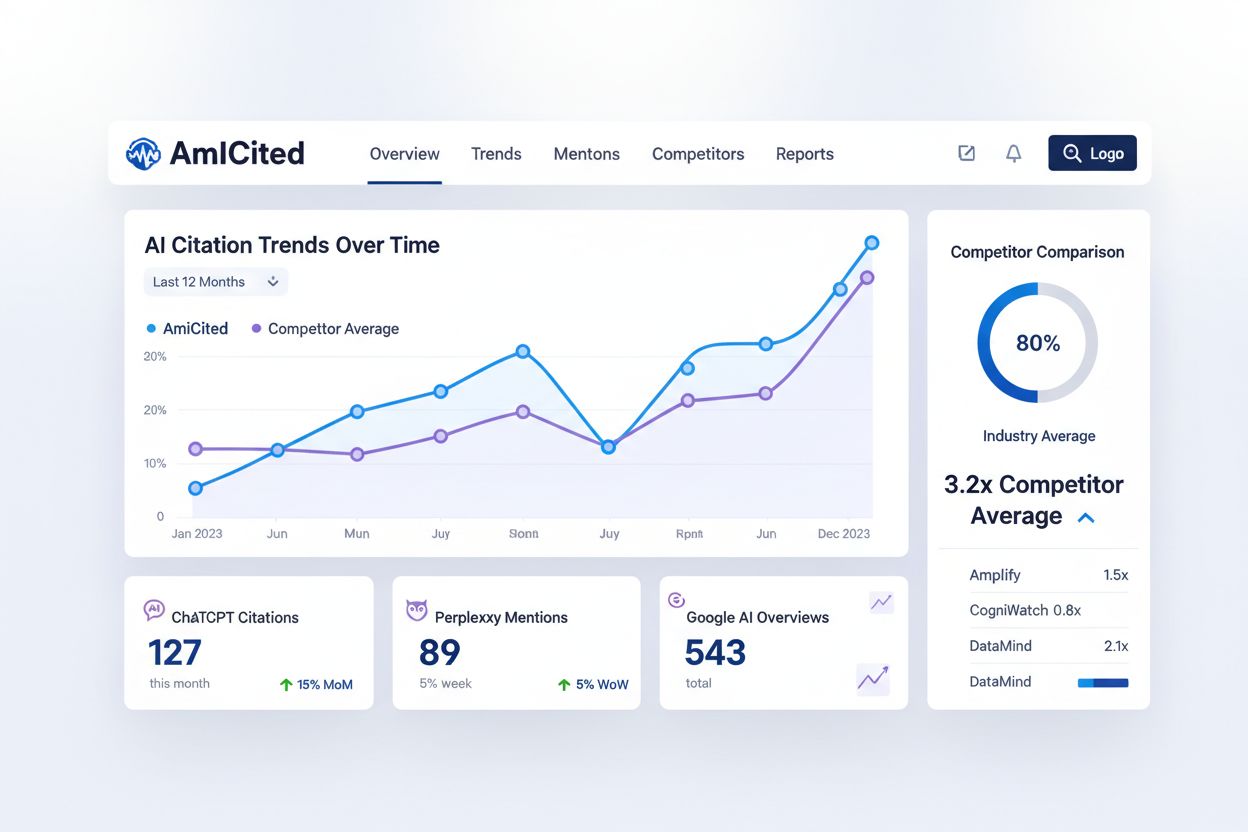

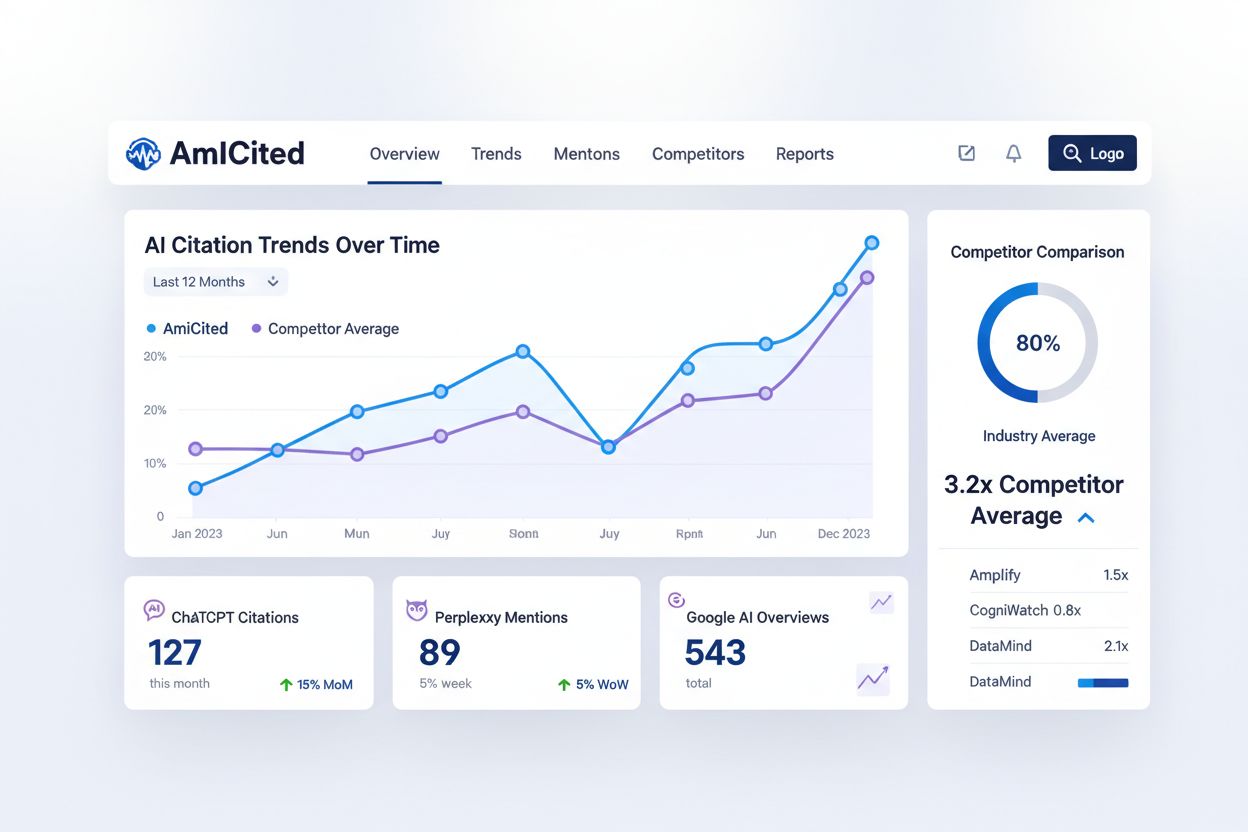

Monitorowanie, w jaki sposób AI cytują Twoje treści, jest niezbędne do zrozumienia widoczności i identyfikowania możliwości optymalizacji — tymczasem większość twórców tego nie kontroluje. AmICited.com to platforma do śledzenia, jak ChatGPT, Perplexity, Google AI Overviews i inne systemy AI cytują Twoją markę i treści. To uzupełnienie dla klasycznych narzędzi SEO, dostarczające wgląd w zupełnie nowy paradygmat wyszukiwania.

AmICited śledzi kluczowe wskaźniki, których nie mierzą narzędzia SEO:

Częstotliwość cytowań — Jak często Twoje treści są cytowane w różnych systemach AI; pozwala to ocenić, które materiały trafiają w algorytmy, a które wymagają poprawy.

Wzorce cytowań — Które strony i treści są cytowane najczęściej; pomaga to zidentyfikować najmocniejsze materiały i luki w ofercie.

Widoczność konkurencji w AI — Porównaj swoje cytowania AI z konkurencją; benchmark ujawnia Twoją pozycję w AI-wyszukiwaniu.

Śledzenie trendów — Obserwuj, jak zmienia się widoczność AI w czasie po wdrożeniu optymalizacji; pozwala mierzyć skuteczność strategii.

Różnorodność źródeł — Śledź cytowania na różnych platformach AI; widoczność w ChatGPT może różnić się od Perplexity czy Google AI Overviews, co pozwala optymalizować pod konkretne systemy.

Włączenie AmICited do strategii monitoringu treści daje dane potrzebne do optymalizacji pod AI — zamiast zgadywać, czy działania przynoszą efekty.

Wdrożenie strategii treści opartych na pytaniach dla AI wymaga systematycznego podejścia: budowania na istniejących materiałach i wdrażania nowych praktyk optymalizacyjnych. Proces powinien być metodyczny i oparty o dane — zaczynając od audytu, przez optymalizację struktury, budowanie autorytetu, po ciągły monitoring. Oto praktyczny 8-krokowy plan maksymalizacji widoczności w AI:

Audyt istniejących treści — Przeanalizuj top 50 stron pod kątem struktury, długości, hierarchii nagłówków i częstotliwości aktualizacji; wskaż strony wymagające optymalizacji.

Identyfikacja wartościowych pytań — Zbadaj konwersacyjne zapytania z branży w Answer the Public, Quora, Reddit; priorytet daj pytaniom z wysokim wolumenem i intencją zakupową.

Przebudowa z sekcjami Q&A — Przekształć istniejące treści, dodając nagłówki-pytania i bezpośrednie odpowiedzi; zamień tradycyjne tytuły na pytania odpowiadające zapytaniom użytkowników.

Wdrożenie hierarchii nagłówków — Każda treść powinna mieć poprawny układ H2/H3 z jasną organizacją; długie sekcje podziel na bloki po 120-180 słów z opisowymi podtytułami.

Dodanie FAQ — Stwórz sekcje FAQ na 20 najważniejszych stronach, po 5-10 pytań i odpowiedzi; priorytet dla pytań z danych wyszukiwania i opinii użytkowników.

Budowa autorytetu przez linki — Zaplanuj strategię pozyskiwania wartościowych linków z branży; celuj w jakość, nie ilość.

Monitoring przez AmICited — Skonfiguruj monitoring marki i kluczowych treści; ustal bazowe metryki i śledź zmiany po optymalizacjach.

Kwartalne aktualizacje — Ustal harmonogram odświeżania treści co kwartał: nowe dane, przykłady, najświeższe informacje; priorytet dla stron z największym ruchem i cytowaniami.

Ta strategia przekształca Twoje treści z klasycznego SEO w kompleksowe podejście zapewniające widoczność zarówno w tradycyjnym wyszukiwaniu, jak i w systemach konwersacyjnych AI.

Treści oparte na pytaniach to materiały skonstruowane wokół naturalnych pytań, które użytkownicy zadają konwersacyjnym systemom AI. Zamiast celować w słowa kluczowe typu „dentysta Warszawa”, skupiają się na pełnych pytaniach takich jak „Gdzie znajdę dobrego dentystę w Warszawie otwartego w weekendy?”. Takie podejście dopasowuje treść do naturalnego języka użytkownika i sposobu, w jaki AI interpretuje zapytania.

Tradycyjne wyszukiwanie zwraca listę uporządkowanych linków na podstawie dopasowania słów kluczowych, natomiast konwersacyjne AI syntetyzuje bezpośrednie odpowiedzi z wielu źródeł. Konwersacyjne AI rozumie kontekst, zapamiętuje historię rozmowy i dostarcza pojedyncze, zsyntetyzowane odpowiedzi z cytowaniami. Ta podstawowa różnica wymaga innych strategii optymalizacji treści.

LLMy analizują treści hierarchicznie, wykorzystując strukturę nagłówków i podziały sekcji do zrozumienia organizacji informacji. Optymalna struktura z sekcjami po 120-180 słów, przejrzystą hierarchią H2/H3 i bezpośrednimi odpowiedziami na początku sekcji ułatwia AI ekstrakcję i cytowanie Twoich treści. Słaba struktura zmniejsza szansę na cytowanie, niezależnie od jakości treści.

Badania pokazują, że około 1900 słów to minimalny próg dla konkurencyjnej widoczności w AI, a naprawdę kompleksowe opracowania osiągają ponad 2900 słów. Jednak ważniejsza od długości jest głębia — treści zawierające wypowiedzi ekspertów, dane statystyczne i wiele perspektyw są znacznie częściej cytowane niż te sztucznie wydłużone.

Treści zaktualizowane w ciągu ostatnich trzech miesięcy otrzymują średnio 6,0 cytowań, podczas gdy nieaktualizowane — 3,6. Wprowadź kwartalny plan odświeżania, dodając nowe statystyki, uaktualniając przykłady i uwzględniając najnowsze informacje. To sygnalizuje AI aktualność i utrzymuje konkurencyjność cytowań.

Tak. Mimo że duże domeny mają przewagę autorytetu, mniejsze strony mogą konkurować dzięki lepszej strukturze treści, optymalizacji pod pytania i aktywności w społecznościach. Tytuły oparte na pytaniach mają 7x większy wpływ dla mniejszych domen, a obecność na Quora i Reddit zwiększa szanse na cytowania nawet 4x.

AmICited monitoruje, jak ChatGPT, Perplexity i Google AI Overviews cytują Twoją markę i treści. Dostarcza wgląd w wzorce cytowań, identyfikuje luki w treściach, śledzi widoczność konkurencji w AI i mierzy efekty optymalizacji — to metryki, których tradycyjne narzędzia SEO nie zapewniają.

Nie. Schema markup jest przydatny w tradycyjnym wyszukiwaniu, ale dla AI ma minimalne znaczenie. Treści z FAQ schema otrzymują średnio 3,6 cytowań, podczas gdy dobrze zorganizowane treści bez schema — 4,2. Skup się na strukturze i jakości treści, nie tylko na znacznikach.

Zobacz, jak ChatGPT, Perplexity i Google AI Overviews cytują Twoją markę dzięki narzędziu śledzenia cytowań AI od AmICited.

Odkryj nieodpowiedziane zapytania w wyszukiwarkach AI i zamień je w szanse na treści. Dowiedz się, jak identyfikować luki, w których cytowani są konkurenci, a C...

Dowiedz się, czym różnią się zapytania konwersacyjne od tradycyjnych zapytań opartych na słowach kluczowych. Zrozum, dlaczego wyszukiwarki AI priorytetyzują nat...

Poznaj kluczowe trendy kształtujące ewolucję wyszukiwania AI w 2026 roku, w tym możliwości multimodalne, systemy agentowe, wyszukiwanie informacji w czasie rzec...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.