Najlepsza struktura strony dla indeksowania i widoczności w wyszukiwarkach AI

Dowiedz się, jak zbudować strukturę swojej strony internetowej dla optymalnego indeksowania przez roboty AI, w tym semantyczny HTML, architekturę serwisu, organ...

Dowiedz się, jak optymalizować mapy witryn XML dla robotów AI, takich jak GPTBot i ClaudeBot. Opanuj najlepsze praktyki tworzenia map witryn, by zwiększyć widoczność w odpowiedziach generowanych przez AI i indeksowaniu LLM.

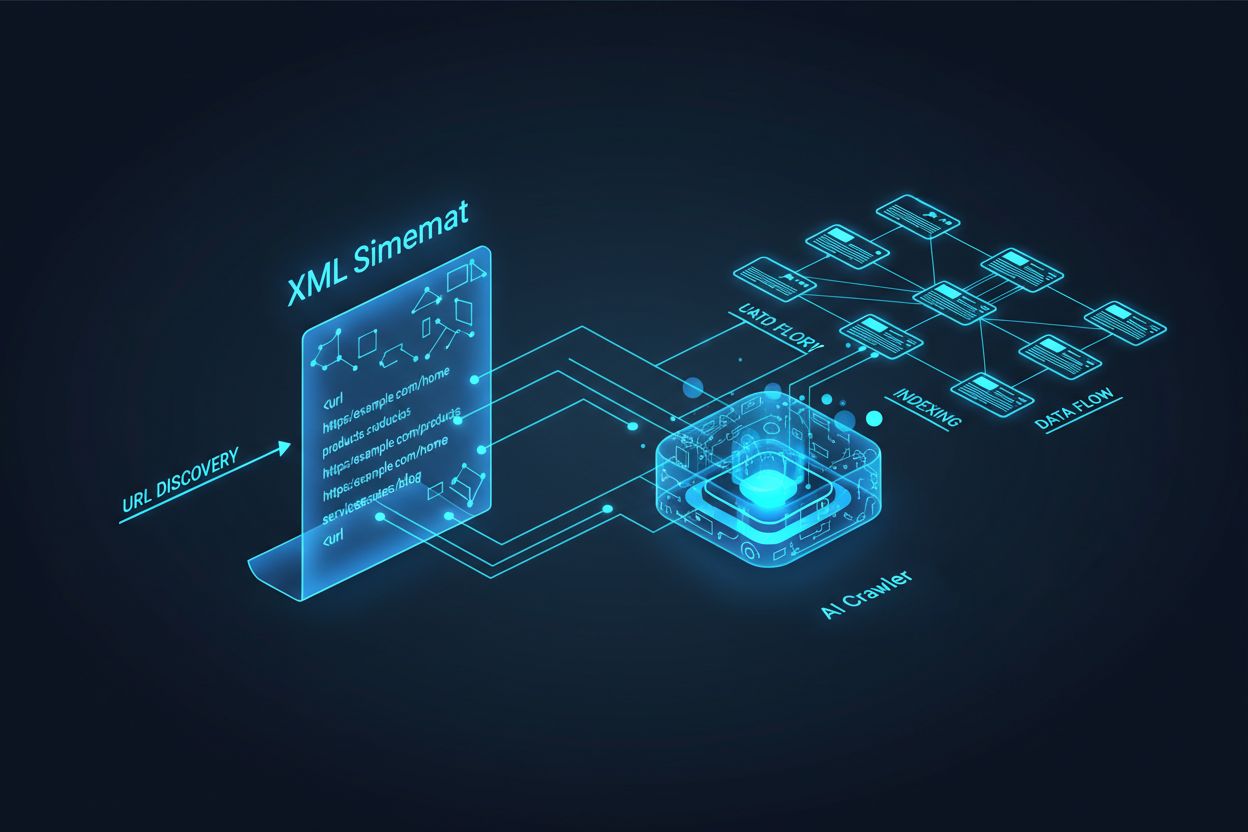

Roboty AI, takie jak GPTBot, ClaudeBot czy PerplexityBot, działają zasadniczo inaczej niż tradycyjne boty wyszukiwarek. Podczas gdy Googlebot indeksuje strony w celu ustalenia pozycji w wynikach wyszukiwania, roboty AI wydobywają wiedzę do trenowania i zasilania dużych modeli językowych, które obsługują wyszukiwanie konwersacyjne i generowane przez AI odpowiedzi. Bez odpowiednio zoptymalizowanej mapy witryny XML Twoje treści pozostają niewidoczne dla tych kluczowych systemów, niezależnie od ich jakości czy autorytetu. Traktuj mapę witryny jak mapę drogową, która wskazuje systemom AI, gdzie znajdują się najbardziej wartościowe treści i jak są zorganizowane.

Różnica między tradycyjnymi robotami wyszukiwarek a robotami AI jest kluczowa, by zrozumieć, dlaczego optymalizacja mapy witryny jest dziś ważniejsza niż kiedykolwiek. Tradycyjne wyszukiwarki, takie jak Google, skupiają się na pozycjonowaniu pojedynczych stron pod określone słowa kluczowe, podczas gdy roboty AI priorytetyzują pozyskiwanie wiedzy i semantyczne zrozumienie. Oto jak się różnią:

| Aspekt | Tradycyjne roboty (Googlebot) | Roboty AI (GPTBot, ClaudeBot) |

|---|---|---|

| Główny cel | Pozycjonowanie stron w wynikach wyszukiwania | Pozyskiwanie wiedzy do treningu LLM i odpowiedzi w czasie rzeczywistym |

| Fokus | Metadane, linki wewnętrzne, sygnały rankingowe | Struktura treści, znaczenie semantyczne, gęstość faktów |

| Priorytet indeksowania | Bazuje na PageRank i świeżości | Bazuje na autorytecie, aktualności tematycznej i wartości wiedzy |

| Wpływ na cytowanie | Generuje ruch przez linki | Określa, czy Twoje treści pojawią się w odpowiedziach AI |

| Obsługa JavaScript | Wykonuje i renderuje JavaScript | Często pomija JavaScript; priorytet dla HTML renderowanego po stronie serwera |

Ta fundamentalna różnica oznacza, że optymalizacja wyłącznie pod tradycyjne SEO już nie wystarcza. Mapa witryny musi obecnie spełniać podwójną rolę: pomagać wyszukiwarkom zrozumieć strukturę witryny oraz kierować roboty AI do najwartościowszych zasobów wiedzy.

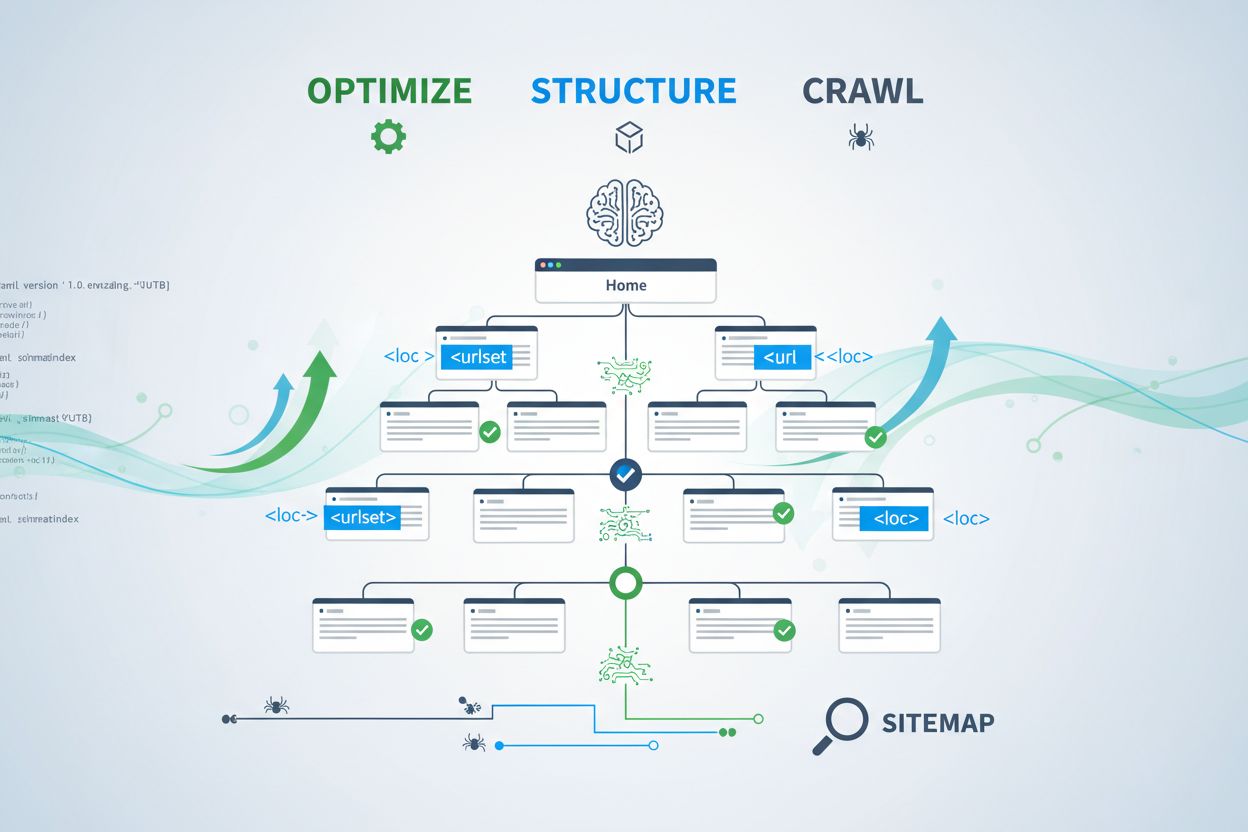

Mapa witryny XML działa jak plan Twojej strony, jasno informując roboty, jakie strony istnieją i jak wpisują się w całą strategię treści. Dla systemów AI mapy witryn odgrywają jeszcze ważniejszą rolę niż dla tradycyjnych wyszukiwarek. Roboty AI używają map, by zrozumieć architekturę tematyczną serwisu, zidentyfikować treści priorytetowe i zdecydować, które strony wymagają głębszej analizy. Gdy mapa witryny jest kompletna i dobrze zorganizowana, systemy AI szybciej odkrywają i oceniają Twoje treści pod kątem wykorzystania w odpowiedziach generatywnych. Przeciwnie, niekompletna lub nieaktualna mapa tworzy „martwe strefy”, przez które najważniejsze strony nigdy nie zostaną zauważone przez AI. Efekt jest bezpośredni: strony nieobecne na mapie mają znacznie mniejsze szanse na cytowanie przez AI, niezależnie od ich jakości czy trafności.

Tworzenie skutecznej mapy dla robotów AI to coś więcej niż tylko wypisanie wszystkich adresów URL. Mapa powinna być strategicznie wyselekcjonowana i zawierać tylko strony faktycznie wartościowe dla użytkowników i systemów AI. Oto kluczowe najlepsze praktyki:

Dobrze zorganizowana mapa działa jak filtr jakości, pokazując AI, że starannie wyselekcjonowałeś treści i każdemu adresowi należy się uwaga. Taka strategia znacząco zwiększa szanse na cytowanie w odpowiedziach generowanych przez AI.

Aktualność to jeden z najsilniejszych czynników rankingowych w wyszukiwarkach opartych na AI. Przy wyborze źródeł do cytowania roboty AI mocno biorą pod uwagę świeżość treści. Znacznik lastmod w Twojej mapie XML to główny sygnał informujący systemy AI, kiedy treść została ostatnio zaktualizowana. Nieaktualne lub brakujące znaczniki mogą sprawić, że nawet autorytatywne treści zostaną zdegradowane na rzecz nowszych. Jeśli mapa wskazuje, że strona nie była zmieniana od lat, AI może uznać ją za nieaktualną i wybrać treści konkurencji. Z kolei precyzyjne lastmod, odzwierciedlające rzeczywiste zmiany, sygnalizują AI, że informacje są aktualne i wiarygodne. Dla tematów wrażliwych na czas, jak ceny, regulacje czy trendy, dokładność znaczników jest jeszcze ważniejsza. Automatyczne aktualizacje w CMS-ie zapewniają, że każda zmiana od razu trafia do mapy, maksymalizując widoczność w odpowiedziach AI.

Podczas gdy mapa witryny zaprasza roboty do indeksowania, plik robots.txt kontroluje, które części serwisu mogą być dostępne dla robotów. Oba pliki muszą współpracować, by zmaksymalizować widoczność w AI. Częsty błąd to stworzenie kompletnej mapy przy jednoczesnym blokowaniu robotów AI w robots.txt, co wprowadza sprzeczność i zmniejsza widoczność. Twój robots.txt powinien jawnie zezwalać głównym robotom AI, takim jak GPTBot, ClaudeBot czy PerplexityBot, na dostęp do treści. Możesz strategicznie blokować tylko te strony, które nie powinny być indeksowane, np. panele administracyjne, strony logowania czy duplikaty. Kluczowe jest, by zasady robots.txt były zgodne ze strategią mapy—jeśli strona jest na mapie, powinna być również dostępna zgodnie z robots.txt. Regularne audyty obu plików pomagają wykryć błędy konfiguracji, które mogą po cichu ograniczać widoczność w AI.

Najskuteczniejsze strategie optymalizacji pod AI traktują mapę witryny i dane strukturalne jako systemy uzupełniające się. Jeśli mapa wskazuje stronę jako ważną, a ta strona zawiera odpowiednie schema, wysyłasz spójny sygnał o jej celu i wartości. Na przykład jeśli mapa priorytetyzuje poradnik, powinien on zawierać schema HowTo opisujące kroki. Strony produktów na mapie powinny mieć Product schema z ceną, dostępnością i recenzjami. Taka zgodność tworzy spójny obraz danych łatwy do interpretacji i zaufania przez AI. Gdy mapa i schema są niespójne, AI traci pewność co do celu danej strony, zmniejszając szanse na cytowanie. Dopasowując strategię mapy do wdrożenia schema, tworzysz jednolity sygnał, który znacznie zwiększa szanse na cytowanie w odpowiedziach AI.

Różne typy treści wymagają odmiennych strategii map, by zmaksymalizować widoczność w AI. Posty blogowe, strony produktów, opisy usług czy FAQ mają różne cele i powinny być odpowiednio zoptymalizowane:

| Typ treści | Strategia mapy | Zalecane dane strukturalne (schema) | Priorytety |

|---|---|---|---|

| Posty i artykuły | Dodawaj z precyzyjną datą publikacji i aktualizacji | Article, NewsArticle, BlogPosting | Priorytet dla aktualnych, ponadczasowych treści; regularna aktualizacja lastmod |

| Strony produktów | Dodawaj z aktualizacjami stanu magazynowego; rozważ osobną mapę produktów | Product, Offer, AggregateRating | Wyróżnij bestsellery i nowości; często aktualizuj ceny |

| Strony usług | Dodawaj z datami aktualizacji usług | Service, LocalBusiness, ProfessionalService | Priorytet dla kluczowych usług; aktualizacja dostępności i cen |

| Strony FAQ | Dodawaj z datami aktualizacji treści | FAQPage, Question, Answer | Priorytet dla wyczerpujących FAQ; aktualizuj odpowiedzi przy zmianie informacji |

| Wideo | Dodawaj w mapie wideo z miniaturą i czasem trwania | VideoObject, Video | Dodaj transkrypcje; aktualizuj liczbę wyświetleń i zaangażowanie |

| Obrazy | Dodawaj w mapie obrazów z podpisami | ImageObject, Product (dla zdjęć produktów) | Optymalizuj alt text; dodaj opisowe podpisy |

Dzięki takiemu podejściu każdy typ treści otrzymuje właściwą optymalizację pod kątem AI. Dopasowując strategię mapy do miksu treści, maksymalizujesz szansę na znalezienie i cytowanie najcenniejszych zasobów przez systemy AI.

Standard llms.txt, zaproponowany pod koniec 2024 roku, to eksperymentalne podejście do ułatwienia AI zrozumienia struktury strony. W przeciwieństwie do XML, llms.txt to plik Markdown zawierający czytelną dla człowieka tabelę treści. Wypisuje najważniejsze strony i zasoby w formacie łatwiejszym do przetwarzania przez modele językowe. Choć koncepcja jest obiecująca, obecnie llms.txt ma minimalny wpływ na widoczność w AI w porównaniu do tradycyjnych map XML. Najważniejsze roboty, takie jak GPTBot i ClaudeBot, nadal opierają się głównie na XML do wykrywania adresów i sygnałów świeżości. Zamiast zastępować mapę XML, llms.txt należy traktować jako narzędzie uzupełniające, dostarczające dodatkowego kontekstu AI. Jeśli wdrażasz llms.txt, upewnij się, że uzupełnia, a nie zastępuje podstawową strategię mapy XML – najpierw zadbaj o perfekcyjną mapę XML z poprawnymi datami i strategiczną selekcją treści.

Nawet dobre witryny często popełniają krytyczne błędy w mapach, które po cichu ograniczają widoczność w AI. Ich zrozumienie i unikanie jest kluczowe, by zmaksymalizować obecność w odpowiedziach generowanych przez AI:

Naprawa tych typowych błędów natychmiast poprawi Twoją widoczność w AI. Zacznij od audytu obecnej mapy według tej listy i usuń wykryte problemy.

Utrzymanie zoptymalizowanej mapy wymaga stałego monitoringu i walidacji. Istnieje wiele narzędzi, które pomagają dbać o skuteczność mapy dla robotów AI. Google Search Console oferuje wbudowaną walidację i pokazuje, ile adresów Google zaindeksował z Twojej mapy. Screaming Frog SEO Spider pozwala przeskanować całą witrynę i porównać wyniki z mapą, wykrywając brakujące lub uszkodzone adresy. Walidatory map XML sprawdzają poprawność składni i zgodność z protokołem mapy. Dla dużych firm platformy SEO, takie jak Semrush czy Ahrefs, oferują funkcje analizy mapy i śledzą zmiany w czasie. Regularne audyty—najlepiej co miesiąc—pozwalają wychwycić błędy zanim wpłyną one na widoczność w AI. Ustaw przypomnienia, by przeglądać mapę po każdej dużej zmianie treści, wdrożeniu nowych sekcji czy zmianie architektury strony.

Aby zrozumieć, jak roboty AI korzystają z mapy, potrzebujesz monitoringu i analizy. Logi serwera zawierają informacje, które roboty odwiedzają witrynę, jak często indeksują i które strony priorytetyzują. Analizując logi, możesz wykryć wzorce i optymalizować mapę. Narzędzia takie jak AmICited.com pozwalają monitorować, jak często Twoje treści są cytowane przez AI (ChatGPT, Claude, Perplexity, Google AI Overviews), dając bezpośrednią informację zwrotną o skuteczności mapy. Google Analytics można skonfigurować do śledzenia ruchu z AI, pokazując, które strony generują największą widoczność. Korelując te dane ze strukturą mapy, wyłonisz typy i tematy treści najbardziej atrakcyjne dla AI. Takie podejście pozwala stale udoskonalać strategię mapy, priorytetyzując treści generujące najwięcej cytowań i widoczności AI.

Poza podstawową optymalizacją, zaawansowane strategie mogą znacząco poprawić widoczność w AI. Tworzenie osobnych map dla różnych typów treści—np. blogów, produktów, wideo—umożliwia precyzyjną optymalizację. Dynamiczne generowanie mapy, gdzie aktualizuje się ona w czasie rzeczywistym, zapewnia robotom AI dostęp do najnowszych treści. Dla dużych witryn wdrożenie hierarchii map i strategicznej priorytetyzacji kieruje roboty na najcenniejsze zasoby. Niektóre firmy tworzą osobne mapy AI, zawierające wyłącznie najbardziej autorytatywne, warte cytowania strony, sygnalizując robotom, które adresy zasługują na priorytet. Integracja strategii mapy z CMS sprawia, że optymalizacja jest automatyczna i nie wymaga ręcznych aktualizacji. Te zaawansowane podejścia wymagają większej wiedzy technicznej, ale przynoszą znaczne korzyści organizacjom z rozbudowanymi ekosystemami treści.

Krajobraz robotów AI dynamicznie się zmienia—pojawiają się nowe roboty, a standardy takie jak llms.txt zyskują popularność. Przyszłościowa strategia mapy polega na elastyczności i śledzeniu branżowych trendów. Wdrażaj systemy generowania map, które łatwo dostosujesz do nowych wymagań robotów bez ręcznej re-konfiguracji. Monitoruj komunikaty głównych firm AI o nowych robotach i aktualizuj robots.txt oraz mapę zgodnie z nimi. Rozważ długoterminową wartość widoczności w AI w stosunku do kontroli nad treścią—choć niektóre firmy decydują się blokować roboty AI, trend wskazuje, że cytowania AI będą coraz ważniejsze dla widoczności marki. Opracuj jasną politykę zarządzania dostępem robotów AI i wykorzystaniem treści. Traktując mapę witryny jako żywy dokument, który ewoluuje wraz z rynkiem AI, zapewniasz, że Twoje treści pozostaną widoczne i cytowane, gdy mechanizmy wyszukiwania i odkrywania będą się dalej zmieniać.

Mapę witryny należy aktualizować za każdym razem, gdy publikujesz nową treść lub wprowadzasz istotne zmiany na istniejących stronach. Najlepiej wdrożyć automatyczne generowanie mapy witryny, aby aktualizacje następowały natychmiastowo. Dla stron z częstymi zmianami treści zalecane są codzienne aktualizacje. Dla statycznych witryn wystarczające są comiesięczne przeglądy.

Większość głównych robotów AI, takich jak GPTBot i ClaudeBot, przestrzega dyrektyw robots.txt, ale nie wszystkie. Najlepszą praktyką jest jawne zezwolenie robotom AI w pliku robots.txt zamiast polegać na domyślnym zachowaniu. Monitoruj logi serwera, aby zweryfikować, czy roboty zachowują się zgodnie z oczekiwaniami.

Mapy witryn XML to pliki maszynowe, które zawierają listę wszystkich Twoich adresów URL wraz z metadanymi, takimi jak ostatnia modyfikacja (lastmod). llms.txt to nowszy standard oparty na Markdown, zaprojektowany, aby zapewnić systemom AI czytelną dla człowieka tabelę treści. Obecnie mapy witryn XML są ważniejsze dla widoczności w AI, podczas gdy llms.txt należy traktować jako uzupełnienie.

Sprawdź logi serwera pod kątem agentów użytkownika takich jak 'GPTBot', 'ClaudeBot', 'PerplexityBot' i 'Google-Extended'. Możesz także użyć narzędzi takich jak AmICited.com, aby monitorować, jak często Twoje treści są cytowane przez systemy AI, co świadczy o skutecznym indeksowaniu i przetwarzaniu.

Tak, tworzenie oddzielnych map witryn dla blogów, produktów, wideo i zdjęć pozwala zastosować strategie optymalizacji specyficzne dla danego typu. Pomaga to również robotom AI lepiej zrozumieć strukturę Twoich treści i może poprawić efektywność indeksowania w przypadku dużych witryn.

Mapy witryn XML nie powinny zawierać więcej niż 50 000 adresów URL w jednym pliku. Dla większych witryn używaj indeksów map witryn do organizowania wielu plików. Roboty AI radzą sobie z dużymi mapami, ale podzielenie ich na logiczne sekcje poprawia efektywność indeksowania i ułatwia zarządzanie.

Znaczniki lastmod sygnalizują robotom AI świeżość treści. Aktualność to silny czynnik rankingowy w systemach AI, więc precyzyjne znaczniki pomagają Twoim treściom konkurować o cytowania. Zawsze używaj automatycznych systemów do aktualizacji znaczników tylko wtedy, gdy treść faktycznie się zmienia—nigdy nie ustawiaj fałszywych dat ręcznie.

Tak, źle utrzymana mapa witryny może poważnie zaszkodzić Twojej widoczności w AI. Uszkodzone linki, nieaktualne adresy URL, nieprecyzyjne znaczniki czasu i niepełne pokrycie zmniejszają szanse na cytowanie przez systemy AI. Regularne audyty i konserwacja są niezbędne do ochrony widoczności w AI.

Śledź, jak często Twoje treści są cytowane przez ChatGPT, Claude, Perplexity i Google AI Overviews. Optymalizuj strategię mapy witryny na podstawie rzeczywistych danych o cytowaniach AI.

Dowiedz się, jak zbudować strukturę swojej strony internetowej dla optymalnego indeksowania przez roboty AI, w tym semantyczny HTML, architekturę serwisu, organ...

Kompletny przewodnik po AI crawlerach i botach. Identyfikuj GPTBot, ClaudeBot, Google-Extended oraz 20+ innych AI crawlerów z agentami użytkownika, tempem indek...

Poznaj kluczowe techniczne czynniki SEO wpływające na widoczność w wyszukiwarkach AI, takich jak ChatGPT, Perplexity i Google AI Mode. Dowiedz się, jak szybkość...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.