Karta Referencyjna AI Crawlerów: Wszystkie Boty w Jednym Miejscu

Kompletny przewodnik po AI crawlerach i botach. Identyfikuj GPTBot, ClaudeBot, Google-Extended oraz 20+ innych AI crawlerów z agentami użytkownika, tempem indek...

Dowiedz się, jak strategie renderowania SSR i CSR wpływają na widoczność dla AI crawlerów, cytowania marki w ChatGPT i Perplexity oraz ogólną obecność w wyszukiwarkach AI.

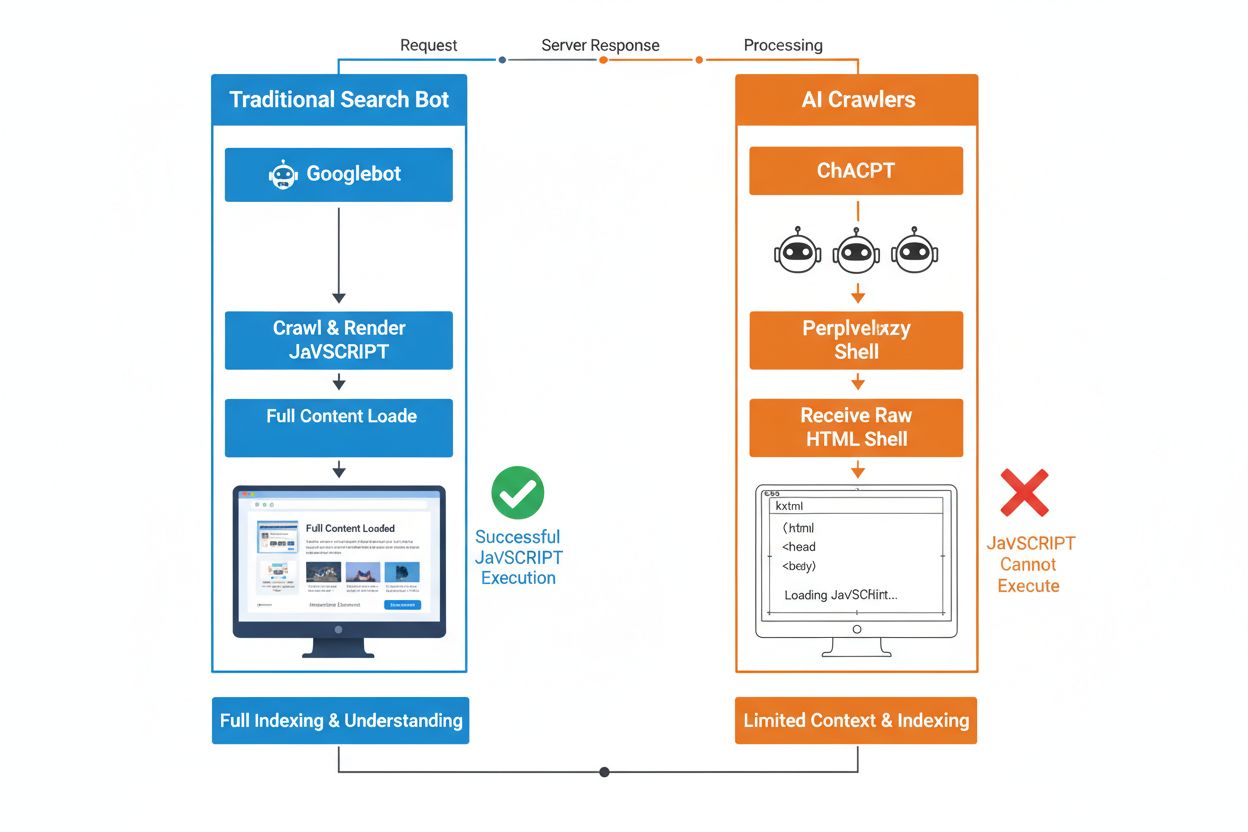

Zasadnicza różnica między tradycyjnymi botami wyszukiwarek a crawlerami AI tkwi w ich podejściu do wykonywania JavaScriptu. Podczas gdy Googlebot i inne tradycyjne wyszukiwarki potrafią renderować JavaScript (choć z ograniczeniami zasobów), AI crawlery takie jak GPTBot, ChatGPT-User i OAI-SearchBot w ogóle nie wykonują JavaScriptu—widzą jedynie surowy HTML przesłany przy pierwszym załadowaniu strony. To kluczowe rozróżnienie oznacza, że jeśli zawartość Twojej strony zależy od JavaScriptu po stronie klienta, systemy AI otrzymają niekompletny lub pusty zrzut stron, bez szczegółów produktów, cen, recenzji i innej dynamicznej treści widocznej dla użytkownika w przeglądarce. Zrozumienie tej luki jest istotne, ponieważ wyniki wyszukiwania oparte na AI szybko stają się głównym kanałem odkrywania informacji przez użytkowników.

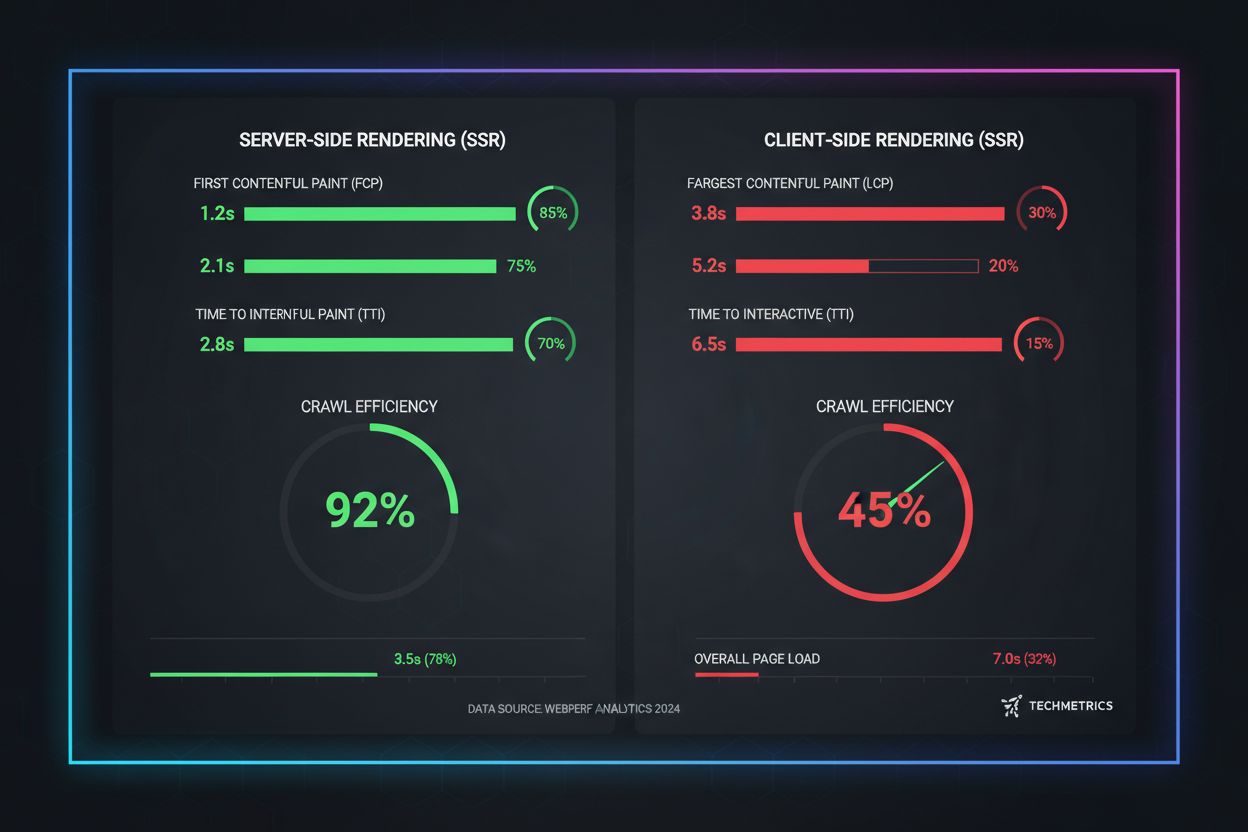

Renderowanie po stronie serwera (SSR) zasadniczo poprawia widoczność w AI poprzez dostarczenie w pełni wyrenderowanego HTML bezpośrednio z serwera przy pierwszym żądaniu, eliminując potrzebę wykonywania JavaScriptu przez AI crawlery. Dzięki SSR cała kluczowa treść—nagłówki, teksty, informacje o produktach, metadane i dane strukturalne—jest obecna w HTML, który otrzymują boty, co czyni ją natychmiast dostępną do włączenia do korpusów treningowych AI i indeksów wyszukiwania. To podejście gwarantuje spójne dostarczanie treści wszystkim crawlerom, szybsze indeksowanie oraz pełną widoczność metadanych, na których polegają systemy AI, by prawidłowo interpretować i cytować Twoje materiały. Poniższa tabela ilustruje, jak różne strategie renderowania wpływają na widoczność dla AI crawlerów:

| Typ renderowania | Co widzą AI crawlery | Szybkość indeksowania | Kompletność treści | Widoczność metadanych |

|---|---|---|---|---|

| Renderowanie po stronie serwera (SSR) | W pełni wyrenderowany HTML ze wszystkimi treściami | Szybko (natychmiast) | Pełna | Doskonała |

| Renderowanie po stronie klienta (CSR) | Minimalny szkielet HTML, brak treści dynamicznych | Wolno (jeśli w ogóle) | Niepełna | Słaba |

| Statyczne generowanie stron (SSG) | Wstępnie zbudowany, zcache’owany HTML | Bardzo szybko | Pełna | Doskonała |

| Hybrydowe/incremental | Mieszanka statycznych i dynamicznych tras | Średnio do szybko | Dobra (jeśli kluczowe strony pre-renderowane) | Dobra |

Renderowanie po stronie klienta (CSR) stanowi poważne wyzwanie dla widoczności w AI, ponieważ wymusza na crawlerach oczekiwanie na wykonanie JavaScriptu—czego boty AI po prostu nie robią ze względu na ograniczenia zasobów i krótkie limity czasu. Gdy strona oparta na CSR się ładuje, początkowa odpowiedź HTML zawiera jedynie szkielet z loaderami i placeholderami, a właściwa treść doczytuje się asynchronicznie przez JavaScript. AI crawlery narzucają ścisłe limity czasu 1-5 sekund i nie wykonują skryptów, co oznacza, że rejestrują pusty lub niemal pusty zrzut strony pozbawiony opisów produktów, cen, recenzji i innych kluczowych informacji. Tworzy to kaskadowy problem: niekompletne zrzuty prowadzą do słabej jakości chunkowania i embeddingów, przez co maleje szansa na uwzględnienie Twoich stron w odpowiedziach generowanych przez AI. Dla e-commerce, SaaS i serwisów z bogatą treścią opartych na CSR przekłada się to bezpośrednio na utraconą widoczność w AI Overviews, odpowiedziach ChatGPT i Perplexity—czyli kanałach, które napędzają odkrywanie w erze AI.

Techniczny powód, dla którego boty AI nie mogą wykonywać JavaScriptu, wynika z fundamentalnych ograniczeń skalowalności i zasobów, które są wpisane w ich architekturę. AI crawlery stawiają na szybkość i efektywność kosztem kompletności, działając w ramach ścisłych limitów czasu, ponieważ muszą przetwarzać miliardy stron do trenowania i aktualizacji modeli językowych. Wykonywanie JavaScriptu wymaga uruchamiania przeglądarek bezgłowych, przydzielania pamięci i oczekiwania na zakończenie operacji asynchronicznych—na co nie ma miejsca przy skali wymaganej przez LLM. Zamiast tego systemy AI koncentrują się na ekstrakcji czystego, semantycznie zorganizowanego HTML dostępnego natychmiast, traktując treści statyczne jako kanoniczną wersję Twojej strony. Ten wybór odzwierciedla fundamentalną prawdę: systemy AI są zoptymalizowane pod kątem dostarczania statycznego HTML, nie renderowania złożonych frameworków JavaScript, takich jak React, Vue czy Angular.

Wpływ na odpowiedzi generowane przez AI i widoczność marki jest ogromny i bezpośrednio przekłada się na wyniki biznesowe. Gdy AI crawlery nie mają dostępu do Twojej treści przez renderowanie JavaScript, Twoja marka staje się niewidoczna w AI Overviews, nieobecna w cytowaniach i nie pojawia się w wynikach wyszukiwania napędzanych przez LLM—nawet jeśli dobrze wypadasz w tradycyjnym Google. Dla e-commerce oznacza to, że szczegóły produktów, ceny i dostępność nigdy nie trafią do systemów AI, skutkując niepełnymi lub nieprawidłowymi rekomendacjami i utraconymi okazjami sprzedażowymi. Firmy SaaS tracą widoczność w porównaniach funkcji i stronach cenników, które mogłyby przyciągać wartościowych leadów przez narzędzia badawcze AI. Serwisy newsowe i contentowe widzą, jak ich artykuły są pomijane w podsumowaniach AI, co zmniejsza ruch referencyjny z platform takich jak ChatGPT i Perplexity. Różnica między tym, co widzi człowiek, a co system AI, tworzy problem dwutorowej widoczności: Twoja strona może wyglądać dobrze w tradycyjnych metrykach SEO, a równocześnie być niewidoczna dla najszybciej rosnącego kanału odkrywania.

Pre-rendering i rozwiązania hybrydowe to praktyczne sposoby na połączenie zalet obu podejść renderowania bez konieczności całkowitej przebudowy architektury. Zamiast wybierać między interaktywnością CSR a indeksowalnością SSR, nowoczesne zespoły wdrażają strategiczne kombinacje, które służą różnym celom:

Pozwala to zachować bogate, interaktywne doświadczenia użytkownika przy jednoczesnej gwarancji, że AI crawlery otrzymują kompletny, wyrenderowany HTML. Frameworki takie jak Next.js, Nuxt i SvelteKit czynią hybrydowe renderowanie dostępnym bez konieczności dużych nakładów deweloperskich. Kluczem jest zidentyfikowanie stron, które generują ruch, przychody lub odciążenie supportu—te kluczowe strony zawsze powinny być pre-renderowane lub SSR, by zapewnić widoczność w AI.

Strategia renderowania bezpośrednio wpływa na to, jak systemy AI cytują i odnoszą się do Twojej marki, dlatego monitorowanie widoczności na platformach AI jest kluczowe. Narzędzia takie jak AmICited.com śledzą, jak systemy AI cytują Twoją markę w ChatGPT, Perplexity, Google AI Overviews i innych platformach opartych na LLM, pokazując, czy Twoja treść faktycznie dociera do tych systemów. Gdy strona korzysta z CSR bez pre-renderingu, dane z AmICited często ujawniają wyraźną lukę: możesz zajmować wysokie pozycje w tradycyjnym wyszukiwaniu, a jednocześnie mieć zero cytowań w odpowiedziach AI. Takie monitorowanie ujawnia prawdziwy koszt wyboru renderowania przez JavaScript—nie tylko w efektywności crawlów, ale w utraconej widoczności marki i szansach na cytowanie. Wdrażając SSR lub pre-rendering i następnie monitorując efekty przez AmICited, możesz zmierzyć bezpośredni wpływ decyzji dotyczących renderowania na widoczność w AI, co ułatwia uzasadnienie inwestycji technicznych wobec osób odpowiedzialnych za ruch i konwersje.

Audyt i optymalizacja strategii renderowania pod kątem widoczności w AI wymaga systematycznego, krok po kroku podejścia. Zacznij od identyfikacji stron generujących największą wartość: strony produktowe, cenniki, kluczowa dokumentacja i popularne wpisy na blogu powinny być priorytetowe. Skorzystaj z narzędzi takich jak Screaming Frog (w trybie “Text Only”) lub Chrome DevTools, aby porównać, co widzą boty, a co użytkownicy—jeśli kluczowa treść nie jest obecna w źródle strony, zależy od JavaScriptu i jest niewidoczna dla AI crawlerów. Następnie dobierz strategię renderowania do wymagań świeżości treści: strony statyczne mogą korzystać z SSG, często aktualizowane z SSR lub ISR, a funkcje interaktywne można dobudować przez JavaScript na SSR. Potem przetestuj z rzeczywistymi botami AI, przesyłając swoje strony do ChatGPT, Perplexity i Claude, by sprawdzić, czy mają dostęp do treści. Na koniec monitoruj logi crawlów pod kątem AI user-agentów (GPTBot, ChatGPT-User, OAI-SearchBot), by potwierdzić, że boty skutecznie crawlują pre-renderowane lub SSR-owane strony. Takie iteracyjne podejście zamienia renderowanie ze szczegółu technicznego w mierzalną dźwignię widoczności.

Metryki wydajności z rzeczywistego świata pokazują, jak duże są różnice między podejściami renderowania pod kątem indeksowalności przez AI. Strony SSR i pre-renderowane osiągają First Contentful Paint (FCP) w 0,5-1,5 sekundy, podczas gdy witryny CSR często potrzebują 2-4 sekund lub więcej na pobranie i wykonanie JavaScriptu. Dla AI crawlerów działających w ramach limitów czasu 1-5 sekund ta różnica oznacza pełną widoczność lub całkowitą niewidoczność. Wydajność crawlowania znacząco rośnie przy SSR: pre-renderowana strona e-commerce może być w pełni zindeksowana w kilka godzin, a jej odpowiednik oparty na CSR może potrzebować tygodni, gdy crawlery zmagają się z narzutem JavaScriptu. Równie istotne są poprawy w tempie indeksacji—strony SSR widzą nowe treści zindeksowane w ciągu 24-48 godzin, natomiast CSR często doświadcza opóźnień 7-14 dni. Dla treści wrażliwych na czas, takich jak newsy, premiery produktów czy oferty limitowane, to opóźnienie bezpośrednio oznacza utraconą widoczność w kluczowym momencie wyszukiwań.

Przyszłość SEO jest nierozerwalnie związana z widocznością w wyszukiwarkach AI, dlatego strategia renderowania to kluczowa inwestycja długoterminowa, a nie techniczny szczegół do odhaczenia. Wyszukiwanie zasilane przez AI rośnie wykładniczo—13,14% wszystkich wyników Google uruchamia AI Overviews, a platformy takie jak ChatGPT notują ponad cztery miliardy wizyt miesięcznie, z rosnącą popularnością Perplexity i Claude. W miarę jak systemy AI stają się głównym kanałem odkrywania dla coraz większej liczby użytkowników, decyzje dotyczące renderowania podejmowane dziś będą decydować o Twojej widoczności jutro. Ciągłe monitorowanie jest kluczowe, ponieważ zachowanie AI crawlerów, limity czasu i wsparcie dla JavaScriptu ewoluują wraz z rozwojem tych systemów. Zespoły traktujące renderowanie jako jednorazową migrację często stają się niewidoczne ponownie w ciągu kilku miesięcy, gdy platformy AI zmieniają strategie crawlów. Zamiast tego włącz optymalizację renderowania do kwartalnych planów, sprawdzaj widoczność w AI w testach regresyjnych i korzystaj z narzędzi takich jak AmICited, by śledzić, czy Twoja marka pozostaje widoczna w zmieniającym się krajobrazie AI. Marki wygrywające w AI search to te, które traktują strategię renderowania jako kluczową przewagę konkurencyjną, a nie dług techniczny do odłożenia na później.

AI crawlery takie jak GPTBot i ChatGPT-User działają w ramach ścisłych ograniczeń zasobów i bardzo krótkich limitów czasu (1-5 sekund), ponieważ muszą przetwarzać miliardy stron do trenowania modeli językowych. Wykonywanie JavaScriptu wymaga uruchamiania przeglądarek bezgłowych i oczekiwania na operacje asynchroniczne—na co nie można sobie pozwolić przy tej skali potrzebnej do trenowania LLM. Zamiast tego systemy AI skupiają się na ekstrakcji czystego, statycznego HTML dostępnego od razu.

Renderowanie po stronie serwera dostarcza w pełni wyrenderowany HTML przy pierwszym żądaniu, dzięki czemu cała zawartość jest natychmiast dostępna dla AI crawlerów bez wykonywania JavaScriptu. Zapewnia to, że szczegóły produktów, ceny, recenzje i metadane docierają niezawodnie do systemów AI, zwiększając szansę na cytowanie Twojej marki w odpowiedziach generowanych przez AI oraz pojawienie się w AI Overviews.

Renderowanie po stronie serwera (SSR) renderuje strony na żądanie, gdy nadejdzie zapytanie, podczas gdy pre-rendering generuje statyczne pliki HTML podczas budowania. Pre-rendering najlepiej sprawdza się dla treści, które nie zmieniają się często, a SSR jest lepszy dla treści dynamicznych, które są regularnie aktualizowane. Oba podejścia zapewniają, że AI crawlery otrzymują kompletny HTML bez wykonywania JavaScriptu.

Tak, ale z istotnymi ograniczeniami. Możesz użyć narzędzi do pre-renderingu, by generować statyczne zrzuty HTML swoich stron CSR, lub wdrożyć hybrydowe renderowanie, gdzie kluczowe strony są renderowane po stronie serwera, a mniej istotne pozostają po stronie klienta. Jednak bez tych optymalizacji, strony CSR są w dużej mierze niewidoczne dla AI crawlerów.

Użyj narzędzi takich jak Screaming Frog (tryb tekstowy), Chrome DevTools lub Google Search Console, aby porównać, co widzą boty, a co użytkownicy. Jeśli kluczowa treść jest nieobecna w źródle strony, jest zależna od JavaScriptu i niewidoczna dla AI crawlerów. Możesz też przetestować bezpośrednio w ChatGPT, Perplexity i Claude, aby sprawdzić, czy mają dostęp do Twojej treści.

SSR i strony pre-renderowane zazwyczaj osiągają First Contentful Paint (FCP) w 0,5-1,5 sekundy, podczas gdy strony CSR często potrzebują 2-4+ sekund. Ponieważ AI crawlery działają z limitami czasu 1-5 sekund, szybsze renderowanie przekłada się bezpośrednio na lepszą indeksowalność przez AI. Poprawa Core Web Vitals korzystnie wpływa także na doświadczenia użytkowników i tradycyjne pozycje SEO.

AmICited monitoruje, jak systemy AI cytują Twoją markę w ChatGPT, Perplexity i Google AI Overviews. Śledząc widoczność w AI przed i po wdrożeniu SSR lub pre-renderingu, możesz zmierzyć bezpośredni wpływ decyzji dotyczących renderowania na cytowania marki i obecność w wyszukiwaniu AI.

To zależy od wymagań dotyczących aktualności treści i priorytetów biznesowych. Treści statyczne korzystają z SSG, często aktualizowane z SSR, a funkcje interaktywne można nałożyć poprzez JavaScript na wyrenderowany HTML. Zacznij od identyfikacji stron o największej wartości (produkty, cenniki, dokumentacja) i w pierwszej kolejności wdrażaj dla nich SSR lub pre-rendering.

Monitoruj, jak ChatGPT, Perplexity i Google AI Overviews cytują Twoją markę. Zrozum prawdziwy wpływ swojej strategii renderowania na cytowania w AI.

Kompletny przewodnik po AI crawlerach i botach. Identyfikuj GPTBot, ClaudeBot, Google-Extended oraz 20+ innych AI crawlerów z agentami użytkownika, tempem indek...

Dowiedz się, jak przetestować, czy crawlery AI, takie jak ChatGPT, Claude i Perplexity, mogą uzyskać dostęp do treści Twojej strony internetowej. Poznaj metody ...

Dowiedz się, jak JavaScript wpływa na widoczność stron dla crawlerów AI. Sprawdź, dlaczego boty AI nie potrafią renderować JavaScript, jakie treści są ukrywane ...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.