Jak zidentyfikować intencję wyszukiwania dla optymalizacji AI

Dowiedz się, jak identyfikować i optymalizować intencję wyszukiwania w wyszukiwarkach AI. Poznaj metody klasyfikacji zapytań użytkowników, analizuj AI SERP oraz...

Dowiedz się, jak duże modele językowe interpretują intencję użytkownika poza słowami kluczowymi. Poznaj rozszerzanie zapytań, rozumienie semantyczne oraz jak systemy AI decydują, które treści cytować w odpowiedziach.

Intencja użytkownika w wyszukiwaniu AI odnosi się do ukrytego celu lub powodu stojącego za zapytaniem, a nie tylko do wpisywanych słów kluczowych. Gdy szukasz “najlepsze narzędzia do zarządzania projektami”, możesz chcieć szybkiego porównania, informacji o cenach lub możliwościach integracji — a duże modele językowe (LLM-y) takie jak ChatGPT, Perplexity i Gemini od Google starają się zrozumieć, który z tych celów faktycznie realizujesz. W przeciwieństwie do tradycyjnych wyszukiwarek, które dopasowują słowa kluczowe do stron, LLM-y interpretują znaczenie semantyczne Twojego zapytania, analizując kontekst, sformułowania i powiązane sygnały, by przewidzieć, co tak naprawdę chcesz osiągnąć. To przejście od dopasowania słów kluczowych do rozumienia intencji jest podstawą działania nowoczesnych systemów wyszukiwania AI i bezpośrednio decyduje, które źródła zostaną zacytowane w odpowiedziach generowanych przez AI. Zrozumienie intencji użytkownika stało się kluczowe dla marek zabiegających o widoczność w wynikach wyszukiwania AI, ponieważ narzędzia takie jak AmICited monitorują obecnie, jak systemy AI odnoszą się do Twoich treści na podstawie dopasowania intencji.

Gdy wpisujesz pojedyncze zapytanie do systemu wyszukiwania AI, za kulisami dzieje się coś niezwykłego: model nie odpowiada po prostu bezpośrednio na Twoje pytanie. Zamiast tego rozszerza Twoje zapytanie na dziesiątki powiązanych mikro-pytań — badacze nazywają to “query fan-out”. Na przykład proste wyszukiwanie takie jak “Notion vs Trello” może wywołać podzapytania: “Które jest lepsze do współpracy zespołowej?”, “Jakie są różnice cenowe?”, “Które lepiej integruje się ze Slackiem?” oraz “Które jest łatwiejsze dla początkujących?”. To rozszerzenie pozwala LLM-om zbadać różne aspekty Twojej intencji i zebrać bardziej kompleksowe informacje przed wygenerowaniem odpowiedzi. System ocenia następnie fragmenty z różnych źródeł na bardzo szczegółowym poziomie, a nie całe strony — to oznacza, że pojedynczy akapit z Twoich treści może zostać wybrany, podczas gdy reszta strony zostanie pominięta. Ta analiza na poziomie fragmentów sprawia, że klarowność i precyzja w każdej sekcji są ważniejsze niż kiedykolwiek — dobrze zorganizowana odpowiedź na konkretną podintencję może być powodem, dla którego Twoje treści zostaną włączone do wygenerowanej przez AI odpowiedzi.

| Oryginalne zapytanie | Podintencja 1 | Podintencja 2 | Podintencja 3 | Podintencja 4 |

|---|---|---|---|---|

| “Najlepsze narzędzia do zarządzania projektami” | “Które najlepsze dla zespołów zdalnych?” | “Jakie są ceny?” | “Które integruje się ze Slackiem?” | “Które najłatwiejsze dla początkujących?” |

| “Jak poprawić produktywność” | “Jakie narzędzia pomagają w zarządzaniu czasem?” | “Jakie są sprawdzone metody produktywności?” | “Jak ograniczyć rozpraszacze?” | “Jakie nawyki wzmacniają koncentrację?” |

| “AI search engines explained” | “Czym różnią się od Google?” | “Która wyszukiwarka AI jest najdokładniejsza?” | “Jak radzą sobie z prywatnością?” | “Jaka jest przyszłość wyszukiwania AI?” |

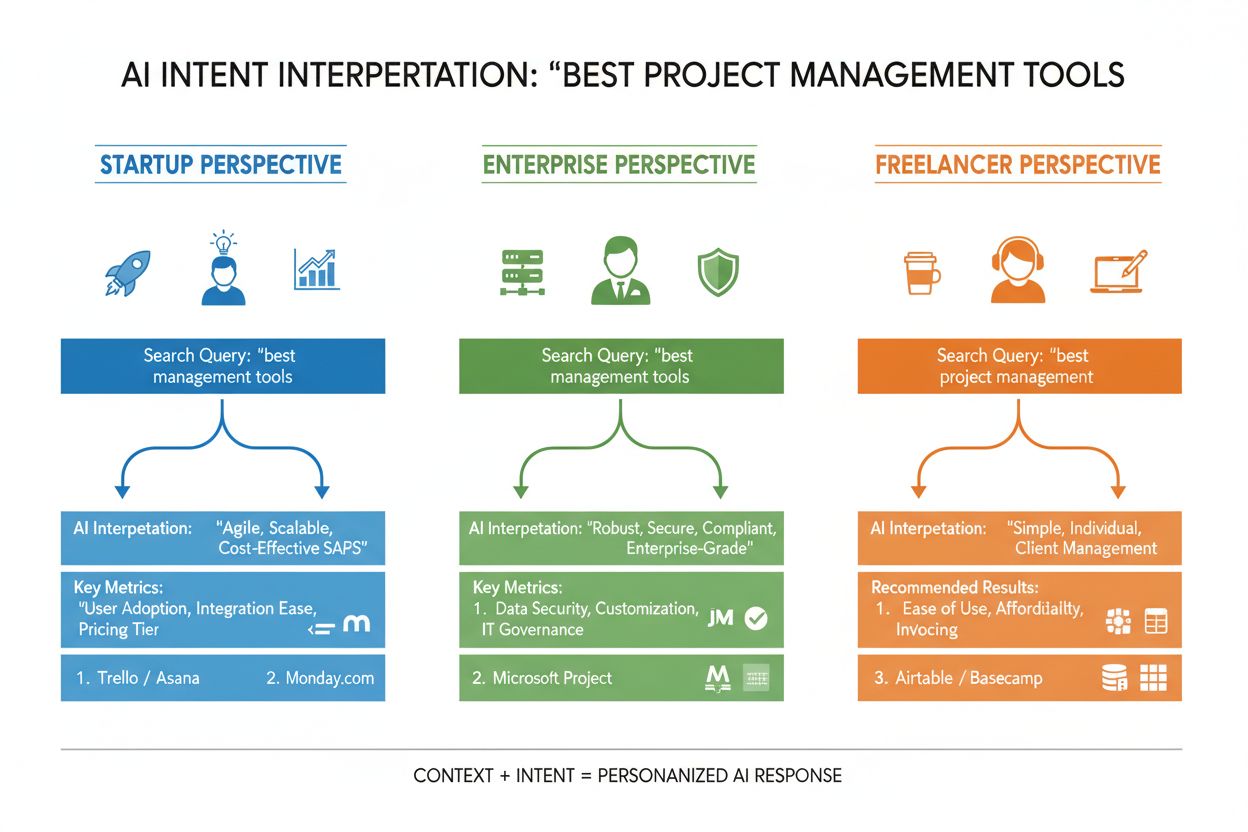

LLM-y nie oceniają Twojego zapytania w oderwaniu — budują to, co badacze nazywają “osadzeniem użytkownika” (user embedding), czyli profil wektorowy, który odzwierciedla ewoluującą intencję na podstawie historii wyszukiwania, lokalizacji, typu urządzenia, pory dnia, a nawet wcześniejszych rozmów. To zrozumienie kontekstu pozwala systemowi na daleko idącą personalizację wyników: dwie osoby szukające “najlepszych narzędzi CRM” mogą otrzymać zupełnie inne rekomendacje, jeśli jedna jest założycielem startupu, a druga menedżerem korporacyjnym. Reranking w czasie rzeczywistym dodatkowo dopasowuje wyniki na podstawie Twoich interakcji — jeśli klikniesz konkretne wyniki, spędzisz czas na czytaniu określonych sekcji lub zadasz pytania uzupełniające, system dostosuje rozumienie Twojej intencji i zaktualizuje przyszłe rekomendacje. Ta pętla sprzężenia zwrotnego sprawia, że systemy AI stale uczą się, czego użytkownicy naprawdę chcą, a nie tylko co wpisali pierwotnie. Dla twórców treści i marketerów to podkreśla, jak ważne jest tworzenie treści odpowiadających na intencje w różnych kontekstach użytkowników i na różnych etapach podejmowania decyzji.

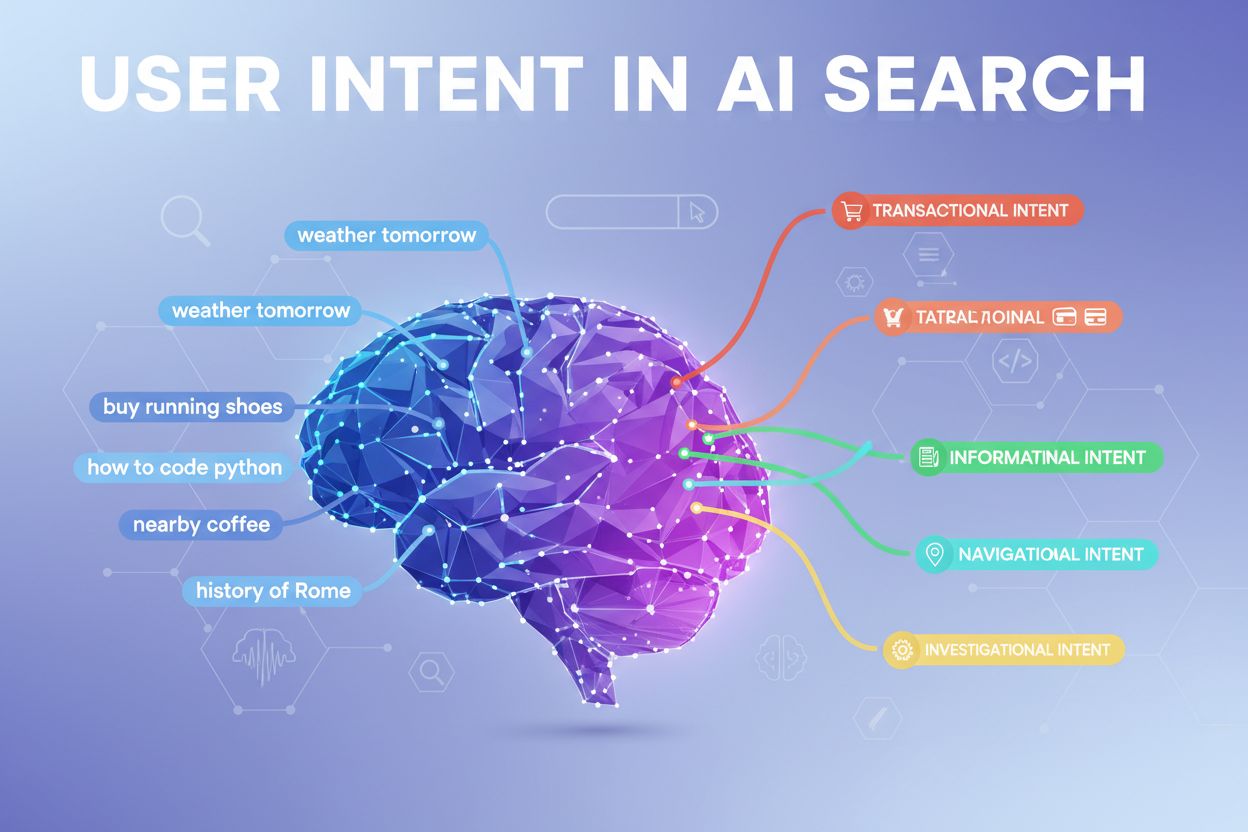

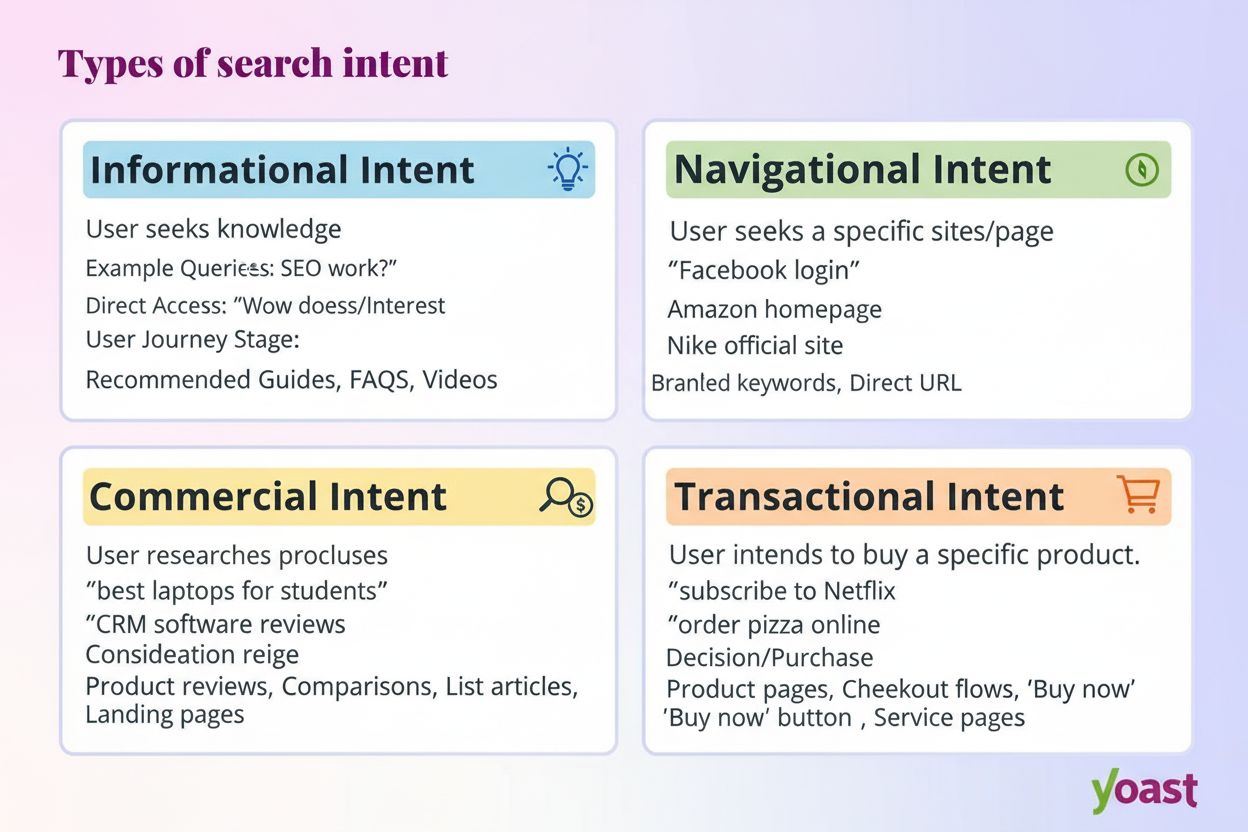

Nowoczesne systemy AI klasyfikują intencje użytkownika na kilka odrębnych kategorii, z których każda wymaga innych treści i odpowiedzi:

LLM-y automatycznie klasyfikują te intencje poprzez analizę struktury zapytania, słów kluczowych i sygnałów kontekstowych, a następnie wybierają treści najlepiej pasujące do wykrytego typu intencji. Znajomość tych kategorii pomaga twórcom treści organizować strony tak, by odpowiadały na konkretne intencje użytkowników.

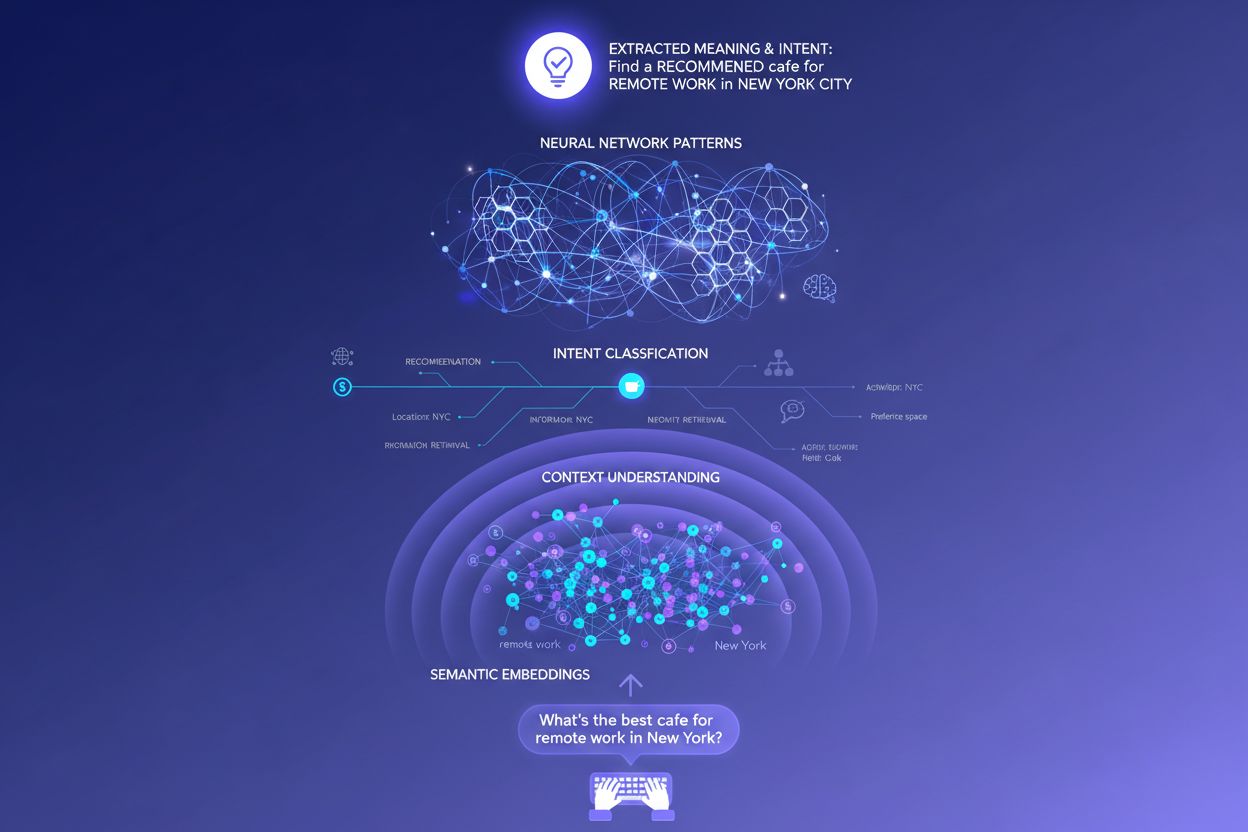

Tradycyjne wyszukiwarki oparte na słowach kluczowych działają poprzez proste dopasowanie ciągów znaków — jeśli Twoja strona zawiera dokładnie te słowa, które ktoś wpisuje, może się wyświetlić. To podejście zupełnie nie radzi sobie z synonimami, parafrazami i kontekstem. Jeśli ktoś szuka “tani program do zarządzania projektami”, a na Twojej stronie jest “platforma do koordynacji zadań przyjazna dla budżetu”, tradycyjne wyszukiwanie może w ogóle nie wychwycić powiązania. Osadzenia semantyczne rozwiązują ten problem, przekształcając słowa i frazy w matematyczne wektory oddające znaczenie, a nie tylko powierzchowny tekst. Te wektory istnieją w wielowymiarowej przestrzeni, gdzie semantycznie podobne pojęcia grupują się razem, co pozwala LLM-om rozpoznać, że “tani”, “przyjazny dla budżetu”, “niedrogi” i “o niskim koszcie” oznaczają tę samą intencję. Takie podejście radzi sobie też znacznie lepiej z długimi lub konwersacyjnymi zapytaniami — pytanie typu “Jestem freelancerem i potrzebuję czegoś prostego, ale mocnego” zostanie dopasowane do odpowiednich treści, nawet jeśli nie zawiera typowych słów kluczowych. W praktyce systemy AI mogą więc prezentować trafne odpowiedzi na niejasne, złożone czy nietypowe zapytania, czyniąc je znacznie bardziej użytecznymi niż ich poprzednicy opierający się na słowach kluczowych.

U technicznych podstaw interpretacji intencji leży architektura transformera — rodzaj sieci neuronowej, która przetwarza język poprzez analizę relacji między słowami przy użyciu mechanizmu zwanego “attention” (uwaga). Zamiast czytać tekst sekwencyjnie jak człowiek, transformatory oceniają, jak każde słowo odnosi się do pozostałych w zapytaniu, co pozwala uchwycić niuanse znaczeniowe i kontekst. Osadzenia semantyczne to numeryczne reprezentacje, które powstają w tym procesie — każde słowo, fraza czy pojęcie zamieniane jest na wektor liczb odzwierciedlający jego znaczenie. Modele takie jak BERT (Bidirectional Encoder Representations from Transformers) i RankBrain wykorzystują te osadzenia, by rozpoznać, że “najlepszy CRM dla startupów” i “topowa platforma do zarządzania relacjami z klientami dla nowych firm” wyrażają podobną intencję, mimo zupełnie innych sformułowań. Mechanizm attention jest szczególnie potężny, ponieważ pozwala modelowi skupić się na najistotniejszych częściach zapytania — w “najlepsze narzędzia do zarządzania projektami dla zespołów zdalnych z ograniczonym budżetem” system nauczy się ważyć “zespoły zdalne” i “ograniczony budżet” jako kluczowe sygnały intencji. Ta zaawansowana technicznie architektura sprawia, że nowoczesne wyszukiwanie AI jest o wiele bardziej inteligentne niż tradycyjne systemy oparte na słowach kluczowych.

Zrozumienie, jak LLM-y interpretują intencję, fundamentalnie zmienia strategię tworzenia treści. Zamiast pisać jeden obszerny poradnik mający zdobyć pozycję na jedno słowo kluczowe, skuteczna treść dziś odpowiada na wiele podintencji w modułowych sekcjach, które mogą funkcjonować samodzielnie. Jeśli piszesz o narzędziach do zarządzania projektami, zamiast jednej wielkiej tabeli porównawczej przygotuj osobne sekcje odpowiadające na “Które najlepsze dla zespołów zdalnych?”, “Które jest najtańsze?” oraz “Które integruje się ze Slackiem?” — każda z tych sekcji staje się potencjalną kartą odpowiedzi, którą LLM-y mogą wyodrębnić i zacytować. Formatowanie gotowe do cytowania ma ogromne znaczenie: używaj faktów zamiast ogólników, podawaj konkretne liczby i daty, a informacje układaj tak, by AI mogło łatwo je zacytować lub podsumować. Wypunktowania, wyraźne nagłówki i krótkie akapity pomagają LLM-om skuteczniej analizować Twoje treści niż gęsty tekst. Narzędzia takie jak AmICited umożliwiają dziś marketerom monitorowanie, jak systemy AI cytują ich treści w ChatGPT, Perplexity i Google AI, ujawniając, które dopasowania intencji działają, a gdzie są luki. To podejście oparte na danych — optymalizacja pod realną interpretację i cytowanie przez AI — to prawdziwa rewolucja w stosunku do tradycyjnego SEO.

Weźmy przykład z e-commerce: gdy ktoś szuka “kurtka wodoodporna do 800 zł”, wyraża jednocześnie kilka intencji — oczekuje informacji o trwałości, potwierdzenia ceny i rekomendacji produktów. System AI może rozszerzyć to na podzapytania o technologie wodoodporności, porównania cen, recenzje marek i informacje o gwarancji. Marka, która w swoich treściach kompleksowo, modułowo i klarownie odpowiada na te zagadnienia, ma znacznie większe szanse na cytowanie przez AI niż konkurent z ogólną stroną produktową. W branży SaaS to samo pytanie “Jak zaprosić zespół do tego workspace?” może pojawić się setki razy w logach wsparcia, sygnalizując istotną lukę w treściach. Asystent AI uczący się na Twojej dokumentacji może mieć trudności z jasną odpowiedzią, co wpłynie na słabsze doświadczenie użytkownika i mniejszą widoczność w AI-generowanych odpowiedziach wsparcia. W kontekście news/informacji zapytanie “Co się dzieje z regulacjami AI?” zostanie zinterpretowane inaczej w zależności od kontekstu użytkownika — decydent potrzebuje szczegółów legislacyjnych, lider biznesu skutków konkurencyjnych, a technolog szczegółów technicznych. Skuteczne treści wyraźnie odpowiadają na te różne konteksty intencji.

Pomimo zaawansowania, LLM-y napotykają realne wyzwania w interpretacji intencji. Niejasne zapytania typu “Java” mogą odnosić się do języka programowania, wyspy lub kawy — nawet z kontekstem system może źle sklasyfikować intencję. Mieszane lub złożone intencje komplikują sprawę: “Czy ten CRM jest lepszy od Salesforce i gdzie mogę go wypróbować za darmo?” łączy porównanie, ocenę i intencję transakcyjną w jednym zapytaniu. Ograniczenia okna kontekstowego sprawiają, że LLM-y mogą uwzględnić tylko określoną ilość historii rozmowy, więc przy dłuższych dialogach wcześniejsze sygnały intencji mogą zostać zapomniane. Halucynacje i błędy merytoryczne wciąż są problemem, zwłaszcza w obszarach wymagających wysokiej precyzji, jak zdrowie, finanse czy prawo. Kwestie prywatności również mają znaczenie — w miarę jak systemy zbierają więcej danych behawioralnych, by poprawić personalizację, muszą równoważyć dokładność rozpoznania intencji z ochroną prywatności użytkownika. Zrozumienie tych ograniczeń pomaga twórcom treści i marketerom realistycznie ocenić możliwości widoczności w wyszukiwaniu AI i pamiętać, że nie każde zapytanie zostanie zinterpretowane idealnie.

Wyszukiwanie oparte na intencji ewoluuje w stronę coraz bardziej zaawansowanego rozumienia i interakcji. Konwersacyjne AI stanie się coraz bardziej naturalne, utrzymując kontekst w dłuższych, złożonych dialogach, gdzie intencja może się zmieniać i rozwijać. Wielomodalne rozpoznawanie intencji połączy tekst, obraz, głos, a nawet wideo, by szerzej interpretować cele użytkownika — wyobraź sobie prośbę do AI: “znajdź mi coś takiego” i pokazujesz zdjęcie. Wyszukiwanie bez zapytania (zero-query search) to nowy trend, w którym systemy AI przewidują potrzeby użytkownika, zanim zostaną one wyrażone, wykorzystując sygnały behawioralne i kontekst do proaktywnego prezentowania informacji. Ulepszona personalizacja sprawi, że wyniki będą coraz lepiej dopasowane do indywidualnych profili, etapów decyzyjnych i sytuacji kontekstowych. Integracja z systemami rekomendacyjnymi zatarze granicę między wyszukiwaniem a odkrywaniem, gdy AI będzie proponować trafne treści, o których użytkownik nawet nie pomyślał. Wraz z rozwojem tych możliwości przewagę zyskają marki i twórcy, którzy głęboko rozumieją intencje i strukturyzują treści tak, by kompleksowo na nie odpowiadać w różnych kontekstach i dla różnych typów użytkowników.

Intencja użytkownika odnosi się do ukrytego celu lub powodu stojącego za zapytaniem, a nie tylko do wpisanych słów kluczowych. LLM-y interpretują znaczenie semantyczne poprzez analizę kontekstu, sformułowania i powiązanych sygnałów, aby przewidzieć, co użytkownik rzeczywiście chce osiągnąć. Dlatego to samo zapytanie może dawać różne wyniki w zależności od kontekstu użytkownika i etapu podejmowania decyzji.

LLM-y wykorzystują proces zwany 'query fan-out', czyli rozbicie pojedynczego zapytania na dziesiątki powiązanych mikro-pytań. Na przykład 'Notion vs Trello' może zostać rozszerzone na podzapytania dotyczące współpracy zespołowej, cen, integracji czy łatwości obsługi. Pozwala to systemom AI badać różne aspekty intencji i zebrać pełniejsze informacje.

Zrozumienie intencji pomaga twórcom treści optymalizować je pod kątem tego, jak systemy AI faktycznie interpretują i cytują ich prace. Treści, które odpowiadają na wiele podintencji w modułowych sekcjach, są bardziej prawdopodobne do wybrania przez LLM-y. Bezpośrednio wpływa to na widoczność w odpowiedziach generowanych przez AI na platformach takich jak ChatGPT, Perplexity i Google AI.

Osadzenia semantyczne przekształcają słowa i frazy w matematyczne wektory, które oddają znaczenie, a nie tylko powierzchowny tekst. Dzięki temu LLM-y rozpoznają, że 'tani', 'przyjazny dla budżetu' i 'niedrogi' wyrażają tę samą intencję, mimo użycia różnych słów. To semantyczne podejście znacznie lepiej radzi sobie z synonimami, parafrazowaniem i kontekstem niż tradycyjne dopasowanie słów kluczowych.

Tak, LLM-y napotykają trudności przy niejednoznacznych zapytaniach, mieszanych intencjach i ograniczeniach kontekstu. Zapytania takie jak 'Java' mogą odnosić się do języka programowania, geografii lub kawy. Długie rozmowy mogą przekroczyć okno kontekstowe, przez co wcześniejsze sygnały intencji zostają zapomniane. Zrozumienie tych ograniczeń pomaga mieć realistyczne oczekiwania co do widoczności w wyszukiwaniu AI.

Marki powinny tworzyć modułowe treści, które odpowiadają na wiele podintencji w odrębnych sekcjach. Stosuj formatowanie gotowe do cytowań, z faktami, konkretnymi liczbami i jasną strukturą. Monitoruj, jak systemy AI odnoszą się do Twoich treści za pomocą narzędzi takich jak AmICited, by zidentyfikować luki w dopasowaniu intencji i odpowiednio optymalizować.

Intencja jest nastawiona na zadanie — co użytkownik chce osiągnąć teraz. Zainteresowanie to szersza, ogólna ciekawość. Systemy AI priorytetyzują intencję, ponieważ bezpośrednio decyduje ona, które treści zostaną wybrane do odpowiedzi. Użytkownik może ogólnie interesować się narzędziami produktywności, ale jego intencją może być znalezienie czegoś konkretnie do współpracy zdalnego zespołu.

Systemy AI cytują źródła najlepiej dopasowane do wykrytej intencji. Jeśli Twoje treści wyraźnie odpowiadają na konkretną podintencję, z dobrze ustrukturyzowanymi, rzeczowymi informacjami, ich wybór jest bardziej prawdopodobny. Narzędzia takie jak AmICited śledzą te wzorce cytowań, pokazując, które dopasowania intencji zwiększają widoczność w odpowiedziach generowanych przez AI.

Dowiedz się, jak LLM-y odnoszą się do Twoich treści w ChatGPT, Perplexity i Google AI. Śledź dopasowanie intencji i optymalizuj widoczność w AI dzięki AmICited.

Dowiedz się, jak identyfikować i optymalizować intencję wyszukiwania w wyszukiwarkach AI. Poznaj metody klasyfikacji zapytań użytkowników, analizuj AI SERP oraz...

Intencja wyszukiwania to cel stojący za zapytaniem użytkownika. Poznaj cztery typy intencji, sposoby ich identyfikacji oraz optymalizację treści dla lepszych po...

Poznaj kategorie intencji wyszukiwania AI oraz sposób, w jaki generatywne silniki, takie jak ChatGPT, Perplexity i Google AI, interpretują cele użytkowników. Do...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.