Różnicowany dostęp dla crawlerów

Dowiedz się, jak selektywnie zezwalać lub blokować crawlery AI w oparciu o cele biznesowe. Wdrażaj różnicowany dostęp crawlerów, by chronić treści i zachować wi...

Dowiedz się, jak zapory Web Application Firewall pozwalają na zaawansowaną kontrolę nad botami AI wychodząc poza robots.txt. Wdrażaj zasady WAF, by chronić swoją treść przed nieautoryzowanym scrapingiem AI i monitoruj cytowania AI za pomocą AmICited.

Niewystarczalność robots.txt jako samodzielnego mechanizmu ochrony staje się coraz bardziej widoczna w erze konsumpcji treści napędzanej przez AI. Podczas gdy tradycyjne wyszukiwarki zazwyczaj przestrzegają wytycznych robots.txt, współczesne boty AI działają według zupełnie innych motywacji i mechanizmów egzekwowania, przez co proste polityki tekstowe nie wystarczają do ochrony treści. Według analizy Cloudflare, boty AI stanowią już niemal 80% całego ruchu botów na stronach internetowych, a boty treningowe konsumują ogromne ilości treści, zwracając jednocześnie minimalny ruch polecający — boty OpenAI mają stosunek crawl do referral 400:1, a Anthropic nawet 38 000:1. Dla wydawców i właścicieli treści ta asymetria stanowi poważne zagrożenie biznesowe, ponieważ modele AI szkolone na ich treści mogą bezpośrednio ograniczać ruch organiczny i obniżać wartość ich własności intelektualnej.

Web Application Firewall (WAF) działa jako odwrotny proxy umieszczony między użytkownikami a serwerami WWW, analizując każde żądanie HTTP w czasie rzeczywistym i filtrując niepożądany ruch na podstawie konfigurowalnych zasad. W przeciwieństwie do robots.txt, który opiera się na dobrowolności botów, WAF-y egzekwują ochronę na poziomie infrastruktury, czyniąc je znacznie skuteczniejszymi do kontroli dostępu botów AI. Poniższe porównanie ilustruje różnice między WAF a tradycyjnymi podejściami do bezpieczeństwa:

| Funkcja | Robots.txt | Tradycyjny firewall | Nowoczesny WAF |

|---|---|---|---|

| Poziom egzekwowania | Doradczy/dobrowolny | Blokowanie po IP | Inspekcja świadoma aplikacji |

| Wykrywanie botów AI | Tylko po user-agencie | Ograniczone rozpoznawanie botów | Analiza behawioralna + fingerprinting |

| Adaptacja w czasie rzeczywistym | Plik statyczny | Wymaga ręcznych aktualizacji | Ciągłe informacje o zagrożeniach |

| Granularność kontroli | Tylko poziom ścieżki | Szerokie zakresy IP | Zasady na poziomie żądania |

| Uczenie maszynowe | Brak | Brak | Zaawansowana klasyfikacja botów |

WAF-y oferują szczegółową klasyfikację botów z wykorzystaniem fingerprintingu urządzeń, analizy behawioralnej i uczenia maszynowego do profilowania botów według intencji i zaawansowania, co pozwala na znacznie bardziej precyzyjną kontrolę niż proste reguły zezwól/zablokuj.

Boty AI dzielą się na trzy główne kategorie, z których każda stanowi inne zagrożenia i wymaga odmiennych strategii ochronnych. Boty treningowe jak GPTBot, ClaudeBot czy Google-Extended systematycznie zbierają treści z sieci na potrzeby budowy zbiorów danych dla dużych modeli językowych, odpowiadając za ok. 80% całego ruchu botów AI i nie przynosząc wydawcom żadnej wartości referral. Boty wyszukiwarkowe i cytujące takie jak OAI-SearchBot i PerplexityBot indeksują treści do AI-wspieranych wyszukiwarek i mogą generować pewien ruch polecający poprzez cytowania, choć jest on znacznie mniejszy niż przy tradycyjnych wyszukiwarkach. Pobieracze na żądanie użytkownika aktywują się tylko, gdy użytkownik poprosi asystenta AI o konkretną treść, działając na bardzo małą skalę i nie wykazując systematycznych wzorców crawl. Zagrożenia obejmują:

Nowoczesne WAF-y stosują zaawansowane techniki wykrywania technicznego, wykraczające daleko poza proste dopasowanie user-agenta, by z wysoką dokładnością identyfikować i klasyfikować boty AI. Systemy te wykorzystują analizę behawioralną do badania wzorców żądań, obejmujących szybkość crawl, sekwencjonowanie żądań i sposób obsługi odpowiedzi, co odróżnia boty od ludzi. Fingerprinting urządzenia analizuje nagłówki HTTP, sygnatury TLS i cechy przeglądarki, by wykryć podszywanie się pod znane boty. Modele uczenia maszynowego trenowane na milionach żądań pozwalają wykrywać nowe sygnatury botów i nietypowe taktyki w czasie rzeczywistym, adaptując się do zagrożeń bez potrzeby ręcznych aktualizacji reguł. Dodatkowo WAF-y mogą weryfikować legalność botów poprzez sprawdzanie adresów IP żądań z oficjalnymi zakresami IP publikowanymi przez główne firmy AI — OpenAI publikuje zweryfikowane IP pod https://openai.com/gptbot.json, Amazon pod https://developer.amazon.com/amazonbot/ip-addresses/ — zapewniając, że tylko autoryzowane boty mają dostęp.

Skuteczne wdrożenie zasad WAF dla botów AI wymaga wielowarstwowego podejścia łączącego blokowanie po user-agencie, weryfikację IP i polityki behawioralne. Przykład podstawowej konfiguracji WAF blokującej znane boty treningowe przy jednoczesnym umożliwieniu legalnego wyszukiwania:

# Zasada WAF: Blokuj boty treningowe AI

Nazwa reguły: Block-AI-Training-Crawlers

Warunek 1: HTTP User-Agent pasuje do (GPTBot|ClaudeBot|anthropic-ai|Google-Extended|Meta-ExternalAgent|Amazonbot|CCBot|Bytespider)

Działanie: Blokuj (zwróć 403 Forbidden)

# Zasada WAF: Zezwól zweryfikowanym botom wyszukiwarkowym

Nazwa reguły: Allow-Verified-Search-Crawlers

Warunek 1: HTTP User-Agent pasuje do (OAI-SearchBot|PerplexityBot)

Warunek 2: Adres IP źródła w zweryfikowanym zakresie IP

Działanie: Zezwól

# Zasada WAF: Ogranicz ruch podejrzanych botów

Nazwa reguły: Rate-Limit-Suspicious-Bots

Warunek 1: Częstotliwość żądań przekracza 100 żądań/minutę

Warunek 2: User-Agent zawiera wskaźniki bota

Warunek 3: Brak dopasowania do zweryfikowanego IP

Działanie: Wyzwanie (CAPTCHA) lub Blokuj

Organizacje powinny starannie ustalać priorytety reguł, zapewniając, że bardziej szczegółowe reguły (np. weryfikacja IP dla legalnych botów) są wykonywane przed szerokimi regułami blokującymi. Regularne testowanie i monitorowanie skuteczności reguł jest kluczowe, gdyż user-agenty i zakresy IP botów często się zmieniają. Wielu dostawców WAF oferuje gotowe zestawy reguł dedykowane do zarządzania botami AI, co upraszcza wdrożenie i zapewnia kompleksową ochronę.

Weryfikacja i allowlisting IP to najpewniejsza metoda odróżnienia legalnych botów AI od prób podszywania się, ponieważ user-agent łatwo podrobić, a IP już znacznie trudniej w skali masowej. Główne firmy AI publikują oficjalne zakresy IP w formacie JSON, umożliwiając automatyczną weryfikację bez ręcznego zarządzania — OpenAI udostępnia osobne listy IP dla GPTBot, OAI-SearchBot i ChatGPT-User, a Amazon prowadzi zbiorczy rejestr dla Amazonbota. Zasady WAF mogą być tak skonfigurowane, by allowlistować wyłącznie żądania z tych zweryfikowanych adresów IP, skutecznie uniemożliwiając złym aktorom obchodzenie ograniczeń przez zmianę user-agenta. Dla organizacji stosujących blokowanie na poziomie serwera przez .htaccess czy firewall, połączenie weryfikacji IP z dopasowaniem user-agenta daje ochronę warstwową, niezależną od konfiguracji WAF. Dodatkowo niektóre boty respektują meta tagi HTML takie jak <meta name="robots" content="noarchive">, sygnalizując compliant botom, by nie wykorzystywały treści do treningu modeli — to dodatkowy mechanizm dla wydawców chcących chronić wybrane strony.

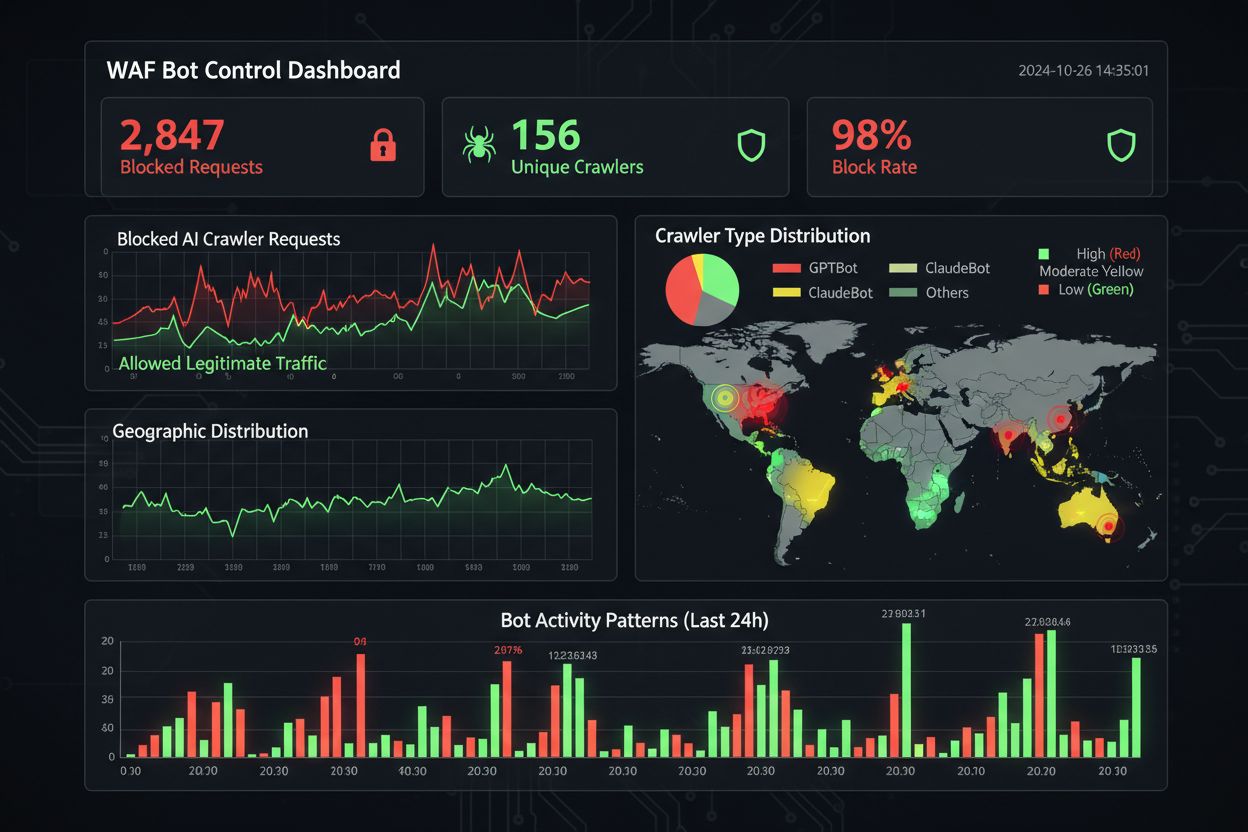

Skuteczne monitorowanie i zapewnienie zgodności wymaga ciągłej widoczności ruchu botów i weryfikacji, czy reguły blokujące działają prawidłowo. Organizacje powinny regularnie analizować logi dostępu serwera, by sprawdzić, które boty odwiedzają ich witryny i czy zablokowane boty nadal próbują uzyskać dostęp — logi Apache to zwykle /var/log/apache2/access.log, a Nginx /var/log/nginx/access.log. Filtrowanie przez grep pozwala szybko wykryć podejrzane wzorce. Platformy analityczne coraz lepiej rozróżniają ruch botów od ludzi, umożliwiając ocenę wpływu blokad na wskaźniki jak współczynnik odrzuceń, konwersje czy SEO. Narzędzia typu Cloudflare Radar zapewniają globalny wgląd w ruch botów AI i wykrywają nowe boty nieujęte jeszcze na Twojej czarnej liście. Z punktu widzenia zgodności, logi WAF generują ścieżki audytu potwierdzające wdrożenie odpowiednich środków ochrony danych i własności intelektualnej, co ma coraz większe znaczenie dla RODO, CCPA i innych regulacji. Przeglądy czarnej listy botów powinny być kwartalne, bo regularnie pojawiają się nowe boty AI i zmieniają user-agenty — społecznościowy projekt ai.robots.txt na GitHub

to cenne źródło informacji o nowych zagrożeniach.

Odpowiednie zrównoważenie ochrony treści z celami biznesowymi wymaga analizy, które boty warto blokować, a które dopuścić, gdyż zbyt agresywna blokada może ograniczyć widoczność w nowych kanałach odkrywania przez AI. Blokowanie botów treningowych, takich jak GPTBot i ClaudeBot, chroni własność intelektualną, ale nie wpływa bezpośrednio na ruch, ponieważ te boty nie generują referral. Jednak blokowanie botów wyszukiwarkowych, takich jak OAI-SearchBot i PerplexityBot, może zmniejszyć widoczność w wynikach wyszukiwania AI, gdzie użytkownicy aktywnie szukają cytowań — to kompromis zależny od strategii treści i profilu odbiorców. Niektórzy wydawcy testują alternatywy, np. zezwalają na boty wyszukiwarkowe, blokując tylko treningowe, lub wdrażają modele płatności za crawl, gdzie firmy AI płacą za dostęp do treści. Narzędzia typu AmICited.com pomagają wydawcom śledzić cytowania ich treści przez AI, co pozwala podejmować decyzje o blokowaniu na podstawie danych. Optymalna konfiguracja WAF zależy od modelu biznesowego: wydawcy newsów mogą priorytetyzować blokowanie botów treningowych przy dopuszczaniu wyszukiwarkowych, a firmy SaaS mogą blokować wszystkie boty AI, by chronić cenniki i funkcje przed konkurencją. Regularne monitorowanie ruchu i przychodów po wdrożeniu zasad WAF pomaga weryfikować, czy strategia ochrony odpowiada rzeczywistym efektom biznesowym.

Przy porównywaniu rozwiązań WAF do zarządzania botami AI, organizacje powinny ocenić kilka kluczowych możliwości odróżniających platformy klasy enterprise od podstawowych. Cloudflare AI Crawl Control integruje się z WAF, oferując gotowe reguły dla znanych botów AI, z możliwością blokowania, dopuszczania lub wdrażania płatności za crawl dla wybranych botów — kolejność reguł gwarantuje, że zasady WAF są realizowane przed innymi warstwami bezpieczeństwa. AWS WAF Bot Control oferuje poziomy ochrony: podstawowy i ukierunkowany, ten drugi wykorzystuje przesłuchiwanie przeglądarki, fingerprinting i heurystyki behawioralne do wykrywania zaawansowanych botów, które nie ujawniają się po user-agencie, opcjonalnie z analizą opartą na uczeniu maszynowym. Azure WAF oferuje podobne możliwości przez zarządzane zestawy reguł, choć z mniejszą specjalizacją pod kątem AI niż Cloudflare czy AWS. Poza tym specjalistyczne rozwiązania do zarządzania botami jak DataDome dostarczają zaawansowane modele uczenia maszynowego trenowane specjalnie na zachowaniach botów AI, ale są droższe. Wybór zależy od obecnej infrastruktury, budżetu i oczekiwanego poziomu zaawansowania — organizacje korzystające już z Cloudflare mają łatwą integrację, a klienci AWS mogą uruchomić Bot Control w ramach bieżącej infrastruktury WAF.

Najlepsze praktyki zarządzania botami AI podkreślają podejście warstwowe, łączące wiele mechanizmów kontroli zamiast polegania na pojedynczym rozwiązaniu. Organizacje powinny przeglądać czarne listy kwartalnie, by wyłapać nowe boty i aktualizacje user-agentów, utrzymywać analizę logów serwera, by weryfikować, czy blokady nie są obchodzone, oraz regularnie testować konfigurację WAF, by reguły działały w odpowiedniej kolejności. Przyszłość technologii WAF to coraz większa integracja AI do wykrywania zagrożeń w czasie rzeczywistym i adaptacja do nowych taktyk botów, a także połączenie z większymi ekosystemami bezpieczeństwa dla ochrony kontekstowej. Wraz ze wzrostem wymogów prawnych dotyczących scrapowania danych i źródeł dla AI, WAF-y staną się kluczowym narzędziem zgodności, a nie tylko opcjonalną warstwą bezpieczeństwa. Warto wdrażać kompleksowe zasady WAF dla botów AI już dziś, zanim rozpowszechnią się nowe zagrożenia jak boty AI oparte na przeglądarkach czy headless, bo koszt zaniechania — utracony ruch, zafałszowane statystyki i ryzyko prawne — jest dużo wyższy niż inwestycja w solidną infrastrukturę ochronną.

Robots.txt to plik doradczy, który opiera się na dobrowolnym przestrzeganiu przez boty Twoich wytycznych, podczas gdy zasady WAF są wymuszane na poziomie infrastruktury i dotyczą wszystkich żądań niezależnie od zgodności bota. WAF-y zapewniają wykrywanie i blokowanie w czasie rzeczywistym, podczas gdy robots.txt jest statyczny i łatwy do obejścia przez nieprzestrzegające boty.

Tak, wiele botów AI ignoruje wytyczne z robots.txt, ponieważ są zaprojektowane do maksymalizacji zbierania danych treningowych. Dobrze zachowujące się boty największych firm zazwyczaj respektują robots.txt, ale źli aktorzy i niektóre nowe boty już nie. Dlatego zasady WAF zapewniają bardziej niezawodną ochronę.

Sprawdź logi dostępu serwera (zwykle w /var/log/apache2/access.log lub /var/log/nginx/access.log) pod kątem identyfikatorów user-agent zawierających oznaczenia botów. Narzędzia takie jak Cloudflare Radar dają globalny wgląd w ruch botów AI, a platformy analityczne coraz częściej rozróżniają ruch botów od wizyt ludzi.

Blokowanie botów treningowych, takich jak GPTBot, nie ma bezpośredniego wpływu na SEO, ponieważ nie przynoszą ruchu polecającego. Jednak blokowanie botów wyszukiwarkowych, takich jak OAI-SearchBot, może zmniejszyć widoczność w wynikach wyszukiwania opartych na AI. Google AI Overviews przestrzega standardowych zasad Googlebota, więc blokowanie Google-Extended nie wpływa na zwykłe indeksowanie wyszukiwarek.

Cloudflare AI Crawl Control, AWS WAF Bot Control i Azure WAF to skuteczne rozwiązania. Cloudflare oferuje najwięcej funkcji AI z gotowymi zasadami i opcją płatności za crawl. AWS zapewnia zaawansowane wykrywanie z użyciem uczenia maszynowego, a Azure dostarcza solidne, zarządzane zestawy reguł. Wybierz na podstawie swojej infrastruktury i budżetu.

Przeglądaj i aktualizuj zasady WAF przynajmniej raz na kwartał, ponieważ regularnie pojawiają się nowe boty AI i istniejące aktualizują swoje user-agenty. Monitoruj projekt ai.robots.txt na GitHubie w poszukiwaniu nowych zagrożeń i sprawdzaj logi serwera co miesiąc, by wykryć nowe boty odwiedzające Twoją witrynę.

Tak, to częsta strategia. Możesz skonfigurować zasady WAF tak, by blokowały boty treningowe, takie jak GPTBot czy ClaudeBot, a pozwalały na boty wyszukiwarkowe jak OAI-SearchBot i PerplexityBot. Chroni to Twoje treści przed wykorzystaniem do treningu modeli, a jednocześnie utrzymuje widoczność w wynikach wyszukiwania AI.

Ceny WAF różnią się w zależności od dostawcy. Cloudflare oferuje WAF od 20 USD/mies. z funkcjami AI Crawl Control. AWS WAF pobiera opłaty za web ACL i regułę — zwykle 5-10 USD/mies. za podstawową ochronę. Azure WAF jest wliczony w cenę Application Gateway. Koszty wdrożenia są minimalne w porównaniu z wartością ochrony treści i zachowaniem dokładnych statystyk.

AmICited śledzi aktywność botów AI i monitoruje, jak Twoje treści są cytowane w ChatGPT, Perplexity, Google AI Overviews i innych platformach AI. Zyskaj wgląd w swoją obecność w AI i dowiedz się, które boty mają dostęp do Twoich treści.

Dowiedz się, jak selektywnie zezwalać lub blokować crawlery AI w oparciu o cele biznesowe. Wdrażaj różnicowany dostęp crawlerów, by chronić treści i zachować wi...

Dowiedz się, jak skonfigurować robots.txt dla robotów AI, w tym GPTBot, ClaudeBot i PerplexityBot. Poznaj kategorie robotów AI, strategie blokowania oraz najlep...

Dowiedz się, jak przeprowadzić audyt dostępu AI crawlerów do swojej strony. Odkryj, które boty widzą Twoje treści i napraw blokady ograniczające widoczność w Ch...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.