Perfekcyjne podsumowanie. Dodam na koniec:

To jest przyszłość strategii treści.

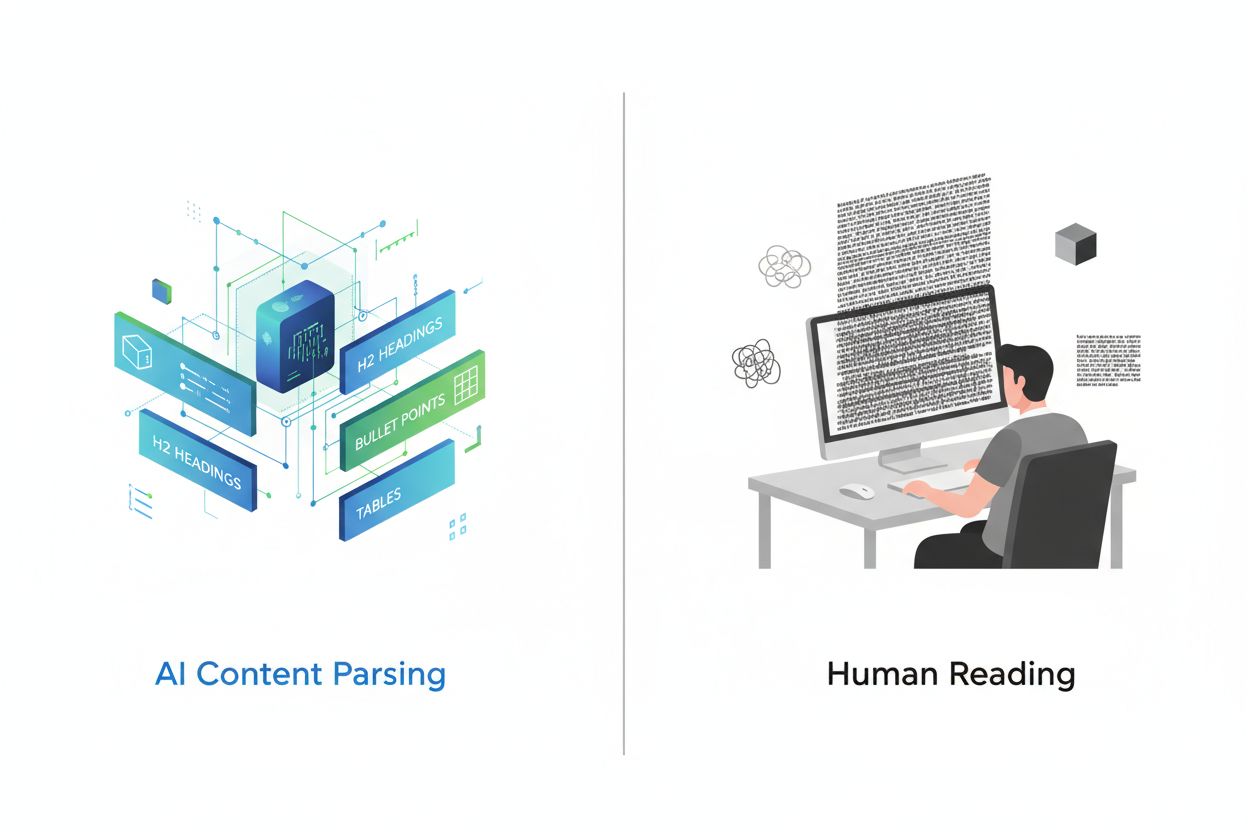

Przechodzimy ze świata, gdzie treści żyją na stronach przeglądanych przez ludzi, do świata, gdzie funkcjonują w strukturach wiedzy pobieranych przez AI na rzecz człowieka.

Organizacje, które już teraz zbudują solidne architektury wiedzy, zdominują AI-mediowane odkrywanie treści. Ci, którzy to zignorują, znikną, gdy AI stanie się głównym interfejsem odkrywania treści.

To nie przesada – to logiczny finał obecnych trendów.

Dzięki wszystkim za inspiracje. Dużo z tego wdrożymy w naszej przebudowie bazy wiedzy.