Pozyskiwanie oparte na embeddingach:

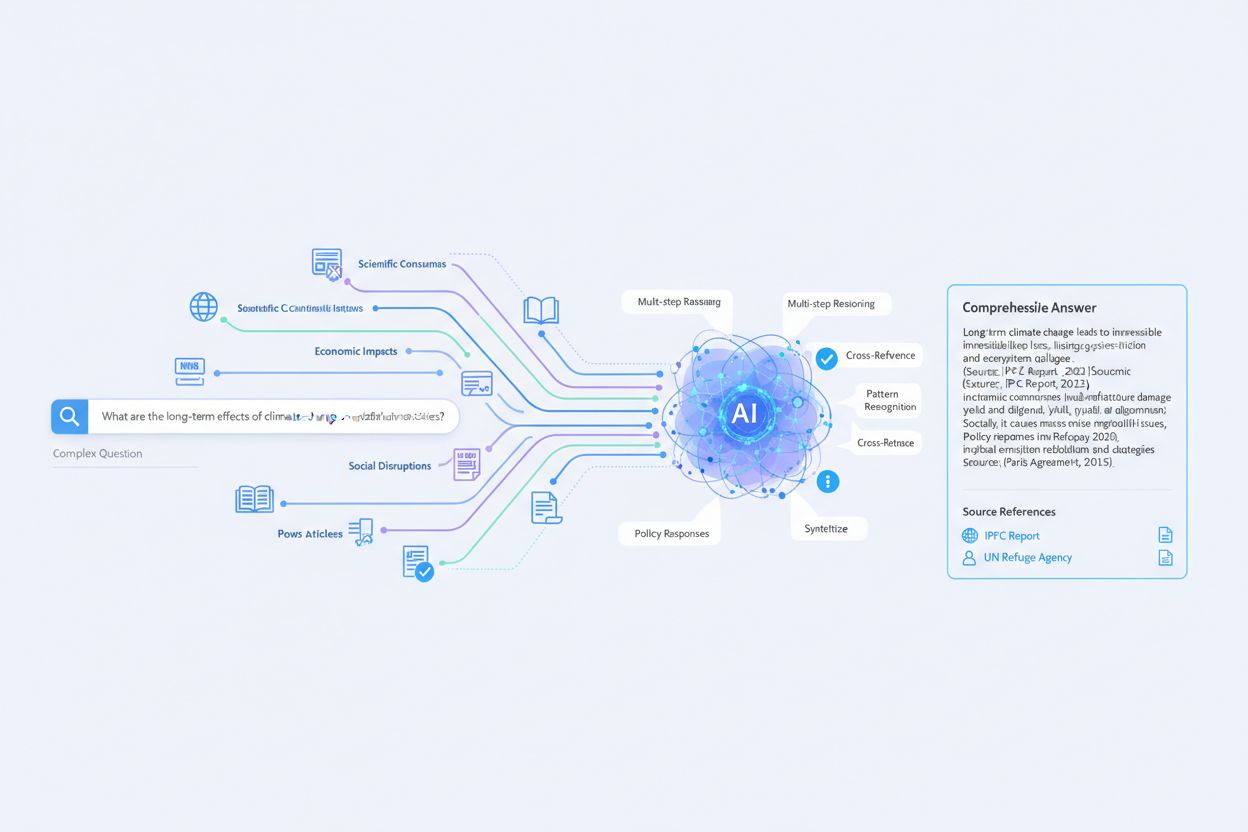

Tak, dokładnie. Proces wygląda tak:

- Zapytanie zamieniane na embedding (wektor liczbowy)

- Wektor porównywany z embeddingami dokumentów

- Wyszukiwanie po podobieństwie zwraca najlepsze dopasowania

- Wyniki mogą nie zawierać dokładnych słów z zapytania

Przetwarzanie wielu źródeł:

Perplexity przetwarza źródła równolegle, nie sekwencyjnie:

Pobrane dokumenty (5-10 źródeł)

↓

Równoległa ekstrakcja istotnych fragmentów

↓

Ranking fragmentów według trafności

↓

Połączony kontekst + zapytanie → LLM

↓

Zsyntezowana odpowiedź z cytowaniami inline

Mechanizm cytowania:

Podczas generowania każdego twierdzenia LLM zachowuje atrybucję źródła. Dlatego cytaty pojawiają się inline – model śledzi, które źródło wspiera którą wypowiedź.

Rozwiązywanie konfliktów:

Kiedy źródła się różnią, Perplexity często:

- Przedstawia różne perspektywy

- Wskazuje na rozbieżności

- Waży według wiarygodności źródeł