Gęstość słów kluczowych

Gęstość słów kluczowych mierzy, jak często słowo kluczowe pojawia się w treści w stosunku do całkowitej liczby słów. Poznaj optymalne wartości procentowe, najle...

Odkryj, dlaczego gęstość słów kluczowych nie ma już znaczenia w wyszukiwaniu AI. Dowiedz się, co ChatGPT, Perplexity i Google AI Overviews naprawdę biorą pod uwagę przy ocenie treści i cytowaniu.

Gęstość słów kluczowych ma minimalny wpływ na systemy AI i nowoczesne wyszukiwarki. Badania pokazują, że strony na najwyższych pozycjach mają średnio tylko 0,04% gęstości słów kluczowych, podczas gdy modele AI priorytetowo traktują znaczenie semantyczne, autorytet tematyczny i głębię treści zamiast częstotliwości słów kluczowych. Skup się na naturalnym języku i kompleksowym pokryciu tematu.

Gęstość słów kluczowych odnosi się do procentowego udziału danego słowa kluczowego w treści strony internetowej w stosunku do całkowitej liczby słów. Historycznie, ten wskaźnik był kluczowy dla strategii SEO — im częściej pojawiało się słowo kluczowe, tym bardziej strona wydawała się istotna dla danego zapytania. Jednak wraz z rozwojem sztucznej inteligencji, dużych modeli językowych (LLM) i wyszukiwania semantycznego nastąpiła fundamentalna zmiana. Dziś gęstość słów kluczowych nie jest już głównym czynnikiem rankingowym dla Google, ChatGPT, Perplexity, Google AI Overviews czy Claude. Zamiast tego, te systemy oceniają treść na podstawie znaczenia semantycznego, autorytetu tematycznego, relacji między encjami oraz intencji użytkownika. Zrozumienie tej zmiany jest kluczowe dla każdego, kto tworzy treści mające się dobrze pozycjonować zarówno w tradycyjnych wynikach wyszukiwania, jak i być cytowane przez systemy AI. Przejście od optymalizacji skoncentrowanej na słowach kluczowych do optymalizacji skoncentrowanej na znaczeniu to jedna z najważniejszych zmian w strategii treści cyfrowych w ostatniej dekadzie.

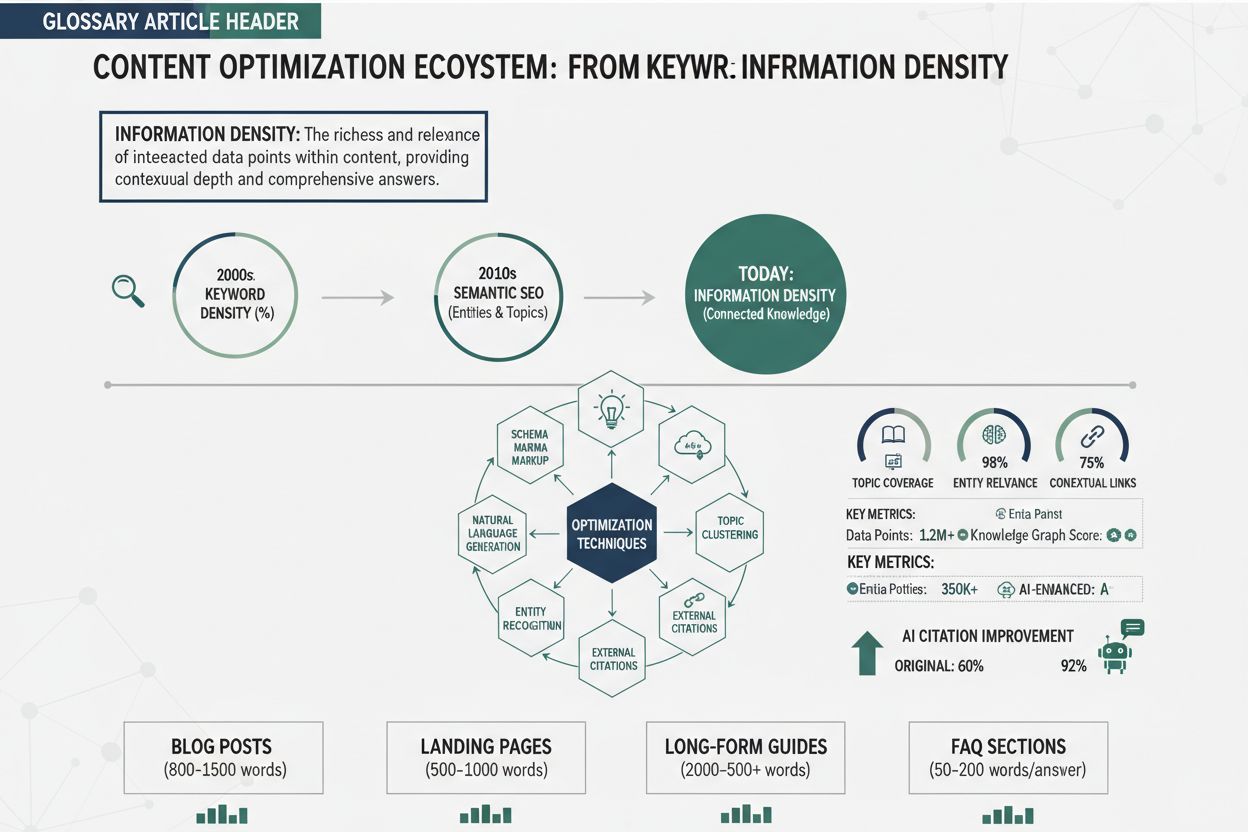

Historia pozycjonowania wyszukiwarek pokazuje, dlaczego gęstość słów kluczowych stała się nieaktualna. Na początku lat 2000 wyszukiwarki takie jak Google silnie polegały na częstotliwości słów kluczowych i linkach zwrotnych jako głównych sygnałach rankingowych. Skutkowało to powszechnym upychanie słów kluczowych — praktyką nienaturalnego przeładowywania treści słowami kluczowymi w celu manipulowania pozycją. Strony powtarzały frazy w sposób niezręczny, kosztem czytelności i doświadczenia użytkownika. Były szef ds. webspam w Google, Matt Cutts, słynnie stwierdził, że powtarzanie słów kluczowych przynosi “malejące korzyści”, sygnalizując odejście firmy od tego wskaźnika. W 2013 roku Google wprowadził Hummingbird — aktualizację algorytmu, która priorytetowo traktowała intencję wyszukiwania zamiast dokładnego dopasowania słów kluczowych. Następnie pojawiły się RankBrain (2015), BERT (2018) i MUM (2021) — każda z tych innowacji pozwalała Google lepiej rozumieć kontekst, semantykę i relacje między pojęciami. Nowoczesne systemy AI analizują dziś znaczenie słów, a nie ich częstotliwość. Badanie z 2025 roku, analizujące 1536 wyników wyszukiwania Google, nie wykazało żadnej spójnej korelacji między gęstością słów kluczowych a pozycją w rankingu, przy czym wyniki w top 10 miały średnio tylko 0,04% gęstości słów kluczowych w porównaniu do 0,07-0,08% na niższych pozycjach. Dane te jednoznacznie pokazują, że niższa gęstość słów kluczowych jest faktycznie związana z lepszymi pozycjami.

| Aspekt | Gęstość słów kluczowych | Głębia semantyczna | Autorytet tematyczny |

|---|---|---|---|

| Definicja | Procentowy udział słowa kluczowego w treści | Stopień, w jakim treść kompleksowo omawia temat i jego podtematy | Zakres ekspertyzy wykazany w danym obszarze tematycznym |

| Jak jest mierzony | (Częstotliwość słowa kluczowego / liczba słów) × 100 | Pokrycie encji, mapowanie relacji, klastrowanie treści | Ilość i jakość powiązanych treści w domenie |

| Znaczenie dla AI | Minimalne lub żadne | Kluczowe dla cytowania i rankingu AI | Niezbędne dla zaufania systemów AI |

| Zalecany zakres | 0,5-2% (brak ścisłych reguł) | Głębokie, powiązane klastry treści | Wiele kompleksowych artykułów na dany temat |

| Wpływ na ranking | Znikomy; może zaszkodzić przy nadmiarze | Bezpośredni pozytywny wpływ na widoczność | Silny pozytywny wpływ na cytowania AI |

| Doświadczenie użytkownika | Może pogorszyć czytelność, jeśli wymuszona | Poprawia satysfakcję i zaangażowanie użytkownika | Buduje długofalowy autorytet i zaufanie |

| Preferencje systemów AI | Ignorowane lub karane | Wysoko cenione przy cytowaniach | Priorytetowe przy wyborze źródeł |

To porównanie pokazuje, dlaczego twórcy treści powinni zasadniczo zmienić strategię optymalizacji. Gęstość słów kluczowych to mechaniczny wskaźnik, który nie odzwierciedla sposobu oceny treści przez nowoczesne systemy AI. Głębia semantyczna i autorytet tematyczny natomiast bezpośrednio wpływają na to, czy systemy takie jak ChatGPT, Perplexity i Google AI Overviews zacytują Twoje treści jako zaufane źródło.

Duże modele językowe i wyszukiwarki AI wykorzystują zaawansowane sieci neuronowe do rozumienia znaczenia treści, a nie liczenia słów kluczowych. Google BERT (Bidirectional Encoder Representations from Transformers) potrafi zrozumieć kontekst słów w odniesieniu do wszystkich innych w zdaniu, a nie tylko ich pozycję czy częstotliwość. MUM (Multitask Unified Model) idzie jeszcze dalej, rozumiejąc informacje w wielu językach i formatach jednocześnie. Systemy te mapują treści do grafów wiedzy — uporządkowanych reprezentacji encji, ich atrybutów i relacji. Gdy szukasz “planowania emerytalnego”, systemy AI nie wybierają stron o najwyższej gęstości tego wyrażenia. Zamiast tego, identyfikują strony, które kompleksowo omawiają powiązane encje, takie jak “401(k)”, “Roth IRA”, “plany emerytalne” i wyjaśniają ich atrybuty, np. “limity wpłat”, “opodatkowanie” czy “dopasowanie pracodawcy”. Badania BrightEdge wykazały, że 82,5% cytowań w AI Overviews pochodzi ze “stron głębokich”, oddalonych o dwa lub więcej kliknięć od strony głównej — treści obszernych i powiązanych, a nie powierzchownych podsumowań. To dowodzi, że systemy AI priorytetowo traktują głębię i kompleksowość treści, a nie częstotliwość słów kluczowych. Przy wyborze źródeł do odpowiedzi stosują technikę “query fan-out”, rozbijając złożone zapytania na powiązane podtematy i łącząc strony wspierające w spójne odpowiedzi. Strony z mocnym pokryciem encji i głębią podtematów są znacznie częściej wybierane jako źródła.

Upychanie słów kluczowych jest wyraźnie karane przez Google i inne systemy wyszukiwania. Oficjalne zasady dotyczące spamu Google mówią, że “wypełnianie strony internetowej słowami kluczowymi lub liczbami w celu manipulowania rankingiem” narusza ich wytyczne i może skutkować karą ręczną lub algorytmiczną degradacją. Treść, która sztucznie powtarza słowa kluczowe, brzmi nienaturalnie zarówno dla ludzi, jak i systemów AI. Nowoczesne modele językowe potrafią wykryć wymuszone użycie słów kluczowych i rozpoznać, kiedy priorytetem jest manipulacja pozycją, a nie wartość dla użytkownika. Gdy systemy AI napotkają treści przeładowane słowami kluczowymi, często je deprioritetyzują, ponieważ sygnalizują one niską jakość i są nieprzyjazne użytkownikowi. Ponadto upychanie słów kluczowych zwykle prowadzi do gorszych wskaźników zaangażowania — użytkownicy szybko opuszczają strony, które brzmią nienaturalnie. Wyszukiwarki monitorują czas spędzony na stronie, głębokość scrollowania i współczynnik klikalności jako sygnały jakości treści. Strony z wymuszonym powtarzaniem słów kluczowych wykazują zazwyczaj słabe zaangażowanie, co dodatkowo pogarsza ich pozycje. Bilans ryzyka i korzyści jest jasny: próba manipulowania rankingiem przez gęstość słów kluczowych daje minimalne korzyści i duże ryzyko kar.

Każdy główny system AI ma swoją specyfikę, ale łączy je wspólne kryteria oceny, które nie mają nic wspólnego z gęstością słów kluczowych. ChatGPT (z włączonym wyszukiwaniem) priorytetowo traktuje autorytatywne źródła, kompleksowe pokrycie i aktualność. Gdy ChatGPT cytuje źródła, wybiera strony, które szczegółowo odpowiadają na zapytanie, zawierając jasne i dobrze zorganizowane informacje. Perplexity podobnie ceni głębię tematyczną, kwalifikacje ekspertów i oryginalne badania. Algorytm platformy identyfikuje strony wykazujące rzeczywistą ekspertyzę i unikalne spostrzeżenia, a nie ogólne podsumowania. Google AI Overviews (dawniej SGE) wykorzystuje istniejące systemy rankingowe Google jako podstawę, ale dodatkowo ocenia kompleksowość i wiarygodność. Strony pojawiające się w AI Overviews mają zazwyczaj silne sygnały E-E-A-T (Doświadczenie, Ekspertyza, Autorytatywność, Wiarygodność), jasne informacje o autorze i powiązane klastry treści. Claude (AI firmy Anthropic) kładzie nacisk na dokładność, niuans i oryginalną analizę. Cytując źródła, wybiera strony prezentujące zrównoważone perspektywy i uznające złożoność zagadnień, zamiast upraszczających odpowiedzi. Wśród wszystkich tych systemów wspólny mianownik jest oczywisty: znaczenie semantyczne, autorytet tematyczny i głębia treści liczą się znacznie bardziej niż częstotliwość słów kluczowych. Jeśli chcesz, aby Twoje treści były cytowane przez AI, skoncentruj się na zbudowaniu rozpoznawalnego autorytetu w swojej dziedzinie poprzez kompleksowe, powiązane treści, a nie optymalizowanie gęstości słów kluczowych.

Autorytet tematyczny zastąpił gęstość słów kluczowych jako kluczowy wyznacznik trafności zarówno dla tradycyjnych wyszukiwarek, jak i systemów AI. Autorytet tematyczny to poziom ekspertyzy, wiarygodności i zaufania, jaki strona wykazuje w określonym temacie. Zamiast powtarzania słów kluczowych, budujesz autorytet tematyczny, tworząc obszerne, dobrze zorganizowane treści, które wyczerpująco omawiają temat i powiązane podtematy. Podejście to polega na tworzeniu klastrów treści — sieci powiązanych stron skupionych wokół centralnego tematu przewodniego. Na przykład, strona o usługach finansowych może utworzyć stronę filarową o “planowaniu emerytalnym”, wspieraną przez podtematy o “planach 401(k)”, “Roth IRA” i “planach emerytalnych”, z klastrowymi stronami odpowiadającymi na konkretne pytania, takie jak “limity wpłat na 401(k)”, “korzyści podatkowe Roth IRA” czy “porównanie 401(k) i Roth IRA”. Taka struktura sygnalizuje wyszukiwarkom i systemom AI, że Twoja strona ma głęboką ekspertyzę w danym temacie. Linkowanie wewnętrzne w ramach tych klastrów wzmacnia relacje encji i pomaga AI zrozumieć powiązania pomiędzy pojęciami. Budując autorytet tematyczny, naturalnie używasz adekwatnych słów kluczowych w kontekście — nie przez wymuszone powtórzenia, ale przez kompleksowe pokrycie powiązanych zagadnień. Przewodnik o planowaniu emerytalnym liczący ponad 3000 słów naturalnie zawiera frazy takie jak “401(k)”, “wpłata”, “podatek” czy “dopasowanie pracodawcy” wielokrotnie, ale gęstość słów kluczowych pozostaje niska (zazwyczaj 0,5-1,5%), bo treść skupia się na wartości, a nie optymalizacji słów kluczowych.

Różne platformy AI mają nieco inne wzorce cytowań, ale żadna nie priorytetyzuje gęstości słów kluczowych. Google AI Overviews najczęściej cytuje strony dobrze pozycjonujące się w tradycyjnym Google, co oznacza preferencję dla stron o silnym autorytecie tematycznym, mocnych sygnałach E-E-A-T i kompleksowym pokryciu. Bardziej prawdopodobne jest też wybranie stron o czytelnej strukturze (odpowiednia hierarchia nagłówków, schema markup, uporządkowane informacje). Perplexity wydaje się cenić oryginalne badania, kwalifikacje ekspertów i unikalne perspektywy. Często cytowane są strony zawierające badania, cytaty ekspertów lub oryginalne dane. ChatGPT (z wyszukiwaniem) priorytetowo traktuje aktualność przy tematach wrażliwych na czas i autorytet przy tematach ponadczasowych. Częściej cytowane są strony z uznanych i zaufanych domen. Claude stawia na dokładność i niuans, często cytując strony uznające złożoność i prezentujące zrównoważone spojrzenia. Aby zoptymalizować się pod kątem cytowań na tych platformach, skup się na: tworzeniu oryginalnych, popartych badaniami treści; jasnym przedstawieniu kwalifikacji autorów; budowaniu powiązanych klastrów treści pokazujących głębię tematyczną; stosowaniu danych strukturalnych (schema markup) dla jasności znaczenia treści; utrzymaniu wysokich standardów dokładności z odpowiednimi cytowaniami i fact-checkingiem. Żadna z tych strategii nie obejmuje optymalizacji gęstości słów kluczowych.

Przejście od myślenia w kategoriach gęstości słów kluczowych do optymalizacji semantycznej wymaga fundamentalnej zmiany strategii treści. Zacznij od zidentyfikowania kluczowych tematów i powiązania ich z encjami, które Google rozpoznaje w swoim Grafie Wiedzy. Dla każdego głównego tematu stwórz stronę filarową zapewniającą kompleksowy przegląd, następnie rozwijaj podtematy i strony klastrowe omawiające konkretne aspekty, porównania i pytania użytkowników. Używaj naturalnego języka — pisz najpierw dla ludzi, potem dla wyszukiwarek. Umieszczaj docelowe słowa kluczowe naturalnie w kontekście pomocnych, kompleksowych treści, ale nie wymuszaj ich. Wprowadzaj warianty semantyczne i powiązane terminy, aby systemy AI mogły zrozumieć pełen zakres tematu. Zamiast wielokrotnie powtarzać “planowanie emerytalne”, używaj odmian typu “strategia emerytalna”, “oszczędności emerytalne”, “konta emerytalne” czy “planowanie dochodu na emeryturze”. Strukturyzuj treści za pomocą przejrzystej hierarchii nagłówków (H1, H2, H3), wypunktowań, tabel porównawczych i odpowiednich wizualizacji. Taka struktura pomaga zarówno użytkownikom, jak i systemom AI efektywnie analizować Twoją treść. Wdrażaj schema markup (Article, FAQ, HowTo, Product itp.), aby jasno wskazać wyszukiwarkom, o czym jest treść. Stosuj linkowanie wewnętrzne do łączenia powiązanych stron w klastrach, używając opisowego anchor textu wyjaśniającego relacje między stronami. Monitoruj wyniki w Google Search Console, aby śledzić, które zapytania generują wyświetlenia i kliknięcia, oraz analizuj zaangażowanie (czas na stronie, głębokość scrollowania). Narzędzia takie jak AmICited pozwolą Ci śledzić, gdzie Twoje treści pojawiają się na platformach AI, dając wgląd w to, które strony są cytowane i które tematy wymagają pogłębienia.

Ewolucja od SEO do wyszukiwania napędzanego AI prowadzi do nowej dyscypliny zwanej Generative Engine Optimization (GEO). Tradycyjne SEO skupiało się na pozycjonowaniu na słowa kluczowe, a AI Overviews Optimization (AIO) na pojawianiu się w odpowiedziach generowanych przez AI, natomiast GEO patrzy szerzej na to, jak treści są odkrywane, pobierane i syntetyzowane przez systemy AI. W erze GEO strategia treści musi uwzględniać sposób, w jaki duże modele językowe pobierają i łączą informacje z wielu źródeł. Oznacza to budowanie semantycznie bogatych ekosystemów treści, gdzie strony są powiązane przez wyraźne relacje encji i głębię tematyczną. Najczęściej cytowane przez AI są strony oferujące kompleksowe pokrycie tematu, jasną ekspertyzę i wiarygodne informacje. Gęstość słów kluczowych nie ma tu żadnego znaczenia. Liczy się to, czy Twoje treści mogą być łatwo odnalezione, zrozumiane i zacytowane przez AI jako autorytatywne źródło. Wraz z rozwojem systemów AI, będą one coraz bardziej doceniać treści prezentujące prawdziwą ekspertyzę i unikalną wartość. Strony inwestujące dziś w autorytet tematyczny i głębię semantyczną zyskają trwałą przewagę konkurencyjną w zmieniającym się świecie wyszukiwania. Odwrót od gęstości słów kluczowych to dojrzałość technologii wyszukiwania — od mechanicznego dopasowania wzorców do prawdziwego rozumienia znaczenia i ekspertyzy.

Śledź, gdzie Twoje treści pojawiają się w ChatGPT, Perplexity, Google AI Overviews i Claude. Zrozum, co sprawia, że systemy AI cytują Twoje treści i zoptymalizuj je odpowiednio.

Gęstość słów kluczowych mierzy, jak często słowo kluczowe pojawia się w treści w stosunku do całkowitej liczby słów. Poznaj optymalne wartości procentowe, najle...

Dyskusja społecznościowa na temat tego, czy gęstość słów kluczowych ma znaczenie dla wyszukiwania AI. Prawdziwe doświadczenia profesjonalistów SEO testujących w...

Dowiedz się, czym jest gęstość informacji i jak zwiększa ona szansę cytowania przez AI. Poznaj praktyczne techniki optymalizacji treści pod kątem systemów AI, t...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.