Badania Promptów dla Widoczności AI: Zrozumienie Zapytań Użytkowników

Dowiedz się, jak prowadzić skuteczne badania promptów dla widoczności AI. Poznaj metodologię zrozumienia zapytań użytkowników w LLM i śledzenia swojej marki w C...

Dowiedz się, jak centra pomocy zwiększają widoczność w AI dzięki strukturalnym treściom Q&A, oznaczeniom FAQ schema i strategicznej optymalizacji treści pod ChatGPT, Perplexity i Gemini.

Centra pomocy znacząco zwiększają widoczność w AI, ponieważ ich format Q&A odzwierciedla sposób, w jaki systemy AI wyszukują i cytują treści, a oznaczenie FAQ schema zwiększa prawdopodobieństwo cytowania nawet 3,2x w wygenerowanych przez AI odpowiedziach.

Centra pomocy tradycyjnie służyły jako repozytoria wsparcia klienta i były często pomijane przez zespoły marketingowe skupione na ruchu blogowym i budowaniu świadomości marki. Jednak w erze wyszukiwarek opartych na AI takich jak ChatGPT, Perplexity, Gemini czy Grok, centra pomocy stały się jednym z najcenniejszych zasobów w walce o widoczność w generatywnych wynikach wyszukiwania. Podstawowy powód jest strukturalny: centra pomocy są zbudowane wokół formatu pytań i odpowiedzi, który doskonale współgra ze sposobem, w jaki duże modele językowe (LLM) wyszukują, wydobywają i cytują treści. Gdy użytkownicy zadają pytania systemom AI, te poszukują treści odpowiadających naturalnym sformułowaniom pytań i oferujących jasne, zwięzłe odpowiedzi — dokładnie to, co zapewniają dobrze zorganizowane centra pomocy. Ta zgodność tworzy znaczącą przewagę konkurencyjną dla marek, które optymalizują swoje centra pomocy pod kątem widoczności w AI, czyniąc je kopalnią fraz kluczowych o wysokiej intencji i autorytatywnych cytowań.

Przejście od tradycyjnego wyszukiwania do silników odpowiedzi opartych na AI to fundamentalna zmiana strategii treści. Podczas gdy tradycyjne SEO skupiało się na pozycjach pod kątem słów kluczowych w niebieskich linkach Google, optymalizacja widoczności w AI polega na zdobywaniu cytowań w odpowiedziach generowanych przez AI, które użytkownicy czytają bez przechodzenia na strony źródłowe. Centra pomocy sprawdzają się tu idealnie, ponieważ zawierają dokładnie taki typ treści, jaki preferują systemy AI: skoncentrowane, oparte na pytaniach artykuły z jasnymi odpowiedziami, przejrzystą strukturą i ekspercką wiedzą. Według badań nad optymalizacją pod generatywne silniki, artykuły z centrów pomocy są pisane w dokładnie takim formacie, jaki lubią LLM-y typu ChatGPT, Gemini czy Perplexity — krótkie, jasne treści Q&A, jedno pytanie na artykuł i jedna kompleksowa odpowiedź. Ta zgodność strukturalna sprawia, że centra pomocy nie wymagają rozbudowanej optymalizacji, by stać się widocznymi w AI; potrzebują jedynie poprawnej implementacji strukturalnych oznaczeń danych i sygnałów aktualności treści, aby maksymalizować swój potencjał.

Architektura treści centrum pomocy tworzy naturalne przewagi dla crawlerów AI i modeli językowych. Każdy artykuł centrum pomocy zwykle podąża za spójnym wzorcem: tytuł oparty na pytaniu, jasna sekcja odpowiedzi i dodatkowe szczegóły uporządkowane nagłówkami oraz wypunktowaniami. Ta konsekwencja sygnalizuje systemom AI, że treść jest rzetelna i dobrze zorganizowana, co ułatwia crawlerom zrozumienie relacji między pytaniami a odpowiedziami. Crawlery AI nie renderują JavaScriptu ani nie interpretują złożonych projektów stron tak jak ludzie; czytają strukturę HTML i szukają semantycznych sygnałów wskazujących na hierarchię treści i ich znaczenie. Centra pomocy naturalnie dostarczają te sygnały poprzez swój format Q&A, znacznie ułatwiając pracę crawlerów i zwiększając szansę na poprawne wydobycie treści do cytowania.

Struktura HTML dobrze zaprojektowanych centrów pomocy dodatkowo poprawia crawlability pod AI. Gdy artykuły używają właściwej hierarchii nagłówków (H1 dla głównego pytania, H2 dla sekcji odpowiedzi, H3 dla podrozdziałów), tworzą czytelną mapę treści, którą mogą podążać systemy AI. Dodatkowo centra pomocy zazwyczaj unikają ciężkich zależności JavaScript i złożonych elementów interaktywnych, które mogłyby ukryć treść przed crawlerami. Prosty, tekstowy projekt, który jest przyjazny dla użytkownika, jest jednocześnie przyjazny dla crawlerów, tworząc sytuację win-win, gdzie optymalizacja dla ludzi równocześnie wspiera widoczność AI. To zasadniczo różni się od wielu postów blogowych czy stron marketingowych, które przedkładają wizualny design i interaktywność nad klarowność strukturalną, przez co mogą być trudniejsze do poprawnej interpretacji przez AI.

Duże modele językowe są trenowane na ogromnych zbiorach danych tekstowych i uczą się wzorców prezentowania informacji. Jednym z najsilniejszych jest format pytanie-odpowiedź, który często występuje w źródłach takich jak Wikipedia, Stack Overflow, Reddit czy strony FAQ. Gdy LLM napotykają treści zbudowane jako jasne pytania i wyczerpujące odpowiedzi, rozpoznają ten wzorzec i traktują go jako wiarygodne źródło. Ten mechanizm rozpoznania jest tak silny, że systemy AI aktywnie preferują treści w formacie Q&A, gdy dostępnych jest wiele źródeł, ponieważ struktura redukuje niejednoznaczność i czyni wydobycie bardziej niezawodnym.

Sposób, w jaki użytkownicy korzystają z systemów AI, wzmacnia tę preferencję. Gdy ktoś pyta ChatGPT, Perplexity czy Gemini o coś, używa naturalnego języka, który odzwierciedla nagłówki artykułów centrum pomocy. Użytkownik może zapytać „Jak zresetować hasło?”, a system AI szuka treści, która bezpośrednio odpowiada na to pytanie. Artykuły centrum pomocy zatytułowane „Jak zresetować hasło” idealnie wpisują się w ten wzorzec, zwiększając szansę uznania ich za trafne i zacytowania. Ta zgodność między formatem zapytań użytkownika, wzorcami wyszukiwania AI a strukturą artykułu centrum pomocy tworzy naturalną synergię, której nie mają inne typy treści. Posty blogowe z tytułami typu „Najlepsze praktyki zarządzania hasłami” mogą zawierać te same informacje, ale różnica w formacie sprawia, że AI rzadziej wydobędzie i zacytuje konkretną odpowiedź na pytanie użytkownika.

Oznaczenie FAQ schema (dane strukturalne FAQPage) to techniczna implementacja, która jednoznacznie informuje systemy AI i wyszukiwarki, które fragmenty treści są pytaniami, a które odpowiedziami. Choć Google w sierpniu 2023 ograniczył wyświetlanie rozszerzonych wyników FAQ do stron rządowych i zdrowotnych, co zmniejszyło liczbę widocznych snippetów FAQ w tradycyjnym wyszukiwaniu, platformy AI takie jak ChatGPT, Perplexity i Gemini aktywnie crawlują i priorytetyzują oznaczenia FAQ schema. Badania pokazują, że strony z oznaczeniem FAQPage są 3,2x bardziej prawdopodobne, by pojawić się w Google AI Overviews w porównaniu do stron bez takich oznaczeń, a FAQ schema jest jednym z najczęściej cytowanych typów schematu w odpowiedziach AI. Ta dramatyczna różnica w prawdopodobieństwie cytowania czyni implementację FAQ schema jednym z najwyższych ROI zadań technicznego SEO pod kątem AI.

Wartość FAQ schema dla systemów AI polega na zdejmowaniu z algorytmów NLP konieczności interpretacji, które fragmenty tekstu są pytaniem, a które odpowiedzią. Schemat jawnie oznacza te relacje w formacie czytelnym dla maszyn. Ta przejrzystość pozwala AI wydobywać odpowiedzi z większą pewnością i dokładniej cytować źródła. Gdy system AI napotyka FAQ schema, może bezpośrednio zacytować tekst odpowiedzi bez obaw o pominięcie ważnego kontekstu. Ta niezawodność sprawia, że treści oznaczone FAQ są częściej wybierane do cytowania, zwłaszcza gdy dostępnych jest wiele źródeł dla tego samego pytania. Dodatkowo FAQ schema pomaga AI ocenić zakres i kompletność odpowiedzi, decydując, czy jedna odpowiedź w pełni wyczerpuje pytanie, czy należy połączyć kilka źródeł.

Treści centrum pomocy naturalnie targetują frazy o wysokiej intencji — zapytania wskazujące, że użytkownik chce podjąć działanie lub rozwiązać konkretny problem. W przeciwieństwie do treści blogowych, które często celują w frazy świadomościowe typu „co to jest zarządzanie hasłami”, artykuły w centrum pomocy celują w frazy decyzyjne typu „jak zresetować hasło” lub „dlaczego moje hasło nie działa”. Te wysokojintencyjne zapytania mają niższy wolumen wyszukiwań niż ogólne frazy świadomościowe, ale konwertują znacznie lepiej, bo użytkownicy szukający takich odpowiedzi są aktywnie nastawieni na rozwiązanie problemu. Dla widoczności w AI frazy o wysokiej intencji są szczególnie cenne, bo odzwierciedlają dokładnie typ pytań zadawanych systemom AI.

Przewaga targetowania słów kluczowych przez centra pomocy wykracza poza pojedyncze artykuły i obejmuje całą bazę wiedzy. Dobrze zorganizowane centrum pomocy obejmujące wszystkie aspekty produktu lub usługi tworzy kompleksowy klaster tematyczny sygnalizujący AI głęboką ekspertyzę. Gdy AI napotyka wiele artykułów centrum pomocy opisujących różne aspekty tego samego zagadnienia — np. „Jak skonfigurować integracje”, „Jak rozwiązywać błędy integracji” i „Jakie integracje są obsługiwane” — rozpoznaje, że domena ma autorytatywne, pełne pokrycie tematu. Taka autorytatywność tematyczna zwiększa szansę cytowania treści centrum pomocy nawet w przypadku, gdy konkretne pytanie użytkownika nie pokrywa się dokładnie z żadnym artykułem. Efekt klasteryzacji sprawia, że inwestycja w treści centrum pomocy przynosi zwielokrotnione korzyści — każdy nowy artykuł wzmacnia autorytet istniejących i zwiększa szansę cytowań w całej bazie wiedzy.

Linkowanie wewnętrzne w centrach pomocy pełni kilka funkcji dla widoczności w AI. Po pierwsze, tworzy powiązaną sieć treści, pomagając AI zrozumieć relacje tematyczne i hierarchię. Gdy artykuł o „Integracji ze Slackiem” linkuje do powiązanych treści jak „Rozwiązywanie błędów integracji” czy „Lista obsługiwanych integracji”, takie linki sygnalizują AI, że artykuły są powiązane tematycznie i należą do większej struktury wiedzy. Ta spójność pomaga AI zrozumieć zakres ekspertyzy i zwiększa szansę cytowania kilku artykułów centrum pomocy przy złożonych pytaniach wymagających różnych perspektyw.

Po drugie, linkowanie wewnętrzne rozprowadza equity linków i priorytet crawlowania po centrum pomocy, zapewniając uwagę crawlerów także mniej promowanym artykułom. Artykuł linkowany z wielu innych i z głównej nawigacji otrzymuje wyższy crawl priority niż odizolowany wpis, dzięki czemu częściej jest indeksowany i cytowany przez AI. Po trzecie, linkowanie wewnętrzne poprawia doświadczenie użytkownika poprzez umożliwienie odkrywania powiązanych treści bez opuszczania centrum pomocy, co redukuje współczynnik odrzuceń i podnosi metryki zaangażowania sygnalizujące jakość treści AI. Strategiczne rozmieszczenie linków — przy użyciu opisowych anchor tekstów z odpowiednimi frazami — pomaga też AI zrozumieć tematykę linkowanych artykułów i lepiej dopasować zapytania użytkownika do najbardziej trafnych treści centrum pomocy.

Systemy AI, zwłaszcza Google AI Overviews, zdecydowanie preferują ostatnio aktualizowane treści, ponieważ sygnały świeżości wskazują na aktualność i rzetelność informacji. Centra pomocy, które regularnie aktualizują artykuły — odświeżając je co 3-6 miesięcy o nowe statystyki, przykłady i bieżące informacje — wysyłają silne sygnały świeżości do AI. To zasadnicza różnica w stosunku do tradycyjnego SEO, gdzie świeżość treści ma znaczenie, ale nie jest tak kluczowa jak autorytet tematyczny czy linki zwrotne. Dla widoczności w AI świeżość może być decydującym czynnikiem przy porównywalnych źródłach, bo AI stara się dostarczać użytkownikom najnowsze i najdokładniejsze informacje.

Implementacja sygnałów świeżości w centrach pomocy powinna obejmować widoczne daty ostatniej aktualizacji w artykułach, które są wyraźnymi wskaźnikami świeżości dla AI. Ponadto artykuły należy odświeżać o aktualne statystyki, przykłady i informacje zgodne z obecnym stanem produktu lub usługi. Gdy artykuł o „Korzystaniu z funkcji X” jest aktualizowany zgodnie z najnowszymi zmianami lub nowymi możliwościami, staje się cenniejszy dla AI niż przestarzałe treści konkurencji. Tworzy to trwałą przewagę dla centrów pomocy traktujących utrzymanie aktualności jako proces ciągły, a nie jednorazowy projekt. Połączenie regularnych aktualizacji, widocznych dat i bieżących informacji tworzy silny sygnał świeżości zwiększający szansę cytowania w odpowiedziach generowanych przez AI.

Choć FAQ schema to podstawowy typ danych strukturalnych dla centrów pomocy, wdrożenie dodatkowych typów schema tworzy pełniejszą strukturę, z której mogą korzystać systemy AI. Article schema (lub BlogPosting schema) dostarcza metadanych o dacie publikacji, autorze i strukturze artykułu, pomagając AI ocenić autorytet i świeżość treści. Organization schema na stronie głównej centrum pomocy ustanawia tożsamość i ekspertyzę firmy, dostarczając kontekstu, kto stoi za treściami i czy jest wiarygodnym źródłem. HowTo schema dla artykułów instruktażowych umożliwia AI zrozumienie sekwencji kroków i poprawne ich wydobycie.

Warstwowe zastosowanie kilku typów schema tworzy bogatszą strukturę danych, którą systemy AI mogą trafniej interpretować. Gdy artykuł centrum pomocy zawiera FAQ schema dla struktury Q&A, Article schema dla metadanych publikacji i HowTo schema dla instrukcji, AI otrzymuje kilka sygnałów o charakterze i jakości treści. Ta redundancja poprawia trafność, bo AI może weryfikować dane między różnymi typami schema i mieć pewność, że wydobywa właściwe treści. Dodatkowo wdrożenie breadcrumb schema w nawigacji centrum pomocy pomaga AI zrozumieć hierarchię treści i relacje między artykułami oraz kategoriami. Skumulowany efekt prawidłowej implementacji wielu typów schema jest znacznie większy niż wdrożenie pojedynczego typu, tworząc przewagę dla centrów pomocy stosujących kompleksowe podejście do danych strukturalnych.

Różne platformy AI mają odmienne wzorce cytowań i preferencje treści, wpływając na skuteczność treści centrów pomocy w ekosystemie AI. ChatGPT mocno preferuje autorytatywne, neutralne, encyklopedyczne treści z zewnętrznymi cytowaniami i konkretnymi danymi. Artykuły centrum pomocy zawierające odniesienia do autorytetów, liczby i obiektywne informacje są częściej cytowane przez ChatGPT. Dane treningowe tej platformy obejmują m.in. Wikipedię, przez co preferuje ona podobne, neutralne, kompletne i dobrze udokumentowane treści. Centra pomocy przyjmujące taki ton i styl cytowań — traktując artykuły jak mini-encyklopedie, a nie marketing — lepiej wypadają w cytowaniach ChatGPT.

Perplexity AI wykazuje inną preferencję, faworyzując konwersacyjne, oparte na doświadczeniu treści z praktycznymi przykładami i wglądem społeczności. Platforma ceni realne scenariusze, konkretne przypadki i autentyczne przykłady zastosowań. Artykuły centrum pomocy zawierające przykłady, scenariusze klientów i praktyczne porady są częściej cytowane przez Perplexity. Ponadto Perplexity wyżej ocenia treści generowane przez społeczność i dyskusje, więc artykuły odwołujące się do feedbacku społeczności wypadają lepiej. Google AI Overviews stosuje zrównoważone podejście, ceniąc zarówno autorytet, jak i świeżość treści. Platforma podkreśla wagę sygnałów E-E-A-T (Doświadczenie, Ekspertyza, Autorytatywność, Wiarygodność), więc artykuły z atrybucją autora, datą publikacji i dowodami ekspertyzy są częściej cytowane.

Gemini oraz Grok to nowe platformy AI o ewoluujących wzorcach cytowań. Gemini, będąc systemem AI Google, prawdopodobnie podziela preferencje Google AI Overviews — ceni świeże treści i silne sygnały E-E-A-T. Grok, system AI Elona Muska, kładzie nacisk na informacje w czasie rzeczywistym i bieżące wydarzenia, przez co świeżość treści jest tu szczególnie ważna. Centra pomocy utrzymujące aktualność i często aktualizujące artykuły lepiej wypadają w Grok. Wniosek strategiczny: centra pomocy optymalizowane pod wszystkie główne platformy AI powinny równoważyć wiele cech treści — autorytatywność dla ChatGPT, praktyczne przykłady dla Perplexity, świeżość dla Google i Grok oraz sygnały E-E-A-T dla wszystkich. Takie zrównoważone podejście maksymalizuje szansę cytowania w całym ekosystemie AI, zamiast optymalizować pod jedną platformę.

| Aspekt | Tradycyjne centrum pomocy | Centrum pomocy zoptymalizowane pod AI |

|---|---|---|

| Główny cel | Redukcja zgłoszeń wsparcia | Redukcja zgłoszeń + zdobywanie cytowań AI |

| Struktura treści | Różne formaty (artykuły, poradniki, FAQ) | Spójny format Q&A: jedno pytanie na artykuł |

| Oznaczenia schema | Minimalne lub brak danych strukturalnych | Kompleksowe FAQ, Article i Organization schema |

| Długość odpowiedzi | Zmienna, często ponad 100 słów | Optymalnie 40-60 słów z pełnym kontekstem |

| Cytowania | Tylko odwołania wewnętrzne | Cytowania zewnętrzne do autorytetów |

| Świeżość treści | Aktualizowane raz w roku lub w razie potrzeby | Aktualizowane co miesiąc, nowe statystyki i przykłady |

| Ton | Skoncentrowany na produkcie, czasem promocyjny | Neutralny, informacyjny, edukacyjny |

| Linkowanie wewnętrzne | Minimalne powiązania | Strategiczne linki między powiązanymi artykułami |

| Atrybucja autora | Często anonimowa | Wyraźne dane autora i sygnały ekspertyzy |

| Widoczność daty | Ukryta lub niedostępna | Widoczna data ostatniej aktualizacji w każdym artykule |

| Optymalizacja mobilna | Podstawowy design responsywny | Optymalizacja pod wyszukiwanie głosowe i asystentów AI |

| Prawdopodobieństwo cytowania przez AI | Niskie (nieustrukturalizowane treści) | 3,2x wyższe (z FAQ schema) |

| Szansa na featured snippet | Średnia | Wysoka (struktura + schema) |

| Kompatybilność z wyszukiwaniem głosowym | Ograniczona | Optymalizacja pod konwersacyjne zapytania |

Centra pomocy osiągające maksymalną widoczność w AI mają kilka wspólnych cech, które odróżniają je od tradycyjnej dokumentacji wsparcia. Jedno pytanie na artykuł to podstawowa zasada — każdy wpis powinien odpowiadać na jedno, konkretne pytanie, a nie próbować omówić wiele tematów naraz. Takie skupienie ułatwia AI dopasowanie zapytań do właściwych artykułów i wydobycie pełnych odpowiedzi bez niejasności. Gdy artykuł próbuje odpowiedzieć na „Jak zresetować hasło, zmienić e-mail i zaktualizować profil?” w jednym miejscu, AI ma trudność z określeniem, która odpowiedź dotyczy którego pytania, przez co maleje szansa cytowania. Rozdzielenie tego na trzy odrębne artykuły — każdy z jasnym pytaniem — znacząco podnosi widoczność w AI.

Jasne, kompletne odpowiedzi, które są zrozumiałe bez dodatkowego kontekstu, są niezbędne do cytowania przez AI. Odpowiedzi powinny zakładać, że system AI może wyodrębnić i zaprezentować tylko tę odpowiedź, bez otaczających akapitów. Każda odpowiedź musi zatem zawierać wystarczająco dużo informacji, by była zrozumiała samodzielnie. Przykładowo odpowiedź „Kliknij przycisk na dole formularza” jest niepełna, bo nie wskazuje, który przycisk i formularz. Kompletna odpowiedź to: „Kliknij niebieski przycisk Wyślij na dole formularza ustawień konta, aby zapisać zmiany.” Takie podejście gwarantuje, że nawet gdy AI wyciągnie pojedyncze odpowiedzi z kontekstu, będą one jasne i użyteczne.

Strukturalne formatowanie z nagłówkami, wypunktowaniami i pogrubieniami pomaga zarówno ludziom, jak i AI zrozumieć organizację treści. Artykuły powinny korzystać z nagłówków H2 i H3 do dzielenia treści na sekcje, wypunktowań do list kroków lub cech oraz pogrubień do wyróżniania kluczowych terminów i informacji. Formatowanie to poprawia czytelność dla użytkowników szukających szybkich odpowiedzi, pomaga AI rozpoznać hierarchię treści i zwiększa szansę na featured snippets, które zasilają Google AI Overviews. Połączenie jasnej struktury i właściwego formatowania daje treści efektywne w klasycznym wyszukiwaniu, featured snippets i odpowiedziach AI.

Centra pomocy budują autorytet tematyczny poprzez kompleksowe pokrycie konkretnych zagadnień związanych z produktem lub usługą. Gdy centrum pomocy zawiera artykuły omawiające każdy aspekt funkcji — jak jej używać, jak rozwiązywać problemy, jak integrować z innymi narzędziami i najczęstsze pytania — zbiór tych treści sygnalizuje AI głęboką ekspertyzę w danym obszarze. Taki autorytet tematyczny zwiększa szansę cytowania przez AI także w przypadku, gdy zapytanie użytkownika nie pokrywa się dokładnie z żadnym artykułem. Efekt klasteryzacji sprawia, że każdy nowy artykuł wzmacnia autorytet istniejących i podnosi szansę cytowania w całej bazie wiedzy.

Budowanie autorytetu tematycznego wymaga strategicznego planowania, jakie zagadnienia należy pokryć kompleksowo. Zamiast przypadkowo pisać o pojedynczych funkcjach, skuteczne centra pomocy identyfikują kluczowe tematy i tworzą wokół każdego z nich kompletne klastry artykułów. Przykładowo narzędzie do zarządzania projektami może utworzyć klaster „Zarządzanie zadaniami” składający się z: „Jak utworzyć zadanie”, „Jak przypisać zadanie członkom zespołu”, „Jak ustawić terminy zadań”, „Jak oznaczyć zadania jako ukończone” i „Jak rozwiązywać problemy z zadaniami”. Takie pokrycie sygnalizuje ekspertyzę i sprawia, że AI częściej cytuje kilka artykułów z klastra przy pytaniach o zarządzanie zadaniami. To podejście poprawia także klasyczne SEO, bo wyszukiwarki nagradzają szerokie pokrycie tematu lepszymi pozycjami.

Pomiar skuteczności optymalizacji centrum pomocy pod AI wymaga innych metryk niż tradycyjne SEO. Klasyczne SEO skupia się na pozycjach i ruchu organicznym, a sukces widoczności AI mierzy się cytowaniami w wygenerowanych przez AI odpowiedziach. Wyzwanie polega na tym, że cytowania AI nie generują bezpośredniego ruchu jak pozycje w wyszukiwarce; zamiast tego budują autorytet marki i świadomość wśród użytkowników czytających odpowiedzi AI bez przechodzenia na stronę źródłową. Śledzenie cytowań AI wymaga monitorowania wzmiankowań marki i produktów w ChatGPT, Perplexity, Google AI Overviews, Gemini i Grok, by sprawdzić, gdzie i jak cytowane są treści centrum pomocy.

Kluczowe metryki mierzenia widoczności AI centrum pomocy to: częstotliwość cytowań na głównych platformach AI (ile razy treści centrum pojawiają się w odpowiedziach AI), kontekst cytowań (czy cytowania są pozytywne, neutralne, negatywne i czy zawierają nazwę marki), pojawienia się w featured snippets (które artykuły centrum są na pozycji zero w Google), ruch organiczny (tradycyjna skuteczność SEO, często rośnie wraz ze wzrostem widoczności AI), sygnały świeżości treści (jak często aktualizowane są artykuły i czy data aktualizacji jest widoczna), walidacja schema (procent artykułów z poprawnym oznaczeniem FAQ schema) i pokrycie linkowania wewnętrznego (jak dobrze artykuły są powiązane linkami). Najważniejszą metryką jest częstotliwość cytowań w odpowiedziach AI, bo bezpośrednio pokazuje, czy treści centrum są rozpoznawane i cytowane przez AI. Pomiar tej metryki wymaga ręcznego monitoringu (wyszukiwanie fraz marki i produktów w ChatGPT, Perplexity itp.) lub korzystania ze specjalnych narzędzi do monitoringu widoczności AI, które automatycznie śledzą cytowania w różnych platformach. Połączenie danych o cytowaniach AI z tradycyjnymi metrykami SEO daje pełny obraz efektywności centrum pomocy w klasycznym i AI-wyszukiwaniu.

Wdrożenie optymalizacji centrum pomocy pod AI wymaga systematycznego podejścia obejmującego strukturę treści, techniczne wdrożenie i utrzymanie. Rozpocznij od audytu treści istniejącego centrum pomocy, by zidentyfikować artykuły dobrze radzące sobie w tradycyjnym wyszukiwaniu oraz luki tematyczne. Na tej podstawie ustal priorytety optymalizacji, skupiając się na artykułach z największym ruchem i tych odpowiadających na frazy o wysokiej intencji. Każdy artykuł powinien stosować zasadę jedno pytanie na artykuł, zawierać jasną, kompletną odpowiedź i być odpowiednio sformatowany (nagłówki, wypunktowania).

Wdróż FAQ schema we wszystkich artykułach centrum pomocy w formacie JSON-LD. Skorzystaj z narzędzia Rich Results Test Google, by zweryfikować poprawność schema przed publikacją, upewniając się, że wszystkie wymagane właściwości są obecne. Testuj schema na desktopie i mobile, by sprawdzić poprawność wyświetlania. Po wdrożeniu monitoruj centrum pomocy w raporcie Rich Results Google Search Console, by śledzić walidację i ewentualne błędy. Ustal harmonogram aktualizacji treści, odświeżając artykuły co 3-6 miesięcy o bieżące informacje, nowe statystyki i przykłady. Dodaj widoczne daty aktualizacji do wszystkich artykułów, by sygnalizować świeżość AI. Przy aktualizacjach priorytetowo traktuj artykuły o wysokiej intencji i te już cytowane przez AI, bo przyniosą największy wzrost widoczności.

Buduj linkowanie wewnętrzne strategicznie, identyfikując powiązane artykuły i linkując między nimi opisowymi anchorami. Dodaj sekcję „Powiązane artykuły” na końcu każdego wpisu, sugerującą inne treści centrum pomocy. Wykorzystaj nawigację i strukturę kategorii, by podkreślić powiązania tematyczne i pomóc zarówno użytkownikom, jak i AI zrozumieć organizację treści. Optymalizuj pod wiele platform AI, pisząc treści centrum pomocy równoważące preferencje różnych systemów: autorytatywne cytowania dla ChatGPT, praktyczne przykłady dla Perplexity, świeże informacje dla Google AI Overviews oraz sygnały E-E-A-T dla wszystkich. Takie podejście maksymalizuje szansę cytowania w całym ekosystemie AI, a nie tylko jednej platformie.

Centra pomocy przekształciły się z pomijanych repozytoriów wsparcia w kluczowe aktywa dla widoczności w AI i budowania autorytetu marki. Zgodność struktury Q&A centrum pomocy ze sposobem, w jaki AI wyszukuje i cytuje treści, daje naturalną przewagę, której inne typy treści nie są w stanie dorównać. Poprawna implementacja FAQ schema, konsekwentna struktura treści, regularne aktualizacje i budowa autorytetu

Śledź, gdzie i jak systemy AI cytują treści Twojego centrum pomocy w ChatGPT, Perplexity, Gemini i Google AI Overviews dzięki monitorowaniu w czasie rzeczywistym.

Dowiedz się, jak prowadzić skuteczne badania promptów dla widoczności AI. Poznaj metodologię zrozumienia zapytań użytkowników w LLM i śledzenia swojej marki w C...

Dowiedz się, dlaczego Twoja marka nie pojawia się w ChatGPT, Perplexity, Google AI Overviews i Claude. Poznaj 5 kluczowych czynników i sposoby ich naprawy.

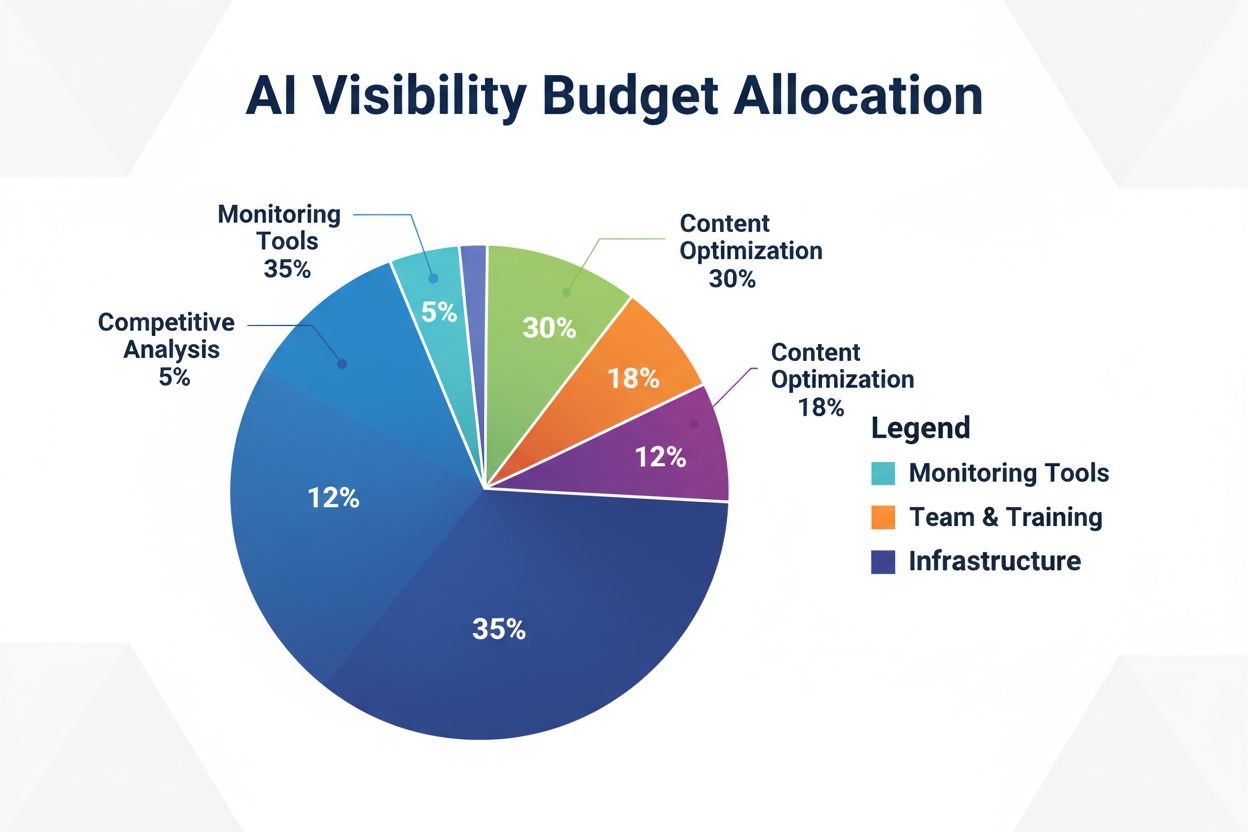

Dowiedz się, jak strategicznie alokować budżet widoczności AI na narzędzia monitorujące, optymalizację treści, zasoby zespołu oraz analizę konkurencji, aby zmak...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.