Wskaźnik Perplexity

Wskaźnik Perplexity mierzy przewidywalność tekstu w modelach językowych. Dowiedz się, jak ten kluczowy wskaźnik NLP kwantyfikuje niepewność modelu, jak jest obl...

Dowiedz się, co oznacza wynik perplexity w treści i modelach językowych. Zrozum, jak mierzy on niepewność modelu, dokładność przewidywań oraz ocenę jakości tekstu.

Wynik perplexity to metryka mierząca, jak dobrze model językowy przewiduje następne słowo w sekwencji. Określa poziom niepewności modelu podczas przewidywań — niższy wynik oznacza wyższą pewność i lepszą skuteczność predykcji.

Wynik perplexity to podstawowa metryka wykorzystywana w przetwarzaniu języka naturalnego i uczeniu maszynowym do oceny, jak dobrze model językowy radzi sobie z przewidywaniem tekstu. W istocie mierzy on stopień niepewności, jaki model posiada podczas przypisywania prawdopodobieństw słowom w sekwencji. Metryka ta ma szczególne znaczenie przy ocenie wydajności modeli w zadaniach takich jak generowanie tekstu, tłumaczenia maszynowe czy konwersacyjne AI. Gdy model językowy przetwarza tekst, przypisuje wartości prawdopodobieństwa potencjalnym kolejnym słowom na podstawie kontekstu zapewnionego przez poprzedzające słowa. Perplexity odzwierciedla, jak bardzo model jest pewny tych przewidywań, czyniąc z niej kluczowe narzędzie oceny dla deweloperów i badaczy pracujących z dużymi modelami językowymi.

Pojęcie perplexity pochodzi z teorii informacji, gdzie stanowi miarę niepewności w rozkładach prawdopodobieństwa. W kontekście modeli językowych niższe wyniki perplexity oznaczają, że model jest bardziej pewny swoich przewidywań i generuje więc spójniejszy oraz płynniejszy tekst. Z kolei wyższe wartości perplexity sugerują, że model jest niepewny co do kolejnego słowa, co potencjalnie prowadzi do mniej spójnych lub mniej trafnych wyników. Zrozumienie tej metryki jest kluczowe dla każdego pracującego z generowaniem treści przez AI, ponieważ bezpośrednio wpływa ona na jakość i wiarygodność generowanego tekstu.

Obliczenie wyniku perplexity obejmuje kilka kroków matematycznych, które przekształcają surowe przewidywania prawdopodobieństwa w jedną, czytelną metrykę. Podstawowy wzór opiera się na entropii przewidywań modelu, która mierzy poziom niepewności w wyniku. Wyrażenie matematyczne to: Perplexity = 2^H(p), gdzie H(p) oznacza entropię przewidywań modelu. Ten wzór pokazuje, że perplexity wynika bezpośrednio z entropii — niższe wartości entropii przekładają się na niższe wyniki perplexity.

Proces praktycznego obliczania przebiega według uporządkowanej sekwencji kroków. Najpierw model językowy przewiduje prawdopodobieństwo kolejnego tokena na podstawie tekstu wejściowego i zapewnionego kontekstu. Następnie stosowana jest transformacja logarytmiczna tych prawdopodobieństw, co pozwala przekształcić je w wygodniejszą do analizy miarę. Kolejno wyliczana jest średnia logarytmiczna wiarygodność wszystkich przewidzianych słów w zbiorze testowym dla całej sekwencji. Na końcu wykonuje się potęgowanie średniej logarytmicznej wiarygodności, aby uzyskać końcowy wynik perplexity. Pełny wzór na obliczenie perplexity dla sekwencji słów to: Perplexity = exp(-1/N × Σ log p(w_i | w_{i-1}, w_{i-2}, …, w_1)), gdzie p(w_i | w_{i-1}, …, w_1) to przewidywane prawdopodobieństwo i-tego słowa przy znanych poprzednich słowach, a N to liczba słów w sekwencji.

| Krok obliczeniowy | Opis | Cel |

|---|---|---|

| Predykcja tokena | Model przewiduje prawdopodobieństwo następnego słowa | Ustalenie podstawowych przewidywań |

| Transformacja logarytmiczna | Stosowanie logarytmu do prawdopodobieństw | Przekształcenie do przydatnej miary |

| Średnia obliczeń | Wyliczenie średniej logarytmicznej wiarygodności w sekwencji | Normalizacja względem długości tekstu |

| Potęgowanie | Podniesienie e do potęgi średniej ujemnej | Uzyskanie końcowego wyniku perplexity |

Wynik perplexity jest kluczową metryką oceny wydajności modelu językowego na wielu płaszczyznach. Jest ważny, ponieważ zapewnia bezpośredni wgląd w dokładność przewidywań, pomagając deweloperom zrozumieć, jak dobrze model przewiduje słowa i generuje spójne teksty. Niski wynik perplexity wskazuje, że model dokonuje pewnych przewidywań i prawdopodobnie generuje płynne, kontekstowo adekwatne treści. Ma to szczególne znaczenie w aplikacjach takich jak chatboty, wirtualni asystenci i systemy generowania treści, gdzie jakość tekstu bezpośrednio wpływa na doświadczenie użytkownika. Dodatkowo perplexity pomaga ocenić poziom pewności modelu co do przewidywań — jeśli perplexity jest wysokie, model jest niepewny kolejnego słowa, co może prowadzić do niespójnego lub nietrafnego generowania tekstu.

Metryka ta jest również niezbędna do porównywania i wyboru modeli. Przy ocenie różnych modeli językowych lub porównywaniu wersji tego samego modelu podczas fine-tuningu perplexity daje wymierną miarę postępu lub pogorszenia. Programiści mogą używać wyników perplexity, by określić, czy dany model nadaje się do konkretnych zadań, takich jak generowanie tekstu, tłumaczenia maszynowe, streszczanie czy odpowiadanie na pytania. Ponadto perplexity umożliwia ocenę w czasie rzeczywistym podczas treningu modelu, pozwalając na bieżąco monitorować jego wydajność i odpowiednio wprowadzać korekty. Jest to szczególnie cenne podczas fine-tuningu, gdzie kontrolowanie perplexity pomaga upewnić się, że model staje się coraz lepszy w pewnych przewidywaniach, a nie tylko dopasowuje się do danych treningowych.

Zrozumienie, jak interpretować wyniki perplexity, jest niezbędne do podejmowania świadomych decyzji o wydajności modelu i jego przydatności do określonych zastosowań. Niższy wynik perplexity oznacza, że model jest bardziej pewny swoich przewidywań i zazwyczaj generuje tekst wyższej jakości, bardziej spójny. Na przykład wynik perplexity równy 15 sugeruje, że model wybiera spośród około 15 możliwych słów na każdym kroku predykcji, co oznacza stosunkowo wysoką pewność. Dla kontrastu, wyższy wynik perplexity rzędu 50 lub więcej sugeruje, że model jest niepewny i rozważa znacznie więcej możliwości, co często wiąże się z mniej spójnymi lub mniej trafnymi wynikami. Interpretacja tego, co jest „dobrym” wynikiem perplexity, zależy od konkretnego zadania, zbioru danych i architektury modelu.

Różne typy treści i modeli wykazują odmienne zakresy bazowe wyników perplexity. Na przykład modele trenowane na dobrze ustrukturyzowanych, formalnych tekstach, takich jak artykuły z Wikipedii, zwykle osiągają niższe wyniki perplexity niż modele trenowane na treściach konwersacyjnych lub kreatywnych. Porównując wyniki perplexity różnych modeli, kluczowe jest, by oceniać je na tym samym zbiorze danych i z zastosowaniem tej samej metody tokenizacji, ponieważ te czynniki silnie wpływają na rezultaty. Model z wynikiem perplexity 20 na jednym zbiorze niekoniecznie jest lepszy od innego z wynikiem 25 na innym zbiorze. Dodatkowo długość sekwencji wpływa na obliczenia perplexity — dłuższe sekwencje zwykle dają stabilniejsze wyniki, podczas gdy krótsze mogą wykazywać większą zmienność i generować wartości odstające.

Choć wynik perplexity jest cenną metryką, posiada istotne ograniczenia, które trzeba brać pod uwagę podczas oceny modeli językowych. Jednym z głównych ograniczeń jest to, że perplexity nie mierzy rozumienia — model z niskim wynikiem perplexity może wciąż generować tekst niespójny, nieistotny lub niepoprawny merytorycznie. Metryka ta odnosi się wyłącznie do zdolności modelu do przewidywania następnego słowa na podstawie wzorców statystycznych z danych treningowych, a nie do rzeczywistego zrozumienia znaczenia czy kontekstu. Oznacza to, że model może osiągać świetne wyniki perplexity, generując tekst poprawny gramatycznie, lecz pozbawiony sensu lub zawierający błędy merytoryczne.

Kolejną ważną kwestią jest to, że perplexity nie oddaje skutecznie długotrwałych zależności. Metryka ta opiera się na przewidywaniach kolejnych słów i nie odzwierciedla tego, jak dobrze model utrzymuje spójność i logikę w dłuższych fragmentach tekstu. Istotna jest również wrażliwość na tokenizację — różne metody tokenizacji mogą znacząco wpływać na wyniki perplexity, co utrudnia bezpośrednie porównania modeli korzystających z innych tokenizatorów. Na przykład modele operujące na poziomie znaków mogą uzyskać niższe wyniki perplexity niż modele na poziomie słów, ale niekoniecznie generują przez to lepszy tekst. Ponadto perplexity jest miarą przeznaczoną przede wszystkim dla autoregresyjnych lub kauzalnych modeli językowych i nie da się jej bezpośrednio stosować do modeli maskowanych, takich jak BERT, które korzystają z innych mechanizmów predykcji.

Aby uzyskać pełną ocenę wydajności modelu językowego, wynik perplexity należy stosować w połączeniu z innymi metrykami oceny, a nie jako jedyną miarę. BLEU, ROUGE oraz METEOR to powszechnie wykorzystywane metryki porównujące generowany tekst ze wzorcowymi i są szczególnie przydatne w zadaniach tłumaczenia maszynowego i streszczania. Ocena ludzka przez wykwalifikowanych sędziów dostarcza informacji o aspektach, których nie wychwytują metryki automatyczne, takich jak płynność, trafność, spójność i ogólna jakość. Ocena poprawności merytorycznej z użyciem systemów QA lub narzędzi fact-checkingowych zapewnia, że generowane treści są nie tylko płynne, ale i poprawne. Metryki różnorodności i kreatywności, takie jak współczynnik powtórzeń, wskaźnik nowości czy entropia, mierzą, jak różnorodny i oryginalny jest generowany tekst, co ma znaczenie w zastosowaniach kreatywnych.

Ponadto ocena modeli pod kątem stronniczości i sprawiedliwości jest kluczowa dla ich bezpiecznego wdrażania w rzeczywistych aplikacjach, gdzie szkodliwe uprzedzenia mogą prowadzić do poważnych problemów. Łącząc wynik perplexity z tymi dodatkowymi miarami, deweloperzy mogą lepiej ocenić dokładność przewidywań, płynność i przydatność w praktyce danego modelu. Takie kompleksowe podejście pozwala wskazać modele, które nie tylko dobrze przewidują, ale robią to z pewnością, spójnością i niezawodnością. Zestawienie różnych metryk daje pełniejszy obraz wydajności modelu i pomaga upewnić się, że wybrane rozwiązanie spełnia konkretne wymagania zastosowań.

Wynik perplexity znajduje szerokie zastosowanie w rzeczywistych aplikacjach, w których wydajność modelu językowego bezpośrednio wpływa na jakość treści i doświadczenie użytkownika. W generowaniu tekstu perplexity pomaga zapewnić, że wygenerowane treści są spójne i płynne, potwierdzając, że przewidywania modelu są pewne i adekwatne do kontekstu. W przypadku systemów tłumaczenia maszynowego perplexity ocenia, jak dobrze model tłumaczący przewiduje kolejne słowo w języku docelowym, co jest kluczowe dla uzyskania tłumaczeń wysokiej jakości, zachowujących znaczenie i niuanse oryginału. W chatbotach i wirtualnych asystentach niskie perplexity oznacza płynne i kontekstowo trafne odpowiedzi, co bezpośrednio zwiększa satysfakcję i zaangażowanie użytkowników.

Modele streszczające korzystają z oceny perplexity, by upewnić się, że generowane streszczenia są czytelne i spójne, zachowując jednocześnie kluczowe informacje źródłowe. Twórcy treści i platformy AI wykorzystują perplexity do oceny jakości tekstów generowanych przez AI przed ich publikacją lub prezentacją użytkownikom. W miarę jak generowanie treści przez AI staje się coraz powszechniejsze w wyszukiwarkach i na platformach z odpowiedziami, zrozumienie i monitorowanie wyników perplexity pomaga zapewnić zgodność generowanych treści z wymogami jakości. Organizacje korzystające z systemów AI mogą używać tej metryki do identyfikacji momentów, w których modele wymagają ponownego treningu, fine-tuningu lub wymiany, by utrzymać stałą jakość treści oraz zaufanie użytkowników do odpowiedzi generowanych przez AI.

Śledź, jak Twoje treści pojawiają się w odpowiedziach AI w ChatGPT, Perplexity i innych wyszukiwarkach AI. Zapewnij swojej marce właściwe przypisanie w odpowiedziach generowanych przez AI.

Wskaźnik Perplexity mierzy przewidywalność tekstu w modelach językowych. Dowiedz się, jak ten kluczowy wskaźnik NLP kwantyfikuje niepewność modelu, jak jest obl...

Dyskusja społeczności na temat wskaźnika perplexity w kontekście treści i modeli językowych. Twórcy oraz eksperci AI zastanawiają się, czy ma to znaczenie dla t...

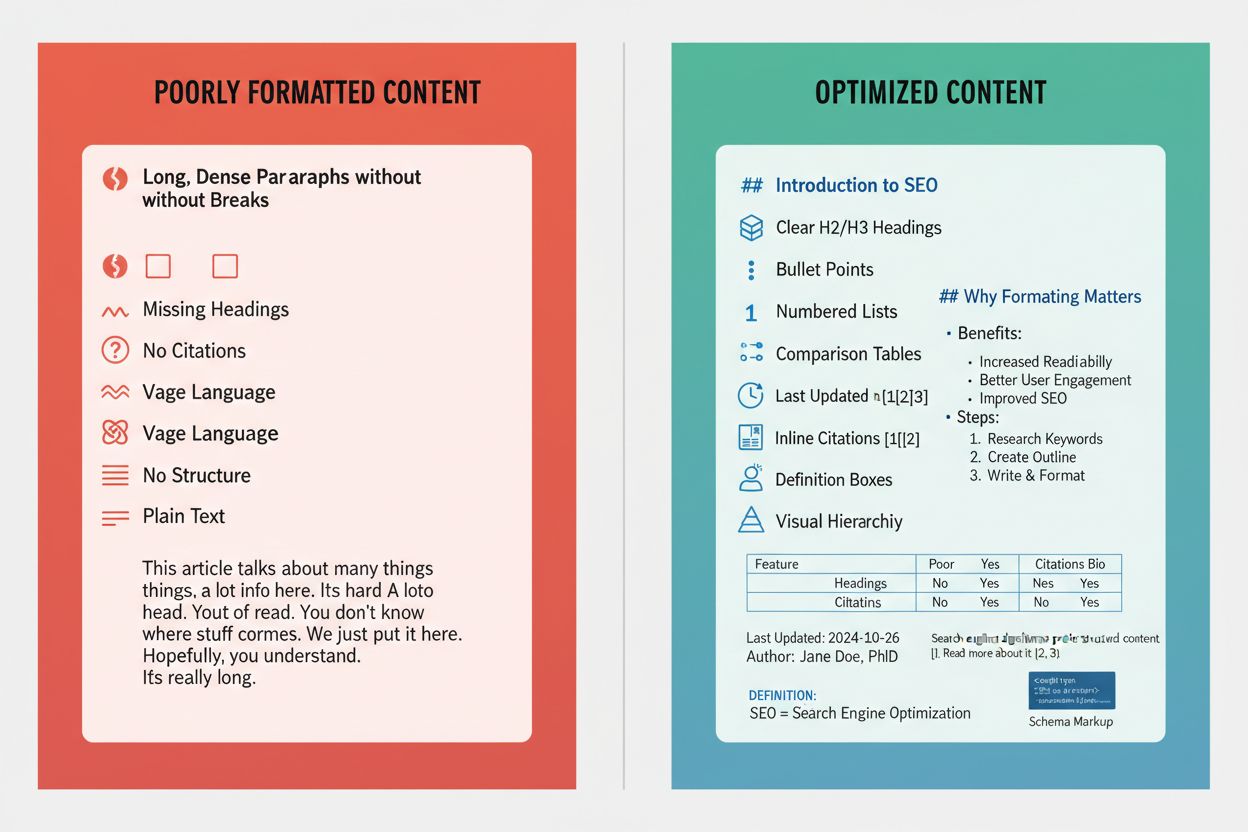

Dowiedz się, jak formatować treści dla maksymalnej widoczności w cytowaniach Perplexity. Opanuj tworzenie cytowalnych treści, oznaczenia schema i strategie cyto...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.