Jakie Czynniki Zaufania Wykorzystują Silniki AI do Oceny Źródeł

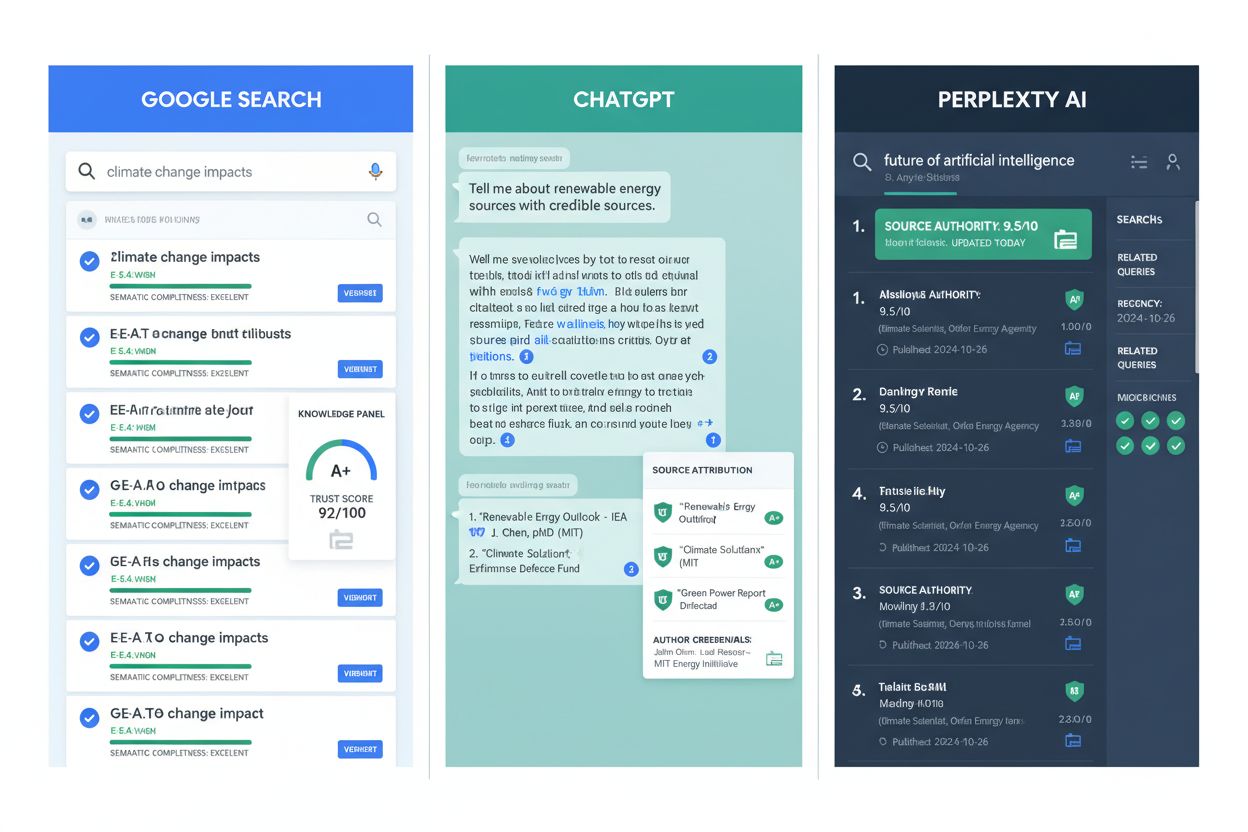

Dowiedz się, jak silniki AI, takie jak ChatGPT, Perplexity i Google AI, oceniają wiarygodność źródeł. Poznaj E-E-A-T, autorytet domeny, częstotliwość cytowań or...

Dowiedz się, które źródła są najczęściej cytowane przez silniki AI. Poznaj sposoby oceny wiarygodności przez ChatGPT, Google AI Overviews i Perplexity oraz przeanalizuj wzorce cytowań w różnych branżach, aby zoptymalizować swoją treść pod widoczność w AI.

Silniki AI, takie jak ChatGPT, Google AI Overviews i Perplexity, ufają źródłom na podstawie autorytetu, dokładności i przejrzystości. YouTube (~23%), Wikipedia (~18%) i Google.com (~16%) dominują w cytowaniach w różnych branżach, podczas gdy Reddit, LinkedIn i instytucje takie jak NIH różnią się w zależności od platformy i tematu. Każdy silnik AI ma odrębne preferencje kształtowane przez dane treningowe i algorytmy rankingowe.

Silniki AI oceniają wiarygodność źródeł na podstawie wielu sygnałów, wykraczających daleko poza prosty autorytet domeny. Gdy ChatGPT, Perplexity, Google AI Overviews oraz inne generatory odpowiedzi AI przetwarzają zapytania, opierają się na zaawansowanych wskaźnikach zaufania, ustalonych podczas trenowania i doskonalonych przez algorytmy rankingowe w czasie rzeczywistym. Systemy te nie wybierają źródeł przypadkowo — stosują algorytmy filtrujące, które priorytetowo traktują dokładność, autorytet, przejrzystość i spójność, aby określić, które informacje zasługują na wyróżnienie w odpowiedziach. Zrozumienie tych mechanizmów zaufania jest kluczowe dla każdego, kto chce zwiększyć widoczność swojej marki w odpowiedziach generowanych przez AI.

Podstawą oceny zaufania przez AI jest kuratela danych treningowych. Większość dużych modeli językowych korzysta z ogromnych zbiorów danych, obejmujących recenzowane czasopisma naukowe, archiwa wiadomości, encyklopedyczne źródła i publikacje rządowe. Jednocześnie deweloperzy odfiltrowują strony spamowe, farmy treści i znane sieci dezinformacji. Ten etap wstępnego przetwarzania ustala bazowy zakres źródeł, które AI może uznać za wiarygodne. Po wdrożeniu silniki AI stosują dodatkowe warstwy logiki rankingowej, biorąc pod uwagę częstotliwość cytowań, reputację domeny, aktualność treści i kontekst, aby wybrać źródła pojawiające się w odpowiedziach w czasie rzeczywistym.

Dane ukazują wyraźne różnice w tym, jak każdy silnik AI priorytetowo traktuje źródła. YouTube dominuje z około 23,3% cytowań w prawie każdej branży, będąc najczęściej cytowanym źródłem ogółem. Odzwierciedla to preferencję silników AI do wizualnych, praktycznych wyjaśnień, które upraszczają złożone tematy. Wikipedia jest tuż za nią z wynikiem 18,4%, zapewniając ustrukturyzowane, neutralne definicje idealne do podsumowań. Google.com odpowiada za 16,4% cytowań, co podkreśla znaczenie ekosystemu Google, w tym stron wsparcia i dokumentacji dla deweloperów.

Jednak te liczby maskują ważne różnice zależne od platformy. ChatGPT wykazuje wyraźną preferencję dla Wikipedii (7,8% wszystkich cytowań), co pokazuje orientację tej platformy na encyklopedyczne, faktograficzne treści. Z kolei Perplexity zdecydowanie faworyzuje Reddit (6,6% cytowań), co odzwierciedla filozofię projektową stawiającą na informacje napędzane przez społeczność i wymianę doświadczeń. Google AI Overviews stosuje bardziej zrównoważone podejście, rozkładając cytowania na Reddit (2,2%), YouTube (1,9%) i Quorę (1,5%), co sugeruje strategię łączącą treści profesjonalne z platformami społecznościowymi.

| Platforma AI | Najczęściej cytowane źródło | % cytowań | Drugie źródło | % cytowań | Trzecie źródło | % cytowań |

|---|---|---|---|---|---|---|

| ChatGPT | Wikipedia | 7,8% | 1,8% | Forbes | 1,1% | |

| Google AI Overviews | 2,2% | YouTube | 1,9% | Quora | 1,5% | |

| Perplexity | 6,6% | YouTube | 2,0% | Gartner | 1,0% | |

| Google AI Mode | Strony marek/OEM | 15,2% | 2,2% | YouTube | 1,9% |

Sygnały zaufania różnią się radykalnie w zależności od branży, pokazując, że silniki AI stosują kontekstowe ważenie, by dostosować ocenę wiarygodności do intencji zapytania. W przypadku zapytania zdrowotnych i medycznych dominuje autorytet instytucjonalny. National Institutes of Health (NIH) otrzymuje 39% cytowań, następnie Healthline (15%), Mayo Clinic (14,8%) i Cleveland Clinic (13,8%). Ta koncentracja odzwierciedla fakt, że silniki AI rozumieją, iż informacje zdrowotne wymagają potwierdzonej wiedzy klinicznej i recenzowanych dowodów. YouTube nadal odgrywa rolę wspierającą 28% dla przystępnych wyjaśnień dla pacjentów, ale platformy społecznościowe prawie nie występują w cytowaniach zdrowotnych, co pokazuje, że systemy AI rozumieją ryzyko dezinformacji medycznej.

Zapytania finansowe pokazują inny wzorzec, gdzie YouTube dominuje z wynikiem 23%, ponieważ użytkownicy szukają przystępnych wyjaśnień i poradników bardziej niż tradycyjnych instytucji finansowych. Wikipedia (7,3%), LinkedIn (6,8%) i Investopedia (5,7%) dostarczają definicji i profesjonalnych spostrzeżeń. Ten rozkład sugeruje, że silniki AI rozumieją, iż edukacja finansowa wymaga zarówno autorytatywnych materiałów referencyjnych, jak i przystępnych treści edukacyjnych. Pojawiają się też przestrzenie społecznościowe, jak Reddit i Quora, co podkreśla, jak AI łączy autorytet instytucjonalny z poradami od społeczności w tematach finansowych.

Zapytania e-commerce i zakupowe pokazują, że YouTube prowadzi z wynikiem 32,4%, a następnie Shopify (17,7%), Amazon (13,3%) i Reddit (11,3%). Ten schemat odzwierciedla zrozumienie przez silniki AI, że decyzje zakupowe wymagają zarówno edukacyjnych poradników, jak i walidacji produktu poprzez recenzje i rekomendacje społeczności. Zapytania SEO to ciekawy przypadek, gdzie YouTube (39,1%) i Google.com (39,0%) są niemal na równi, co wskazuje, że AI uznaje za równie wartościowe zarówno oficjalne przewodniki, jak i praktyczne porady ekspertów przy tematach technicznych.

Silniki AI oceniają wiarygodność przez cztery powiązane ze sobą wymiary, które wspólnie decydują o ocenie źródła. Dokładność to pierwszy filar — treść musi przedstawiać sprawdzalne fakty poparte dowodami lub danymi, unikając niepotwierdzonych twierdzeń. AI ocenia dokładność, porównując informacje w wielu źródłach i sprawdzając ich spójność. Gdy źródła zgadzają się co do faktu, pewność rośnie; gdy się różnią, system może stosować ostrożność lub obniżać ocenę tych twierdzeń. Ten mechanizm krzyżowego sprawdzania oznacza, że treści pojawiające się w wielu zaufanych dokumentach zyskują dodatkową wagę, zwiększając swoje szanse na cytowanie lub podsumowanie.

Autorytet stanowi drugi filar i jest bardziej złożony niż samo rozpoznanie domeny. Choć ugruntowani wydawcy i uznane instytucje mają przewagę — główne media są cytowane co najmniej w 27% przypadków, a nawet do 49% w przypadku zapytań wymagających aktualności — autorytet coraz częściej obejmuje także wiedzę z pierwszej ręki. Silniki AI rozpoznają sygnały eksperckości, jak oryginalne badania, treści tworzone przez zweryfikowanych specjalistów i osoby dzielące się własnym doświadczeniem. Mniejsze marki i niszowi wydawcy, którzy konsekwentnie wykazują się sprawdzoną wiedzą, mogą być równie widoczni jak tradycyjne media, czasem nawet bardziej przekonująco. Google AI Overviews trzy razy częściej linkuje do stron .gov niż standardowe wyniki wyszukiwania, pokazując, jak instytucjonalny autorytet zyskuje dodatkową wagę przy określonych typach zapytań.

Przejrzystość to trzeci filar, wymagający, aby źródła wyraźnie się identyfikowały, odpowiednio cytowały autorów i umożliwiały prześledzenie informacji do jej źródła. Silniki AI faworyzują treści, gdzie autorstwo jest jawne, źródła są podane, a kontekst jest wyraźny. Ta przejrzystość umożliwia zarówno użytkownikom, jak i systemom AI weryfikację twierdzeń i zrozumienie ich podstaw. Czwarty filar, spójność w czasie, pokazuje wiarygodność poprzez wiele artykułów lub aktualizacji, a nie pojedyncze przypadki. Treści, które utrzymują dokładność w licznych publikacjach i aktualizacjach na przestrzeni czasu, sygnalizują zaufanie skuteczniej niż pojedyncze autorytatywne materiały.

Po wprowadzeniu zapytania silniki AI stosują zaawansowaną logikę rankingową, która równoważy wiarygodność z trafnością i aktualnością. Częstotliwość cytowań i powiązania między źródłami odgrywają kluczową rolę — treści pojawiające się w wielu zaufanych dokumentach zyskują zwiększoną wagę. Zasada ta jest rozwinięciem koncepcji PageRank: tak jak Google nie wybiera ręcznie autorytatywnych stron, lecz polega na sygnałach, takich jak częstotliwość linkowania przez wiarygodne strony, tak systemy generatywne bazują na krzyżowo weryfikowanej wiarygodności, by wyróżniać określone źródła. Gdy fakt pojawia się w kilku źródłach o wysokim autorytecie, AI uznaje go za bardziej wiarygodny i chętniej go cytuje.

Aktualność i częstotliwość aktualizacji mają istotny wpływ na ranking, zwłaszcza w Google AI Overviews, które opierają się na podstawowych systemach rankingowych Google. Aktywnie aktualizowane lub niedawno uzupełnione treści mają większą szansę na pojawienie się, szczególnie w zapytaniach dotyczących zmieniających się tematów, jak regulacje, najnowsze wiadomości lub nowe badania. Sygnał świeżości zapewnia, że odpowiedzi generowane przez AI odzwierciedlają aktualne informacje, a nie przestarzałe poglądy. Kontekstowe ważenie dodaje kolejny poziom zaawansowania — pytania techniczne mogą faworyzować naukowe lub specjalistyczne źródła, a zapytania informacyjne — treści dziennikarskie. Ta elastyczność pozwala silnikom dostosować sygnały zaufania do intencji użytkownika, tworząc zniuansowane systemy oceniania, które łączą wiarygodność z kontekstem.

Oprócz trenowania i rankingowania silniki AI stosują wewnętrzne metryki zaufania — systemy oceny szacujące prawdopodobieństwo, że stwierdzenie jest prawdziwe. Te oceny wpływają na to, które źródła są cytowane oraz czy model zdecyduje się na użycie zastrzeżeń zamiast udzielania jednoznacznych odpowiedzi. Modele przypisują wewnętrzne prawdopodobieństwo do generowanych stwierdzeń; wysokie oceny oznaczają większą pewność, podczas gdy niskie mogą uruchamiać mechanizmy zabezpieczające, jak zastrzeżenia lub odpowiedzi awaryjne. Progi te nie są stałe — przy zapytaniach, gdzie informacje są rzadkie lub niskiej jakości, silniki obniżają gotowość do udzielania definitywnych odpowiedzi lub wyraźniej cytują zewnętrzne źródła.

Zgodność między źródłami znacząco wzmacnia ocenę pewności. Gdy wiele zaufanych źródeł potwierdza daną informację, pewność wzrasta znacznie. Przeciwnie, gdy sygnały są rozbieżne, systemy mogą stosować zastrzeżenia lub całkowicie obniżać ocenę danych twierdzeń. Ten mechanizm tłumaczy, dlaczego informacje potwierdzone przez wiele autorytatywnych źródeł uzyskują wyższe oceny pewności niż te pojawiające się tylko w jednym, nawet bardzo prestiżowym źródle. Interakcja między tymi mechanizmami a wyborem źródeł tworzy sprzężenie zwrotne, w którym najbardziej wiarygodne źródła stają się coraz bardziej widoczne w odpowiedziach AI.

Domeny komercyjne (.com) dominują w cytowaniach AI z ponad 80% wszystkich cytowań, co czyni rozszerzenie domeny istotnym sygnałem zaufania. Strony non-profit (.org) są drugie z wynikiem 11,29%, co odzwierciedla uznanie przez AI wiarygodności instytucjonalnej. Domeny krajowe (.uk, .au, .br, .ca) łącznie stanowią ok. 3,5% cytowań, co wskazuje na globalny zasięg źródeł. Co ciekawe, rozszerzenia technologiczne, jak .io i .ai, mają zauważalną obecność mimo bycia stosunkowo nowymi, sugerując rosnące możliwości dla marek technologicznych w budowaniu autorytetu.

Ten rozkład domen pokazuje, że tradycyjne domeny komercyjne mają wciąż znaczną przewagę wiarygodności, ale nowe rozszerzenia zyskują na znaczeniu, gdy AI coraz częściej ocenia jakość treści niezależnie od końcówki domeny. Dominacja .com i .org wynika zarówno z ich obecności w danych treningowych, jak i powiązania z uznanymi organizacjami. Jednak rosnący udział specjalistycznych TLD wskazuje, że silniki AI coraz częściej nagradzają ekspercką jakość treści ponad rodowód domeny.

Zrozumienie specyfiki preferencji zaufania każdej platformy umożliwia celowaną optymalizację. Dla widoczności w ChatGPT należy zadbać o obecność w autorytatywnych bazach wiedzy i uznanych mediach. Dominacja Wikipedii w cytowaniach ChatGPT (47,9% z top 10 źródeł) sugeruje, że kompleksowe, dobrze ustrukturyzowane treści referencyjne są traktowane priorytetowo. Warto zadbać, by marka pojawiała się w odpowiednich hasłach Wikipedii, współtworzyć publikacje branżowe i mieć silną obecność na głównych marketplace’ach, ponieważ ChatGPT mocno faworyzuje domeny sklepowe (41,3% cytowań).

Aby zoptymalizować widoczność w Perplexity, należy postawić na aktywne zaangażowanie w społeczności i tworzenie obszernych, cytowalnych treści. Dominacja Reddita (46,7% w top 10 źródeł Perplexity) pokazuje, że informacje napędzane przez społeczność i dyskusje peer-to-peer mają duży wpływ na widoczność. Warto autentycznie uczestniczyć w odpowiednich społecznościach Reddita, publikować szczegółowe poradniki i badania, które są naturalnie cytowane przez członków społeczności, oraz utrzymywać obecność na profesjonalnych portalach typu LinkedIn. Perplexity cytuje aż 8 027 unikalnych domen — to największa różnorodność spośród wszystkich platform, co sugeruje, że niszowa ekspertyza i specjalistyczne treści są doceniane.

Dla Google AI Overviews należy równoważyć treści edukacyjne z wideo i utrzymywać świeżość oraz regularnie aktualizować strony. Dominacja YouTube (23,3% cytowań) oraz preferencja platformy do zrównoważonego rozkładu źródeł sugerują, że najlepsze efekty daje strategia wielokanałowa. Publikuj edukacyjne poradniki, twórz jasne wideo, dbaj o aktualność informacji na stronie oraz obecność na profesjonalnych platformach. Trzykrotnie wyższa preferencja dla stron .gov pokazuje, że instytucjonalna wiarygodność i potwierdzona ekspertyza mają tu szczególną wagę.

Pomimo zaawansowanych mechanizmów zaufania, nierównowaga źródeł pozostaje poważnym wyzwaniem. Sygnały autorytetu często faworyzują duże, anglojęzyczne wydawnictwa i zachodnie media, co może pomijać lokalną lub nieangielską ekspertyzę, nierzadko bardziej wiarygodną. To upraszcza zakres prezentowanych perspektyw i tworzy „martwe pola” w odpowiedziach generowanych przez AI. Ponadto dynamiczny charakter wiedzy stanowi stałe wyzwanie — konsensus naukowy się zmienia, regulacje ewoluują, a nowe badania mogą obalać wcześniejsze założenia. To, co uznawane jest za prawdziwe dziś, może być nieaktualne jutro, przez co silniki muszą stale odnawiać i kalibrować wskaźniki wiarygodności.

Brak przejrzystości w systemach AI utrudnia planowanie strategii. Firmy AI rzadko ujawniają pełen skład danych treningowych czy dokładny sposób ważenia sygnałów zaufania, przez co wydawcy nie mogą dokładnie zrozumieć, dlaczego pewne źródła pojawiają się częściej. Ta luka w przejrzystości utrudnia zarówno użytkownikom zrozumienie logiki AI, jak i marketerom dopasowanie strategii treści do faktycznych priorytetów platformy. Badanie Uniwersytetu Columbia wykazało, że ponad 60% odpowiedzi AI nie posiadało dokładnych cytowań, co podkreśla te wyzwania i ciągłą potrzebę ulepszania oceny źródeł oraz precyzji cytowań.

Branża zmierza w kierunku większej przejrzystości i odpowiedzialności w ocenie źródeł. Oczekuj większego nacisku na odpowiedzi bezpośrednio powiązane z ich źródłami poprzez linki, śledzenie pochodzenia i etykietowanie źródeł. Te funkcje pomagają użytkownikom potwierdzić, czy twierdzenia pochodzą z wiarygodnych dokumentów, a także rozpoznać, gdy tak nie jest. Mechanizmy feedbacku są coraz częściej wdrażane systemowo, co pozwala na uwzględnianie korekt użytkowników, ocen i zgłoszeń błędów w aktualizacjach modeli. Powstaje w ten sposób pętla, w której wiarygodność jest nie tylko określana algorytmicznie, ale również doskonalona przez praktyczne wykorzystanie.

Inicjatywy open source i projekty na rzecz przejrzystości dążą do większego wglądu w stosowanie sygnałów zaufania. Ujawniając praktyki dotyczące danych treningowych czy systemów ważenia, umożliwiają naukowcom i opinii publicznej lepsze zrozumienie, dlaczego pewne źródła są wyróżniane. Ta przejrzystość pomaga budować odpowiedzialność w branży i umożliwia tworzenie skuteczniejszych strategii treści. W miarę dojrzewania systemów AI spodziewaj się dalszej ewolucji metod oceny wiarygodności źródeł, z naciskiem na potwierdzoną ekspertyzę, transparentność źródeł i wykazywaną dokładność w czasie.

Śledź, gdzie Twoja domena pojawia się w odpowiedziach generowanych przez AI w ChatGPT, Perplexity, Google AI Overviews i innych wyszukiwarkach AI. Uzyskaj wgląd w czasie rzeczywistym w wydajność swoich cytowań AI.

Dowiedz się, jak silniki AI, takie jak ChatGPT, Perplexity i Google AI, oceniają wiarygodność źródeł. Poznaj E-E-A-T, autorytet domeny, częstotliwość cytowań or...

Dowiedz się, jak budować sygnały zaufania dla wyszukiwarek AI, takich jak ChatGPT, Perplexity i Google AI Overviews. Poznaj zasady E-E-A-T, sygnały autorytetu o...

Dowiedz się, jak systemy AI oceniają wiarygodność źródeł poprzez kwalifikacje autora, cytowania i weryfikację. Poznaj techniczne mechanizmy, kluczowe czynniki o...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.