Czym jest audyt treści AI i dlaczego Twoja marka go potrzebuje?

Dowiedz się, czym jest audyt treści AI, czym różni się od tradycyjnych audytów treści oraz dlaczego monitorowanie obecności Twojej marki w wyszukiwarkach AI, ta...

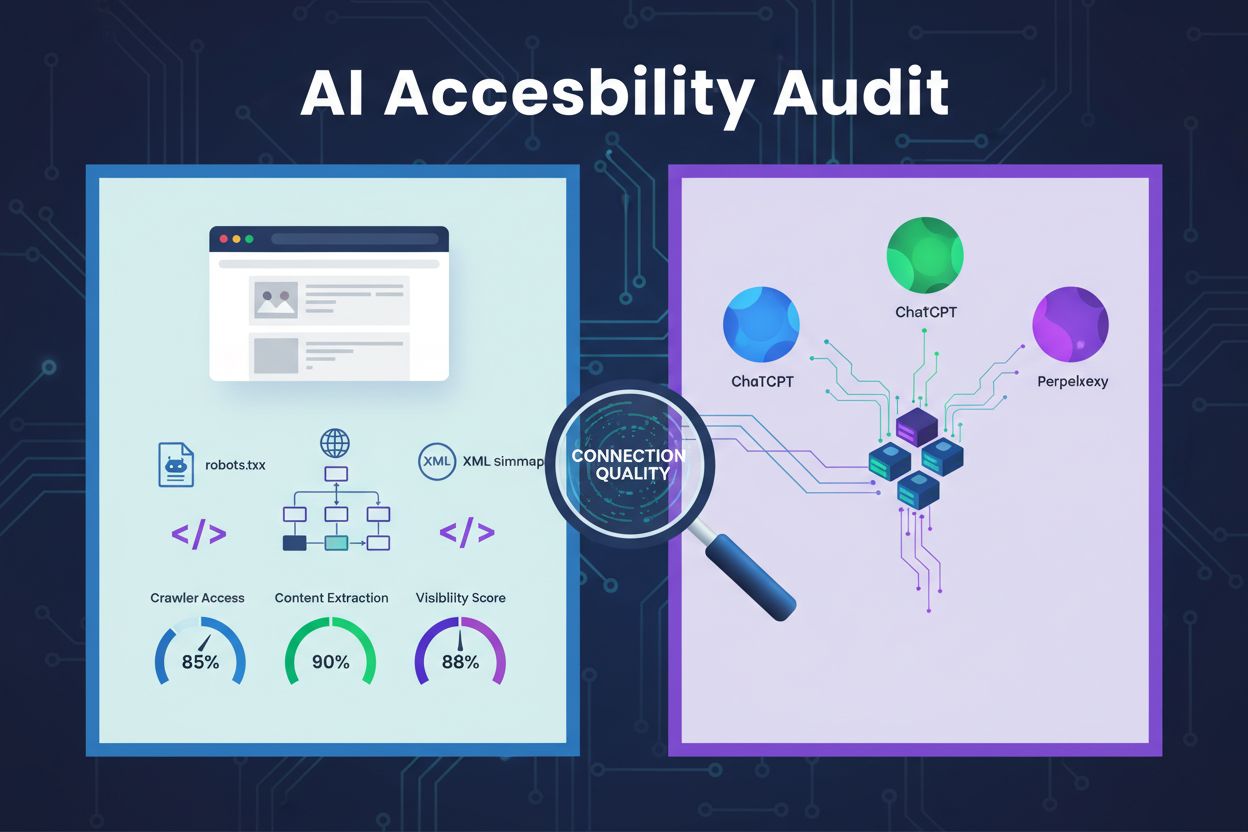

Techniczna analiza architektury strony internetowej, konfiguracji oraz struktury treści w celu określenia, czy roboty AI mogą skutecznie uzyskiwać dostęp, rozumieć i wydobywać treści. Ocenia konfigurację robots.txt, mapy witryny XML, możliwość indeksowania, renderowanie JavaScript oraz zdolność ekstrakcji treści, aby zapewnić widoczność w platformach wyszukiwania opartych na AI, takich jak ChatGPT, Claude i Perplexity.

Techniczna analiza architektury strony internetowej, konfiguracji oraz struktury treści w celu określenia, czy roboty AI mogą skutecznie uzyskiwać dostęp, rozumieć i wydobywać treści. Ocenia konfigurację robots.txt, mapy witryny XML, możliwość indeksowania, renderowanie JavaScript oraz zdolność ekstrakcji treści, aby zapewnić widoczność w platformach wyszukiwania opartych na AI, takich jak ChatGPT, Claude i Perplexity.

Audyt dostępności dla AI to techniczna analiza architektury Twojej strony, konfiguracji oraz struktury treści, mająca na celu ustalenie, czy roboty AI mogą skutecznie uzyskać dostęp, zrozumieć i wydobyć Twoje treści. W przeciwieństwie do tradycyjnych audytów SEO koncentrujących się na pozycjach słów kluczowych i linkach, audyt dostępności AI sprawdza techniczne fundamenty umożliwiające systemom AI, takim jak ChatGPT, Claude i Perplexity, odnajdowanie i cytowanie Twoich materiałów. Analizie podlegają kluczowe elementy, w tym konfiguracja robots.txt, mapy witryny XML, indeksowalność strony, renderowanie JavaScript oraz możliwość ekstrakcji treści, aby zapewnić pełną widoczność witryny w ekosystemie wyszukiwania opartym na AI.

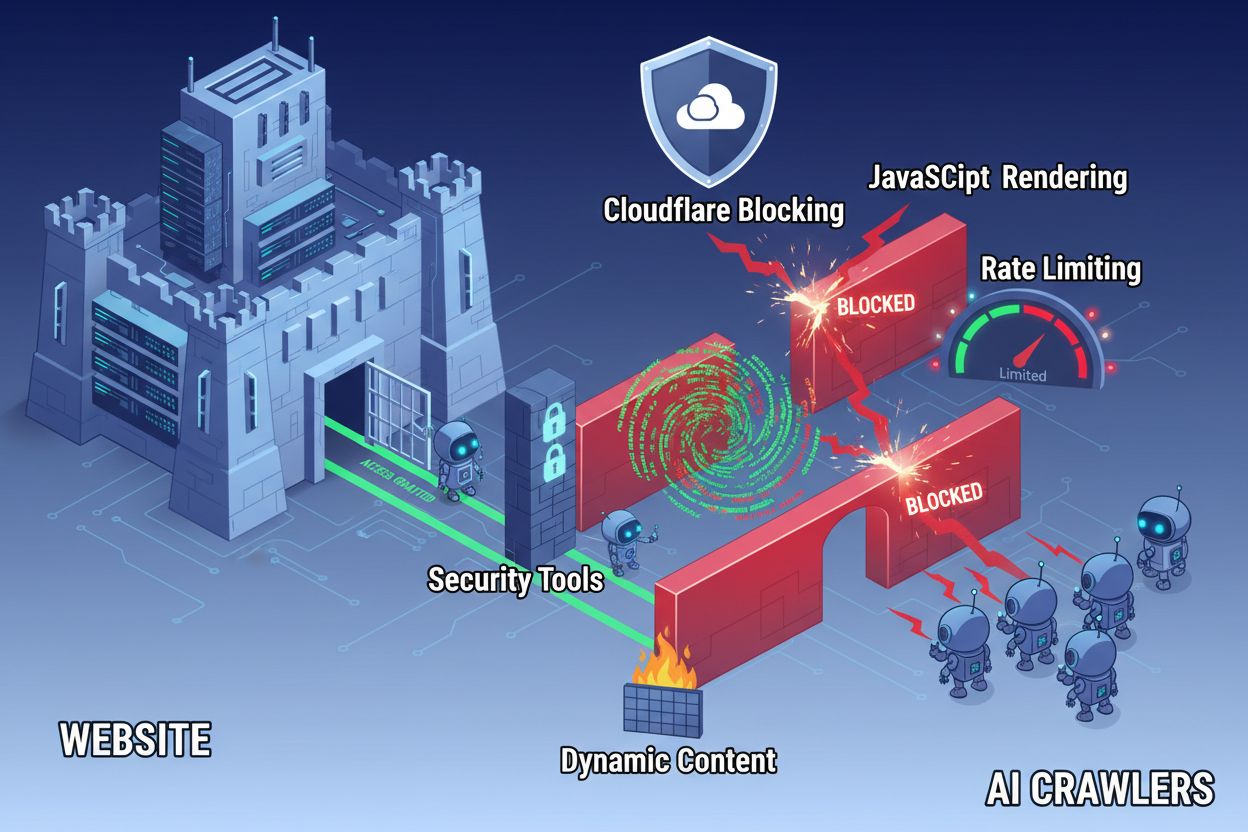

Pomimo rozwoju technologii webowych, roboty AI napotykają poważne bariery podczas próby uzyskania dostępu do nowoczesnych stron internetowych. Głównym wyzwaniem jest fakt, że wiele współczesnych witryn silnie opiera się na renderowaniu JavaScript w celu dynamicznego wyświetlania treści, podczas gdy większość robotów AI nie jest w stanie wykonywać kodu JavaScript. Oznacza to, że około 60-90% treści nowoczesnych stron pozostaje niewidoczne dla systemów AI, mimo że poprawnie wyświetla się w przeglądarkach użytkowników. Dodatkowo narzędzia bezpieczeństwa, takie jak Cloudflare, domyślnie blokują roboty AI, traktując je jako potencjalne zagrożenie, a nie legalne roboty indeksujące. Badania pokazują, że 35% stron korporacyjnych przypadkowo blokuje roboty AI, uniemożliwiając odnalezienie i cytowanie wartościowych treści przez systemy AI.

Najczęstsze bariery blokujące dostęp robotów AI:

Kompleksowy audyt dostępności dla AI obejmuje analizę wielu technicznych i strukturalnych aspektów wpływających na interakcję systemów AI z Twoją stroną. Każdy z tych elementów pełni istotną rolę w zapewnieniu widoczności treści w wyszukiwarkach opartych na AI. Proces audytu obejmuje testowanie indeksowalności, weryfikację plików konfiguracyjnych, ocenę struktury treści i monitorowanie faktycznego zachowania robotów. Dzięki systematycznej analizie tych elementów możesz zidentyfikować konkretne bariery i wdrożyć celowane rozwiązania poprawiające widoczność w AI.

| Element | Cel | Wpływ na widoczność w AI |

|---|---|---|

| Konfiguracja robots.txt | Kontroluje, które roboty mają dostęp do określonych sekcji strony | Krytyczny – błędna konfiguracja całkowicie blokuje roboty AI |

| Mapy witryny XML | Kierują roboty do ważnych stron i struktury treści | Wysoki – pomagają AI priorytetyzować i odkrywać treści |

| Indeksowalność strony | Zapewnia dostępność stron bez logowania i złożonej nawigacji | Krytyczny – zablokowane strony są niewidoczne dla AI |

| Renderowanie JavaScript | Określa, czy treść dynamiczna jest widoczna dla robotów | Krytyczny – 60-90% treści może być pominięte bez pre-renderingu |

| Ekstrakcja treści | Ocena łatwości parsowania i rozumienia treści przez AI | Wysoki – słaba struktura zmniejsza szansę cytowania |

| Konfiguracja narzędzi bezpieczeństwa | Zarządza regułami zapory i ochrony wpływającymi na roboty | Krytyczny – zbyt restrykcyjne reguły blokują legalne roboty AI |

| Implementacja schema markup | Dostarcza maszynowo czytelny kontekst o treści | Średni – poprawia zrozumienie i szansę cytowania przez AI |

| Struktura linkowania wewnętrznego | Ustanawia semantyczne relacje między stronami | Średni – pomaga AI rozpoznać autorytet i powiązania tematyczne |

Twój plik robots.txt to podstawowy mechanizm kontroli dostępu robotów do strony. Umieszczony w głównym katalogu domeny, ten prosty plik tekstowy zawiera instrukcje wskazujące robotom, czy mogą indeksować określone sekcje witryny. Dla dostępności AI poprawna konfiguracja robots.txt jest kluczowa, ponieważ błędne reguły mogą całkowicie zablokować główne roboty AI, takie jak GPTBot (OpenAI), ClaudeBot (Anthropic) i PerplexityBot (Perplexity). Najważniejsze jest wyraźne zezwolenie tym robotom przy jednoczesnym zabezpieczeniu serwisu przed botami szkodliwymi i ochronie wrażliwych obszarów.

Przykładowa konfiguracja robots.txt dla robotów AI:

# Zezwól wszystkim robotom AI

User-agent: GPTBot

User-agent: ChatGPT-User

User-agent: ClaudeBot

User-agent: Claude-Web

User-agent: PerplexityBot

User-agent: Google-Extended

Allow: /

# Blokuj wrażliwe obszary

Disallow: /admin/

Disallow: /private/

Disallow: /api/

# Mapy witryny

Sitemap: https://yoursite.com/sitemap.xml

Sitemap: https://yoursite.com/ai-sitemap.xml

Taka konfiguracja wyraźnie pozwala głównym robotom AI na dostęp do publicznych treści, jednocześnie chroniąc sekcje administracyjne i prywatne. Dyrektywy Sitemap pomagają robotom szybko odnaleźć najważniejsze podstrony.

Mapa witryny XML to mapa drogowa dla robotów, zawierająca adresy URL do indeksowania oraz metadane o każdej stronie. Dla systemów AI mapy witryny są szczególnie wartościowe, ponieważ pomagają robotom zrozumieć strukturę, priorytetyzować ważne treści i odkrywać strony, które mogłyby zostać pominięte przy standardowym indeksowaniu. W przeciwieństwie do tradycyjnych wyszukiwarek, które mogą wnioskować o strukturze przez linkowanie, roboty AI znacznie zyskują na jasnych wskazówkach, które strony są najważniejsze. Dobrze zbudowana mapa z poprawnymi metadanymi zwiększa szansę na odnalezienie, zrozumienie i cytowanie treści przez AI.

Przykład struktury mapy witryny XML zoptymalizowanej pod AI:

<?xml version="1.0" encoding="UTF-8"?>

<urlset xmlns="http://www.sitemaps.org/schemas/sitemap/0.9">

<!-- Najważniejsze treści dla robotów AI -->

<url>

<loc>https://yoursite.com/about</loc>

<lastmod>2025-01-03</lastmod>

<priority>1.0</priority>

</url>

<url>

<loc>https://yoursite.com/products</loc>

<lastmod>2025-01-03</lastmod>

<priority>0.9</priority>

</url>

<url>

<loc>https://yoursite.com/blog/ai-guide</loc>

<lastmod>2025-01-02</lastmod>

<priority>0.8</priority>

</url>

<url>

<loc>https://yoursite.com/faq</loc>

<lastmod>2025-01-01</lastmod>

<priority>0.7</priority>

</url>

</urlset>

Atrybut priority wskazuje robotom AI, które strony są najważniejsze, a lastmod podaje aktualność treści. Pomaga to systemom AI efektywnie gospodarować zasobami indeksowania i lepiej rozumieć hierarchię treści.

Poza plikami konfiguracyjnymi istnieje szereg barier technicznych utrudniających dostęp robotów AI do Twoich treści. Renderowanie JavaScript to najpoważniejsze wyzwanie, ponieważ nowoczesne frameworki webowe, takie jak React, Vue czy Angular, generują treści dynamicznie w przeglądarce, pozostawiając robotom AI pusty HTML. Cloudflare i podobne narzędzia bezpieczeństwa często domyślnie blokują roboty AI, traktując ich wysoką liczbę zapytań jako potencjalny atak. Limity zapytań utrudniają pełną indeksację, a złożona architektura strony oraz dynamiczne ładowanie treści komplikują nawigację robotów. Na szczęście istnieją skuteczne rozwiązania tych problemów.

Rozwiązania zwiększające dostępność robotów AI:

Systemy AI muszą nie tylko uzyskać dostęp do treści, ale także ją zrozumieć. Ekstrakcja treści to proces sprawdzania, jak skutecznie roboty AI mogą parsować, rozumieć i wydobywać wartościowe informacje ze stron. Kluczowe znaczenie ma tu semantyczna struktura HTML – użycie prawidłowej hierarchii nagłówków, opisowych tekstów i logicznej organizacji, aby przekazać sens. Kiedy treść ma przejrzystą strukturę z czytelnymi nagłówkami (H1, H2, H3), opisowymi akapitami i logicznym podziałem, systemy AI łatwiej identyfikują kluczowe informacje i rozumieją kontekst. Dodatkowo schema markup zapewnia maszynowo czytelne metadane, które jasno określają tematykę treści, radykalnie zwiększając szansę na zrozumienie i cytowanie przez AI.

Właściwa struktura semantyczna obejmuje również stosowanie elementów semantycznych HTML, takich jak <article>, <section>, <nav>, <aside>, zamiast ogólnych <div>. Pomaga to systemom AI rozpoznać przeznaczenie i znaczenie różnych sekcji. W połączeniu z danymi strukturalnymi (schema FAQ, Product, Organization) treść staje się znacznie bardziej dostępna dla AI i ma większą szansę pojawienia się w odpowiedziach generowanych przez sztuczną inteligencję.

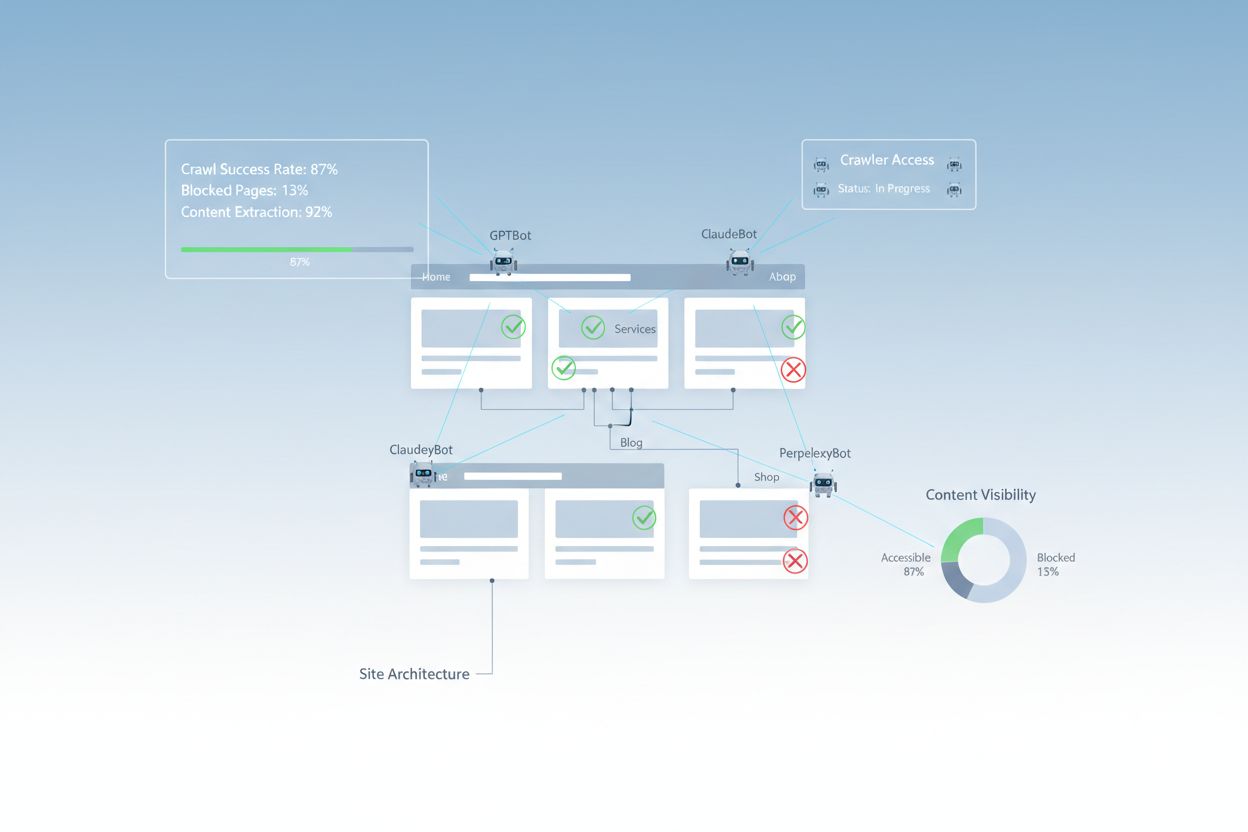

Po wdrożeniu usprawnień należy zweryfikować, czy roboty AI rzeczywiście mają dostęp do Twoich treści i monitorować efekty. Logi serwera dostarczają bezpośrednich dowodów aktywności robotów – pokazują, które boty odwiedziły stronę, jakie podstrony przeglądały i czy napotkały błędy. Google Search Console umożliwia wgląd w interakcje robotów Google z Twoją stroną, natomiast specjalistyczne narzędzia do monitorowania widoczności AI śledzą, jak Twoje treści są prezentowane w różnych platformach AI. AmICited.com monitoruje, jak systemy AI cytują Twoją markę w ChatGPT, Perplexity oraz Google AI Overviews, wykazując, które strony są cytowane i jak często.

Narzędzia i metody monitorowania dostępu robotów AI:

Optymalizacja strony pod kątem dostępności dla robotów AI wymaga strategicznego, ciągłego podejścia. Najlepiej traktować dostępność AI nie jako jednorazowy projekt, lecz jako stały proces monitorowania i ulepszania. Najskuteczniejsza strategia łączy poprawną konfigurację techniczną z optymalizacją treści, gwarantując gotowość zarówno infrastruktury, jak i materiałów do współpracy z AI.

Zalecenia dla dostępności AI:

Czego unikać w dostępności AI:

Najskuteczniejsza strategia dostępności dla AI traktuje roboty jako partnerów w dystrybucji treści, a nie zagrożenie do blokowania. Zapewniając techniczną poprawność, właściwą konfigurację i przejrzystą strukturę semantyczną strony, maksymalizujesz szansę, że systemy AI odnajdą, zrozumieją i zacytują Twoje treści w odpowiedziach dla użytkowników.

Audyt dostępności dla AI skupia się na strukturze semantycznej, treściach czytelnych maszynowo oraz wartości cytowania dla systemów AI, podczas gdy tradycyjne audyty SEO kładą nacisk na słowa kluczowe, linki zwrotne i pozycje w wyszukiwarkach. Audyty AI sprawdzają, czy roboty mogą uzyskać dostęp i zrozumieć treści, natomiast audyty SEO analizują czynniki wpływające na pozycjonowanie w wynikach Google.

Sprawdź logi serwera pod kątem user agentów robotów AI, takich jak GPTBot, ClaudeBot i PerplexityBot. Skorzystaj z Google Search Console, aby monitorować aktywność indeksowania, przetestuj plik robots.txt za pomocą narzędzi walidacyjnych i użyj specjalnych platform, takich jak AmICited, aby śledzić, jak systemy AI cytują Twoje treści na różnych platformach.

Do najczęstszych barier należą ograniczenia renderowania JavaScript (roboty AI nie mogą wykonywać kodu JavaScript), blokowanie przez Cloudflare i narzędzia bezpieczeństwa (35% stron korporacyjnych blokuje roboty AI), limity zapytań uniemożliwiające pełną indeksację, złożona architektura strony oraz dynamiczne ładowanie treści. Każda bariera wymaga innych rozwiązań.

Większość firm odnosi korzyści z udostępniania strony robotom AI, ponieważ zwiększa to widoczność marki w wynikach wyszukiwania opartych na AI i interfejsach konwersacyjnych. Decyzja powinna jednak zależeć od strategii treści, pozycji konkurencyjnej i celów biznesowych. Możesz użyć robots.txt, aby selektywnie zezwalać określonym robotom, jednocześnie blokując inne zgodnie z własnymi potrzebami.

Przeprowadzaj kompleksowy audyt co kwartał lub za każdym razem, gdy wprowadzisz istotne zmiany w architekturze strony, strategii treści lub konfiguracji bezpieczeństwa. Monitoruj aktywność robotów na bieżąco za pomocą logów serwera i specjalistycznych narzędzi. Aktualizuj robots.txt i mapy witryny za każdym razem, gdy publikujesz nowe sekcje lub zmieniasz strukturę adresów URL.

Robots.txt to główny mechanizm kontroli dostępu robotów AI. Odpowiednia konfiguracja wyraźnie pozwala głównym robotom AI (GPTBot, ClaudeBot, PerplexityBot) na dostęp, chroniąc jednocześnie wrażliwe obszary. Błędnie skonfigurowany robots.txt może całkowicie zablokować roboty AI, uniemożliwiając indeksację treści niezależnie od jej jakości.

Chociaż optymalizacja techniczna jest istotna, widoczność w AI można również poprawić przez optymalizację treści—stosowanie semantycznej struktury HTML, wdrożenie schema markup, poprawę linkowania wewnętrznego i zapewnienie kompletności treści. Jednak bariery techniczne, takie jak renderowanie JavaScript czy blokowanie przez narzędzia bezpieczeństwa, zwykle wymagają rozwiązań technicznych dla pełnej dostępności AI.

Używaj analizy logów serwera do śledzenia aktywności robotów, Google Search Console do statystyk indeksowania, walidatorów robots.txt do weryfikacji konfiguracji, walidatorów schema markup do sprawdzania danych strukturalnych oraz specjalnych platform, takich jak AmICited, do monitorowania cytowań AI. Wiele narzędzi SEO, np. Screaming Frog, oferuje także symulację pracy robotów pod kątem testowania dostępności dla AI.

Śledź, jak ChatGPT, Perplexity, Google AI Overviews i inne systemy AI cytują Twoją markę dzięki AmICited. Uzyskaj wgląd w czasie rzeczywistym w swoją widoczność w wyszukiwarkach AI i zoptymalizuj strategię treści.

Dowiedz się, czym jest audyt treści AI, czym różni się od tradycyjnych audytów treści oraz dlaczego monitorowanie obecności Twojej marki w wyszukiwarkach AI, ta...

Poznaj kompletną, krok po kroku metodologię przeprowadzania audytu widoczności w AI. Dowiedz się, jak mierzyć wzmianki o marce, cytowania oraz widoczność w Chat...

Dowiedz się, czym są audyty konkurencji w AI, dlaczego są ważne dla pozycji konkurencyjnej i jak analizować widoczność konkurencji w ChatGPT, Perplexity i Googl...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.