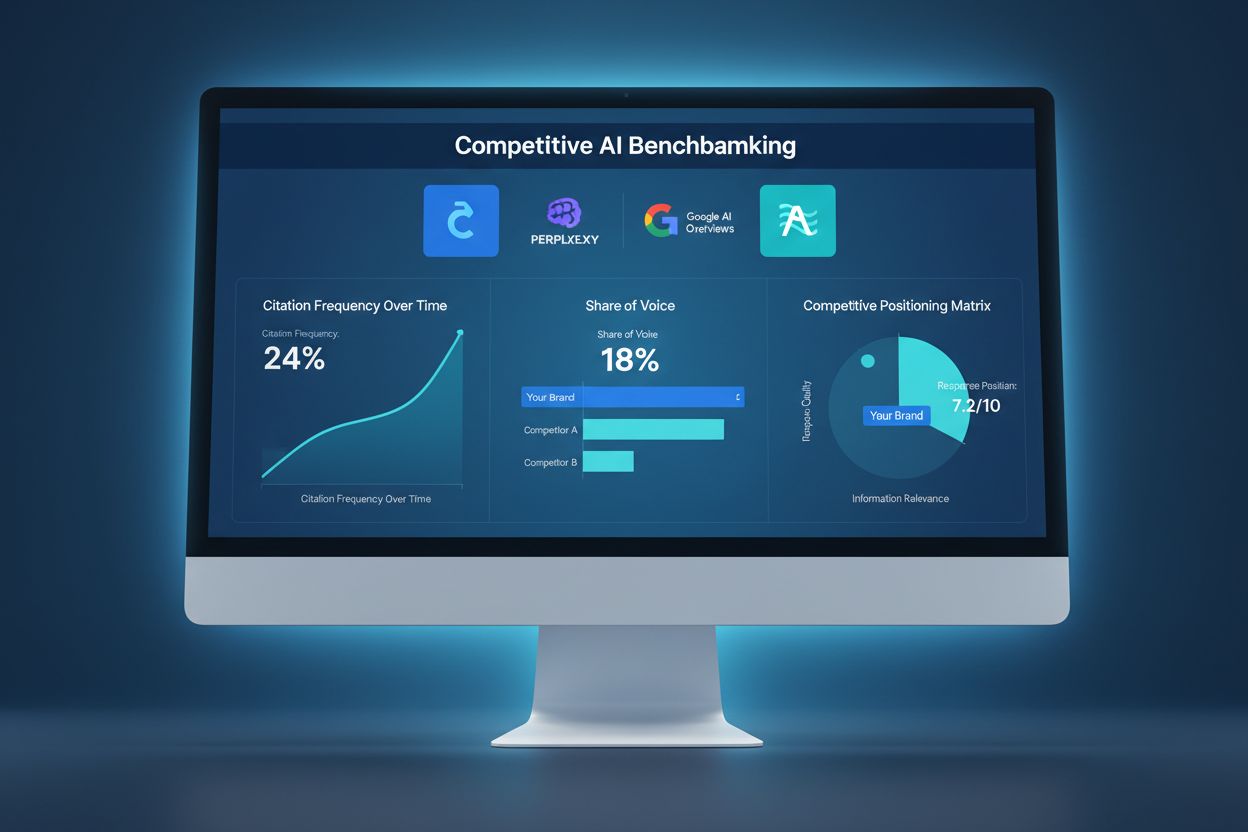

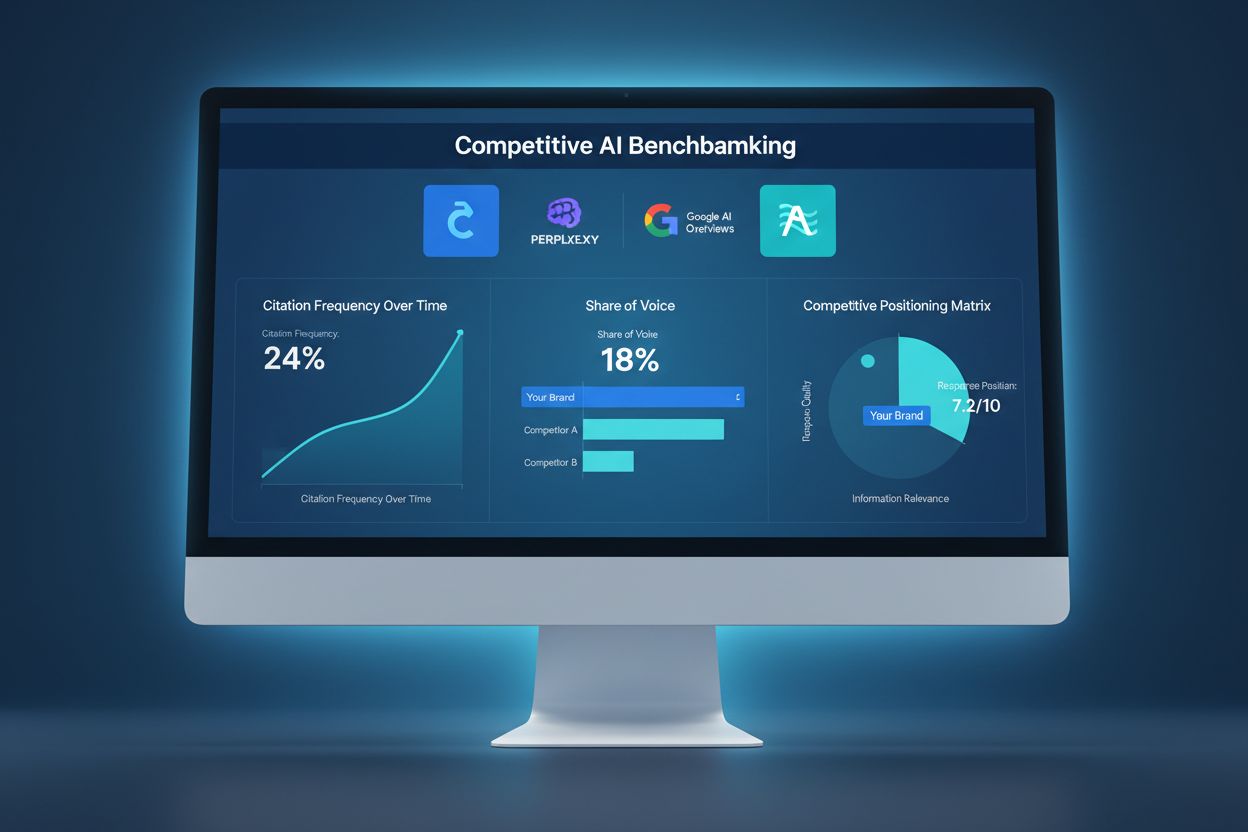

Konkurencyjne benchmarkowanie AI

Dowiedz się, jak porównywać widoczność swojej marki w AI na tle konkurencji. Monitoruj cytowania, udział głosu oraz pozycjonowanie konkurencyjne w ChatGPT, Perp...

Sabotaż AI w konkurencji odnosi się do celowych prób konkurentów, mających na celu negatywny wpływ na widoczność, sentyment lub wyniki marki w wynikach wyszukiwania opartych na AI oraz odpowiedziach chatbotów. Obejmuje to zatruwanie danych, fałszywe recenzje, kampanie dezinformacyjne i manipulację danymi treningowymi AI w celu zaszkodzenia reputacji marki i ograniczenia cytowań przez AI.

Sabotaż AI w konkurencji odnosi się do celowych prób konkurentów, mających na celu negatywny wpływ na widoczność, sentyment lub wyniki marki w wynikach wyszukiwania opartych na AI oraz odpowiedziach chatbotów. Obejmuje to zatruwanie danych, fałszywe recenzje, kampanie dezinformacyjne i manipulację danymi treningowymi AI w celu zaszkodzenia reputacji marki i ograniczenia cytowań przez AI.

Sabotaż AI w konkurencji odnosi się do celowych prób manipulowania, zatruwania lub korumpowania danych, z których wyszukiwarki AI i modele językowe korzystają do generowania wyników i cytowań. W przeciwieństwie do tradycyjnego negatywnego SEO, które koncentruje się na obniżaniu pozycji stron konkurencji za pomocą schematów linkowania lub technicznych exploitów, sabotaż AI celuje w dane treningowe i źródła, na których polegają systemy AI, by udzielać odpowiedzi. To rozróżnienie jest kluczowe, ponieważ systemy AI, takie jak Google AI Overviews, Perplexity i GPT, cytują źródła bezpośrednio ze swoich danych treningowych, co czyni je podatnymi na skoordynowane kampanie dezinformacyjne. Skutki w rzeczywistości są znaczące: 60% wyszukiwań kończy się bez kliknięcia w stronę internetową, a konkurenci mogą teraz zatruwać wyniki AI, by przekierować ruch, zaszkodzić reputacji marki lub promować fałszywe informacje, nie ingerując w tradycyjne pozycje w wyszukiwarkach.

Sabotaż AI w konkurencji działa poprzez kilka powiązanych wektorów ataku, które wykorzystują sposób, w jaki systemy AI pobierają i przetwarzają informacje. Zatruwanie danych to podstawowa technika, polegająca na wprowadzaniu fałszywych, mylących lub złośliwych informacji do źródeł, z których systemy AI korzystają podczas treningu — takich jak publiczne bazy danych, fora, serwisy z recenzjami i agregatory wiadomości. Atakujący stosują odwracanie etykiet (zmiana metadanych w celu błędnej klasyfikacji treści), wstrzykiwanie danych (dodawanie fałszywych wpisów do baz danych) oraz ataki z backdoorem (umieszczanie ukrytych wyzwalaczy w danych treningowych). Konkurenci prowadzą także skoordynowane kampanie fałszywych recenzji, zalewając platformy sfabrykowanymi opiniami, jednocześnie rozpowszechniając dezinformację i deepfake’i przez media społecznościowe, blogi i treści indeksowane przez AI. Słabością jest fakt, że systemy AI często ufają ilości i spójności informacji, zamiast weryfikować ich autentyczność. Oto porównanie różnych metod sabotażu:

| Metoda | Jak działa | Wpływ na AI | Trudność wykrycia |

|---|---|---|---|

| Zatruwanie danych | Podawanie fałszywych informacji do zbiorów treningowych | AI cytuje zatrute źródła bezpośrednio w wynikach | Wysoka – wymaga analizy danych |

| Fałszywe recenzje | Skoordynowane ataki recenzjami na platformach | Zniekształca analizę sentymentu i rekomendacje AI | Średnia – analiza wzorców pomaga |

| Kampanie dezinformacyjne | Rozpowszechnianie fałszywych twierdzeń na indeksowanych stronach | AI wzmacnia fałszywe narracje w wynikach | Wysoka – wymaga fact-checkingu |

| Deepfake’i | Tworzenie syntetycznych mediów osób lub produktów | Szkodzi wiarygodności marki, gdy AI je cytuje | Bardzo wysoka – wymaga weryfikacji |

| Przejęcie katalogów | Przejęcie wizytówek konkurencji | AI pobiera fałszywe dane z przejętych katalogów | Średnia – weryfikacja pomaga |

| Fałszywe artykuły | Publikowanie sfabrykowanych treści na stronach przypominających newsy | AI traktuje je jako autorytatywne źródła | Wysoka – wymaga weryfikacji źródła |

Systemy AI są zasadniczo bardziej podatne na sabotaż niż tradycyjne wyszukiwarki, ponieważ ufają danym treningowym bardziej bezkrytycznie niż ludzie. Podczas gdy algorytm Google ocenia autorytet linków i reputację domeny, modele AI uczą się po prostu wzorców z wszelkich dostępnych danych — co czyni je podatnymi na skoordynowane ataki. Badania pokazują, że już 250 złośliwych dokumentów może zatruć model AI, co stanowi znacznie niższą barierę wejścia niż w przypadku tradycyjnych ataków SEO. Problem pogłębia fakt, że systemy AI cytują źródła bezpośrednio, przez co zatrute dane nie tylko wpływają na wyniki — stają się autorytatywną odpowiedzią widoczną dla użytkowników. Wykrycie zatrutych danych jest nieporównywalnie trudniejsze niż zidentyfikowanie złego linku, ponieważ manipulacja zachodzi na poziomie treningu i często jest niewidoczna dla zewnętrznych audytorów. Przy wzroście ruchu z wyszukiwań AI o 527% w ciągu zaledwie pięciu miesięcy (styczeń–maj 2025) i 79% Amerykanów ufających wyszukiwarkom AI, motywacja konkurencji do sabotażu jest większa niż kiedykolwiek, a infrastruktura bezpieczeństwa wciąż pozostaje w tyle.

Najbardziej znany przypadek sabotażu AI miał miejsce, gdy Target padł ofiarą skoordynowanej kampanii dezinformacyjnej, która fałszywie sugerowała, że sprzedaje „dziecięcą odzież o tematyce satanistycznej”. Systemy AI, wytrenowane na tej sfabrykowanej narracji, zaczęły wyświetlać te fałszywe twierdzenia w wynikach wyszukiwania i podsumowaniach AI, powodując poważne szkody reputacyjne, zanim firma zdążyła zareagować. Podobne ataki dotknęły systemy pocztowe przez zatruwanie filtrów antyspamowych, gdzie konkurenci wprowadzali złośliwe wzorce do danych treningowych, powodując oznaczanie legalnych wiadomości jako spam. Bombardowanie recenzjami przez konkurencję stało się powszechne — firmy masowo wystawiają fałszywie negatywne opinie konkurencji, które AI agreguje w oceny sentymentu. Przejęcie wizytówek w katalogach to kolejny wektor, gdzie atakujący przejmują profile konkurencji w Google Moja Firma lub branżowych katalogach, po czym umieszczają fałszywe informacje indeksowane i cytowane przez AI. Te przypadki pokazują, że sabotaż AI to nie teoria — realnie szkodzi firmom już dziś, a szkody są spotęgowane przez to, że wyniki AI są postrzegane jako autorytatywne i często są pierwszą widoczną informacją.

Wykrywanie sabotażu AI w konkurencji wymaga wielopoziomowego monitoringu, który śledzi, jak Twoja marka pojawia się w wynikach AI i źródłach cytowań. Pierwszym krokiem jest ciągłe monitorowanie wyników AI dla Twojej marki, produktów i kluczowych osób na platformach takich jak Google AI Overviews, Perplexity, ChatGPT i Claude. Śledzenie sentymentu w indeksowanych źródłach pozwala wykryć nagłe zmiany w sposobie omawiania marki — to sygnał ostrzegawczy dla skoordynowanych kampanii dezinformacyjnych. Identyfikacja fałszywych recenzji polega na analizie wzorców opinii pod kątem anomalii statystycznych, takich jak nagłe wzrosty ocen jedno-gwiazdkowych czy powielanie tego samego języka. Wczesne wykrycie jest kluczowe; badania pokazują, że pierwsze 48 godzin od rozpoczęcia ataku jest decydujące dla ograniczenia skutków. Monitoring powinien również śledzić, które źródła są cytowane przez AI na temat Twojej marki, co pozwala wykryć zatrute dane zanim spowodują szerokie szkody. Oto kluczowe metody wykrywania:

Budowanie odporności na sabotaż AI w konkurencji wymaga proaktywnej, wieloaspektowej strategii wykraczającej poza tradycyjne zarządzanie reputacją. Tworzenie wysokiej jakości, autorytatywnych treści to najsilniejsza obrona — systemy AI uczą się rozpoznawać i priorytetyzować treści od uznanych, wiarygodnych źródeł, przez co zatrute dane mają trudniej konkurować z prawdziwymi informacjami. Wzmacnianie prawdziwych informacji na wielu platformach indeksowanych sprawia, że AI — szukając danych o Twojej marce — natrafia na spójne, rzetelne komunikaty od autorytetów. Zabezpieczenie obecności marki oznacza przejęcie i weryfikację wszystkich wizytówek firmowych, profili społecznościowych i katalogów branżowych, by zapobiec atakom przejęcia. Wdróż zaawansowane systemy monitoringu, pozwalające śledzić markę w wynikach AI w czasie rzeczywistym i szybko reagować na zagrożenia. Opracuj procedury reagowania określające, jak zespół postępuje po wykryciu sabotażu (dokumentacja, zgłoszenia na platformach, działania prawne). Budowanie relacji z dziennikarzami, influencerami branżowymi i zaufanymi publikacjami tworzy dodatkowe warstwy wiarygodności rozpoznawane i premiowane przez AI.

Dedykowane platformy monitorujące AI stały się kluczową infrastrukturą do ochrony marki w dobie wyszukiwania AI. Narzędzia te zapewniają alerty w czasie rzeczywistym, gdy Twoja marka pojawia się w wynikach AI, pozwalając śledzić nie tylko pozycje, lecz także rzeczywiste cytowania i źródła wykorzystywane przez systemy AI. AmICited.com wyróżnia się jako kompleksowe rozwiązanie zaprojektowane specjalnie do monitorowania, jak Twoja marka, produkty i osoby są cytowane w wyszukiwarkach AI — w tym Google AI Overviews, Perplexity i GPT. Platforma śledzi, które źródła są cytowane przez AI na temat Twojej marki, umożliwiając wykrycie zatrutych danych i reakcję zanim spowodują szkody. Integracja z szerszą strategią bezpieczeństwa marki pozwala korelować wzorce cytowań AI z tradycyjnymi wskaźnikami wyszukiwania, sentymentem w mediach społecznościowych i recenzjami, uzyskując pełny obraz otoczenia konkurencyjnego. Łącząc monitoring AI z narzędziami do zarządzania reputacją, tworzysz zintegrowany system obrony, który wcześnie wykrywa próby sabotażu i dostarcza danych do szybkiej reakcji.

Wraz ze wzrostem skali sabotażu AI w konkurencji, ramy prawne ewoluują, by adresować te nowe zagrożenia. Zgłoszenia DMCA mogą służyć do usuwania zatrutych treści ze źródeł indeksowanych, choć proces jest często powolny i wymaga jasnych dowodów naruszenia praw autorskich lub podszywania się. Prawo dotyczące zniesławienia daje możliwości w przypadku sabotażu polegającego na fałszywych twierdzeniach szkodzących reputacji, choć udowodnienie szkód w kontekście AI pozostaje skomplikowane. Większość dużych platform posiada obecnie mechanizmy zgłaszania nadużyć AI, w tym zatruwania danych, fałszywych recenzji i kampanii dezinformacyjnych, choć egzekwowanie tych zasad jest zróżnicowane. Pojawiające się regulacje, takie jak EU AI Act czy planowane przepisy w USA, zaczynają tworzyć ramy odpowiedzialności dla systemów AI wzmacniających fałszywe informacje, co może otworzyć nowe możliwości dochodzenia roszczeń prawnych. Firmy powinny skrupulatnie dokumentować wszelkie próby sabotażu — ta dokumentacja jest kluczowa zarówno w postępowaniach sądowych, jak i w odwołaniach do platform. Konsultacje z prawnikami doświadczonymi w AI i reputacji cyfrowej stają się coraz ważniejsze przy opracowywaniu strategii zgodnych z nowymi regulacjami.

Krajobraz sabotażu AI w konkurencji będzie nadal ewoluował wraz z rozwojem coraz bardziej zaawansowanych technik zarówno po stronie atakujących, jak i obrońców. Fałszywe recenzje generowane przez AI przy wykorzystaniu dużych modeli językowych będą coraz trudniejsze do odróżnienia od autentycznych opinii, co wymusi wdrożenie zaawansowanych systemów detekcji. Weryfikacja oparta na blockchainie i zdecentralizowane systemy wiarygodności pojawiają się jako potencjalne rozwiązania do potwierdzania autentyczności źródeł, zanim zostaną wykorzystane przez AI w treningu. Dostawcy platform inwestują w ulepszone zabezpieczenia, w tym lepszą walidację danych, weryfikację źródeł i algorytmy wykrywające zatruwanie, choć środki te zawsze będą krok za nowymi wektorami ataku. Systemy weryfikacji społecznościowej, gdzie użytkownicy i eksperci oznaczają podejrzane treści, mogą stać się standardem, tworząc społecznościową barierę przed sabotażem. Przewagę konkurencyjną zyskają firmy, które wyprzedzają nowe zagrożenia poprzez ciągły monitoring, szybkie procedury reagowania i inwestowanie w edukację AI wśród swoich zespołów. Organizacje, które już dziś traktują monitoring AI jako kluczowy element ochrony marki, będą najlepiej przygotowane do obrony przed coraz bardziej wyrafinowanymi atakami w przyszłości.

Tradycyjne negatywne SEO koncentruje się na manipulacji linkami i kopiowaniu treści w celu obniżenia pozycji w wyszukiwarce. Sabotaż AI w konkurencji atakuje dane treningowe AI i zachowanie modeli, zatruwając źródła, które są cytowane przez systemy AI w odpowiedziach. Systemy AI są bardziej podatne, ponieważ bezpośrednio cytują źródła i bardziej ufają danym treningowym niż tradycyjne algorytmy wyszukiwarek.

Monitoruj, jak platformy AI opisują Twoją markę co tydzień, korzystając z narzędzi takich jak AmICited.com. Zwróć uwagę na nagłe zmiany sentymentu, pojawianie się fałszywych twierdzeń w odpowiedziach AI, skoordynowane negatywne recenzje lub rozprzestrzenianie się dezinformacji na różnych platformach. Wczesne wykrycie w ciągu pierwszych 48 godzin jest kluczowe dla ograniczenia skutków.

Udokumentuj wszystko natychmiast, wykonując zrzuty ekranu i notując znaczniki czasowe. Zgłoś sprawę do zaatakowanych platform (OpenAI, Google, Anthropic). Nagłaśniaj prawdziwe informacje na własnych kanałach. Skontaktuj się z prawnikiem, jeśli doszło do zniesławienia lub szkód finansowych. Wdróż systemy monitoringu, aby szybko wykrywać kolejne ataki.

Badania pokazują, że atakujący potrzebują jedynie 250 złośliwych dokumentów lub 7-8% zbioru danych, by znacząco zatruć modele AI. Tak niska bariera wejścia sprawia, że systemy AI są szczególnie podatne w porównaniu do tradycyjnych wyszukiwarek, które mają bardziej zaawansowane mechanizmy wykrywania spamu.

Obecne platformy AI mają ograniczone możliwości wykrywania i głównie polegają na zgłoszeniach użytkowników oraz okresowym retrenowaniu na czystych danych. Jednak platformy wdrażają coraz lepsze systemy weryfikacji, detekcji anomalii i kontroli dostępu. Odpowiedzialność za wczesne wykrycie często spoczywa na samych markach.

Buduj silną, autentyczną reputację poprzez wysokiej jakości treści, regularnie monitoruj wyniki wyszukiwania AI, zabezpiecz obecność marki w katalogach, wdrażaj systemy monitorowania w czasie rzeczywistym i szybko reaguj na ataki. Prewencja przez budowanie reputacji jest skuteczniejsza niż działania naprawcze po sabotażu.

AmICited.com monitoruje, jak platformy AI (ChatGPT, Perplexity, Google AI Overviews) odnoszą się do Twojej marki, śledząc zmiany sentymentu i wzorce cytowań. Powiadomienia w czasie rzeczywistym informują o nagłych zmianach w opisach Twojej marki przez AI, umożliwiając szybką reakcję na próby sabotażu.

Możesz wystąpić z pozwem o zniesławienie, złożyć zgłoszenie DMCA dotyczące fałszywych treści, zgłosić naruszenia regulaminu na platformach oraz potencjalnie domagać się odszkodowania za szkody finansowe. Kluczowa jest dokumentacja sabotażu. Skonsultuj się z prawnikiem specjalizującym się w prawach cyfrowych i własności intelektualnej.

Chroń swoją markę przed sabotażem AI w konkurencji dzięki monitorowaniu w czasie rzeczywistym na platformach ChatGPT, Perplexity i Google AI Overviews. Wykrywaj zagrożenia zanim zaszkodzą Twojej reputacji.

Dowiedz się, jak porównywać widoczność swojej marki w AI na tle konkurencji. Monitoruj cytowania, udział głosu oraz pozycjonowanie konkurencyjne w ChatGPT, Perp...

Dyskusja społeczności na temat czarnych technik, które szkodzą widoczności w AI. Prawdziwe spostrzeżenia o zatruwaniu AI, manipulacji treścią i ochronie marki....

Dowiedz się, jak monitorować pojawianie się konkurencji w ChatGPT, Perplexity, Claude i innych wyszukiwarkach AI. Odkryj narzędzia i strategie do śledzenia wido...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.