Budżet indeksowania

Budżet indeksowania to liczba stron, które wyszukiwarki przeszukują na Twojej stronie w określonym przedziale czasu. Dowiedz się, jak zoptymalizować budżet inde...

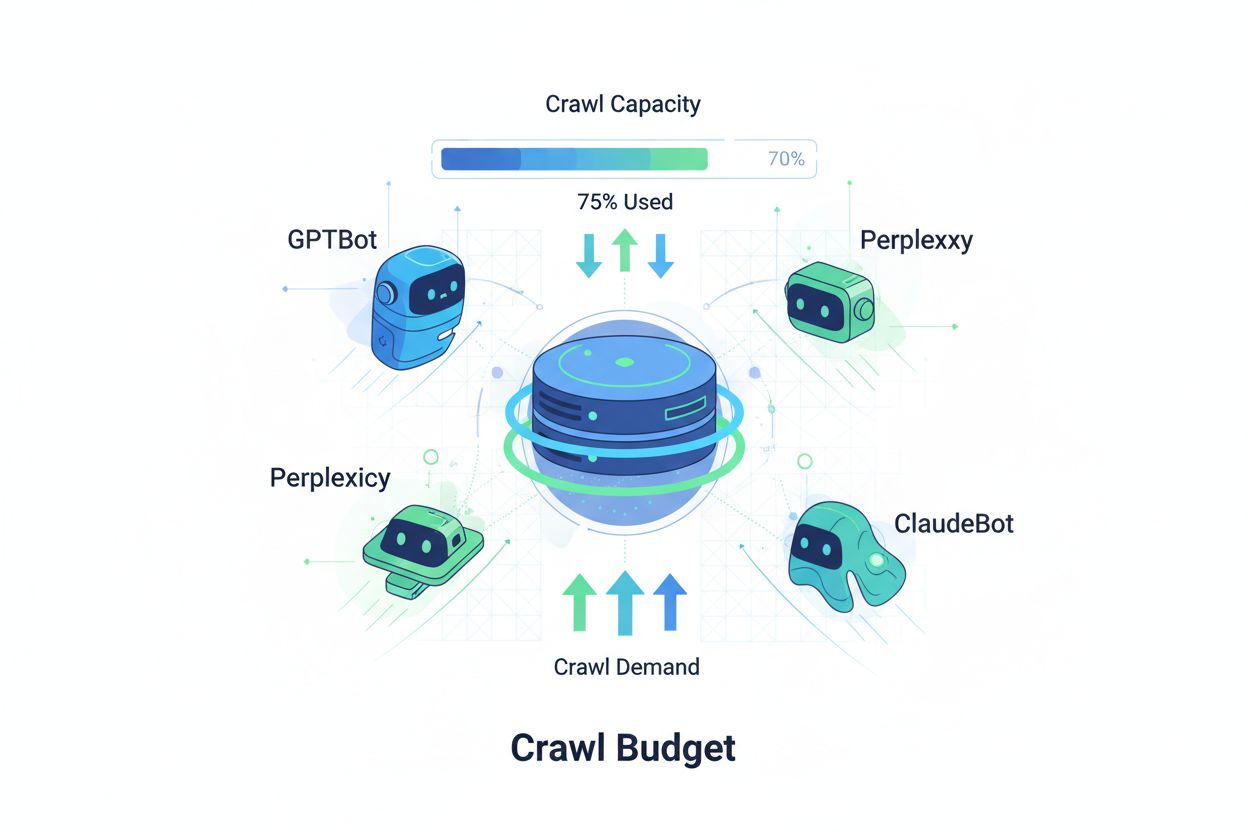

Techniki zapewniające, że roboty AI efektywnie uzyskują dostęp i indeksują najważniejsze treści na stronie internetowej w ramach swojego limitu indeksowania. Optymalizacja budżetu indeksowania zarządza równowagą między pojemnością indeksowania (zasoby serwera) a zapotrzebowaniem na indeksowanie (żądania botów), aby zmaksymalizować widoczność w odpowiedziach generowanych przez AI, jednocześnie kontrolując koszty operacyjne i obciążenie serwera.

Techniki zapewniające, że roboty AI efektywnie uzyskują dostęp i indeksują najważniejsze treści na stronie internetowej w ramach swojego limitu indeksowania. Optymalizacja budżetu indeksowania zarządza równowagą między pojemnością indeksowania (zasoby serwera) a zapotrzebowaniem na indeksowanie (żądania botów), aby zmaksymalizować widoczność w odpowiedziach generowanych przez AI, jednocześnie kontrolując koszty operacyjne i obciążenie serwera.

Budżet indeksowania odnosi się do ilości zasobów—mierzonych liczbą żądań i przepustowością—przydzielanych przez wyszukiwarki i boty AI na indeksowanie Twojej strony internetowej. Tradycyjnie pojęcie to dotyczyło głównie zachowania Google, lecz pojawienie się botów opartych o AI zasadniczo zmieniło sposób, w jaki organizacje muszą podchodzić do zarządzania budżetem indeksowania. Równanie budżetu indeksowania składa się z dwóch kluczowych zmiennych: pojemności indeksowania (maksymalna liczba stron, które bot może zindeksować) oraz zapotrzebowania na indeksowanie (rzeczywista liczba stron, które bot chce zindeksować). W erze AI dynamika ta stała się znacznie bardziej złożona, ponieważ boty takie jak GPTBot (OpenAI), Perplexity Bot i ClaudeBot (Anthropic) konkurują o zasoby serwera obok tradycyjnych robotów wyszukiwarek. Boty AI działają według innych priorytetów i schematów niż Googlebot, często zużywając znacznie więcej przepustowości i dążąc do innych celów indeksowania, przez co optymalizacja budżetu indeksowania nie jest już opcjonalna, lecz niezbędna do utrzymania wydajności strony i kontroli kosztów operacyjnych.

Roboty AI zasadniczo różnią się od tradycyjnych botów wyszukiwarek pod względem wzorców indeksowania, częstotliwości oraz zużycia zasobów. Podczas gdy Googlebot respektuje limity budżetu indeksowania i stosuje zaawansowane mechanizmy ograniczające, boty AI często wykazują bardziej agresywne zachowania, czasem wielokrotnie pobierając te same treści i mniej zwracając uwagę na sygnały obciążenia serwera. Badania pokazują, że GPTBot od OpenAI może zużyć 12-15 razy więcej przepustowości niż robot Google na niektórych stronach, szczególnie tych z dużą ilością treści lub często aktualizowanymi stronami. To agresywne podejście wynika z wymagań treningowych AI—boty te muszą stale pobierać świeże treści, aby poprawiać wydajność modeli, co stanowi zupełnie inne podejście do indeksowania niż wyszukiwarki nastawione na przeszukiwanie do celów wyszukiwania. Wpływ na serwer jest znaczący: organizacje odnotowują istotny wzrost kosztów przepustowości, wykorzystania CPU i obciążenia serwera bezpośrednio przypisywany ruchowi botów AI. Dodatkowo, kumulacja indeksowania przez wiele botów AI jednocześnie może pogarszać doświadczenie użytkownika, spowalniać ładowanie strony i podnosić koszty hostingu, przez co rozróżnienie między tradycyjnymi a AI botami staje się kluczową kwestią biznesową, a nie tylko techniczną ciekawostką.

| Charakterystyka | Tradycyjne roboty (Googlebot) | Roboty AI (GPTBot, ClaudeBot) |

|---|---|---|

| Częstotliwość indeksowania | Adaptacyjna, respektuje budżet | Agresywna, ciągła |

| Zużycie przepustowości | Umiarkowane, zoptymalizowane | Wysokie, zasobożerne |

| Respektowanie robots.txt | Ścisłe przestrzeganie | Zmienna zgodność |

| Zachowanie cache’owania | Zaawansowane cache’owanie | Częste powtórne zapytania |

| Identyfikacja user-agent | Jasna, spójna | Czasem maskowana |

| Cel biznesowy | Indeksowanie wyszukiwarki | Trening modelu/pozyskiwanie danych |

| Wpływ kosztowy | Minimalny | Znaczny (12-15x wyższy) |

Zrozumienie budżetu indeksowania wymaga opanowania jego dwóch podstawowych składników: pojemności indeksowania i zapotrzebowania na indeksowanie. Pojemność indeksowania to maksymalna liczba adresów URL, które Twój serwer może obsłużyć w określonym czasie, na co wpływają różne powiązane czynniki. Ta pojemność zależy od:

Zapotrzebowanie na indeksowanie natomiast to liczba stron, które boty rzeczywiście chcą zindeksować, zależnie od cech treści i priorytetów botów. Wpływ na zapotrzebowanie mają:

Wyzwanie optymalizacyjne pojawia się, gdy zapotrzebowanie na indeksowanie przekracza pojemność—boty muszą wybierać, które strony indeksować, potencjalnie pomijając istotne aktualizacje. Z kolei, gdy pojemność znacząco przewyższa zapotrzebowanie, marnujesz zasoby serwera. Celem jest osiągnięcie efektywności indeksowania: maksymalizowanie indeksowania ważnych stron przy minimalizowaniu marnotrawstwa na treści o niskiej wartości. Równowaga ta staje się coraz bardziej złożona w erze AI, gdzie różne typy botów o różnych priorytetach konkurują o te same zasoby, wymagając zaawansowanych strategii alokacji budżetu indeksowania dla wszystkich interesariuszy.

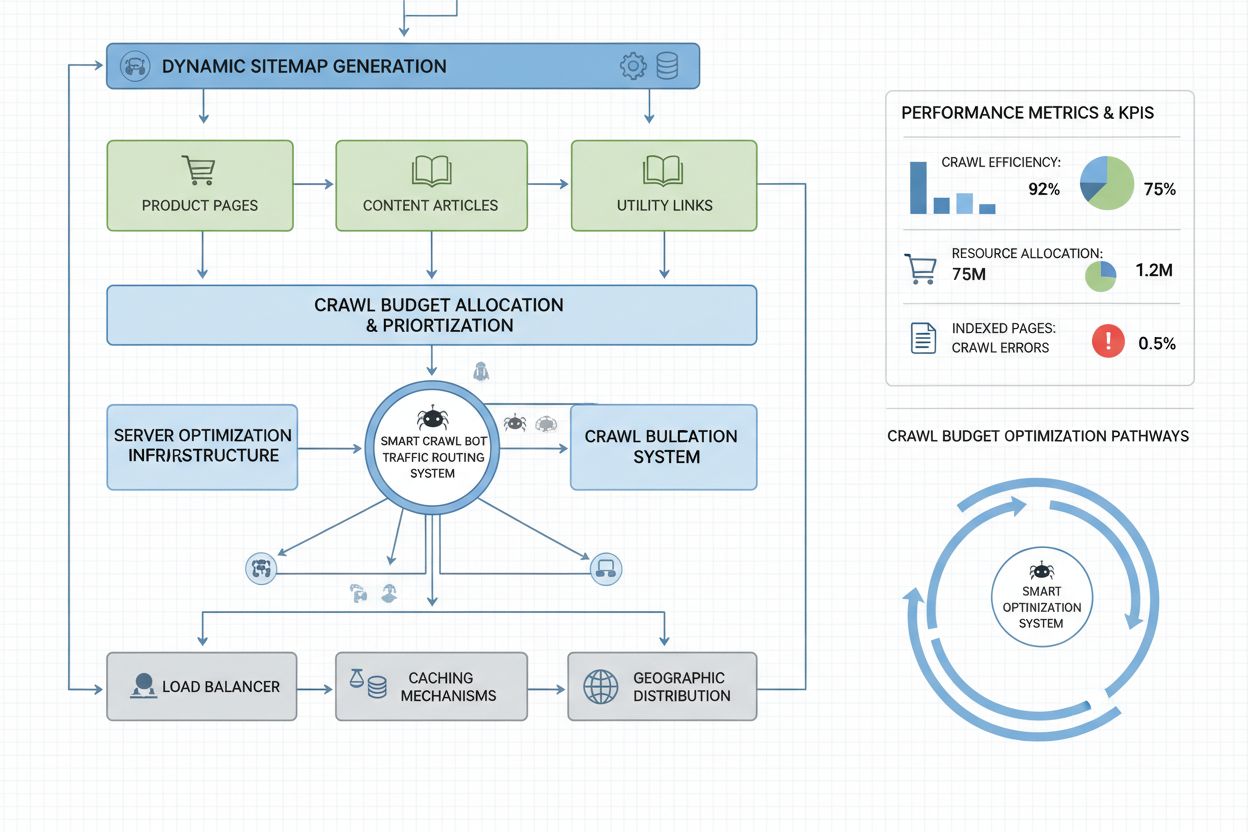

Pomiar wydajności budżetu indeksowania zaczyna się od Google Search Console, która w sekcji „Ustawienia” prezentuje statystyki indeksowania: dzienne żądania, pobrane bajty i czasy odpowiedzi. Aby obliczyć współczynnik efektywności indeksowania, podziel liczbę udanych indeksowań (odpowiedzi HTTP 200) przez całkowitą liczbę żądań indeksowania—na zdrowych stronach współczynnik ten wynosi zwykle 85-95%. Wzór na podstawową efektywność indeksowania to: (Udane indeksowania ÷ Całkowita liczba żądań) × 100 = Efektywność indeksowania w %. Oprócz danych Google praktyczne monitorowanie obejmuje:

Dla monitoringu botów AI narzędzia takie jak AmICited.com umożliwiają specjalistyczne śledzenie aktywności GPTBot, ClaudeBot i Perplexity Bot, pokazując, które strony te boty priorytetyzują i jak często wracają. Warto także wdrożyć własne alerty na nietypowe skoki indeksowania—szczególnie przez boty AI—by szybko reagować na nieoczekiwane zużycie zasobów. Kluczową metryką jest koszt indeksowania na stronę: dzieląc całkowite zużycie zasobów serwera przez liczbę unikalnych stron zindeksowanych, dowiesz się, czy efektywnie wykorzystujesz budżet, czy marnujesz go na treści o niskiej wartości.

Optymalizacja budżetu indeksowania dla botów AI wymaga wielowarstwowego podejścia łączącego wdrożenia techniczne z decyzjami strategicznymi. Główne taktyki optymalizacyjne to:

Strategia wyboru taktyki zależy od modelu biznesowego i strategii treści. Sklepy internetowe mogą blokować boty AI na stronach produktów, by zapobiec trenowaniu konkurencji na swoich danych, podczas gdy wydawcy treści mogą zezwalać na indeksowanie, by zyskać widoczność w odpowiedziach AI. Dla stron, które odczuwają realne przeciążenie serwera przez boty AI, najbardziej bezpośrednim rozwiązaniem jest blokada specyficzna dla user-agenta w robots.txt: User-agent: GPTBot oraz Disallow: / uniemożliwia GPTBotowi OpenAI dostęp do strony. Traci się jednak wtedy potencjalną widoczność w odpowiedziach ChatGPT i innych AI. Bardziej wyważona strategia to selektywna blokada: pozwolenie botom AI na dostęp do treści publicznych, a blokada wrażliwych sekcji, archiwów lub duplikatów, które nie wnoszą wartości ani dla bota, ani użytkowników.

Strony o skali enterprise, zarządzające milionami stron, wymagają bardziej zaawansowanych strategii optymalizacji budżetu niż podstawowa konfiguracja robots.txt. Dynamiczne mapy witryny to kluczowy krok naprzód—mapy generowane są w czasie rzeczywistym na podstawie świeżości treści, ocen ważności i historii indeksowania. Zamiast statycznych plików XML zawierających wszystkie strony, dynamiczne mapy promują ostatnio aktualizowane, najczęściej odwiedzane i konwertujące strony, by boty skupiały budżet na najważniejszych treściach. Segmentacja adresów URL dzieli stronę na logiczne strefy indeksowania, z oddzielnymi strategiami optymalizacji—sekcje newsowe mogą mieć dynamiczne mapy aktualizowane nawet codziennie, a treści evergreen rzadziej.

Optymalizacja po stronie serwera obejmuje wdrażanie cache’owania świadomego indeksowania, czyli serwowanie zcache’owanych odpowiedzi botom, a świeżych treści użytkownikom, co zmniejsza obciążenie przez powtarzające żądania botów. Sieci CDN z obsługą ruchu botów mogą izolować ruch botów od użytkowników, zabezpieczając przepustowość dla prawdziwych odwiedzających. Ograniczanie tempa według user-agent pozwala serwerom spowalniać zapytania botów AI, przy zachowaniu normalnej szybkości dla Googlebota i użytkowników. W dużych organizacjach rozproszone zarządzanie budżetem indeksowania między różnymi regionami serwerowymi zapobiega przeciążeniu pojedynczego punktu i pozwala na geograficzne balansowanie ruchu botów. Uczenie maszynowe do przewidywania indeksowania analizuje historyczne wzorce, by przewidzieć, które strony boty odwiedzą następnie, umożliwiając proaktywne optymalizacje ich wydajności i cache’owania. Takie strategie enterprise zmieniają budżet indeksowania z ograniczenia w zarządzany zasób, pozwalając dużym organizacjom obsługiwać miliardy stron przy zachowaniu optymalnej wydajności zarówno dla botów, jak i użytkowników.

Decyzja o blokowaniu lub zezwalaniu botom AI na indeksowanie to fundamentalny wybór biznesowy z istotnymi skutkami dla widoczności, pozycji konkurencyjnej i kosztów operacyjnych. Zezwolenie botom AI przynosi znaczące korzyści: Twoje treści mogą być uwzględnione w odpowiedziach generowanych przez AI, co potencjalnie zwiększa ruch z ChatGPT, Claude, Perplexity i innych aplikacji; marka zyskuje widoczność w nowym kanale dystrybucji; a dodatkowo korzystasz z sygnałów SEO wynikających z cytowania przez systemy AI. Jednak korzyści te mają swoją cenę: większe obciążenie serwera i zużycie przepustowości, potencjalne trenowanie konkurencyjnych modeli AI na Twoich treściach oraz utrata kontroli nad sposobem prezentacji i przypisywania informacji w odpowiedziach AI.

Blokada botów AI eliminuje te koszty, ale poświęcasz widoczność i potencjalnie oddajesz udziały konkurencji, która pozwala na indeksowanie. Optymalna strategia zależy od modelu biznesowego: wydawcy treści i organizacje medialne często zyskują na zezwoleniu, by zwiększyć dystrybucję przez podsumowania AI; firmy SaaS i sklepy internetowe mogą blokować, by chronić dane przed trenowaniem konkurencji; uczelnie i instytucje naukowe zwykle zezwalają, by maksymalizować upowszechnianie wiedzy. Podejście hybrydowe daje kompromis: pozwól na indeksowanie treści publicznych, blokuj dostęp do wrażliwych sekcji, treści generowanych przez użytkowników lub informacji zastrzeżonych. Taka strategia maksymalizuje korzyści widoczności, chroniąc jednocześnie kluczowe zasoby. Dodatkowo monitoring w AmICited.com i podobnych narzędziach pozwala ocenić, czy Twoje treści faktycznie są cytowane przez systemy AI—jeśli Twoja strona nie pojawia się w odpowiedziach AI mimo zezwolenia, blokada staje się bardziej atrakcyjna, bo ponosisz koszt bez widocznych korzyści.

Skuteczne zarządzanie budżetem indeksowania wymaga specjalistycznych narzędzi zapewniających wgląd w zachowanie botów i umożliwiających optymalizację na podstawie danych. Conductor i Sitebulb oferują analizę indeksowania na poziomie enterprise, symulując zachowanie wyszukiwarek, wykrywając nieefektywności, marnotrawstwo na stronach z błędami i szanse na poprawę alokacji budżetu. Cloudflare umożliwia zarządzanie botami na poziomie sieci, pozwalając precyzyjnie kontrolować dostęp botów i wdrażać ograniczenia tempa specyficzne dla botów AI. Dla śledzenia botów AI, AmICited.com jest najpełniejszym narzędziem, monitorując GPTBot, ClaudeBot, Perplexity Bot i inne, z zaawansowaną analityką: które strony odwiedzają, jak często i czy Twoje treści pojawiają się w odpowiedziach AI.

Analiza logów serwera pozostaje fundamentem optymalizacji budżetu—narzędzia takie jak Splunk, Datadog lub open-source ELK Stack pozwalają analizować surowe logi, segmentować ruch po user-agent i wykrywać najbardziej zasobożerne boty oraz najczęściej indeksowane strony. Własne dashboardy śledzące trendy indeksowania pozwalają ocenić skuteczność optymalizacji i wykrywać nowe boty. Google Search Console nadal zapewnia podstawowe dane o zachowaniu Googlebota, a Bing Webmaster Tools—o robocie Microsoftu. Najbardziej zaawansowane organizacje wdrażają wielonarzędziowe strategie monitoringu łączące Search Console do tradycyjnych robotów, AmICited.com do monitorowania AI, analizę logów do pełnej widoczności oraz narzędzia typu Conductor do symulacji i analizy efektywności. Takie warstwowe podejście daje pełną kontrolę nad interakcją wszystkich typów botów z Twoją stroną i pozwala optymalizować w oparciu o dane, a nie domysły. Regularny monitoring—najlepiej cotygodniowy przegląd metryk indeksowania—umożliwia szybkie wykrycie problemów, takich jak nagłe skoki indeksowania, wzrost błędów czy pojawienie się nowych agresywnych botów, pozwalając zareagować, zanim wpłyną one na wydajność strony lub koszty operacyjne.

Boty AI takie jak GPTBot i ClaudeBot działają według innych priorytetów niż Googlebot. Podczas gdy Googlebot respektuje limity budżetu indeksowania i stosuje zaawansowane ograniczenia, boty AI często wykazują znacznie bardziej agresywne wzorce indeksowania, zużywając 12-15 razy więcej przepustowości. Boty AI stawiają na ciągłe pozyskiwanie treści do trenowania modeli, a nie na indeksowanie do wyszukiwarki, co sprawia, że ich zachowanie wymaga odmiennych strategii optymalizacji.

Badania pokazują, że GPTBot od OpenAI może zużywać 12-15 razy więcej przepustowości niż robot Google na niektórych stronach, szczególnie tych z dużymi bibliotekami treści. Dokładne zużycie zależy od wielkości strony, częstotliwości aktualizacji treści oraz liczby jednocześnie indeksujących botów AI. Równoczesne indeksowanie przez wiele botów AI może znacznie zwiększyć obciążenie serwera i koszty hostingu.

Tak, możesz blokować wybrane roboty AI za pomocą robots.txt bez wpływu na tradycyjne SEO. Jednak blokada robotów AI oznacza rezygnację z widoczności w odpowiedziach generowanych przez AI, takich jak ChatGPT, Claude, Perplexity i inne aplikacje AI. Decyzja zależy od modelu biznesowego—wydawcy treści zwykle korzystają na umożliwieniu indeksowania, natomiast sklepy internetowe mogą blokować, by zapobiec trenowaniu konkurencji.

Złe zarządzanie budżetem indeksowania może skutkować nieindeksowaniem ważnych stron, wolniejszym indeksowaniem nowych treści, zwiększonym obciążeniem serwera i kosztami przepustowości, pogorszeniem doświadczenia użytkownika przez zużycie zasobów przez boty oraz utratą szans na widoczność zarówno w tradycyjnych wyszukiwarkach, jak i w odpowiedziach generowanych przez AI. Najbardziej narażone są duże strony z milionami podstron.

Dla najlepszych rezultatów monitoruj metryki budżetu indeksowania co tydzień, a podczas dużych wdrożeń treści lub nagłych skoków ruchu—nawet codziennie. Użyj Google Search Console do danych o tradycyjnych robotach, AmICited.com do monitorowania robotów AI oraz logów serwera dla pełnej widoczności botów. Regularne monitorowanie pozwala szybko wykryć problemy, zanim wpłyną one na wydajność strony.

Skuteczność robots.txt wobec botów AI jest zmienna. Gdy Googlebot rygorystycznie przestrzega zapisów robots.txt, boty AI są w tym niekonsekwentne—niektóre respektują zasady, inne je ignorują. Dla większej kontroli stosuj blokowanie specyficzne dla user-agenta, ograniczanie żądań na poziomie serwera lub używaj narzędzi zarządzania botami na CDN, takich jak Cloudflare.

Budżet indeksowania bezpośrednio wpływa na widoczność w AI, ponieważ boty AI nie mogą cytować ani odwoływać się do treści, których nie zindeksowały. Jeśli ważne strony nie są indeksowane z powodu ograniczeń budżetowych, nie będą pojawiać się w odpowiedziach generowanych przez AI. Optymalizacja budżetu indeksowania zapewnia, że najważniejsze treści zostaną odkryte przez boty AI, zwiększając szanse na cytowanie w odpowiedziach ChatGPT, Claude i Perplexity.

Priorytetyzuj strony przy użyciu dynamicznych map witryn, które wyróżniają ostatnio aktualizowane treści, strony o dużym ruchu i te z potencjałem konwersji. Użyj robots.txt do blokowania stron o niskiej wartości, takich jak archiwa czy duplikaty. Wprowadź przejrzystą strukturę URL i strategiczne linkowanie wewnętrzne, by kierować boty do ważnych treści. Monitoruj, które strony faktycznie indeksują boty AI za pomocą narzędzi takich jak AmICited.com, aby udoskonalić strategię.

Śledź, jak boty AI indeksują Twoją stronę i optymalizuj swoją widoczność w odpowiedziach generowanych przez AI dzięki kompleksowej platformie monitorowania robotów AI AmICited.com.

Budżet indeksowania to liczba stron, które wyszukiwarki przeszukują na Twojej stronie w określonym przedziale czasu. Dowiedz się, jak zoptymalizować budżet inde...

Dowiedz się, czym jest crawl budget dla AI, czym różni się od tradycyjnych budżetów indeksowania oraz dlaczego jest ważny dla widoczności Twojej marki w odpowie...

Dowiedz się, jak działają indeksy wyszukiwania AI, jakie są różnice między metodami indeksowania ChatGPT, Perplexity i SearchGPT oraz jak zoptymalizować swoje t...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.